一、爬虫类里未返回Item

在爬虫里

parse要加上

yield Item

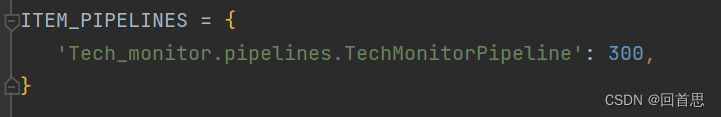

二、设置里未开启管道

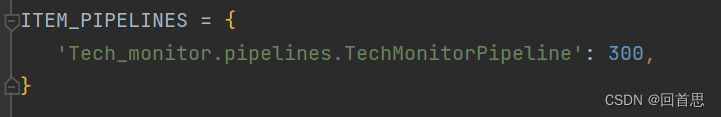

三、设置里同时打开下载中间件和管道时

下载中间件的权重要大,所以后面的值就要小于管道

一、爬虫类里未返回Item

在爬虫里

parse要加上

yield Item

二、设置里未开启管道

三、设置里同时打开下载中间件和管道时

下载中间件的权重要大,所以后面的值就要小于管道

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?