NVIDIA的显卡驱动程序和CUDA完全是两个不同的概念!CUDA是NVIDIA推出的用于自家GPU的并行计算框架,也就是说CUDA只能在NVIDIA的GPU上运行,而且只有当要解决的计算问题是可以大量并行计算的时候才能发挥CUDA的作用。

NVIDIA的显卡驱动器与CUDA

NVIDIA的显卡驱动器与CUDA并不是一一对应的,CUDA本质上只是一个工具包而已,所以我可以在同一个设备上安装很多个不同版本的CUDA工具包,比如我的电脑上同事安装了 CUDA 9.0、CUDA 9.2、CUDA 10.0三个版本。一般情况下,我只需要安装最新版本的显卡驱动,然后根据自己的选择选择不同CUDA工具包就可以了,但是由于使用离线的CUDA总是会捆绑CUDA和驱动程序,所以在使用多个CUDA的时候就不要选择离线安装的CUDA了,否则每次都会安装不同的显卡驱动,这不太好,我们直接安装一个最新版的显卡驱动,然后在线安装不同版本的CUDA即可。

显卡驱动链接:https://www.nvidia.com/Download/index.aspx?lang=en-us

CUDA的下载地址为:https://developer.nvidia.com/cuda-downloads

CUDA其他版本的下载地址为:https://developer.nvidia.com/cuda-toolkit-archive

CUDA Toolkit本地安装包时内含特定版本Nvidia显卡驱动的,所以只选择下载CUDA Toolkit就足够了,如果想安装其他版本的显卡驱动就下载相应版本即可。

参考:https://blog.csdn.net/qq_27825451/article/details/89082978

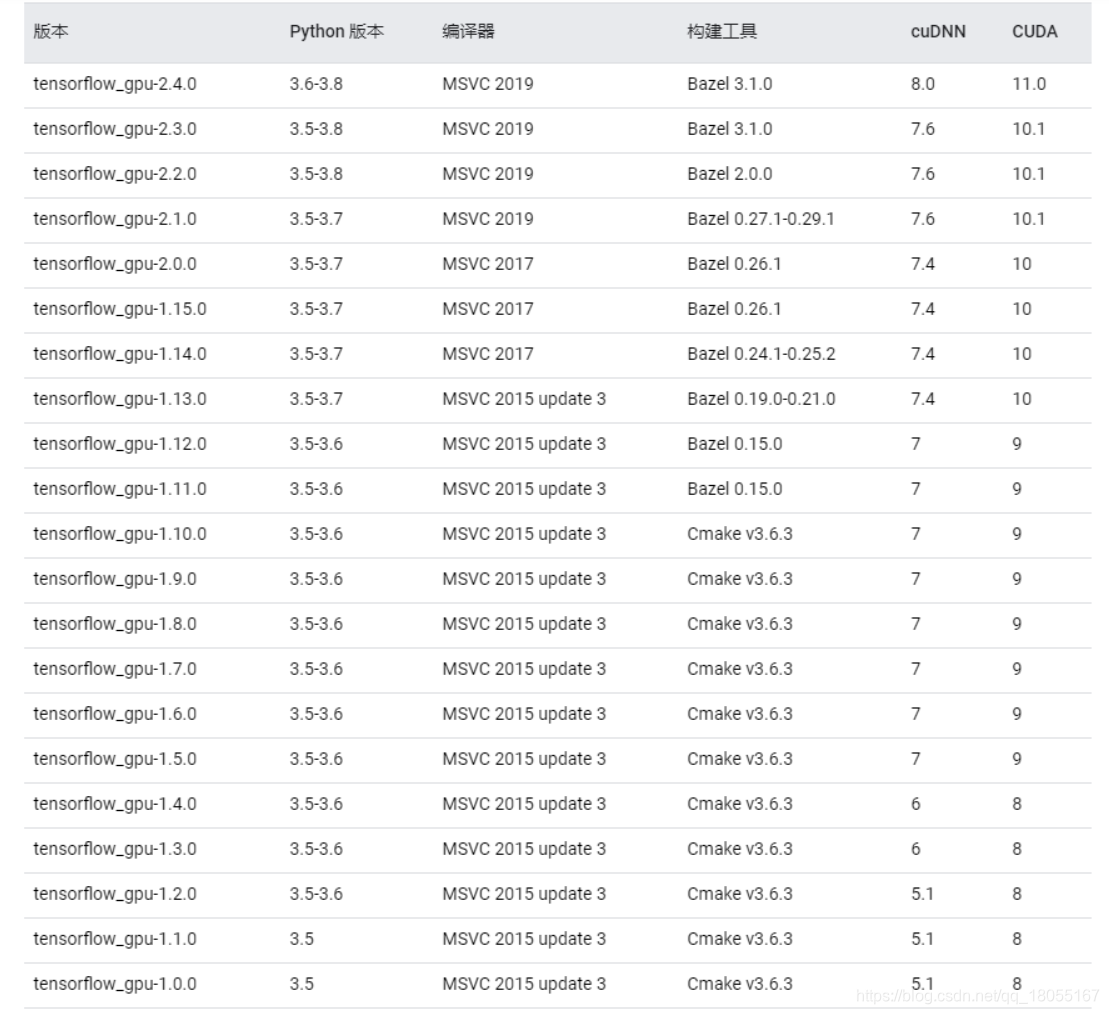

tensorflow各个版本需要的CUDA版本以及Cudnn的对应关系

https://www.tensorflow.org/install/source_windows

https://www.tensorflow.org/install/source#common_installation_problems

cuDNN是一个SDK,是一个专门用于神经网络的加速包,注意,它跟我们的CUDA没有一一对应的关系,即每一个版本的CUDA可能有好几个版本的cuDNN与之对应,但一般有一个最新版本的cuDNN版本与CUDA对应更好。

如何参考自己安装的CUDA的版本

(1)通过命令查看:nvcc -V 或者是nvcc --version都可以,但前提是添加了环境变量

(2)直接通过文件查看,这里分为Linux和windows两种情况

在windows平台下,可以直接进入CUDA的安装目录,比如我的是:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.2 里面有一个version.txt的文本文件,直接打开即可,也可以使用命令,即

首先进入到安装目录,然后执行:type version.txt 即可查看

在Linux平台下:

同windows类似,进入到安装目录,然后执行 cat version.txt 命令

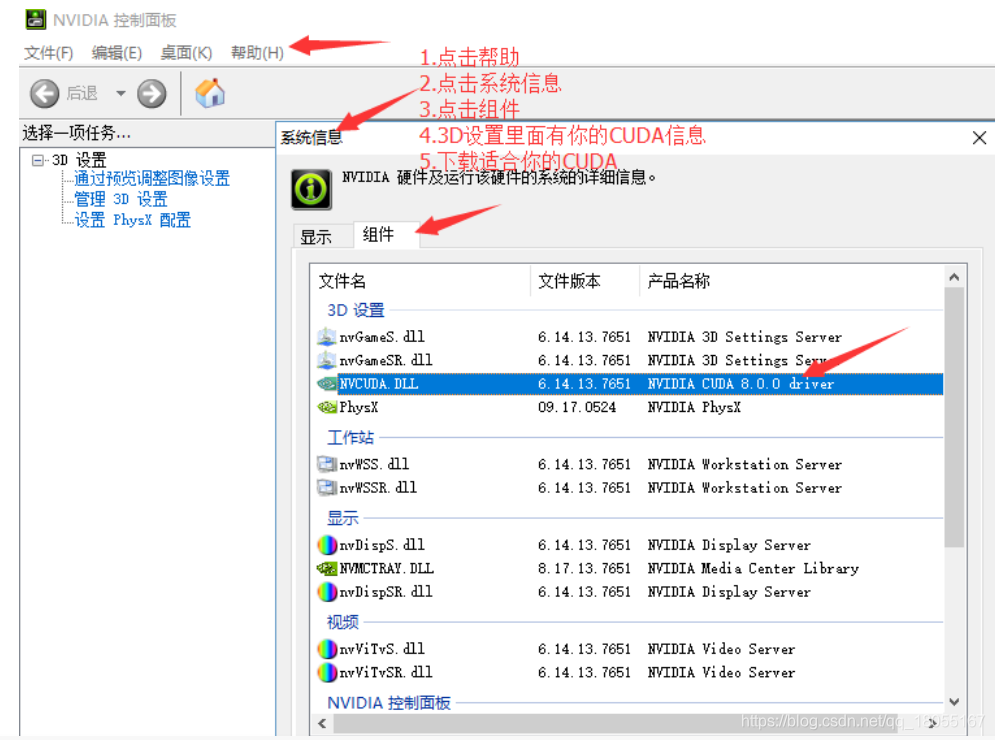

(3)通过NVIDIA设置界面查看CUDA版本

keras与tensorflow的对应关系

https://docs.floydhub.com/guides/environments/

参考

参考博客对各版本的对应关系进行了详细的介绍

参考:

https://blog.csdn.net/qq_27825451/article/details/89082978

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?