一、安装VMare

二、安装Centos7

三、配置linux

1、配置网络

ip addr #查看本机ip

vi /etc/sysconfig/network-scripts/ifcfg-ens33

BOOTPROTO=static #修改

ONBOOT=yes #修改

IPADDR=192.168.52.100

NETMASK=255.255.255.0

GATEWAY=192.168.52.2 #结尾必须.2 .1默认被占用了

DNS1=8.8.8.8

// 保存并退出

service network restart #重启网络服务

2、编辑VMare虚拟网络编辑器

(编辑 -- 虚拟网络编辑器)

3、测试

ping www.baidu.com #测试网络

// 如果不通

service network restart

hostnamectl set-hostname node00 #设置hostname

logout #登出

如果发生 there are job stoped 错误:

jobs 查看正在执行的任务

fg %1 重新执行 (1是jobs命令中的任务编号)

kill %1 杀死任务。

yum install -y vim #安装vim

4、关闭防火墙

systemctl stop firewalld #关闭防火墙

systemctl disable firewalld #防火墙不在启动

systemctl status firewalld #查看防火墙状态

// 显示下列信息即为关闭

● firewalld.service - firewalld - dynamic firewall daemon

Loaded: loaded (/usr/lib/systemd/system/firewalld.service; disabled; vendor preset: enabled)

Active: inactive (dead)

Docs: man:firewalld(1)

yum install -y vim #安装vim

vim /etc/selinux/config #进入selinux设置文件

SELINUX=disabled

5、建立映射节点

vim /etc/hosts #进入配置文件

192.168.52.100 node01

192.168.52.110 node02

192.168.52.120 node03

6、添加普通用户并授权

useradd hadoop #添加hadoop用户

passwd hadoop #给hadoop用户添加密码

hadoop #密码设为hadoopvisudo #进入用户权限配置文件

## Allow root to run any commands anywhere

root ALL=(ALL) ALL

hadoop ALL=(ALL) ALL # 给hadoop用户添加所有权限

7、上传并解压Hadoop、JDK安装文件

#切换到hadoop用户,注意“-”左右有空格

#(从此步骤开始,最好切换到hadoop用户操作)

su - hadoop

cd / # 先进入根目录

mkdir -p /kkb/soft # 软件压缩包存放目录

mkdir -p /kkb/install # 软件解压后存放目录

chown -R hadoop:hadoop /kkb # root用户将文件夹权限更改为hadoop用户// 将jdk8-linux压缩包,zookeeper压缩包,hadoop压缩包,通过xftp传送到/kkb/soft/目录

cd /kkb/soft

# 解压jdk到/kkb/install文件夹

tar -zxvf jdk-8u141-linux-x64.tar.gz -C /kkb/install/

# 解压hadoop到/kkb/install文件夹

tar -zxvf hadoop-2.6.0-cdh5.14.2_after_compile.tar.gz -C /kkb/install/

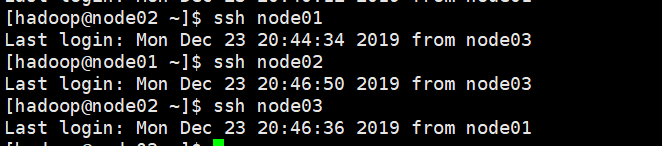

8、免密登陆设置

# hadoop用户下执行下列命令,必须!

# 下面操作node01,node02,node03 都执行,回车next。

ssh-keygen -t rsa #生成公钥 (一直回车)

ssh-copy-id node01 #三台机器的公钥全部拷贝到node01

// 此时node01的 /home/hadoop/.ssh 文件夹中包含了3台机器的公钥#下面是在node01 hadoop用户下执行

cd /home/hadoop/.ssh/

scp authorized_keys node02:$PWD #将node01的授权文件拷贝到node02

scp authorized_keys node03:$PWD #将node01的授权文件拷贝到node03

# “:PWD”的意思是:拷贝目标文件位置和node01的位置一致。#验证免密登录

#在node01执行

ssh node02 #在node01登录node02,不需要密码就ok

ssh node03 #在node01登录node02,不需要密码就ok

#回到node01

logout#修改.ssh目录权限

[hadoop@node01 ~]$ chmod -R 755 .ssh/

[hadoop@node01 ~]$ cd .ssh/

[hadoop@node01 .ssh]$ chmod 644 *

[hadoop@node01 .ssh]$ chmod 600 id_rsa

[hadoop@node01 .ssh]$ chmod 600 id_rsa.pub

#把hadoop的公钥添加到本机认证文件当中,如果没有添加启动集群时需要输入密码才能启动,这里需要重点注意下

[hadoop@node01 .ssh]$ cat id_rsa.pub >> authorized_keys

[hadoop@node01 .ssh]$测试:

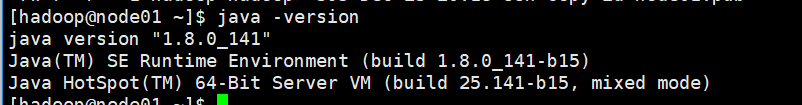

8、配置JDK , Hadoop环境变量(3台都要配)

rpm -e --nodeps #删除原生jdk

vim /etc/profile # 配置全局全局环境变量,下拉到文件最下方

export JAVA_HOME=/kkb/install/jdk1.8.0_141 #添加

export HADOOP_HOME=/kkb/install/hadoop-2.6.0-cdh5.14.2 #添加

export PATH=$PATH:$HOME/bin:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin #添加source /etc/profile # 环境变量立即生效

java -version #验证java

hadoop version #验证hadoop测试:

本文详细介绍了如何在虚拟机中搭建大数据环境,包括安装Centos7,配置Linux网络,关闭防火墙,设置免密登录,安装JDK和Hadoop,配置环境变量,以及配置Hadoop集群。通过这些步骤,确保了在虚拟机上成功部署并测试了一个完整的Hadoop环境。

本文详细介绍了如何在虚拟机中搭建大数据环境,包括安装Centos7,配置Linux网络,关闭防火墙,设置免密登录,安装JDK和Hadoop,配置环境变量,以及配置Hadoop集群。通过这些步骤,确保了在虚拟机上成功部署并测试了一个完整的Hadoop环境。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

784

784

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?