目录

一 介绍

nvidia-smi简称NVSMI,提供监控GPU使用情况和更改GPU状态的功能,是一个跨平台工具,它支持所有标准的NVIDIA驱动程序支持的Linux发行版以及从WindowsServer 2008 R2开始的64位的系统。该工具是N卡驱动附带的,只要安装好驱动后就会有它。

二 命令

nvidia-smi

- Fan:风扇转速(0%-100%),N/A表示没有风扇

- Temp:GPU温度(GPU温度过高会导致GPU频率下降)

- Perf:性能状态,从P0(最大性能)到P12(最小性能)

- Pwr:GPU功耗

- Persistence-M:持续模式状态(持续模式耗能大,但在新的GPU应用启动时花费时间更少)

persistence mode 持续模式默认关闭。persistence mode 能够让 GPU 更快响应任务,待机功耗增加。关闭 persistence mode 同样能够启动任务。 - Bus-Id:GPU总线,00000000:37:00.0

- Disp.A:Display Active,表示GPU是否初始化

- Memory-Usage:显存使用率

- Volatile GPU-UTil:GPU使用率,与显存使用率的区别可参考显存与GPU

- ECC:是否开启错误检查和纠错技术,0/DISABLED,1/ENABLED

- Compute M:计算模式

附加选项

1、指定GPU:nvidia-smi -i 0

2、指定动态刷新时间,默认5秒刷新一次,通过Ctrl+C停止:nvidia-smi -l 5

3、将查询信息输出到具体文件中,不在终端显示:nvidia-smi -f xxx

4、查询所有GPU当前详细信息:nvidia-smi -q

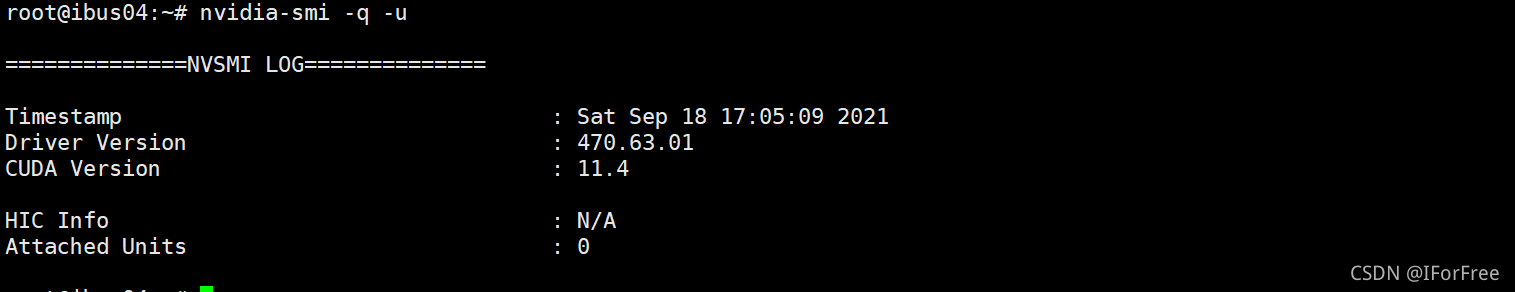

5、显示单元而不是GPU属性 nvidia-smi -q -u

6、指定具体的GPU或unit属性:nvidia-smi -q -i XXX nvidia-smi -q -u XXX

6、指定具体的GPU或unit属性:nvidia-smi -q -i XXX nvidia-smi -q -u XXX

7、将查询信息输出到文档:nvidia-smi -q -f XXX

8、将查询信息输出到xml:nvidia-smi -q -x

9、指定显示GPU的特定信息:nvidia-smi -q -d xxx,xxx属性可以为MEMORY, UTILIZATION, ECC, TEMPERATURE, POWER,CLOCK, COMPUTE, PIDS, PERFORMANCE, SUPPORTED_CLOCKS, PAGE_RETIREMENT,ACCOUNTING

10、选择性查询选项,可以指定显示的属性选项:nvidia-smi --query-gpu=gpu_name,gpu_bus_id,vbios_version-format=csv

设备修改选项

可以手动设置GPU卡设备的状态选项:

1、nvidia-smi -pm 0/1

设置持久模式:0/DISABLED,1/ENABLED

2、nvidia-smi -e 0/1

设置ECC支持:0/DISABLED,1/ENABLED

3、nvidia-smi -p 0/1

重置ECC错误次数:0/VOLATILE,1/AGGREGATE

4、nvidia-smi -c

设置计算应用模式:0/DEFAULT,1/EXCLUSIVE_PROCESS,2/PROHIBITED

5、nvidia-smi -r

GPU复位

6、nvidia-smi -vm

设置GPU虚拟化模式

7、nvidia-smi-rac xxx,xxx

设置GPU工作频率

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?