目录[-]

1.解压eclipse:

eclipse-SDK-4.2-linux-gtk.tar.gz

(1)解压程序文件:

|

1

|

hm@hm-ubuntu:

/usr

$

sudo

tar

eclipse.

tar

.gz

|

(2)在Ubuntu桌面点鼠标右键,创建启动器:

(3)在“命令”选择eclipse执行文件:

2.安装hadoop开发插件:

hadoop-eclipse-plugin-*.jar插件须符合此eclipse版本。

(1)手动制作hadoop-eclipse-plugin插件

见《Hadoop上路_01-手动制作hadoop-eclipse-plugin插件》

(2)把插件放入%eclipse%/dropins/hadoop/plugins目录

首先在%eclipse%/dropins/中创建hadoop/plugins层级目录

3.执行快捷方式:

错误:

重新配置了环境变量中的jdk路径,eclipse不能检测到新路径

解决:

更新环境变量后重启系统

4.配置Hadoop视图:

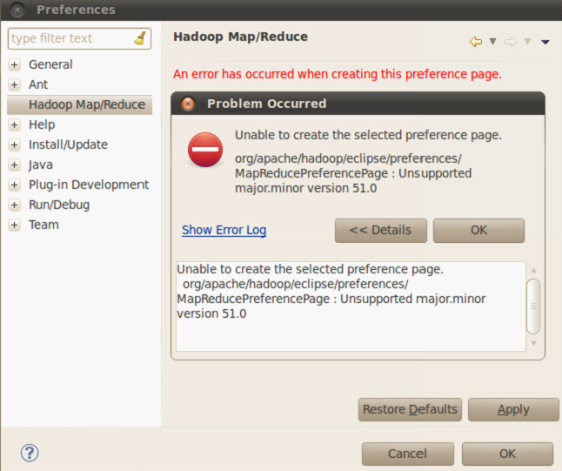

1)window -> preferences -> Hadoop Map/Reduce,

配置任意hadoop解压目录(仅在创建Map/Reduce Project项目时供自动加载jar包用;如果创建Java Project可以置空):

错误:

jdk版本错误:

当前使用的hadoop-eclipse-plugin-1.1.2插件是基于JDK1.7制作的,而系统中安装的是JDK1.6。

eclipse.buildId=M20130204-1200

java.version=1.6.0_24

java.vendor=Sun Microsystems Inc.

BootLoader constants: OS=linux, ARCH=x86, WS=gtk, NL=zh_CN

Command-line arguments: -os linux -ws gtk -arch x86

Error

Sun May 19 09:10:21 CST 2013

Unable to create the selected preference page.

java.lang.UnsupportedClassVersionError: org/apache/hadoop/eclipse/preferences/MapReducePreferencePage : Unsupported major.minor version 51.0

at java.lang.ClassLoader.defineClass1(Native Method)

at java.lang.ClassLoader.defineClassCond(ClassLoader.java:632)

at java.lang.ClassLoader.defineClass(ClassLoader.java:616)

at org.eclipse.osgi.internal.baseadaptor.DefaultClassLoader.defineClass(DefaultClassLoader.java:188)

at org.eclipse.osgi.baseadaptor.loader.ClasspathManager.defineClassHoldingLock(ClasspathManager.java:632)

... ...

at org.eclipse.equinox.launcher.Main.run(Main.java:1438)

解决:

升级当前系统的JDK版本到插件使用的1.7。

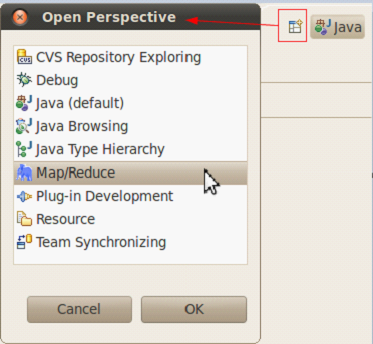

2)打开Hadoop视图,

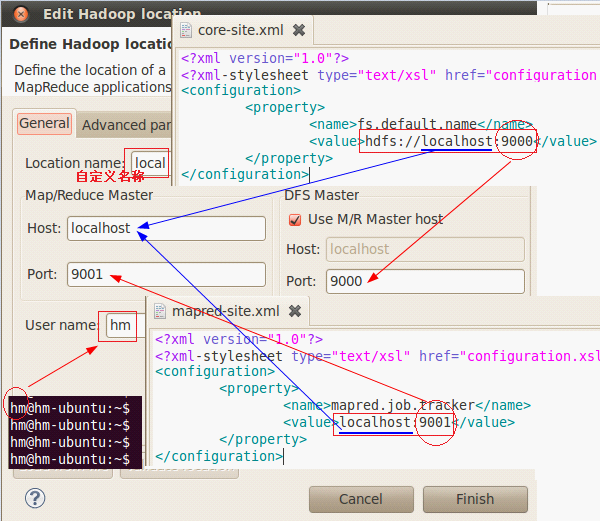

3)新建Hadoop Location连接,

4)配置主机、端口,

5)完成:

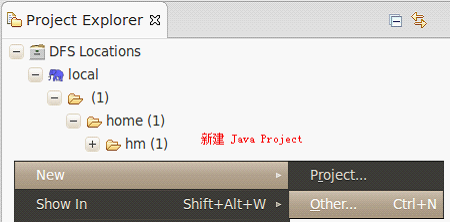

“local”下的目录即HDFS中的目录。可以直接在上面进行下载、创建、上传、删除等操作:

错误:

hadoop-eclipse-plugin-*.jar插件中jar包引用错误

An internal error occurred during: "Map/Reduce location status updater".

org/codehaus/jackson/map/JsonMappingException

解决:

在制作插件时%hadoop%/src/contrib/eclipse-plugin/META-INF/MANIFEST.MF中的Bundle-ClassPath内jar的路径写错导致的,修改正确,重新制作。

5.创建项目:

在Map/Reduce视图中创建java project:

- end

746

746

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?