Hadoop分布式文件系统(HDFS)被设计成适合运行在通用硬件(commodity hardware)上的分布式文件系统。它和现有的分布式文件系统有很多共同点。但同时,它和其他的分布式文件系统的区别也是很明显的。HDFS是一个高度容错性的系统,适合部署在廉价的机器上。HDFS能提供高吞吐量的数据访问,非常适合大规模数据集上的应用。HDFS放宽了一部分POSIX约束,来实现流式读取文件系统数据的目的。HDFS在最开始是作为Apache Nutch搜索引擎项目的基础架构而开发的。HDFS是Apache Hadoop Core项目的一部分。下面我简单说说用Java实现对HDFS文件进行上传、下载以及查看当前文件夹下所有文件:

开始前准备工作:

搭建一个分布式或者伪分布式的Hadoop集群,这个有问题的请看我以前写的文章,传送阵;

eclipse,建议使用eclipse4.4以上版本;

第一步:

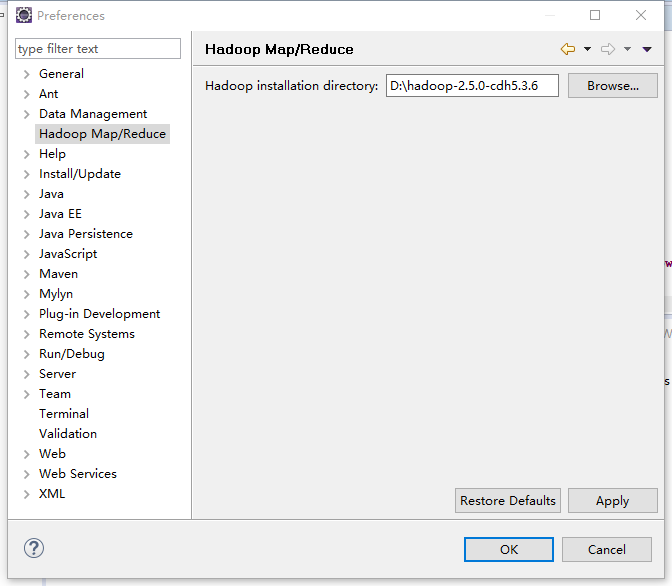

配置Hadoop主目录:

解压Hadoop-2.6.0文件到D盘根目录下,然后配置eclipse的Hadoop主目录;

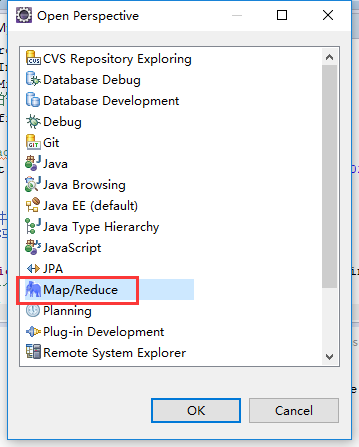

第二步:配置插件:

打开Windows->Open Perspective中的Map/Reduce,在此perspective下进行hadoop程序开发。

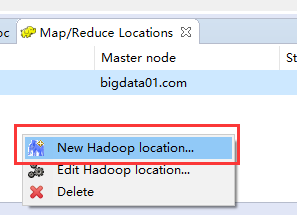

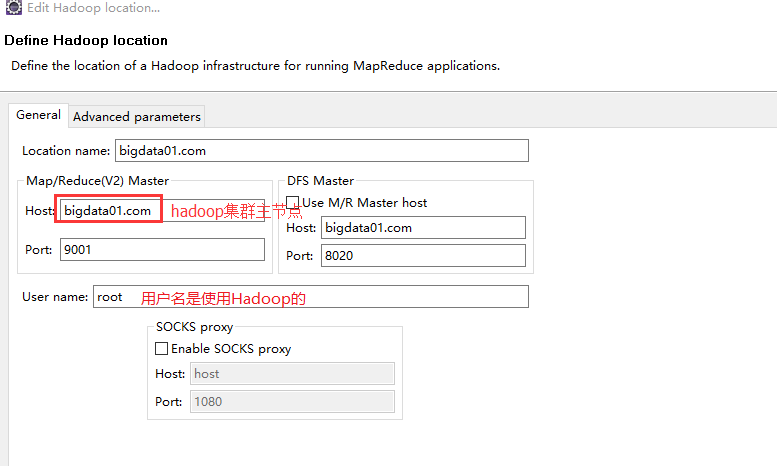

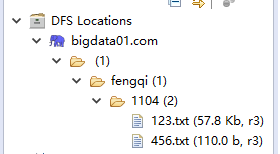

打开Windows->Show View中的Map/Reduce Locations,如下图右键选择New Hadoop location…新建hadoop连接。

确认完成以后如下,eclipse会连接hadoop集群。

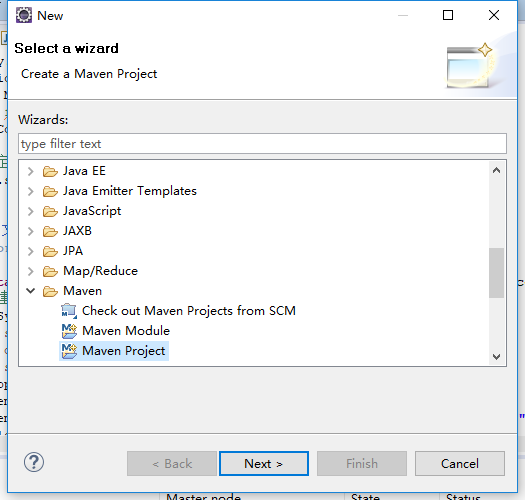

第三步:创建maven项目

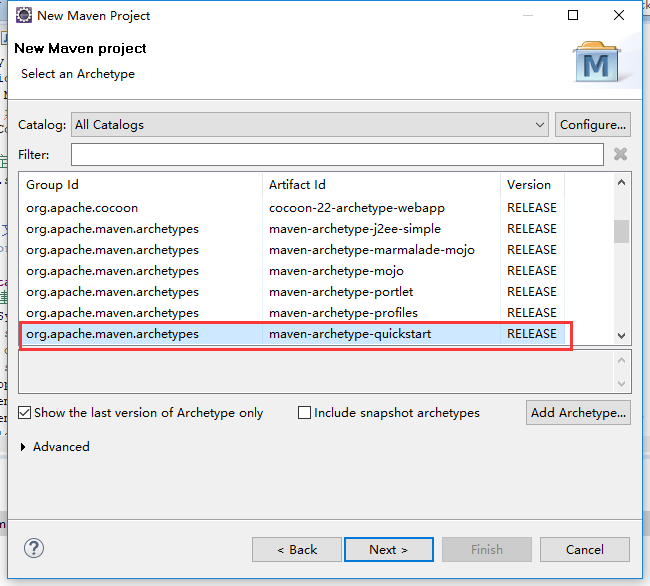

new一个项目,选择other,然后找到maven project,单击下一步:

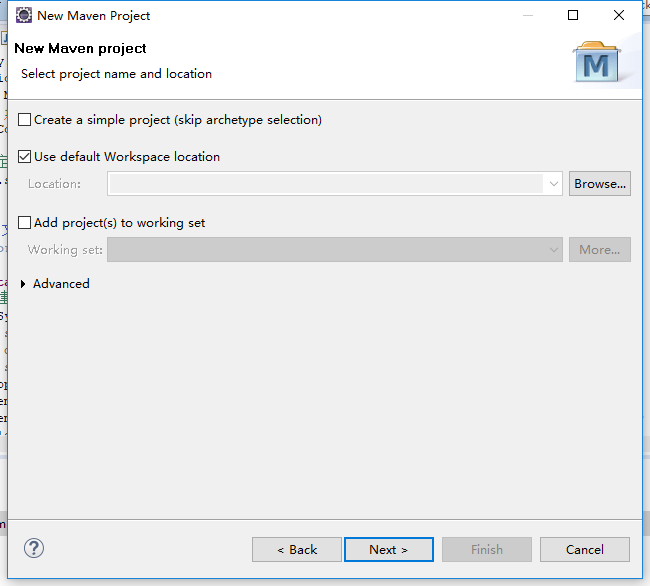

默认,单击next:

默认,单击nest:

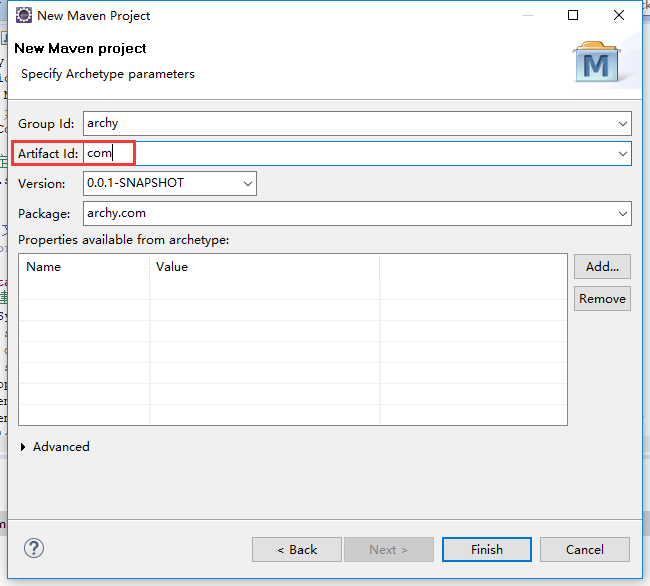

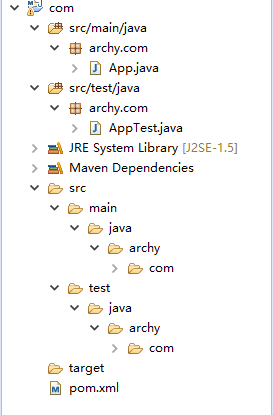

按照下图填写内容,完成后单击Finish:

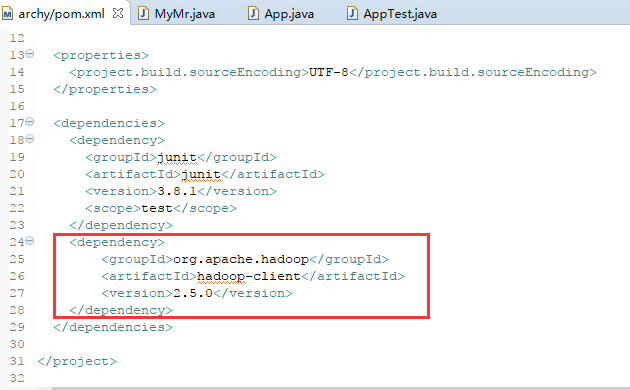

第四步:配置pom.xml文件:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.5.0</version>

</dependency>

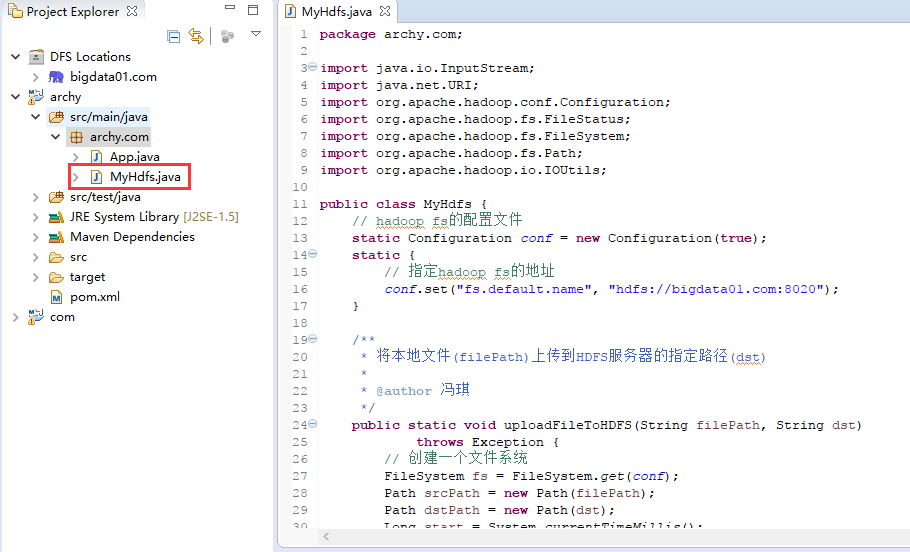

package archy.com;

import java.io.InputStream;

import java.net.URI;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

public class MyHdfs {

// hadoop fs的配置文件

static Configuration conf = new Configuration(true);

static {

// 指定hadoop fs的地址

conf.set("fs.default.name", "hdfs://bigdata01.com:8020");

}

/**

* 将本地文件(filePath)上传到HDFS服务器的指定路径(dst)

*

* @author 冯琪

*/

public static void uploadFileToHDFS(String filePath, String dst)

throws Exception {

// 创建一个文件系统

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(filePath);

Path dstPath = new Path(dst);

Long start = System.currentTimeMillis();

fs.copyFromLocalFile(false, srcPath, dstPath);

System.out.println("Time:" + (System.currentTimeMillis() - start));

System.out.println("________准备上传文件" + conf.get("fs.default.name")

+ "____________");

fs.close();

getDirectoryFromHdfs(dst);

}

/**

* 下载文件

*

* @author 冯琪

*/

public static void downLoadFileFromHDFS(String src) throws Exception {

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(src);

InputStream in = fs.open(srcPath);

try {

// 将文件COPY到标准输出(即控制台输出)

IOUtils.copyBytes(in, System.out, 4096, false);

} finally {

IOUtils.closeStream(in);

fs.close();

}

}

/**

* 遍历指定目录(direPath)下的所有文件

*

* @author 冯琪

*/

public static void getDirectoryFromHdfs(String direPath) throws Exception {

FileSystem fs = FileSystem.get(URI.create(direPath), conf);

FileStatus[] filelist = fs.listStatus(new Path(direPath));

for (int i = 0; i < filelist.length; i++) {

System.out.println("_________________第" + i + "个文件"

+ "____________________");

FileStatus fileStatus = filelist[i];

System.out.println("Name:" + fileStatus.getPath().getName());

System.out.println("size:" + fileStatus.getLen());

System.out.println("_________________第" + i + "个文件"

+ "____________________");

}

fs.close();

}

/**

* 测试方法

*

* @author 冯琪

*/

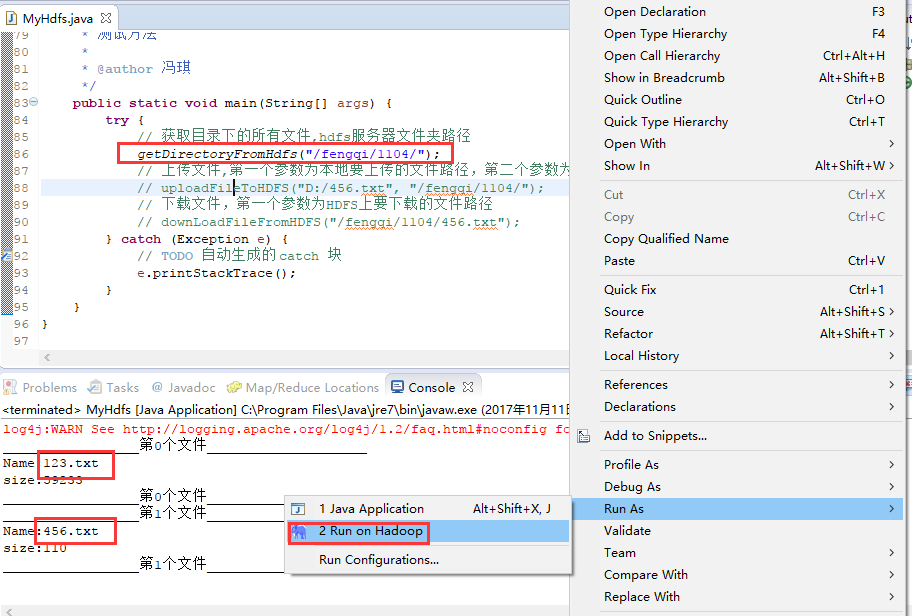

public static void main(String[] args) {

try {

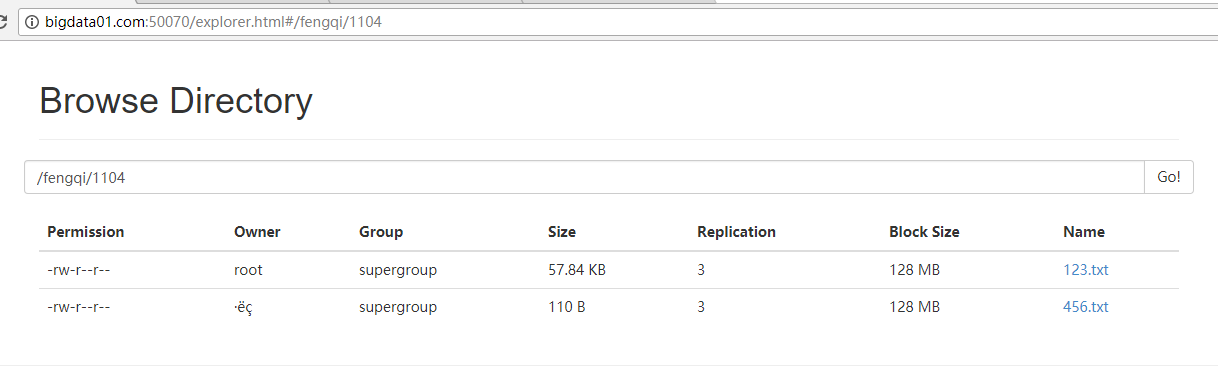

// 获取目录下的所有文件,hdfs服务器文件夹路径

getDirectoryFromHdfs("/fengqi/1104/");

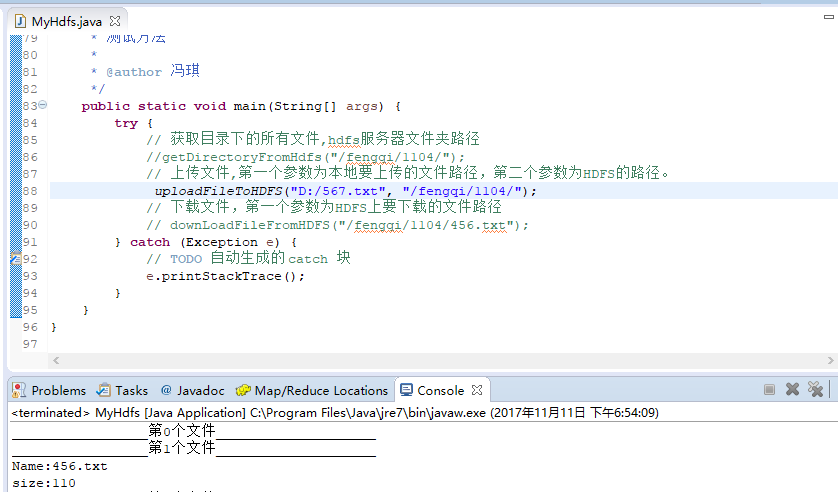

// 上传文件,第一个参数为本地要上传的文件路径,第二个参数为HDFS的路径。

// uploadFileToHDFS("D:/456.txt", "/fengqi/1104/");

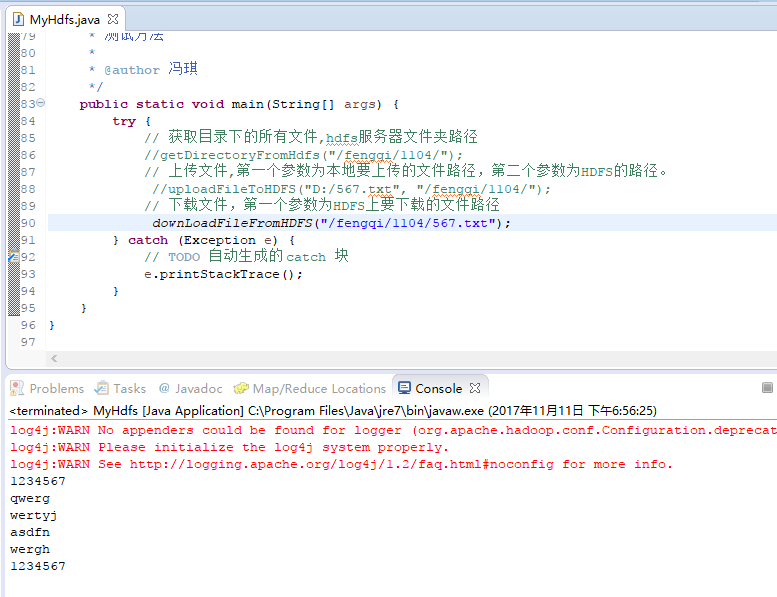

// 下载文件,第一个参数为HDFS上要下载的文件路径

// downLoadFileFromHDFS("/fengqi/1104/456.txt");

} catch (Exception e) {

// TODO 自动生成的 catch 块

e.printStackTrace();

}

}

}

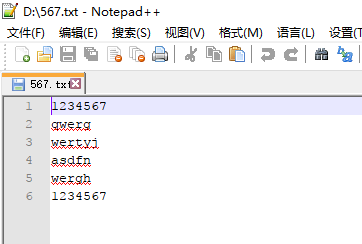

第六步:测试结果

如果有什么疑问或者见解,欢迎在下方留言,谢谢。

746

746

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?