一、逻辑回归 vs 线性回归(尤其注意损失函数):

虽然损失函数定义的不一样,但是最后化简后发现和线性回归是一样的。

那为什么把逻辑回归的损失函数定义成square error呢?原因如下:

总结:当定义成square error时,随机参数一般会使模型离最理想的状态还有一定差距,但是这个时候模型的学习的梯度会非常小,甚至为0,不利于模型的收敛,故采用cross entropy。

二、同一组数据采用生成式和判别方法最后有什么不同

判别式:直接求解参数(w和b);对数据不做任何假设。

生成式:需要求解u1,u2和∑;需要对数据的分布做假设(比如高斯,伯努利分布等)。

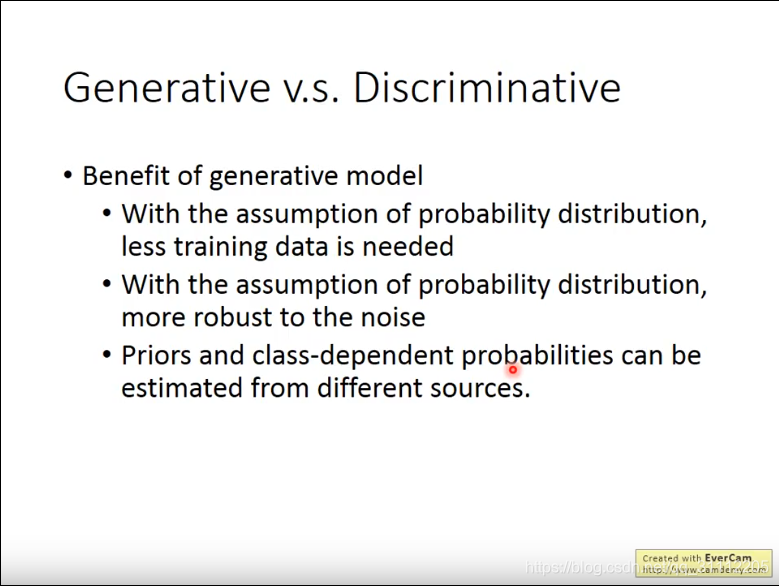

所以,一般情况下判别式求解的模型会比生成式的要好。但生成式也有自己的优势,如下:

三、多分类

四、逻辑回归和神经网络的关系

实质是多个逻辑回归单元组成的结构被称为神经网络

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?