文章目录

- PO

- OOP

- python

- RBAC

- Django

- DRFTODO

- FlaskTODO

- cookie session token

- Mysql

- ES

- 消息队列TODO

- redis

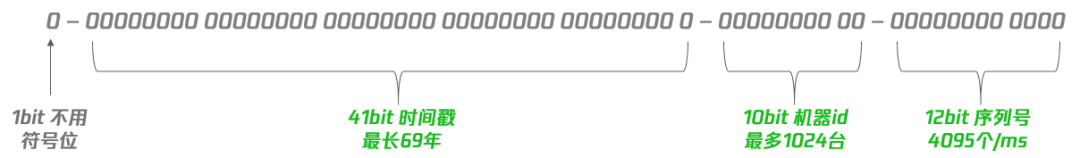

- 分布式 id (UUID)

- CDN

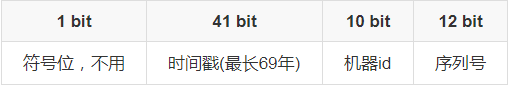

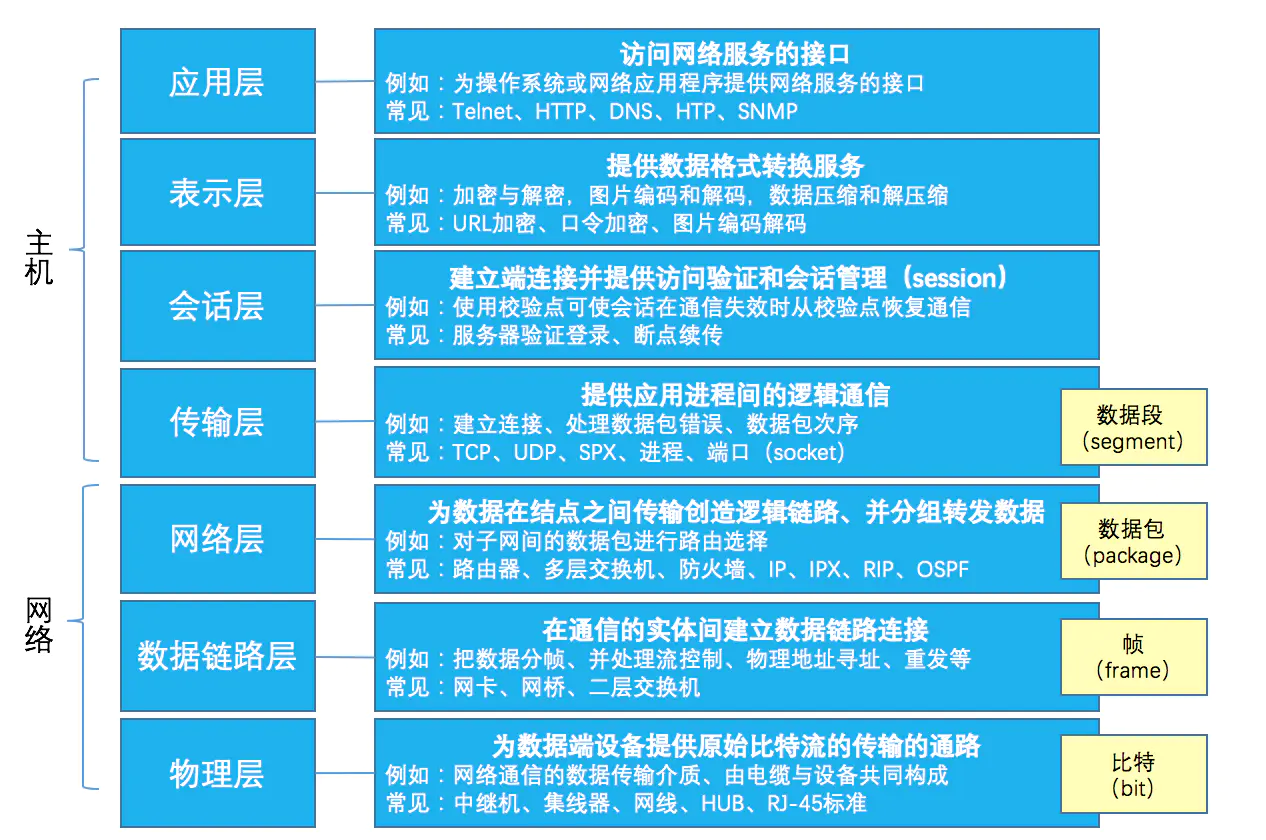

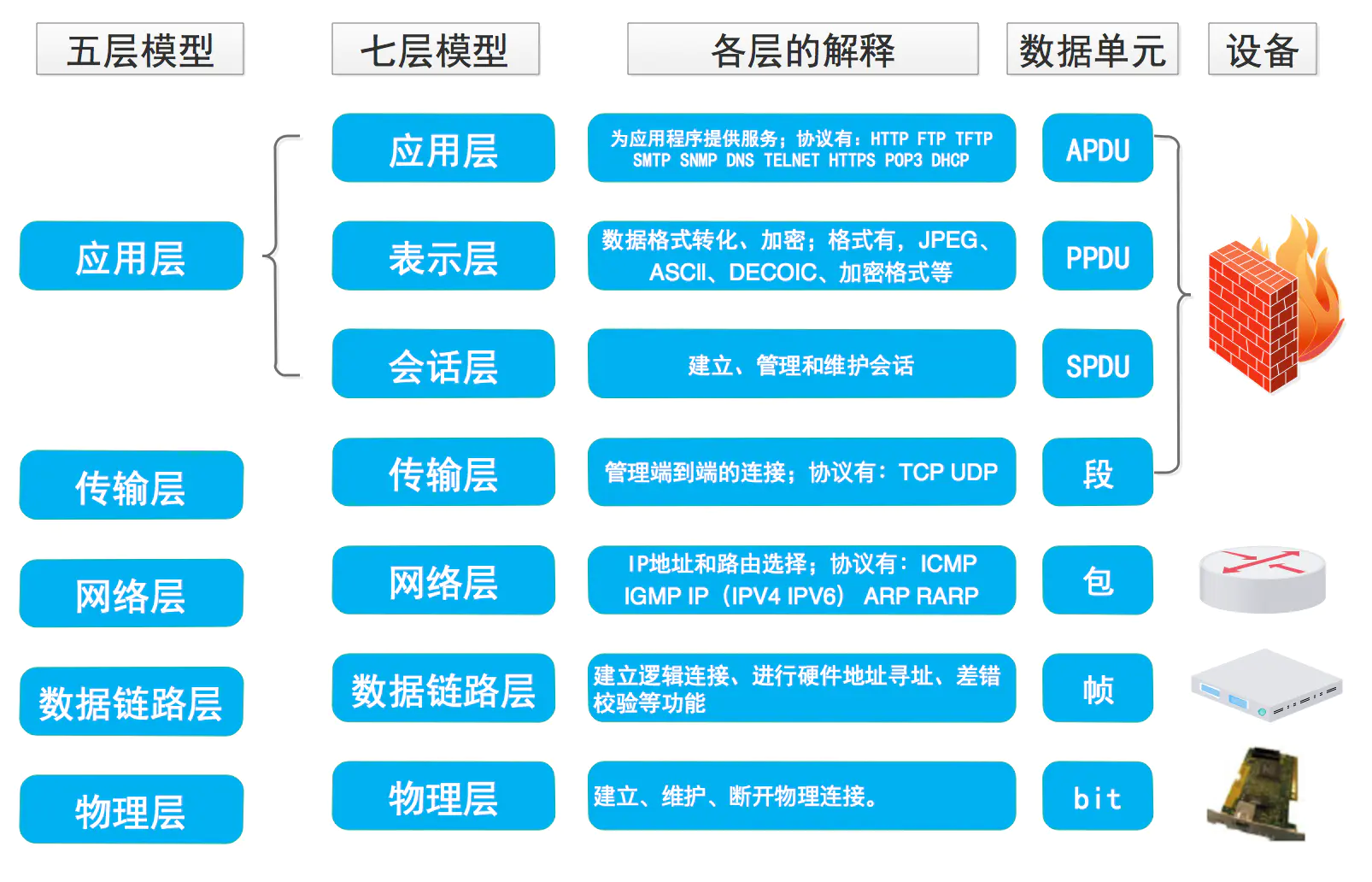

- 计算机网络

- 提高并发的方法

- linux 常用命令

- Docker 常用命令

- 常见安全漏洞

- nginx + uwsgi 部署

PO

-

面向过程(Procedure Oriented 简称PO :如C语言)

-

传统的面向过程的编程思想总结起来就八个字——自顶向下,逐步细化!实现步骤如下:

-

将要实现的功能描述为一个从开始到结束按部就班的连续的步骤(过程)

-

依次逐步完成这些步骤,如果某一步的难度较大,又可以将该步骤再次细化为若干个子步骤,以此类推,一直到结束得到想要的结果

-

程序的主体是函数,一个函数就是一个封装起来的模块,可以实现一定的功能,各个子步骤往往就是通过各个函数来完成的,从而实现代码的重用和模块

化编程

-

OOP

-

面向对象编程(英文Object Oriented Programming),所以也叫做OOP

-

早期的计算机编程是基于面向过程的,因为早期计算机处理的问题都不是很复杂,所以一个算法,一个数据结构就能够很好的解决当时的问题

但是随着计算机技术的发展,要处理的计算机问题越来越复杂。为了更好的解决这样的问题,就出现了一切皆对象的面向对象编程,把计算机中的东西比喻成

现实生活中的一样事物,一个对象,那现实生活中的对象都会有属性跟行为,这就对应着计算机中的属性和方法(函数)

把对象作为一个程序的基本单元,把数据和功能封装在里面,能够实现很好的复用性,灵活性和扩展性

-

OOP中2个基本概念

- 类和对象

- 类是描述如何创建一个对象的代码段,用来描述具有相同的属性和方法的对象的集合,它定义了该集合中每个对象所共有的属性和方法

- 对象是类的实例(Instance)

-

OOP的三大特征

-

封装

- 对类中成员属性和方法的保护 , 控制外界对内部成员的访问 , 修改 , 删除等操作

- 一个类就是一个封装了数据以及操作这些数据的代码的逻辑实体

-

多态

- 不同的子类对象 , 调用相同的父类方法 , 产生不同的执行结果

-

继承

-

一个类除了自身所拥有的属性方法之外 , 还获取了另外一个类的成员属性和方法

继承正如其名,继承上一代的东西。继承了某对象将拥有该对象的属性和方法,并且还可以自己拓展添加自己的属性和方法

可以增加代码的可重用性,拓展,修改

-

继承概念的实现方式有二类:实现继承与接口继承

- 实现继承是指直接使用父类的属性和方法而无需额外编码的能力

- 接口继承是指仅使用属性和方法的名称、但是子类必须提供实现的能力

-

-

-

OOP的五大基本原则

-

单一职责原则SRP(Single Responsibility Principle)

- 一个类的功能要单一,不能包罗万象

-

开放封闭原则OCP(Open-Close Principle)

- 一个模块在扩展性方面应该是开放的而在更改性方面应该是封闭的

-

里式替换原则LSP(the Liskov Substitution Principle LSP)

- 子类应当可以替换父类并出现在父类能够出现的任何地方

-

依赖倒置原则DIP(the Dependency Inversion Principle DIP)

-

具体依赖抽象,上层依赖下层

假设B是较A低的模块,但B需要使用到A的功能,这个时候,B不应当直接使用A中的具体类

而应当由B定义一个抽象接口,并由A来实现这个抽象接口,B只使用这个抽象接口

这样就达到了依赖倒置的目的,B也解除了对A的依赖,反过来是A依赖于B定义的抽象接口

通过上层模块难以避免依赖下层模块,假如B也直接依赖A的实现,那么就可能造成循环依赖

一个常见的问题就是编译A模块时需要直接包含到B模块的cpp文件,而编译B时同样要直接包含到A的cpp文件

-

-

接口分离原则ISP(the Interface Segregation Principle ISP)

- 模块间要通过抽象接口隔离开,而不是通过具体的类强耦合起来

-

PO和OOP

面向过程

-

优点

- 性能比面向对象高,因为类调用时需要实例化,开销比较大

- 比较消耗资源;比如单片机、嵌入式开发、 Linux/Unix等一般采用面向过程开发,性能是最重要的因素

-

缺点

- 没有面向对象易维护、易复用、易扩展

面向对象

-

优点

- 易维护、易复用、易扩展,由于面向对象有封装、继承、多态性的特性,可以设计出低耦合的系统,使系统更加灵活、更加易于维护

-

缺点

- 性能比面向过程低

区别

- 都可以实现代码重用和模块化编程,但是面对对象的模块化更深,数据更封闭,也更安全,因为面向对象的封装性更强

- 面对对象的思维方式更加贴近于现实生活,更容易解决大型的复杂的业务逻辑

- 从前期开发角度上来看,面对对象远比面向过程要复杂,但是从维护和扩展功能的角度上来看,面对对象远比面向过程要简单

python

闭包函数

-

简介

如果在一个函数的内部定义了另一个函数,外部的我们叫他外函数,内部的我们叫他内函数。

在一个外函数中定义了一个内函数,内函数里运用了外函数的临时变量,并且外函数的返回值是内函数的引用。这样就构成了一个闭包。

闭包中外部函数返回的不是一个具体的值,而是一个函数。一般情况下,返回的函数会赋值给一个变量,这个变量可以在后面被继续执行调用。

-

作用

函数开头需要做一些额外工作,当多次调用该函数时,如果将额外工作的代码放在外部函数,就可以减少多次调用导致的不必要开销,提高程序的运行效率。

-

装饰器

例如工作中写了一个登录功能,我们想统计这个功能执行花了多长时间,可以用装饰器装饰这个登录模块,装饰器帮我们完成登录函数执行之前和之后取时间。

-

面向对象

经历了上面的分析,我们发现外函数的临时变量送给了内函数。类对象有好多类似的属性和方法,用类创建出来的对象都具有相同的属性方法

闭包也是实现面向对象的方法之一。在python当中虽然我们不这样用,在其他编程语言入比如avaScript中,经常用闭包来实现面向对象编程。

-

# 闭包函数,其中 exponent 称为自由变量

def nth_power(exponent):

def exponent_of(base):

return base ** exponent

return exponent_of # 返回值是 exponent_of 函数

square = nth_power(2) # 计算一个数的平方

cube = nth_power(3) # 计算一个数的立方

print(square(2)) # 计算 2 的平方

print(cube(2)) # 计算 2 的立方

# 运行结果为

4

8

"""

在上面程序中,外部函数 nth_power() 的返回值是函数 exponent_of(),而不是一个具体的数值。

需要注意的是,在执行完 square = nth_power(2) 和 cube = nth_power(3) 后,外部函数 nth_power() 的参数 exponent 会和内部函数 exponent_of 一起赋值给 squre 和 cube,这样在之后调用 square(2) 或者 cube(2) 时,程序就能顺利地输出结果,而不会报错说参数 exponent 没有定义。

"""

# Python闭包的__closure__属性

"""

闭包比普通的函数多了一个 __closure__ 属性,该属性记录着自由变量的地址。

当闭包被调用时,系统就会根据该地址找到对应的自由变量,完成整体的函数调用。

以 nth_power() 为例,当其被调用时,可以通过 __closure__ 属性获取自由变量(也就是程序中的 exponent 参数)存储的地址

"""

print(square.__closure__)

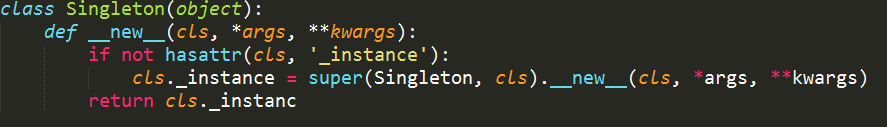

单例模式

- 实现方式: 1. 使用__new__; 2. 使用装饰器; 3. 使用元类(metaclass)

使用__new__

class Singleton(object):

def __new__(cls):

# 关键在于这,每一次实例化的时候,我们都只会返回这同一个 instance 对象

if not hasattr(cls, 'instance'):

cls.instance = super(Singleton, cls).__new__(cls)

return cls.instance

使用装饰器

def singleton(cls):

instances = {}

def getinstance(*args,**kwargs):

if cls not in instances:

instances[cls] = cls(*args,**kwargs)

return instances[cls]

return getinstance

@singleton

class MyClass:

a = 1

c1 = MyClass()

c2 = MyClass()

print(c1 == c2) # True

"""

在上面,我们定义了一个装饰器 singleton,它返回了一个内部函数 getinstance,该函数会判断某个类是否在字典 instances 中,如果不存在,则会将 cls 作为 key,cls(*args, **kw) 作为 value 存到instances 中,否则,直接返回 instances[cls]。

"""

使用元类

class Singleton2(type):

def __init__(self, *args, **kwargs):

self.__instance = None

super(Singleton2,self).__init__(*args, **kwargs)

def __call__(self, *args, **kwargs):

if self.__instance is None:

self.__instance = super(Singleton2,self).__call__(*args, **kwargs)

return self.__instance

class Foo(object):

__metaclass__ = Singleton2

#在代码执行到这里的时候,元类中的__new__方法和__init__方法其实已经被执行了,而不是在 Foo 实例化的时候执行。且仅会执行一次。

foo1 = Foo()

foo2 = Foo()

#_Singleton__instance': <__main__.Foo object at 0x100c52f10> 存在一个私有属性来保存属性

print (Foo.__dict__)

print (foo1 is foo2) # True

装饰器

闭包

-

要想了解装饰器,首先要了解闭包。闭包就是在函数中再嵌套一个函数,并且引用外部函数的变量,这就是闭包

def outer(x): def inner(y): return x + y return inner print(outer(6)(5)) # 11如代码所示,在outer函数内,又定义了一个inner函数,并且inner函数又引用了外部函数outer的变量x,这就是一个闭包

在输出时,outer(6)(5),第一个括号传进去的值返回inner函数,其实就是返回6 + y,所以再传第二个参数进去,就可以得到返回值,6 + 5

装饰器

-

装饰器就是一个闭包,装饰器是闭包的一种应用

简言之,python 装饰器就是用于拓展原来函数功能的一种函数,这个函数的特殊之处在于它的返回值也是一个函数

使用 python 装饰器的好处就是在不用更改原函数的代码前提下给函数增加新的功能

# 装饰器给函数加上一个进入函数的debug模式,不用修改原函数代码就完成了这个功能 def debug(func): def wrapper(): print("[DEBUG]: enter {}()".format(func.__name__)) return func() return wrapper @debug def hello(): print("hello") hello() """ [DEBUG]: enter hello() hello """

带参数的装饰器

-

装饰器可以加参数,另外装饰的函数也是可以传参数的

def logging(level): # 装饰器可传入参数 def outwrapper(func): # 多一层方法嵌套 def wrapper(*args, **kwargs): # 使用 *args, **kwargs 适应所有参数 print("[{0}]: enter {1}()".format(level, func.__name__)) return func(*args, **kwargs) # 传递参数给真实调用的方法 return wrapper return outwrapper @logging(level="INFO") def hello(a, b, c): print(a, b, c) hello("hello,","good","morning") """ [INFO]: enter hello() hello, good morning """

类装饰器

-

装饰器不一定只用函数写,也可以使用类装饰器,用法与函数装饰器并没有太大区别,实质是使用了类方法中的call魔法方法来实现类的直接调用

类利用了

__init__和__call__方法__init__定义了装饰器的参数__call__会在调用logging对象的方法时触发- 可以这样理解:

t=logging(level="TEST")会调用__init__,而调用t(hello)会调用__call__(hello)

class logging(object): def __init__(self, func): self.func = func def __call__(self, *args, **kwargs): print("[DEBUG]: enter {}()".format(self.func.__name__)) return self.func(*args, **kwargs) @logging def hello(a, b, c): print(a, b, c) hello("hello,","good","morning") """ [DEBUG]: enter hello() hello, good morning """ -

类装饰器也是可以带参数的

class logging(object): def __init__(self, level): self.level = level def __call__(self, func): def wrapper(*args, **kwargs): print("[{0}]: enter {1}()".format(self.level, func.__name__)) return func(*args, **kwargs) return wrapper @logging(level="TEST") def hello(a, b, c): print(a, b, c) hello("hello,","good","morning") """ [TEST]: enter hello() hello, good morning """

装饰器使用场景

-

知道了如何实现一个装饰器,那么可以在不修改原方法的情况下,给方法增加额外的功能,这就非常适合给方法集成一些通用的逻辑

例如记录日志、记录执行耗时、本地缓存、路由映射等功能

-

记录日志

import logging from functools import wraps def logging(func): @wraps(func) def wrapper(*args, **kwargs): # 记录调用日志 logging.info('call method: %s %s %s', func.func_name, args, kwargs) return func(*args, **kwargs) return wrapper -

记录方法执行耗时

from functools import wraps def timeit(func): @wraps(func) def wrapper(*args, **kwargs): start = time.time() result = func(*args, **kwargs) duration = int(time.time() - start) # 统计耗时 print 'method: %s, time: %s' % (func.func_name, duration) return result return wrapper -

记录方法执行次数

from functools import wraps def counter(func): @wraps(func) def wrapper(*args, **kwargs): wrapper.count = wrapper.count + 1 # 累计执行次数 print 'method: %s, count: %s' % (func.func_name, wrapper.count) return func(*args, **kwargs) wrapper.count = 0 return wrapper -

本地缓存

from functools import wraps def localcache(func): cached = {} miss = object() @wraps(func) def wrapper(*args): result = cached.get(args, miss) if result is miss: result = func(*args) cached[args] = result return result return wrapper -

路由映射

class Router(object): def __init__(self): self.url_map = {} def register(self, url): def wrapper(func): self.url_map[url] = func return wrapper def call(self, url): func = self.url_map.get(url) if not func: raise ValueError('No url function: %s', url) return func() router = Router() @router.register('/page1') def page1(): return 'this is page1' @router.register('/page2') def page2(): return 'this is page2' print router.call('/page1') print router.call('/page2') -

除此之外,装饰器还能用在权限校验、上下文处理等场景中

总结

-

基于 Python 中一切皆对象的概念,我们理解了实现装饰器的本质:闭包

闭包可以传入一个方法对象,然后返回一个增强功能的方法对象,然后配合 Python 提供的

@语法糖,就可以实现一个装饰器 -

除了用函数实现一个装饰器之外,还可以通过 Python 的魔法方法,用类来实现一个装饰器

-

使用装饰器的常见场景,主要包括权限校验、日志记录、方法调用耗时、本地缓存、路由映射等功能

-

使用装饰器的好处是,可以把我们的业务逻辑和控制逻辑分离开,业务开发人员可以更好地关注业务逻辑

装饰器可以方便地实现对控制逻辑的统一定义,这种方式也遵循了设计模式中的单一职责

推导式

列表:

[val for val in Iterable]

lst = [i for i in range(1,101)]

集合:

{val for val in Iterable}

字典:

{k:v for k,v in Iterable}

# 枚举 ,将索引号和 iterable 中的值,一个一个拿出来配对组成元组放入迭代器中

enumerate(iterable,[start=0])

# 参数:

iterable : 可迭代性数据 (迭代器 , 容器类型数据 , 可迭代对象range)

start : 可以选择开始的索引号(默认从0开始索引)

# zip 拉链式,将多个 iterable 中的值,一个一个拿出来配对组成元组放入迭代器中

zip(iterable, ... ...)

# 参数:

iterable : 可迭代性数据 (迭代器 , 容器类型数据 , 可迭代对象range)

# zip 形成字典推导式 变成字典

lst1 = ["苏大强","小明","小花","小蔡","小新"]

lst2 = ["苏明成","小小明","大花","小保姆"]

dic = {k:v for k,v in zip(lst1,lst2)}

匿名函数

-

匿名函数 lambda

是指一类无需定义标识符(函数名)的函数或子程序。lambda 函数可以接收任意多个参数 (包括可选参数) 并且返回单个表达式的值。

-

语法

lambda [arg1 [,arg2,.....argn]]: expression lambda x, y: x*y # 函数输入是x和y,输出是它们的积x*y lambda:None # 函数没有输入参数,输出是None lambda *args: sum(args) # 输入是任意个数参数,输出是它们的和(隐性要求输入参数必须能进行算术运算) lambda **kwargs: 1 # 输入是任意键值对参数,输出是1冒号前是参数,可以有多个,用逗号隔开,冒号右边的为表达式(只能为一个)。其实lambda返回值是一个函数的地址,也就是函数对象。

高阶函数

- 定义 : 能够把函数当成参数传递的就是高阶函数

map

# 语法:

map(func,Iterable)

# 功能:

处理数据

把可迭代型数据中的数据一个一个拿出来,放到到函数中做处理,把处理之后的结果放到迭代器当中,最后返回迭代器

# 参数:

func : 自定义函数

Iterable: 可迭代型数据(容器类型数据,range对象,迭代器)

# 返回值:

迭代器

# 1. lst = ["1","2","3","4"] => [1,2,3,4]

lst = ["1","2","3","4"]

# 常规写法

lst_new = []

for i in lst:

lst_new.append(int(i))

print(lst_new)

# map 改造

it = map(int,lst)

"""

代码解析:

先把"1"扔到int当中做处理,将强转后的结果扔到迭代器中

然后把"2"扔到int当中做处理,将强转后的结果扔到迭代器中

然后把"3"扔到int当中做处理,将强转后的结果扔到迭代器中

然后把"4"扔到int当中做处理,将强转后的结果扔到迭代器中

最终返回迭代器

"""

# 获取迭代器中的数据

# 方法1. next

res = next(it)

print(res)

# 方法2. for

for i in it:

print(i)

# 方法3. for + next

for i in range(4):

res = next(it)

print(res)

# list强转

print(list(it))

# 2. [1,2,3,4] => [2,8,24,64]

lst = [1,2,3,4]

"""

1 * 2^1 = 2

2 * 2^2 = 8

3 * 2^3 = 24

4 * 2^4 = 64

"""

# 常规写法

lst_new = []

for i in lst:

res = i << i

lst_new.append(res)

print(lst_new)

# map 改造

"""参数和返回值return一定要写"""

def func(n):

return n << n

lst = [1,2,3,4]

it = map(func,lst)

print(list(it))

# lambda + map

it = map(lambda n : n << n,lst)

print(list(it))

filter

# 语法:

filter(func,Iterable)

# 功能:

过滤数据

return True 当前这个数据保留

return False 当前这个数据舍弃

# 参数:

func : 自定义函数

Iterable: 可迭代型数据(容器类型数据,range对象,迭代器)

# 返回值:

迭代器

lst = [1,2,3,4,5,6,7,8,9,10]

# 常规写法

lst_new = []

for i in lst:

if i % 2 == 0:

lst_new.append(i)

print(lst_new)

# filter 改写

def func(i):

if i % 2 == 0:

return True

else:

return False

it = filter(func,lst)

# 1.next

res = next(it)

print(res)

# 2. for

for i in it:

print(i)

# 3. for + next

it = filter(func,lst)

for i in range(5):

res = next(it)

print(res)

# 4. list 强转

res = list(it)

print(res)

# filter + lambda 改写

it = filter(lambda i : True if i % 2 == 0 else False , lst)

print(list(it))

reduce

# 语法:

reduce(func,Iterable)

# 功能:

计算数据

先把可迭代型数据中的前两个值拿出来,放到函数当中做运算,把计算结果和可迭代型数据中的第三个元素再扔进函数当中做运算

再把结果算出来,和第四个元素做运算,以此类推,直到所有结果运算完毕,返回该结果

# 参数:

func : 自定义函数

Iterable: 可迭代型数据(容器类型数据,range对象,迭代器)

# 返回值:

计算之后的结果

# 从 ... 导入 ...

from functools import reduce

# 练习1

lst = [5,4,8,8] # => 整型 5488

def func(x,y):

return x*10 + y

res = reduce(func,lst)

print(res , type(res))

"""

代码解析 :

先拿出5和4两个元素,扔到 func 当中做运算,结果是54

再拿54和8两个元素,扔到 func 当中做运算,结果是548

再拿548和8两个元素,扔到 func 当中做运算,结果5488

返回最终结果 : 5488 程序结束

"""

# reduce + lambda 改造

res = reduce(lambda x,y : x*10 + y , lst)

print(res)

# 练习2

""" "789" => 789 禁止使用int强转 """

def func(x,y):

return x*10 + y

strvar = "789"

res = reduce(func,list(strvar))

print(res , type(res))

"""

代码运行结果:

77777777778 * 10 + 9

777777777787777777777877777777778777777777787777777777877777777778777777777787777777777877777777778777777777789 <class 'str'>

"""

# "789" -> 数字7 数字8 数字9

def func1(x,y):

return x*10 + y

def func2(n):

dic = {"0":0,"1":1,"2":2,"3":3,"4":4,"5":5,"6":6,"7":7,"8":8,"9":9}

return dic[n]

it = map(func2,"789") # [7,8,9]

res = reduce(func1,it)

print(res , type(res))

sorted

# 功能:

排序

# 语法:

sorted( Iterable , key=函数 , reverse=False )

# 参数:

Iterable : 可迭代型数据(容器类型数据,range对象,迭代器)

key : 自定义函数 或 内置函数

reverse : 代表升序或者降序,默认是升序(从小到大排序) reverse=False

# 返回值:

排序后的结果

# 1. 默认是从小到大排序

lst = [1,2,3,4,5,-65,-100,-3,-7,22]

res = sorted(lst)

# 2. reverse 从大到小排序

res = sorted(lst,reverse=True)

# 3. 指定函数进行排序

# 按照绝对值排序 abs

lst = [-65,-8,4,-77,9,-5,6]

res = sorted(lst,key=abs)

# 4. 使用自定义函数进行排序

lst = [23,78,64,52,85]

def func(n):

return n % 10

lst = sorted(lst,key=func)

# 5. 使用 `sorted` 函数按年龄进行排序

student_tuples = [

('john', 'A', 15),

('jane', 'B', 12),

('dave', 'B', 10),

]

student_tuples_sort = sorted(student_tuples, key=lambda x:x[2])

sorted 和 sort 之间的区别

- sorted 可以排序一切容器类型数据 , sort 只能排列表

- sorted 返回的是新列表 , sort 是基于原有的列表进行修改(推荐使用sorted)

偏函数

官方解释

functools.partial(func, *args, **keywords)

Return a new partial object which when called will behave like func called with the positional arguments args and keyword arguments keywords.

If more arguments are supplied to the call, they are appended to args. If additional keyword arguments are supplied, they extend and override keywords.

Roughly equivalent to:

-

返回一个偏函数对象,这个对象和 func 一样,可以被调用,同时在调用的时候可以指定位置参数 (*args) 和 关键字参数(**kwargs)

如果有更多的位置参数提供调用,会被附加到 args 中

如果有额外的关键字参数提供,将会扩展并覆盖原有的关键字参数

# 定义一个函数,接受三个参数

def partial(func, *args, **keywords):

def newfunc(*fargs, **fkeywords):

newkeywords = keywords.copy()

newkeywords.update(fkeywords)

return func(*args, *fargs, **newkeywords)

newfunc.func = func

newfunc.args = args

newfunc.keywords = keywords

return newfunc

定义

partial_func = functools.partial(func, *args, **keywords)

# partial 接受三个参数

func: 需要被扩展的函数,返回的函数其实是一个类 func 的函数

*args: 需要被固定的位置参数

**kwargs: 需要被固定的关键字参数

# 如果在原来的函数 func 中关键字参数不存在,将会扩展,如果存在,则会覆盖

def add(*args, **kwargs):

# 打印位置参数

for n in args:

print(n)

print("-"*20)

# 打印关键字参数

for k, v in kwargs.items():

print('%s:%s' % (k, v))

# 暂不做返回,只看下参数效果,理解 partial 用法

# 普通调用

add(1, 2, 3, v1=10, v2=20)

"""

1

2

3

--------------------

v1:10

v2:20

"""

# partial

add_partial = partial(add, 10, k1=10, k2=20)

add_partial(1, 2, 3, k3=20)

"""

10

1

2

3

--------------------

k1:10

k2:20

k3:20

"""

add_partial(1, 2, 3, k1=20)

"""

10

1

2

3

--------------------

k1:20

k2:20

"""

作用

-

和装饰器一样,它可以扩展函数的功能,但又不完成等价于装饰器

通常应用的场景是当我们要频繁调用某个函数时,其中某些参数是已知的固定值,通常我们可以调用这个函数多次,但这样看上去似乎代码有些冗余,而偏函

数的出现就是为了很少的解决这一个问题

场景

-

partial 有个专有名词,叫做科里化,实际上python的对象方法绑定就是用类似partial的方式完成的,对象在生成的时候,方法和对象是无关的,对象方法在

new的时候通过partial绑定在对象上,所以python永远不愿意取消self的方法参数,本身就在说明这点

而且你的对象同时也可以包含和生成类无关的对象方法,说明对象方法在内存中和类定义是无关的

事实上python中的类更像是一种生成对象的原型工厂,方法是预编译后绑定在对象上的,而不像是一个通常面向对象的编程语言

-

flask 有 redirect(path, code=302),假如要写十几个 if 语句,全要加 302, 会很麻烦。但是 redirect_302 = partial(redirect, code=302) 后就变成单参函数了

-

flask 利用 local() 为线程或协程开辟资源空间,并用 stack 栈存储维护,内部再使用偏函数 functools.partial(func1, 10) 拆分各属性值

-

flask LocalProxy 代理对象使用偏函数

LocalProxy就是flask框架的werkzeug工具实现的一个代理对象,它接收一个可调用的无参数函数作为参数,内部实现了object对象所有的魔法方法的重写,

理论上可以代理任何的对象,不管这个对象的结构是怎么样的

_request_ctx_err_msg = '''\ Working outside of request context. This typically means that you attempted to use functionality that needed an active HTTP request. Consult the documentation on testing for information about how to avoid this problem.\ ''' _app_ctx_err_msg = '''\ Working outside of application context. This typically means that you attempted to use functionality that needed to interface with the current application object in some way. To solve this, set up an application context with app.app_context(). See the documentation for more information.\ ''' def _lookup_req_object(name): top = _request_ctx_stack.top if top is None: raise RuntimeError(_request_ctx_err_msg) return getattr(top, name) def _lookup_app_object(name): top = _app_ctx_stack.top if top is None: raise RuntimeError(_app_ctx_err_msg) return getattr(top, name) def _find_app(): top = _app_ctx_stack.top if top is None: raise RuntimeError(_app_ctx_err_msg) return top.app # context locals _request_ctx_stack = LocalStack() _app_ctx_stack = LocalStack() current_app = LocalProxy(_find_app) request = LocalProxy(partial(_lookup_req_object, 'request')) session = LocalProxy(partial(_lookup_req_object, 'session')) g = LocalProxy(partial(_lookup_app_object, 'g'))

实例

-

100 加任意数的和

# 常规做法 """ 两种做法都会存在有问题: 第一种,100这个固定值会返回出现,代码总感觉有重复 第二种,就是当我们想要修改 100 这个固定值的时候,我们需要改动 add 这个方法 """ # 一 def add(*args): return sum(args) print(add(1, 2, 3) + 100) print(add(5, 5, 5) + 100) # 二 def add(*args): # 对传入的数值相加后,再加上100返回 return sum(args) + 100 print(add(1, 2, 3)) # 106 print(add(5, 5, 5)) # 115 # parital from functools import partial def add(*args): return sum(args) add_100 = partial(add, 100) print(add_100(1, 2, 3)) # 106 add_101 = partial(add, 101) print(add_101(1, 2, 3)) # 107

魔法方法

构造方法

-

最为熟知的基本的魔法方法就是 _init_ ,可以用它来指明一个对象初始化的行为

当调用 x = SomeClass() 的时候, _init_ 并不是第一个被调用的方法

事实上,第一个被调用的是 _new_ ,这个 方法才真正地创建了实例

当这个对象的生命周期结束的时候,_del_ 会被调用

-

_new_(cls,[…)

- _new_ 是对象实例化时第一个调用的方法,它只取 cls 参数,并把其他参数传给 _init_

- _new_ 很少使用,但是也有它适合的场景,尤其是当类继承自一个像元组或者字符串这样不经常改变的类型的时候

-

_init_(self,[…])

- 类的初始化方法

- 它获取任何传给构造器的参数(比如我们调用 x = SomeClass(10, ‘foo’) , _init_ 就会接到参数 10 和 ‘foo’

-

_del_(self)

-

_new_ 和 _init_ 是对象的构造器, _del_ 是对象的销毁器

-

它并非实现了语句 del x (因此该语句不等同于 x.del())

-

而是定义了当对象被垃圾回收时的行为

当对象需要在销毁时做一些处理的时候这个方法很有用,比如 socket 对象、文件对象

但是需要注意的是,当Python解释器退出但对象仍然存活的时候, _del_ 并不会执行

-

可调用对象

-

在Python中,函数是一等的对象

这意味着它们可以像其他任何对象一样被传递到函数和方法中,这是一个十分强大的特性

-

_call_(self, [args…])

允许类的一个实例像函数那样被调用

注意 _call_ 可以有多个参数,这代表你可以像定义其他任何函数一样,定义 _call_

class Entity: '''表示一个实体的类,调用它的实例,可以更新实体的位置''' def __init__(self, size, x, y): self.x, self.y = x, y self.size = size def __call__(self, x, y): self.x, self.y = y, x

深浅拷贝

-

_copy_(self)

定义对类的实例使用 copy.copy() 时的行为

copy.copy() 返回一个对象的浅拷贝,这意味着拷贝出的实例是全新的,然而里面的数据全都是引用的

也就是说,对象本身是拷贝的,但是它的数据还是引用的(所以浅拷贝中的数据更改会影响原对象)

-

_deepcopy_(self, memodict=)

定义对类的实例使用 copy.deepcopy() 时的行为

copy.deepcopy() 返回一个对象的深拷贝,这个对象和它的数据全都被拷贝了一份

memodict 是一个先前拷贝对象的缓存,它优化了拷贝过程,而且可以防止拷贝递归数据结构时产生无限递归

当你想深拷贝一个单独的属性时,在那个属性上调用 copy.deepcopy() ,使用 memodict 作为第一个参数

上下文管理器

- _enter_() 和 _exit_() 方法的对象都可称之为上下文管理器,上下文管理器对象可以使用 with 关键字。显然,文件(file)对象也实现了上下文管理器

-

_enter_ 和 __ exit__

-

当 with 对象时, 就会触发这个对象的**_enter_**方法

-

当离开 with 代码块, 会触发这个对象的 __ exit__ 方法

-

with open('foo.txt') as bar: pass

-

-

示例(可关闭的连接)

class Closer: '''一个上下文管理器,可以在with语句中使用close()自动关闭对象''' def __init__(self, obj): self.obj = obj def __enter__(self, obj): return self.obj # 绑定到目标 def __exit__(self, exception_type, exception_value, traceback): try: self.obj.close() except AttributeError: # obj不是可关闭的 print 'Not closable.' return True # 成功地处理了异常 # 一个 Closer 在实际使用中的例子,使用一个FTP连接来演示 >>> from magicmethods import Closer >>> from ftplib import FTP >>> with Closer(FTP('ftp.somesite.com')) as conn: ... conn.dir() ... # 为了简单,省略了某些输出 >>> conn.dir() # 很长的 AttributeError 信息,不能使用一个已关闭的连接 >>> with Closer(int(5)) as i: ... i += 1 ... Not closable. >>> i 6

描述符

简介

-

在 Python 中,**允许把一个类属性,托管给一个类,这个属性就是一个「描述符」。**换句话说,「描述符」是一个「绑定行为」的属性

也可以把「描述符」理解为:对象的属性不再是一个具体的值,而是交给了一个方法去定义

# 在类 A 中定义了一个类属性 x,然后打印它的值

class A:

x = 10

print(A.x) # 10

# 除了直接定类属性之外,还可以这样定义一个类属性:

# 类属性 x 不再是一个具体的值,而是一个类 Ten。Ten 中定义了一个 __get__ 方法,返回具体的值

class Ten:

def __get__(self, obj, objtype=None):

return 10

class A:

x = Ten() # 属性换成了一个类

print(A.x) # 10

# 可以根据不同的条件,在方法内给属性赋予不同的值

# age 类属性被另一个类托管了,在这个类的 __get__ 中,它会根据 Person 类的属性 name,决定 age 是什么值

# 通过描述符的使用,我们可以轻易地改变一个类属性的定义方式

class Age:

def __get__(self, obj, objtype=None):

if obj.name == 'zhangsan':

return 20

elif obj.name == 'lisi':

return 25

else:

return ValueError("unknow")

class Person:

age = Age()

def __init__(self, name):

self.name = name

p1 = Person('zhangsan')

print(p1.age) # 20

p2 = Person('lisi')

print(p2.age) # 25

p3 = Person('wangwu')

print(p3.age) # unknow

协议

-

一个类属性想要托管给一个类,这个类内部实现的方法不能是随便定义的,它必须遵守「描述符协议」,也就是要实现以下几个方法:

-

__get__(self, obj, type=None) -> value -

__set__(self, obj, value) -> None -

__delete__(self, obj) -> None

只要是实现了以上几个方法的其中一个,那么这个类属性就可以称作描述符

-

-

描述符又可以分为「数据描述符」和「非数据描述符」:

- 只定义了

__get___,叫做非数据描述符 - 除了定义

__get__之外,还定义了__set__或__delete__,叫做数据描述符

- 只定义了

# coding: utf8

class Age:

def __init__(self, value=20):

self.value = value

def __get__(self, obj, type=None):

print('call __get__: obj: %s type: %s' % (obj, type))

return self.value

def __set__(self, obj, value):

if value <= 0:

raise ValueError("age must be greater than 0")

print('call __set__: obj: %s value: %s' % (obj, value))

self.value = value

class Person:

age = Age()

def __init__(self, name):

self.name = name

p1 = Person('zhangsan')

print(p1.age)

# call __get__: obj: <__main__.Person object at 0x1055509e8> type: <class '__main__.Person'>

# 20

print(Person.age)

# call __get__: obj: None type: <class '__main__.Person'>

# 20

p1.age = 25

# call __set__: obj: <__main__.Person object at 0x1055509e8> value: 25

print(p1.age)

# call __get__: obj: <__main__.Person object at 0x1055509e8> type: <class '__main__.Person'>

# 25

p1.age = -1

# ValueError: age must be greater than 0

-

上述示例中,类属性

age是一个描述符,它的值取决于Age类从输出结果来看,当我们获取或修改

age属性时,调用了Age的__get__和__set__方法:- 当调用

p1.age时,__get__被调用,参数obj是Person实例,type是type(Person) - 当调用

Person.age时,__get__被调用,参数obj是None,type是type(Person) - 当调用

p1.age = 25时,__set__被调用,参数obj是Person实例,value是25 - 当调用

p1.age = -1时,__set__没有通过校验,抛出ValueError

其中,调用

__set__传入的参数,比较容易理解,但对于__get__方法,通过类或实例调用,传入参数是不同的,这就需要了解描述符的工作原理 - 当调用

工作原理

-

要解释描述符的工作原理,首先我们需要先从属性的访问说起。

在开发时,不知道你有没有想过这样一个问题:通常我们写这样的代码

a.b,其背后到底发生了什么?这里的

a和b可能存在以下情况:- a 可能是一个类,也可能是一个实例,我们这里统称为对象

- b 可能是一个属性,也可能是一个方法,方法其实也可以看做是类的属性

-

无论是以上哪种情况,在 Python 中,都有一个统一的调用逻辑:

- 先调用

__getattribute__尝试获得结果 - 如果没有结果,调用

__getattr__

- 先调用

-

用代码表示:

def getattr_hook(obj, name): try: return obj.__getattribute__(name) except AttributeError: if not hasattr(type(obj), '__getattr__'): raise return type(obj).__getattr__(obj, name) -

这里需要重点关注一下

__getattribute__,因为它是所有属性查找的入口,它内部实现的属性查找顺序是这样的:- 要查找的属性,在类中是否是一个描述符

- 如果是描述符,再检查它是否是一个数据描述符

- 如果是数据描述符,则调用数据描述符的

__get__ - 如果不是数据描述符,则从

__dict__中查找 - 如果

__dict__中查找不到,再看它是否是一个非数据描述符 - 如果是非数据描述符,则调用非数据描述符的

__get__ - 如果也不是一个非数据描述符,则从类属性中查找

- 如果类中也没有这个属性,抛出

AttributeError异常

-

用代码表示:

# 获取一个对象的属性 def __getattribute__(obj, name): null = object() # 对象的类型 也就是实例的类 objtype = type(obj) # 从这个类中获取指定属性 cls_var = getattr(objtype, name, null) # 如果这个类实现了描述符协议 descr_get = getattr(type(cls_var), '__get__', null) if descr_get is not null: if (hasattr(type(cls_var), '__set__') or hasattr(type(cls_var), '__delete__')): # 优先从数据描述符中获取属性 return descr_get(cls_var, obj, objtype) # 从实例中获取属性 if hasattr(obj, '__dict__') and name in vars(obj): return vars(obj)[name] # 从非数据描述符获取属性 if descr_get is not null: return descr_get(cls_var, obj, objtype) # 从类中获取属性 if cls_var is not null: return cls_var # 抛出 AttributeError 会触发调用 __getattr__ raise AttributeError(name) -

到这里我们可以看到,在一个对象中查找一个属性,都是先从

__getattribute__开始的在

__getattribute__中,它会检查这个类属性是否是一个描述符,如果是一个描述符,那么就会调用它的__get__方法但具体的调用细节和传入的参数是下面这样的:

# 如果 a 是一个实例,调用细节为: type(a).__dict__['b'].__get__(a, type(a)) # 如果 a 是一个类,调用细节为: a.__dict__['b'].__get__(None, a)

数据和非数据描述符

-

定义的区别:

- 只定义了

__get___,叫做非数据描述符 - 除了定义

__get__之外,还定义了__set__或__delete__,叫做数据描述符

此外,我们从上面描述符调用的顺序可以看到,在对象中查找属性时,数据描述符要优先于非数据描述符调用

在之前的例子中,我们定义了

__get__和__set__,所以那些类属性都是数据描述符。 - 只定义了

-

非数据描述符 示例:

class A: def __init__(self): self.foo = 'abc' def foo(self): return 'xyz' print(A().foo) """ 这段代码定义了一个相同名字的属性和方法 foo,如果现在执行 A().foo,会输出答案 abc,这就和非数据描述符有关系了 """ # 执行 dir(A.foo),观察结果 print(dir(A.foo)) # [... '__get__', '__getattribute__', ...] """ A 的 foo 方法其实实现了 __get__,在上面的分析已经得知: 只定义 __get__ 方法的对象,它其实是一个非数据描述符,也就是说,在类中定义的方法,其实本身就是一个非数据描述符 所以,在一个类中,如果存在相同名字的属性和方法,按照上面所讲的 __getattribute__ 中查找属性的顺序,这个属性就会优先从实例中获取,如果实例中不存在,才会从非数据描述符中获取,所以在这里优先查找的是实例属性 foo 的值 """

总结关于描述符的相关知识点:

- 描述符必须是一个类属性

__getattribute__是查找一个属性(方法)的入口__getattribute__定义了一个属性(方法)的查找顺序:数据描述符、实例属性、非数据描述符、类属性- 如果我们重写了

__getattribute__方法,会阻止描述符的调用 - 所有方法其实都是一个非数据描述符,因为它定义了

__get__

使用场景-属性校验器

-

用描述符实现了一个属性校验器

class Validator: def __init__(self): self.data = {} def __get__(self, obj, objtype=None): return self.data[obj] def __set__(self, obj, value): # 校验通过后再赋值 self.validate(value) self.data[obj] = value def validate(self, value): pass -

定义两个校验类,继承

Validator,然后实现自己的校验逻辑class Number(Validator): def __init__(self, minvalue=None, maxvalue=None): super(Number, self).__init__() self.minvalue = minvalue self.maxvalue = maxvalue def validate(self, value): if not isinstance(value, (int, float)): raise TypeError(f'Expected {value!r} to be an int or float') if self.minvalue is not None and value < self.minvalue: raise ValueError( f'Expected {value!r} to be at least {self.minvalue!r}' ) if self.maxvalue is not None and value > self.maxvalue: raise ValueError( f'Expected {value!r} to be no more than {self.maxvalue!r}' ) class String(Validator): def __init__(self, minsize=None, maxsize=None): super(String, self).__init__() self.minsize = minsize self.maxsize = maxsize def validate(self, value): if not isinstance(value, str): raise TypeError(f'Expected {value!r} to be an str') if self.minsize is not None and len(value) < self.minsize: raise ValueError( f'Expected {value!r} to be no smaller than {self.minsize!r}' ) if self.maxsize is not None and len(value) > self.maxsize: raise ValueError( f'Expected {value!r} to be no bigger than {self.maxsize!r}' ) -

使用这个校验类

class Person: # 定义属性的校验规则 内部用描述符实现 name = String(minsize=3, maxsize=10) age = Number(minvalue=1, maxvalue=120) def __init__(self, name, age): self.name = name self.age = age # 属性符合规则 p1 = Person('zhangsan', 20) print(p1.name, p1.age) # 属性不符合规则 p2 = person('a', 20) # ValueError: Expected 'a' to be no smaller than 3 p3 = Person('zhangsan', -1) # ValueError: Expected -1 to be at least 1 "当对 Person 实例进行初始化时,就可以校验这些属性是否符合预定义的规则了"

function与method

-

在开发时经常看到的

function、unbound method、bound method,它们之间的区别代码示例

class A: def foo(self): return 'xyz' print(A.__dict__['foo']) # <function foo at 0x10a790d70> print(A.foo) # <unbound method A.foo> print(A().foo) # <bound method A.foo of <__main__.A object at 0x10a793050>> -

从结果可以看出它们的区别:

-

function准确来说就是一个函数,并且它实现了__get__方法,因此每一个function都是一个非数据描述符,而在类中会把function放到__dict__中存储 -

当

function被实例调用时,它是一个bound method -

当

function被类调用时, 它是一个unbound method

-

-

function是一个非数据描述符而

bound method和unbound method的区别就在于调用方的类型是什么如果是一个实例,那么这个

function就是一个bound method,否则它是一个unbound method

property/staticmethod/classmethod

-

property、staticmethod、classmethod 这些装饰器的实现,默认是 C 来实现的

其实,也可以直接利用 Python 描述符的特性来实现这些装饰器

-

property的 Python 版实现class property: def __init__(self, fget=None, fset=None, fdel=None, doc=None): self.fget = fget self.fset = fset self.fdel = fdel self.__doc__ = doc def __get__(self, obj, objtype=None): if obj is None: return self.fget if self.fget is None: raise AttributeError(), "unreadable attribute" return self.fget(obj) def __set__(self, obj, value): if self.fset is None: raise AttributeError, "can't set attribute" return self.fset(obj, value) def __delete__(self, obj): if self.fdel is None: raise AttributeError, "can't delete attribute" return self.fdel(obj) def getter(self, fget): return type(self)(fget, self.fset, self.fdel, self.__doc__) def setter(self, fset): return type(self)(self.fget, fset, self.fdel, self.__doc__) def deleter(self, fdel): return type(self)(self.fget, self.fset, fdel, self.__doc__) -

staticmethod的 Python 版实现class staticmethod: def __init__(self, func): self.func = func def __get__(self, obj, objtype=None): return self.func -

classmethod的 Python 版实现class classmethod: def __init__(self, func): self.func = func def __get__(self, obj, klass=None): if klass is None: klass = type(obj) def newfunc(*args): return self.func(klass, *args) return newfunc -

由此可见,通过描述符可以实现强大而灵活的属性管理功能,对于一些要求属性控制比较复杂的场景,可以选择用描述符来实现

总结

-

一个类属性是可以托管给另外一个类的,这个类如果实现了描述符协议方法,那么这个类属性就是一个描述符

此外,描述符又可以分为数据描述符和非数据描述符

-

分析获取一个属性的过程,一切的入口都在

__getattribute__中,这个方法定义了寻找属性的顺序其中实例属性优先于数据描述符调用,数据描述符要优先于非数据描述符调用

-

方法其实就是一个非数据描述符,如果在类中定义了相同名字的实例属性和方法,按照

__getattribute__中的属性查找顺序,实例属性优先访问 -

分析了

function和method的区别,以及使用 Python 描述符也可以实现property、staticmethod、classmethod装饰器 -

Python 描述符提供了强大的属性访问控制功能,我们可以在需要对属性进行复杂控制的场景中去使用它

类的表示

-

使用字符串来表示类是一个相当有用的特性

在Python中有一些内建方法可以返回类的表示,相对应的,也有一系列魔法方法可以用来自定义在使用这些内建函数时类的行为

-

_str_(self)

定义对类的实例调用 str() 时的行为

-

_repr_(self)

定义对类的实例调用 repr() 时的行为。 str() 和 repr() 最主要的差别在于“目标用户”

repr() 的作用是产生机器可读的输出(大部分情况下,其输出可以作为有效的Python代码),而 str() 则产生人类可读的输出

-

_unicode_(self)

定义对类的实例调用 unicode() 时的行为。 unicode() 和 str() 很像,只是它返回unicode字符串

注意,如果调用者试图调用 str() 而你的类只实现了 **_unicode_() ,那么类将不能正常工作。所有你应该总是定义 **_str_()

-

_format_(self)

定义当类的实例用于新式字符串格式化时的行为

例如, “Hello, 0:abc!”.format(a) 会导致调用 a._format_(“abc”)

当定义你自己的数值类型或字符串类型时,你可能想提供某些特殊的格式化选项,这种情况下这个魔法方法会非常有用

-

_hash_(self)

定义对类的实例调用 hash() 时的行为

它必须返回一个整数,其结果会被用于字典中键的快速比较

实现这个魔法方法通常也需要实现 __eq__ ,并且遵守如下的规则: a == b 意味着 hash(a) == hash(b)

-

_nonzero_(self)

定义对类的实例调用 bool() 时的行为

根据你自己对类的设计,针对不同的实例,这个魔法方法应该相应地返回True或False

-

_dir_(self)

定义对类的实例调用 dir() 时的行为,这个方法应该向调用者返回一个属性列表

一般来说,没必要自己实现 __dir__

但是如果你重定义了 __getattr__ 或者 __getattribute__ ,乃至使用动态生成的属性,以实现类的交互式使用,那么这个魔法方法是必不可少的

访问控制

-

_getattr_(self, name)

当用户试图访问一个根本不存在(或者暂时不存在)的属性时,你可以通过这个魔法方法来定义类的行为

这个可以用于捕捉错误的拼写并且给出指引,使用废弃属性时给出警告(如果你愿意,仍然可以计算并且返回该属性),以及灵活地处理AttributeError

只有当试图访问不存在的属性时它才会被调用,所以这不能算是一个真正的封装的办法

-

_setattr_(self, name, value)

和 _getattr_ 不同,_setattr_ 可以用于真正意义上的封装

它允许你自定义某个属性的赋值行为,不管这个属性存在与否,也就是说你可以对任意属性的任何变化都定义自己的规则

-

_delattr_(self, name)

这个魔法方法和 _setattr_ 几乎相同,只不过它是用于处理删除属性时的行为

和 _setattr_ 一样,使用它时也需要多加小心,防止产生无限递归(在 _delattr_ 的实现中调用 del self.name 会导致无限递归)

-

_getattribute_(self, name)

_getattribute_ 只能用于新式类,在最新版的Python中所有的类都是新式类,在老版Python中你可以通过继承 object 来创建新式类

_getattribute_ 允许你自定义属性被访问时的行为,它也同样可能遇到无限递归问题(通过调用基类的 _getattribute_ 来避免)

_getattribute_ 基本上可以替代 _getattr_

只有当它被实现,并且显式地被调用,或者产生 AttributeError 时它才被使用

-

递归调用问题

def __setattr__(self, name. value): # 因为每次属性幅值都要调用 __setattr__(),所以这里的实现会导致递归 # 这里的调用实际上是 self.__setattr('name', value) # 因为这个方法一直在调用自己,因此递归将持续进行,直到程序崩溃 self.name = value # 解决方案 def __setattr__(self, name, value): # 定义自定义行为 self.__dict__[name] = value # 使用 __dict__ 进行赋值

容器类型

-

_len_(self)

返回容器的长度,可变和不可变类型都需要实现

-

_getitem_(self, key)

定义对容器中某一项使用 self[key] 的方式进行读取操作时的行为这也是可变和不可变容器类型都需要实现的一个方法

它应该在键的类型错误式产生 TypeError 异常,同时在没有与键值相匹配的内容时产生 KeyError 异常

-

_setitem_(self, key)

定义对容器中某一项使用 self[key] 的方式进行赋值操作时的行为它是可变容器类型必须实现的一个方法

同样应该在合适的时候产生 KeyError 和 TypeError 异常

-

_iter_(self, key)

它应该返回当前容器的一个迭代器迭代器以一连串内容的形式返回

最常见的是使用 iter() 函数调用,以及在类似 for x in container: 的循环中被调用迭代器是他们自己的对象,需要定义 __iter__ 方法并在其中返回自己

-

_reversed_(self)

定义了对容器使用 reversed() 内建函数时的行为它应该返回一个反转之后的序列当你的序列类是有序时,类似列表和元组,再实现这个方法

-

_contains_(self, item)

_contains_ 定义了使用 in 和 not in 进行成员测试时类的行为

你可能好奇为什么这个方法不是序列协议的一部分,原因是,如果 _contains_ 没有定义,Python就会迭代整个序列,如果找到了需要的一项就返回 True

-

_missing_(self ,key)

_missing_ 在字典的子类中使用,它定义了当试图访问一个字典中不存在的键时的行

目前为止是指字典的实例,例如我有一个字典 d , “george” 不是字典中的一个键,当试图访问 d[“george’] 时就会调用 d._missing_(“george”) )

反射

-

_instancecheck_(self, instance)

检查一个实例是否是你定义的类的一个实例(例如 isinstance(instance, class) )

-

_subclasscheck_(self, subclass)

检查一个类是否是你定义的类的子类(例如 issubclass(subclass, class) )

操作符

- 使用Python魔法方法的一个巨大优势就是可以构建一个拥有Python内置类型行为的对象

比较操作符

- _cmp_(self, other)

- _cmp_* 是所有比较魔法方法中最基础的一个,它实际上定义了所有比较操作符的行为(<,==,!=,等等),但是它可能不能按照你需要的方式工作

- 例如,判断一个实例和另一个实例是否相等采用一套标准,而与判断一个实例是否大于另一实例采用另一套

- _cmp_ 应该在 self < other 时返回一个负整数,在 self == other 时返回 0,在 self > other 时返回正整数

- 最好只定义你所需要的比较形式,而不是一次定义全部

- 如果你需要实现所有的比较形式,而且它们的判断标准类似,那么 _cmp_ 是一个很好的方法,可以减少代码重复,让代码更简洁

- _eq_(self, other)

- 定义等于操作符 (==) 的行为

- _ne_(self, other)

- 定义不等于操作符 (!=) 的行为

- _lt_(self, other)

- 定义小于操作符 (<) 的行为

- _gt_(self, other)

- 定义大于操作符 (>) 的行为

- _le_(self, other)

- 定义小于等于操作符 (<=) 的行为

- _ge_(self, other)

- 定义大于等于操作符 (>=) 的行为

数值操作符

-

数值操作符五类:一元操作符,常见算数操作符,反射算数操作符,增强赋值操作符,类型转换操作符

-

一元操作符

-

_pos_(self)

实现取正操作,例如 +some_object

-

_neg_(self)

实现取负操作,例如 -some_object

-

_abs_(self)

实现内建绝对值函数 abs() 操作

-

_invert_(self)

实现取反操作符 ~。

-

_round_(self, n)

实现内建函数 round() ,n 是近似小数点的位数

-

_floor_(self)

实现 math.floor() 函数,即向下取整

-

_ceil_(self)

实现 math.ceil() 函数,即向上取整

-

_trunc_(self)

实现 math.trunc() 函数,即距离零最近的整数

-

-

常见算数操作符(二元操作符)

-

_add_(self, other)

实现加法操作

-

_sub_(self, other)

实现减法操作

-

_mul_(self, other)

实现乘法操作

-

_floordiv_(self, other)

实现使用 // 操作符的整数除法

-

_div_(self, other)

实现使用 / 操作符的除法

-

_truediv_(self, other)

实现 true 除法,这个函数只有使用 from __future__ import division 时才有作用

-

_mod_(self, other)

实现 % 取余操作

-

_divmod_(self, other)

实现 divmod 内建函数

-

__pow__

实现 ** 操作符

-

_lshift_(self, other)

实现左移位运算符 <<

-

_rshift_(self, other)

实现右移位运算符 >>

-

_and_(self, other)

实现按位与运算符 &

-

_or_(self, other)

实现按位或运算符 |

-

_xor_(self, other)

实现按位异或运算符 ^

-

-

反射算数操作符

-

_radd_(self, other)

实现反射加法操作

-

_rsub_(self, other)

实现反射减法操作

-

_rmul_(self, other)

实现反射乘法操作

-

_rfloordiv_(self, other)

实现使用 // 操作符的整数反射除法

-

_rdiv_(self, other)

实现使用 / 操作符的反射除法

-

_rtruediv_(self, other)

实现 true 反射除法,这个函数只有使用 from __future__ import division 时才有作用

-

_rmod_(self, other)

实现 % 反射取余操作符

-

_rdivmod_(self, other)

实现调用 divmod(other, self) 时 divmod 内建函数的操作

-

_rpow_

实现 ** 反射操作符

-

_rlshift_(self, other)

实现反射左移位运算符 << 的作用

-

_rshift_(self, other)

实现反射右移位运算符 >> 的作用

-

_rand_(self, other)

实现反射按位与运算符 &

-

_ror_(self, other)

实现反射按位或运算符 |

-

_rxor_(self, other)

实现反射按位异或运算符 ^

-

-

增强赋值操作符

-

x += 1 # 也就是 x = x + 1

-

_iadd_(self, other)

实现加法赋值操作

-

_isub_(self, other)

实现减法赋值操作

-

_imul_(self, other)

实现乘法赋值操作

-

_ifloordiv_(self, other)

实现使用 //= 操作符的整数除法赋值操作

-

_idiv_(self, other)

实现使用 /= 操作符的除法赋值操作

-

_itruediv_(self, other)

实现 true 除法赋值操作,这个函数只有使用 from future import division 时才有作用

-

_imod_(self, other)

实现 %= 取余赋值操作

-

_ipow_

**实现 **= 操作

-

_ilshift_(self, other)

实现左移位赋值运算符 <<=

-

_irshift_(self, other)

实现右移位赋值运算符 >>=

-

_iand_(self, other)

实现按位与运算符 &=

-

_ior_(self, other)

实现按位或赋值运算符 |

-

_ixor_(self, other)

实现按位异或赋值运算符 ^=

-

-

类型转换操作符

-

_int_(self)

实现到int的类型转换

-

_long_(self)

实现到long的类型转换

-

_float_(self)

实现到float的类型转换

-

_complex_(self)

实现到complex的类型转换

-

_oct_(self)

实现到八进制数的类型转换

-

_hex_(self)

实现到十六进制数的类型转换

-

_index_(self)

实现当对象用于切片表达式时到一个整数的类型转换

-

_trunc_(self)

当调用 math.trunc(self) 时调用该方法, _trunc_ 应该返回 self 截取到一个整数类型(通常是long类型)的值

-

_coerce_(self)

该方法用于实现混合模式算数运算,如果不能进行类型转换, _coerce_ 应该返回 None

反之,它应该返回一个二元组 self 和 other ,这两者均已被转换成相同的类型

-

-

反射

简介

- 通过字符串去操作对象的属性和方法

四个方法

- hasattr、getattr、setattr、delattr

实例化对象的反射操作

class A:

country = "中国"

area = "深圳"

def __init__(self, name, age):

self.name = name

self.age = age

def func(self):

print(666)

a = A("Jane", 18)

# 对象的属性

print(a.name) # Jane

# 注意这个变量名也要用字符串形式

print(hasattr(a, "name")) # True

# 不是这样用,而是字符串形式的属性名

print(hasattr(a, "Jane")) # False

# 一般 hasattr 与 getattr 结合起来使用

if hasattr(a, "name"):

print(getattr(a, "name")) # Jane

# 可以设置一个默认值,目的是防止程序报错,如果没有该属性,就返回默认值

print(getattr(a, "sex", None)) # None

print(a.country) # 中国

print(getattr(a, "country")) # 中国

ret = getattr(a, "func")

# 注意这里 ret() 相当于 func()

print(ret()) # 666

# 给对象添加一个属性

setattr(a, "sex", "男")

print(a.sex) # 男

# 删除对象的某个属性

delattr(a, "name")

print(a.name) # AttributeError: 'A' object has no attribute 'name'

类名的反射操作

class A:

country = "中国"

area = "深圳"

def __init__(self, name, age):

self.name = name

self.age = age

def func(self):

print(666)

# 获取类 A 的静态属性 country

print(getattr(A, "country")) # 中国

# 获取类 A 的静态属性 area

print(getattr(A, "area")) # 深圳

# 获取类 A 的动态方法并执行

getattr(A, "func")(23) # 666

getattr __getattr__ __getattribute__ _get_ 区别

-

getattr()

- python内置的一个函数,它可以用来获取对象的属性和方法

-

_getattr_()、__getattribute()__

-

类对象的魔法方法,在访问对象属性的时候会被调用

class A(object): def __init__(self, x): self.x = x def hello(self): return 'hello func' def __getattr__(self, item): print('in __getattr__') return 100 def __getattribute__(self, item): print('in __getattribute__') return super(A, self).__getattribute__(item) a = A(10) print(a.x) print(a.y) # 输出 in __getattribute__ 10 in __getattribute__ in __getattr__ 100可以看出,在获到对象属性时,

__getattribute__()是一定会被调用的,无论属性存不存在,首先都会调用这个魔法方法如果调用像

a.y这种不存在的对象时,调用**_getattribute_()**找不到y这个属性,就会再调用__getattr__()这个魔法方法可以通过这个方法设置属性不存在时的默认值

使用上面的getattr()方法获取属性时,也是同样的调用关系,只不过只有在

getattr()带第三个参数作为默认值时,才会调用__getattr__()方法

-

-

__get__()

-

描述符方法之一,经常配套使用的是

__set__()方法通过描述符,可以将访问对象属性转变为调用描述符方法。这在ORM中被经常使用, 可以通过描述符方法进行参数格式验证

import random class Die(object): def __init__(self, sides=6): self.sides = sides def __get__(self, instance, owner): print('Die __get__()') return int(random.random() * self.sides) + 1 def __set__(self, instance, value): print('Die __set__()') class Game(object): d6 = Die() d10 = Die(sides=10) d20 = Die(sides=20) game = Game() print(game.d6) game.d6 = 10 print(game.d6) # 输出 Die __get__() 5 Die __set__() 10使用描述符可以让我们在获取或者给对象赋值时对数据值进行一些特殊的加工和处理

python里经常使用的

@property装饰器其实就是通过描述符的方式实现的

-

is 和 ==

-

官方文档中说 is 表示的是对象标示符(object identity),而 == 表示的是相等(equality)

is 的作用是用来检查对象的标示符是否一致,也就是比较两个对象在内存中的地址是否一样,而 == 是用来检查两个对象是否相等

检查 a is b 的时候,其实相当于检查 id(a) == id(b),而检查 a == b 的时候,实际是调用了对象 a 的 eq() 方法,a == b 相当于 a.eq(b)

一般情况下,如果 a is b 返回True的话,即 a 和 b 指向同一块内存地址的话,a == b 也返回True,即 a 和 b 的值也相等

a = "hello" b = "hello" print(id(a)) # 输出 140506224367496 print(id(b)) # 输出 140506224367496 print(a is b) # 输出 True print(a == b) # 输出 True a = "hello world" b = "hello world" print(id(a)) # 输出 140506208811952 print(id(b)) # 输出 140506208812208 print(a is b) # 输出 False print(a == b) # 输出 True a = [1, 2, 3] b = [1, 2, 3] print(id(a)) # 输出 140506224299464 print(id(b)) # 输出 140506224309576 print(a is b) # 输出 False print(a == b) # 输出 True a = [1, 2, 3] b = a print(id(a)) # 输出 140506224305672 print(id(b)) # 输出 140506224305672 print(a is b) # 输出 True print(a == b) # 输出 True # 结论 只要 a 和 b 的值相等,a == b 就会返回True,而只有 id(a) 和 id(b) 相等时,a is b 才返回 True

进程、线程、协程

进程

-

一个程序的执行实例就是一个进程

每一个进程提供执行程序所需的所有资源(进程本质上是资源的集合,资源分配的最小单位)

每一个进程都有它自己的内存空间和系统资源;在OS的眼里,进程就是一个担当分配系统资源CPU时间、内存的实体

线程

-

线程是操作系统能够进行运算调度的最小单位。它被包含在进程之中,是进程中的实际运作单位(CPU调度的最小单位)

-

多线程和多进程最大的不同在于,多进程中,同一个变量,各自有一份拷贝存在于每个进程中,互不影响,而多线程中,所有变量都由所有线程共享,所以,

任何一个变量都可以被任何一个线程修改,因此,线程之间共享数据最大的危险在于多个线程同时改一个变量

from concurrent.futures import ThreadPoolExecutor import threading def action(max): my_sum = 0 for i in range(max): print(threading.current_thread().name + ' ' + str(i)) my_sum += i return my_sum with ThreadPoolExecutor(max_workers=4) as pool: # submit results = [pool.submit(action, i) for i in [300000, 100, 50]] # map # results = pool.map(action, [3000, 100, 50]) for r in results: print(r.result()) # map # print(list(results))

进程与线程区别

- 同一个进程中的线程共享同一内存空间, 但是进程之间是独立的

- 同一进程中的所有线程的数据是共享的(进程通讯),进程之间的数据是独立的

- 对主线程的修改可能会影响其他线程的行为,但是父进程的修改(除了删除以外)不会影响其他子进程

- 同一进程的线程之间可以直接通信,但是进程之间的交流需要借助中间代理来实现

- 线程是一个上下文的执行指令,而进程则是与运算相关的一簇资源

- 创建新的线程很容易,但是创建新的进程需要对父进程做一次复制

- 一个线程可以操作同一进程的其他线程,但是进程只能操作其子进程

- 线程启动速度快,进程启动速度慢

协程

简介

-

协程是一种用户级的轻量级线程。协程拥有自己的寄存器上下文和栈。协程调度切换时,将寄存器上下文和栈保存到其他地方,在切回来的时候,恢复先前保

存的寄存器上下文和栈

-

协程能保留上一次调用时的状态(即所有局部状态的一个特定组合),每次过程重入时,就相当于进入上一次调用的状态,换种说法:进入上一次离开时所处

逻辑流的位置

-

在并发编程中,协程与线程类似,每个协程表示一个执行单元,有自己的本地数据,与其它协程共享全局数据和其它资源

-

协程是用户自己来编写调度逻辑的,对CPU来说,协程其实是单线程,所以CPU不用去考虑怎么调度、切换上下文,这就省去了CPU的切换开销,所以协程在

一定程度上又好于多线程

-

Python对协程的支持是通过generator实现的。generator也叫生成器,生成器又是基于迭代器实现的

迭代器

-

能被next()方法调用,并不断返回下一个值的对象,叫做迭代器

-

迭代器是一个带状态的对象,调用next()方法的时候返回容器中的下一个值,任何实现了iter和next()方法的对象都是迭代器,iter返回迭代器自身,next

返回容器中的下一个值,如果容器中没有更多元素了,则抛出StopIteration异常。

-

特征:并不依赖索引,而通过next指针迭代所有数据,一次只取一个值,非常节省空间

-

Python中当容器对象提供了对迭代的支持时,可以通过

container.__iter__()来返回一个迭代器对象。迭代器需要支持以下两个方法,这两个方法共同构成了迭代器协议:

-

iterator._iter_()

该方法返回迭代器本身,这个方法是配合for和in使用所必须的 -

iterator._next_()

该方法返回下一项,如果已没有可返回的内容则引发StopIteration异常

-

生成器

-

生成器本质是迭代器, 允许自定义逻辑的迭代器

-

不需要再像上面的类一样写iter()和next()方法了,只需要一个yiled关键字

生成器一定是迭代器,因此任何生成器也是以一种懒加载的模式生成值

gevent

-

Python通过yield提供了对协程的基本支持,但是不完全。而第三方的gevent为Python提供了比较完善的协程支持

-

gevent它是一个并发网络库。它的协程是基于greenlet的,并基于libev实现快速事件循环

-

基本思想:

当一个greenlet(协程/微线程)遇到IO操作时,比如访问网络,就自动切换到其他的greenlet(协程/微线程),等到IO操作完成,再在适当的时候切换回来继续执行。由于IO操作非常耗时,经常使程序处于等待状态,有了gevent为我们自动切换协程,就保证总有greenlet在运行,而不是等待IO

-

由于切换是在IO操作时自动完成,所以gevent需要修改Python自带的一些标准库,这一过程在启动时通过monkey patch完成

Monkey patch

-

猴子补丁(monkey patch)的主要功能就是动态的属性的替换

-

monkey patch 允许程序在运行期间动态修改一个类或模块

-

一个比较实用的例子,很多代码用到 import json,后来发现ujson性能更高,如果觉得把每个文件的import json 改成 import ujson as json成本较高,或者

说想测试一下用ujson替换json是否符合预期,只需要在入口加上

import json import ujson def monkey_patch_json(): json.__name__ = 'ujson' json.dumps = ujson.dumps json.loads = ujson.loads monkey_patch_json()

windows 和 linux fork

- Unix系统中,我们通常用fork来创建一个进程,相应的,在Windows操作系统里,我们用的是CreateProcess

fork 过程

-

当fork()系统调用发生时,子进程会拷贝其父进程的所有页面,并将其加载入操作系统为它分配的一片独立内存中。这些拷贝的动作很消耗时间,而且在某些

情况下并不需要这么做。如果子进程马上执行了"exec"系统调用(用来执行任何可执行文件)或者Fork()之后就退出进程,拷贝父进程的页面就很不划算,因

为exec后包括代码段,数据段和堆栈等都已经被新的内容取代,只留下进程ID等一些表面上的信息仍保持原样,而如果fork完之后我们马上就调用exec,这些

辛辛苦苦拷贝来的东西又会被立刻抹掉。

-

这种情况下,一种叫 copy-on-write (写时复制)(COW)的技术被采用了,当fork发生时,父进程的页面并没有被拷贝到子进程中,相反,这些页面被父进程

和子进程所共享。无论父子进程中谁要去修改页面,系统就为该进程拷贝一个独立的特定页面,然后再对其进行修改。该进程以后就只使用这个新拷贝的页面

而不再是共享的那个,而别的进程则继续使用共享的页面。这项技术就叫写时复制,因为当有进程要写页面的时候,就需要先拷贝页面。

-

采用了COW技术,Fork时,子进程只需要拷贝父进程的页面表就可以了。产生这种设计是因为有时兼容POSIX的操作系统在Fork之后,并不需要执行Exec,比

如apache Web Server就因此而受益,有点接近Windows的CreateThread。

-

COW技术使得创建子进程的代价小了许多,但是现实情况下,很多时候Fork会紧跟着一个EXEC,因为Exec必须装载所有的映像,unix还是得花很大的代价来

创建一个进程。比较公平的比较是 fork 近似于 NtCreateThread 而 CreateProcess 近似于 fork + execve。

windows

-

相对于Unix,Windows的设计更有弹性,它是一个多层次的而且更加组件化的操作系统,Windows拥有许多子系统,我们通常说的Windows,只是它的子系

统之一,称为WoW(Windows On Windows),其他子系统还包括Wow64,Posix和OS2。 Windows NT内核也支持COW fork,但是只为SFU(Microsoft’s UNIX

environment for Windows)所使用,SFU进程和Win32进程是不同的东西。

-

Win32的进程创建,需要通知CSRSS进程被创建,CSRSS又调用了LPC,而它要求至少kernel32(NTDll.dll)等动态库要被加载,然后它又要处理许多预保留的工

作项目,之后该进程才能被认为是一个Win32进程,之后还有许多枝节要去处理比如解析manifests,程序兼容性检查,程序的限制策略等等等等,这些附加在原

始进程创建过程之后枝节,无疑拖累了进程创建速度。

-

不带任何子系统的原生进程的创建速度是很快的,而创建SFU进程要比Win32进程简单得多,也快得多,尽管Win32花了许多力气在加载这些枝节之上,但是

一方面,它提高了对客户的友好,另一方面,运行库的预加载使得图形界面的处理速度更快,或者Win32进程天生就是为图形处理做准备的。

区别

-

在windows系统中不可以用fork来创建进程,linux可以

-

linux

-

当你调用

fork()最初只有你的虚拟机被复制,所有的页面被标记为copy-on write (写时复制)。新子进程将拥有父进程虚拟机的逻辑副本,但在您真正开始写入之前,它不会消耗任何额外的RAM。

至于线程,

fork在子进程中只创建一个类似于调用线程副本的新线程。另外,只要你调用任何一个

exec系列的调用,那么你的整个过程映像被替换为一个新的,只有文件描述符被保留。这些副本是“写时复制”的,所以如果你的子进程没有修改数据,除了父进程的内存之外,它不会使用任何内存。

通常,在

fork(),子进程使得exec()用另一个进程替换这个进程的程序,然后所有的内存都被丢弃。 -

fork基本上把你的进程分成两部分,在fork函数调用之后,父进程和子进程都继续执行指令。但是,子进程中的返回值是0,而父进程中的返回值是子进程的进程ID。

-

子进程的创建非常快,因为它使用与父进程相同的页面。

这些页面被标记为写时拷贝(COW),这样如果任一进程改变了页面,那么另一个就不会受到影响。

一旦子进程存在,它通常会调用一个

exec函数来替换映像。 -

fork()不是一个确切的进程副本。 它创建一个子进程,但是子进程在与父进程相同的指令处开始执行,并从那里继续。

-

-

windows

- Windows没有

fork的平等,而CreateProcess调用只允许你启动一个新的进程。 - 新的进程会从头开始执行复制的程序。

- Windows没有

GIL锁

设计初衷

-

解决线程间数据一致性和状态同步的困难

-

改进

-

为了让各个线程能够平均利用CPU时间,python会计算当前已执行的微代码数量,达到一定阈值后就强制释放GIL

而这时也会触发一次操作系统的线程调度,是否真正进行上下文切换由操作系统自主决定

-

产生背景

-

GIL产生在垃圾回收机制的背景下

Python 使用引用计数来进行内存管理(垃圾回收)

Python 里创建的所有对象,都有一个变量(reference count)记录着当前有多少个引用指向了这个对象,当引用数变成 0 的时候

Python 就会回收这个对象所占用的内存

Python 的引用计数需要避免资源竞争的问题,需要在有两个或多个线程同时增加或减少引用计数的情况下,依然保证引用计数的结果是正确的

当有多个线程同时改一个对象的引用计数的时候,有可能导致内存泄漏(对象的引用计数永远没有归零的机会)

还有可能导致对象提前释放,程序崩溃(一个对象存在引用的情况下引用计数变成了 0,导致此对象提前释放)

通过对不同线程访问、修改引用计数增加锁,我们就可以保证引用计数总是被正确的修改(可以联想一下数据库的锁机制)

但是,如果我们对每一个对象或者每一组对象都增加锁,这就意味在在你的 Python 程序中有很多个锁同时存在

多个锁同时存在会有其他的风险–死锁(死锁只会在有多个锁存在的情况下发生,参考数据的死锁)

除此之外,性能下降也是多个锁存在的一大弊端。因为申请锁和释放锁都是一笔不小的开销

GIL 是一把锁(这里强调单个),这把锁加载了 Python 的解释器上,它要求任何 Python 代码在执行的时候需要先申请这把锁,否则就别想执行

只有一把锁,带来的好处就是

- 不会有死锁

- 对因为引入锁而导致的性能下降影响不大

然而坏处就是 GIL 这把锁让计算密集型的代码也只能使用单线程执行

垃圾回收机制

- python 采用的是引用计数机制为主,标记-清除和**分代收集(隔代回收)**两种机制为辅的策略

引用计数

-

引用计数的原理:

每个对象维护一个对象引用 ob_ref 字段,用来记录该对象当前被引用的次数,每当新的引用指向该对象时,它的引用计数ob_ref加1,每当该对象的引用失效

时计数ob_ref减1,一旦对象的引用计数为0,该对象立即被回收,对象占用的内存空间将被释放。它的缺点是需要额外的空间维护引用计数,这个问题是其次

的,不过最主要的问题是它不能解决对象的“循环引用”。

-

引用计数的优点:

-

1、简单

-

2、实时性:一旦没有引用,内存就直接释放了,不用像其他机制得等到特定时机。实时性还带来一个好处:处理回收内存的时间分摊到了平时。

-

-

引用计数的缺点:

-

1、维护引用计数消耗资源

-

2、循环引用

-

标记清除

- 标记清除算法是一种基于追踪回收(tracing GC)技术实现的垃圾回收算法。

- 它分为两个阶段:

- 第一阶段是标记阶段,GC会把所有的活动对象打上标记

- 第二阶段是把那些没有标记的非活动对象进行回收

分代回收

-

分代回收是一种以空间换时间的操作方式,Python将内存根据对象的存活时间划分为不同的集合,每个集合称为一个代,Python将内存分为了3“代”,分别为

年轻代(第0代)、中年代(第1代)、老年代(第2代),他们对应的是3个链表,它们的垃圾收集频率随着对象存活时间的增大而减小。

-

新创建的对象都会分配在年轻代,年轻代链表的总数达到上限时,Python垃圾收集机制就会被触发,把那些可以被回收的对象回收掉,而那些不会回收的对象

就会被移到中年代去,依此类推,老年代中的对象是存活时间最久的对象,甚至是存活于整个系统的生命周期内。

-

同时,分代回收是建立在标记清除技术基础之上。分代回收同样作为Python的辅助垃圾收集技术处理那些容器对象

简介

-

GIL并不是Python的特性,它是在实现Python解析器(CPython)时所引入的一个概念

-

GIL的问题其实是由于近十几年来应用程序和操作系统逐步从多任务单核心演进到多任务多核心导致的 , 在单核CPU上调度多个线程任务,大家相互共享一个全

局锁,谁在CPU执行,谁就占有这把锁,直到这个线程因为IO操作或者Timer Tick到期让出CPU,没有在执行的线程就安静的等待着这把锁(除了等待之外,

他们应该也无事可做)

-

防止多线程并发执行机器码的互斥锁(mutex)

GIL锁的释放

- 一个线程有两种情况下会释放全局解释器锁

- 一种情况是在该线程进入IO操作之前,会主动释放GIL

- 另一种情况是解释器不间断运行了1000字节码(Py2)或运行15毫秒(Py3)后,该线程也会放弃GIL

如何避免GIL的影响

-

在以IO操作为主的IO密集型应用中,多线程和多进程的性能区别并不大,原因在于即使在Python中有GIL锁的存在,由于线程中的IO操作会使得线程立即释放

GIL,切换到其他非IO线程继续操作,提高程序执行效率。相比进程操作,线程操作更加轻量级,线程之间的通讯复杂度更低,建议使用多线程

-

如果是计算密集型的应用,尽量使用多进程或者协程来代替多线程

守护进程

简介

-

守护进程是脱离于终端并且在后台运行的进程,脱离终端是为了避免在执行的过程中的信息在终端显示,并且进程也不会被任何终端所产生的信息所打断

-

守护进程一般的生命周期是系统启动到系统停止运行

-

在Linux服务器实际应用中,经常会有需要长时间执行的任务。若在前台运行,用户无法进行其他操作或者断开与服务器的连接,否则任务将被中止

此时适合使用守护进程

特性

-

后台运行

-

与其运行前的环境隔离开来

这些环境包括未关闭的文件描述符、控制终端、会话和进程组、工作目录以及文件创建掩码等

这些环境通常是守护进程从执行它的父进程(特别是shell)中继承下来的

-

启动方式特殊,它可以在系统启动时从启动脚本 /etc/rc.d 中启动,可以由 inetd 守护进程启动,可以由 crond 启动,还可以由用户终端(通常是 shell)执行

编程规则

- 在后台运行,调用 fork ,然后使父进程 exit

- 脱离控制终端,登录会话和进程组,调用 setsid() 使进程成为会话组长

- 禁止进程重新打开控制终端

- 关闭打开的文件描述符,调用 fclose()

- 将当前工作目录更改为根目录

- 重设文件创建掩码为 0

- 处理 SIGCHLD 信号

python实现

# coding=utf8

import os

import sys

import atexit

def daemonize(pid_file=None):

"""

创建守护进程

:param pid_file: 保存进程id的文件

:return:

"""

# 从父进程fork一个子进程出来

pid = os.fork()

# 子进程的pid一定为0,父进程大于0

if pid:

# 退出父进程

sys.exit(0)

# 子进程默认继承父进程的工作目录,最好是变更到根目录,否则回影响文件系统的卸载

os.chdir('/')

# 子进程默认继承父进程的umask(文件权限掩码),重设为0(完全控制),以免影响程序读写文件

os.umask(0)

# 让子进程成为新的会话组长和进程组长

os.setsid()

# 注意了,这里是第2次fork,也就是子进程的子进程,我们把它叫为孙子进程

_pid = os.fork()

if _pid:

# 退出子进程

sys.exit(0)

# 此时,孙子进程已经是守护进程了,接下来重定向标准输入、输出、错误的描述符(是重定向而不是关闭, 这样可以避免程序在 print 的时候出错)

# 刷新缓冲区先,小心使得万年船

sys.stdout.flush()

sys.stderr.flush()

# dup2函数原子化地关闭和复制文件描述符,重定向到/dev/nul,即丢弃所有输入输出

with open('/dev/null') as read_null, open('/dev/null', 'w') as write_null:

os.dup2(read_null.fileno(), sys.stdin.fileno())

os.dup2(write_null.fileno(), sys.stdout.fileno())

os.dup2(write_null.fileno(), sys.stderr.fileno())

# 写入pid文件

if pid_file:

with open(pid_file, 'w+') as f:

f.write(str(os.getpid()))

# 注册退出函数,进程异常退出时移除pid文件

atexit.register(os.remove, pid_file)

开源项目

简介

-

Github 开源项目: python-daemon 提供了 Python 版本的守护进程化实现。提供以下方法:

-

start() - starts the daemon (creates PID and daemonizes)

-

stop() - stops the daemon (stops the child process and removes the PID)

-

restart() - does stop() then start()

-

使用示例

from daemon import Daemon

class pantalaimon(Daemon):

def run(self):

# Do stuff

pass

# 指定 pid 文件的路径

pineMarten = pantalaimon('/path/to/pid.pid')

pineMarten.start()

python用法

守护进程

-

什么是守护进程

-

主进程创建子进程,然后将该进程设置成守护自己的进程,守护进程会在主进程代码执行结束后就终止

-

如果我们有两个任务需要并发执行,那么开一个主进程和一个子进程分别去执行就可以了

-

主进程在其代码结束后就已经运行完毕了,守护进程在此时就被回收,然后主进程会一直等非守护的子进程都运行完毕后回收子进程的资源

才会结束,否则会产生僵尸进程

-

如果子进程的任务在主进程任务结束后就没有存在的必要了,那么该子进程应该在开启前就被设置成守护进程

主进程代码运行结束,守护进程随即终止

-

守护进程内无法再开启子进程,否则抛出异常

-

-

使用守护进程

- 守护进程本身就是一个子进程,所以在主进程需要将任务并发执行的时候需要开启子进程

- 当该子进程执行的任务生命周期伴随着主进程的生命周期时,就需要将该子进程做成守护进程

-

使用示例

from multiprocessing import Process

import os

import time

def task(x):

print('%s is running ' %x)

time.sleep(3)

print('%s is done' %x)

if __name__ == '__main__':

p1=Process(target=task,args=('守护进程',))

p2=Process(target=task,args=('子进程',))

p1.daemon=True # 设置p1为守护进程

p1.start()

p2.start()

print('主')

# 当主进程的代码运行完毕后,守护进程就会立马结束掉,而不会去管其他子进程是否运行完毕

>>:主

>>:子进程 is running

>>:子进程 is done

守护线程

-

什么是守护线程

-

守护线程会在该进程内所有非守护线程全部都运行完毕后,守护线程才会挂掉,并不是主线程运行完毕后守护线程挂掉

-

守护线程守护的是:当前进程内所有的子线程

-

主线程在其他非守护线程运行完毕后才算运行完毕守护线程在此时就被回收

因为主线程的结束意味着进程的结束,进程整体的资源都将被回收,而进程必须保证非守护线程都运行完毕后才能结束

-

-

主线程与进程的关系

-

主线程的生命周期就是一个进程的生命周期

-

主进程等待子进程是因为主进程要负责回收子进程的系统资源,主线程等待子线程是因为主线程要等待子线程运行完毕,子线程运行完毕后,这个进程

才算运行完毕后,主线程才结束

-

-

使用示例

# 当只有一个子线程并且为守护线程,那么这个守护线程就会等待主线程运行完毕后挂掉

from threading import Thread

import os

import time

def task(x):

print('%s is running ' %x)

time.sleep(3)

print('%s is done' %x)

if __name__ == '__main__':

t1=Thread(target=task,args=('守护线程',))

t1.daemon=True # 设置p1为守护进程

t1.start()

print('主')

>>:守护线程 is running

>>:主

# 当有多个子线程时,守护线程就会等待所有的子线程运行完毕后,守护线程才会挂掉(这一点和主线程是一样的,都是等待所有的子线程运行完毕后才会挂掉)

from threading import Thread

import time

def foo():

print(123)

time.sleep(1)

print("end123")

def bar():

print(456)

time.sleep(3)

print("end456")

t1=Thread(target=foo)

t2=Thread(target=bar)

t1.daemon=True

t1.start()

t2.start()

print("main-------")

>>:123

>>:456

>>:main-------

>>:end123

>>:end456

守护进程与后台进程

- 通过&符号,可以把命令放到后台执行。它与守护进程是不同的:

- 守护进程与终端无关,是被init进程收养的孤儿进程;而后台进程的父进程是终端,仍然可以在终端打印

- 守护进程在关闭终端时依然坚挺;而后台进程会随用户退出而停止,除非加上nohup

- 守护进程改变了会话、进程组、工作目录和文件描述符,后台进程直接继承父进程(shell)

os.path 和 sys.path

- os.path 主要是用于用户对系统路径文件的操作

- sys.path 主要用户对 Python 解释器的系统环境参数的操作

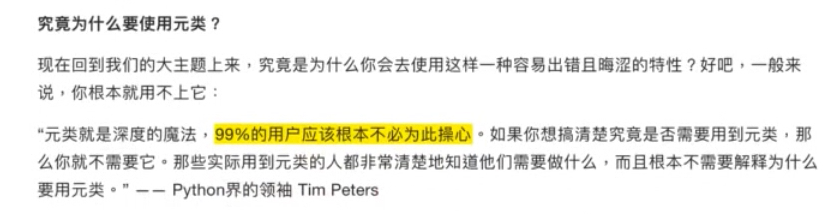

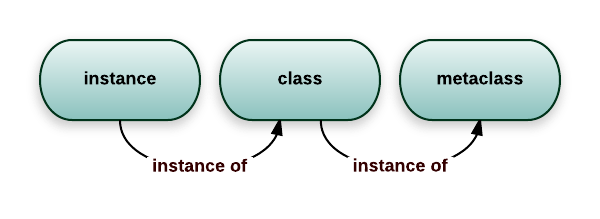

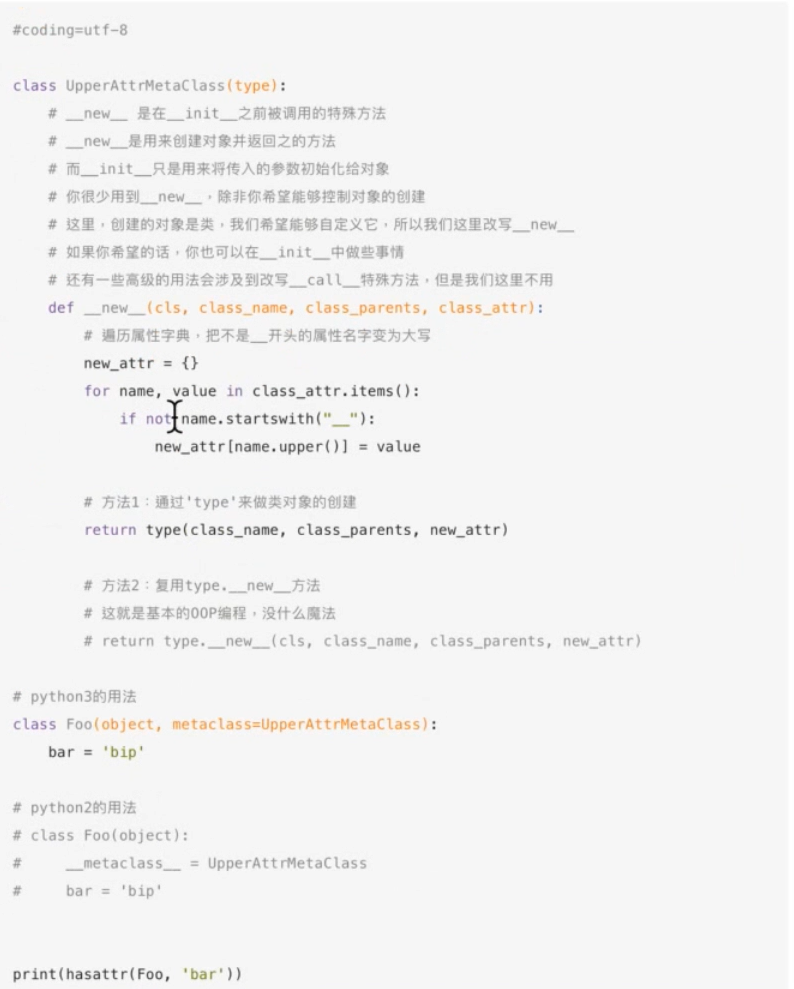

元类 metaclass

简介

-

metaclass(元类),元类可以控制类的创建过程,它主要做三件事:

-

拦截类的创建

-

修改类的定义

-

返回修改后的类

-

-

对象由类产生,类由元类产生

-

元类示例

class HelloMeta2(type): def __init__(cls, name, bases, attrs): super(HelloMeta2, cls).__init__(name, bases, attrs) attrs_ = {} for k, v in attrs.items(): if not k.startswith('__'): attrs_[k] = v setattr(cls, '_new_dict', attrs_) class New_Hello2(metaclass=HelloMeta2): a = 1 b = True In : New_Hello2._new_dict Out: {'a': 1, 'b': True} In : h2 = New_Hello2() In : h2._new_dict Out: {'a': 1, 'b': True}在Python里类使用 _new_ 方法创建实例,_init_ 负责初始化一个实例

对于type也是一样的效果,只不过针对的是类,在上面的HelloMeta中只使用了**_new_** 创建类

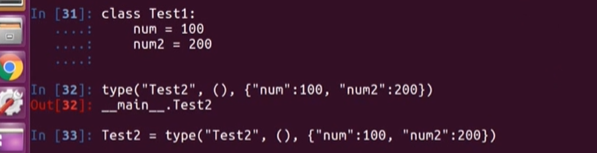

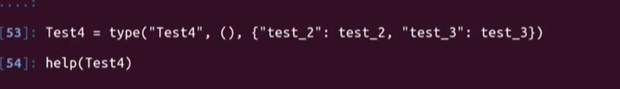

type创建类

示例1

- Test1 等同于 Test2

示例2

示例3

使用场景

-

日常的业务逻辑开发是不太需要使用到元类的,因为元类是用来拦截和修改类的创建的,用到的场景很少

-

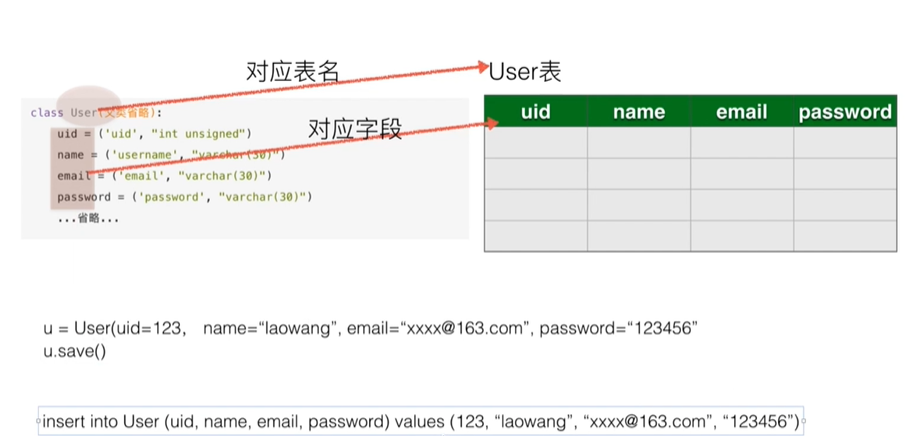

最典型的使用场景就是 ORM

**ORM就是「对象 关系 映射」**的意思,简单的理解就是把关系数据库的一张表映射成一个类,一行记录映射为一个对象

ORM框架中的Model只能动态定义,因为这个模式下这些关系只能是由使用者来定义,元类再配合描述符就可以实现ORM了

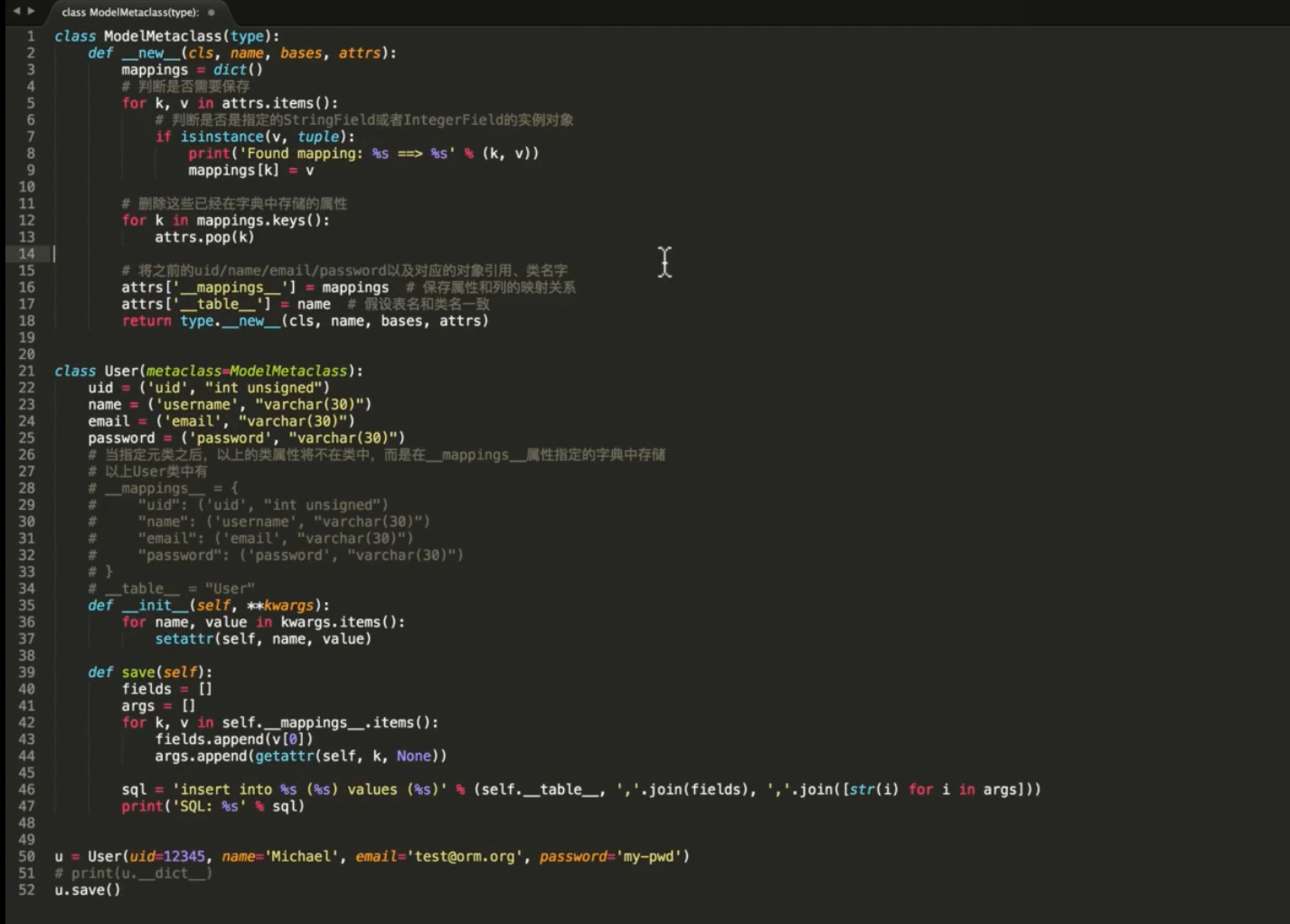

元类实现ORM

简介

- 参考资料:《mini-web框架》-5.元类和orm_哔哩哔哩_bilibili ------在此感谢王铭东老师的视频讲解

示例

- 示例: 类实例化对象调用相应的方法转化为对数据库的操作

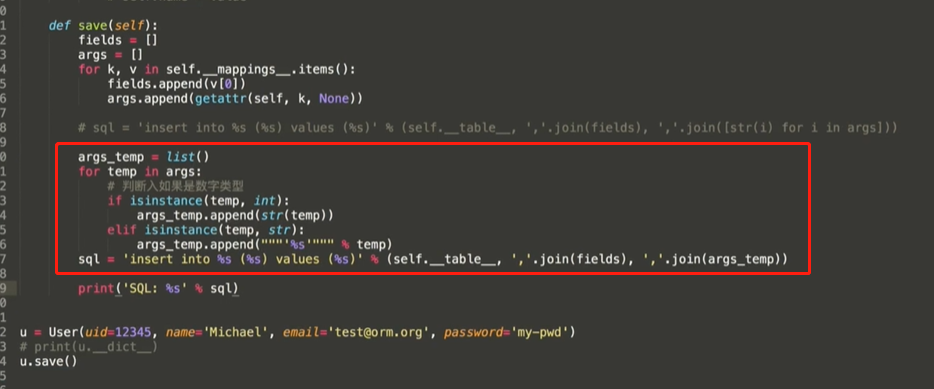

ORM-save 实现

- 通过元类实现 ORM 的 save 方法

- 拼接原生 sql ,value 值字符串添加引号,整型不作处理

序列化

简介

- 序列化: 把不能够直接存储的数据变得可存储,这个过程叫做序列化

- 反序列化: 把文件中的数据拿出来,恢复成原来的数据类型,这个过程叫做反序列化

json 和 pickle 的区别

-

json 序列化之后的数据类型是 str ,所有编程语言都能识别

但仅限于 ( int float bool ) ( str list tuple dict None )

json 不能连续 load , 只能一次性拿出所有数据

-

pickle 序列化之后的数据类型是 bytes

所有数据类型都可以转化,但仅限于 python 之间的存储传输

pickle 可以连续 load , 多套数据放到同一个文件中

-

json 使用的广泛性比 pickle 更强

json 用在不同编程语言的数据交流中

pickle 用于 python 中数据的存储传输

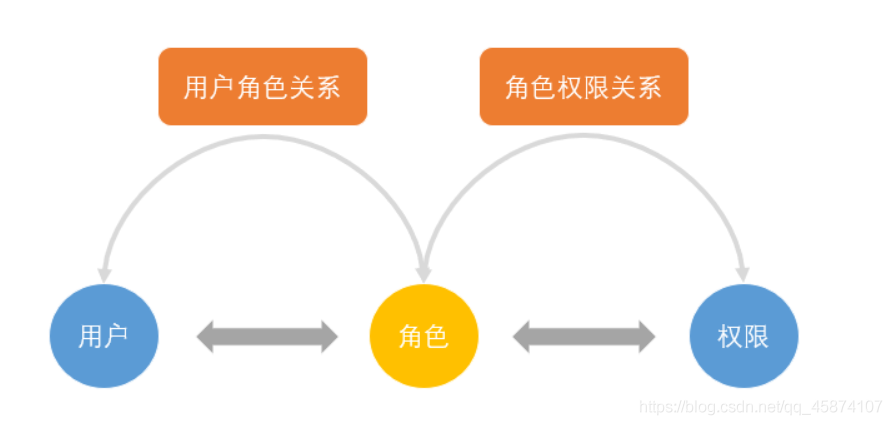

RBAC

RBAC模型

-

Role-Based Access Control

- 基于角色的访问控制

- 面向企业安全策略的一种有效的访问控制方式

-

基本思想

-

对系统操作的各种权限不是直接授予具体的用户,而是在用户集合与权限集合之间建立一个角色集合

每一种角色对应一组相应的权限

一旦用户被分配了适当的角色后,该用户就拥有此角色的所有操作权限

这样不必在每次创建用户时都进行分配权限的操作,只要分配用户相应的角色即可

而且角色的权限变更比用户的权限变更要少得多,这样将简化用户的权限管理,减少系统的开销

-

RBAC的组成

- RBAC模型有3个基础组成部分

- 用户、角色、权限

- RBAC通过定义角色的权限,并对用户授予某个角色从而来控制用户的权限,实现了用户和权限的逻辑分离,极大地方便了权限的管理

- User(用户): 每个用户都有唯一的UID识别,并被授予不同的角色

- Role(角色): 不同角色具有不同的权限

- Permission(权限):访问权限

- 用户-角色映射: 用户和角色之间的映射关系

- 角色-权限映射: 角色和权限之间的映射关系

- 示例

- 管理员和普通用户被授予不同的权限,普通用户只能去修改和查看个人信息,而不能创建创建用户和冻结用户,而管理员由于被授予所有权限

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-mKJdQtn1-1673840082938)(https://gitee.com/lifei_free/pic_storage_gitee/raw/master/picture/rbac_02.jpg)]

RBAC安全原则

-

最小权限原则

- RBAC可以将角色配置成其完成任务所需的最小权限集合

-

责任分离原则

-

可以通过调用相互独立互斥的角色来共同完成敏感的任务

例如要求一个计账员和财务管理员共同参与统一过账操作

-

-

数据抽象原则

-

可以通过权限的抽象来体现

例如财务操作,用借款、存款等抽象权限,而不是使用典型的读、写、执行权限

-

RBAC优缺点

-

优点

-

简化了用户和权限的关系

-

易扩展、易维护

-

-

缺点

- RBAC模型没有提供操作顺序的控制机制,这一缺陷使得RBAC模型很难适应哪些对操作次序有严格要求的系统

Django

多数据库实现

-

settings.py

try: environment = os.getenv('PY_ENV') if environment == 'PRODUCT': DATABASE_ROUTERS = ['mainsys.dbconfig_product.MasterSlaveRouter'] from mainsys.dbconfig_product import * elif environment == 'TEST': DATABASE_ROUTERS = ['mainsys.dbconfig_test.MasterSlaveRouter'] from mainsys.dbconfig_test import * elif not is_linux: DATABASE_ROUTERS = ['mainsys.dbconfig_develop.MasterSlaveRouter'] from mainsys.dbconfig_local import * else: DATABASE_ROUTERS = ['mainsys.dbconfig_develop.MasterSlaveRouter'] from mainsys.dbconfig_develop import * except ImportError as e: if "dbconfig" not in str(e): raise e -

db_dev.py

""" 本文件记录数据库相关配置 """ import platform is_linux = platform.system().lower() == 'linux' elasticsearch_host = '' # MongoDB MONGO_DB = { 'host': '10.32.177.2', 'port': 27017, 'maxPoolSize': 100 } # 数据库配置 DATABASES = { 'default': { 'ENGINE': 'mainsys.mysqlpool', "NAME": "hdjmrh-gaoJingJian-data", "USER": "hdjmrh-gaojingjian", "PASSWORD": "Lingxi@123", "HOST": "10.32.177.1", }, 'base_data': { 'ENGINE': 'mainsys.mysqlpool', "NAME": "hdgjj_base_data", "USER": "select_user", "PASSWORD": "select_user@321", "HOST": "10.32.176.33", }, "jmrh": { "ENGINE": "mainsys.mysqlpool", "NAME": "xm_jmrh", "USER": "select_user", "PASSWORD": "select_user@321", "HOST": "10.32.176.33", }, 'hdjmrh-gaoJingJian-data': { "ENGINE": "mainsys.mysqlpool", "NAME": "hdjmrh-gaoJingJian-data", "USER": "hdjmrh-gaojingjian", "PASSWORD": "Lingxi@123", "HOST": "10.32.177.1", } } class MasterSlaveRouter(object): def db_for_read(self, model, **hints): if model._meta.app_label in ['final', 'court', 'dataplus', 'codes', 'company', 'ministry', 'el_listed']: return 'base_data' elif model._meta.app_label in ['survey', 'analyse_report']: return 'hdjmrh-gaoJingJian-data' elif model._meta.app_label in ['jmrh', ]: return 'jmrh' return 'default' def db_for_write(self, model, **hints): if model._meta.app_label in ['final', 'court', 'dataplus', 'codes', 'company', 'ministry', 'el_listed']: return 'base_data' elif model._meta.app_label in ['survey', 'analyse_report']: return 'hdjmrh-gaoJingJian-data' elif model._meta.app_label in ['jmrh', ]: return 'jmrh' return 'default' def allow_relation(self, obj1, obj2, **hints): return True def allow_migrate(self, db, app_label, model_name=None, **hints): if app_label in ['final', 'court', 'dataplus', 'codes', 'company', 'ministry', 'el_listed']: return 'base_data' elif app_label in ['survey', 'analyse_report']: return 'hdjmrh-gaoJingJian-data' elif app_label in ['jmrh', ]: return 'jmrh' return 'default' # 如需启用配置的多数据库路由规则,则反注释掉下面语句 DATABASE_ROUTERS = ['mainsys.dbconfig_develop.MasterSlaveRouter']

ORM

- 参考python 元类简单实现orm 按住ctrl 跳转

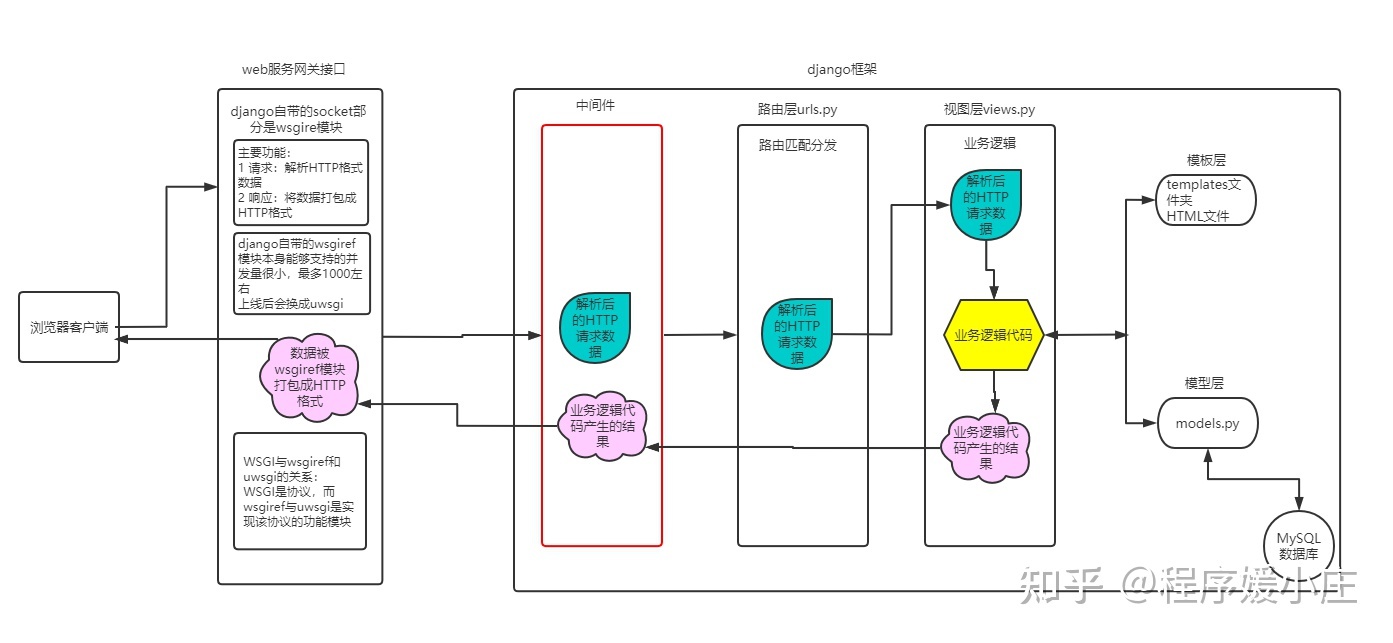

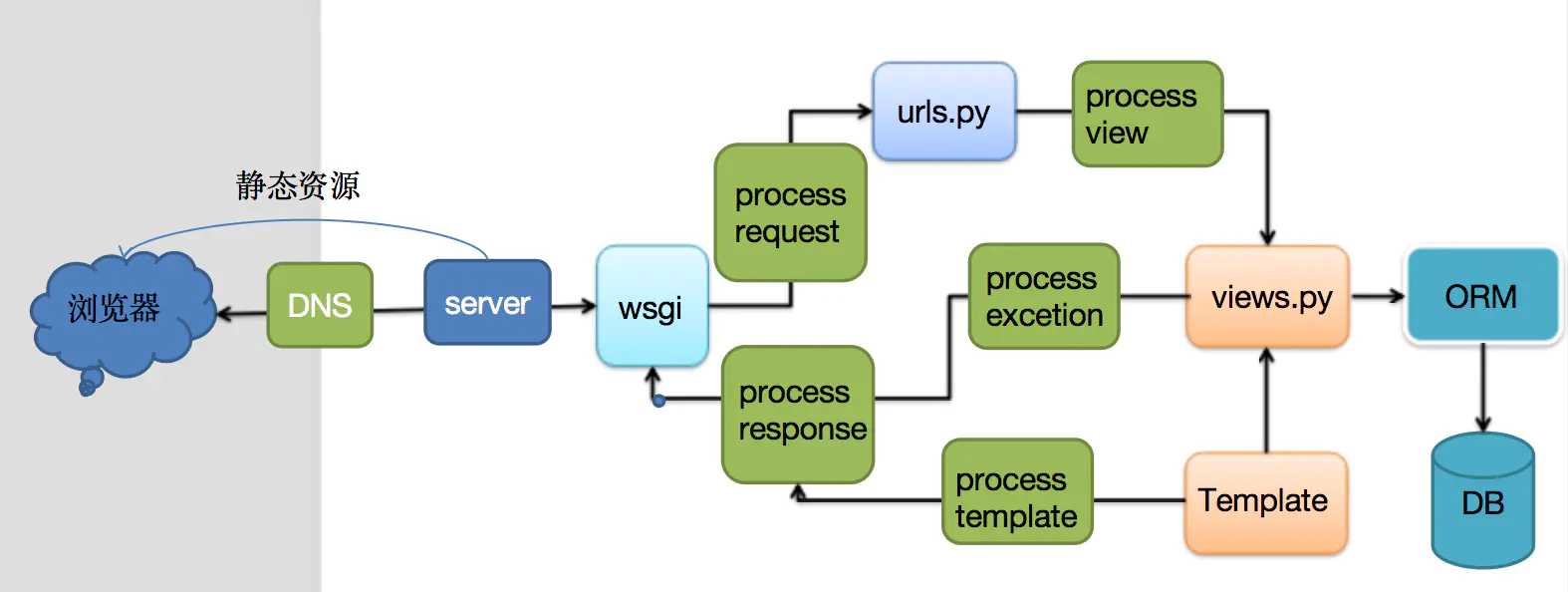

生命周期

版本1

- 客户端浏览器向django服务端发送请求之后,首先回经过web网关接口,将客户端的请求解析成HTTP格式的数据封装到request对象中

- 解析后的数据回来到应用程序部分,首先会经过django的中间件,请求来的时候会经过每个中间件中的process_request方法,到达django后端

- 请求会经过路由层,在进行路由匹配后执行对应的视图函数,在经过视图函数的业务逻辑后会产生response对象

- 响应对象也会通过中间件中的每个process_response方法,回到web服务网关接口,将response对象打包成HTTP格式的数据返回给客户端浏览器

版本2

中间件

概述

- 中间件是一个用来处理Django的请求和响应的框架级别的钩子

- 它是一个轻量、低级别的插件系统,用于在全局范围内改变Django的输入和输出

- 每个中间件组件负责做一些特定的功能

五种方法

process_request

-

执行时间

- 在视图函数之前,在路由匹配之前

-

参数

- request:请求对象,与视图中用到的request参数是同一个对象

-

返回值

- None:按照正常的流程走

- HttpResponse:接着倒序执行当前中间件的以及之前执行过的中间件的process_response方法,不再执行其它的所有方法

-

执行顺序

- 按照MIDDLEWARE中的注册的顺序执行,也就是此列表的索引值

process_response

- 执行时间

- 最后执行

- 参数

- request:请求对象,与视图中用到的request参数是同一个对象

- response:响应对象,与视图中返回的response是同一个对象

- 返回值

- response:必须返回此对象,按照正常的流程走

- 执行顺序

- 按照注册的顺序倒序执行

process_view

- 执行时间

- 在process_request方法及路由匹配之后,视图之前

- 参数

- request:请求对象,与视图中用到的request参数是同一个对象

- view_func:将要执行的视图函数(它是实际的函数对象,而不是函数的名称作为字符串)

- view_args:url路径中将传递给视图的位置参数的元组

- view_kwargs:url路径中将传递给视图的关键值参数的字典

- 返回值

- None:按照正常的流程走

- HttpResponse:它之后的中间件的process_view,及视图不执行,执行所有中间件的process_response方法

- 执行顺序

- 按照注册的顺序执行

process_template_response

- 此方法必须在视图函数返回的对象有一个render()方法(或者表明该对象是一个TemplateResponse对象或等价方法)时,才被执行

- 执行时间

- 视图之后,process_exception之前

- 参数

- request:请求对象,与视图中用到的request参数是同一个对象

- response:是TemplateResponse对象(由视图函数或者中间件产生)

- 返回值

- response:必须返回此对象,按照正常的流程走

- 执行顺序

- 按照注册的顺序倒序执行

process_exception

- 此方法只在视图中触发异常时才被执行

- 执行时间

- 视图之后,process_response之前

- 参数

- request:请求对象,与视图中用到的request参数是同一个对象

- exception:视图函数异常产生的Exception对象

- 返回值

- None:按照正常的流程走

- HttpResponse对象:不再执行后面的process_exception方法

- 执行顺序

- 按照注册的顺序倒序执行

MVC/MTV

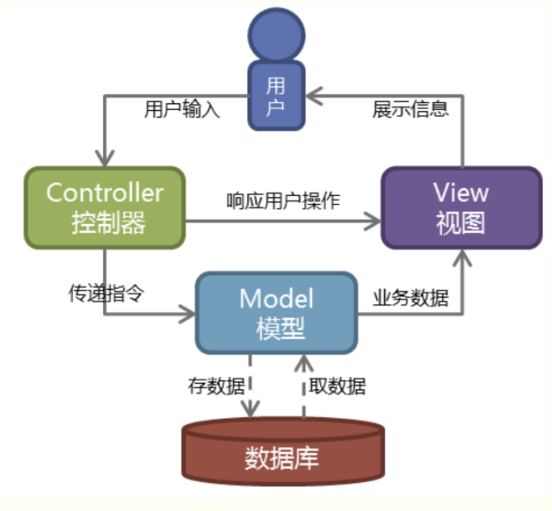

MVC模型

- Web服务器开发领域里著名的MVC模式

- MVC就是把Web应用分为 模型(M),控制器© 视图(V) 三层,他们之间以一种插件式的、松耦合的方式连接在一起

- 模型负责业务对象与数据库的映射(ORM)

- 视图负责与用户的交互(页面)

- 控制器接受用户的输入调用模型和视图完成用户的请求

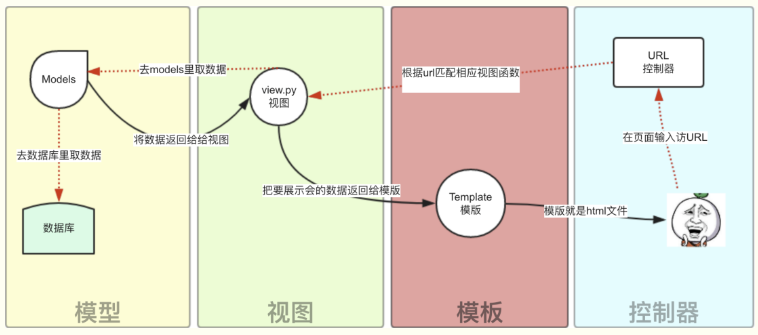

MTV模型

- Django的MTV分别代表:

- Model(模型):负责业务对象与数据库的对象(ORM)

- Template(模版):负责如何把页面展示给用户

- View(视图):负责业务逻辑,并在适当的时候调用Model和Template

- 此外,Django还有一个urls分发器,它的作用是将一个个URL的页面请求分发给不同的view处理,view再调用相应的Model和Template

路由分发

- Django 的 url 路由分发:解析请求的url,匹配找到对应的view函数来处理

# test/urls.py

from django.contrib import admin

from django.urls import path, include

urlpatterns = [

path('app01/',include('app01.urls')),

path('app02/',include('app02.urls')),

path('admin/', admin.site.urls),

]

# app01/urls.py

from django.urls import path

from app01 import views

urlpatterns = [

path('index/',views.index),

]

# app02/urls.py

from django.urls import path

from app02 import views

urlpatterns = [

path('index/',views.index),

]

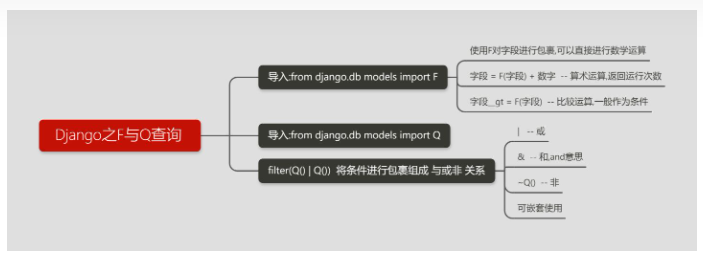

F/Q查询

F 查询

-

使用 F 对字段进行包裹,可以直接进行数学运算

-

from django.db.models import F,Q # 查询评论数大于阅读数的书籍 res = models.Bbook.objects.all().filter(commit_num__gt=F('read_num')) # 查询评论数大于阅读数2倍的书籍 res = models.Bbook.objects.all().filter(commit_num__gt=F('read_num')*2)

Q查询

-

Q查询:制造 与或非 的条件,filter(Q() | Q()) 将条件进行包裹组成 与或非 关系

-

from django.db.models import F,Q # 查询作者名字是猎虎或者价格大于5000的书 -- 或 | res = models.Bbook.objects.filter(Q(authors__name='猎虎')|Q(price__gt=5000)) # 查询作者名字是猎虎并且价格大于5000的书 -- 与 & res = models.Bbook.objects.filter(Q(authors__name='猎虎') & Q(price__gt=5000)) or res = models.Bbook.objects.filter(Q(authors__name='猎虎', price__gt=5000)) # 查询作者名字不是猎虎的书 -- 非 ~ res = models.Bbook.objects.filter(~Q(authors__name='猎虎')) # Q 可以嵌套 res = models.Bbook.objects.filter((Q(authors__name='猎虎') & Q(price__gt=100)) | Q(id__lt=29))

信号量

信号量定义

- Django 提供一个了“信号分发器”机制,允许解耦的应用在框架的其它地方发生操作时会被通知到。

- Django自带一套信号机制来帮助我们在框架的不同位置之间传递信息。

- 也就是说,当某一事件发生时,信号系统可以允许一个或多个发送者(senders)将通知或信号(signals)发送给一组接受者(receivers)。

信号量使用场景

- Django信号的应用场景很多,尤其是用于不同模型或程序间的联动。

- 常见例子包括创建User对象实例时创建一对一关系的UserProfile对象实例,或者每当用户下订单时触发给管理员发邮件的动作。

常用内置信号

- django.db.models.signals.pre_save & post_save在模型调用 save()方法之前或之后发送。

- django.db.models.signals.pre_delete & post_delete在模型调用delete()方法或查询集调用delete() 方法之前或之后发送。

- django.core.signals.request_started & request_finished Django建立或关闭HTTP 请求时发送。

示例:利用信号实现不同模型的联动更新

-

假设我们有一个Profile模型,与User模型是一对一的关系。

我们希望创建User对象实例时也创建Profile对象实例,而使用post_save更新User对象时不创建新的Profile对象。

这时我们就可以自定义create_user_profile和save_user_profile两个监听函数,同时监听sender(User模型)发出的post_save信号。

由于post_save可同时用于模型的创建和更新,我们用if created这个判断来加以区别。

from django.db import models

from django.db.models.signals import post_save

from django.dispatch import receiver

class Profile(models.Model):

user = models.OneToOneField(User, on_delete=models.CASCADE)

birth_date = models.DateField(null=True, blank=True)

@receiver(post_save, sender=User)

def create_user_profile(sender, instance, created, **kwargs):

if created:

Profile.objects.create(user=instance)

@receiver(post_save, sender=User)

def save_user_profile(sender, instance, **kwargs):

instance.profile.save()

DRFTODO

FlaskTODO

cookie session token

跨域认证

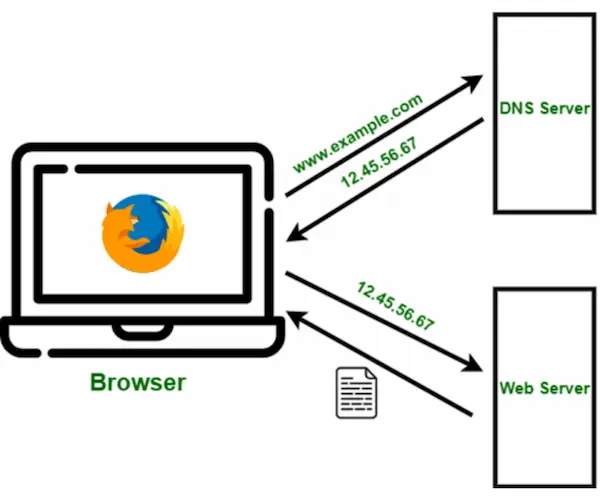

- 互联网服务离不开用户认证。流程如下

1、用户向服务器发送用户名和密码

2、服务器验证通过后,在当前对话(session)里面保存相关数据,比如用户角色、登录时间等等

3、服务器向用户返回一个 session_id,写入用户的 Cookie

4、用户随后的每一次请求,都会通过 Cookie,将 session_id 传回服务器

5、服务器收到 session_id,找到前期保存的数据,由此得知用户的身份

-

这种模式的问题在于,扩展性(scaling)不好

单机当然没有问题,如果是服务器集群,或者是跨域的服务导向架构,就要求 session 数据共享,每台服务器都能够读取 session

-

举例来说

-

A 网站和 B 网站是同一家公司的关联服务。现在要求,用户只要在其中一个网站登录,再访问另一个网站就会自动登录,请问怎么实现?

-

一种解决方案是 session 数据持久化,写入数据库或别的持久层

各种服务收到请求后,都向持久层请求数据

这种方案的优点是架构清晰,缺点是工程量比较大。另外,持久层万一挂了,就会单点失败

-

另一种方案是服务器索性不保存 session 数据了,所有数据都保存在客户端,每次请求都发回服务器。JWT 就是这种方案的一个代表

-

cookie

-

一个 Web 站点可能会为每一个访问者产生一个唯一的ID, 然后以 Cookie 文件的形式保存在每个用户的机器上。

HTTP协议本身是无状态的,服务器无法判断用户身份。Cookie实际上是一小段的文本信息(key-value格式)。

客户端向服务器发起请求,如果服务器需要记录该用户状态,就使用response向客户端浏览器颁发一个Cookie。

客户端浏览器会把Cookie保存起来。当浏览器再请求该网站时,浏览器把请求的网址连同该Cookie一同提交给服务器。

服务器检查该Cookie,以此来辨认用户状态。

-

当用户第一次访问并登陆一个网站的时候,cookie的设置以及发送会经历以下4个步骤:

- 客户端发送一个请求到服务器

- 服务器发送一个HttpResponse响应到客户端,其中包含Set-Cookie的头部

- 客户端保存cookie,之后向服务器发送请求时,HttpRequest请求中会包含一个Cookie的头部

- 服务器返回响应数据

-

Cookie只能被放置它的网站读取。这一点是浏览器保证的,这也是浏览器的一个重要的安全机制。

session

-

在计算机中,尤其是在网络应用中,称为“会话控制”。Session对象存储特定用户会话所需的属性及配置信息,存储到服务器。

服务器为了保存用户状态而创建的一个特殊的对象,在无连接(HTTP)协议基础之上实现在用户状态管理。

-

当浏览器第一次访问服务器时,服务器创建一个session对象(该对象有一个唯一的id,一般称之为sessionId)

服务器会将sessionId 以cookie的方式发送给浏览器。

当浏览器再次访问服务器时,会将sessionId发送过来,服务器依据 sessionId就可以找到对应的session对象。

-

cookie和session都是用来保存用户状态的,cookie在客户端,session在服务器端,所以也会占用服务器资源

session虽然数据是保存在服务器端,但是客户端也会存一个cookie文件存放sessionId

token

-

Token是服务端生成的一串字符串,以作客户端进行请求的一个令牌,当第一次登录后,服务器生成一个Token便将此Token返回给客户端,以后客户端只需

带上这个Token前来请求数据即可,无需再次带上用户名和密码。

-

使用Token的目的:

Token的目的是为了减轻服务器的压力,减少频繁的查询数据库,使服务器更加健壮。

-

token在服务器时可以不用存储用户信息的,token传递的方式也不限于cookie传递,token也可以保存起来。

session的存储是需要空间的,session的传输一般都是通过cookie来传输,或url重写的方式。

-

token的生成方式

浏览器第一次访问服务器时,会传过来一个唯一表示ID,服务端通过算法,加密钥,生成一个token。

通过BASE64编码后将 token 发送给客户端。

客户端将token保存起来,下次请求带着token,服务器收到请求会用相同的算法取验证toekn,如果通过就继续执行。

token组成

- uid (用户唯一的身份标识)

- time (当前时间的时间戳)

- sign (签名,由token的前几位+盐以哈希算法压缩成一定长的十六进制字符串,可以防止恶意第三方拼接token请求服务器)

-

token和session的区别

共同点:都是保存了用户身份信息,都有过期时间。

session翻译为会话,token翻译为令牌。

session是空间换时间,token是时间换空间。

session和sessionid:服务器会保存一份,可能保存到缓存/数据库/文件。

token:服务器不需要记录任何东西,每次都是一个无状态的请求,每次都是通过解密来验证是否合法。

sessionid:一般是随机字符串,要到服务器检索id的有效性。

jwt 原理

简介

-

**JSON Web Token(缩写 JWT)**是目前最流行的跨域认证解决方案

-

实施 Token 验证的方法挺多的,还有一些标准方法,比如 JWT,表示:JSON Web Tokens 。JWT 标准的 Token 有三个部分:

- header(头部),头部信息主要包括(参数的类型–JWT,签名的算法–HS256)

- poyload(负荷),负荷基本就是自己想要存放的信息 (因为信息会暴露,不应该在载荷里面加入任何敏感的数据)

- sign(签名),签名的作用就是为了防止恶意篡改数据

-

中间用点分隔开,并且都会使用 Base64 编码,所以真正的 Token 看起来像这样:

eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJpc3MiOiJuaW5naGFvLm5ldCIsImV4cCI6IjE0Mzg5NTU0NDUiLCJuYW1lIjoid2FuZ2hhbyIsImFkbWluIjp0cnVlfQ.SwyHTEx_RQppr97g4J5lKXtabJecpejuef8AqKYMAJc

Header

-

Header 部分主要是两部分内容,一个是 Token 的类型,另一个是使用的算法,比如下面类型就是 JWT,使用的算法是 HS256。

{ "typ" : "JWT", "alg" : "HS256" } # Base64 编码 eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9

Payload

-

Payload 里面是 Token 的具体内容,这些内容里面有一些是标准字段,你也可以添加其它需要的内容。

iss:Issuer,发行者 sub:Subject,主题 aud:Audience,观众 exp:Expiration time,过期时间 nbf:Not before iat:Issued at,发行时间 jti:JWT ID # iss 发行人,exp 过期时间,自定义的字段 name,admin { "iss" : "csdn.net", "exp" : "201511205211314", "name" : "维C果糖", "admin" : true } # Base64 编码 eyJpc3MiOiJuaW5naGFvLm5ldCIsImV4cCI6IjE0Mzg5NTU0NDUiLCJuYW1lIjoid2FuZ2hhbyIsImFkbWluIjp0cnVlfQ

Signature

-

JWT 的最后一部分是 Signature ,这部分内容有三个部分,先是用 Base64 编码的 header 和 payload ,再用加密算法加密一下,加密的时候要放进去一个 Secret ,这个相当于是一个密码,这个密码秘密地存储在服务端。

header payload secret var encodedString = base64UrlEncode(header) + "." + base64UrlEncode(payload); HMACSHA256(encodedString, 'secret'); # HMACSHA256 SwyHTEx_RQppr97g4J5lKXtabJecpejuef8AqKYMAJc # token eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJpc3MiOiJuaW5naGFvLm5ldCIsImV4cCI6IjE0Mzg5NTU0NDUiLCJuYW1lIjoid2FuZ2hhbyIsImFkbWluIjp0cnVlfQ.SwyHTEx_RQppr97g4J5lKXtabJecpejuef8AqKYMAJc

详细参考资料: JSON Web Token 入门教程 - 阮一峰的网络日志 (ruanyifeng.com)

Web安全

-

Token,我们称之为“令牌”,其最大的特点就是随机性,不可预测。一般黑客或软件无法猜测出来。

-

Token 一般用在两个地方:

- 防止表单重复提交

- Anti CSRF 攻击(跨站点请求伪造)

-

两者在原理上都是通过 session token 来实现的。当客户端请求页面时,服务器会生成一个随机数 Token,并且将 Token 放置到 session 当中,然后将

Token 发给客户端(一般通过构造 hidden 表单)。下次客户端提交请求时,Token 会随着表单一起提交到服务器端。

-

如果应用于“Anti CSRF攻击”,则服务器端会对 Token 值进行验证,判断是否和session中的Token值相等,若相等,则可以证明请求有效,不是伪造的。

不过,如果应用于“防止表单重复提交”,服务器端第一次验证相同过后,会将 session 中的 Token 值更新下,若用户重复提交,第二次的验证判断将失败,

因为用户提交的表单中的 Token 没变,但服务器端 session 中 Token 已经改变了。

-

上面的 session 应用相对安全,但也叫繁琐,同时当多页面多请求时,必须采用多 Token 同时生成的方法,这样占用更多资源,执行效率会降低。

因此,也可用 cookie 存储验证信息的方法来代替 session Token。比如,应对“重复提交”时,当第一次提交后便把已经提交的信息写到 cookie 中,当第二次

提交时,由于 cookie 已经有提交记录,因此第二次提交会失败。

不过,cookie 存储有个致命弱点,如果 cookie 被劫持(XSS 攻击很容易得到用户 cookie),那么又一次 game over,黑客将直接实现 CSRF 攻击。

-

此外,要避免“加 token 但不进行校验”的情况,在 session 中增加了 token,但服务端没有对 token 进行验证,这样根本起不到防范的作用。还需注意的是,

对数据库有改动的增、删、改操作,需要加 token 验证,对于查询操作,一定不要加 token,防止攻击者通过查询操作获取 token 进行 CSRF攻击。但并不是

这样攻击者就无法获得 token,只是增大攻击成本而已。

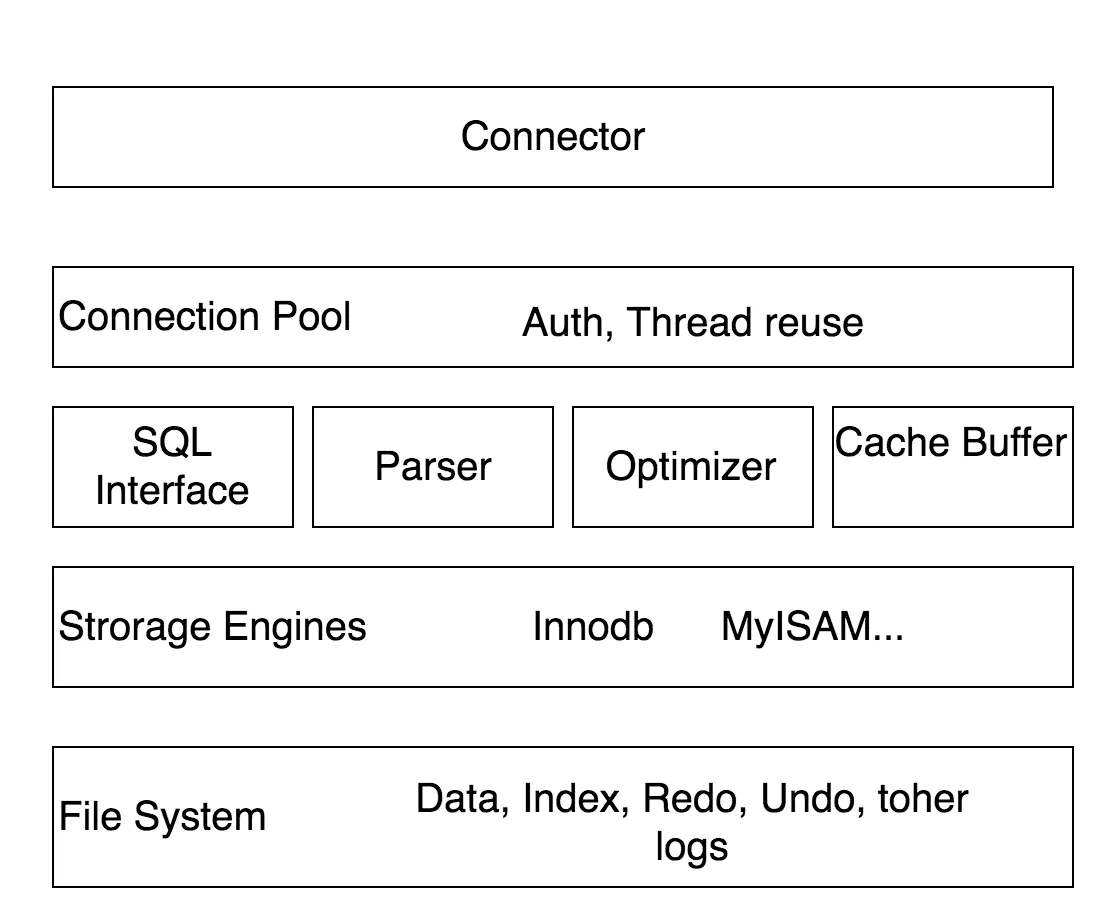

Mysql

查询优化

- 通过慢查询日志发现速度慢的sql,使用 explain 分析慢 sql

-

示例1:

-

like 区分大小写 LIKE BINARY ‘110%’

- 模糊查询是区分大小的,导致查询效率变慢(类似严格匹配)

-

like 不区分大小写 LIKE ‘110%’

- 大小写不敏感查询速度提升很大,sql 执行效率高

-

-

示例2:

- 多个字段条件查询(字段均建立索引),单个条件数据量最少的应放在最前面,提高 sql 查询效率

- 公司某项目中查询接口没考虑字段顺序,导致接口响应30s

- 多个字段条件查询(字段均建立索引),单个条件数据量最少的应放在最前面,提高 sql 查询效率

-

示例3:

- 多个字段条件查询(字段均建立索引),sql 查询未正确使用索引,接口响应时间过长,可以通过强制指定索引优化

-

索引原理

简介

-

什么是索引

- 索引(在MySQL中也叫“键key”)是存储引擎快速找到记录的一种数据结构 ——《高性能MySQL》

-

索引设计的原则

-

适合索引的列是出现在where子句中的列,或者连接子句中指定的列

-

基数较小的类,索引效果较差,没有必要在此列建立索引

-

使用短索引

- 如果对长字符串列进行索引,应该指定一个前缀长度,这样能够节省大量索引空间

-

不要过度索引

- 索引需要额外的磁盘空间,并降低写操作的性能

- 在修改表内容的时候,索引会进行更新甚至重构,索引列越多,这个时间就会越长,所以只保持需要的索引有利于查询即可

-

-

B Tree 和 B+Tree

-

目前大部分数据库系统及文件系统都采用 B Tree 或其变种 B+Tree 作为索引结构

-

文件系统及数据库系统普遍采用 B Tree / B+Tree 的原因

-

一般来说,索引本身也很大,不可能全存内存,往往以索引文件的形式存在磁盘

-

索引查找过程中就要产生磁盘I/O消耗,相对于内存存取,I/O存取的消耗要高几个数量级,所以评价一个数据结构作为索引的优劣最重要的指标就是

在查找过程中磁盘I/O操作次数的渐进复杂度

-

索引的结构组织要尽量减少查找过程中磁盘I/O的存取次数

-

-

在MySQL中,索引属于存储引擎级别的概念,不同存储引擎对索引的实现方式不同,本节主要讨论 MyISAM 和 InnoDB 两个存储引擎的索引实现方式

-

-

最左前缀匹配原则

- 在MySQL建立联合索引时会遵守最左前缀匹配原则,即最左优先,在检索数据时从联合索引的最左边开始匹配

最左前缀匹配原理

简介

-

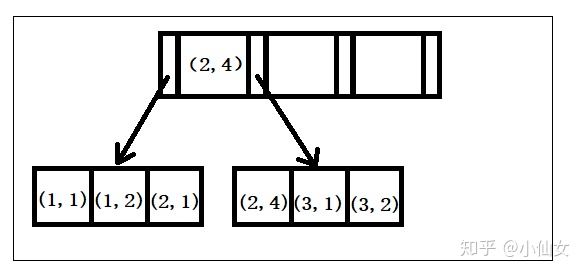

要想理解联合索引的最左匹配原则,先来理解下索引的底层原理

- 索引的底层是一颗B+树,那么联合索引的底层也就是一颗B+树,只不过联合索引的B+树节点中存储的是键值

- 由于构建一棵B+树只能根据一个值来确定索引关系,所以数据库依赖联合索引最左的字段来构建

-

示例

-

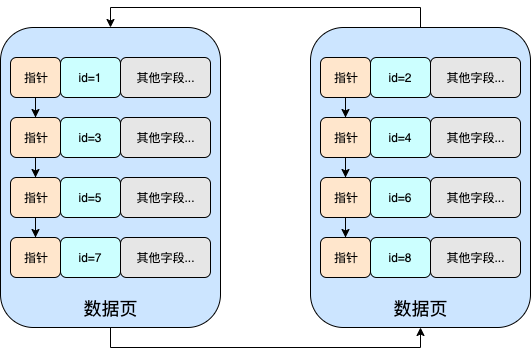

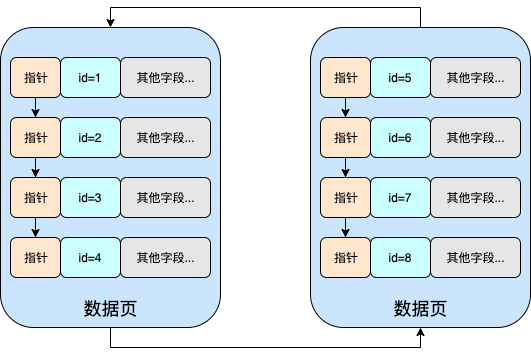

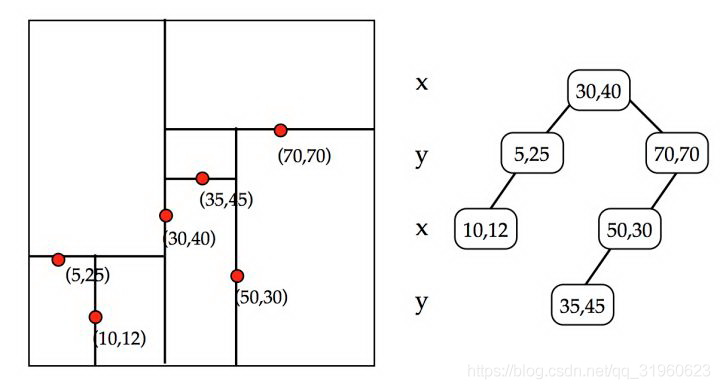

创建一个(a,b)的联合索引,那么它的索引树就是下图的样子

-

可以看到a的值是有顺序的,1,1,2,2,3,3,而b的值是没有顺序的1,2,1,4,1,2

但是我们又可发现a在等值的情况下,b值又是按顺序排列的,但是这种顺序是相对的

这是因为MySQL创建联合索引的规则是首先会对联合索引的最左边第一个字段排序,在第一个字段的排序基础上,然后在对第二个字段进行排序

所以 b=2 这种查询条件没有办法利用索引

-

由于整个过程是基于explain结果分析的,那接下来在了解下 explain 中的 type 字段和 key_lef 字段

-

type

- 联接类型(下面给出各种联接类型,按照从最佳类型到最坏类型进行排序:(重点看ref,rang,index))

- system:

- 表只有一行记录(等于系统表),这是const类型的特例,平时不会出现,可以忽略不计

- const:

- 表示通过索引一次就找到了,const用于比较primary key 或者 unique索引

- 因为只需匹配一行数据,所有很快。如果将主键置于where列表中,mysql就能将该查询转换为一个const

- eq_ref:

- 唯一性索引扫描,对于每个索引键,表中只有一条记录与之匹配。常见于主键 或 唯一索引扫描

- 注意:ALL全表扫描的表记录最少的表如t1表

- ref:

- 非唯一性索引扫描,返回匹配某个单独值的所有行

- 本质是也是一种索引访问,它返回所有匹配某个单独值的行,然而他可能会找到多个符合条件的行,所以它应该属于查找和扫描的混合体

- range:

- 只检索给定范围的行,使用一个索引来选择行。key列显示使用了那个索引

- 一般就是在where语句中出现了bettween、<、>、in等的查询

- 这种索引列上的范围扫描比全索引扫描要好。只需要开始于某个点,结束于另一个点,不用扫描全部索引

- index:

- Full Index Scan,index与ALL区别为index类型只遍历索引树

- 这通常为ALL块,应为索引文件通常比数据文件小(Index与ALL虽然都是读全表,但index是从索引中读取,而ALL是从硬盘读取)

- ALL:

- Full Table Scan,遍历全表以找到匹配的行

- system:

key_len

-

显示MySQL实际决定使用的索引的长度

-

如果索引是NULL,则长度为NULL。如果不是NULL,则为使用的索引的长度。所以通过此字段就可推断出使用了那个索引

-

计算规则:

-

定长字段,int占用4个字节,date占用3个字节,char(n)占用n个字符

-

变长字段varchar(n),则占用n个字符+两个字节

-

不同的字符集,一个字符占用的字节数是不同的

Latin1编码的,一个字符占用一个字节,gdk编码的,一个字符占用两个字节,utf-8编码的,一个字符占用三个字节

-

对于所有的索引字段,如果设置为NULL,则还需要1个字节

-

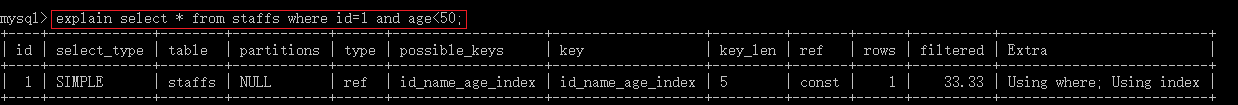

示例

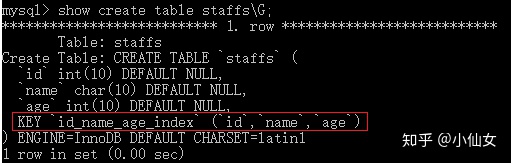

- 创建表

- 表中对id列、name列、age列建立了一个联合索引 id_name_age_index,实际上相当于建立了三个索引(id)(id_name)(id_name_age)

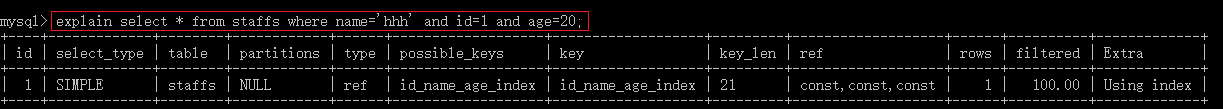

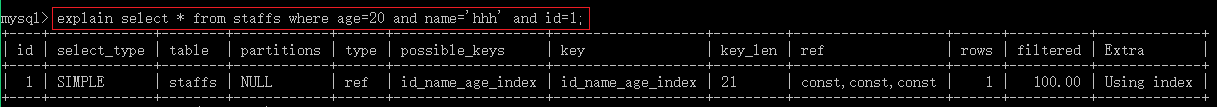

全值匹配查询

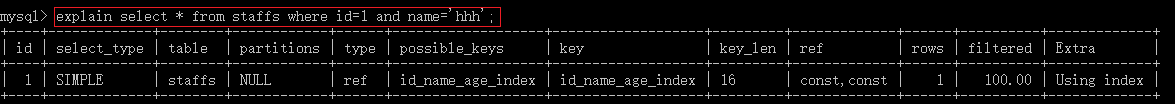

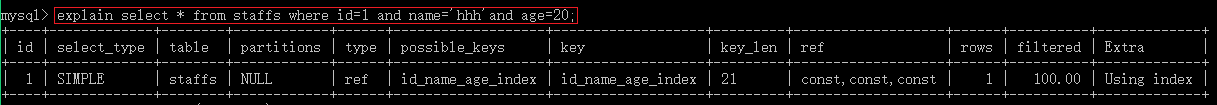

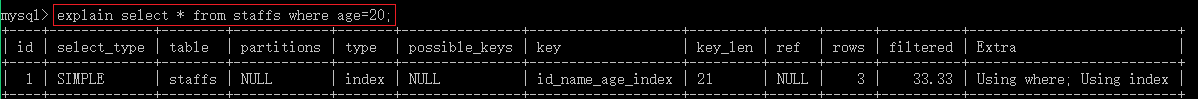

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-vvkX1S9Y-1673840082942)(https://gitee.com/lifei_free/pic_storage_gitee/raw/master/picture/mysql_index_03.jpg)]

-

通过观察上面的结果可知,where后面的查询条件,不论是使用(id,age,name)(name,id,age)还是(age,name,id)顺序

在查询时都使用到了联合索引, 这是因为MySQL中有查询优化器explain,所以sql语句中字段的顺序不需要和联合索引定义的字段顺序相同

查询优化器会判断纠正这条SQL语句以什么样的顺序执行效率高,最后才能生成真正的执行计划,所以不论以何种顺序都可使用到联合索引

另外通过观察上面三个图中的key_len字段,也可说明在搜索时使用的联合索引中的(id_name_age)索引,因为id为int型,允许null,所以占5个字节

name为char(10),允许null,又使用的是latin1编码,所以占11个字节,age为int型允许null,所以也占用5个字节,所以该索引长度为21(5+11+5)

而上面key_len的值也正好为21,可证明使用的(id_name_age)索引

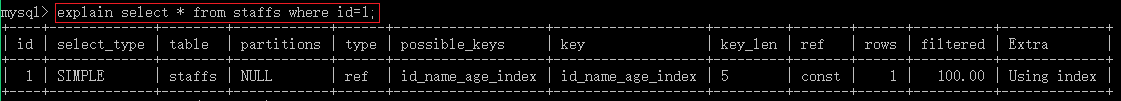

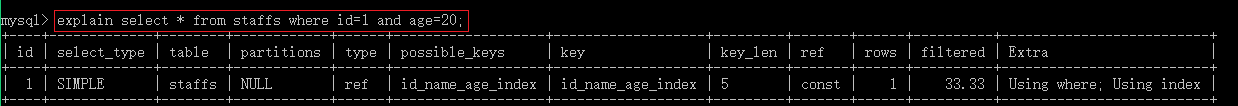

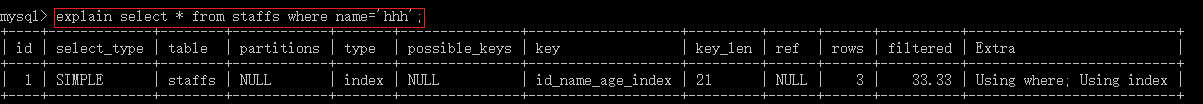

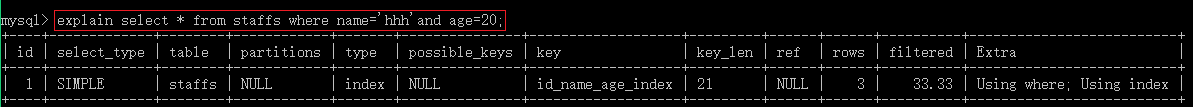

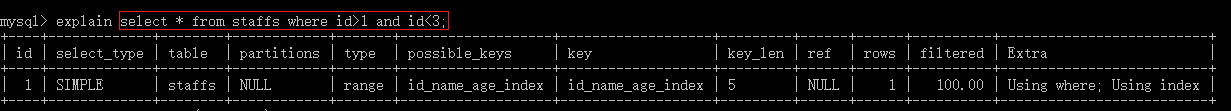

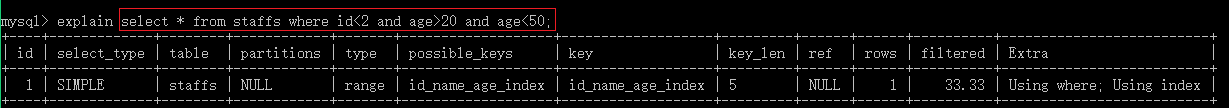

匹配最左列

-

该搜索是遵循最左匹配原则的

通过key字段也可知,在搜索过程中使用到了联合索引,且使用的是联合索引中的(id)索引,因为key_len字段值为5,而id索引的长度正好为5

-

由于id到name是从左边依次往右边匹配,这两个字段中的值都是有序的,所以也遵循最左匹配原则

通过key字段可知,在搜索过程中也使用到了联合索引,但使用的是联合索引中的(id_name)索引