一 分布式计算概述

1.1 什么是(数据)计算

我们一直在提及:分布式计算, 分布式暂且不论, “计算”到底是指什么呢?

大数据体系内的计算, 举例:

- 销售额统计、区域销售占比、季度销售占比

- 利润率走势、客单价走势、成本走势

- 品类分析、消费者分析、店铺分析

等等一系列,基于数据得出的结论。 这些就是我们所说的计算。

分布式计算:顾名思义,即以分布式的形式完成数据的统计,得到需要的结果。

为什么非要分布式计算呢,非分布式不行吗?

数据太大,一台计算机无法独立处理。需要多台服务器协同工作,共同完成一个计算任务。

1.2 分布式计算模式

那如何计算呢?两种模式:

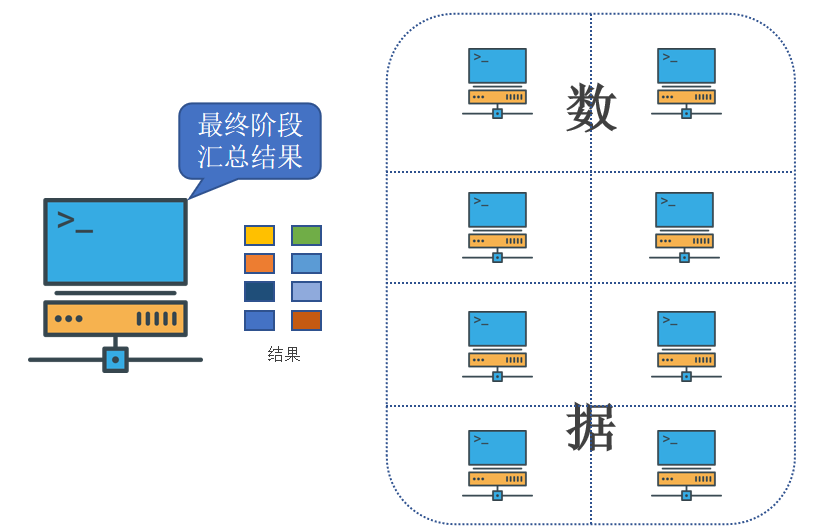

- 分散->汇总模式

- 中心调度->步骤执行模式

分散->汇总模式:(MapReduce就是这种模式)

- 将数据分片,多台服务器各自负责一部分数据处理

- 然后将各自的结果,进行汇总处理

- 最终得到想要的计算结果

生活中的“人口普查”,就是典型的分散汇总的分布式统计模式。

中心调度->步骤执行模式(大数据体系的Spark、Flink等是这种模式)

- 由一个节点作为中心调度管理者

- 将任务划分为几个具体步骤

- 管理者安排每个机器执行任务

- 最终得到结果数据

生活中的各类项目:项目经理 和 项目成员,就是这种模式,一个管理分配任务,其余人员领取任务工作。

二 MapReduce

2.1 MapReduce介绍

MapReduce 即Hadoop内提供的进行分布式计算的组件。

MapReduce是“分散->汇总”模式的分布式计算框架,可供开发人员开发相关程序进行分布式数据计算。MapReduce提供了2个编程接口:

- Map

- Reduce

其中

- Map功能接口提供了“分散”的功能, 由服务器分布式对数据进行处理

- Reduce功能接口提供了“汇总(聚合)”的功能,将分布式的处理结果汇总统计

用户如需使用MapReduce框架完成自定义需求的程序开发,只需要使用Java、Python等编程语言,实现Map Reduce功能接口即可。

现在, 我们借助一个案例,简单分析一下,MapReduce是如何完成分布式计算的。

假设有如下文件,内部记录了许多的单词。且已经开发好了一个MapReduce程序,功能是统计每个单词出现的次数。

2.2 MapReduce执行原理

现在, 我们借助一个案例,简单分析一下,MapReduce是如何完成分布式计算的。

假设有如下文件,内部记录了许多的单词。且已经开发好了一个MapReduce程序,功能是统计每个单词出现的次数。

假定有4台服务器用以执行MapReduce任务,可以3台服务器执行Map,1台服务器执行Reduce

注:MapReduce尽管可以通过Java、Python等语言进行程序开发,但当下年代基本没人会写它的代码了,因为太过时了。 尽管MapReduce很老了,但现在仍旧活跃在一线,主要是Apache Hive框架非常火,而Hive底层就是使用的MapReduce。 所以对于MapReduce的代码开发,博客里会简单扩展一下,但不会深入讲解。

MapReduce的运行机制:

- 将要执行的需求,分解为多个Map Task和Reduce Task

- 将Map Task 和 Reduce Task分配到对应的服务器去执行

三 YARN

YARN 即Hadoop内提供的进行分布式资源调度的组件

3.1 MapReduce与YARN的关系

MapReduce是基于YARN运行的,即没有YARN”无法”运行MapReduce程序,所以,MapReduce和YARN会在同一章节同时学习

3.2 资源调度

什么是资源调度? 我们为什么需要资源调度?

- 资源:服务器硬件资源,如:CPU、内存、硬盘、网络等

- 资源调度:管控服务器硬件资源,提供更好的利用率

- 分布式资源调度:管控整个分布式服务器集群的全部资源,整合进行统一调度

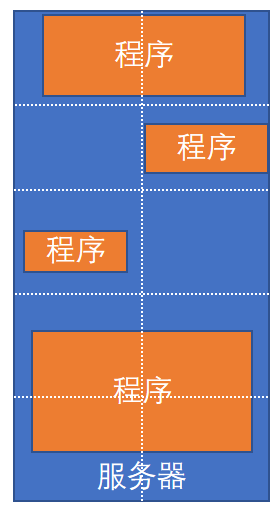

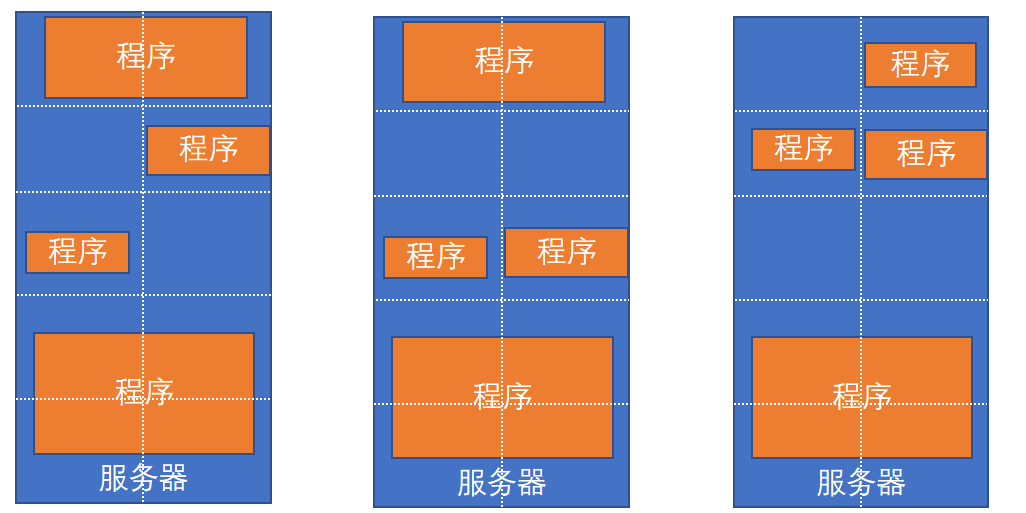

程序的资源调度

服务器会运行多个程序, 每个程序对资源(CPU内存等)的使用都不同

程序没有节省的概念,有多少就会用多少。

所以,为了提高资源利用率,进行调度就非常有必要了。

将服务器上的资源进行划分,对程序实行申请制度,需要多少申请多少

提高资源使用率

对于服务器集群亦可使用这种思路,调度整个集群的资源

这就是 Hadoop YARN框架的作用,调度整个服务器集群的资源统一管理。

3.3 YARN的资源调度

YARN 管控整个集群的资源进行调度, 那么应用程序在运行时,就是在YARN的监管(管理)下去运行的。

这就像:全部资源都是公司(YARN)的,由公司分配给个人(具体的程序)去使用。

比如,一个具体的MapReduce程序。 我们知道, MapReduce程序会将任务分解为若干个Map任务和Reduce任务。

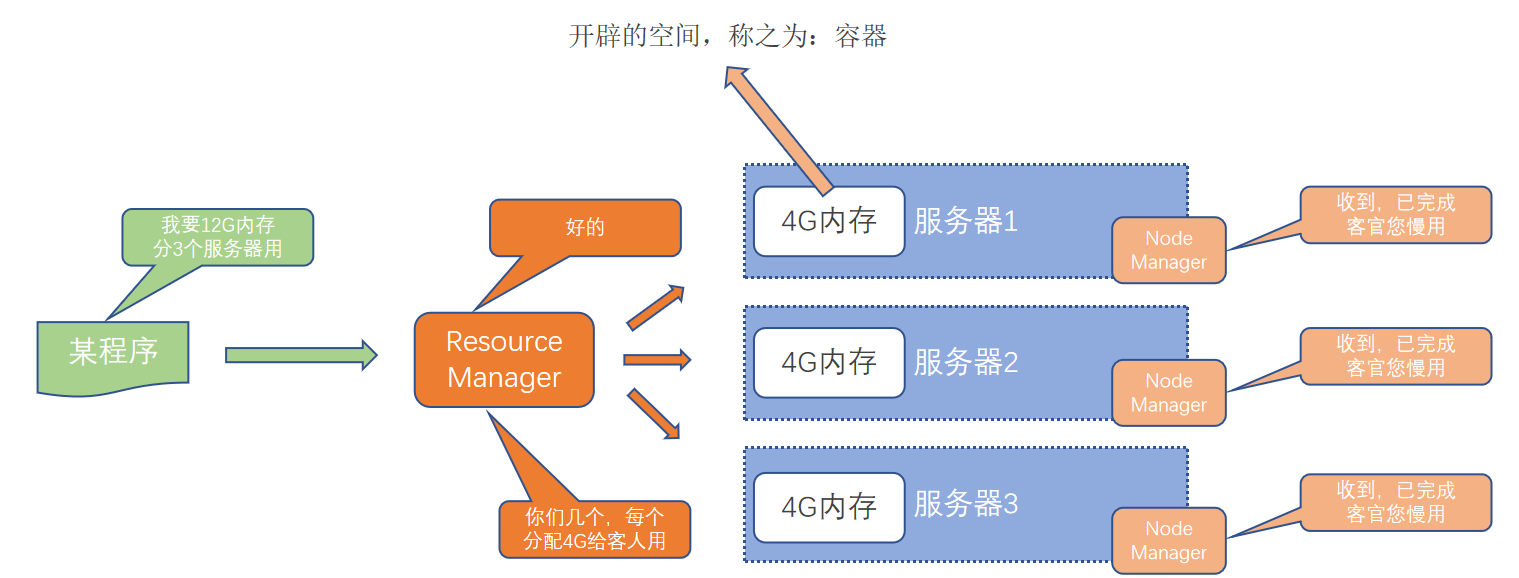

假设,有一个MapReduce程序, 分解了3个Map任务,和1个Reduce任务,那么如何在YARN的监管(管理)下运行呢?

向YARN申请使用资源,YARN分配好资源后运行,空闲资源可供其它程序使用

之前我们学过HDFS主从架构,有两个角色

- 主(Master)角色:NameNode

- 从(Slave)角色 :DataNode

同样,YARN也是主从架构,有2个角色

- 主(Master)角色:ResourceManager

- 从(Slave) 角色:NodeManager

ResourceManager:整个集群的资源调度者, 负责协调调度各个程序所需的资源(管理、统筹并分配整个集群的资源)。

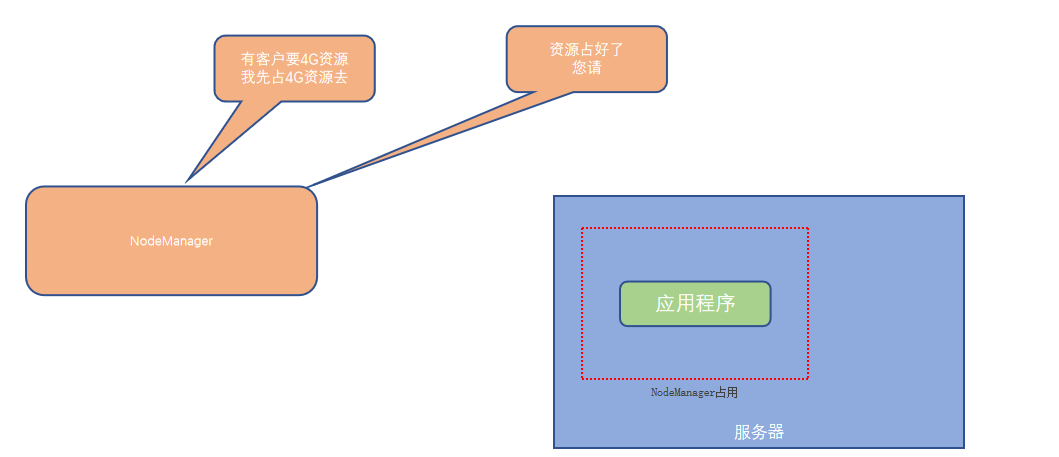

NodeManager:单个服务器的资源调度者,负责调度单个服务器上的资源提供给应用程序使用(管理、分配单个服务器的资源,即创建管理容器,由容器提供资源供程序使用)。

如何实现服务器上精准分配如下的硬件资源呢?

容器:

- NodeManager在服务器上构建一个容器(提前占用资源,类似集装箱的概念)

- 然后将容器的资源提供给程序使用

- 程序运行在容器(集装箱)内,无法突破容器的资源限制

3.4 Web应用代理(Web Application Proxy)

YARN的架构中除了上边的两个核心角色,即:

- ResourceManager:集群资源总管家

- NodeManager:单机资源管家

还可以搭配2个辅助角色,使得YARN集群运行更加稳定

- 代理服务器(ProxyServer):Web Application Proxy Web应用程序代理

- 历史服务器(JobHistoryServer): 应用程序历史信息记录服务

代理服务器,即Web应用代理是 YARN 的一部分。默认情况下,它将作为资源管理器(RM)的一部分运行,但是可以配置为在独立模式下运行。使用代理的原因是为了减少通过 YARN 进行基于网络的攻击的可能性。

这是因为, YARN在运行时会提供一个WEB UI站点(同HDFS的WEB UI站点一样)可供用户在浏览器内查看YARN的运行信息

对外提供WEB 站点会有安全性问题, 而代理服务器的功能就是最大限度保障对WEB UI的访问是安全的。 比如:

- 警告用户正在访问一个不受信任的站点

- 剥离用户访问的Cookie等

开启代理服务器,可以提高YARN在开放网络中的安全性 (但不是绝对安全只能是辅助提高一些)

代理服务器默认集成在了ResourceManager中,也可以将其分离出来单独启动,如果要分离代理服务器

- 在yarn-site.xml中配置 yarn.web-proxy.address 参数即可 (部署环节会使用到)

- 并通过命令启动它即可

$HADOOP_YARN_HOME/sbin/yarn-daemon.sh start proxyserver(部署环节会使用到)

3.5 JobHistoryServer历史服务器

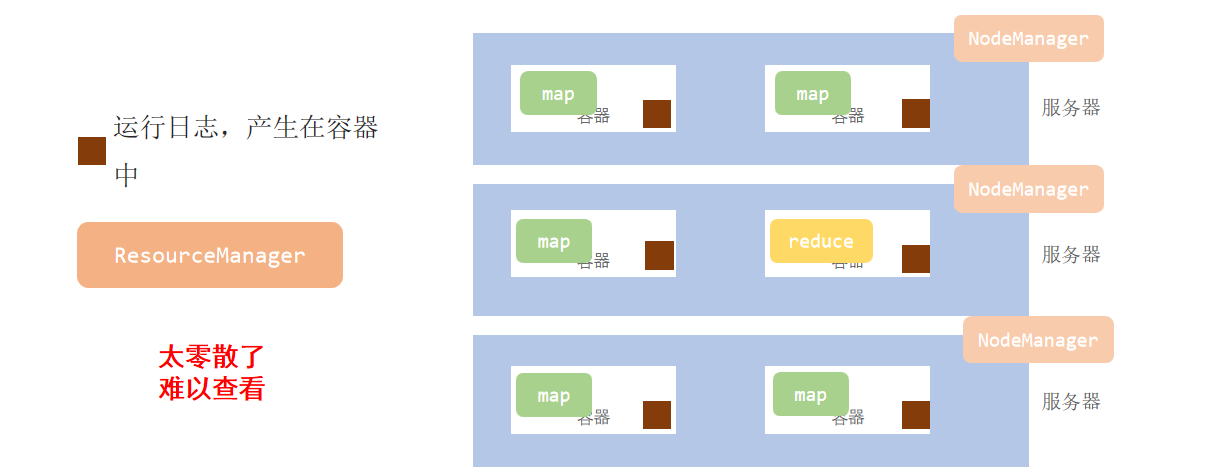

历史服务器的功能很简单: 记录历史运行的程序的信息以及产生的日志并提供WEB UI站点供用户使用浏览器查看。

程序看日志不是日常操作吗? 为何需要一个单独的历史服务器?回答这个问题要从YARN的运行机制说起。

统一收集到HDFS,由历史服务器托管为WEB UI供用户在浏览器统一查看

JobHistoryServer历史服务器功能:

- 提供WEB UI站点,供用户在浏览器上查看程序日志

- 可以保留历史数据,随时查看历史运行程序信息

JobHistoryServer需要配置:

-

开启日志聚合,即从容器中抓取日志到HDFS集中存储

-

配置历史服务器端口和主机

详细历史服务器配置和启动,在后边部署YARN集群环节讲解

三 MapReduce & YARN 的部署

3.1 部署说明

Hadoop HDFS分布式文件系统,我们会启动:

- NameNode进程作为管理节点

- DataNode进程作为工作节点

- SecondaryNamenode作为辅助

同理,Hadoop YARN分布式资源调度,会启动:

- ResourceManager进程作为管理节点

- NodeManager进程作为工作节点

- ProxyServer、JobHistoryServer这两个辅助节点

那么,MapReduce呢?MapReduce运行在YARN容器内,无需启动独立进程

所以关于MapReduce和YARN的部署,其实就是2件事情:

- 关于MapReduce: 修改相关配置文件,但是没有进程可以启动

- 关于YARN: 修改相关配置文件, 并启动ResourceManager、NodeManager进程以及辅助进程(代理服务器、历史服务器)

通过表格进行汇总

有3台服务器,其中node1配置较高

3.2 配置MapReduce环境

在 $HADOOP_HOME/etc/hadoop 文件夹内修改

mapred-env.sh文件

添加如下环境变量

# 设置jdk路径

export JAVA_HOME=/usr/local/jdk18

# 设置JobHistoryServer进程内存为1G

export HADOOP_JOB_HISTORYSERVER_HEAPSIZE=1000

# 设置日志级别为info

export HADOOP_MAPRED_ROOT_LOGGER=INFO,RFA

mapred-site.xml文件

添加如下配置信息

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

<description>MapReduce的运行框架设置为YARN</description>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>node1:10020</value>

<description>历史服务器通讯端口为node1:10020</description>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node1:19888</value>

<description>历史服务器web端口为node1的19888</description>

</property>

<property>

<name>mapreduce.jobhistory.intermediate-done-dir</name>

<value>/data/mr-history/tmp</value>

<description>历史信息在hdfs的记录临时路径</description>

</property>

<property>

<name>mapreduce.jobhistory.done-dir</name>

<value>/data/mr-history/done</value>

<description>历史信息在hdfs的记录路径</description>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<description>MapReduce_HOME设置为HADOOP_HOME</description>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<description>MapReduce_HOME设置为HADOOP_HOME</description>

</property>

<property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<description>MapReduce_HOME设置为HADOOP_HOME</description>

</property>

</configuration>

yarn-env.sh文件,添加如下4行环境变量内容

# 配置jdk路径的环境变量

export JAVA_HOME=/usr/local/jdk18

# 设置hadoop_home的环境变量

export HADOOP_HOME=/export/server/hadoop

# 设置配置文件路径的环境变量

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

# export YARN_CONF_DIR=$HADOOP_HOME/etc/hadoop

# export YARN_LOG_DIR=$HADOOP_HOME/logs/yarn

# 设置日志文件路径的环境变量

export HADOOP_LOG_DIR=$HADOOP_HOME/logs

yarn-site.xml文件,配置如下

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.log.server.url</name>

<value>http://node1:19888/jobhistory/logs</value>

<description>历史服务器URL</description>

</property>

<property>

<name>yarn.web-proxy.address</name>

<value>node1:8089</value>

<description>代理服务器主机和端口</description>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

<description>开启日志聚合</description>

</property>

<property>

<name>yarn.nodemanager.remote-app-log-dir</name>

<value>/tmp/logs</value>

<description>程序日志HDFS的存储路径</description>

</property>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>node1</value>

<description>resourcemanager节点设置在node1服务器</description>

</property>

<property>

<name>yarn.resourcemanager.scheduler.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.scheduler.fair.FairScheduler</value>

<description>选择公平调度器</description>

</property>

<property>

<name>yarn.nodemanager.local-dirs</name>

<value>/data/nm-local</value>

<description>nodemanager中间数据本地存储路径.</description>

</property>

<property>

<name>yarn.nodemanager.log-dirs</name>

<value>/data/nm-log</value>

<description>nodemanager数据日志本地存储路径</description>

</property>

<property>

<name>yarn.nodemanager.log.retain-seconds</name>

<value>10800</value>

<description>Default time (in seconds) to retain log files on the NodeManager Only applicable if log-aggregation is disabled.</description>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

<description>为MapReduce程序开启Shuffle服务.</description>

</property>

</configuration>

MapReduce和YARN的配置文件修改好后,需要分发到其它的服务器节点中。

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml node2:'pwd'/

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml node3:'pwd'/

分发完成配置文件,就可以启动YARN的相关进程了。

3.3 集群启动命令介绍

常用的进程启动命令如下:

- 一键启动YARN集群:

$HADOOP_HOME/sbin/start-yarn.sh- 会基于yarn-site.xml中配置的yarn.resourcemanager.hostname来决定在哪台机器上启动resourcemanager

- 会基于workers文件配置的主机启动NodeManager

- 一键停止YARN集群:

$HADOOP_HOME/sbin/stop-yarn.sh - 在当前机器,单独启动或停止进程

$HADOOP_HOME/bin/yarn --daemon start|stop resourcemanager|nodemanager|proxyserver- start和stop决定启动和停止

- 可控制resourcemanager、nodemanager、proxyserver三种进程

- 历史服务器启动和停止

$HADOOP_HOME/bin/mapred --daemon start|stop historyserver

3.4 启动YARN集群

在node1服务器,以hadoop用户执行

-

首先执行:

$HADOOP_HOME/sbin/start-yarn.sh,一键启动所需的:- ResourceManager

- NodeManager

- ProxyServer(代理服务器)

-

其次执行:

$HADOOP_HOME/bin/mapred --daemon start historyserver启动:- HistoryServer(历史服务器)

- HistoryServer(历史服务器)

查看YARN的WEB UI页面

打开 http://node1:8088,即可看到YARN集群的监控页面(ResourceManager的WEB UI)

在最后,可以给VmWare虚拟机打上快照,保存安装状态。

总结:仅启动YARN的相关进程即可(MapReduce无需启动任何进程,需要时会运行在YARN内部(容器中)

命令详细介绍

启动:$HADOOP_HOME/sbin/start-yarn.sh

- 从yarn-site.xml中读取配置,确定ResourceManager所在机器,并启动它

- 读取workers文件,确定机器,启动全部的NodeManager

- 在当前机器启动ProxyServer(代理服务器)

关闭:$HADOOP_HOME/sbin/stop-yarn.sh

单进程启停

除了一键启停外,也可以单独控制进程的启停。

-

$HADOOP_HOME/bin/yarn,此程序也可以用以单独控制所在机器的进程的启停

用法:yarn --daemon (start|stop) (resourcemanager|nodemanager|proxyserver) -

$HADOOP_HOME/bin/mapred,此程序也可以用以单独控制所在机器的历史服务器的启停

用法:mapred --daemon (start|stop) historyserver

四 提交MapReduce任务到YARN执行

在部署并成功启动YARN集群后,我们就可以在YARN上运行各类应用程序了。

YARN作为资源调度管控框架,其本身提供资源供许多程序运行,常见的有:

- MapReduce程序

- Spark程序

- Flink程序

Spark和Flink是大数据后续的学习内容,我们目前先来体验一下在YARN上执行MapReduce程序的过程。

Hadoop官方内置了一些预置的MapReduce程序代码,我们无需编程,只需要通过命令即可使用。

常用的有2个MapReduce内置程序:

- wordcount:单词计数程序。 统计指定文件内各个单词出现的次数

- pi:求圆周率。通过蒙特卡罗算法(统计模拟法)求圆周率

这些内置的示例MapReduce程序代码,都在:

$HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar 这个文件内。

可以通过 hadoop jar 命令来运行它,提交MapReduce程序到YARN中。

语法: hadoop jar 程序文件 java类名 [程序参数] ... [程序参数]

4.1 提交wordcount示例程序

单词计数示例程序的功能很简单:

- 给定数据输入的路径(HDFS)、给定结果输出的路径(HDFS)

- 将输入路径内的数据中的单词进行计数,将结果写到输出路径

我们可以准备一份数据文件,并上传到HDFS中。数据文件命名为words.txt,文件里边内容如下:

java maltose java itcast

hadoop hdfs hadoop hdfs

hadoop mapreduce hadoop yarn

java hadoop maltose hadoop

java maltose hadoop yarn mapreduce

在HDFS内新建文件夹,并上传上边的words.txt文件

hadoop fs -mkdir -p /input/wordcount

hadoop fs -mkdir /output

hadoop fs -put words.txt /input/wordcount/

执行如下命令,提交示例MapReduce程序WordCount到YARN中执行

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar wordcount hdfs://node1:8020/input/wordcount/ hdfs://node1:8020/output/wc1

注意:

- 参数wordcount,表示运行jar包中的单词计数程序(Java Class)

- 参数1是数据输入路径(hdfs://node1:8020/input/wordcount/)

- 参数2是结果输出路径(hdfs://node1:8020/output/wc1), 需要确保输出的文件夹不存在

提交程序后,可以在YARN的WEB UI页面看到运行中的程序(http://node1:8088/cluster/apps)

执行完成后,可以查看HDFS上的输出结果

- _SUCCESS文件是标记文件,表示运行成功,本身是空文件

- part-r-00000,是结果文件,结果存储在以part开头的文件中

执行完成后,可以借助历史服务器查看到程序的历史运行信息

ps:如果没有启动历史服务器和代理服务器,此操作无法完成(页面信息由历史服务器提供,鼠标点击跳转到新网页功能由代理服务器提供)

查看运行日志

点击logs链接,可以查看到详细的运行日志信息。

此功能基于:

- 配置文件中配置了日志聚合功能,并设置了历史服务器

- 启动了代理服务器和历史服务器

- 历史服务器进程会将日志收集整理,形成可以查看的网页内容供我们查看。

所以,如果发现无法查看程序运行历史以及无法查看程序运行日志信息,请检查上述1、2、3是否都正确设置。

4.2 提交求圆周率示例程序

可以执行如下命令,使用蒙特卡罗算法模拟计算求PI(圆周率)

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar pi 3 1000

- 参数pi表示要运行的Java类,这里表示运行jar包中的求pi程序

- 参数3,表示设置几个map任务

- 参数1000,表示模拟求PI的样本数(越大求的PI越准确,但是速度越慢)

如图,运行完成,求得PI值(样本1000太小,不够精准,仅演示)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?