Python网络爬虫入门篇:Request库入门

这里写目录标题

1.预备知识

学习者需要预先掌握Python的数字类型、字符串类型、分支、循环、函数、列表类型、字典类型、文件和第三方库使用等概念和编程方法。

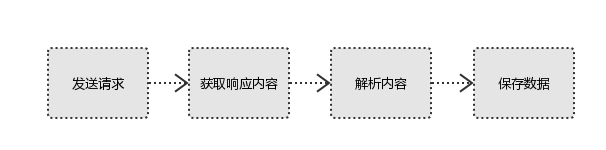

2. Python爬虫基本流程

a. 发送请求

使用http库向目标站点发起请求,即发送一个Request,Request包含:请求头、请求体等。

Request模块缺陷:不能执行JS 和CSS 代码。

b. 获取响应内容

如果requests的内容存在于目标服务器上,那么服务器会返回请求内容。

Response包含:html、Json字符串、图片,视频等。

c. 解析内容

对用户而言,就是寻找自己需要的信息。对于Python爬虫而言,就是利用正则表达式或者其他库提取目标信息。

解析html数据:正则表达式(RE模块),第三方解析库如Beautifulsoup,pyquery等

解析json数据:json模块

解析二进制数据:以wb的方式写入文件

d. 保存数据

解析得到的数据可以多种形式,如文本,音频,视频保存在本地。

数据库(MySQL,Mongdb、Redis)

文件

3. Requests库入门

3.1 Requests库安装和测试

安装:

Win平台:以“管理员身份运行cmd”,执行 pip install requests

3.2 Requests库的7个主要方法

方法 说明

requests.request() 构造一个请求,支撑一下个方法的基础方法。

requests.get() 获取HTML网页的主要方法,对应HTTP的GET

requests.head() 获取HTML网页投信息的方法,对应HTTP的HEAD

requests.post() 向HTML网页提交POST请求的方法,对应HTTP的POST

requests.put() 向HTML网页提交PUT请求的方法,对应HTTP的PUT

requests.patch() 向HTML网页提交局部修改请求,对应HTTP的PATCH

requests.delete() 向HTML网页提交删除请求,对应HTTP的DELETE

带可选参数的请求方式:

requests.request(method,url,**kwargs)

method:请求方式,对应get/put/post等7种

url:获取页面的url链接

**kwargs:控制访问的参数,均为可选项,共以下13个

params:字典或字节系列,作为参数增加到url中

>>> kv = {'key1':'value1','key2':'value2'}

>>> r = requests.request('GET','http://python123.io/ws',params=kv)

>>> print(r.url)

https://python123.io/ws?key1=value1&key2=value2

data:字典、字节系列或文件对象,作为requests的内容

>>> kv = {'key1':'value1','key2':'value2'}

>>> r = requests.request('POST','http://python123.io/ws',data=kv)

>>> body = '主题内容'

>>> r = requests.request('POST','http:///python123.io/ws',data=body)

json:JSON格式的数据,作为equests的内容

>>> kv = {'key1':'value1','key2':'value2'}

>>> r = requests.request('POST','http://python123.io/ws',json=kv)

headers:字典,HTTP定制头

>>> hd = {'user-agent':'Chrome/10'}

>>> r = requests.request('POST','http://www.baidu.com',headers=hd)

timeout:设置超时时间,秒为单位。

>>> r = requests.request('GET','http://python123.io/ws',timeout=30)

3.3 Requests库的get()方法

Response对象的属性

3.5 理解Response的编码

3.6 理解Requests库的异常

Requests库支持常见的6种连接异常

3.7 爬取网页的通用代码框架

import requests

def getHTMLText(url):

try:

r = requests.get(url,timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "产生异常"

if __name__ == "__main__":

url = "http://www.baidu.com"

print(getHTMLText(url))

如风少年: [link](https://www.cnblogs.com/wenwei-blog/p/10435602.html#auto_id_0).

254

254

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?