MCP 的发展

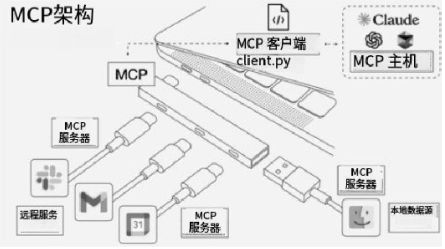

MCP 是由美国人工智能初创公司 Anthropic (Claude 系列模型也是他们推出的)主导开发的,于 2024 年 11 月正式开源,在 2025 年迎来了爆发式增长。MCP 的推出旨在解决大模型与第三方系统集成日益增长的复杂性问题。这里引用一段官方 Github 仓库里的原话:

The Model Context Protocol (MCP) is an open protocol that enables seamless integration between LLM applications and external data sources and tools. Whether you're building an AI-powered IDE, enhancing a chat interface, or creating custom AI workflows, MCP provides a standardized way to connect LLMs with the context they need.

2025 年 3 月 26 日,OpenAI 宣布将在其 Agents SDK 以及 ChatGPT 桌面应用中集成对 MCP 的支持。谷歌旗下的 DeepMind 子公司首席执行官 Demis Hassabis 在 2025 年 4 月初确认,将在其 Gemini 模型和相关设施中支持 MCP。同时,国内众多科技巨头也相继推出了自己的 MCP 服务平台。开发者社区对 MCP 的创新架构也给予了高度评价。

MCP 简介

MCP 是一种开放协议

- 公开的、非专有的

- 鼓励社区参与和推动,避免厂商锁定

MCP 是一种“应用层协议”

- 对应OSI 模型或 TCP/IP 模型的应用层

- 专注于定义应用程序之间通信的语义和规则

- 底层网络的复杂细节则被抽象化处理

MCP 致力于规范人工智能系统各组成部分之间上下文信息的交换方式以及交互行为

- “组成部分”的范围很广,可以是各种 AI 模型、传统的软件工具、API 服务、外部数据源、用户交互界面等

- “上下文信息”是核心,涉及执行 AI 任务所需的一切相关信息,例如:用户偏好、会话历史、领域知识、实时环境数据、当前任务状态、系统能力与约束等

- MCP 通过定义标准的“交换方式”(如 JSON、请求/响应模式、发布/订阅机制)和“交互行为”(如组件如何请求信息、提供更新、触发动作、报告事件等)来确保这些多样化的上下文信息能够在不同组件间顺畅、准确的流动

MCP 的 AI 应用标准接口主要体现在以下 3 个方面:

① 统一工具调用标准

在复杂 AI 应用中,往往需要调用多种不同来源、不同功能的 AI 工具或模型,如果不对他们的 API 和数据格式进行统一,后续集成和维护的成本将会很高。“统一工具调用标准”主要涉及以下两个方面:

1.标准化的工具描述(每个可供调用的工具即 MCP Client 能够以一种标准化的方式声明其能力)

- 唯一标识符

- 功能描述

- 输入参数规范

2.标准化的交互方法(定义了一组核心的 Method和 Notification,用于实现 MCP Host 与 MCP Client 之间调用工具的标准化交互流程)

- 工具发现

- 工具执行

- 工具执行结果/进度通知

② 动态工具集成

在统一工具调用标准的基础上,MCP 进一步支持动态工具集成(Dynamic Tool Integration),赋予 AI 应用更多的灵活性和可扩展性。可以根据需求变化、在运行时动态调整其能力。动态工具集成使 AI 应用能快速适应需求,集成新技术,构建更健壮、更有弹性的系统。

- 运行时工具发现与加载

- 插件化架构的实现

- 按需服务与资源优化

- 版本管理与依赖协商

③ 语义对齐

统一的语法接口解决了“如何说”的问题。但如果缺乏语义对齐(Semantic Alignment),即使工具能够被成功调用,其输入也可能被误解,输出结果也可能无法被正确使用,导致 AI 系统行为异常甚至产生严重错误。MCP 提供以下机制,构建更加一致的语义:

- 上下文模式与数据字典

- 共享词汇表与本体库

- 元数据描述与溯源

- 上下文协商与转换服务

MCP 典型应用场景

企业助手:企业可以利用 MCP 使其内部的 AI 助手能够安全高效的访问和检索专有文档

自然语言数据访问:通过 MCP 将 LLM 与数据库连接起来,使得用户可以用自然语言进行数据库查询,降低数据访问的技术门槛

桌面助手:比如 Claude Desktop 在本地运行 MCP Server,允许 AI 助手安全地读取本地文件或与操作系统工具进行交互

多工具智能体:MCP 支持涉及多个工具的复杂智能体工作流,使得跨分布式资源的“思维链”推理成为可能

集成开发环境:比如像 Cursor 利用 MCP 实现 AI 驱动的代码辅助

云服务集成:Cloudflare 推出了远程 MCP Server 托管服务,允许客户端无缝连接到安全的、云托管的 MCP Server

参考文献

在学习以上部分内容及笔记撰写过程中,查阅参考了一些优秀的教程和社区资源:

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?