为了使集群能够更加稳健,我在运行了大约半年后的CDH上启用了HDFS高可用性,目的就是为了防止集群中namenode机器宕机后集群还能靠备用节点进制故障转移。我这一操作好了,原本没问题的集群一下子出现了好多问题。

是由下面这个事件暴露出来的:

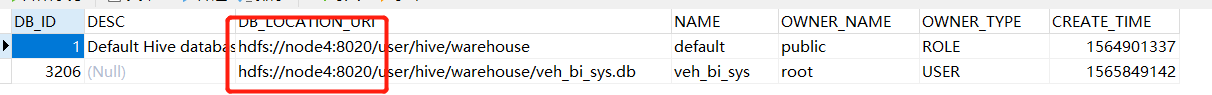

我们在集群内安装了kylin进行多维数据分析,在我启用HA后,kylin在build的时候就会报一些奇怪的错误,起初还不怎么影响使用,直到后来被迫重启了下集群,发现HBase大量的region挂掉了,都处于offline状态,于是去每个节点查看regionserver的日志,发现使regionserver识别不到hdfs上的一些文件了。未开启HA的时候,hdfs上文件的路径这样表示hdfs://node4:8020/xxx,开启HA后就发生了变化hdfs://nameservice1/xxx,但是由于一些内部原因,我猜测某些组件的元数据依然存储的是前者,故HA后集群会异常。下面从kylin build的错误日志开始排查。

上面只是猜测,接着咱再去找证据。

如上图,在对kylin的cube进行重新build的时候,执行到14步骤的时候,需要进行一个叫Hive Cleanup的操作,这个操作失败了导致kylin任务也失败了。纳闷,于是又去找hive的麻烦,的确找到了。

Hive元数据的问题,在Hive数据库中有两张表:

DBS : Hive数据仓库的总路径

SDS : Hive每张表对应的路径

先把路径都改成HA的路径,然后重新执行kylin build。

update DBS set DB_LOCATION_URI=REPLACE (DB_LOCATION_URI,'node4:8020','nameservice1');

update SDS set LOCATION=REPLACE (LOCATION,'node4:8020','nameservice1')

依然报错,重启HDFS集群再次尝试,希望成功。

kylin build正常了。

很遗憾,但是hbase还有些许异常。每次重启完集群,如果active的节点不是node4的话,hbase就会有大量的region无法正常连接到regionserver,需要手动故障转移到node4上。原因未知,静待解决。

去regionserver下查看日志:

下午3点37:42.789分 INFO RetryInvocationHandler

org.apache.hadoop.ipc.RemoteException(org.apache.hadoop.ipc.StandbyException): Operation category READ is not supported in state standby. Visit https://s.apache.org/sbnn-error

at org.apache.hadoop.hdfs.server.namenode.ha.StandbyState.checkOperation(StandbyState.java:88)

at org.apache.hadoop.hdfs.server.namenode.NameNode$NameNodeHAContext.checkOperation(NameNode.java:1962)

at org.apache.hadoop.hdfs.server.namenode.FSNamesystem.checkOperation(FSNamesystem.java:1421)

at org.apache.hadoop.hdfs.server.namenode.FSNamesystem.getListing(FSNamesystem.java:3729)

at org.apache.hadoop.hdfs.server.namenode.NameNodeRpcServer.getListing(NameNodeRpcServer.java:1138)

at org.apache.hadoop.hdfs.protocolPB.ClientNamenodeProtocolServerSideTranslatorPB.getListing(ClientNamenodeProtocolServerSideTranslatorPB.java:708)

at org.apache.hadoop.hdfs.protocol.proto.ClientNamenodeProtocolProtos$ClientNamenodeProtocol$2.callBlockingMethod(ClientNamenodeProtocolProtos.java)

at org.apache.hadoop.ipc.ProtobufRpcEngine$Server$ProtoBufRpcInvoker.call(ProtobufRpcEngine.java:523)

at org.apache.hadoop.ipc.RPC$Server.call(RPC.java:991)

at org.apache.hadoop.ipc.Server$RpcCall.run(Server.java:869)

at org.apache.hadoop.ipc.Server$RpcCall.run(Server.java:815)

at java.security.AccessController.doPrivileged(Native Method)

at javax.security.auth.Subject.doAs(Subject.java:422)

at org.apache.hadoop.security.UserGroupInformation.doAs(UserGroupInformation.java:1875)

at org.apache.hadoop.ipc.Server$Handler.run(Server.java:2675)

, while invoking ClientNamenodeProtocolTranslatorPB.getListing over node4/10.20.190.9:8020 after 1 failover attempts. Trying to failover after sleeping for 717ms.

故我猜想,这可能是HBase元数据与Hive元数据同样的问题,需要将hdfs://node4:8020/xxx形式修改成hdfs://nameservice1/xxx形式。

518

518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?