我需要学习的内容

摘自参考1(其实原创是知乎回答)

1、基本的爬虫工作原理

2、基本的http抓取工具,scrapy

3、避免重复抓取网页,这里我们主要讨论使用 Bloom Filter

4、如果需要大规模网页抓取,你需要学习分布式爬虫的概念。其实没那么玄乎,你只要学会怎样维护一个所有集群机器能够有效分享的分布式队列就好。

5、将分布式队列和Scrapy的结合

6、后续处理,网页析取(grangier/python-goose GitHub),存储(Mongodb)

Bloom Filter

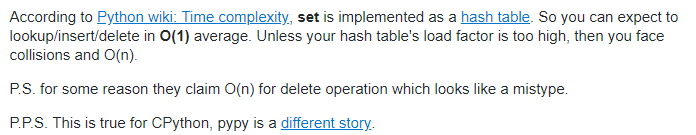

避免重复抓取网页时,通常的想法是维护一个 seen 集合,但是这样每次判断网页是否在队列中或已爬取复杂度为 O(log(n)) Stack Overflow 对集合 in 操作的复杂度的回答是这样的?(所以原回答还是好奇怪o?)

如果使用一般的hash内存使用率低,所以一般大型的爬虫会使用 Bloom Filter这一数据结果,它的详细介绍在这里。显而易见,快是建立在低准确率的基础上的,当hash被分配的内存足够大时,这个准确率会有所提高。

Scrapy

顺序:引擎问Spider拿到需要处理的网站?引擎告诉调度器网站是什么?调度器把处理好的请求发给下载器?下载器传递给Spider下载好的内容?Spider处理完数据后产生新的网址和Item数据,发给引擎?引擎分别把内容发给调度器和管道?…

以下是来自参考2对各部分功能的说明?

至于该如何实现一个scrapy爬虫,参考2已经给出了详细的过程~

2423

2423

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?