1. 机器学习基石–学习的可行性

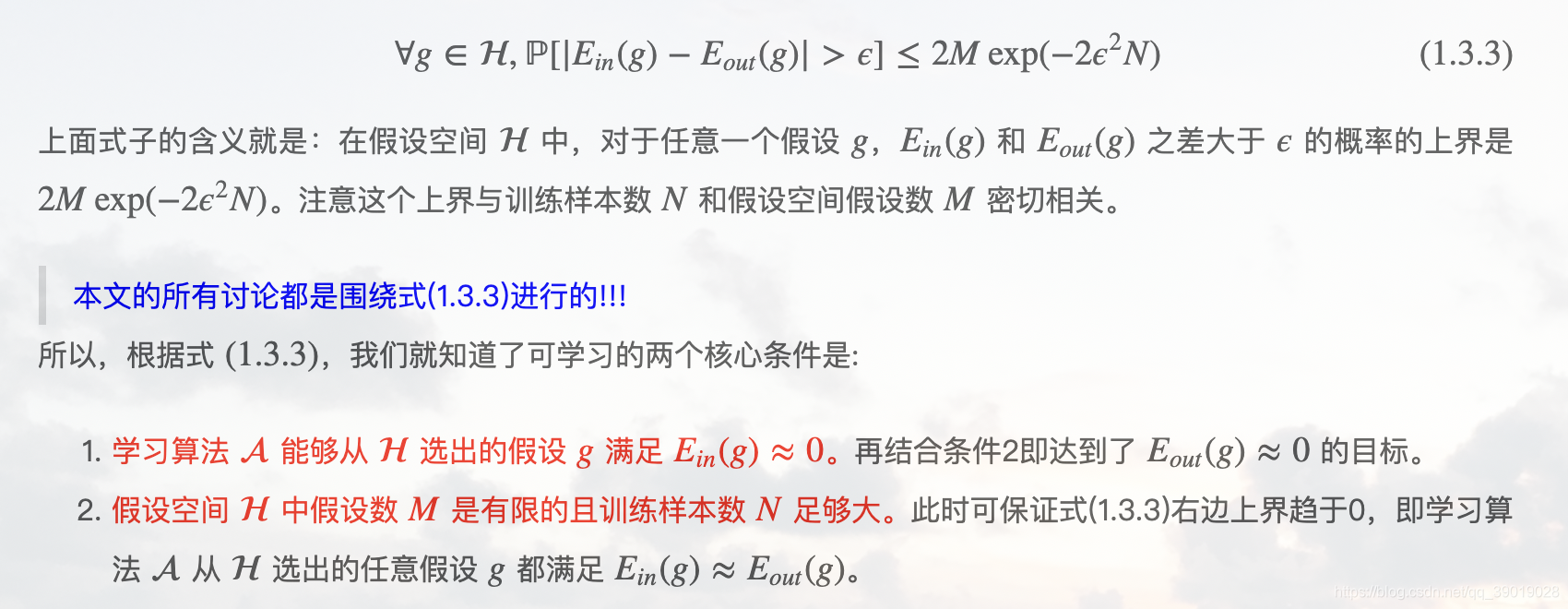

本文主要是通过 Hoeffding 不等式证明了当模型的所有 hypothesis 的个数 M 为有限个时,样本数目 N 足够大时,就能够保证泛化误差 Eout(h) 和训练误差 Ein(h) 很接近。

这时候只要找到一个 hypothesis 使得 Ein(h) 很小,那么 Eout(h) 也会很小,从而达到学习的目的。

当然有一个大前提就是训练样本和测试样本必须要在同一分布下产生,否则学习无从谈起。

The complexity of H:对于第一个问题,如果H很大,即M很大,那么Ein就不能很好地估计Eout;对于第二个问题如果H很大,即M很大,能找到更好地g,使Ein更小。所以M的大小有待商榷。

The complexity of f:不会影响第一个问题,会影响第二个问题,因为复杂的f更难拟合,Ein会较大,如果我们用更复杂的假设函数取拟合,此时M增大,可以使得Ein较小,但是此时Ein就不能很好地估计Eout。对于很复杂的f我们可能根本无法学习。

-

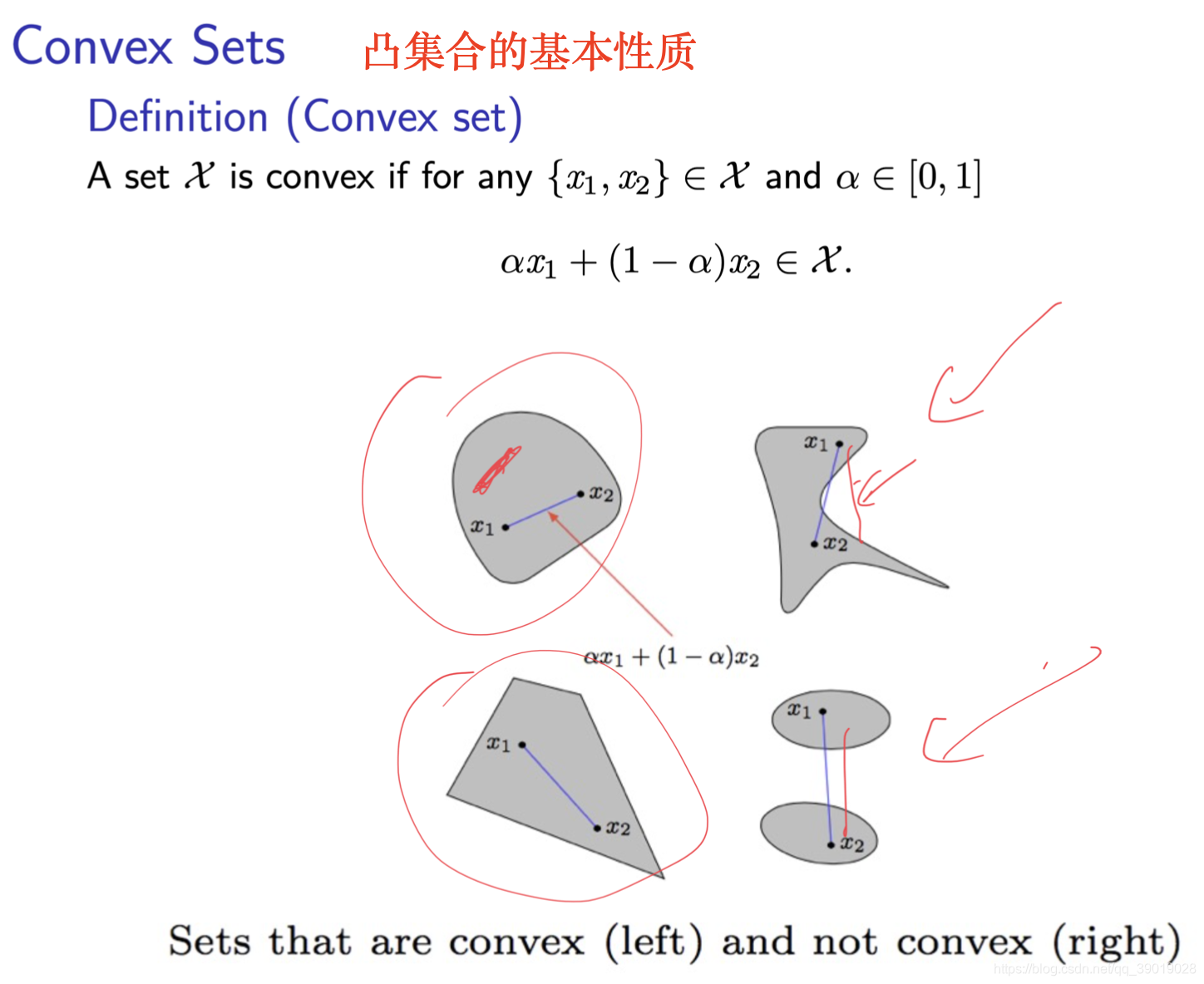

VC dimension当做模型有效参数个数( ‘effective’ number of parameters)

-

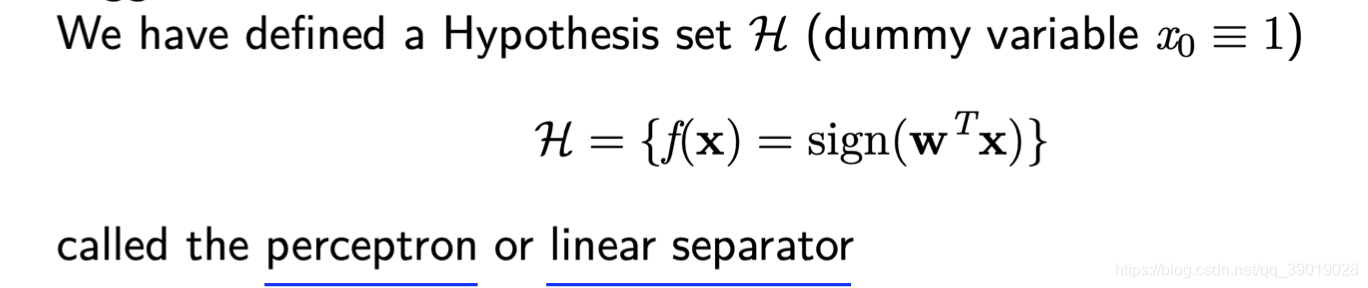

线性模型

(1)二分类

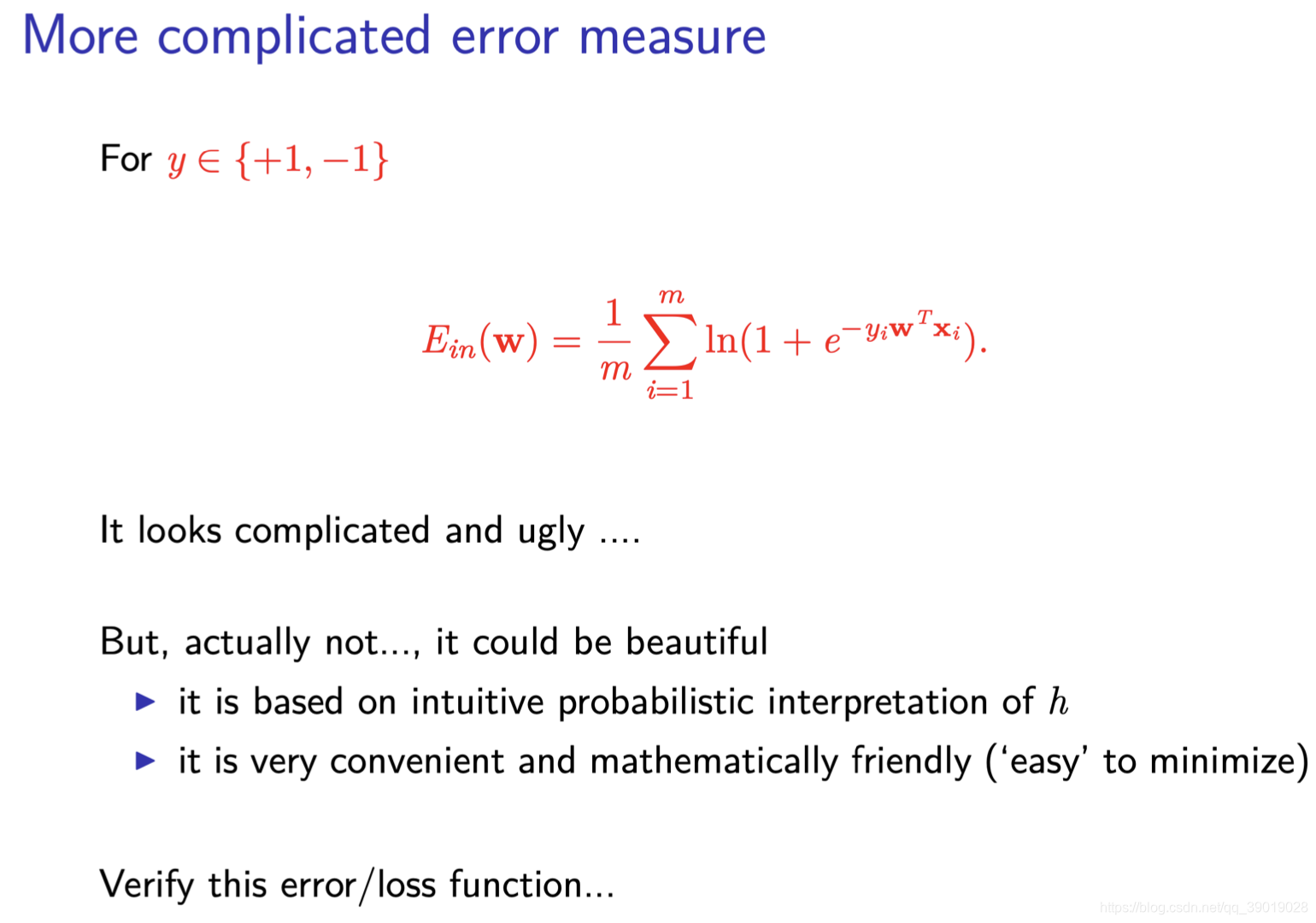

Logistic 回归的来源,代价函数的推导和求解

增长函数、断点、打碎、增长函数的上界、VC维等。

SVM支持向量机,软硬间隔,对偶问题

泛化能力取决于三部分:训练集容量、假设集合、置信水平。

两种风险最小化、偏差方差分解

815

815

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?