前段时间业务老是执行失败,检查资源使用情况后决定在两台节点上启动datandoe。

节点配置: 2core, 4G memory,2T(空磁盘) 使用ambari操作服务

启动datanode服务时候,启动不起来,排查问题发现是不满足hadoop节点最低要求(注: 与ambari中配置有关!)

给节点升配,节点配置 4core ,16G memory ,2T ,ambari中datanode挂载点为 /mnt/disk1,/mnt/disk2,/mnt/disk3

节点中配置挂载点为 /dev/vdb -> /mnt

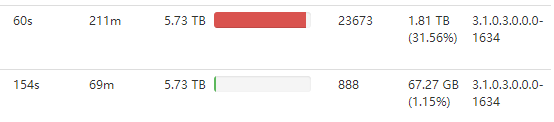

此时出现错误: 这是一个1.9TB的磁盘,被计算了三次。

这是一个1.9TB的磁盘,被计算了三次。![]()

解决办法:把这两台服务器加入黑名单,内部数据备份结束后,停止两台节点的hadoop服务。加一块500G磁盘,将2T磁盘拆分为两个1T。

(不使用直接下线的原因:直接下线只适用于一台节点下线,多台节点下线需要从黑名单设置下线。防止同一个备份块被彻底删除。)

数据同步结束状态:

http://hostname:50070/dfshealth.html#tab-datanode

Decommissioning 中会显示正在退役的节点数据同步状态。同步结束后,节点名称前方会变为一个关闭的图标。

比较神奇的是,当你在ambari中点击停用datanode,一台数据被清空,一台数据还在。

关闭服务,并检测

进行磁盘分区和磁盘挂载(略)

注意:需要删除ambari中对应节点的datanode服务,然后重新安装。

注意:磁盘分区后,对应的路径可能出现权限问题,所以需要注意hdfs是否有路径权限,可以给777权限。

别忘数据迁移。ambari有对应数据迁移操作。

1730

1730

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?