文章目录

2 HDFS-集群压测

在企业中非常关心每天从 Java 后台拉取过来的数据,需要多久能上传到集群?消费者关心多久能从 HDFS 上拉取需要的数据?

为了搞清楚 HDFS 的读写性能,生产环境上非常需要对集群进行压测。

HDFS的读写性能主要受网络和磁盘影响比较大。为了方便测试,将hadoop102、Hadoop103、hadoop104虚拟机网络都设置为100mbps

100Mbps 单位是 bit; 10M/s 单位是 byte ; 1byte=8bit, 100Mbps/8=12.5M/s

测试网速

在hadoop102上开启一个服务器,用于提供对外下载接口

在 hadoop102 的/opt/software 目录下开启服务器。

[ranan@hadoop102 software]$ python3 -m http.server

下载速度在12.5M/s以内,说明网速设置完成

2.1 测试HDFS写性能

测试1 限制网络

1 向HDFS集群写10个128M的文件

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.1.3-tests.jar TestDFSIO -write -nrFiles 10 -fileSize 128MB

hadoop-mapreduce-clientjobclient-3.1.3-tests.jar 该jar包专门用于压力测试的

TestDFSIO HDFS的读写性能

-write 写性能

-nrFiles n 为生成 mapTask 的数量,生产环境一般可通过 hadoop103:8088 查看 CPU,一般是测试文件个数=集群CPU总核数 - 1(保证三台服务器都有MapTask运行)

核数,设置为(CPU 核数 - 1)

-fileSize 128MB 每个文件的大小为128MB

如果测试过程中,出现异常

原因分析:实际4个G,虚拟内存是4*2.1=8.4G,因为centos7和Java8内存处理兼容性差,linux会预留大量内存不能使用,导致虚拟内存经常会溢出。

可以在 yarn-site.xml 中设置虚拟内存检测为 false

<!--是否启动一个线程检查每个任务正使用的虚拟内存量,如果任务超出分配值,则

直接将其杀掉,默认是 true -->

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

分发配置并重启 Yarn 集群

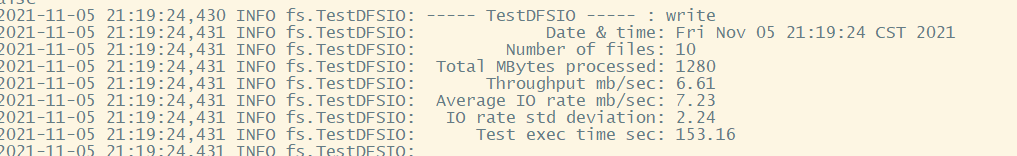

测试结果分析

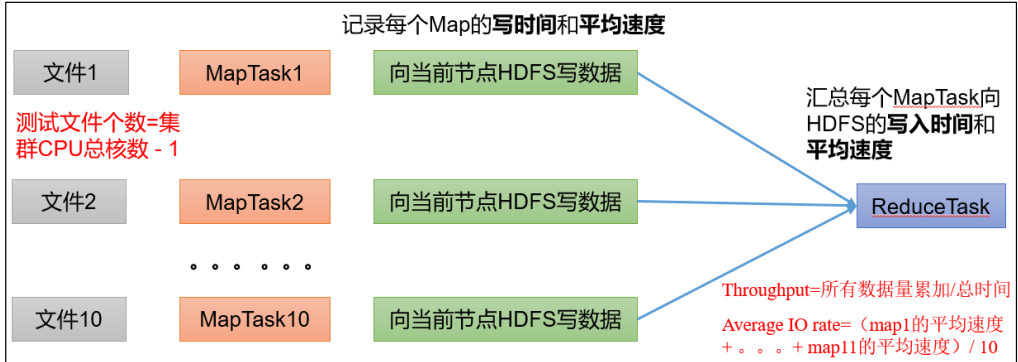

Number of files: 生成 mapTask 数量, 一般是集群中(CPU 核数-1)

Total MBytes processed:所有数据总总大小

Throughput mb/sec:,单个 mapTask 的吞吐量

计算方式: 处理的总文件大小/(每一个 mapTask写数据的时间累加)

Average IO rate mb/sec::平均 mapTak 的吞吐量

计算方式:(每个 mapTask 处理文件大小/每一个 mapTask 写数据的时间)全部相加除以 task 数量

IO rate std deviation:方差、反映各个 mapTask 处理的差值,越小越均衡

1)一个三个副本,进行压测的时候,假设该客户端在集群中那么本地是准备了一份副本(不参与测试),对HFDS进行写的时候只需要写副本2、副本3

一共参与测试的文件: 10 个文件 * 2 个副本 = 20 个

压测后的速度:6.61M/s

实测速度:6.61M/s * 20 个文件 ≈ 132M/s

三台服务器的带宽: 12.5M/S(100mbps) + 12.5 + 12.5 ≈ 30M/s

所有网络资源已经用满。

如果实测速度远远小于网络,并且实测速度不能满足工作需求,可以考虑采用固态硬盘或者增加磁盘个数。

2)如果客户端不在集群节点,那就三个副本都参与计算

测试2 不限制网络

1 向HDFS集群写10个128M的文件

修改网络配置

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.1.3-tests.jar TestDFSIO -write -nrFiles 10 -fileSize 128MB

2 测试结果分析

集群中那么本地是准备了一份副本(不参与测试),对HFDS进行写的时候只需要写副本2、副本3

一共参与测试的文件: 10 个文件 * 2 个副本 = 20 个

压测后的速度:60.25M/s

实测速度:60.25M/s * 20 个文件 ≈ 1205M/s

不受网络限制,写速度受磁盘的读写速度限制

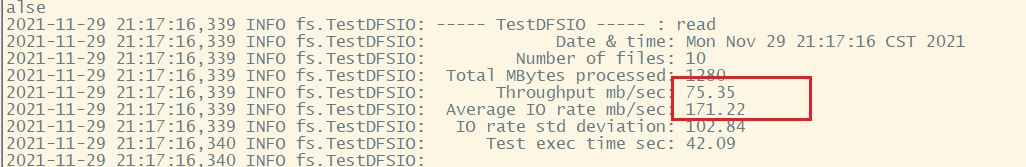

2.2 测试HDFS读性能

1 读取HDFS集群10个128M的文件

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.1.3-tests.jar TestDFSIO -read -nrFiles 10 -fileSize 128MB

实际的网速(网络的带宽):12.5M/s + 12.5M/s +12.5M/s= 37M/s

为什么读取文件速度大于网络带宽? 由于目前只有三台服务器,且有三个副本,数据读取就近原则,相当于都是读取的本地磁盘数据,没有走网络。

2745

2745

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?