论文地址:

https://scholar.google.com/scholar?hl=zh-CN&as_sdt=2005&sciodt=0%2C5&cites=12328462444653843486&scipsc=&q=CBAM%3A+Convolutional+Block+Attention+Module&btnG=

代码地址:

https://github.com/Jongchan/attention-module

定义:

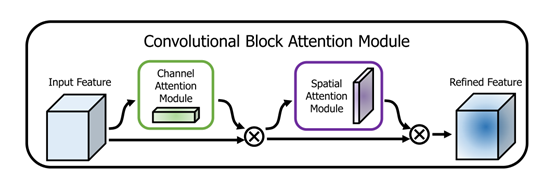

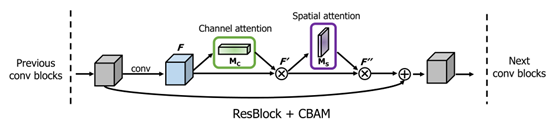

卷积块注意模块(CBAM)是一个简单而有效的前馈卷积神经网络的注意模块。工作流程:给定一个特征图作为输入,经过模块中两个互相独立的空间注意力和通道注意力,将注意力图乘以输入特征图以进行自适应特征细化。两个注意力模块,通道和空间注意力计算互补的注意,分别关注“什么”和“哪里”,提高了CNN的表征能力。作者发现顺序组合并且将通道注意力放在前面可以取得更好的效果。

CBAM结构图:

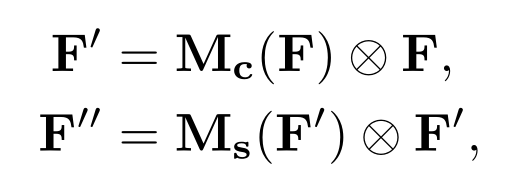

整体过程公式化:

输入中间特征图F∈RC×H×W,然后CBAM依次推导出一维通道注意力图Mc∈RC×1×1和二维空间注意力图Ms∈R1×H×W,输入特征图首先与通道注意力图相乘得到F’,然后F’再与空间注意力逐元素相乘得到最终注意力特征图F’’。

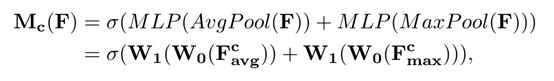

通道注意力:

同时而不是单独的使用average-pool和max-pool提高网络的表征能力。

首先,我们使用平均池和最大池操作聚合特征图的空间信息,生成两个不同的空间上下文描述F_avg^c和 F_maxc,分别表示平均池化特征和最大池化特征。然后将F_avgc和 F_max^c输入到共享网络,生成通道注意力图Mc∈RC×1×1。该共享网络由多层感知器(MLP)和一个隐含层组成。为了减少参数开销,将隐藏的激活大小设置为RC/r×1×1,其中r为缩减比。将共享网络应用到每个描述后,使用元素求和合并输出特征向量。则通道注意力计算为:

其中,σ为sigmoid激活函数,W0∈RC/r×C, W1∈RC×C/r。注意,MLP权值W0和W1对两个输入是共享的,ReLU激活函数followed by W0。

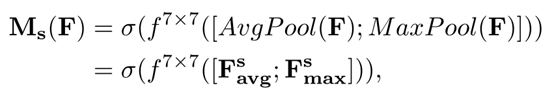

空间注意力:

空间注意关注的“在哪里”是信息的一部分,是通道注意的补充。

通过两个pooling操作,生成两个二维特征图F_avg^s∈R1×H×W和 F_max^s∈R1×H×W来聚合特征图的通道信息。它们分别表示通道上的平均池化特征和最大池化特征。然后通过一个标准的卷积层将它们连接和卷积,生成我们的二维空间注意力图。简言之,空间注意的计算方法为:

式中,σ为sigmoid函数,f7×7为卷积核7×7的卷积运算。

CBAM可以即用即插入到任何CNN架构中,以ResNet中集成了ResBlock的CBAM为例:

1228

1228

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?