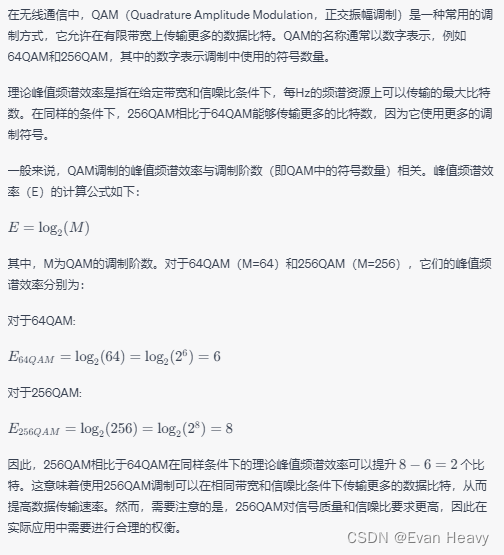

1. 64QAM与16QAM速率对比

64 = 2^6,6bit信息/符号;

16 = 2^4,4bit信息/符号;

6/4 = 1.5倍数

2. 人工智能热点关注(ChatGPT)

GPT “生成性预先训练转换器”(generative pretrained transformer)

百科:

ChatGPT是一种由OpenAI训练的大型语言模型。它的原理是基于Transformer架构,通过预训练大量文本数据来学习如何生成人类可读的文本,然后通过接受输入并生成输出来实现对话。

ChatGPT的用途非常广泛,可以用于自然语言处理(NLP)任务,它拥有极强的自然语言处理能力,可以用于各种任务,如文本生成、文本分类、问答系统、语言翻译和对话系统等。

如果你想使用ChatGPT,你可以用它来构建对话机器人,回答问题,生成文本等。它的应用非常广泛,可以用于各种场景,如客服、帮助提供者、教育机构等。

1. 对话系统:它可以模拟人类对话,并根据上下文生成自然流畅的回答。

ChatGPT可以被用来构建智能客服系统,与客户进行对话,回答他们的问题,解决他们

的问题。同时,ChatGPT也可以被用来构建语音助手,如智能家居设备中的语音控制系

统,以及手机中的智能助手,如Siri和Alexa。

2. 自然语言生成:它可以生成各种类型的文本,如新闻报道、文章、电子邮件、广告等。

可以生成高质量文本,可以帮助程序员生成代码完成开发。

3. 文本分类

ChatGPT可以被用来将文本分类到不同的类别中,如垃圾邮件过滤、情感分析等。这些

应用可以帮助人们更好地管理信息,提高工作效率。

4. 问答系统:可以被用来构建问答系统,回答用户的问题,提供相关信息。

ChatGPT可以被用来回答各种文本问题,如搜索、技术支持、咨询等。ChatGPT也可

以被用来回答语音问题,从而帮助用户更快地获取信息。

5. 语言翻译:可以被用来作语言翻译系统

无监督预训练技术是ChatGPT实现对话生成的关键技术,它可以自动地从大量的无标注数据中学习到语言的规律和特征,从而提高模型的泛化能力和表现力。

Tranformer模型:

规范化层作用:在一定层数后接规范化层进行数值的规范化,使其特征数值在合理范围内.

3. 解决AI模型的泛化能力

【深度学习/AI中的generalization问题,也就是泛化和正则化】

机器学习方法训练出来一个模型,希望它不仅仅是对于已知的数据(训练集)性能表现良好,对于未知的数据(测试集)也应该表现良好,也就是具有良好的generalization能力,这就是泛化能力。测试集的误差,也被称为泛化误差。

在机器学习中,泛化能力的好坏,最直观表现出来的就是模型的过拟合(overfitting)与欠拟合(underfitting)。

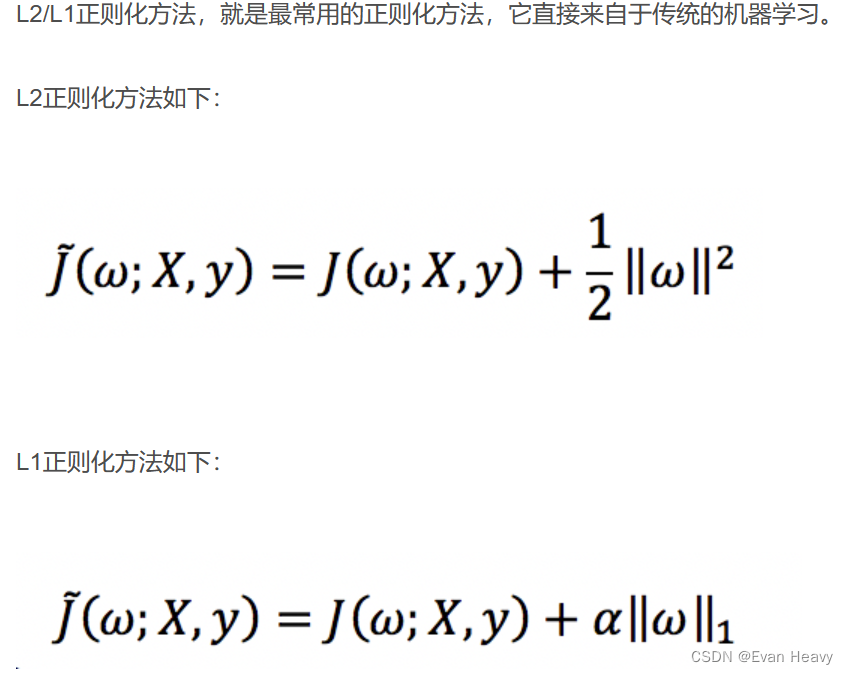

减缓过拟合:正则化。正则化,它的目标就是要同时让经验风险和模型复杂度较小。正则化的最终目标: 让网络学的不要太死,否则变成僵硬的书呆子。

一个机器学习系统,学习的是从输入到输出的关系,只要一个模型足够复杂,它是不是可以记住所有的训练集合样本之间的映射,代价就是模型复杂,带来的副作用就是没见过的只是略有不同的样本可能表现地就很差,就像下面这张图,只是更改了一个像素,预测就从Dog变成了Cat。

正则化方法:

1.经验正则化:提前终止 / 模型集成

提前终止:训练曲线随着不断迭代训练误差不断减少,但是泛化误差减少后开始增长。

假如我们在泛化误差指标不再提升后,提前结束训练,也是一种正则化方

法,这大概是最简单的方法了。

模型集成:模型集成(ensemable),也就是通过训练多个模型来完成该任务,它可以是不

同网络结构,不同的初始化方法,不同的数据集训练的模型,也可以是用不

同的测试图片处理方法,总之,采用多个模型进行投票的策略。

Dropout一种重要方法:它在训练过程中,随机的丢弃一部分输入,此时丢弃

部分对应的参数不会更新。

因为dropout降低了模型的性能,所以对于原本需要容量为N的网络才能

解决的问题,现在需要N/p,p就是保留该节点的概率,这个概率通常在

0.5~0.9之间,p=1就是普通的网络了。

因为dropout相当于增加了噪声,造成梯度的损失,所以需要使用更大的

学习率和动量项。与此同时,对权重进行max-norm等权重约束方法,使

其不超过某个值。

2. 参数正则化方法:

数据增强:归一化batch normalization

现在一般采用批梯度下降方法对深度学习进行优化,这种方法把数据分为若干组,按组来更新参数,一组中的数据共同决定了本次梯度的方向,下降时减少了随机性。另一方面因为批的样本数与整个数据集相比小了很多,计算量也下降了很多。

Batch Normalization(简称BN)中的batch就是批量数据,即每一次优化时的样本数目,通常BN网络层用在卷积层后,用于重新调整数据分布。假设神经网络某层一个batch的输入为X=[x1,x2,...,xn],其中xi代表一个样本,n为batch size。

Batch Normalization归一化优势:

(1) 减轻了对参数初始化的依赖,这是利于调参的朋友们的。

(2) 训练更快,可以使用更高的学习率。

(3) BN一定程度上增加了泛化能力,dropout等技术可以去掉。

两种提高泛化能力的思路:

第一,在不同的环境中采集多组数据重新模型训练,以此提高模型的泛化能力;第二,不用换环境采集新数据,而是对现有的训练数据合理去噪(或称滤波),用去噪后的强特征数据重新训练模型,以此提高模型的泛化能力。

461

461

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?