步骤一:进入scihub网址

步骤二:搜索想查找的文章

步骤三:搜索页面出来后(比如等待加载的页面,或者无法加载pdf的页面),复制链接到迅雷

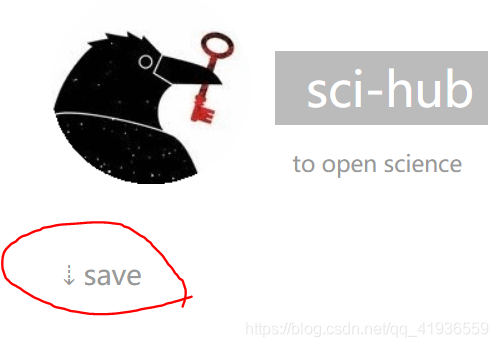

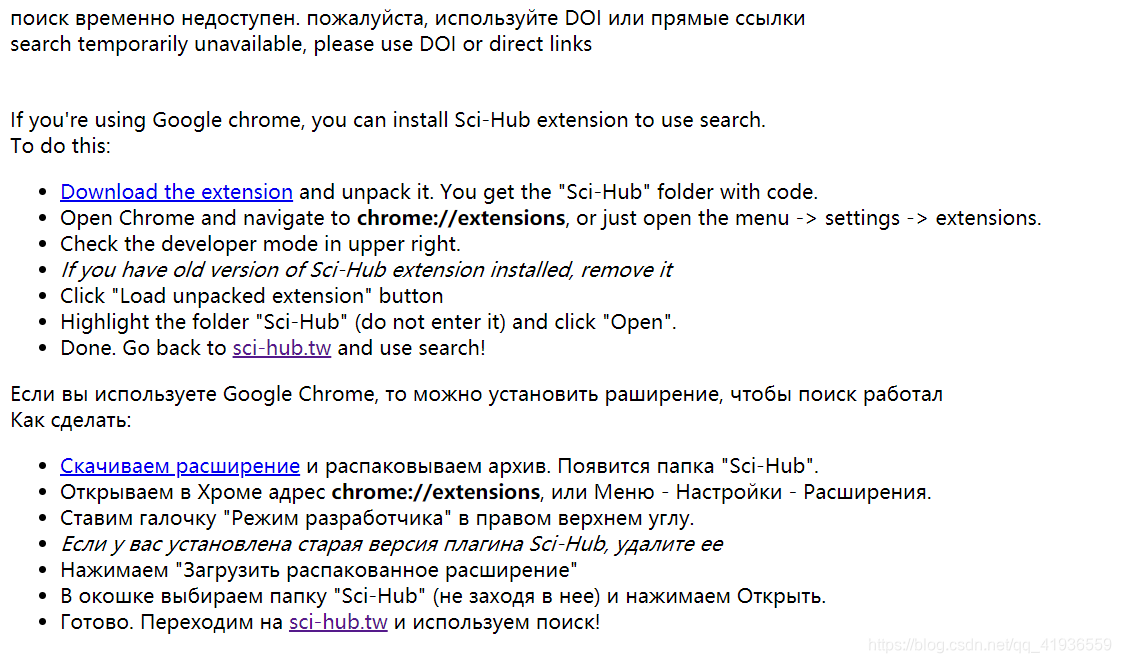

步骤四:点击左边的save,等待下载即可

然后就会冒出来迅雷的下载链接啦

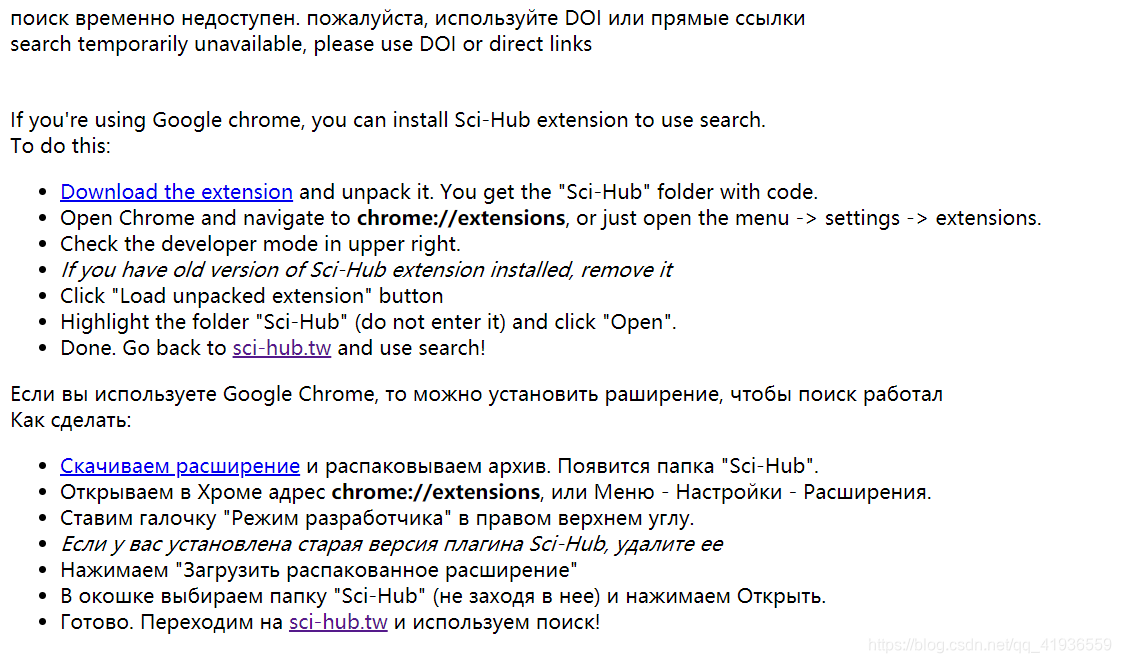

如果是下面的情形,应该是scihub里没有,或者名字打错了:

scihub下载太慢或者无法加载的问题

最新推荐文章于 2023-09-24 19:44:47 发布

步骤一:进入scihub网址

步骤二:搜索想查找的文章

步骤三:搜索页面出来后(比如等待加载的页面,或者无法加载pdf的页面),复制链接到迅雷

步骤四:点击左边的save,等待下载即可

然后就会冒出来迅雷的下载链接啦

如果是下面的情形,应该是scihub里没有,或者名字打错了:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?