摘要:

一个值得信赖的强化学习算法应该能够解决具有挑战性的现实世界问题,包括稳健地处理不确定性、满足安全约束以避免灾难性故障,以及在部署期间推广到看不见的场景。本研究旨在概述可信强化学习的这些主要观点,考虑到其在鲁棒性、安全性和普遍性方面的内在弱点。特别是,我们给出了严格的表述,对相应的方法进行了分类,并讨论了每个观点的基准。此外,我们提供了一个展望部分来激发有希望的未来方向,并简要讨论考虑到人类反馈的外部漏洞。我们希望这项调查能够将不同的研究线索汇集在一个统一的框架中,并提高强化学习的可信度。

CCS 概念: • 计算方法 → 强化学习;马尔可夫决策过程; • 安全和隐私 → 安全和隐私的社会方面; • 计算机系统组织→机器人; • 硬件→ 安全关键系统。

其他关键词和短语:可信强化学习、鲁棒强化学习、安全强化学习、可推广强化学习

1引言

凭借其解决世界上一些最紧迫问题的巨大潜力,强化学习 (RL) [173] 被应用于运输 [68]、制造 [133]、安全 [75]、医疗保健 [211] 和世界饥饿 [44] ].随着 RL 开始转向部署在现实世界的问题上,它的快速发展伴随着同样多的风险作为奖励 [3, 42, 161]。在消费者接受 RL 授权的服务之前,研究人员的任务是证明其创新的可信度

可信度旨在最大限度地发挥 AI 系统的优势,同时最大限度地降低其风险 [3]。它具有超出其字面意义的丰富含义,并激发了一个包含多个原则、要求和标准的综合框架 [3]。最近,在可信赖的 RL [2, 5, 48, 107, 108, 121, 129, 137, 140, 145, 148, 165, 171, 201] 领域取得了令人振奋的进展,这极大地促进了我们的理解RL 的内在漏洞和可信赖 RL 特定方面的潜在解决方案。很明显,迈向可信赖 RL 的下一次飞跃将需要对这些问题的挑战、现有可信赖 RL 方法的弱点和优势以及基于现有工作的可信赖 RL 范式转变的全面和基本理解。与传统机器学习 (ML) 中的可信度问题相比,RL 中的问题要复杂几个数量级,因为 RL 是一个包含多个马尔可夫决策过程 (MDP) 组件(观察、环境动力学、动作、和奖励)[173]。值得注意的是,这些组件可能会受到各种鲁棒性、安全性、泛化和安全问题的影响,这些问题在传统 ML 中已经或未被考虑过。更多静态部分(例如,观察)中的关注点可以在 ML 研究中找到它们的根源,而那些与系统的交互属性(例如,动作)更相关的部分是 RL 所独有的,并且很少被探索。此外,当将 RL 视为两个阶段(模型训练和模型部署)时,我们可以单独研究这两个阶段的弱点以及它们之间的联系

为了促进该领域的进步,在本文中,我们从三个方面对可信赖的 RL 进行了全面的调查,涉及四个 MDP 元素和两个阶段,包括 • 对扰动和不确定性的鲁棒性, • RL 的安全性以限制破坏性成本,以及 •泛化到域内和域外看不见的环境。

对于具有强互连的智能代理,通常同时需要这些要求。

我们以自动驾驶汽车(AVs)为例,具体说明可信度的三个方面。首先,AV 的观察很容易受到对手扰动相机或 LiDAR 输入的影响,训练 AV 时环境动态和奖励可能会中毒,执行器在执行已部署的良性策略时也可能被对手操纵。关于这两个阶段及其联系,在训练过程中,希望安全探索,这样汽车就不会撞车;在部署过程中,安全约束也被期望提交给遵守,以避免危险的结果。此外,需要从 AV 的训练环境到测试环境进行良好的泛化。 AV 应该在城市和不同的天气和季节之间进行概括。

尽管可信度存在这些相互关联的方面,但现有调查主要集中在有限的部分。 García 等人 [52]、Gu 等人 [62] 和 Brunke 等人 [25] 致力于安全强化学习,而 Moos 等人 [121] 和 Kirk 等人 [88] 分别专注于鲁棒性和泛化。他们通过为可信 RL 的一个方面提供具体描述来推进该领域,但缺乏对 RL 内在弱点的全面描述,正如我们上面所设想的那样。

在本次调查中,我们想为可信 RL 的三个方面提供一个统一的框架。对于每个方面,我们将 1) 阐明术语,2) 分析它们的内在漏洞,3) 介绍解决这些漏洞的方法,以及 4) 总结流行的基准测试。如图 1 所示,鲁棒性、安全性和泛化性与代理、环境、奖励和成本具有很强的相关性,这与 MDP 的组成部分相对应。为了在读者容易理解的范围内,我们将调查限制在 MDP 设置中。我们将我们的调查视为 RL 的内在可信方面,因为我们假设人类偏好以及代理和环境的设置是预先定义的。

在展望部分,我们将讨论内在和外在可信度之间的联系。特别是,我们将对四个基本问题进行展望。

如何证明和评估可信赖的强化学习?

• 可信度的不同方面之间的关系是什么?

• 如何与物理代理和环境共同设计可信赖的强化学习?

• 如何实现以人为本的可信强化学习设计?

我们希望这项调查能够将不同的研究线索汇集在一个统一的框架中,并激发新的研究,以全面了解可信赖的 RL 的内在方面。

调查的其余部分组织如下。从第 2 节到第 4 节,每一节都涉及可信度的一个方面。我们将在第 5 部分的调查之外解释我们对未来方向主要挑战的三个方面的展望。我们将在第 6 部分以 10 个要点结束调查。

2 抗扰动的鲁棒 RL

2.1 Overview

Robust RL 旨在在面对不确定性和对抗性攻击时确定性或统计性地提高算法的最坏情况性能。训练任务和测试任务之间的差异广泛存在。例如,在连续控制任务中,真实的物理参数可能与模拟中的物理参数不同,在自动驾驶场景中,周围的智能体可能有新的驾驶行为。这种差异激发了鲁棒 RL 的发展。此外,现实世界应用程序的安全关键特性使稳健性成为帮助避免灾难性故障的甚至重要的功能。人们对研究 RL 中的有效攻击和防御产生了浓厚的兴趣。可以在 [28、76、121] 中找到对这两个领域的详细评论。

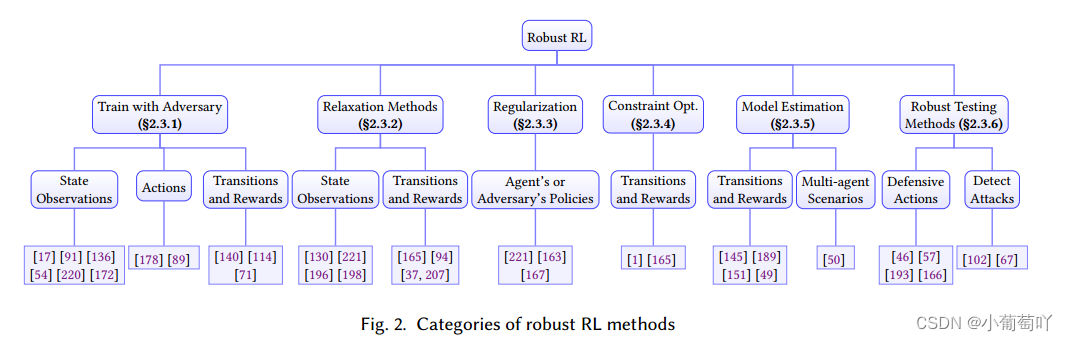

在本节中,我们首先在第 2 节中总结了稳健的 RL 公式。 2.2,在针对不同 MDP 组件的不确定性方面的鲁棒性,包括观察/状态、动作、转换和奖励。然后,我们在第 2 节中介绍了稳健的训练和测试方法。 2.3 提高对每个组件的不确定性或人为设计的攻击的鲁棒性。我们在图 2 中总结了稳健的 RL 方法。最后,我们在第 2.4 节中介绍了用于测试所提出的稳健 RL 算法的稳健性的应用程序和基准

2.2 鲁棒强化学习的问题表述

2.2.1 针对不确定状态观察的鲁棒 RL

大多数 Robust RL 方法旨在稳健地处理观察到的状态与实际状态之间的不匹配。

状态不确定性可能来自部分状态观察。由于传感器错误或传感器容量有限。一般来说,实际状态与状态观察之间的不匹配会降低策略的性能,甚至可能在安全关键情况下导致灾难性故障。针对状态观察不确定性的稳健 RL 旨在稳健地处理这种状态观察不匹配。让观察到的状态为 𝑠∼ ∈ S,作为动作生成 𝑎 ∼ 𝜋 (𝑠∼) 的输入。让实际状态为 𝑠 ∈ S 用于环境推出 𝑠 ′ ∼ 𝑃 (𝑠, 𝑎)。 Robust RL 旨在找到最优策略𝜋,在最坏的可能状态观察下实现最佳性能 [221]。

在多种设置中广泛研究了训练时对状态观察的攻击。 ATLA [220] 和 PA-AD [172] 考虑了 SA-MDP 框架下的最佳对手 [221],其目的是在

有界状态扰动。为了找到这个最优对手(即最优对抗状态扰动),ATLA [220] 建议训练一个对手,其动作空间是状态空间中的扰动集,而 PA-AD [172] 进一步解耦了寻找状态的问题扰动到寻找策略扰动加上找到实现最低价值策略的状态,从而解决大状态空间的挑战。特别是在多代理环境中,Gleave 等人 [54] 考虑了一种不同的威胁模型,在这种模型中,对手可以控制代理的对手。

他们建议通过训练对手的对抗性政策来制作自然的对抗性观察。 agent 的固定训练策略,从而根据经验实现对抗目标。与这些在原始任务中最小化累积奖励的工作不同,Tretschk 等人 [185] 试图最大化由对抗性奖励信号𝑟 adv 引导的对抗性累积奖励。假设白盒访问受过训练的代理,他们训练一个对抗性变压器网络 (ATN) [15] 以及受过训练的代理人在对抗性任务上产生扰动。

在测试时,为了将代理引诱到目标损坏的动作序列,Lin 等人 [101] 首先生成一个首选动作序列以通过规划算法引诱代理,然后制作导致计划动作的对抗状态扰动。每一步后都会动态调整动作顺序,以提高攻击的有效性。

此外,非靶向方法通过应用随机噪声来简单地干扰动作选择[91],或采用对抗性攻击(例如,FGSM [56]和CW攻击[26])来故意改变概率,从而在不同程度上有效动作选择(要么降低选择最佳动作的概率 [17, 72, 91],要么增加选择最差动作的概率 [101, 136])。 Behzadan 和 Munir [16] 提出了策略归纳攻击,其中代理 Q 网络与目标代理 Q 网络一起训练,对抗状态观察是 w.r.t 计算的。代理模型,然后利用对抗性示例的可转移性来毒害目标网络。

2.2.2 针对不确定行为的鲁棒 RL

2.2.3 针对不确定的转换和奖励的鲁棒 RL

由于模拟到真实的差距、测试域的非平稳性、训练和测试任务分布的变化,或部分可观察到的环境转换和奖励,训练和测试环境之间的差异广泛存在。环境差异通常反映在不同的过渡和奖励上。因此,Robust RL against uncertainty transitions and rewards 旨在稳健地处理这种环境不匹配。在这种情况下,不确定变量遵循 ![]()

环境差异。我们总结了两种与环境差异相关的主流稳健公式:(1) 假设转换和奖励函数不确定的稳健 MDP 公式,以及 (2) 假设用于生成转换和奖励的潜在分布不确定的分布稳健 MDP 公式.相比之下,分布稳健的公式对可能的转换和奖励的先验分布信息进行编码,因此可能有助于平衡性能和稳健性。众所周知,分布稳健的 MDP 公式通过平衡标称性能和最坏情况性能来帮助生成不太保守的策略 [166、201]。在 [200] 中可以找到优化名义分布和最坏情况分布之间的权衡。

分布稳健的 MDP。相比之下,分布稳健的 MDP (DR-MDP) 在 (𝑃, 𝑟) 上假设了额外的分布信息。 DR-MDP 对 𝜇 设置了约束,其中 (𝑃, 𝑟) ∼ 𝜇。形式上,转移概率 𝑝∼ 和奖励 𝑟∼ 是未知参数,服从模糊集 F 内的联合概率分布 𝜇。与稳健的 MDP 设置类似,令 𝑇 为规划范围。更具体地说,DR-MDP 的目标是

除了矩形假设之外,差异度量是定义模糊集 F 的另一个重要设置。可能的选择包括 Wasserstein 距离 [1, 37, 94, 165],KL 散度 [115, 167] 或矩 [29, 201, 207, 214]。在[144]中对歧义集进行了全面的回顾。选择合适的歧义集结构并使用流数据动态更新歧义集仍然是悬而未决的问题。

除了 MDP 公式之外,[127] 中的稳健和分布式稳健设置可以进一步扩展到具有部分观察的设置,例如 [132、146、156] 中的稳健 POMDP 公式和 [127] 中的分布式稳健 POMDP 公式。

对奖励的对抗性攻击。对奖励的对抗性攻击会扭曲每个时间步的奖励,以引诱代理学习错误的策略。设腐败奖励为𝑟∼ = 𝜈 (𝑟),其中𝜈 体现了奖励中毒策略 [73、112、223] 或等效于腐败奖励 MDP 公式 [47、222] 中的奖励腐败函数。

Huang 和 Zhu [73] 分析了伪造的奖励(成本)信号对 Q 学习算法收敛的影响。

作者提出了一个关于伪造成本的稳健区域,在该区域中,对手将不断失败,并提供代理将学习目标对抗策略的条件。同样,Zhang 等人 [223] 根据攻击预算将奖励中毒攻击分为三类。必须达到一个阈值才能使攻击变得可行。之后进一步增加阈值会产生另外两类:非自适应攻击和自适应攻击[223]。

2.3 稳健强化学习的方法论

在本节中,一旦在上一节中定义了稳健目标,我们将总结常用的训练方法。特别是,人们希望在对抗训练中解决以下问题:

(1)如何设置对手的目标?

(2) 如何通过松弛使对抗训练在计算上可行?

(3) 如何规范对手的能力,使政策不至于过于保守?我们将在下面的章节中介绍相应的方法。

2.3.1 与对手的鲁棒训练对抗训练[56, 113] 被认为是传统监督学习任务中训练时间防御的最有效方法之一。在本小节中,我们将讨论一种对抗性训练策略,即使用局部对抗性攻击获得的损失下限(累积奖励的上限)训练 RL 代理。本地攻击可以是未参数化攻击或来自参数化对手代理的攻击。与对手代理的训练自然可以表述为对手代理和 RL 代理之间的零和博弈 [140]

状态观察针对状态观察不确定性的鲁棒 RL 直接向 RL 代理的状态观察或梯度更新添加扰动。此类方法基于 Q 函数来量化状态-动作对的最优性并搜索最可能的扰动。在具有离散动作和基于图像的观察的 Atari Pong 环境中,对嘈杂观察和 FGSM 攻击的对抗训练提高了弹性

DQN [17] 和 A3C 算法 [91]。 Pattanaik 等人没有存储基于 FGSM 攻击的扰动图像

[136] 建议存储受更强的基于梯度的攻击扰动的状态,这有助于提高 DQN 和 DDPG 对动态不确定性的鲁棒性。与 [91] 中的 FSGM 攻击相比,FSGM 攻击降低了在给定当前状态下选择最佳动作的概率,[136] 中基于梯度的攻击鼓励了选择最差动作的概率。除了添加未参数化的扰动之外,还可以有一个参数化的对手代理来扰乱状态观察并最小化 RL 代理的累积奖励。对手代理可以与 RL 代理并行训练 [172、220],也可以是预先训练的对手 [54]

行动 现有的针对行动扰动的对抗性训练策略主要集中在局部对抗性攻击 [89, 178]。他们采用鲁棒 RL 的博弈论公式,将 RL 智能体视为针对敌方智能体训练的主角智能体。例如,Tessler 等人 [178] 提出了两个对动作不确定性的鲁棒性标准:概率动作鲁棒 MDP (PR-MDP) 标准和噪声动作鲁棒 MDP (NR-MDP) 标准,它们考虑了偶尔的对抗性动作,以及分别是持续的对抗性扰动。他们通过找到所提出的 MDP 公式的最佳解决方案来制定稳健的学习问题,并为表格设置中的两个标准开发策略迭代方法。在深度 RL 设置中,Tessler 等人 [178] 提出了一种稳健的深度确定性策略梯度算法来训练对手代理和主角代理。与 PR-MDP 设置类似,Klima 等人 [89] 引入了一个对手代理来缩小主角代理在关键领域的行动空间。他们建立在 TD 学习的基础上,TD 错误是主角和对手智能体的 Q 值的凸组合

转换和奖励稳健的对抗性 RL (RARL) [140] 是处理环境不确定性的最流行的框架之一。 RARL 将环境差异建模为对手玩家施加的额外力量/干扰。它将策略学习制定为零和、极小极大目标,并建议交替优化对手和主角的策略,直到收敛。这可以被视为针对最坏的可能情况优化条件风险值 (CVaR) [176]。当代工作 ARPL [114] 在训练期间利用动态噪声、过程噪声或观察噪声方面的对抗性示例的主动计算,以支持训练跨域传输的稳健策略。该方法通过从动态生成的自然发生的对抗场景中学习来获得稳健性,这些场景不断暴露代理人决策中的缺陷。

最近,Huang 等人 [71] 提出了 RRL-stack 公式,它将鲁棒 RL 视为一般和 Stackelberg 游戏,主角代理作为领导者。,对手代理作为跟随者。 RRL-stack 自然地编码了顺序性质,并为稳健训练提供了通用公式。使用提出的 Stackelberg 策略梯度算法,RRL 堆栈公式在机器人和自动驾驶场景中与 RARL 相比具有更好的训练稳定性

2.3.2 稳健的放松训练2.3.1 假设一个对手代理,另一行工作训练 RL 代理具有损失的上限(累积奖励的下限),可以通过松弛方法获得。

状态观察 可以在对抗性扰动下推导出累积奖励的下限,并直接最大化下限而不是标准的 RL 目标。例如,Oikarinen 等人 [130] 使用导致最大训练损失的对抗性示例构建损失。 Zhang 等人 [221] 提出了状态对抗 MDP,其中扰动是对状态观察的。给定一个策略 𝜋,他们利用神经网络的凸松弛,推导出非对抗性 MDP 的值与针对最佳对手的值之间的性能下降上限。性能下降上限通常等同于鲁棒性保证,并且与可证明的鲁棒 RL 文献 [196、198] 密切相关。

转换和奖励 通过利用歧义集的性质,可以得出环境转换差异下的政策绩效差距。 Lecarpentier 和 Rachelson [94] 定义了一种新颖的非固定 MDP(NS-MDP),它假设过渡动力学和奖励函数随时间缓慢变化。在数学上,他们将演化率与 Lipschitz 连续性联系起来,并使用 Wasserstein 距离作为度量标准 Mankowitz 等人 [115] 旨在提高最先进的连续控制 RL 算法的稳健性,并提出最大 a- 的稳健版本后验策略优化 (R-MPO)。他们利用领域知识来选择参数来扰动和定义训练和测试中不确定性集的参数范围。

Yang [207] 利用基于 Wasserstein 的歧义集和有限状态动作空间,利用 Kantorovich 对偶性构造内值最小化问题的下界来求解 Bellman 方程。 [37] 中提出的 Wasserstein 分布式鲁棒 MDP (DRWMDP) 设置与 [207] 有一些相似之处。 Derman 和 Mannor [37] 建立了 DRWMDP 和正则化之间的联系,并提供了一个正则化值函数下界,以保证 w.r.t. 的稳健性。线性近似情况下的 Wasserstein 球。除了基于 Wasserstein 的歧义集,[201] 中的歧义集由一系列嵌套集表示,每个集都与一个置信度相关联。 [214] 后来将 [201] 扩展到更一般的不确定性集公式,可以对嵌套集和不相交集进行建模。 [29] 将 [214] 中的结果概括为一类新的不确定性集,其中基于 Wasserstein 的歧义集和基于一般矩的歧义集作为两个特例。

2.3.3 具有正则化的鲁棒训练 在 Robust RL 中,可以将正则化器应用于策略以增强鲁棒性。正则化器可以帮助鼓励学习策略的平滑性,例如,min𝜃 max𝑠 max𝑠∼ 𝐷(𝜋 (·|𝑠), 𝜋 (·|𝑠∼))。因此,它可以防止政策在状态观察扰动下发生剧烈变化 [163、221]。基于正则化的方法 [61、69、206] 也在标准神经网络训练中进行了研究,以提高训练模型的稳健性。除了策略平滑度之外,Smirnova 等人 [167] 还建议对 RL 代理的策略设置一个约束,以确保在学习过程中进行安全探索。他们提出了一种分布稳健的策略迭代方案,并采用了一种自适应的基于 KL 的不确定性集,其不确定性水平与样本大小相关。 Huang 等人 [71] 提出在给定对手当前环境的情况下,使用主角的最高可能回报来自适应地规范对手的策略。正规化的对手会产生具有挑战性但可解决的环境,以提高主角代理的稳健性。

2.3.4 带约束优化的鲁棒训练 有了明确定义的歧义集,可以使用约束优化中的技术解决等式(4)中的内部最小化问题 [1, 165]。使用 Wasserstein 歧义集,Sinha 等人 [165] 提出了一个案例研究,考虑深度 Q 学习的分布鲁棒性,其中 Q 值由超参数化前馈神经网络建模。使用拉格朗日惩罚公式,当惩罚足够大时,它可以解决梯度下降对过渡动力学的最坏扰动。 Abdullah 等人 [1] 提出了 Wasserstein Robust RL (WR2L),它考虑了一种 RL 设置,假设环境对手在平均 Wasserstein 球 P0 内添加扰动。 WR2L 对动力学参数进行梯度上升,直到(几乎)收敛。为了保证更新的动力学参数满足模糊集约束,WR2L 基于蒙特卡洛估计计算 Wasserstein 距离,该估计可扩展到高维非凸或非凹设置。

2.3.5 使用模型估计转换进行稳健训练。

集成学习方法旨在通过利用一组学习来提高预测性能

算法或模型。集成学习与 EPOpt 中的对抗训练相结合 [145]。 EPOpt 在两个过程之间迭代:

(1) 使用模型集合对源域建模并为源域找到稳健的策略,以及

(2) 根据从目标域收集的数据改进模型集合。

奖励。 Wang 等人 [189] 考虑有限奖励集的设置,并通过混淆矩阵对奖励腐败进行建模。通过使用聚合奖励动态改进混淆矩阵的估计,他们设法接近真实的奖励信号。 Romoff 等人 [151] 建议在随机奖励损坏的情况下使用估计器进行奖励估计。基本上,他们同时学习价值函数和奖励函数。在更新价值估计时,他们利用估计奖励而不是采样奖励,减少传播到价值函数的方差。 AIRL [49] 是一种基于对抗性学习的逆向对抗性学习算法,旨在通过使用仅限于奖励近似器和整形项的状态-动作级别鉴别器来学习对动态变化不变的分离奖励函数。

多代理场景。 Gallego 等人 [50] 通过干扰对手来增强 MDP,并引入受威胁的 MDP (TMDP),明确地模拟代理对对手策略的信念。采用 level-𝑘 方案 [170],使代理人和对手交替模拟彼此的信念,从而成为更高级别的玩家。与对手比赛时,已证明 2 级学习者明显优于独立学习者(不考虑对手)。

2.3.6 鲁棒测试方法 借助预训练策略,鲁棒测试方法旨在增强代理在部署期间的鲁棒性。我们确定了两种类型的测试时间稳健方法,包括(1)被动选择防御动作和(2)主动检测潜在攻击。

选择防御动作。在测试时,提高鲁棒性的一种自然方法是在最坏的扰动下选择动作。考虑到对状态观察的潜在扰动,CARRL [46] 建议通过将最差观察传递给经过训练的 DNN 模型来选择最差观察扰动下的动作。它基于与模型架构和权重相关的神经网络验证方法计算 Q 值的下限。其他方法基于神经网络验证 [57、193] 在最坏情况下的扰动下得出 Q 值的下限。除了状态的不确定性之外,Sinha 等人 [166] 还考虑了测试时对手行为信念的不确定性。他们提出了一种分布鲁棒的强盗优化方法,并动态调整风险规避水平。因此,RL 代理选择最优策略,假设歧义集中最坏的可能信念。

检测潜在的攻击。与上述专门为实现动作次优而设计的方法相比,直接检测对抗性示例并根据恢复的状态或奖励信息预测动作是相当通用的。这种方法首先检测对抗性攻击和/或预测良性状态/奖励函数,然后根据已经训练好的模型提供行动建议。由于状态观察的不确定性,预测可以基于帧预测模型(视觉预见模块 [102])或元学习层次结构 MLAH [67] 中的主策略。

2.4 应用基准和资源

深度鲁棒 RL 算法在 MuJoCo 控制任务 [184] 中得到广泛测试,训练和测试任务之间存在物理参数差异。例如,2D Hopper 基准测试 [45] 和 HalfCheetah 基准测试 [191]

根据高斯分布改变代理的质量、地面摩擦力、关节阻尼和电枢。这两个基准后来在 [145] 中被采用。 Pinto 等人 [140] 后来建议在更广泛的任务中进行测试,包括具有不同质量和摩擦力的 InvertedPendulum、HalfCheetah、Swimmer、Hopper、Walker2d 和 Ant。除了基于 MuJoCo 的基准之外,还有基于 OpenAI Gym 环境的稳健基准 [24]。例如,Huang 等人 [71] 建议在具有不同动作延迟的 LunarLander 基准测试中进行测试。 Mankowitz 等人 [115] 介绍了灵巧手部任务的实验,旨在使用阴影手域将立方体旋转到目标方向。稳健的 RL 方法也在 Atari 游戏中进行了测试,其中向图像输入添加了噪声,例如 [17、91]。

除了机器人连续控制任务和模拟游戏之外,鲁棒 RL 还在移动机器人任务和自动驾驶场景中进行了测试。 Liu 等人 [108] 提出了一个安全可靠的基准测试,其中包含基于 Bullet safety gym [60] 环境的移动机器人任务。 Jaafra 等人 [77] 建议在 CARLA 模拟器 [41] 中测试不同条件,包括交通密度,如动态物体的数量,以及视觉效果,如天气和闪电条件。 Huang 等人 [71] 提出了一种基于具有不同周围车辆初始位置的高速公路环境 [97] 的高速公路合并基准

3 安全学习以避免毁灭性成本

3.1 概述

在将它们部署到现实世界的安全关键应用程序(例如自动驾驶汽车)时,安全也是另一个主要问题。传统的强化学习仅旨在最大化从环境中获得的任务奖励,缺乏满足安全约束的保证。安全策略应明确考虑训练期间的安全约束,并防止 RL 代理造成破坏性成本或处于危险状态。例如,如果将 RL 算法部署在真实的机器人手臂上,安全约束将是避免撞到易碎物体和周围可能破坏贵重财产或造成伤害的人。同样,自动驾驶应用程序中的 RL 代理应遵守交通规则并避免与周围障碍物发生碰撞。因此,为现实世界的应用开发安全的强化学习算法非常重要,这些算法可以让它们在满足某些安全约束的同时完成任务。

安全强化学习,也称为约束强化学习,旨在学习在满足安全约束的同时最大化预期任务奖励的策略。根据安全要求和训练要求,safe RL 有不同的表述。在安全要求方面,有轨迹安全约束和状态安全约束。从训练需求的角度来看,我们可以将安全 RL 分为两类:安全部署和安全探索,其中前者旨在在模型训练后安全地行动,但训练过程中可能会违反约束,后者指的是在训练过程中提供安全保障,使整个训练过程能够在不引起灾难性不安全行为的情况下完成。

请注意,在 RL 设置中,智能体需要从失败中学习,在安全 RL 设置中也是如此。有人可能会争辩说,我们应该始终通过领域知识而不是主动学习来避免任何安全关键故障。然而,在本次调查中,我们发现在很多情况下,无法准确描述环境风险。这也是为什么我们要既注意安全部署,又注意安全探索来管理风险的原因。在数学上,结果被描述为安全约束。在下一节中,我们扩展传统的 MDP 来对它们进行建模。

3.2 安全强化学习的问题表述

安全 RL 通常在受约束的马尔可夫决策过程 (CMDP) [6] 框架下建模,其中代理通过辅助安全约束违反成本的限制来强制执行。 CMDP 由元组 (S, A, 𝑅, 𝑃,𝛾, 𝜌0,𝐶) 定义,其中 S 是状态空间,A 是动作空间,𝑅 : S × A × S ↦→ R 是奖励函数, 𝑃 : S×A ↦→ Δ(S) 是转换函数,𝛾 是折扣因子,𝜌0 : S ↦→ Δ(S) 是初始状态的分布。前 6 个元素与原始 MDP 相同。最后一个元素 𝐶 = {𝑐 𝑖 : S × A × S ↦→ R≥0,𝑖 = 1, ...,𝑚} 是 CMDP 独有的,这是一组违反 𝑚 安全约束的成本。为简单起见,我们在以下定义中只考虑一个约束𝑐,尽管它们也可以扩展到多个约束。

我们将𝑉 𝜋 𝑟 (𝜌0) = E𝜋 [ 𝑡 𝛾 𝑡 𝑟(𝑠𝑡 , 𝑎𝑡 , 𝑠𝑡+1)] 表示为奖励价值函数,即策略下的预期累积奖励𝜋 ∈ Π : S ↦→ Δ( A) 和初始状态分布𝜌0。同样,我们将 𝑉 𝜋 𝑐 (𝜌0) = E𝜋 [ 𝑡 𝑐(𝑠𝑡 , 𝑎𝑡 , 𝑠𝑡+1)] 表示为成本值函数。安全 RL 问题有多种表述和定义,具体取决于安全要求的级别,但它们共享相同的原则:在满足约束要求的同时最大化任务性能。我们首先介绍最常用的轨迹安全约束。

3.3 安全强化学习方法

在本节中,我们从优化、规划和控制理论等不同角度

述了如何解决安全强化学习问题。

3.3.1 基于原始对偶的方法原始对偶框架通常用于解决约束优化问题,它引入了一个额外的拉格朗日乘数𝜆来惩罚约束违规并产生加权优化目标:𝐿(𝜋,𝜆)= 𝑉 𝜋 𝑟 (𝜇0) + 𝜆(𝜅 −𝑉 𝜋 𝑐 (𝜇0)). (8) 手动选择 𝜆 是拉格朗日对偶问题的直接解决方案,在早期研究中得到应用 [20, 22]。然而,手动转动 𝜆 具有挑战性并且可能导致次优解决方案,因为约束满足性能对 𝜆 很敏感。最近的工作侧重于自适应调整乘数,以便可以根据策略性能和奖励规模动态调整约束违反的惩罚权重。我们将首先介绍基于拉格朗日的方法,这是学习拉格朗日乘子最常用的框架,然后介绍其他类型的方法,这些方法利用额外的约束、近似或变分推理来克服基于拉格朗日的方法的局限性

基于拉格朗日的方法。作为一个简单有效的框架,基于拉格朗日的方法通过解决以下最小-最大优化问题依次更新原始变量(即策略参数)和对偶变量(即拉格朗日乘数)

我们将 𝜃 表示为策略参数。在通过任何不受约束的强化学习算法最大化 𝜃 和最小化拉格朗日乘数 𝜆 之间交替产生一系列基于拉格朗日的方法来解决安全部署问题 [208]。 Chow 等人 [31] 提出 PDO 通过基于奖励和成本价值函数𝑉𝜋𝜃𝑟(𝜇0)和𝐽𝑐(𝜋𝜃)执行梯度下降来更新原始参数和对偶变量。 Liang 等人 [100] 通过结合 𝑉 𝜋𝜃 𝑐 (𝜇0) 的离策略评估来加速对偶变量学习过程,以学习对偶问题中的拉格朗日乘数,同时保持策略参数原始更新的策略训练. Tessler 等人 [179] 重新制定拉格朗日对偶问题,并在每个过渡步骤中将成本直接合并到奖励中以指导政策,这也可以处理均值约束。

Paternain 等人 [135] 证明在温和假设下 CMDP 的拉格朗日对偶问题中存在强对偶性,原始对偶算法可以收敛到鞍点而没有对偶性间隙。 Stooke 等人 [171] 观察到约束函数和拉格朗日乘子之间的大相移会导致不稳定的训练和训练曲线的振荡行为,因此他们将 PID 控制的思想应用于双变量学习阶段,使得可以减轻振荡和过冲行为。最近的工作也采用了增广拉格朗日乘数,可以实现优异的安全性能[13]。基于拉格朗日的方法是一种用于学习约束满足策略的通用算法,可以很容易地合并到经典的 RL 方法中。然而,近似求解最小化(对偶问题)会导致每次迭代都出现次优对偶变量,并且涉及 𝜆 的非平稳成本惩罚项将使原始问题中的策略梯度步骤难以优化。

双变量的凸优化。为了解决优化过程中的性能不稳定性,CPO [2] 扩展了 TRPO [160] 中的思想,即在策略更新过程中添加额外的信任域约束,并提出在通过二次逼近策略参数空间后通过凸优化求解对偶变量。阶泰勒展开。与 TRPO 类似,它也会在违反约束时通过线搜索将更新策略协调到安全集。 Yu 等人 [213] 还提出用近似凸二次函数代替非凸约束目标,从而将原始问题转化为一系列代理凸约束优化问题。虽然可以通过凸优化有效地求解对偶变量,但在实践中,近似误差会导致约束满足性能不佳。 Liu 等人 [107] 进一步提出了一种基于变分推理的方法——CVPO——将策略学习分解为具有非参数变分分布的凸优化阶段和监督学习阶段以适应参数化策略。 CVPO 通过一种新颖的 Expectation-Maximization 风格解决了安全 RL 问题,在策略优化过程中自然地结合了约束条件,从而为学习到的策略提供了最优性和鲁棒性保证。

基于投影。另一种方法是在原始对偶算法的基础上增加一个投影步骤,以促进策略学习。 Zhang 等人 [224] 提出了一种具有信赖域约束的一阶梯度下降法,该方法首先通过封闭形式的解计算最优更新策略,然后将其投影回参数化策略空间,与其他信赖域相比,计算效率更高方法。 PCPO [209] 首先忽略成本并解决无约束的 RL,然后将即时策略投射到安全集中,这是通过成本约束的近似获得的。 Yang 等人 [210] 添加了一个新步骤,将即时策略投影到基线策略的邻居集中以加速学习。尽管这些方法有效地提高了训练过程中的安全性,但约束违反由于神经网络参数化值函数的外推误差和安全集估计中的逼近误差,s仍然几乎是不可避免的

3.3.2 不确定性感知方法我们已经介绍了一系列从优化角度解决安全RL问题的基于拉格朗日的方法,现在我们提出从数据收集或动作采样角度考虑的方法。一些方法不是根据策略输出直接与环境交互,而是明确考虑不确定性估计以最小化约束违规。我们通常将它们分为两类:基于置信上限的方法和基于动态不确定性的方法,其中前者通常是无模型的,而后者通常是基于模型的方法。

置信上限 (UCB)。基于 UCB 的方法利用不确定性估计来平衡训练期间的探索和开发,并且通常用于有效探索表格环境并违反有界约束。 Singh 等人 [164] 和 Efroni 等人 [43] 将 UCB 应用于奖励、成本和转换函数,以加速表格 CMDP 的采样;他们的方法通过线性程序或其他原始对偶优化方法来约束奖励后悔和成本约束违反。与线性约束不同,Brantley 等人 [23] 提出了基于 UCB 的规划来处理 episodic tabular CMDP 的凹凸和硬约束设置。丁等

[38] 将表格约束 RL 扩展到具有线性转换内核的 CMDP,并在函数逼近设置中提供了一种可证明有效的方法。

动力学不确定性。 Safe MPC [90] 利用高斯过程来估计动态不确定性并安全地探索环境以学习动态。 SAVED [181] 和 RCE [109] 都使用神经网络集合作为动力学模型来估计动力学预测不确定性并通过模型预测控制方式解决约束优化问题,其中前者制定机会约束以确保安全从概率的角度来看,而后者考虑的是最坏的不安全情况。 CASRL [27] 通过将非平稳干扰建模为概率潜在变量,进一步将先前的方法从静止环境扩展到非静止环境。

3.3.3 利用先验知识进行安全探索与以往在政策训练后关注安全性的方法不同,一些研究人员在训练过程中也关心安全性,即在探索过程中提供一定的安全保证。显然,在没有任何系统、安全约束和环境的先验知识的情况下,很难保证策略在训练期间始终安全某些安全约束。因此,一些研究利用特定任务的先验知识或领域知识在某些假设下实现安全探索。其中的大多数方法都借鉴了控制界的思想,例如 Lyapunov 理论和控制势垒函数,以利用系统动力学的先验知识。另一种方法利用安全约束结构来实现安全探索。

基于李雅普诺夫的方法:李雅普诺夫理论可以为控制系统的稳定性和安全性提供有用的见解。在控制理论中,安全性通常通过可以通过李雅普诺夫函数计算的吸引力区域来定义。使用 Lyapunov 函数的关键思想是显示系统的稳定性,这类似于显示梯度下降在严格拟凸函数上的稳定性。如果可以证明将策略和动力学应用于状态可以导致 Lyapunov 函数的值严格变小,那么状态最终会收敛到原点处的平衡点。 Berkenkamp 等人 [19] 利用这一原理在学习期间通过动态和策略类的 Lipschitz 连续性假设实现安全探索。 Richards 等人 [150] 通过构建神经网络 Lyapunov 函数进一步扩展了之前的工作。建议的安全培训

算法可以使安全证书适应状态空间中最大安全区域的形状,同时仅依赖于动力学输入和输出的知识,而不是任何特定的模型结构。与限制探索空间相反,Chow 等人 [32] 提出了一种基于 Lyapunov 的安全策略梯度算法来解决具有未知动力学和约束的约束优化问题。

基于控制障碍函数的方法:控制障碍函数是控制理论中的另一个有用工具,它提供了一个连续的函数来惩罚不安全状态或无限成本的行为。 Li 和 Belta [99] 提出了一种具有 Lyapunov 函数和控制屏障函数的时间逻辑引导方法来保护策略探索和部署,它允许用户以不同形式和不同级别指定任务目标和约束。 Cheng 等人 [30] 提出了一种控制器架构,它结合了 (1) 基于 RL 的无模型控制器与 (2) 利用控制屏障函数 (CBF) 的基于模型的控制器和 (3) 未知系统动态的在线学习,以确保学习过程中的安全。所提出的框架利用 RL 算法的成功来学习高性能控制器,而基于 CBF 的控制器既保证安全又通过约束可探索策略集来指导学习过程。

后处理安全层:后处理安全层是另一种保证安全探索的方法。它纠正了策略产生的所有不安全行为并确保状态安全,这仅在预期或累积约束下超过了其他安全的 RL 方法。 Pham 等人 [139] 提出了一个优化层(OptLayer)来计算最接近原始不安全动作的安全动作。 OptLayer 由一个完整的二次求解器组成,它将通过前向传播对每个不安全的动作运行迭代内点法。安全层 [35] 为类似的优化目标提供了一种封闭形式的解决方案,并通过假设每次最多有一个约束处于活动状态来有效地简化计算。尽管这些方法在某些环境中获得了零约束违反,但其安全保证依赖于单步状态转移的精确预测,因此仅适用于线性系统或其他动力学相对简单的系统。 Peng 等人 [138] 提出当动作远离专家时,使用安全的专家策略来指导学习策略。 Yu 等人 [212] 提出通过从重播缓冲区同时学习安全编辑器策略来执行动作校正,这可以实现有效的离策略训练。

形式化方法:形式化验证提供了一种为控制系统提供安全性的严格方法。时间逻辑是评估系统时间行为的常用形式化方法,例如机器人的多模态感知信息。用户可以将他们的领域知识提供给以数学方式、精确且明确地描述的时间逻辑规范,以便可以正式定义系统的行为。

Li 和 Belta [99]、Liu 等人 [105] 提出了一种时序逻辑引导的强化学习算法来实现安全探索。拟议的框架允许用户以不同的数学形式和不同的层次指定任务目标和约束。 Puranic 等人 [142] 还利用信号时间逻辑来学习控制策略,同时满足预定义的安全要求

3.3.4 其他方法也有一些研究从其他角度解决安全强化学习问题。 Mehta 等人 [117] 引入了一种课程学习结构,在安全教师的监督下学习安全策略,该策略可以在代理违反约束时引导其返回安全区。 Srinivasan 等人 [169] 预训练安全评论家来估计安全约束策略的未来失败概率,然后使用学习到的安全预防措施将第一阶段策略微调到目标任务。 Turchetta 等人 [186] 提出了一种自适应监督器,通过使用可学习的策略选择和激活重置控制器来防止代理采取危险的策略。 Thananjeyan 等人 [180] 建议在策略训练之前从离线数据中学习约束违反区域,并从中恢复代理

通过使用单独的恢复策略将不安全状态转换为安全区域。 Sootla 等人 [168] 通过增加状态空间来包裹环境,使得修改后的 MDP 可以通过任何 RL 算法来解决,并且几乎可以肯定地实现安全性能。

3.4 基准和资源安全的 RL 任务和环境。 AI Safety Gridworlds 环境 [96] 为表格安全 RL 算法提供了一个测试平台。 Safety Gym [148] 是一个基于 Mujoco 的安全 RL 环境,它提供了几个不同难度级别的高维连续控制任务。 Safety Gym 在安全 RL 社区备受关注,已成为安全 RL 最流行的公共基准之一。 Bullet Safety Gym [60] 是一种基于 PyBullet 模拟引擎的安全健身房变体,它提供了更多的机器人和安全的 RL 任务,而 Safe Control Gym [217] 提供了几个经典的基于控制的环境。

安全的 RL 算法资源。 Safety Gym [148] 提供了几种受约束的深度 RL 算法来建立未来工作可以建立的基线,以及 Bullet Safety Gym [60]。 SafePO [81] 是一种公共安全策略优化算法基准,它提供了大量基于策略的无模型安全 RL 方法实现。

4 强化学习中的泛化 4.1 概述 RL 中的泛化侧重于设计算法以生成可以迁移或适应各种环境的策略,而不会过度适应训练环境。此功能对于 RL 代理的实际部署至关重要,因为测试时的环境通常与训练环境不同或本质上是动态的。有几项现有调查根据其方法对 RL 泛化研究进行分类 [88、188、225]。然而,在本次调查中,我们采用不同的方法根据他们的评价差异进行分类。

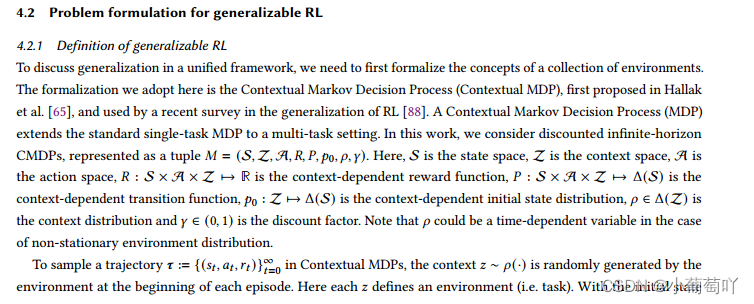

本节的结构如下:我们首先讨论上下文 MDP 的形式化,在第 4.2.1 节中,可泛化 RL 的定义基于该上下文 MDP。然后我们分别在 4.2.2 和 4.2.3 节中描述了评估变化的两个维度。最后,我们在 4.3 节讨论了可泛化 RL 的方法分类

𝑠0 ∼ 𝑝0 (· | 𝑧),在每个时间步长 𝑡,代理遵循策略 𝜋 选择一个动作 𝑎𝑡 ∼ 𝜋 (𝑠𝑡) 并获得奖励 𝑅(𝑠𝑡,𝑎𝑡,𝑧)。然后环境过渡到下一个状态𝑠𝑡+1∼𝑃 (· | 𝑠𝑡, 𝑎𝑡, 𝑧)。在某些特殊情况下,𝑧 在每个时间步都被采样,因此它会在整个情节中发生变化。

请注意,对于本次调查中研究的大多数作品,我们并未强调状态与观察之间的区别。然而,每当评估的重点是针对观察的明显变化而不是环境的潜在状态的泛化时,我们都会尝试引入上下文相关的发射函数𝑜 = O(𝑠|𝑧)。例子只是在机器人操作任务 [66] 中改变物体的颜色,或者在像素观察 [219] 的控制任务中改变背景干扰物。随着上下文 MDP 的形式化,我们已准备好定义泛化任务。

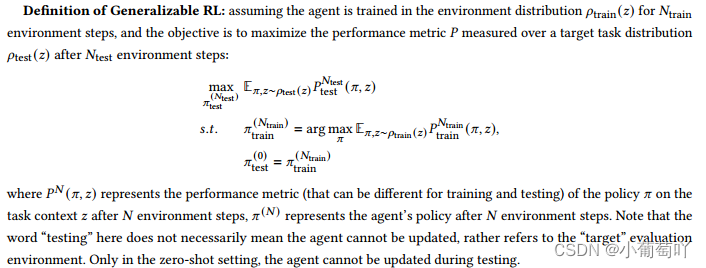

其中 𝑃 𝑁 (𝜋, 𝑧) 表示在 𝑁 环境步骤后任务上下文 𝑧 上策略 𝜋 的性能指标(训练和测试可能不同),𝜋 (𝑁 ) 表示代理在 𝑁 环境步骤后的策略。请注意,这里的“测试”一词并不一定意味着代理不能更新,而是指“目标”评估环境。只有在零样本设置中,代理才能在测试期间更新。

4.2.2 训练和测试分布之间的关系在本节中,我们将描述训练分布𝜌train(𝑧)和测试分布𝜌test(𝑧)之间关系的分类。这里我们分为三类:IID、OOD 和非平稳。

独立相同分布 (IID):训练和测试环境来自同一分布,即 𝜌train(𝑧) = 𝜌test(𝑧)。请注意,虽然我们描述的是分布之间的关系,但 RL 代理通常是在从分布中抽取的一组样本 MDP 上进行训练或测试的。因此,即使训练和测试来自相同的分布,这仍然是一个重要的问题,因为代理在训练期间可能永远不会经历完全相同的环境。定性地,在训练期间看到的不同上下文数量较少,IID 泛化变得更加困难,因为训练环境是稀疏采样的并且不能很好地代表真实分布。

分布外 (OOD)(固定):训练和测试环境来自不同的分布,即 𝜌train(𝑧) ≠ 𝜌test(𝑧)。这种不匹配可能是由多种原因造成的。例如,确切的测试分布未知或难以建模。研究 OOD 泛化的动机之一是实现 Sim-to-Real 迁移。由于 RL 的数据效率低,通常的做法是在模拟器中训练代理,然后将代理转移到物理世界。然而,即使是最先进的模拟器也无法完美地捕捉真实世界,模拟环境与真实环境之间的不匹配可能会在部署过程中导致灾难性的失败。另一个动机是组合泛化,其中测试上下文独立地采用在训练期间看到的值,但在看不见的组合中。例如,在训练期间,代理已经看到上下文组合 (𝑎0, 𝑏0)、(𝑎0, 𝑏1)、(𝑎1, 𝑏0),同时在 (𝑎1, 𝑏1) 上进行测试。

表 1. 可泛化 RL 的分类。每行代表评估期间 MDP 组件的变化,每列代表评估期间的分布变化。我们使用颜色来表示可泛化 RL 的不同方法。红色:通过环境设计概括;蓝色:通过在线适应进行概括;绿色:通过系统学习进行概括。如果一种方法使用两种或多种方法,它将用相应的颜色着色。

非平稳:测试环境来自时变的非平稳分布。尽管 OOD 和非平稳之间存在一些重叠,但归类为非平稳的研究侧重于明确处理非平稳性,即终身或连续 RL [182]。在此设置中,存在一个(通常是无限且未知的)测试分布序列,{𝜌test,1 (𝑧), 𝜌test,2 (𝑧), . . .}。智能体可能必须学习如何利用过去的经验、识别新的分布并避免灾难性遗忘。为了评估这些属性,我们可以检查代理在遇到测试分布的转换时是否经历了显着的性能下降。

4.2.3 可泛化 RL 的 MDP 组件变化 通过上述训练和测试分布之间的关系,我们现在检查上下文控制的 MDP 组件是什么,这构成了评估变化的另一个维度。 MDP 有四个上下文相关的组件:初始状态分布、动态、奖励函数和观察发射函数。

Observation emission function 𝑜 = O (𝑠|𝑧):context-dependent emission function 根据状态和上下文输出观察。由于大多数研究没有明确区分状态和观察,我们只在上下文对观察产生变化而不是环境的基本状态时才引入这个术语。示例:在使用像素图像作为策略输入时更改对象的颜色或相机的视角。

Initial state distribution𝜌0(𝑠|𝑧):context-dependent initial state distribution输出基于上下文的初始状态分布。当上下文改变系统的底层状态时,例如,初始

器人操作任务的物体位置,机器人运动任务的形状和障碍物的位置。

Dynamics 𝑃 (𝑠|𝑠, 𝑎, 𝑧):依赖于上下文的动力学输出基于先前状态、动作和上下文的下一个状态的分布。示例:物理参数,例如重力常数、摩擦系数或应用于机器人的扰动力。

奖励函数𝑅(𝑠, 𝑎|𝑧):依赖于上下文的奖励函数根据状态、动作和上下文输出标量奖励。目标条件 MDP [8, 83, 158] 可以被视为具有上下文相关奖励函数的 MDP。在这里,目标等同于上下文。

利用 4.2.2 和 4.2.3 节中描述的评估变化的两个维度,我们将论文列表分类到表 1 中。请注意,将一篇论文归为一类并不一定意味着该方法本身只能应用于该类别评价变异。相反,我们考虑实际出现在论文中的评估。从表 1 中,我们观察到大多数论文都关注 IID、OOD 和非平稳的动态变化。这种现象可能源于机器人 Sim-to-Real 传输中的流行应用,这是泛化 RL 的主要动机之一。

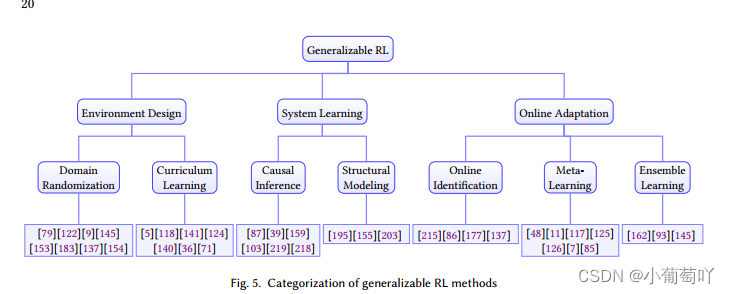

4.3 可泛化强化学习的方法论 为了提高泛化能力,可以从三个不同的角度入手:设计指导训练的环境(环境设计),学习环境的特征(系统学习),或者设计一种能够快速适应多样化的学习算法测试期间的任务(在线改编)。接下来,我们将介绍三种主要方法。

4.3.1 环境设计 由于泛化强化学习面临的挑战往往来自训练和测试环境的差异,因此很自然地会提出这样一个问题:如何设计/生成训练环境以提高测试性能?域随机化。域随机化是一种在训练期间使模拟环境的可变性多样化的技术,以便该策略能够在测试期间推广到真实环境。早期作品使用对机器人性能不关键的随机模型参数[79]

在扰动动态模型 [9、122、145] 和随机视觉特征 [153] 上,在术语域随机化首次出现在 [183] 之前。可以随机化的模拟器功能包括但不限于: • 控制器属性,例如扭矩噪声、控制频率和延迟、控制器增益和阻尼 [137]。

• 质量、重力和摩擦等物理参数[137]。

• 视觉输入,例如照明、物体纹理、位置、方向和相机视野[154、183]。

课程学习。上述工作依赖于手工挑选随机特征和值,这不可避免地需要一定程度的参数调整才能找到随机特征的适当值或分布。为了最大限度地减少人工,最近人们越来越关注开发自动域随机化和课程学习的方法。主动/自动域随机化使用模型的性能作为反馈信号来更新训练上下文的分布。 Akkaya 等人 [5] 提出了自动域随机化,只有在达到最低性能水平时才逐渐增加训练环境的难度。 Mehta 等人 [118] 提出主动域随机化来学习一种采样策略,该策略通过利用随机环境和参考环境之间的性能差异来产生信息量最大的环境。 Portelas 等人 [141] 通过迭代采样和拟合高斯混合模型来学习难度级别和环境顺序以设置为训练环境,从而最大限度地提高学习效率。 Muratore 等人 [124] 使用贝叶斯优化来搜索源域分布参数的空间,以学习最大化现实世界性能的稳健策略。

对抗训练是课程学习的另一种常见形式。 RARL [140] 将课程学习制定为代理人和对手应用扰动力之间的两人零和博弈。实证研究发现这种对抗性训练可以提高 RL 代理的泛化能力。与前面提到的零和同时博弈设置不同,PAIRED [36] 假设对手正在最大化后悔,这被定义为最佳代理和当前代理

课程学习的一个重要假设是环境上下文的之间的性能差距。 RRL-Stack [71] 建议使用一般和 Stackelberg 博弈公式来解决无法解决的环境和不稳定训练的潜在问题。访问和控制,因为算法需要主动改变训练环境的分布。与我们调查后面部分讨论的其他方法相比,课程强化学习确实需要更多信息和对环境的控制。然而,在大多数情况下,这不被认为是限制性的,因为 RL 代理通常在模拟器中接受培训,因此访问不是主要限制。作为一个新兴领域,课程 RL 的实证评估最近引起了很多关注,但对其在实践中如何或为何起作用的理论理解却很少。我们相信很快就会有更多这方面的研究。

4.3.2 系统学习因果关系和不变特征发现。动态系统和任务背后通常存在潜在的因果关系,决定了事物如何发生或一个对象如何影响另一个对象的机制。

发现这种因果关系是 RL 中的一个热门话题,其中的方法通常可以分为显式学习和隐式学习。显式学习方法通过可微优化 [87] 来估计图结构,它学习具有干预数据的软邻接矩阵,或者通过统计独立测试 [39],它迭代地更新世界因果模型和规划策略。 Scherrer 等人也探索了主动干预方法

[159] 以提高数据收集的效率并降低进行干预的成本 [103]。内隐学习

专注于从共享相同潜在因果关系的多个环境中提取不变特征 [218, 219]。

这种特征被认为是影响动力学的唯一重要因素。因此,可以通过给这个变量赋不同的值来表示不同的系统。

结构建模。除了学习隐藏在环境中的因果关系外,结构建模还旨在建立环境之间的明确关系。这种关系的常见选择是维护分层概率模型。在 Wilson 等人 [195] 中,作者提出了分层贝叶斯多任务 RL (HB MTRL),它使用 MDP 的分层贝叶斯模型类。每一类 MDP 共享一些共同的结构,共享的知识可以在同一类的 MDP 之间传递。 Sæmundsson 等人 [155] 使用具有高斯过程的分层潜变量模型来建模动态并从收集的数据中自动推断任务之间的关系。同样,Xu 等人 [203] 使用 Dirichlet-Process-Gaussian-Process (DPGP) 对 MDPs 分布进行建模,并保持专家混合来处理非平稳性。

4.3.3 在线适配在线识别。 Online Identification 从最可泛化的 RL 的反向角度采用不同的方法。在线识别不是学习在广泛环境中表现良好的策略,而是识别现实世界中动态模型的参数,然后将它们用作控制器的信息。 Yu 等人 [215] 训练在线系统识别 (OIS) 来预测动力学模型参数并将它们与系统状态一起提供给控制器。 Kaspar 等人 [86] 在真实机器人上执行预定义的动作以收集轨迹并优化模拟器参数以使模拟轨迹与真实轨迹对齐。谭等

[177] 还使用收集的真实轨迹来微调模拟器和匹配轨迹。在线识别也可以通过使用以表示状态和动作历史的潜在变量为条件的循环模型来纳入策略 [137]。

元学习。元学习,或学习学习,旨在从过去的经验中学习,以便它能够快速适应新的看不见的测试任务。 Finn 等人 [48] 首次引入了与模型无关的元学习 (MAML),以使用基于梯度的方法在各种学习任务上训练模型,使其仅使用少量训练样本即可适应新的学习任务. Arndt 等人 [11] 将 MAML 与特定于任务的轨迹生成模型一起应用,以促进在真实机器人上探索和部署经过训练的策略。 Mehta 等人 [117] 考虑了任务分布在基于梯度的元学习中的重要性,并提出元 ADR 来寻找任务课程,以避免与元学习相关的各种问题。

Nagabandi 等人 [125, 126] 使用元学习来训练先验动力学模型,以便该先验可以快速适应测试环境。 Ammar 等人 [7] 提出了一种多任务策略梯度方法,在任务之间学习和迁移知识,以在理论保证下加速学习。 Kaplanis 等人 [85] 提供了另一种观点,即为 RL 代理配备可以减轻灾难性遗忘的突触模型。

集成学习。集成学习旨在学习一组模型并将它们组合起来以提高测试期间的性能。与结构建模不同,集成学习并不专注于维护模型之间的显式(主要是层次结构)关系。相反,它通常假设模型的平面结构,并专注于测试期间的策略适应。从基于模型的角度来看,Seo 等人 [162] 通过在训练期间更新最准确的模型并通过使用采样轨迹提取上下文信息来整合在线自适应机制来学习动态模型的集合。从无模型的角度来看,SMERL [93] 旨在学习一组不同的策略,以便它可以通过采用最佳解决方案推广到看不见的环境。

Rajeswaran 等人 [145] 学习基于训练环境集合的稳健策略,并使用来自测试环境的数据不断调整训练环境的分布。

4.4 应用基准和资源 存在许多可泛化 RL 的基准环境。一般来说,泛化的基准环境可以通过它们的应用领域来区分:控制/机器人(例如 RoboSuite [226] 和 DMC [59]),或类游戏街机(例如 Arcade Learning Environment 游戏模式 [18] 和 Phy-问[205])。请注意,仅通过其应用领域来评估环境的难度是具有挑战性的。与连续控制任务相比,类似网格世界的环境可能会对泛化提出更大的挑战,具体取决于基础实验设置。

大多数基准测试环境为用户提供了极大的灵活性来控制训练和测试环境。因此,其中许多与特定的评估变量无关,例如 IID、OOD 或非平稳。与监督学习领域相比,它还强调了为可泛化 RL 创建标准训练/测试协议的难度。

5 展望和未来研究 在本节中,我们将对有前途的研究方向进行展望。第一项前期任务是我们应该能够评估和证明 RL 关于可信度的要求。其次,我们应该了解可信赖方面之间是否存在一些基本的权衡,以及可信赖要求与 RL 的名义性能之间的权衡。第三,除了内在的“数字可信 RL”之外,“物理可信 RL”如何受到代理的物理设计和操作环境设置的影响?最后,我们将讨论包含人类建模、隐私、信任、道德和公平的“社会可信赖 RL”。

5.1 如何证明和评估可信强化学习? 5.1.1 如何设计带认证的可信RL?为强化学习模型和系统的稳健性、安全性甚至泛化性提供认证具有挑战性和重要性。尽管有一些现有作品在不同设置下为 RL 提供了经过认证的稳健性 [92、110、190、197、198],但攻击的约束是有限的(例如,ℓ𝑝 范数有界输入状态扰动)和经过认证的目标,例如动作一致性对于安全部署来说不够实用。

特别是,RL 的动态特性以及复杂的环境约束和无法准确建模的不确定性导致了该方向的高度复杂性。因此,更现实的认证目标,例如将时间属性 RL 考虑在内的鲁棒动作动力学,是有前途且更实用的。

从侧重于一组特定安全约束的安全角度来看,考虑到这些约束,认证目标更加具体。然而,由于以下事实也带来了额外的挑战:1)这些约束通常很难以端到端的方式表征,2)需要新的认证技术,因为大多数现有的认证方法仅基于预测一致性而没有明确采取考虑到特定的(安全)目标,3)这些约束通常与其他人甚至环境相关,这使得认证过程非常复杂。因此,如何通过将安全约束分为不同级别来证明RL的安全性,并表征证明安全性的充分条件具有重要意义。

最后,证明 RL 的泛化具有很多现实意义。例如,如果一辆自动驾驶汽车在乡村环境中接受训练,那么在市区行驶时了解其性能认证就很重要。在这种情况下,如何衡量不同环境或观察之间的差异,如何定义

认证目标(例如,给定偏移观察的奖励下限),以及如何训练可证明可泛化的 RL 将导致有趣的工作,具有理论和实践影响。此外,泛化和鲁棒性证明自然相关。例如,鲁棒性证明是在个体输入层面,泛化证明是在输入分布层面;稳健性认证可被视为“最坏情况”转变,而泛化认证可被视为“自然分布转变”下的认证。通过这种方式,可以潜在地利用一些鲁棒性证明技术来证明不同条件下的泛化。如何分析它们的基本联系或迹象,也是一个值得探索的有趣方向。

5.1.2 如何设计可信RL的评估平台?设计适当的平台和评估指标以评估所提出的 RL 算法的可信度至关重要。

对于连续环境,最常见的平台是 MuJoCo 环境 [184],其中可以改变代理的质量、地面摩擦、关节阻尼和电枢以测试稳健性。 Atari Game 是另一个流行的基于观察的攻击平台。安全评估环境,例如 AI Safety Gridworlds 环境 [96]、Safety Gym [148] 和 Bullet Safety Gym [60],设计具有安全区域的控制任务。泛化的评估侧重于改变无关因素,例如环境背景[33]。此外,组合泛化是通过组合不同的预定义子任务来评估的[119]。

这些平台极大地促进了可信 RL 的开发。但是,这些现有基准存在三个关键限制。最重要的一点仍然是基准测试与现实世界之间的模拟与真实差距很大。仅在简单任务中评估稳健性、安全性和泛化性可能无法很好地泛化到复杂的现实世界应用程序中。第二个限制是大多数基准测试使用创建者设置的预定义任务和参数,缺乏多样性并且可能会受到人为偏见的影响。最后但同样重要的是,虽然任务通常是随机抽样的,但分布很少会触发具有灾难性后果的关键事件,从而导致低估风险和结果的收敛速度非常缓慢 [40]。最近的一些基准测试 [199] 使用逼真的 3D 模拟器来构建真实场景,并使用加速评估方法 [10, 204] 来强调罕见的安全关键案例。然而,建模误差和评估误差之间存在权衡[74]。

这些尝试是对某些方面进行高效准确评估的先驱。然而,我们距离获得令人满意的评估稳健性、安全性和泛化性的基准还很遥远。迫切需要全面和标准的基准测试来使 RL 算法在现实世界中部署。

5.2 可信度的不同方面之间的关系是什么?我们从三个不同的方面讨论了 RL 的可信度。因此,我们至少有四个维度来评估一个值得信赖的 RL 系统:系统的安全性、鲁棒性和泛化方面,以及 RL 系统的标称任务性能,即 RL 的原始功能目标。然而,如何设计一个安全、鲁棒、可泛化且具有高任务性能的可信 RL 系统仍然是一个悬而未决的问题,文献中很少进行研究。为了更好地理解这个问题,我们首先需要回答一个问题:上述四个维度之间的关系是什么?虽然大多数现有论文只关注其中的一两个,但我们认为它们并不相互正交。我们提供了几个关于它们之间关系的假设和想法,这可能对未来值得信赖的 RL 研究有所帮助。

可信度和任务绩效之间的权衡。我们可以观察到,提高可信度的任何方面都可能导致最佳任务性能下降。例如,提高 RL 智能体的安全性可能会导致智能体在探索高回报区域时变得保守,因此与不安全的智能体相比,任务性能相对较低 [108];增加对对抗性扰动的鲁棒性可能过度平滑策略,从而降低任务性能;由于模型容量的限制,在多个任务上训练可泛化的策略可能会降低单个任务的性能。由此可见,提高可信度可能是以牺牲最优任务性能为代价的,这也是没有免费午餐定理的反映。如何确定甜蜜点来平衡它们是一个有趣的问题,如何更好地理解权衡可以帮助我们根据不同的应用程序根据需要调整可信度。

可信度方面之间的相互联系。我们认为安全性、稳健性和泛化的概念具有不可忽略的重叠并且彼此不正交,尽管它们在 RL 文献中大多是独立讨论的。例如,我们可以将观察噪声方面的稳健 RL 策略视为对训练样本周围状态的泛化能力。类似地,针对未见场景的可推广策略可以被视为对动态不确定性的鲁棒性。因此,它们在一定语境下是密不可分的,我们在通用机器学习领域也可以看到类似的讨论和思考[202]。另一方面,安全性也与泛化和鲁棒性密切相关,因为如果代理不能泛化到新环境或对对抗性扰动没有鲁棒性,则不能认为它是安全的。最近的一项工作揭示了鲁棒性和安全性之间的联系,表明无噪声环境中的安全策略在对抗性攻击下可能并不安全 [108],我们希望在这个方向上看到更多的跨学科讨论

5.3 如何与物理代理和环境共同设计可信赖的 RL?虽然可信赖的 RL 在计算方面取得了巨大的发展,但设计和优化代理物理属性的进展通常滞后 [120]。与生物体类似,现实世界中的 RL 智能体既有提供认知能力的“大脑”,也有在做出决策后服务于感知和执行器官的“身体”。一些先前的工作已经在模拟环境中探索了这个方向。

为了找到对特定任务来说几乎是最佳的机器人形态,Gupta 等人 [63] 使用遗传算法来变异和进化学习代理的群体。同样,Ha [64] 使用基于采样的算法来更新代理的物理参数。最近,Yuan 等人 [216] 提出使用图神经网络对控制策略和变形策略进行建模,以便联合优化它们。与非共同优化的代理相比,这些方法中的大多数都显示出优势。

“物理可信 RL”的一些关键挑战仍然存在。例如,如何对物理结构、传感和驱动系统进行建模,以便我们可以使用梯度方法有效地训练整个智能体。如何构建易于使用的仿真平台来优化结构化和模块化的系统?如何设计 step-wise 而不是 episodic 训练来加速训练?我们相信,共同设计 RL 代理的软件和硬件将为未来的 RL 代理提供一条途径,可以更好地适应不断变化的测试环境,并对损坏或对抗环境更具弹性,从而产生新一代可信赖的智能代理。

5.4 可信强化学习如何实现以人为本的设计?除了本文讨论的可信赖 RL 的内在视角(即鲁棒性、安全性、泛化性)外,主要涉及人类反馈的外在视角也引起了极大的关注,需要进一步探索“社会可信赖的 RL”。特别是,此类外部观点广泛包括可解释性、对敏感个人信息的隐私保护、伦理以及对训练有素的 RL 代理或模型的一般人类信任。通过考虑这种以人为中心的设计 [4、51、128、175] 来弥合与人类的信任,文献中还研究了不同的可信 RL

类行为建模和人机交互。首先,对人类行为以及人类与 RL 代理之间的交互进行建模非常重要且具有挑战性。例如,RL 代理的行为分析对于了解经过训练的 RL 模型是利己的还是利他的非常重要,这有利于建立人类信任特别是,人类的次优行为对人类行为建模提出了巨大挑战,这引发了值得信赖的 RL 中的一个关键开放问题。在逆向强化学习 (IRL) 中广泛研究了根据历史观察或对手政策推断代理人的意图(参见 [12] 及其中的参考资料)。然而,IRL 假设所展示的行为接近最佳,而人类经常违反这一点。人类的次优行为取决于多种因素。例如,Ziebart 等人 [227] 假设人类的次优行为是受认知科学 [14] 和经济行为 [123] 中玻尔兹曼噪声-理性决策模型启发的随机噪声的影响。众所周知,人类的风险敏感性(寻求风险或规避风险)会导致次优行为。 [147] 使用前景理论 [84] 来解释决策者对收益和损失的不同态度。 Reddy 等人 [149] 和 Golub 等人 [55] 认为人类的次优行为是由于模型错误指定:人类的次优行为 w.r.t.真实的环境动力学模型可能接近最优 w.r.t.用户对动态模型的内部信念。

人类信任的可解释 RL。除了人机交互的形式化建模之外,让机器决策对人类具有可解释性是建立人类信任的关键步骤。现有的努力是构建结构化强化学习来探索决策过程的语义 [80, 143],为强化学习算法提供可视化 [152, 192],并探索低维解释 [53]。然而,RL 的动态特性和环境中的不确定性使得完全提供定量和可验证的解释具有挑战性。因此,探索 RL 的不同结构和架构非常重要且有趣,例如组合结构和与领域知识的集成,为 RL 提供语义和逻辑解释。

隐私保护 RL 以保护敏感的个人信息。由于 RL 算法的训练需要大量数据,例如为自动驾驶收集的交通场景/驾驶行为和用于智能诊断的人类医学统计数据,训练有素的 RL 模型的隐私问题引起了极大的关注 [106, 157]。显然,这些数据通常包含大量关于个人的敏感信息,例如个人行为和健康状况;差分私有 RL 算法 [111]、博弈论方法 [34] 和局部私有 RL [131] 已被提出来保护 RL 中的私有信息。然而,从人的角度来看,了解隐私保护级别并不直观。例如,在 (𝜖, 𝛿)-differentially private RL 训练下,患者可能不知道什么级别的𝜖适合他/她的个人数据。因此,需要进一步研究新的隐私测量指标、隐私保护标准和数据评估方法以获得人类信任。

具有人类信任的道德和公平的 RL。鉴于 RL 代理通常在人类日常生活中被采用,例如治疗辅助机器人和清洁机器人,确保 RL 代理的伦理非常重要。例如,最近提供了一个大规模基准来研究 RL 视频游戏中的伦理问题,并试图消除游戏中的有毒或暴力对话 [70]。同样,已经进行了不同的研究来识别 RL 中的公平性问题并减轻它们 [78、104]。另一方面,RL 的大型训练观察空间和非线性决策空间使得通过人类反馈训练道德和公平的 RL 智能体更具挑战性。因此,不仅从技术角度,如不同的伦理和公平问题识别和缓解方法,而且从政策制定的角度,如伦理和公平法规等 RL 需要更好地理解和研究。

总的来说,外在的人类信任在不同的背景下被广泛研究,导致不同的定义,例如态度、意图或行为 [98]。自动化中的可信度 [95] 被定义为人类对自动化代理将在不确定情况下帮助实现个人目标的态度。研究人员已经表明,信任会影响人类对智能代理的依赖,这可能会导致依赖不足或过度依赖,从而影响提交给 ACM 的整体手稿

系统性能[134]。通过赋予 RL 智能体产生可解释行为、理解人类偏好甚至影响人类行为、尊重人类隐私和促进团队合作公平性的能力来增强人类对 RL 智能体的信任仍然是一个悬而未决的问题。

6 结论 在本次调查中,我们旨在阐明 RL 的稳健性、安全性和泛化性术语,分析其内在弱点,介绍解决这些问题的工作,并总结流行的基准,从而将不同的研究线索整合到一个统一的框架中.我们希望这项调查能够成为值得信赖的 RL 领域的科学家、工程师和政策制定者的接触点和参考,并推动进一步的研究。

我们在下面总结了本次调查的要点。

• 分布稳健的 RL 算法提供了一种自然公式,通过选择适当的歧义集来编码先验知识。然而,目前还不清楚如何选择合适的歧义集。因此,未来应重点关注选择歧义集的原则。

• 与对手进行强有力的训练可能会导致过于保守的政策和训练不稳定。应该提出更好的对手攻击公式以及强大的训练,例如受已知规则约束或受 RL 代理性能约束的攻击。

• Safe RL 在 ML、控制和机器人社区中有多种定义,每种定义都有其相应的实际应用。需要更多的研究来了解不同用例的每个方向的优缺点。

• 确保复杂系统的安全性仍然是一个具有挑战性的问题,尤其是当违反约束的风险难以预测或领域知识有限时。在 RL 训练阶段或在非静止环境中确保安全仍然是广阔的领域。

• 尽管有许多环境是为评估 RL 而设计的,但很少有环境是为评估其可信度而设计的。研究界将在很大程度上受益于标准的评估环境和管道,它们可以为不同的评估协议和变化提供多种选择。

• 与鲁棒强化学习和安全强化学习相比,可泛化强化学习是一个相对较新的领域。迫切需要一个具有严格和可验证的理论分析和标准基准的统一范式来推进这一领域

• Sim2Real 传输仍然对 ML 社区提出了巨大挑战,这对 RL 代理的实际部署至关重要。一方面,我们需要更多公开可用的训练模拟器,在模拟柔软物体、接触力和真实地形等复杂领域时具有高保真度,以及针对罕见但灾难性场景的有效评估和认证范例。另一方面,我们需要开发更实用的算法,能够在线适应看不见的现实环境。

• 需要更多的研究来理解可信度的不同方面以及强化学习系统的标称功能性能之间的相互联系。例如,在具有环境差异的设置中,发现鲁棒 RL 和可泛化 RL 密切相关。还观察到安全性和鲁棒性或泛化之间的联系,但尚未彻底建立和讨论。

• 虽然我们主要关注“数字可信智能”RL 的内在弱点,但“物理可信智能”需要做更多的工作,既要考虑 RL 算法设计,也要考虑整个生命周期中的物理代理和环境设计,以实现可信自治.这仍然是一个广阔的领域。

• 最后,智能自治需要以人为本的考虑“社会可信”RL,其中包括人类建模和交互、可解释性、隐私、信任、道德和公平

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?