一、需求描述

1.将待分析的文件(不少于10000英文单词)上传到HDFS。

2.调用MapReduce对文件中各个单词出现的次数进行统计。

3.将统计结果下载本地。

二、环境介绍

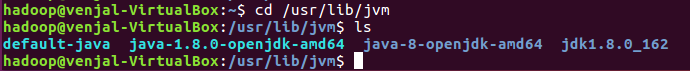

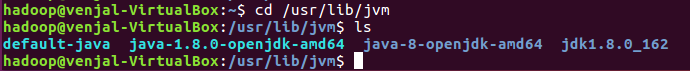

安装Ubuntu系统

配置Java环境,安装JDK

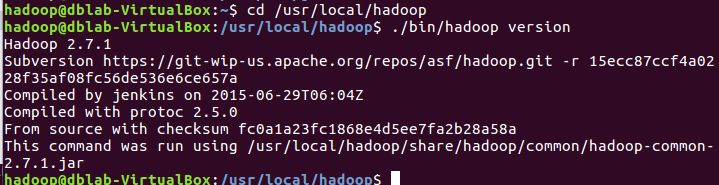

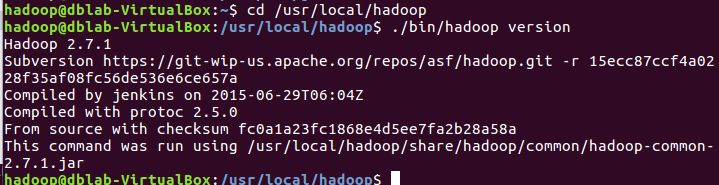

安装hadoop

三、数据来源及数据上传

准备一个待分析的 10000 字英文单词文件,命名为lwj.txt。开启虚拟机双向拖放,将lwj.txt 文件拖拽到 hadoop 中:

<

本文档详细介绍了如何在Ubuntu环境下利用Hadoop MapReduce对一个包含10000个英文单词的文件lwj.txt进行词频统计。首先,文件被上传到HDFS,接着通过Eclipse创建并运行MapReduce程序,最后将处理结果下载至本地并查看。

本文档详细介绍了如何在Ubuntu环境下利用Hadoop MapReduce对一个包含10000个英文单词的文件lwj.txt进行词频统计。首先,文件被上传到HDFS,接着通过Eclipse创建并运行MapReduce程序,最后将处理结果下载至本地并查看。

一、需求描述

1.将待分析的文件(不少于10000英文单词)上传到HDFS。

2.调用MapReduce对文件中各个单词出现的次数进行统计。

3.将统计结果下载本地。

二、环境介绍

安装Ubuntu系统

配置Java环境,安装JDK

安装hadoop

三、数据来源及数据上传

准备一个待分析的 10000 字英文单词文件,命名为lwj.txt。开启虚拟机双向拖放,将lwj.txt 文件拖拽到 hadoop 中:

<

1311

1311

1258

1258

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?