Ubantu18.04 部署Hive

一.什么是Hive

Hive是基于Hadoop的一个数据仓库工具,用来进行数据提取、转化、加载,这是一种可以存储、查询和分析存储在Hadoop中的大规模数据的机制。hive数据仓库工具能将结构化的数据文件映射为一张数据库表,并提供SQL查询功能,能将SQL语句转变成MapReduce任务来执行。Hive的优点是学习成本低,可以通过类似SQL语句实现快速MapReduce统计,使MapReduce变得更加简单,而不必开发专门的MapReduce应用程序。hive是十分适合数据仓库的统计分析和Windows注册表文件。

准备事项

安装Hive前提下 需要先安装hadoop

1.Hive 安装

2.配置Hive

3.安装MySQL 添加Mysql的驱动包

4.初始化元数据

5.启动Hive

1.安装Hive

下载地址:链接: http://hive.apache.org/downloads.html.

解压apache-hive-2.2.1-bin.tar.gz

登录root账户

su

解压

tar -zxvf apache-hive-2.2.1-bin.tar.gz

将解压的hive移动和改名

mv apache-hive-2.2.1-bin /usr/local

mv apache-hive-2.2.1-bin /hive

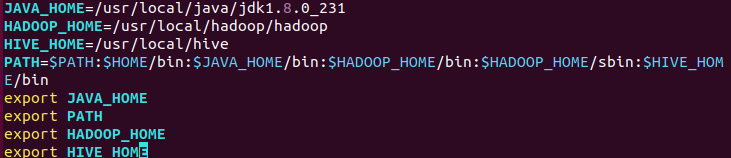

修改环境变量

gedit /etc/profile

HIVE_HOME=/usr/lcoal/hive

PATH=$HIVE_HOME/bin

export HIVE_HOME

刷新环境变量

source /etc/proflie

2.配置环境变量

cd /usr/local/hive/conf

cp hive-default.xml.template hive-site.xml

sudo vim hive-site.xml

添加一下内容

<configuration>

<!-- 连接mysql的地址位置-->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc.mysql://master:3360/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<!-- 连接脚本-->

<property>

<name>javax.jdo.option.ConnetionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<!--mysql用户名hive-->

<property>

<name>javax.jdo.option.ConnetionUserName</name>

<value>hive</vlaue>

<description>username to use against metastore database</description>

</property>

<!--mysql连接密码hive-->

<property>

<name>javax.jdo.option.ConnetionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property>

</configuration>

修改临时文件夹的路径,并修改为固定路径:

<!--数据保存路径-->

<property>

<name>hive.exec.local.scratchdir</name>

<value>/home/hadoop/iotmp</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/home/hadoop/iotmp</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

新建iotmp文件夹:

mkdir -p /home/hadoop/iotmp

3.安装并配置MySQL

sudo apt-get install mysql-server 安装

下载Mysql JDBC驱动器

去mysql官方找GA version下载

https://dev.mysql.com/downloads/connector/j/.

下载完后解压

tar -zxvf mysql-connector-java-5.1.48.tar.gz

然后将解压好的jar包移动到hive/lib下

mv mysql-connector-java-5.1.40-bin.jar /usr/local/hive/lib

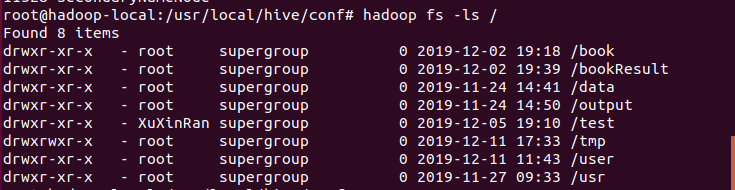

在HDFS中创建目录和设置权限

启动hadoop,在hadoop 创建hive需要用到目录并设置权限。

sbin/start-all.sh

hadoop fs -ls /

hadoop fs -mkdir -p /user/hive/warehouse

hadoop fs -mkdir /tmp

hadoop fs -chmod g+w /tmp

hadoop fs -chmod g+w /user/hive/warehouse

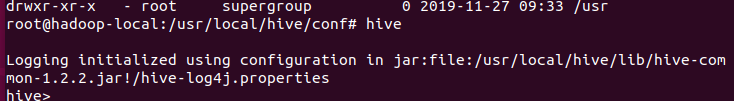

4.初始化数据库

进入/usr/local/hive/lib目录下,初始化元数据

schematool -initSchema -dbType mysql

启动

./hive

这样就成功了!

279

279

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?