大数据hadoop配置(二)

- 搭建Hadoop的全分布模式

- 准备3台虚拟机机器:master,slave1,slave2

- 每台机器的准备工作:安装JDK、关闭防火墙、设置主机名…

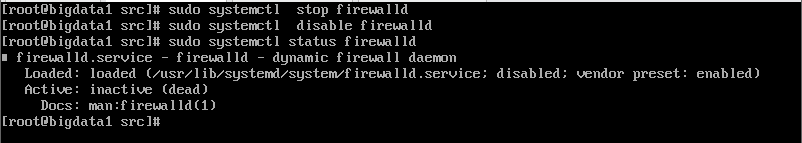

关闭防火墙

sudo systemectl stop firewalld 临时关闭

sudo systemectl disable firewalld 禁止防火墙自启

reboot 重启虚拟机

sudo systemctl staus firewalld 查看防火墙状态

获取ip地址

- 必须将每台的ip地址写入hosts文件,设置为静态ip地址

- 在每台输入命令ip a 找到虚拟机ip地址

将三台ip 输入/etc/hosts

(注:先将文件清空,否则hdfs开启时,会找不到主机)

3.设置主机名

vim /etc/hosts 打开hosts

主机ip 主机名1

主机ip 主机名2

主机ip 主机名3

(注:主机ip对应的主机名)

配置SSH为免密码登录

- 先下在ssh的压缩包。

yum install openssh*

- 修改配置文件

vim/etc/ssh/sshd_comfig 打开文件

将上图的PermitRootLogin,RSAAuthentication,PubkeyAuthentication的设置打开。

3. 启动ssh的服务:

systemctl start sshd.service 启动

sercvice sshd restart 重启

(注:每台虚拟机都要实行123步骤!)

4. 配置免密码登录

ssh-keygen -t rsa (私钥变公钥)

需要将每台机器的公钥复制到每台机器(下面命令,需要在每台机器上执行)

ssh-copy-id -i ~/.ssh/id_rsa.pub root@主机名1

ssh-copy-id -i ~/.ssh/id_rsa.pub root@主机名2

ssh-copy-id -i ~/.ssh/id_rsa.pub root@主机名3

测试是否连接成功

ssh 主机名1

ssh 主机名2

ssh 主机名3

连接xshell和xftp将hadoop、JDK、Zookeeper导入到 主机名1 /home/中

** 解压haoop、jdk、zookeeper**

tar zxf hadoop-2.8.5.tar.gz -C /usr/local/src

tar zxf jdk-8u231-linux-x64.tar.gz -C /usr/local/src

tar zxf zookeeper-1.2.4.tar.gz -C /usr/local/src

重命名 hadoop 、jdk 、zookeeper

mv hadoop-2.8.5/ hadoop

mv jdk1.8.0_231/ java

mv zookeeper-1.2.4 /zookeeper

配置环境变量

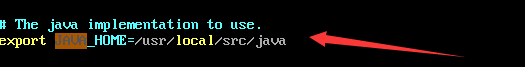

vim /etc/profile 打开配置文件

PATH=$PATH:$HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export SPARK_HOME=/usr/local/src/spark

export JAVA_HOME=/usr/local/src/jdk

export ZOOKEEPER_HOME=/usr/local/src/zookeeper

export PATH=$HADOOP_HOME/bin:$PATH

export PATH=$HADOOP_HOME/sbin:$PATH

export PATH=$SPARK_HOME/bin:$PATH

export PATH=$JAVA_HOME/bin:$PATH

export PATH=$ZOOKEEPER_HOME/bin:$PATH

更新环境

source /etc/profile

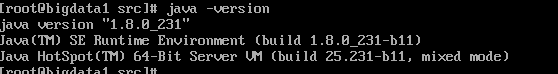

验证

hdfs

java -version

配置hadoop文件

cd /usr/local/src/hadoop/etc/hadoop 移动到这个目录下

- hadoop-env.sh (vim hadoop-env.sh)

export JAVA_HOME=/usr/local/src/java

- hdfs-site.xml (vim hdfs-site.xml)

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!--

Licensed under the Apache License, Version 2.0 (the "License");

you may not use this file except in compliance with the License.

You may obtain a copy of the License at

http://www.apache.org/licenses/LICENSE-2.0

Unless required by applicable law or agreed to in writing, software

distributed under the License is distributed on an "AS IS" BASIS,

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

See the License for the specific language governing permissions and

limitations under the License. See accompanying LICENSE file.

-->

<!-- Put site-specific property overrides in this file. -->

<!--设置hdfs副本数量-->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!--设置权限-->

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

- core-site.xml (vim core-site.xml)

<!--指定HDFS老大(namenode)的通信地址-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://主机名1:9000</value>

</property>

<!--指定hadoop运行时产生的存储路径-->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>

- mapred-site.xml (vim mapred-site.xml)

<!--MR程序运行的容器是yarn-->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

- yarn-site.xml (vim yarn-site.xml)

<configuration>

<!--ResourceManager的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>主机名1</value>

</property>

<!--NodeManager运行MR任务方式-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

-

slave:配置所有的从节点的主机名 (vim slave)

主机名2

主机名3

复制Hadoop、JDK、profile

cd /usr/local/src/

scp -r hadoop/ jdk/ 主机名2:/usr/local/src/

scp -r hadoop/ jdk/ 主机名1:/usr/local/src/

scp /etc/profile 主机名2:/etc/

scp /etc/profile 主机名1:/etc/

格式化hadoop

hdfs namenode -format

启动hadoop集群

start-all.sh(启动)

start-stop.sh (停止)

验证hdfs是不是安装成功

hadoop jar ../share/hadoop/mapreduce/hadoop-mapreduce-examples-2.8.5.jar pi 10 10

(注:因为第一次会出现hadoop在安全模式中无法运行验证所以我们需要关闭安全模式)

*启动完hadoop的时候,hadoop会进入安全模式,此时不能对hdfs进行上传,修改,删除文件的操作。

hadoop dfsadmin -safemode get 命令是用来查看当前hadoop安全模式的开关状态

hadoop dfsadmin -safemode enter 命令是打开安全模式

hadoop dfsadmin -safemode leave 命令是离开安全模式*

到这里 hadoop 全分布式 已经配置完成,如果有不足的地方,请提出建议我会改正。谢谢!

2587

2587

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?