一、前提条件

注:主虚拟机->主节点=namenode

子虚拟机1->子节点1=datanode1

1. Linux系统

2. 配置固定的IP地址,此处需要3个ip,一个给主机,另外两个分别给两台虚拟机

1、连接以太网(插网线),然后点击:设置–>网络和Internet–>以太网–>网络和共享中心

2、点击对应网络的连接状态,点击属性,双击TCP/IPv4,点击使用下面的IP地址,输入对应的IP地址、子网掩码、默认网关,点击确定

3、打开VMware虚拟机,点击:编辑–>虚拟网络编辑器,添加一个网络位置,修改为桥接模式,查看以太网属性-描述,已桥接至,选择该网络,点击确定

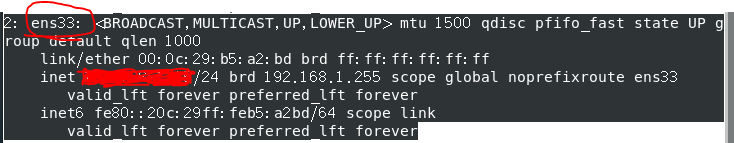

4、启动虚拟机,终端输入ip a查看网卡信息,找到有线网卡对应的记录(我这里是已经配好静态ip的,找到前面的这个名字,看不懂的可以先全篇翻译)

5、编辑网卡配置文件vi /etc/sysconfig/network-scripts/ifcfg-ens33(最后的这个ens33改成自己上一步找到的名字),输入:

DEVICE=(自己上一步找到的名字)

IPADDR=(自己的静态ip)

NETMASK=(自己的子网掩码)

BOOTPROTO=static

GATEWAY=(自己的网关)

ONBOOT=yes

NAME=loopbac2

6、重启网络,出现ok或成功,就没问题

service network restart

7、查看网络地址ip a

确定自己的ip修改成功

8、测试网络连接

虚拟机:ping 主机ip

主机:ping 虚拟机ip

提示:同频段ip也可以互相ping,如果其他人可以ping你,而你无法ping其他人,可能ip已被占用,可以换个ip再试

9、重复以上以上步骤,配置另一台虚拟机的静态ip

3. 主节点服务器免密码登录子节点服务器

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

# 192.168.1.73换成自己的子节点ip

scp ~/.ssh/id_rsa.pub root@192.168.1.73:~/.ssh/authorized_keys

4. Jdk1.8(hadoop2.7.x至3.3版本),可以参考

jdk1.8安装

二、单节点安装

1、下载hadoop文件

hadoop下载地址

2、准备hadoop文件

- 复制文件hadoop-3.2.2.tar.gz 到linux特定目录,如/software

- 解压文件 tar -zxvf hadoop-3.2.2.tar.gz

3、配置变量

(1)编辑/software/hadoop-3.2.2/etc/hadoop/hadoop-env.sh 文件,

设置变量: (命令find / | grep jre找到jre位置作为JAVA_HOME)

注:路径名找自己的

export JAVA_HOME=/usr/java/jdk1.8.0_291-amd64/jre

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

(2)编辑/etc/hosts文件 (ip为虚拟机ip)

192.168.144.155 namenode

(3)编辑/etc/profile (命令find / | grep jre找到jdk位置作为JAVA_HOME)

export JAVA_HOME=/usr/java/jdk1.8.0_291-amd64

export PATH=$PATH:$JAVA_HOME/bin

export PATH=$PATH:/software/hadoop-3.2.2/bin/

命令行命令

# 刷新/etc/profile文件

source /etc/profile

附(4)修改机器名称:(namenode为新名字)

# 修改主机名为namenode方法1

hostnamectl set-hostname namenode

# 查看主机名

sysctl kernel.hostname

# 修改主机名为namenode方法2

sysctl kernel.hostname=namenode

4、配置文件

(1)编辑/software/hadoop-3.2.2/etc/hadoop/core-site.xml文件

<property>

<name>fs.defaultFS</name>

<value>hdfs://namenode:9000</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

(2)先在/home目录下新建data目录,再在data目录下新建hdfs目录,

再编辑/software/hadoop-3.2.2/etc/hadoop/hdfs-site.xml文件

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/data/hdfs</value>

</property>

(3)编辑/software/hadoop-3.2.2/etc/hadoop/mapred-site.xml文件

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

(4)编辑/software/hadoop-3.2.2/etc/hadoop/yarn-site.xml文件

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

5、hdfs格式化

hdfs namenode -format

6、启动进程

sbin/start-dfs.sh

sbin/start-yarn.sh

firewall-cmd --permanent --add-port=9870/tcp

firewall-cmd --permanent --add-port=8088/tcp

firewall-cmd --reload

7、访问hadoop

windows浏览器下访问对应主节点IP地址

http://192.168.244.132:9870/

http://192.168.244.132:8088

三、多节点安装

1、修改配置文件

1.修改/etc/hosts ,每台电脑都要修改

主节点ip namenode

子节点ip datanode1

2.修改主节点的hadoop-3.2.2/etc/hadoop/workers 文件

namenode

datanode1

3.关闭全部防火墙

systemctl stop firewalld

systemctl disable firewalld.service

4.删除文件夹

rm -r hadoop-3.2.2/etc/hadoop/tmp

# 此步只删除子虚拟机里面的文件

rm -r /software/data/hdfs

5.子节点(子虚拟机)修改机器名

sysctl datanode1

6.全部虚拟机重启

init 6

7.启动服务(主节点)

cd /software/hadoop-3.2.2/sbin/

./start-all.sh

8、windows浏览器下访问对应主节点IP地址

出现自己总节点数则成功

http://192.168.244.132:9870/

在这里插入图片描述

http://192.168.244.132:8088

9、如果启动有问题,有报错跟着错误来,查找原因可以参考以下方式

# 检查hadoop进程启动(主节点一般是启动5个,子节点不启动)

ps -ef | grep java

# 杀死进程,pid为对应进程id

kill pid

# 关闭hadoop服务,hadoop下sbin目录下

./stop-all.sh

# 清空日志

cd ../logs

rm -rf *

# 重新启动hadoop服务还是无法访问,查日志,logs下

tail -n 100 (namenode对应的.log文件)

2201

2201

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?