一、RocketMQ原生API使用

使用RocketMQ的原生API开发是最简单也是目前看来最牢靠的方式。这里我们用SpringBoot来搭建一系列消息生产者和消息消费者,来访问我们之前搭建的RocketMQ集群。

1、测试环境搭建

首先创建一个基于Maven的SpringBoot工程,引入如下依赖:

<dependencies>

<dependency>

<groupId>org.apache.rocketmq</groupId>

<artifactId>rocketmq-client</artifactId>

<version>4.7.1</version>

</dependency>

<dependency>

<groupId>org.apache.rocketmq</groupId>

<artifactId>rocketmq-acl</artifactId>

<version>4.7.1</version>

</dependency>

</dependencies>

测试代码中的生产者和消费者都需要依赖NameServer才能运行,只需要将NameServer指向我们自己搭建的RocketMQ集群,而不需要管Broker在哪里,就可以连接我们自己的自己的RocketMQ集群。

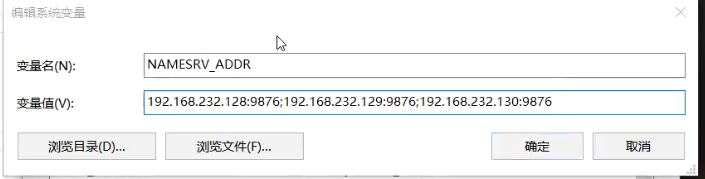

而RocketMQ提供的生产者和消费者寻找NameServer的方式有两种:

1、在代码中指定namesrvAddr属性。例如:consumer.setNamesrvAddr(“127.0.0.1:9876”);

2、通过NAMESRV_ADDR环境变量来指定。多个NameServer之间用分号连接。

2、RocketMQ的编程模型

RocketMQ的生产者和消费者的编程模型都是有个比较固定的步骤的,掌握这个固定的步骤,对于我们学习源码以及以后使用都是很有帮助的。

- 消息发送者的固定步骤

1.创建消息生产者producer,并制定生产者组名

2.指定Nameserver地址

3.启动producer

4.创建消息对象,指定主题Topic、Tag和消息体 5.发送消息 6.关闭生产者producer - 消息消费者的固定步骤

1.创建消费者Consumer,制定消费者组名

2.指定Nameserver地址

3.订阅主题Topic和Tag

4.设置回调函数,处理消息

5.启动消费者consumer

3、RocketMQ的消息样例

那我们来逐一连接下RocketMQ都支持哪些类型的消息:

3.1 生产者-基本样例

基本样例部分我们使用消息生产者分别通过三种方式发送消息,同步发送、异步发送以及单向发送。

然后使用消费者来消费这些消息。

1、单向发送消息

producer向 broker 发送消息,执行 API 时直接返回,不等待broker 服务器的结果 。

环境变量配置name server:

我们首先创建一个消费者:

public class Consumer {

public static void main(String[] args) throws MQClientException {

// 定义一个消息组

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("Jihu_group_test1");

// 也可以通过NAMESRV_ADDR环境变量来指定

consumer.setNamesrvAddr("192.168.131.171:9876");

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_LAST_OFFSET);

consumer.subscribe("TopicTest", "*");

consumer.registerMessageListener(new MessageListenerConcurrently() {

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs,

ConsumeConcurrentlyContext context) {

System.out.printf("%s 收到了新的消息: %s %n", Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

然后来使用生产者单向发送消息:

public class Producer {

public static void main(String[] args) throws MQClientException, InterruptedException {

DefaultMQProducer producer = new DefaultMQProducer("Jihu_group_test1");

// 设置name server 也可以在环境变量中配置

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

for (int i = 0; i < 20; i++) {

try {

// topic是否需要自动创建,这个可以在配置文件中设置

Message msg = new Message("TopicTest",

"TagA",

"OrderID188",

"Hello world".getBytes(RemotingHelper.DEFAULT_CHARSET));

// 单向发送消息,不会等待消费者处理

producer.sendOneway(msg);

} catch (Exception e) {

e.printStackTrace();

}

}

System.out.println("消息发送完毕!");

producer.shutdown();

}

}

关键点就是使用producer.sendOneWay方式来发送消息,这个方法没有返回值,也没有回调。就是只管把消息发出去就行了。

注意,我们这里发送使用的是sendOneway方法,即单向发送。此时生产者只会将消息发送到broker中,至于是否发送成功以及是否被消费,这中单向发送的模式不会关注结果。

是否可以主动的创建组,这个可以在配置文件中配置:

autoCreateTopicEnable=true·

然后从消费者log中可以看到消息消费:

也可以从dashboard中看到消息:

2、同步发送消息

producer向 broker 发送消息,执行 API 时同步等待, 直到broker 服务器返回发送结果 。

同步发送,即生产者将消息发送到broker之后,会等待broker返回这个状态,并将状态通过SendResult对象返回到生产者端。

public class Producer {

public static void main(String[] args) throws MQClientException, InterruptedException {

DefaultMQProducer producer = new DefaultMQProducer("Jihu_group_test2");

// 设置name server 也可以在环境变量中配置

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

for (int i = 0; i < 20; i++) {

try {

Message msg = new Message("TopicTest",

"TagA",

"OrderID188",

"[Sync] Hello world".getBytes(RemotingHelper.DEFAULT_CHARSET));

//同步传递消息,消息会发给集群中的一个Broker节点。可以从这个SendResult中判断消息是否发送成功

SendResult sendResult = producer.send(msg);

System.out.printf("%s%n", sendResult);

} catch (Exception e) {

e.printStackTrace();

}

}

System.out.println("消息发送完毕!");

producer.shutdown();

}

}

3、异步发送消息

producer向 broker 发送消息时指定消息发送成功及发送异常的回调方法,调用 API 后立即返回,producer发送消息线程不阻塞 ,消息发送成功或失败的回调任务在一个新的线程中执行 。

public class AsyncProducer {

public static void main(

String[] args) throws MQClientException, InterruptedException, UnsupportedEncodingException {

DefaultMQProducer producer = new DefaultMQProducer("Jihu_group_test2");

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

// 设置重试次数

producer.setRetryTimesWhenSendAsyncFailed(0);

int messageCount = 100;

//由于是异步发送,这里引入一个countDownLatch,保证所有Producer发送消息的回调方法都执行完了再停止Producer服务。

final CountDownLatch countDownLatch = new CountDownLatch(messageCount);

for (int i = 0; i < messageCount; i++) {

try {

final int index = i;

Message msg = new Message("TopicTest",

"TagA",

"OrderID188",

"[Async] Hello world".getBytes(RemotingHelper.DEFAULT_CHARSET));

producer.send(msg, new SendCallback() {

@Override

public void onSuccess(SendResult sendResult) {

countDownLatch.countDown();

System.out.printf("%-10d OK %s %n", index, sendResult.getMsgId());

}

@Override

public void onException(Throwable e) {

countDownLatch.countDown();

System.out.printf("%-10d Exception %s %n", index, e);

e.printStackTrace();

}

});

System.out.println("消息发送完成");

} catch (Exception e) {

e.printStackTrace();

}

}

countDownLatch.await(5, TimeUnit.SECONDS);

producer.shutdown();

}

}

3.2 消费者-基本样例

消费者消费消息有两种模式,一种是消费者主动去Broker上拉取消息的拉模式,另一种是消费者等待Broker把消息推送过来的推模式。

1、推模式

public class PushConsumer {

public static void main(String[] args) throws InterruptedException, MQClientException {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("Jihu_group_test2");

consumer.setNamesrvAddr("192.168.131.171:9876");

consumer.subscribe("TopicTest", "*");

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_FIRST_OFFSET);

consumer.setConsumeTimestamp("20181109221800");

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs, ConsumeConcurrentlyContext context) {

System.out.printf("%s Receive New Messages: %s %n", Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

2、拉模式

public class PullConsumer {

private static final Map<MessageQueue, Long> OFFSE_TABLE = new HashMap<>();

public static void main(String[] args) throws MQClientException {

DefaultMQPullConsumer consumer = new DefaultMQPullConsumer("Jihu_group_test2");

consumer.setNamesrvAddr("192.168.131.171:9876");

consumer.start();

Set<MessageQueue> mqs = consumer.fetchSubscribeMessageQueues("TopicTest");

for (MessageQueue mq : mqs) {

System.out.printf("Consume from the queue: %s%n", mq);

SINGLE_MQ:

while (true) {

try {

PullResult pullResult =

// getMessageQueueOffset指的是消息消费的偏移量,用来记录上一次消费到的地址,下一次继续向后消费,这样可以防止重复消费

consumer.pullBlockIfNotFound(mq, null, getMessageQueueOffset(mq), 32);

System.out.printf("%s%n", pullResult);

putMessageQueueOffset(mq, pullResult.getNextBeginOffset());

switch (pullResult.getPullStatus()) {

case FOUND:

break;

case NO_MATCHED_MSG:

break;

case NO_NEW_MSG:

break SINGLE_MQ;

case OFFSET_ILLEGAL:

break;

default:

break;

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

consumer.shutdown();

}

private static long getMessageQueueOffset(MessageQueue mq) {

Long offset = OFFSE_TABLE.get(mq);

if (offset != null)

return offset;

return 0;

}

private static void putMessageQueueOffset(MessageQueue mq, long offset) {

OFFSE_TABLE.put(mq, offset);

}

}

这样的代码比较复杂,需要自己维护offset。其实RocketMQ提供了更好的拉取消息的方式。

3、Lite拉模式

public class LitePullConsumerSubscribe {

public static volatile boolean running = true;

public static void main(String[] args) throws Exception {

DefaultLitePullConsumer litePullConsumer = new DefaultLitePullConsumer("lite_pull_consumer_test");

litePullConsumer.setNamesrvAddr("192.168.131.171:9876");

litePullConsumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_FIRST_OFFSET);

litePullConsumer.subscribe("TopicTest", "*");

litePullConsumer.start();

try {

while (running) {

List<MessageExt> messageExts = litePullConsumer.poll();

System.out.printf("%s%n", messageExts);

}

} finally {

litePullConsumer.shutdown();

}

}

}

这样我们就不需要维护offset了。

但是有些时候我们需要使用到offset, 那么使用lite拉模式怎么实现呢?

4、Lite拉模式+offset

public class LitePullConsumerAssign {

public static volatile boolean running = true;

public static void main(String[] args) throws Exception {

DefaultLitePullConsumer litePullConsumer = new DefaultLitePullConsumer("lite_pull_consumer_test");

litePullConsumer.setNamesrvAddr("192.168.131.171:9876");

litePullConsumer.setAutoCommit(false);

litePullConsumer.start();

Collection<MessageQueue> mqSet = litePullConsumer.fetchMessageQueues("TopicTest");

List<MessageQueue> list = new ArrayList<>(mqSet);

List<MessageQueue> assignList = new ArrayList<>();

for (int i = 0; i < list.size() / 2; i++) {

assignList.add(list.get(i));

}

litePullConsumer.assign(assignList);

litePullConsumer.seek(assignList.get(0), 10);

try {

while (running) {

List<MessageExt> messageExts = litePullConsumer.poll();

System.out.printf("%s %n", messageExts);

litePullConsumer.commitSync();

}

} finally {

litePullConsumer.shutdown();

}

}

}

在实际使用中,可以将这个offset存储到redis中。

二、消息模型

1、顺序消息

1、生产者

模拟订单发送:

public class Producer {

public static void main(String[] args) throws UnsupportedEncodingException {

try {

DefaultMQProducer producer = new DefaultMQProducer("group_test_order");

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

for (int i = 0; i < 10; i++) {

int orderId = i;

for (int j = 0; j <= 5; j++) {

Message msg =

new Message("OrderTopicTest", "order_" + orderId, "KEY" + orderId,

("order_" + orderId + " step " + j).getBytes(RemotingHelper.DEFAULT_CHARSET));

// MessageQueueSelector队列选择器

SendResult sendResult = producer.send(msg, new MessageQueueSelector() {

@Override

public MessageQueue select(List<MessageQueue> mqs, Message msg, Object arg) {

// 将order_X相等的消息存储到相同的队列中去:一个topic下默认有多个队列!

Integer id = (Integer) arg;

int index = id % mqs.size();

return mqs.get(index);

}

}, orderId);

System.out.printf("%s%n", sendResult);

}

}

producer.shutdown();

} catch (MQClientException | RemotingException | MQBrokerException | InterruptedException e) {

e.printStackTrace();

}

}

}

此时OrderTopic_Test这个主题下面存在4个队列。生产者需要将order_id相等的消息放到同一个队列中去。

2、消费者

public class Consumer {

public static void main(String[] args) throws MQClientException {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("group_test_order");

consumer.setNamesrvAddr("192.168.131.171:9876");

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_LAST_OFFSET);

consumer.subscribe("OrderTopicTest", "*");

consumer.registerMessageListener(new MessageListenerOrderly() {

@Override

public ConsumeOrderlyStatus consumeMessage(List<MessageExt> msgs, ConsumeOrderlyContext context) {

context.setAutoCommit(true);

for(MessageExt msg:msgs){

System.out.println("收到消息内容 "+new String(msg.getBody()));

}

return ConsumeOrderlyStatus.SUCCESS;

}

});

// 这样是保证不了最终消费顺序的。

// consumer.registerMessageListener(new MessageListenerConcurrently() {

// @Override

// public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs, ConsumeConcurrentlyContext context) {

// for(MessageExt msg:msgs){

// System.out.println("收到消息内容 "+new String(msg.getBody()));

// }

// return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

// }

// });

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

然后我们启动两个消费者,再启动生产者。我们可以看到,发送的消息被这两个消费者平均消费了。

并且我们可以观察到,每一个order_*被消费的时候,都是按照顺序被消费的。比如上图的order_2 step 0 ~ order_2 step 5。中间虽然有其他的order,但是局部order_2的顺序还是被保持的。

即RocketMQ顺序消息可以保证消息消费的局部顺序性!但不保证全局顺序性。

实现原理是:普通情况下消费消息的时候是从多个队列中同时获取,为了保证顺序,那么消费的时候就先从一个队列中拿多条,拿完之后再拿其他队列的。

验证时,可以启动多个Consumer实例,观察下每一个订单的消息分配以及每个订单下多个步骤的消费顺序。

不管订单在多个Consumer实例之前是如何分配的,每个订单下的多条消息顺序都是固定从0~5的。

RocketMQ保证的是消息的局部有序,而不是全局有序。

先从控制台上看下List mqs是什么。

再回看我们的样例,实际上,RocketMQ也只保证了每个OrderID的所有消息有序(发到了同一个queue),而并不能保证所有消息都有序。所以这就涉及到了RocketMQ消息有序的原理。要保证最终消费到的消息是有序的,需要从Producer、Broker、Consumer三个步骤都保证消息有序才行。

首先在发送者端:在默认情况下,消息发送者会采取Round Robin轮询方式把消息发送到不同的MessageQueue(分区队列),而消费者消费的时候也从多个MessageQueue上拉取消息,这种情况下消息是不能保证顺序的。而只有当一组有序的消息发送到同一个MessageQueue上时,才能利用MessageQueue先进先出的特性保证这一组消息有序。

而Broker中一个队列内的消息是可以保证有序的。

然后在消费者端:消费者会从多个消息队列上去拿消息。这时虽然每个消息队列上的消息是有序的,但是多个队列之间的消息仍然是乱序的。消费者端要保证消息有序,就需要按队列一个一个来取消息,即取完一个队列的消息后,再去取下一个队列的消息。而给consumer注入的MessageListenerOrderly对象,在RocketMQ内部就会通过锁队列的方式保证消息是一个一个队列来取的。MessageListenerConcurrently这个消息监听器则不会锁队列,每次都是从多个Message中取一批数据(默认不超过32条)。因此也无法保证消息有序。

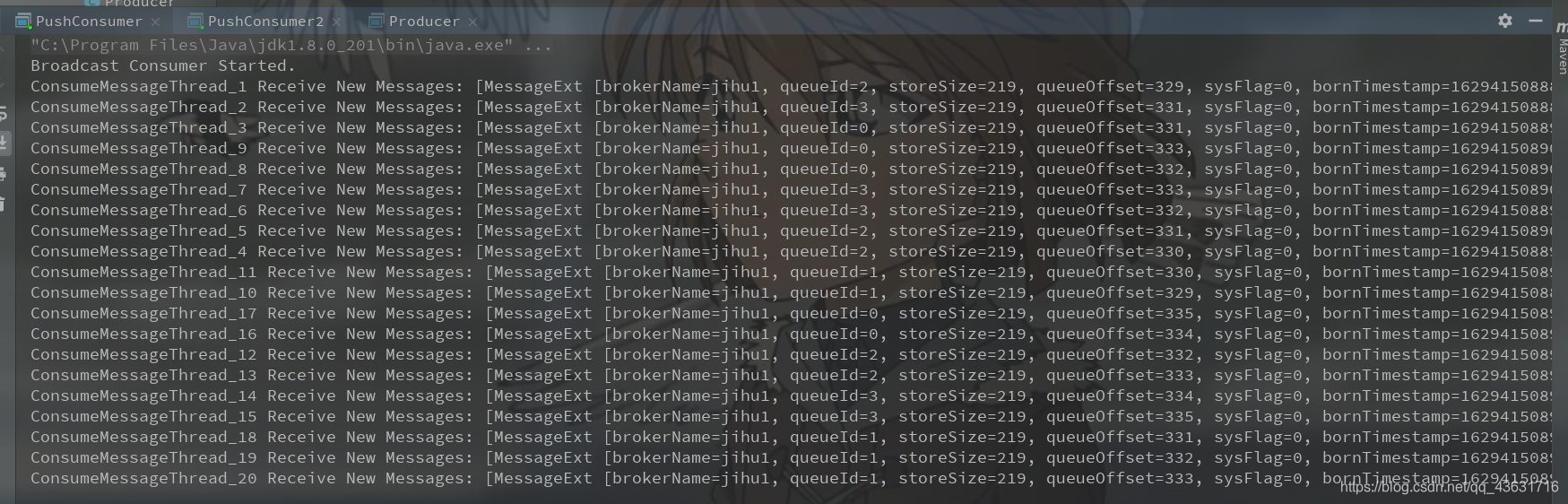

2、广播消息

广播消息并没有特定的消息消费者样例,这是因为这涉及到消费者的集群消费模式。在集群状态(MessageModel.CLUSTERING)下,每一条消息只会被同一个消费者组中的一个实例消费到(这跟kafka和rabbitMQ的集群模式是一样的)。而广播模式则是把消息发给了所有订阅了对应主题的消费者,而不管消费者是不是同一个消费者组。

public class PushConsumer {

public static void main(String[] args) throws InterruptedException, MQClientException {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("Jihu_group_test2");

consumer.setNamesrvAddr("192.168.131.171:9876");

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_LAST_OFFSET);

// 设置消费类型为广播模式

consumer.setMessageModel(MessageModel.BROADCASTING);

consumer.subscribe("TopicTest", "*");

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs,

ConsumeConcurrentlyContext context) {

System.out.printf("%s Receive New Messages: %s %n", Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

consumer.start();

System.out.printf("Broadcast Consumer Started.%n");

}

}

我们启动两个消费者,然后启动生产者:

可以看到,两个消费者消费了相同的消息,这就是广播模式。

3、延迟消息

延迟消息实现的效果就是在调用producer.send方法后,消息并不会立即发送出去,而是会等一段时间再发送出去。这是RocketMQ特有的一个功能。

那会延迟多久呢?延迟时间的设置就是在Message消息对象上设置一个延迟级别message.setDelayTimeLevel(3);

开源版本的RocketMQ中,对延迟消息并不支持任意时间的延迟设定(商业版本中支持),而是只支持18个固定的延迟级别,1到18分别对应messageDelayLevel=1s 5s 10s 30s 1m 2m 3m 4m 5m 6m 7m 8m 9m 10m 20m 30m 1h 2h。这从哪里看出来的?其实从rocketmq-console控制台就能看出来。而这18个延迟级别也支持自行定义,不过一般情况下最好不要自定义修改。

那这么好用的延迟消息是怎么实现的?这18个延迟级别除了在延迟消息中用,还有什么地方用到了?

public class Producer {

public static void main(String[] args) throws MQClientException, InterruptedException {

/*

* Instantiate with a producer group name.

*/

DefaultMQProducer producer = new DefaultMQProducer("Jihu_group_test1");

/*

* Specify name server addresses.

* <p/>

*

* Alternatively, you may specify name server addresses via exporting environmental variable: NAMESRV_ADDR

* <pre>

* {@code

* producer.setNamesrvAddr("name-server1-ip:9876;name-server2-ip:9876");

* }

* </pre>

*/

producer.setNamesrvAddr("192.168.131.171:9876");

/*

* Launch the instance.

*/

producer.start();

for (int i = 0; i < 2; i++) {

try {

/*

* Create a message instance, specifying topic, tag and message body.

*/

Message msg = new Message("TopicTest" /* Topic */,

"TagA" /* Tag */,

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET) /* Message body */

);

//messageDelayLevel=1s 5s 10s 30s 1m 2m 3m 4m 5m 6m 7m 8m 9m 10m 20m 30m 1h 2h

msg.setDelayTimeLevel(3);

/*

* Call send message to deliver message to one of brokers.

*/

SendResult sendResult = producer.send(msg);

System.out.printf("%s%n", sendResult);

} catch (Exception e) {

e.printStackTrace();

Thread.sleep(1000);

}

}

/*

* Shut down once the producer instance is not longer in use.

*/

producer.shutdown();

}

}

这样,消息延迟后消费者才能收到消息。

注意,延时队列和消费者没关系,是生产者延迟后将消息传递!

这里为什么是18个级别呢?

其实在系统的主题中存在一个叫SCHEDULE_TOPIC_XXXX的主题,里面有18个延迟队列,分别对应不同的时长。

4、批量消息

批量消息是指将多条消息合并成一个批量消息,一次发送出去。这样的好处是可以减少网络IO,提升吞吐量。

相信大家在官网以及测试代码中都看到了关键的注释:如果批量消息大于1MB就不要用一个批次发送,而要拆分成多个批次消息发送。也就是说,一个批次消息的大小不要超过1MB

实际使用时,这个1MB的限制可以稍微扩大点,实际最大的限制是4194304字节,大概4MB。但是使用批量消息时,这个消息长度确实是必须考虑的一个问题。 而且批量消息的使用是有一定限制的,这些消息应该有相同的Topic,相同的waitStoreMsgOK。而且不能是延迟消息、事务消息等。

public class SimpleBatchProducer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("BatchProducerGroupName");

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

//If you just send messages of no more than 1MiB at a time, it is easy to use batch

//Messages of the same batch should have: same topic, same waitStoreMsgOK and no schedule support

String topic = "BatchTest";

List<Message> messages = new ArrayList<>();

messages.add(new Message(topic, "Tag", "OrderID001", "Hello world 0".getBytes()));

messages.add(new Message(topic, "Tag", "OrderID002", "Hello world 1".getBytes()));

messages.add(new Message(topic, "Tag", "OrderID003", "Hello world 2".getBytes()));

producer.send(messages);

producer.shutdown();

}

}

那假如我现在有1W条消息,该怎么发送呢?

我们可以将消息拆分开来发送:

public class SplitBatchProducer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("BatchProducerGroupName");

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

//large batch

String topic = "BatchTest";

List<Message> messages = new ArrayList<>(100 * 1000);

for (int i = 0; i < 100 * 1000; i++) {

messages.add(new Message(topic, "Tag", "OrderID" + i, ("Hello world " + i).getBytes()));

}

// producer.send(messages);

//split the large batch into small ones:

ListSplitter splitter = new ListSplitter(messages);

while (splitter.hasNext()) {

List<Message> listItem = splitter.next();

producer.send(listItem);

}

producer.shutdown();

}

}

class ListSplitter implements Iterator<List<Message>> {

private int sizeLimit = 1000 * 1000;

private final List<Message> messages;

private int currIndex;

public ListSplitter(List<Message> messages) {

this.messages = messages;

}

@Override

public boolean hasNext() {

return currIndex < messages.size();

}

@Override

public List<Message> next() {

int nextIndex = currIndex;

int totalSize = 0;

for (; nextIndex < messages.size(); nextIndex++) {

Message message = messages.get(nextIndex);

int tmpSize = message.getTopic().length() + message.getBody().length;

Map<String, String> properties = message.getProperties();

for (Map.Entry<String, String> entry : properties.entrySet()) {

tmpSize += entry.getKey().length() + entry.getValue().length();

}

tmpSize = tmpSize + 20; //for log overhead

if (tmpSize > sizeLimit) {

//it is unexpected that single message exceeds the sizeLimit

//here just let it go, otherwise it will block the splitting process

if (nextIndex - currIndex == 0) {

//if the next sublist has no element, add this one and then break, otherwise just break

nextIndex++;

}

break;

}

if (tmpSize + totalSize > sizeLimit) {

break;

} else {

totalSize += tmpSize;

}

}

List<Message> subList = messages.subList(currIndex, nextIndex);

currIndex = nextIndex;

return subList;

}

@Override

public void remove() {

throw new UnsupportedOperationException("Not allowed to remove");

}

}

5、过滤消息

在大多数情况下,可以使用Message的Tag属性来简单快速的过滤信息。

生产者:

public class TagFilterProducer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("filter_group");

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

String[] tags = new String[] {"TagA", "TagB", "TagC"};

for (int i = 0; i < 15; i++) {

Message msg = new Message("TagFilterTest",

// 轮训tag

tags[i % tags.length],

"Hello world".getBytes(RemotingHelper.DEFAULT_CHARSET));

SendResult sendResult = producer.send(msg);

System.out.printf("%s%n", sendResult);

}

producer.shutdown();

}

}

消费者:

public class TagFilterConsumer {

public static void main(String[] args) throws InterruptedException, MQClientException, IOException {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("filter_group");

consumer.setNamesrvAddr("192.168.131.171:9876");

// "TagA || TagC": topic TagFilterTest 下的tagA 或者TagC

consumer.subscribe("TagFilterTest", "TagA || TagC");

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs,

ConsumeConcurrentlyContext context) {

System.out.printf("%s Receive New Messages: %s %n", Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

主要是看消息消费者。consumer.subscribe(“TagFilterTest”, “TagA || TagC”); 这句只订阅TagA和TagC的消息。

TAG是RocketMQ中特有的一个消息属性。RocketMQ的最佳实践中就建议,使用RocketMQ时,一个应用可以就用一个Topic,而应用中的不同业务就用TAG来区分。

注意,此时从消费者的设置来看,只能接受topic "TagFilterTest"下的TagA 或者TagC,我们来验证一下:

这里的实现和我们想的可能不太一样,我们可以可能会认为是将消息全部发送到Broker中,然后Broker推送给消费者的时候进行过滤。

但是RocketMQ是直接在Broker中过滤,直接在Broker中将消息过滤好,到时候直接推送给消费者,这样可以减少网络IO。

但是,这种方式有一个很大的限制,就是一个消息只能有一个TAG,这在一些比较复杂的场景就有点不足了。 这时候,可以使用SQL表达式来对消息进行过滤。

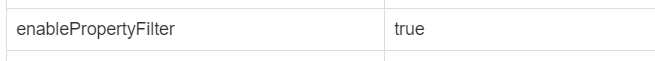

5.1、SQL表达式过滤

注意:在使用sql表达式的时候要开启配置,否则启动消费者会报错:

查看此时未开启,我们需要在broker的conf目录下的broker.conf中配置:

enablePropertyFilter=true

注意:

配置的集群,需要修改2m-2s-sync文件夹下的配置文件:

补充说明:使用RocketMQ-4.7.1的版本时,可能出现修改broker.conf配置,按照上述方法重启无效的问题。这是可以采用mqadmin命令来手动更新设置,命令如下:

mqadmin.cmd updateBrokerConfig -blocalhost:10911 -kenablePropertyFilter -vtrue

mqadmin.cmd updateBrokerConfig -blocalhost:10911 -kfilterSupportRetry -vtrue

更新后查看:

这时候我们就可以正常启动sql过滤了。

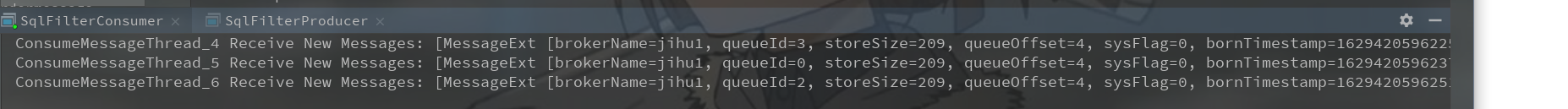

消费者:

public class SqlFilterConsumer {

public static void main(String[] args) throws Exception {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("sql_filter_group");

consumer.setNamesrvAddr("192.168.131.171:9876");

// Don't forget to set enablePropertyFilter=true in broker

consumer.subscribe("SqlFilterTest",

MessageSelector.bySql("(TAGS is not null and TAGS in ('TagA', 'TagB'))" +

"and (a is not null and a between 0 and 3)"));

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs,

ConsumeConcurrentlyContext context) {

System.out.printf("%s Receive New Messages: %s %n", Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

生产者:

public class SqlFilterProducer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("sql_filter_group");

producer.setNamesrvAddr("192.168.131.171:9876");

producer.start();

String[] tags = new String[]{"TagA", "TagB", "TagC"};

for (int i = 0; i < 15; i++) {

Message msg = new Message("SqlFilterTest",

tags[i % tags.length],

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET)

);

msg.putUserProperty("a", String.valueOf(i));

SendResult sendResult = producer.send(msg);

System.out.printf("%s%n", sendResult);

}

producer.shutdown();

}

}

可以看到,15条消息,消费者只消费了3条。这里的过滤条件是TagA和TagB,并且内容是0~3之间。

这个模式的关键是在消费者端使用MessageSelector.bySql(String sql)返回的一个MessageSelector。这里面的sql语句是按照SQL92标准来执行的。sql中可以使用的参数有默认的TAGS和一个在生产者中加入的a属性。

SQL92语法:

RocketMQ只定义了一些基本语法来支持这个特性。你也可以很容易地扩展它。

数值比较,比如:>,>=,<,<=,BETWEEN,=; 字符比较,比如:=,<>,IN; IS NULL 或者 IS NOT NULL;

逻辑符号 AND,OR,NOT; 常量支持类型为:数值,比如:123,3.1415; 字符,比如:‘abc’,必须用单引号包裹起来; NULL,特殊的常量 布尔值,TRUE 或 FALSE

使用注意:只有推模式的消费者可以使用SQL过滤。拉模式是用不了的。

大家想一下,这个消息过滤是在Broker端进行的还是在Consumer端进行的?

6、事务消息

事务消息是RocketMQ提供的一个非常有特色的功能,需要着重理解。

首先,我们了解下什么是事务消息。官网的介绍是:事务消息是在分布式系统中保证最终一致性的两阶段提交的消息实现。他可以保证本地事务执行与消息发送两个操作的原子性,也就是这两个操作一起成功或者一起失败。

其次,我们来理解下事务消息的编程模型。事务消息只保证消息发送者的本地事务与发消息这两个操作的原子性,因此,事务消息的示例只涉及到消息发送者,对于消息消费者来说,并没有什么特别的。

消费者

public class Consumer {

public static void main(String[] args) throws MQClientException {

// 定义一个消息组

// DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("Jihu_group_test1");

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("transaction_test_group");

// 也可以通过NAMESRV_ADDR环境变量来指定

consumer.setNamesrvAddr("192.168.131.171:9876");

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_LAST_OFFSET);

consumer.subscribe("TopicTest", "*");

consumer.registerMessageListener(new MessageListenerConcurrently() {

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs,

ConsumeConcurrentlyContext context) {

System.out.printf("%s 收到了新的消息: %s %n", Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

生产者:

public class TransactionProducer {

public static void main(String[] args) throws MQClientException, InterruptedException {

TransactionListener transactionListener = new TransactionListenerImpl();

TransactionMQProducer producer = new TransactionMQProducer("transaction_test_group");

producer.setNamesrvAddr("192.168.131.171:9876");

ExecutorService executorService = new ThreadPoolExecutor(2, 5, 100, TimeUnit.SECONDS, new ArrayBlockingQueue<Runnable>(2000), new ThreadFactory() {

@Override

public Thread newThread(Runnable r) {

Thread thread = new Thread(r);

thread.setName("client-transaction-msg-check-thread");

return thread;

}

});

producer.setExecutorService(executorService);

// 注入事务监听器

producer.setTransactionListener(transactionListener);

producer.start();

String[] tags = new String[] {"TagA", "TagB", "TagC", "TagD", "TagE"};

for (int i = 0; i < 10; i++) {

try {

// 轮训tag发送消息

Message msg =

new Message("TopicTest", tags[i % tags.length], "KEY" + i,

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET));

// 发送事务消息,此时会执行事务监听器的executeLocalTransaction方法

SendResult sendResult = producer.sendMessageInTransaction(msg, null);

System.out.printf("%s%n", sendResult);

Thread.sleep(10);

} catch (MQClientException | UnsupportedEncodingException e) {

e.printStackTrace();

}

}

for (int i = 0; i < 100000; i++) {

Thread.sleep(1000);

}

producer.shutdown();

}

}

注意,事务消息还需要一个事务监听器:

public class TransactionListenerImpl implements TransactionListener {

private AtomicInteger transactionIndex = new AtomicInteger(0);

private ConcurrentHashMap<String, Integer> localTrans = new ConcurrentHashMap<>();

//在提交完事务消息后执行。

//返回COMMIT_MESSAGE状态的消息会立即被消费者消费到。

//返回ROLLBACK_MESSAGE状态的消息会被丢弃。

//返回UNKNOWN状态的消息会由Broker过一段时间再来回查事务的状态。

@Override

public LocalTransactionState executeLocalTransaction(Message msg, Object arg) {

// int value = transactionIndex.getAndIncrement();

// int status = value % 3;

// localTrans.put(msg.getTransactionId(), status);

// return LocalTransactionState.UNKNOW;

String tags = msg.getTags();

//TagA的消息会立即被消费者消费到

if (StringUtils.contains(tags, "TagA")) {

return LocalTransactionState.COMMIT_MESSAGE;

//TagB的消息会被丢弃

} else if (StringUtils.contains(tags, "TagB")) {

return LocalTransactionState.ROLLBACK_MESSAGE;

//其他消息会等待Broker进行事务状态回查。

} else {

return LocalTransactionState.UNKNOW;

}

}

//在对UNKNOWN状态的消息进行状态回查时执行。返回的结果是一样的。

@Override

public LocalTransactionState checkLocalTransaction(MessageExt msg) {

// Integer status = localTrans.get(msg.getTransactionId());

// if (null != status) {

// switch (status) {

// case 0:

// return LocalTransactionState.UNKNOW;

// case 1:

// return LocalTransactionState.COMMIT_MESSAGE;

// case 2:

// return LocalTransactionState.ROLLBACK_MESSAGE;

// default:

// return LocalTransactionState.COMMIT_MESSAGE;

// }

// }

// return LocalTransactionState.COMMIT_MESSAGE;

String tags = msg.getTags();

//TagC的消息过一段时间会被消费者消费到

if (StringUtils.contains(tags, "TagC")) {

return LocalTransactionState.COMMIT_MESSAGE;

//TagD的消息也会在状态回查时被丢弃掉

} else if (StringUtils.contains(tags, "TagD")) {

return LocalTransactionState.ROLLBACK_MESSAGE;

//剩下TagE的消息会在多次状态回查后最终丢弃

} else {

return LocalTransactionState.UNKNOW;

}

}

}

事务消息的关键是在TransactionMQProducer中指定了一个TransactionListener事务监听器,这个事务监听器就是事务消息的关键控制器。源码中的案例有点复杂,我这里准备了一个更清晰明了的事务监听器示例

当我们调用sendMessageInTransaction方法后,首先会执行监听器中的executeLocalTransaction方法,过了端时间后,才会执行checkLocalTransaction方法再去查看和执行消息。

所以,也是为什么我们测试的时候先收到两条TagA的消息,一段时间后才收到了TagC的消息。

我们来总结一下事务消息流程:

比如说我们现在有一个下单业务,我们来分析一下具体事务步骤。

1、首先订单系统一开始就要向RocketMQ发送一个half即一半消息并获得返回结果,而这个half消息对下游服务是不可见的。

疑问:为什么需要在执行本地事务之前发送half消息呢?

发送half消息的目的是检查RocketMQ服务目前是否可用,用来提醒接下来将会有消息送达。half消息其实就是一种普通的消息,但是它对下游服务是不可见的。

2、经过half消息验证RocketMQ服务正常后,执行本地事务,去MySQL下单。

3、本地事务执行之后会将结果返回给RocketMQ,这时候RocketMQ可以根据返回的本地事务状态来决定接下来动作。如果本地事务执行成功,则将事务消息提交给下游服务;如果本地事务执行失败,则则丢弃该条事务消息。注意,这些操作都是异步执行的,比如RocketMQ不会等待本地事务执行成功后才去将这个装填返回给MQ, 而是过一段时间就去做这个动作。所以状态中才有了一个UN_KNOW。如果是UN_KNOW状态,就会执行checkLocalTransaction方法,再一次的去检查事务状态。这个次数默认是15次。

然后,我们要了解下事务消息的使用限制。

最核心的就是这个事务消息只保证了分布式事务的一半,比如说下单业的确成功了,消息推送给下游服务了。但是如果下游服务失败了呢?

1、事务消息不支持延迟消息和批量消息。

2、为了避免单个消息被检查太多次而导致半队列消息累积,我们默认将单个消息的检查次数限制为 15 次,但是用户可以通过 Broker 配置文件的 transactionCheckMax参数来修改此限制。如果已经检查某条消息超过 N 次的话( N = transactionCheckMax ) 则 Broker 将丢弃此消息,并在默认情况下同时打印错误日志。用户可以通过重写 AbstractTransactionCheckListener 类来修改这个行为。

回查次数是由BrokerConfig.transactionCheckMax这个参数来配置的,默认15次,可以在broker.conf中覆盖。 然后实际的检查次数会在message中保存一个用户属性MessageConst.PROPERTY_TRANSACTION_CHECK_TIMES。这个属性值大于transactionCheckMax,就会丢弃。 这个用户属性值会按回查次数递增,也可以在Producer中自行覆盖这个属性。

3、事务消息将在 Broker 配置文件中的参数 transactionMsgTimeout 这样的特定时间长度之后被检查。当发送事务消息时,用户还可以通过设置用户属性 CHECK_IMMUNITY_TIME_IN_SECONDS 来改变这个限制,该参数优先于 transactionMsgTimeout 参数。

由BrokerConfig.transactionTimeOut这个参数来配置。默认6秒,可以在broker.conf中进行修改。 另外,也可以给消息配置一个MessageConst.PROPERTY_CHECK_IMMUNITY_TIME_IN_SECONDS属性来给消息指定一个特定的消息回查时间。 msg.putUserProperty(MessageConst.PROPERTY_CHECK_IMMUNITY_TIME_IN_SECONDS, “10000”); 这样就是10秒。

4、事务性消息可能不止一次被检查或消费。

5、提交给用户的目标主题消息可能会失败,目前这依日志的记录而定。它的高可用性通过 RocketMQ 本身的高可用性机制来保证,如果希望确保事务消息不丢失、并且事务完整性得到保证,建议使用同步的双重写入机制。

6、事务消息的生产者 ID 不能与其他类型消息的生产者 ID 共享。与其他类型的消息不同,事务消息允许反向查询、MQ服务器能通过它们的生产者 ID 查询到消费者。

接下来,我们还要了解下事务消息的实现机制,参见下图:

事务消息机制的关键是在发送消息时,会将消息转为一个half半消息,并存入RocketMQ内部的一个 RMQ_SYS_TRANS_HALF_TOPIC 这个Topic,这样对消费者是不可见的。再经过一系列事务检查通过后,再将消息转存到目标Topic,这样对消费者就可见了。

最后,我们还需要思考下事务消息的作用。

大家想一下这个事务消息跟分布式事务有什么关系?为什么扯到了分布式事务相关的两阶段提交上了?事务消息只保证了发送者本地事务和发送消息这两个操作的原子性,但是并不保证消费者本地事务的原子性,所以,事务消息只保证了分布式事务的一半。但是即使这样,对于复杂的分布式事务,RocketMQ提供的事务消息也是目前业内最佳的降级方案。

588

588

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?