MyBatis学习笔记(源码分析篇)

前言

MyBatis是一个开源的持久层映射框架,在JavaEE编程领域应用的十分广泛,下面先对MyBatis的使用进行简单的回顾,然后参照代码逐步分析其内部实现原理。如果你对MyBatis的使用还不太了解,请先阅读本系列文档的MyBatis学习笔记(基础使用篇)。

单独使用MyBatis

1) 准备实体类和接口

在进行DAO层操作时,我们一般会抽象出接口,并将查询返回的数据封装在实体类中。

// '文章'实体类(省略 getter/setter和toString,后文亦同)

public class AuthorDO implements Serializable {

private Integer id;

private String name;

private Integer age;

private SexEnum sex;

private String email;

private List<ArticleDO> articles;

}

// '作者'实体类

public class ArticleDO implements Serializable {

private Integer id;

private String title;

private ArticleTypeEnum type;

private String content;

private Date createTime;

private AuthorDO author;

}

// 查询文章的相关方法

public interface ArticleDao {

ArticleDO findOne(@Param("id") int id);

}

// 查询作者的相关方法

public interface AuthorDao {

AuthorDO findOne(@Param("id") int id);

}

2) 引入MyBatis及相关依赖

<dependencies>

<!-- MyBatis框架 -->

<dependency>

<groupId>org.mybatis</groupId>

<artifactId>mybatis</artifactId>

<version>3.4.5</version>

</dependency>

<!-- 数据库驱动 -->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.6</version>

</dependency>

<!-- 测试框架 -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

<!-- 日志框架 -->

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

</dependency>

</dependencies>

3) 主配置文件

<!-- mybatis-congif.xml -->

<configuration>

<properties resource="jdbc.properties"/>

<typeAliases>

<typeAlias alias="Article" type="xyz.coolblog.model.ArticleDO"/>

<typeAlias alias="Author" type="xyz.coolblog.model.AuthorDO"/>

</typeAliases>

<typeHandlers>

<typeHandler handler="xyz.coolblog.mybatis.ArticleTypeHandler" javaType="xyz.coolblog.constant.ArticleTypeEnum"/>

</typeHandlers>

<environments default="development">

<environment id="development">

<transactionManager type="JDBC"/>

<dataSource type="POOLED">

<property name="driver" value="${jdbc.driver}"/>

<property name="url" value="${jdbc.url}"/>

<property name="username" value="${jdbc.username}"/>

<property name="password" value="${jdbc.password}"/>

</dataSource>

</environment>

</environments>

<mappers>

<mapper resource="mapper/AuthorMapper.xml"/>

<mapper resource="mapper/ArticleMapper.xml"/>

</mappers>

</configuration>

4) 映射配置文件

<!-- AuthorMapper.xml -->

<mapper namespace="xyz.coolblog.dao.AuthorDao">

<resultMap id="articleResult" type="Article">

<id property="id" column="article_id" />

<result property="title" column="title"/>

<result property="type" column="type"/>

<result property="content" column="content"/>

<result property="createTime" column="create_time"/>

</resultMap>

<resultMap id="authorResult" type="Author">

<id property="id" column="id"/>

<result property="name" column="name"/>

<result property="age" column="age"/>

<result property="sex" column="sex" typeHandler="org.apache.ibatis.type.EnumOrdinalTypeHandler"/>

<result property="email" column="email"/>

<collection property="articles" ofType="Article" resultMap="articleResult"/>

</resultMap>

<select id="findOne" resultMap="authorResult">

SELECT

au.id, au.name, au.age, au.sex, au.email,

ar.id as article_id, ar.title, ar.type, ar.content, ar.create_time

FROM

author au, article ar

WHERE

au.id = ar.author_id AND au.id = #{id}

</select>

</mapper>

<!-- ArticleMapper.xml -->

<mapper namespace="xyz.coolblog.dao.ArticleDao">

<resultMap id="authorResult" type="Author">

<id property="id" column="author_id"/>

<result property="name" column="name"/>

<result property="age" column="age"/>

<result property="sex" column="sex" typeHandler="org.apache.ibatis.type.EnumOrdinalTypeHandler"/>

<result property="email" column="email"/>

</resultMap>

<resultMap id="articleResult" type="Article">

<id property="id" column="id" />

<result property="title" column="title"/>

<result property="type" column="type" typeHandler="xyz.coolblog.mybatis.ArticleTypeHandler"/>

<result property="content" column="content"/>

<result property="createTime" column="create_time"/>

<association property="author" javaType="Author" resultMap="authorResult"/>

</resultMap>

<select id="findOne" resultMap="articleResult">

SELECT

ar.id, ar.author_id, ar.title, ar.type, ar.content, ar.create_time,

au.name, au.age, au.sex, au.email

FROM

article ar, author au

WHERE

ar.author_id = au.id AND ar.id = #{id}

</select>

</mapper>

5) 进行简单测试

public class MyBatisTest {

private SqlSessionFactory sqlSessionFactory;

@Before

public void prepare() throws IOException {

InputStream inputStream = Resources.getResourceAsStream("mybatis-config.xml");

sqlSessionFactory = new SqlSessionFactoryBuilder().build(inputStream);

inputStream.close();

}

@Test

public void testOne2One() {

SqlSession session = sqlSessionFactory.openSession();

try {

ArticleDao articleDao = session.getMapper(ArticleDao.class);

ArticleDO article = articleDao.findOne(1);

} finally {

session.close();

}

}

@Test

public void testOne2Many() {

SqlSession session = sqlSessionFactory.openSession();

try {

AuthorDao authorDao = session.getMapper(AuthorDao.class);

AuthorDO author = authorDao.findOne(1);

} finally {

session.close();

}

}

}

在Spring中使用MyBatis

1) 引入整合依赖

MyBatis和Spring是两个不相关的框架,要想把两者整合起来,则需要一个中间组件,负责加载和解析 MyBatis 相关配置,并且通过Spring提供的扩展点,将创建的DAO层对象放入到容器中。

<!-- MyBatis-Spring整合组件 -->

<dependency>

<groupId>org.mybatis</groupId>

<artifactId>mybatis-spring</artifactId>

<version>1.3.2</version>

</dependency>

2) 修改部分配置

<!-- application-mybatis.xml -->

<beans>

<context:property-placeholder location="jdbc.properties"/>

<!-- 配置数据源 -->

<bean id="dataSource" class="org.apache.ibatis.datasource.pooled.PooledDataSource">

<property name="driver" value="${jdbc.driver}" />

<property name="url" value="${jdbc.url}" />

<property name="username" value="${jdbc.username}" />

<property name="password" value="${jdbc.password}" />

</bean>

<!-- 配置 SqlSessionFactory -->

<bean id="sqlSessionFactory" class="org.mybatis.spring.SqlSessionFactoryBean">

<!-- 配置 mybatis-config.xml 路径 -->

<property name="configLocation" value="classpath:mybatis-config.xml"/>

<!-- 给 SqlSessionFactory 配置数据源,这里引用上面的数据源配置 -->

<property name="dataSource" ref="dataSource"/>

<!-- 配置 SQL 映射文件 -->

<property name="mapperLocations" value="mapper/*.xml"/>

</bean>

<!-- 配置 MapperScannerConfigurer -->

<bean class="org.mybatis.spring.mapper.MapperScannerConfigurer">

<!-- 配置 Dao 接口所在的包 -->

<property name="basePackage" value="xyz.coolblog.dao"/>

</bean>

</beans>

<!-- mybatis-config.xml -->

<configuration>

<settings>

<setting name="cacheEnabled" value="true"/>

</settings>

<typeAliases>

<typeAlias alias="Article" type="xyz.coolblog.model.ArticleDO"/>

<typeAlias alias="Author" type="xyz.coolblog.model.AuthorDO"/>

</typeAliases>

<typeHandlers>

<typeHandler handler="xyz.coolblog.mybatis.ArticleTypeHandler" javaType="xyz.coolblog.constant.ArticleTypeEnum"/>

</typeHandlers>

</configuration>

3) 进行测试

@RunWith(SpringJUnit4ClassRunner.class)

@ContextConfiguration("classpath:application-mybatis.xml")

public class SpringWithMyBatisTest implements ApplicationContextAware {

private ApplicationContext applicationContext;

/** 自动注入 AuthorDao,无需再通过 SqlSession 获取 */

@Autowired

private AuthorDao authorDao;

@Autowired

private ArticleDao articleDao;

@Test

public void testOne2One() {

ArticleDO article = articleDao.findOne(1);

}

@Test

public void testOne2Many() {

AuthorDO author = authorDao.findOne(1);

}

@Override

public void setApplicationContext(ApplicationContext applicationContext) throws BeansException {

this.applicationContext = applicationContext;

}

}

第一章 配置文件解析过程

在本章节中,将从 MyBatis 解析配置文件的过程着手进行分析,并会在分析的过程中,向大家介绍一些配置的使用方式和用途。

第一节 配置文件解析入口

在单独使用 MyBatis 时,第一步要做的事情就是根据配置文件构建SqlSessionFactory对象。

// 使用工具类 Resources 将配置文件转换为输入流

InputStream inputStream = Resources.getResourceAsStream("mybatis-config.xml");

// 使用构造器 SqlSessionFactoryBuilder 构造会话工厂

SqlSessionFactory sqlSessionFactory = new SqlSessionFactoryBuilder().build(inputStream);

显而易见,这里的 build 方法是我们分析配置文件解析过程的入口方法。

// -☆- SqlSessionFactoryBuilder

public SqlSessionFactory build(InputStream inputStream) {

// 调用重载方法

return build(inputStream, null, null);

}

public SqlSessionFactory build(InputStream inputStream, String environment, Properties properties) {

try {

// 创建配置文件解析器

XMLConfigBuilder parser = new XMLConfigBuilder(inputStream, environment, properties);

// 调用 parse 方法解析配置文件,生成 Configuration 对象

return build(parser.parse());

} catch (Exception e) {

throw ExceptionFactory.wrapException("Error building SqlSession.", e);

} finally {

ErrorContext.instance().reset();

try {

inputStream.close();

} catch (IOException e) {

// Intentionally ignore. Prefer previous error.

}

}

}

public SqlSessionFactory build(Configuration config) {

// 创建 DefaultSqlSessionFactory

return new DefaultSqlSessionFactory(config);

}

从上面的代码中,我们大致可以猜出 MyBatis 配置文件是通过XMLConfigBuilder进行解析的。不过目前这里还没有非常明确的解析逻辑,所以我们继续往下看parse方法。

// -☆- XMLConfigBuilder

public Configuration parse() {

if (parsed) {

throw new BuilderException("Each XMLConfigBuilder can only be used once.");

}

parsed = true;

// 解析配置

parseConfiguration(parser.evalNode("/configuration"));

return configuration;

}

到这里大家可以看到一些端倪了,注意一个 xpath 表达式/configuration。这个表达式代表的是 MyBatis 的<configuration/>标签,这里选中这个标签,并传递给parseConfiguration方法。我们继续跟下去。

private void parseConfiguration(XNode root) {

try {

// 解析 properties 配置

propertiesElement(root.evalNode("properties"));

// 解析 settings 配置,并将其转换为 Properties 对象

Properties settings = settingsAsProperties(root.evalNode("settings"));

// 加载 vfs

loadCustomVfs(settings);

// 解析 typeAliases 配置

typeAliasesElement(root.evalNode("typeAliases"));

// 解析 plugins 配置

pluginElement(root.evalNode("plugins"));

// 解析 objectFactory 配置

objectFactoryElement(root.evalNode("objectFactory"));

// 解析 objectWrapperFactory 配置

objectWrapperFactoryElement(root.evalNode("objectWrapperFactory"));

// 解析 reflectorFactory 配置

reflectorFactoryElement(root.evalNode("reflectorFactory"));

// settings 中的信息设置到 Configuration 对象中

settingsElement(settings);

// 解析 environments 配置

environmentsElement(root.evalNode("environments"));

// 解析 databaseIdProvider,获取并设置 databaseId 到 Configuration 对象

databaseIdProviderElement(root.evalNode("databaseIdProvider"));

// 解析 typeHandlers 配置

typeHandlerElement(root.evalNode("typeHandlers"));

// 解析 mappers 配置

mapperElement(root.evalNode("mappers"));

} catch (Exception e) {

throw new BuilderException("Error parsing SQL Mapper Configuration. Cause: " + e, e);

}

}

到此,一个 MyBatis 的解析过程就出来了,每个配置的解析逻辑都封装在了相应的方法中。在下面分析过程中,我不打算按照方法调用的顺序进行分析,我会适当进行一定的调整。同时,MyBatis 中配置较多,对于一些不常用的配置,这里会略过。那下面我们开始进行分析吧。

第二节 解析 properties 配置

解析properties节点是由propertiesElement这个方法完成的,该方法的逻辑比较简单。在分析方法源码前,先来看一下 properties 节点的配置内容。

<properties resource="jdbc.properties">

<property name="jdbc.username" value="coolblog"/>

<property name="hello" value="world"/>

</properties>

参照上面的配置,来分析一下 propertiesElement 的逻辑。相关分析如下。

// -☆- XMLConfigBuilder

private void propertiesElement(XNode context) throws Exception {

if (context != null) {

// 将子节点配置的"属性:值"转换到 defaults (Properties类型),方便后面使用

Properties defaults = context.getChildrenAsProperties();

// 获取 resource 和 url 属性的值

String resource = context.getStringAttribute("resource");

String url = context.getStringAttribute("url");

// 不能同时配置 resource 和 url

if (resource != null && url != null) {

throw new BuilderException("The properties element cannot specify both a URL and a resource based property file reference. Please specify one or the other.");

}

if (resource != null) {

// 从文件系统中加载并解析属性文件 => defaults(可能会覆盖子节点中配置的属性)

defaults.putAll(Resources.getResourceAsProperties(resource));

} else if (url != null) {

// 通过 url 加载并解析属性文件 => defaults(可能会覆盖子节点中配置的属性)

defaults.putAll(Resources.getUrlAsProperties(url));

}

// 获取Configuration中的全局变量 => defaults

Properties vars = configuration.getVariables();

if (vars != null) {

defaults.putAll(vars);

}

// 把 defaults 设置到 parser 和 configuration 中

parser.setVariables(defaults);

configuration.setVariables(defaults);

}

}

// 扩展:将子节点的"属性:值"转换为Properties集合

public Properties getChildrenAsProperties() {

Properties properties = new Properties();

// 遍历子节点

for (XNode child : getChildren()) {

// 获取 property 节点的 name 和 value 属性

String name = child.getStringAttribute("name");

String value = child.getStringAttribute("value");

// 设置属性到Properties集合中

if (name != null && value != null) {

properties.setProperty(name, value);

}

}

return properties;

}

上面是 properties 节点解析的主要过程,不是很复杂,但需要注意一点,通过 resource 和 url 引用外部Props文件中的属性会覆盖掉子节点配置的属性。

第三节 解析 settings 配置

settings 相关配置是 MyBatis 中非常重要的配置,这些配置用于调整 MyBatis 运行时的行为。settings 配置繁多,在对这些配置不熟悉的情况下,保持默认配置即可,下面先来看一个比较简单的配置。

<settings>

<setting name="cacheEnabled" value="true"/>

<setting name="lazyLoadingEnabled" value="true"/>

<setting name="autoMappingBehavior" value="PARTIAL"/>

</settings>

接下来,对照上面的配置,来分析settingsAsProperties方法源码,并不复杂,只是将setting子节点配置的属性转换为Properties而已。

// -☆- XMLConfigBuilder

private Properties settingsAsProperties(XNode context) {

if (context == null) {

return new Properties();

}

// 将子节点的"属性:值"转换为Properties集合(上节已经分析过了)

Properties props = context.getChildrenAsProperties();

// 创建 Configuration 类的“元信息”对象

MetaClass metaConfig = MetaClass.forClass(Configuration.class, localReflectorFactory);

// 遍历配置的 settings

for (Object key : props.keySet()) {

// 校验 Configuration 中是否存在相关属性(setXxx)

if (!metaConfig.hasSetter(String.valueOf(key))) {

throw new BuilderException("The setting " + key + " is not known. Make sure you spelled it correctly (case sensitive).");

}

}

return props;

}

MetaClass:用来解析目标类的一些元信息,比如类的成员变量,getter/setter 方法等。关于这个类的逻辑,请查询附录章节。

转换出来的Properties要有一个存放的地方,以使其他代码可以找到这些配置。这个存放地方就是 Configuration 对象,下面就来看一下将 settings 配置设置到 Configuration 对象中的过程。

private void settingsElement(Properties props) {

// 设置 autoMappingBehavior 属性,默认值为 PARTIAL

configuration.setAutoMappingBehavior(AutoMappingBehavior.valueOf(props.getProperty("autoMappingBehavior", "PARTIAL")));

configuration.setAutoMappingUnknownColumnBehavior(AutoMappingUnknownColumnBehavior.valueOf(props.getProperty("autoMappingUnknownColumnBehavior", "NONE")));

// 设置 cacheEnabled 属性,默认值为 true

configuration.setCacheEnabled(booleanValueOf(props.getProperty("cacheEnabled"), true));

configuration.setProxyFactory((ProxyFactory) createInstance(props.getProperty("proxyFactory")));

configuration.setLazyLoadingEnabled(booleanValueOf(props.getProperty("lazyLoadingEnabled"), false));

configuration.setAggressiveLazyLoading(booleanValueOf(props.getProperty("aggressiveLazyLoading"), false));

configuration.setMultipleResultSetsEnabled(booleanValueOf(props.getProperty("multipleResultSetsEnabled"), true));

configuration.setUseColumnLabel(booleanValueOf(props.getProperty("useColumnLabel"), true));

configuration.setUseGeneratedKeys(booleanValueOf(props.getProperty("useGeneratedKeys"), false));

configuration.setDefaultExecutorType(ExecutorType.valueOf(props.getProperty("defaultExecutorType", "SIMPLE")));

configuration.setDefaultStatementTimeout(integerValueOf(props.getProperty("defaultStatementTimeout"), null));

configuration.setDefaultFetchSize(integerValueOf(props.getProperty("defaultFetchSize"), null));

configuration.setDefaultResultSetType(resolveResultSetType(props.getProperty("defaultResultSetType")));

configuration.setMapUnderscoreToCamelCase(booleanValueOf(props.getProperty("mapUnderscoreToCamelCase"), false));

configuration.setSafeRowBoundsEnabled(booleanValueOf(props.getProperty("safeRowBoundsEnabled"), false));

configuration.setLocalCacheScope(LocalCacheScope.valueOf(props.getProperty("localCacheScope", "SESSION")));

configuration.setJdbcTypeForNull(JdbcType.valueOf(props.getProperty("jdbcTypeForNull", "OTHER")));

configuration.setLazyLoadTriggerMethods(stringSetValueOf(props.getProperty("lazyLoadTriggerMethods"), "equals,clone,hashCode,toString"));

configuration.setSafeResultHandlerEnabled(booleanValueOf(props.getProperty("safeResultHandlerEnabled"), true));

configuration.setDefaultScriptingLanguage(resolveClass(props.getProperty("defaultScriptingLanguage")));

// 解析默认的枚举处理器

configuration.setDefaultEnumTypeHandler(resolveClass(props.getProperty("defaultEnumTypeHandler")));

configuration.setCallSettersOnNulls(booleanValueOf(props.getProperty("callSettersOnNulls"), false));

configuration.setUseActualParamName(booleanValueOf(props.getProperty("useActualParamName"), true));

configuration.setReturnInstanceForEmptyRow(booleanValueOf(props.getProperty("returnInstanceForEmptyRow"), false));

configuration.setLogPrefix(props.getProperty("logPrefix"));

configuration.setConfigurationFactory(resolveClass(props.getProperty("configurationFactory")));

}

上面代码就是调用 Configuration 的 setter 方法,就没太多逻辑了。重点需要注意一个resolveClass方法,它的源码如下:

// -☆- BaseBuilder

protected Class<?> resolveClass(String alias) {

if (alias == null) {

return null;

}

try {

// 别名解析

return resolveAlias(alias);

} catch (Exception e) {

throw new BuilderException("Error resolving class. Cause: " + e, e);

}

}

// 别名注册器

protected final TypeAliasRegistry typeAliasRegistry;

// 通过typeAliasRegistry(别名注册器)解析别名为全类名

protected Class<?> resolveAlias(String alias) {

return typeAliasRegistry.resolveAlias(alias);

}

这里出现了一个新的类TypeAliasRegistry,用途就是将别名和类型进行映射,这样就可以用别名表示某个类了,方便使用。既然聊到了别名,那下面我们不妨看看别名的配置的解析过程。

第四节 解析 typeAliases 配置

在MyBatis中,可以为类定义一个简短的别名,在书写配置的时候使用别名来配置,MyBatis在解析配置时会自动将别名替换为对应的全类名。有两种配置方式,第一种是按包进行配置,MyBatis会扫描包路径下的所有类(忽略匿名类/接口/内部类)自动生成别名(可以配合Alias注解自定义别名)。

<typeAliases>

<package name="xyz.coolblog.model1"/>

<package name="xyz.coolblog.model2"/>

</typeAliases>

另一种方式是通过手动的方式,明确为某个类配置别名。

<typeAliases>

<typeAlias alias="article" type="xyz.coolblog.model.Article" />

<typeAlias type="xyz.coolblog.model.Author" />

</typeAliases>

下面我们来看一下两种不同的别名配置是怎样解析的。

// -☆- XMLConfigBuilder

private void typeAliasesElement(XNode parent) {

if (parent != null) {

for (XNode child : parent.getChildren()) {

// ⭐️ 从指定的包中解析别名和类型的映射

if ("package".equals(child.getName())) {

String typeAliasPackage = child.getStringAttribute("name");

configuration.getTypeAliasRegistry().registerAliases(typeAliasPackage);

// ⭐️ 从 typeAlias 节点中解析别名和类型的映射

} else {

// 获取 alias 和 type 属性值,alias 不是必填项,可为空

String alias = child.getStringAttribute("alias");

String type = child.getStringAttribute("type");

try {

// 加载 type 对应的类型

Class<?> clazz = Resources.classForName(type);

// 注册别名到类型的映射

if (alias == null) {

typeAliasRegistry.registerAlias(clazz);

} else {

typeAliasRegistry.registerAlias(alias, clazz);

}

} catch (ClassNotFoundException e) {

throw new BuilderException("Error registering typeAlias for '" + alias + "'. Cause: " + e, e);

}

}

}

}

}

上面的代码通过一个if-else条件分支来处理两种不同的配置,这里我用⭐️标注了出来。下面我们来分别看一下这两种配置方式的解析过程,首先来看一下手动配置方式的解析过程。

1. 从 typeAlias 节点中解析并注册别名

在别名的配置中,type属性是必须要配置的,而alias属性则不是必须的。这个在配置文件的 DTD 中有规定。如果使用者未配置 alias 属性,则需要 MyBatis 自行为目标类型生成别名。对于别名为空的情况,注册别名的任务交由void registerAlias(Class<?>)方法处理。若不为空,则由void registerAlias(String, Class<?>)进行别名注册。这两个方法的分析如下:

private final Map<String, Class<?>> TYPE_ALIASES = new HashMap<String, Class<?>>();

public void registerAlias(Class<?> type) {

// 获取全路径类名的简称

String alias = type.getSimpleName();

Alias aliasAnnotation = type.getAnnotation(Alias.class);

if (aliasAnnotation != null) {

// 从注解中取出别名

alias = aliasAnnotation.value();

}

// 调用重载方法注册别名和类型映射

registerAlias(alias, type);

}

public void registerAlias(String alias, Class<?> value) {

if (alias == null) {

throw new TypeException("The parameter alias cannot be null");

}

// 将别名转成小写

String key = alias.toLowerCase(Locale.ENGLISH);

/*

* 如果 TYPE_ALIASES 中存在了某个类型映射,这里判断当前类型与映射中的类型是否一致,

* 不一致则抛出异常,不允许一个别名对应两种类型

*/

if (TYPE_ALIASES.containsKey(key) && TYPE_ALIASES.get(key) != null && !TYPE_ALIASES.get(key).equals(value)) {

throw new TypeException(

"The alias '" + alias + "' is already mapped to the value '" + TYPE_ALIASES.get(key).getName() + "'.");

}

// 缓存别名到类型映射

TYPE_ALIASES.put(key, value);

}

如上,若用户为明确配置 alias 属性,MyBatis 会使用类名的小写形式作为别名。比如,全限定类名xyz.coolblog.model.Author的别名为author。若类中有@Alias注解,则从注解中取值作为别名。

2. 从指定的包中解析并注册别名

从指定的包中解析并注册别名过程主要由别名的解析和注册两步组成。下面来看一下相关代码:

public void registerAliases(String packageName) {

// 调用重载方法注册别名

registerAliases(packageName, Object.class);

}

public void registerAliases(String packageName, Class<?> superType) {

ResolverUtil<Class<?>> resolverUtil = new ResolverUtil<Class<?>>();

/*

* 查找某个包下的父类为 superType 的类。从调用栈来看,这里的

* superType = Object.class,所以 ResolverUtil 将查找所有的类。

* 查找完成后,查找结果将会被缓存到内部集合中。

*/

resolverUtil.find(new ResolverUtil.IsA(superType), packageName);

// 获取查找结果

Set<Class<? extends Class<?>>> typeSet = resolverUtil.getClasses();

for (Class<?> type : typeSet) {

// 忽略匿名类,接口,内部类

if (!type.isAnonymousClass() && !type.isInterface() && !type.isMemberClass()) {

// 为类型注册别名

registerAlias(type);

}

}

}

上面的代码不多,相关流程也不复杂,可简单总结为下面两个步骤:

- 查找指定包下的所有类

- 遍历查找到的类型集合,为每个类型注册别名

在这两步流程中,第2步流程对应的代码上一节已经分析过了,这里不再赘述。第1步的功能理解起来不难,但是背后对应的代码有点多。限于篇幅原因,这里我不打算详细分析这一部分的代码,只做简单的流程总结。如下:

- 通过 VFS(虚拟文件系统)获取指定包下的所有文件的路径名,比如

xyz/coolblog/model/Article.class。 - 筛选以

.class结尾的文件名 - 将路径名转成全限定的类名,通过类加载器加载类名

- 对类型进行匹配,若符合匹配规则,则将其放入内部集合中

以上就是类型资源查找的过程,并不是很复杂,大家有兴趣自己看看吧。

3. 注册 MyBatis 内部类及常见类型的别名

最后,我们来看一下一些 MyBatis 内部类及一些常见类型的别名注册过程。如下:

// -☆- Configuration

public Configuration() {

// 注册事务工厂的别名

typeAliasRegistry.registerAlias("JDBC", JdbcTransactionFactory.class);

// 省略部分代码,下同

// 注册数据源的别名

typeAliasRegistry.registerAlias("POOLED", PooledDataSourceFactory.class);

// 注册缓存策略的别名

typeAliasRegistry.registerAlias("FIFO", FifoCache.class);

typeAliasRegistry.registerAlias("LRU", LruCache.class);

// 注册日志类的别名

typeAliasRegistry.registerAlias("SLF4J", Slf4jImpl.class);

typeAliasRegistry.registerAlias("LOG4J", Log4jImpl.class);

// 注册动态代理工厂的别名

typeAliasRegistry.registerAlias("CGLIB", CglibProxyFactory.class);

typeAliasRegistry.registerAlias("JAVASSIST", JavassistProxyFactory.class);

}

// -☆- TypeAliasRegistry

public TypeAliasRegistry() {

// 注册 String 的别名

registerAlias("string", String.class);

// 注册基本类型包装类的别名

registerAlias("byte", Byte.class);

// 省略部分代码,下同

// 注册基本类型包装类数组的别名

registerAlias("byte[]", Byte[].class);

// 注册基本类型的别名

registerAlias("_byte", byte.class);

// 注册基本类型包装类的别名

registerAlias("_byte[]", byte[].class);

// 注册 Date, BigDecimal, Object 等类型的别名

registerAlias("date", Date.class);

registerAlias("decimal", BigDecimal.class);

registerAlias("object", Object.class);

// 注册 Date, BigDecimal, Object 等数组类型的别名

registerAlias("date[]", Date[].class);

registerAlias("decimal[]", BigDecimal[].class);

registerAlias("object[]", Object[].class);

// 注册集合类型的别名

registerAlias("map", Map.class);

registerAlias("hashmap", HashMap.class);

registerAlias("list", List.class);

registerAlias("arraylist", ArrayList.class);

registerAlias("collection", Collection.class);

registerAlias("iterator", Iterator.class);

// 注册 ResultSet 的别名

registerAlias("ResultSet", ResultSet.class);

}

我记得以前配置<select/>标签的resultType属性,由于不知道有别名这回事,傻傻的使用全限定类名进行配置。当时还觉得这样配置一定不会出错吧,很放心。现在想想有点搞笑。

好了,以上就是别名解析的全部流程,大家看懂了吗?如果觉得没啥障碍的话,那继续往下看呗。

第五节 解析 plugins 配置

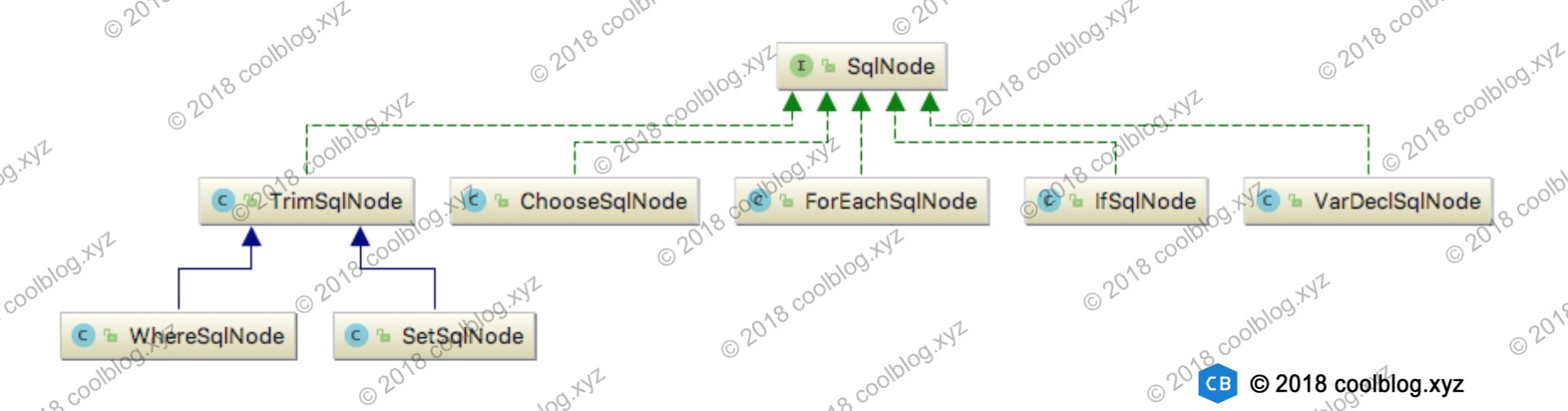

插件是 MyBatis 提供的一个拓展机制,通过插件机制我们可在 SQL 执行过程中的某些点上做一些自定义操作。实现一个插件需要比简单,首先需要让插件类实现Interceptor接口。然后在插件类上添加@Intercepts和@Signature注解,用于指定想要拦截的目标方法。MyBatis 允许拦截下面接口中的一些方法:

| 可拦截的类 | 类中可拦截的方法 |

|---|---|

| Executor | update/query/flushStatements/commit/rollback/getTransaction/close/isClosed |

| ParameterHandler | getParameterObject/setParameters |

| ResultSetHandler | handleResultSets/handleOutputParameters |

| StatementHandler | prepare/parameterize/batch/update/query |

比较常见的插件有分页插件、分表插件等,有兴趣的朋友可以去了解下。本节我们来分析一下插件的配置的解析过程,先来了解插件的配置。如下:

<plugins>

<plugin interceptor="xyz.coolblog.mybatis.ExamplePlugin">

<property name="key" value="value"/>

</plugin>

</plugins>

解析过程分析如下:

private void pluginElement(XNode parent) throws Exception {

if (parent != null) {

for (XNode child : parent.getChildren()) {

String interceptor = child.getStringAttribute("interceptor");

// 获取配置信息

Properties properties = child.getChildrenAsProperties();

// 解析拦截器的类型,并创建拦截器

Interceptor interceptorInstance = (Interceptor) resolveClass(interceptor).newInstance();

// 设置属性

interceptorInstance.setProperties(properties);

// 添加拦截器到 Configuration 中

configuration.addInterceptor(interceptorInstance);

}

}

}

// Configuration使用InterceptorChain来保存所有的拦截器

public void addInterceptor(Interceptor interceptor) {

interceptorChain.addInterceptor(interceptor);

}

// InterceptorChain内部是一个ArrayList

public void addInterceptor(Interceptor interceptor) {

interceptors.add(interceptor);

}

如上,插件解析的过程还是比较简单的。首先是获取配置,然后再解析拦截器类型,并实例化拦截器。最后向拦截器中设置属性,并将拦截器添加到 Configuration 中。好了,关于插件配置的分析就先到这,继续往下分析。

第六节 解析 environments 配置

在 MyBatis 中,事务管理器和数据源是配置在 environments 中的。它们的配置大致如下:

<environments default="development">

<environment id="development">

<transactionManager type="JDBC"/>

<dataSource type="POOLED">

<property name="driver" value="${jdbc.driver}"/>

<property name="url" value="${jdbc.url}"/>

<property name="username" value="${jdbc.username}"/>

<property name="password" value="${jdbc.password}"/>

</dataSource>

</environment>

</environments>

接下来我们对照上面的配置进行分析,如下:

private String environment;

private void environmentsElement(XNode context) throws Exception {

if (context != null) {

if (environment == null) {

// 获取 default 属性

environment = context.getStringAttribute("default");

}

for (XNode child : context.getChildren()) {

// 获取 id 属性

String id = child.getStringAttribute("id");

/*

* 检测当前 environment 节点的 id 与其父节点 environments 的属性 default

* 内容是否一致,一致则返回 true,否则返回 false

*/

if (isSpecifiedEnvironment(id)) {

// 解析 transactionManager 节点,逻辑和插件的解析逻辑很相似,不在赘述

TransactionFactory txFactory = transactionManagerElement(child.evalNode("transactionManager"));

// 解析 dataSource 节点,逻辑和插件的解析逻辑很相似,不在赘述

DataSourceFactory dsFactory = dataSourceElement(child.evalNode("dataSource"));

// 创建 DataSource 对象

DataSource dataSource = dsFactory.getDataSource();

Environment.Builder environmentBuilder = new Environment.Builder(id)

.transactionFactory(txFactory)

.dataSource(dataSource);

// 构建 Environment 对象,并设置到 configuration 中

configuration.setEnvironment(environmentBuilder.build());

}

}

}

}

environments 配置的解析过程没什么特别之处,按部就班解析就行了,不多说了。

第七节 解析 typeHandlers 配置

我们在向数据库存取数据时,需要将数据库字段类型和 Java类型进行相互转换,处理这个转换的模块就是类型处理器TypeHandler。下面,我们来看一下类型处理器的配置方法:

<!-- 自动扫描(javaType和jdbcTyp使用@MappedTypes和@MappedJdbcTypes注解配置) -->

<typeHandlers>

<package name="xyz.coolblog.handlers"/>

</typeHandlers>

<!-- 手动配置 -->

<typeHandlers>

<typeHandler jdbcType="TINYINT"

javaType="xyz.coolblog.constant.ArticleTypeEnum"

handler="xyz.coolblog.mybatis.ArticleTypeHandler"/>

</typeHandlers>

下面开始分析代码。

private void typeHandlerElement(XNode parent) throws Exception {

if (parent != null) {

for (XNode child : parent.getChildren()) {

// 从指定的包中注册 TypeHandler

if ("package".equals(child.getName())) {

String typeHandlerPackage = child.getStringAttribute("name");

// 注册方法 ①

typeHandlerRegistry.register(typeHandlerPackage);

// 从 typeHandler 节点中解析别名到类型的映射

} else {

// 获取 javaType,jdbcType 和 handler 等属性值

String javaTypeName = child.getStringAttribute("javaType");

String jdbcTypeName = child.getStringAttribute("jdbcType");

String handlerTypeName = child.getStringAttribute("handler");

// 解析上面获取到的属性值

Class<?> javaTypeClass = resolveClass(javaTypeName);

JdbcType jdbcType = resolveJdbcType(jdbcTypeName);

Class<?> typeHandlerClass = resolveClass(handlerTypeName);

// 根据 javaTypeClass 和 jdbcType 值的情况进行不同的注册策略

if (javaTypeClass != null) {

if (jdbcType == null) {

// 注册方法 ②

typeHandlerRegistry.register(javaTypeClass, typeHandlerClass);

} else {

// 注册方法 ③

typeHandlerRegistry.register(javaTypeClass, jdbcType, typeHandlerClass);

}

} else {

// 注册方法 ④

typeHandlerRegistry.register(typeHandlerClass);

}

}

}

}

}

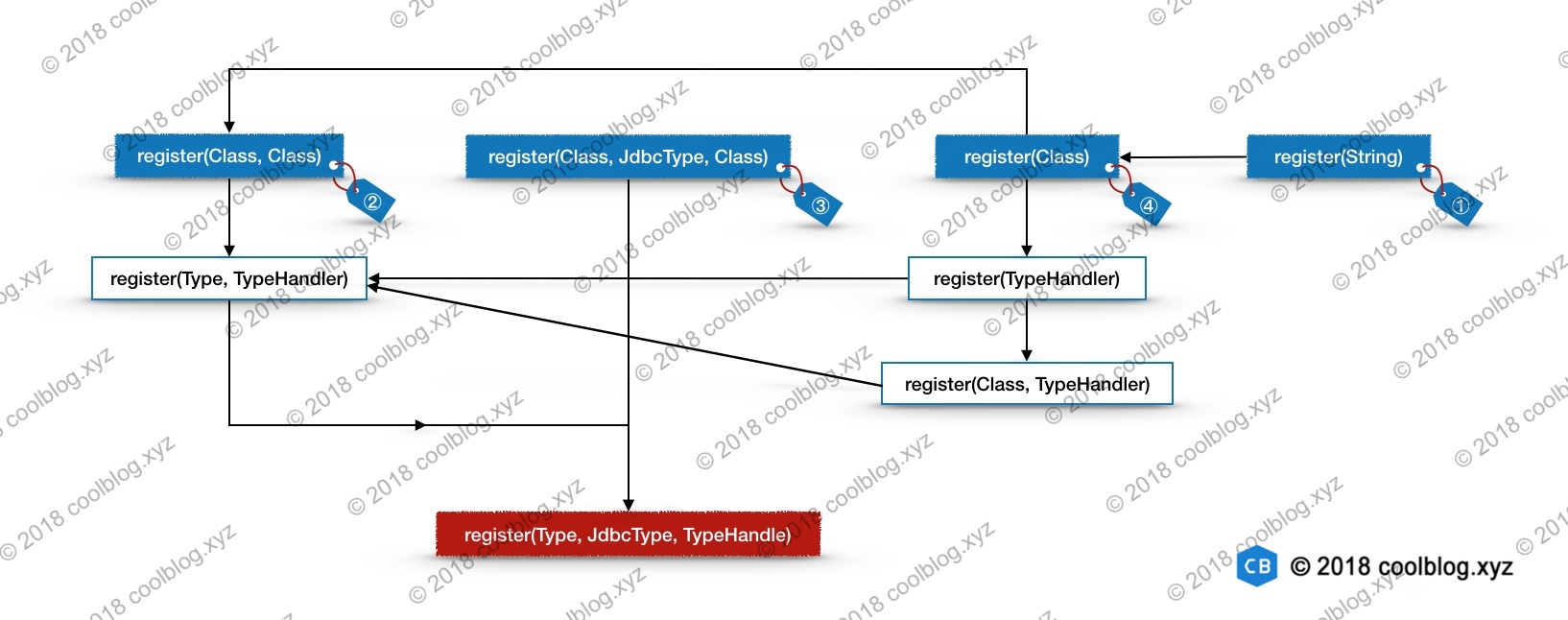

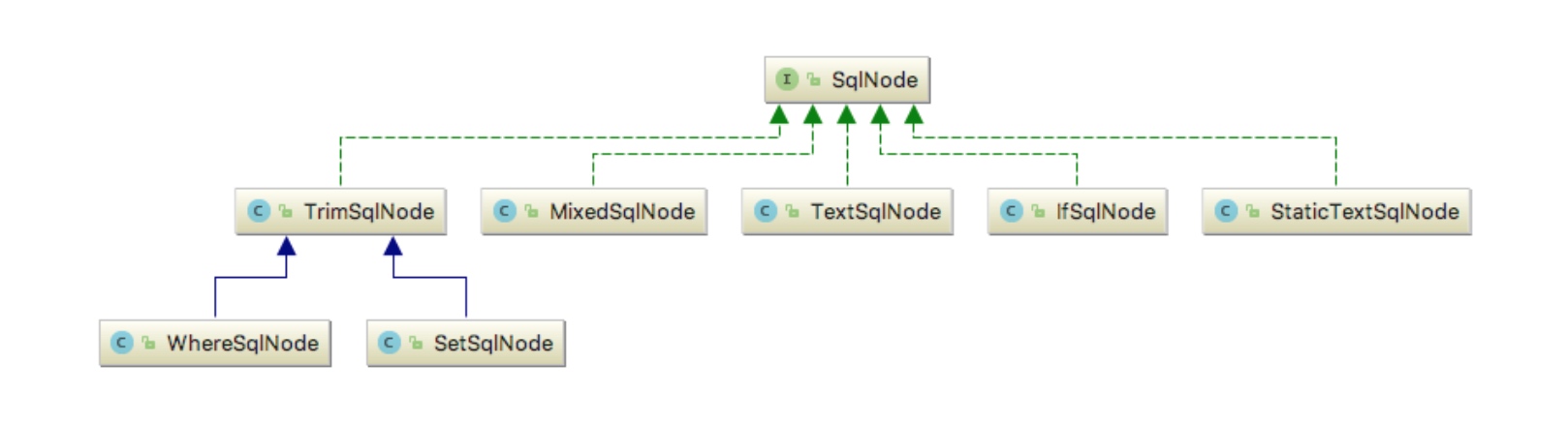

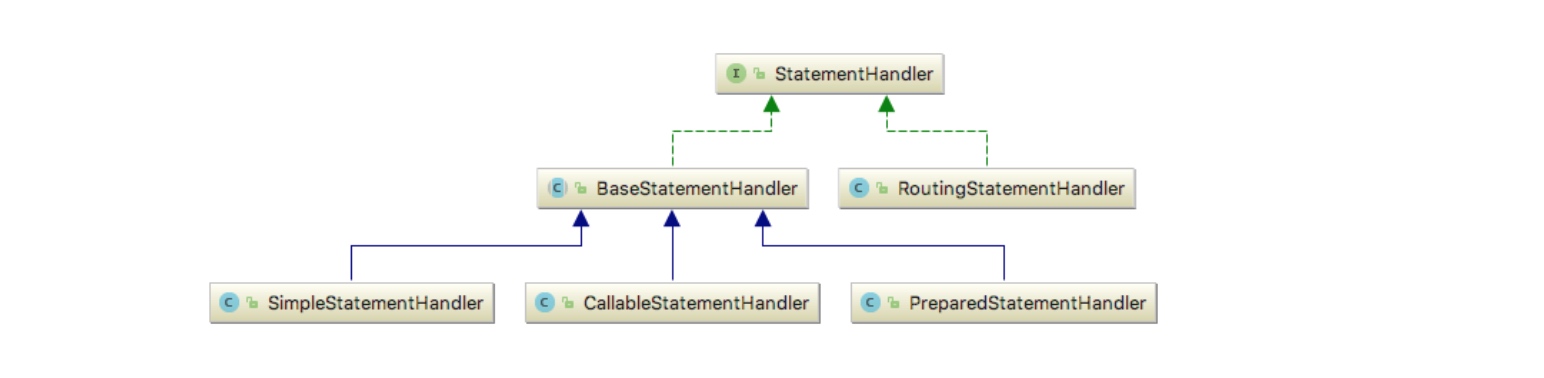

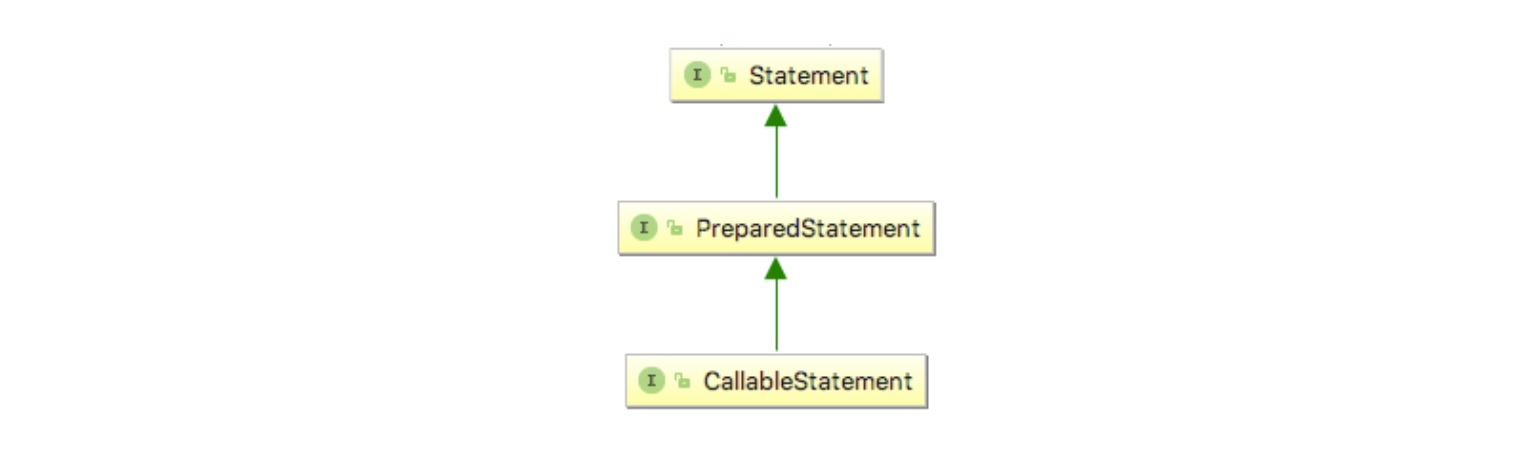

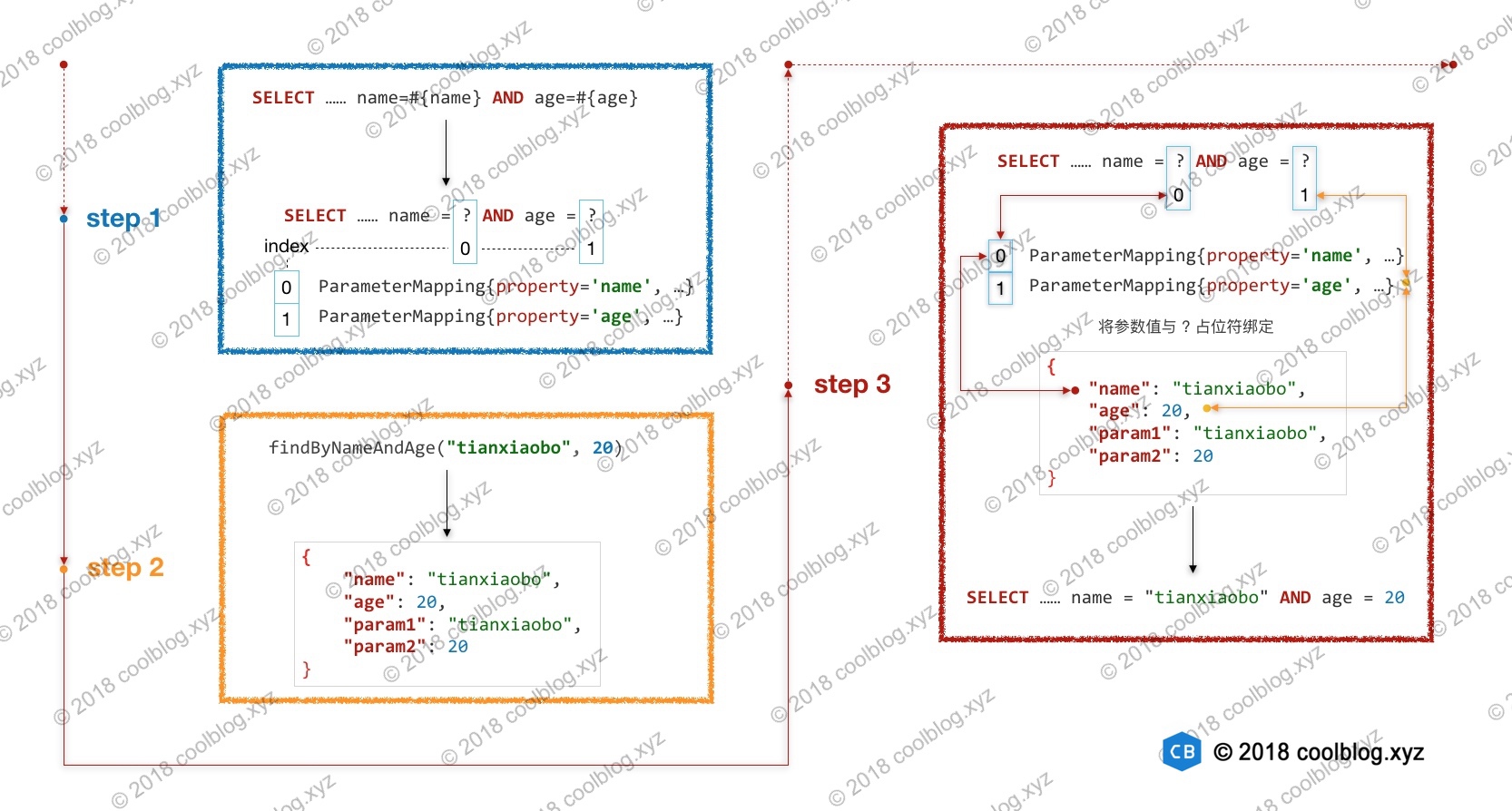

上面的代码中调用了 4 个重载的处理器注册方法,这些注册方法的逻辑不难理解,但之间的调用关系复杂,下面是它们的调用关系图。其中蓝色背景框内的方法称为开始方法,红色背景框内的方法称为终点方法,白色背景框内的方法称为中间方法。

下面我会分析从每个开始方法向下分析,为了避免冗余分析,我会按照③ → ② → ④ → ①的顺序进行分析。

1. register(Class, JdbcType, Class)

当代码执行到此方法时,表示javaTypeClass != null && jdbcType != null条件成立,即明确配置了javaType和jdbcType。

public void register(Class<?> javaTypeClass, JdbcType jdbcType, Class<?> typeHandlerClass) {

// 参数齐全,直接调用终点方法 (其中getInstance用于创建typeHandlerClass实例,优先使用javaTypeClass作为入参调用有参构造)

register(javaTypeClass, jdbcType, getInstance(javaTypeClass, typeHandlerClass));

}

/** 类型处理器注册过程的终点 */

private void register(Type javaType, JdbcType jdbcType, TypeHandler<?> handler) {

if (javaType != null) {

// JdbcType 到 TypeHandler 的映射

Map<JdbcType, TypeHandler<?>> map = TYPE_HANDLER_MAP.get(javaType);

if (map == null || map == NULL_TYPE_HANDLER_MAP) {

map = new HashMap<JdbcType, TypeHandler<?>>();

// 存储 javaType 到 Map<JdbcType, TypeHandler> 的映射

TYPE_HANDLER_MAP.put(javaType, map);

}

map.put(jdbcType, handler);

}

// 存储所有的 TypeHandler

ALL_TYPE_HANDLERS_MAP.put(handler.getClass(), handler);

}

类型处理器的实际注册过程是在该终点方法完成的,就是把类型和处理器进行双层映射而已,外层映射是JavaType和多个JdbcType的映射,内层映射是JdbcType和TypeHandler的映射。

2. register(Class, Class)

当代码执行到此方法时,表示javaTypeClass != null && jdbcType == null条件成立,即仅设置了javaType。

public void register(Class<?> javaTypeClass, Class<?> typeHandlerClass) {

// 调用中间方法register(Type, TypeHandler),去获取jdbcType

register(javaTypeClass, getInstance(javaTypeClass, typeHandlerClass));

}

private <T> void register(Type javaType, TypeHandler<? extends T> typeHandler) {

// 获取 @MappedJdbcTypes 注解(用于解析jdbcType)

MappedJdbcTypes mappedJdbcTypes = typeHandler.getClass().getAnnotation(MappedJdbcTypes.class);

if (mappedJdbcTypes != null) {

// 遍历 @MappedJdbcTypes 注解中配置的值(获取所有配置的JdbcType)

for (JdbcType handledJdbcType : mappedJdbcTypes.value()) {

// 参数解析齐全后,调用终点方法

register(javaType, handledJdbcType, typeHandler);

}

if (mappedJdbcTypes.includeNullJdbcType()) {

// 调用终点方法,jdbcType = null

register(javaType, null, typeHandler);

}

} else {

// 调用终点方法,jdbcType = null

register(javaType, null, typeHandler);

}

}

上面代码主要做的事情是尝试从注解中获取JdbcType的值,然后调用终点方法注册。(注意JdbcType可以配置为NULL,详情查看MyBatis官方文档)。

3. register(Class)

当代码执行到此方法时,表示javaTypeClass == null条件成立,即javaType和jdbcType都未配置。

public void register(Class<?> typeHandlerClass) {

boolean mappedTypeFound = false;

// 获取 @MappedTypes 注解(用于解析javaType)

MappedTypes mappedTypes = typeHandlerClass.getAnnotation(MappedTypes.class);

if (mappedTypes != null) {

// 遍历 @MappedTypes 注解中配置的值

for (Class<?> javaTypeClass : mappedTypes.value()) {

// 调用注册方法 ②

register(javaTypeClass, typeHandlerClass);

mappedTypeFound = true;

}

}

if (!mappedTypeFound) {

// 调用中间方法 register(TypeHandler)

register(getInstance(null, typeHandlerClass));

}

}

public <T> void register(TypeHandler<T> typeHandler) {

boolean mappedTypeFound = false;

// 获取 @MappedTypes 注解

MappedTypes mappedTypes = typeHandler.getClass().getAnnotation(MappedTypes.class);

if (mappedTypes != null) {

for (Class<?> handledType : mappedTypes.value()) {

// 调用中间方法 register(Type, TypeHandler)

register(handledType, typeHandler);

mappedTypeFound = true;

}

}

// 自动发现映射类型

if (!mappedTypeFound && typeHandler instanceof TypeReference) {

try {

TypeReference<T> typeReference = (TypeReference<T>) typeHandler;

// 获取参数模板中的参数类型,并调用中间方法 register(Type, TypeHandler)

register(typeReference.getRawType(), typeHandler);

mappedTypeFound = true;

} catch (Throwable t) {

}

}

if (!mappedTypeFound) {

// 调用中间方法 register(Class, TypeHandler)

register((Class<T>) null, typeHandler);

}

}

public <T> void register(Class<T> javaType, TypeHandler<? extends T> typeHandler) {

// 调用中间方法 register(Type, TypeHandler)

register((Type) javaType, typeHandler);

}

上面的代码主要用于解析javaType,优先通过@MappedTypes注解来解析,其次使用反射来获取javaType。不管是通过哪种方式,解析完成后都会调用中间方法register(Type, TypeHandler),这个方法负责解析jdbcType,在上一节已经分析过。一个负责解析 javaType,另一个负责解析 jdbcType,逻辑比较清晰了。

4. register(String)

该方法主要是用于自动扫描类型处理器,并调用其他方法注册扫描结果,注册时忽略内部类,接口,抽象类等。

public void register(String packageName) {

ResolverUtil<Class<?>> resolverUtil = new ResolverUtil<Class<?>>();

// 从指定包中查找 TypeHandler

resolverUtil.find(new ResolverUtil.IsA(TypeHandler.class), packageName);

Set<Class<? extends Class<?>>> handlerSet = resolverUtil.getClasses();

for (Class<?> type : handlerSet) {

// 忽略内部类,接口,抽象类等

if (!type.isAnonymousClass() && !type.isInterface() && !Modifier.isAbstract(type.getModifiers())) {

// 调用注册方法 ④

register(type);

}

}

}

第八节 解析 mappers 配置

mappers标签主要用于指定映射信息的存放位置,这些映射信息可以是注解形式或XML配置形式。

// -☆- XMLConfigBuilder

private void mapperElement(XNode parent) throws Exception {

if (parent != null) {

for (XNode child : parent.getChildren()) {

if ("package".equals(child.getName())) {

// 获取 <package> 节点中的 name 属性

String mapperPackage = child.getStringAttribute("name");

// 从指定包中查找 mapper 接口,并根据 mapper 接口解析映射配置

configuration.addMappers(mapperPackage);

} else {

// 获取 resource/url/class 等属性

String resource = child.getStringAttribute("resource");

String url = child.getStringAttribute("url");

String mapperClass = child.getStringAttribute("class");

// resource 不为空,且其他两者为空,则从指定路径中加载配置

if (resource != null && url == null && mapperClass == null) {

ErrorContext.instance().resource(resource);

InputStream inputStream = Resources.getResourceAsStream(resource);

XMLMapperBuilder mapperParser = new XMLMapperBuilder(inputStream, configuration, resource, configuration.getSqlFragments());

// 解析映射文件

mapperParser.parse();

// url 不为空,且其他两者为空,则通过 url 加载配置

} else if (resource == null && url != null && mapperClass == null) {

ErrorContext.instance().resource(url);

InputStream inputStream = Resources.getUrlAsStream(url);

XMLMapperBuilder mapperParser = new XMLMapperBuilder(inputStream, configuration, url, configuration.getSqlFragments());

// 解析映射文件

mapperParser.parse();

// mapperClass 不为空,且其他两者为空,则通过 mapperClass 解析映射配置

} else if (resource == null && url == null && mapperClass != null) {

Class<?> mapperInterface = Resources.classForName(mapperClass);

// 解析映射注解

configuration.addMapper(mapperInterface);

// 以上条件不满足,则抛出异常

} else {

throw new BuilderException("A mapper element may only specify a url, resource or class, but not more than one.");

}

}

}

}

}

上面代码主要逻辑是遍历 mappers 的子节点,并根据节点属性值判断通过什么方式加载映射文件或映射信息。

第二章 映射文件解析过程

在本章节中,先分析映射文件中各节点(<cache>,<cache-ref>,<resultMap>, <select | insert | update | delete> 等)的解析过程,然后介绍Mapper 接口的绑定过程。在此之外,有一点需提前声明,由于MyBatis使用注解配置的局限性,下面章节都将以解析XML配置的角度来讲解,如果你学会了XML配置解析,那么理解注解配置解析当然也会非常轻松。

第一节 映射文件解析入口

在展开映射文件的解析之前,先来看一下映射文件解析入口。如下:

// -☆- XMLMapperBuilder

public void parse() {

// 检测映射文件是否已经被解析过

if (!configuration.isResourceLoaded(resource)) {

// 解析 mapper 节点

configurationElement(parser.evalNode("/mapper"));

// 添加资源路径到“已解析资源集合”中

configuration.addLoadedResource(resource);

// 通过命名空间绑定 Mapper 接口

bindMapperForNamespace();

}

// 处理未完成解析的节点

parsePendingResultMaps();

parsePendingCacheRefs();

parsePendingStatements();

}

如上,映射文件解析入口逻辑包含三个核心操作,分别如下:

- 解析 mapper 节点

- 通过命名空间绑定 Mapper 接口

- 处理未完成解析的节点

这三个操作对应的逻辑,我将会在随后的章节中依次进行分析。下面,先来分析第一个操作对应的逻辑,下面是一个映射文件配置示例。

<mapper namespace="xyz.coolblog.dao.AuthorDao">

<cache/>

<resultMap id="authorResult" type="Author">

<id property="id" column="id"/>

<result property="name" column="name"/>

<!-- ... -->

</resultMap>

<sql id="table">

author

</sql>

<select id="findOne" resultMap="authorResult">

SELECT

id, name, age, sex, email

FROM

<include refid="table"/>

WHERE

id = #{id}

</select>

<!-- <insert|update|delete/> -->

</mapper>

上面是一个比较简单的映射文件,还有一些的节点没有出现在上面。以上每种配置中的每种节点的解析逻辑都封装在了相应的方法中,这些方法由 XMLMapperBuilder 类的 configurationElement 方法统一调用。

private void configurationElement(XNode context) {

try {

// 获取 mapper 命名空间

String namespace = context.getStringAttribute("namespace");

if (namespace == null || namespace.equals("")) {

throw new BuilderException("Mapper's namespace cannot be empty");

}

// 设置命名空间到 builderAssistant 中

builderAssistant.setCurrentNamespace(namespace);

// 解析 <cache-ref> 节点

cacheRefElement(context.evalNode("cache-ref"));

// 解析 <cache> 节点

cacheElement(context.evalNode("cache"));

// 已废弃配置,这里不做分析

parameterMapElement(context.evalNodes("/mapper/parameterMap"));

// 解析 <resultMap> 节点

resultMapElements(context.evalNodes("/mapper/resultMap"));

// 解析 <sql> 节点

sqlElement(context.evalNodes("/mapper/sql"));

// 解析 <select>、...、<delete> 等节点

buildStatementFromContext(context.evalNodes("select|insert|update|delete"));

} catch (Exception e) {

throw new BuilderException("Error parsing Mapper XML. The XML location is '" + resource + "'. Cause: " + e, e);

}

}

下面将会先分析 <cache> 节点的解析过程,然后再分析 <cache-ref> 节点,之后会按照顺序分析其他节点的解析过程。

第二节 解析 cache 节点

MyBatis 提供了一级/二级缓存,其中一级缓存是 SqlSession 级别的,默认为开启状态。二级缓存配置在映射文件中,需要显示配置开启。

<!-- 开启二级缓存:

eviction:FIFO表示按“先进先出”的策略淘汰缓存项

flushInterval:缓存每隔60秒刷新一次

size:缓存的容量为512个对象引用

readOnly:为true表示缓存返回的对象是写安全的,即在外部修改对象不会影响到缓存内部存储对象

-->

<cache eviction="FIFO" flushInterval="60000" size="512" readOnly="true"/>

除此之外,还可以给 MyBatis 配置第三方缓存或者自己实现的缓存等。比如,我们将 Ehcache 缓存整合到 MyBatis 中,可以这样配置。

<cache type="org.mybatis.caches.ehcache.EhcacheCache"/>

<property name="timeToIdleSeconds" value="3600"/>

<property name="timeToLiveSeconds" value="3600"/>

<property name="maxEntriesLocalHeap" value="1000"/>

<property name="maxEntriesLocalDisk" value="10000000"/>

<property name="memoryStoreEvictionPolicy" value="LRU"/>

</cache>

下面来分析一下缓存配置的解析逻辑,如下:

private void cacheElement(XNode context) throws Exception {

if (context != null) {

// 获取各种属性

String type = context.getStringAttribute("type", "PERPETUAL");

Class<? extends Cache> typeClass = typeAliasRegistry.resolveAlias(type);

String eviction = context.getStringAttribute("eviction", "LRU");

Class<? extends Cache> evictionClass = typeAliasRegistry.resolveAlias(eviction);

Long flushInterval = context.getLongAttribute("flushInterval");

Integer size = context.getIntAttribute("size");

boolean readWrite = !context.getBooleanAttribute("readOnly", false);

boolean blocking = context.getBooleanAttribute("blocking", false);

// 获取子节点配置

Properties props = context.getChildrenAsProperties();

// 构建缓存对象

builderAssistant.useNewCache(typeClass, evictionClass, flushInterval, size, readWrite, blocking, props);

}

}

上面代码中,大段代码用来解析 <cache> 节点的属性和子节点,这些代码没什么好说的。缓存的构建逻辑封装在 BuilderAssistant 类的 useNewCache 方法中,下面我们来看一下该方法的逻辑。

// -☆- MapperBuilderAssistant

public Cache useNewCache(Class<? extends Cache> typeClass,

Class<? extends Cache> evictionClass,Long flushInterval,

Integer size,boolean readWrite,boolean blocking,Properties props) {

// 使用建造模式构建缓存实例

Cache cache = new CacheBuilder(currentNamespace)

.implementation(valueOrDefault(typeClass, PerpetualCache.class))

.addDecorator(valueOrDefault(evictionClass, LruCache.class))

.clearInterval(flushInterval)

.size(size)

.readWrite(readWrite)

.blocking(blocking)

.properties(props)

.build();

// 添加缓存到 Configuration 对象中

configuration.addCache(cache);

// 设置当前缓存为刚创建的缓存

currentCache = cache;

return cache;

}

上面使用了建造模式构建 Cache 实例,Cache 实例的构建过程略为复杂,我们跟下去看看。

// -☆- CacheBuilder

public Cache build() {

// 设置默认的缓存类型(PerpetualCache)和缓存装饰器(LruCache)

setDefaultImplementations();

// 通过反射创建缓存

Cache cache = newBaseCacheInstance(implementation, id);

// 设置子节点配置的属性

setCacheProperties(cache);

// 仅对内置缓存 PerpetualCache 应用装饰器

if (PerpetualCache.class.equals(cache.getClass())) {

// 遍历装饰器集合,应用装饰器

for (Class<? extends Cache> decorator : decorators) {

// 通过反射创建装饰器实例

cache = newCacheDecoratorInstance(decorator, cache);

// 再次设置子节点配置的属性(for装饰器)

setCacheProperties(cache);

}

// 应用标准的装饰器,比如 LoggingCache、SynchronizedCache

cache = setStandardDecorators(cache);

} else if (!LoggingCache.class.isAssignableFrom(cache.getClass())) {

// 应用具有日志功能的缓存装饰器

cache = new LoggingCache(cache);

}

return cache;

}

上面的构建过程流程较为复杂,这里总结一下。如下:

- 设置默认的缓存类型及装饰器

- 应用装饰器到 PerpetualCache 对象上

- 遍历装饰器类型集合,并通过反射创建装饰器实例

- 将属性设置到实例中

- 应用一些标准的装饰器

- 对非 LoggingCache 类型的缓存应用 LoggingCache 装饰器

在以上4个步骤中,最后一步的逻辑很简单,无需多说。下面按顺序分析前3个步骤对应的逻辑,如下:

private void setDefaultImplementations() {

if (implementation == null) {

// 设置默认的缓存实现类

implementation = PerpetualCache.class;

if (decorators.isEmpty()) {

// 添加 LruCache 装饰器

decorators.add(LruCache.class);

}

}

}

以上逻辑比较简单,主要做的事情是在 implementation 为空的情况下,为它设置一个默认值。如果大家仔细看前面的方法,会发现 MyBatis 做了不少判空的操作。比如:

// 判空操作1,若用户未设置 cache 节点的 type 和 eviction 属性,这里设置默认值 PERPETUAL

String type = context.getStringAttribute("type", "PERPETUAL");

String eviction = context.getStringAttribute("eviction", "LRU");

// 判空操作2,若 typeClass 或 evictionClass 为空,valueOrDefault 方法会为它们设置默认值

Cache cache = new CacheBuilder(currentNamespace)

.implementation(valueOrDefault(typeClass, PerpetualCache.class))

.addDecorator(valueOrDefault(evictionClass, LruCache.class))

// 省略部分代码

.build();

既然前面已经做了两次判空操作,implementation 不可能为空,那么 setDefaultImplementations 方法似乎没有存在的必要了。其实不然,如果有人不按套路写代码。比如:

Cache cache = new CacheBuilder(currentNamespace)

// 忘记设置 implementation

.build();

这里忘记设置 implementation,或人为的将 implementation 设为空。如果不对 implementation 进行判空,会导致 build 方法在构建实例时触发空指针异常,对于框架来说,出现空指针异常是很尴尬的,这是一个低级错误。这里以及之前做了这么多判空,就是为了避免出现空指针的情况,以提高框架的健壮性。好了,关于 setDefaultImplementations 方法的分析先到这,继续往下分析。

我们在使用 MyBatis 内置缓存时,一般不用为它们配置自定义属性。但使用第三方缓存时,则应按需进行配置。比如前面演示 MyBatis 整合 Ehcache 时,就为 Ehcache 配置了一些必要的属性。下面我们来看一下这部分配置是如何设置到缓存实例中的。

private void setCacheProperties(Cache cache) {

if (properties != null) {

/*

* 为缓存实例生成一个“元信息”实例,forObject 方法调用层次比较深,但最终调用了

* MetaClass 的 forClass 方法。关于 MetaClass 的源码,我在上一篇文章中已经

* 详细分析过了,这里不再赘述。

*/

MetaObject metaCache = SystemMetaObject.forObject(cache);

// 遍历子节点属性

for (Map.Entry<Object, Object> entry : properties.entrySet()) {

String name = (String) entry.getKey();

String value = (String) entry.getValue();

if (metaCache.hasSetter(name)) {

// 获取 setter 方法的参数类型

Class<?> type = metaCache.getSetterType(name);

/*

* 根据参数类型对属性值进行转换,并将转换后的值

* 通过 setter 方法设置到 Cache 实例中

*/

if (String.class == type) {

metaCache.setValue(name, value);

} else if (int.class == type || Integer.class == type) {

/*

* 此处及以下分支包含两个步骤:

* 1.类型转换 → Integer.valueOf(value)

* 2.将转换后的值设置到缓存实例中 → metaCache.setValue(name, value)

*/

metaCache.setValue(name, Integer.valueOf(value));

} else if (long.class == type || Long.class == type) {

metaCache.setValue(name, Long.valueOf(value));

}

else if (short.class == type || Short.class == type) {...}

else if (byte.class == type || Byte.class == type) {...}

else if (float.class == type || Float.class == type) {...}

else if (boolean.class == type || Boolean.class == type) {...}

else if (double.class == type || Double.class == type) {...}

else {

throw new CacheException("Unsupported property type for cache: '" + name + "' of type " + type);

}

}

}

}

// 如果缓存类实现了 InitializingObject 接口,则调用 initialize 方法执行初始化逻辑

if (InitializingObject.class.isAssignableFrom(cache.getClass())) {

try {

((InitializingObject) cache).initialize();

} catch (Exception e) {

throw new CacheException("Failed cache initialization for '" +

cache.getId() + "' on '" + cache.getClass().getName() + "'", e);

}

}

}

上面的大段代码用于对属性值进行类型转换,和设置转换后的值到 Cache 实例中。关于上面代码中出现的 MetaObject,大家可以自己尝试分析一下。最后,我们来看一下设置标准装饰器的过程。如下:

private Cache setStandardDecorators(Cache cache) {

try {

// 创建“元信息”对象

MetaObject metaCache = SystemMetaObject.forObject(cache);

if (size != null && metaCache.hasSetter("size")) {

// 设置 size 属性,

metaCache.setValue("size", size);

}

if (clearInterval != null) {

// clearInterval 不为空,应用 ScheduledCache 装饰器

cache = new ScheduledCache(cache);

((ScheduledCache) cache).setClearInterval(clearInterval);

}

if (readWrite) {

// readWrite 为 true,应用 SerializedCache 装饰器

cache = new SerializedCache(cache);

}

/*

* 应用 LoggingCache,SynchronizedCache 装饰器,

* 使原缓存具备打印日志和线程同步的能力

*/

cache = new LoggingCache(cache);

cache = new SynchronizedCache(cache);

if (blocking) {

// blocking 为 true,应用 BlockingCache 装饰器

cache = new BlockingCache(cache);

}

return cache;

} catch (Exception e) {

throw new CacheException("Error building standard cache decorators. Cause: " + e, e);

}

}

以上代码为缓存应用了一些基本的装饰器,但除了 LoggingCache 和 SynchronizedCache 这两个是必要的装饰器外,其他的装饰器应用与否,取决于用户的配置。

第三节 解析 cache-ref 节点

在 MyBatis 中,二级缓存是可以共用的。这需要使用 <cache-ref> 节点配置参照缓存,比如像下面这样。

<!-- Mapper1.xml -->

<mapper namespace="xyz.coolblog.dao.Mapper1">

<!-- Mapper1 与 Mapper2 共用一个二级缓存 -->

<cache-ref namespace="xyz.coolblog.dao.Mapper2"/>

</mapper>

<!-- Mapper2.xml -->

<mapper namespace="xyz.coolblog.dao.Mapper2">

<cache/>

</mapper>

接下来,我们对照上面的配置分析 cache-ref 的解析过程。如下:

private void cacheRefElement(XNode context) {

if (context != null) {

configuration.addCacheRef(builderAssistant.getCurrentNamespace(), context.getStringAttribute("namespace"));

// 创建 CacheRefResolver 实例

CacheRefResolver cacheRefResolver = new CacheRefResolver(builderAssistant, context.getStringAttribute("namespace"));

try {

// 解析参照缓存

cacheRefResolver.resolveCacheRef();

} catch (IncompleteElementException e) {

/*

* 这里对 IncompleteElementException 异常进行捕捉,并将 cacheRefResolver

* 存入到 Configuration 的 incompleteCacheRefs 集合中

*/

configuration.addIncompleteCacheRef(cacheRefResolver);

}

}

}

如上所示,<cache-ref> 节点的解析逻辑封装在了 CacheRefResolver 的 resolveCacheRef 方法中。

// -☆- CacheRefResolver

public Cache resolveCacheRef() {

// 调用 builderAssistant 的 useCacheRef(cacheRefNamespace) 方法

return assistant.useCacheRef(cacheRefNamespace);

}

// -☆- MapperBuilderAssistant

public Cache useCacheRef(String namespace) {

if (namespace == null) {

throw new BuilderException("cache-ref element requires a namespace attribute.");

}

try {

unresolvedCacheRef = true;

// 根据命名空间从全局配置对象(Configuration)中查找相应的缓存实例

Cache cache = configuration.getCache(namespace);

/*

* 若未查找到缓存实例,此处抛出异常。这里存在两种情况导致未查找到 cache 实例,

* 分别如下:

* 1.使用者在 <cache-ref> 中配置了一个不存在的命名空间,

* 导致无法找到 cache 实例

* 2.使用者所引用的缓存实例还未创建

*/

if (cache == null) {

throw new IncompleteElementException("No cache for namespace '" + namespace + "' could be found.");

}

// 修改当前缓存为查询出来的缓存

currentCache = cache;

unresolvedCacheRef = false;

return cache;

} catch (IllegalArgumentException e) {

throw new IncompleteElementException("No cache for namespace '" + namespace + "' could be found.", e);

}

}

关于XML和注解中同时配置缓存的问题?

- XML和注解不能同时开启缓存。会报 IllegalArgumentException: Caches collection already contains value for org.example.dao.XxxMapper错误。因为缓存对象创建后会被添加到Configuration中,而保存所有cache对象的是一个MyBatis自定义的

StrictMap类型,该类型继承自HashMap,在put时会校验元素是否已存在。- 其中一方开启缓存,另一方不能直接使用。由于XML解析和注解解析映射配置时分别创建了两个不同的对象(XmlMapperBuilder和MapperAnnotationBuilder类型),所以它们的内部类MapperBuilderAssistant中保存的currentCache(在解析cache节点时将创建的cache对象设置到currentCache)是两个不同的引用,因此由不同对象构建的MapperStatement(不能在XML和注解中配置同一个MapperStatement),保存了各自的cache对象。从而在查找二级缓存时,只能查找配置了cache节点的那一方。

- 可以使用缓存引用来解决上述问题。因为在缓存引用解析的过程中,会查找对应的cache设置到currentCache,后续构建MapperStatement时会保存此引用。

第四节 解析 resultMap 节点

resultMap 是 MyBatis 框架中最重要的特性,主要用于映射结果,下面开始分析 resultMap 配置的解析过程。

// -☆- XMLMapperBuilder

private void resultMapElements(List<XNode> list) throws Exception {

// 遍历 <resultMap> 节点列表

for (XNode resultMapNode : list) {

try {

// 解析 resultMap 节点

resultMapElement(resultMapNode);

} catch (IncompleteElementException e) {

// ignore, it will be retried

}

}

}

private ResultMap resultMapElement(XNode resultMapNode) throws Exception {

// 调用重载方法(节点名称,已解析的ResultMapping)

return resultMapElement(resultMapNode, Collections.<ResultMapping>emptyList());

}

private ResultMap resultMapElement(XNode resultMapNode, List<ResultMapping> additionalResultMappings) throws Exception {

ErrorContext.instance().activity("processing " + resultMapNode.getValueBasedIdentifier());

// 获取 id 属性(嵌套映射没有id属性,调用resultMapNode.getValueBasedIdentifier()生成,

// 如id = mapper_resultMap[articleResult]_association[article_author])

String id = resultMapNode.getStringAttribute("id", resultMapNode.getValueBasedIdentifier());

// 获取 type 属性(获取顺序依次是type->ofType->resultType->javaType)

String type = resultMapNode.getStringAttribute("type",

resultMapNode.getStringAttribute("ofType",

resultMapNode.getStringAttribute("resultType",

resultMapNode.getStringAttribute("javaType"))));

// 获取 extends 和 autoMapping 属性

String extend = resultMapNode.getStringAttribute("extends");

Boolean autoMapping = resultMapNode.getBooleanAttribute("autoMapping");

// 解析 type 属性对应的类型

Class<?> typeClass = resolveClass(type);

Discriminator discriminator = null;

// 存放解析出来的 ResultMapping

List<ResultMapping> resultMappings = new ArrayList<ResultMapping>();

// 将参数传入的 ResultMapping 添加进来(一般是嵌套映射的父映射)

resultMappings.addAll(additionalResultMappings);

// 获取并遍历 <resultMap> 的子节点列表

List<XNode> resultChildren = resultMapNode.getChildren();

for (XNode resultChild : resultChildren) {

if ("constructor".equals(resultChild.getName())) {

// 解析 constructor 标签,并生成相应的 ResultMapping

processConstructorElement(resultChild, typeClass, resultMappings);

} else if ("discriminator".equals(resultChild.getName())) {

// 解析 discriminator 标签

discriminator = processDiscriminatorElement(resultChild, typeClass, resultMappings);

} else {

// 解析其它标签(id/result/association/collection)

List<ResultFlag> flags = new ArrayList<ResultFlag>();

// 判断是否为 id 标签,如果是,则添加标记

if ("id".equals(resultChild.getName())) {

flags.add(ResultFlag.ID);

}

// 解析 id 和 result 节点,并生成相应的 ResultMapping

resultMappings.add(buildResultMappingFromContext(resultChild, typeClass, flags));

}

}

// 创建 ResultMapResolver 实例

ResultMapResolver resultMapResolver = new ResultMapResolver(builderAssistant, id, typeClass, extend,

discriminator, resultMappings, autoMapping);

try {

// 根据前面获取到的信息构建 ResultMap 对象

return resultMapResolver.resolve();

} catch (IncompleteElementException e) {

/*

* 如果发生 IncompleteElementException 异常,

* 这里将 resultMapResolver 添加到 incompleteResultMaps 集合中

*/

configuration.addIncompleteResultMap(resultMapResolver);

throw e;

}

}

上面的代码比较多,看起来有点复杂,这里总结一下:

- 获取

<resultMap>节点的各种属性 - 遍历

<resultMap>的子节点,并根据子节点名称执行相应的解析逻辑 - 构建 ResultMap 对象

- 若构建过程中发生异常,则将 resultMapResolver 添加到 incompleteResultMaps 集合中

如上流程,第1步和最后一步都是一些常规操作,无需过多解释。第2步和第3步则是接下来需要重点分析的操作,这其中,鉴别器 discriminator 不是很常用的特性,我觉得大家知道它有什么用就行了,所以就不分析了。

1. 解析 id 和 result 节点

在 <resultMap> 节点中,子节点 <id> 和 <result> 都是常规配置,比较常见。下面我们直接分析这两个节点的解析过程。

private ResultMapping buildResultMappingFromContext(XNode context, Class<?> resultType, List<ResultFlag> flags) throws Exception {

// 获取映射的 java 属性名或构造函数形参名(property 或 name 属性配置)

String property;

if (flags.contains(ResultFlag.CONSTRUCTOR)) {

property = context.getStringAttribute("name");

} else {

property = context.getStringAttribute("property");

}

// 获取其他各种属性

String column = context.getStringAttribute("column");

String javaType = context.getStringAttribute("javaType");

String jdbcType = context.getStringAttribute("jdbcType");

String nestedSelect = context.getStringAttribute("select");

/*

* 解析 resultMap 属性,该属性出现在 <association> 和 <collection> 节点中。

* 若这两个节点不包含 resultMap 属性,则调用 processNestedResultMappings 方法解析嵌套 resultMap。

*/

String nestedResultMap = context.getStringAttribute("resultMap", processNestedResultMappings(context, Collections.<ResultMapping>emptyList()));

String notNullColumn = context.getStringAttribute("notNullColumn");

String columnPrefix = context.getStringAttribute("columnPrefix");

String typeHandler = context.getStringAttribute("typeHandler");

String resultSet = context.getStringAttribute("resultSet");

String foreignColumn = context.getStringAttribute("foreignColumn");

boolean lazy = "lazy".equals(context.getStringAttribute("fetchType", configuration.isLazyLoadingEnabled() ? "lazy" : "eager"));

// 解析 javaType、typeHandler 的类型以及枚举类型 JdbcType

Class<?> javaTypeClass = resolveClass(javaType);

Class<? extends TypeHandler<?>> typeHandlerClass = (Class<? extends TypeHandler<?>>) resolveClass(typeHandler);

JdbcType jdbcTypeEnum = resolveJdbcType(jdbcType);

// 构建 ResultMapping 对象

return builderAssistant.buildResultMapping(resultType, property, column, javaTypeClass, jdbcTypeEnum, nestedSelect,

nestedResultMap, notNullColumn, columnPrefix, typeHandlerClass, flags, resultSet, foreignColumn, lazy);

}

上面的方法主要用于获取 <id> 和 <result> 节点的属性,其中,resultMap 属性的解析过程要相对复杂一些。该属性存在于 <association> 和 <collection> 节点中。下面以 <association> 节点为例,演示该节点的两种配置方式,分别如下:

第一种配置方式是通过 resultMap 属性引用其他的 <resultMap> 节点,配置如下:

<resultMap id="articleResult" type="Article">

<id property="id" column="id"/>

<result property="title" column="article_title"/>

<!-- 引用 authorResult -->

<association property="article_author" column="article_author_id" javaType="Author" resultMap="authorResult"/>

</resultMap>

<resultMap id="authorResult" type="Author">

<id property="id" column="author_id"/>

<result property="name" column="author_name"/>

</resultMap>

第二种配置方式是采取 resultMap 嵌套的方式进行配置,如下:

<resultMap id="articleResult" type="Article">

<id property="id" column="id"/>

<result property="title" column="article_title"/>

<!-- resultMap 嵌套 -->

<association property="article_author" javaType="Author">

<id property="id" column="author_id"/>

<result property="name" column="author_name"/>

</association>

</resultMap>

如上配置所示,<association> 的子节点也是一些结果映射配置,这些结果配置最终也会被解析成 ResultMap。

private String processNestedResultMappings(XNode context, List<ResultMapping> resultMappings) throws Exception {

// 判断节点名称

if ("association".equals(context.getName())

|| "collection".equals(context.getName())

|| "case".equals(context.getName())) {

if (context.getStringAttribute("select") == null) {

// resultMapElement 是解析 ResultMap 入口方法

ResultMap resultMap = resultMapElement(context, resultMappings);

// 返回 resultMap id

return resultMap.getId();

}

}

return null;

}

如上,这些嵌套映射配置也是由 resultMapElement 方法解析的,并在最后返回 resultMap.id设置到主映射中。

关于嵌套 resultMap 的解析逻辑就先分析到这,下面分析 ResultMapping 的构建过程。

public ResultMapping buildResultMapping(Class<?> resultType, String property, String column, Class<?> javaType,JdbcType jdbcType,

String nestedSelect, String nestedResultMap, String notNullColumn, String columnPrefix,Class<? extends TypeHandler<?>> typeHandler,

List<ResultFlag> flags, String resultSet, String foreignColumn, boolean lazy) {

/* 解析javaType(获取java属性名对应set方法的返回类型)

* 若 javaType 为空,这里根据 property 的属性进行解析。

* 关于下面方法中的参数,这里说明一下:

* - resultType:即 <resultMap type="xxx"/> 中的 type 属性,即映射的类名

* - property:即 <result property="xxx"/> 中的 property 属性,即映射的属性名

*/

Class<?> javaTypeClass = resolveResultJavaType(resultType, property, javaType);

// 解析 TypeHandler

TypeHandler<?> typeHandlerInstance = resolveTypeHandler(javaTypeClass, typeHandler);

/*

* 解析 column = {property1=column1, property2=column2} 的情况,

* 这里会将 column 拆分成多个 ResultMapping

*/

List<ResultMapping> composites = parseCompositeColumnName(column);

// 通过建造模式构建 ResultMapping

return new ResultMapping.Builder(configuration, property, column, javaTypeClass)

.jdbcType(jdbcType)

.nestedQueryId(applyCurrentNamespace(nestedSelect, true))

.nestedResultMapId(applyCurrentNamespace(nestedResultMap, true))

.resultSet(resultSet)

.typeHandler(typeHandlerInstance)

.flags(flags == null ? new ArrayList<ResultFlag>() : flags)

.composites(composites)

.notNullColumns(parseMultipleColumnNames(notNullColumn))

.columnPrefix(columnPrefix)

.foreignColumn(foreignColumn)

.lazy(lazy)

.build();

}

// -☆- ResultMapping.Builder

public ResultMapping build() {

// 将 flags 和 composites 两个集合变为不可修改集合

resultMapping.flags = Collections.unmodifiableList(resultMapping.flags);

resultMapping.composites = Collections.unmodifiableList(resultMapping.composites);

// 如果未配置 typeHandler 属性,则从 TypeHandlerRegistry 中获取相应 TypeHandler

resolveTypeHandler();

validate();

return resultMapping;

}

ResultMapping 的构建过程不是很复杂,主要过程说明如下:

- 获取映射属性名的 java 类型。

- 根据配置的 typeHandler 属性创建类型处理器实例。

- 处理复合 column。

- 通过建造器构建 ResultMapping 实例。

关于上面方法中出现的一些方法调用,这里接不跟下去分析了,大家可以自己看看。

2. 解析 constructor 节点

constructor节点用于自定义映射对象的构造过程,可以通过有参构造来初始化构造的对象。有如下Java类。

public class ArticleDO {

public ArticleDO(Integer id, String title, String content) {

this.id = id;

this.title = title;

this.content = content;

}

// ...

}

ArticleDO 的构造方法对应的配置如下:

<constructor>

<idArg column="id" name="id"/>

<arg column="title" name="title"/>

<arg column="content" name="content"/>

</constructor>

下面分析 constructor 节点的解析过程。

private void processConstructorElement(XNode resultChild, Class<?> resultType, List<ResultMapping> resultMappings) throws Exception {

// 获取子节点列表

List<XNode> argChildren = resultChild.getChildren();

for (XNode argChild : argChildren) {

List<ResultFlag> flags = new ArrayList<ResultFlag>();

// 向 flags 中添加 CONSTRUCTOR 标志

flags.add(ResultFlag.CONSTRUCTOR);

if ("idArg".equals(argChild.getName())) {

// 向 flags 中添加 ID 标志

flags.add(ResultFlag.ID);

}

// 构建 ResultMapping,上一节已经分析过

resultMappings.add(buildResultMappingFromContext(argChild, resultType, flags));

}

}

首先是获取并遍历子节点列表,然后为每个子节点创建 flags 集合,并添加 CONSTRUCTOR 标志。对于 idArg 节点,额外添加 ID 标志。最后一步则是构建 ResultMapping,该步逻辑前面已经分析过,这里就不多说了。

3. ResultMap 对象构建过程分析

分析完 <resultMap> 的子节点 <id>,<result> 以及 <constructor> 的解析过程,下面来看看 ResultMap 实例的构建过程。下面是之前分析过的 ResultMap 构建的入口。

private ResultMap resultMapElement(XNode resultMapNode, List<ResultMapping> additionalResultMappings) throws Exception {

// 获取 resultMap 节点中的属性

// ...

// 解析 resultMap 对应的类型

// ...

// 遍历 resultMap 节点的子节点,构建 ResultMapping 对象

// ...

// 创建 ResultMap 解析器

ResultMapResolver resultMapResolver = new ResultMapResolver(builderAssistant, id, typeClass, extend,

discriminator, resultMappings, autoMapping);

try {

// 根据前面获取到的信息构建 ResultMap 对象

return resultMapResolver.resolve();

} catch (IncompleteElementException e) {

configuration.addIncompleteResultMap(resultMapResolver);

throw e;

}

}

ResultMap 的构建逻辑封装在 ResultMapResolver 的 resolve 方法中,下面从该方法进行分析。

// -☆- ResultMapResolver

public ResultMap resolve() {

return assistant.addResultMap(this.id, this.type, this.extend, this.discriminator, this.resultMappings, this.autoMapping);

}

上面的方法将构建 ResultMap 实例的任务委托给了 MapperBuilderAssistant 的 addResultMap,我们跟进到这个方法中看看。

// -☆- MapperBuilderAssistant

public ResultMap addResultMap(

String id, Class<?> type, String extend, Discriminator discriminator,

List<ResultMapping> resultMappings, Boolean autoMapping) {

// 为 ResultMap 的 id 和 extend 属性值拼接命名空间

id = applyCurrentNamespace(id, false);

extend = applyCurrentNamespace(extend, true);

// 合并扩展 ResultMap

if (extend != null) {

// 如果 extend 的结果集还未解析,则抛出 IncompleteElementException 异常

if (!configuration.hasResultMap(extend)) {

throw new IncompleteElementException("Could not find a parent resultmap with id '" + extend + "'");

}

// 从 Configuration 中获取所有扩展 ResultMapping

ResultMap resultMap = configuration.getResultMap(extend);

List<ResultMapping> extendedResultMappings = new ArrayList<ResultMapping>(resultMap.getResultMappings());

// 如果主映射已存在该 resultMapping,则将扩展中的移除

extendedResultMappings.removeAll(resultMappings);

// 检测主映射是否有构造器 (即resultMappings 集合中是否包含 CONSTRUCTOR 标志的元素)

boolean declaresConstructor = false;

for (ResultMapping resultMapping : resultMappings) {

if (resultMapping.getFlags().contains(ResultFlag.CONSTRUCTOR)) {

declaresConstructor = true;

break;

}

}

// 如果主映射存在构造器,则移除扩展中的构造器

if (declaresConstructor) {

Iterator<ResultMapping> extendedResultMappingsIter = extendedResultMappings.iterator();

while (extendedResultMappingsIter.hasNext()) {

if (extendedResultMappingsIter.next().getFlags().contains(ResultFlag.CONSTRUCTOR)) {

extendedResultMappingsIter.remove();

}

}

}

// 合并扩展映射到主映射中

resultMappings.addAll(extendedResultMappings);

}

// 构建 ResultMap

ResultMap resultMap = new ResultMap.Builder(configuration, id, type, resultMappings, autoMapping)

.discriminator(discriminator)

.build();

configuration.addResultMap(resultMap);

return resultMap;

}

上面的方法主要用于合并 extend 属性指定的扩展映射,并删除一些多余的映射列。随后,通过建造模式构建 ResultMap 实例。

// -☆- ResultMap

public ResultMap build() {

if (resultMap.id == null) {

throw new IllegalArgumentException("ResultMaps must have an id");

}

// 保存所有被映射的数据库列名(大写形式)

resultMap.mappedColumns = new HashSet<String>();

// 保存所有被映射的java属性名

resultMap.mappedProperties = new HashSet<String>();

// 保存所有的id标记映射列(如果没有一个列有id标记,则把所有列都当作id列)

resultMap.idResultMappings = new ArrayList<ResultMapping>();

// 保存所有的构造器映射列(并按照构造方法参数列表的顺序进行排序)

resultMap.constructorResultMappings = new ArrayList<ResultMapping>();

// 保存所有的非构造器映射列

resultMap.propertyResultMappings = new ArrayList<ResultMapping>();

// 保存所有的构造器参数名

final List<String> constructorArgNames = new ArrayList<String>();

// 遍历所有 ResultMapping

for (ResultMapping resultMapping : resultMap.resultMappings) {

// 检测是否存在嵌套查询

resultMap.hasNestedQueries = resultMap.hasNestedQueries || resultMapping.getNestedQueryId() != null;

// 检测是否存在嵌套映射

resultMap.hasNestedResultMaps =

resultMap.hasNestedResultMaps || (resultMapping.getNestedResultMapId() != null && resultMapping.getResultSet() == null);

// 将 column 转换成大写,并添加到 mappedColumns 集合中

final String column = resultMapping.getColumn();

if (column != null) {

resultMap.mappedColumns.add(column.toUpperCase(Locale.ENGLISH));

} else if (resultMapping.isCompositeResult()) {

// 复合列的特殊处理

for (ResultMapping compositeResultMapping : resultMapping.getComposites()) {

final String compositeColumn = compositeResultMapping.getColumn();

if (compositeColumn != null) {

resultMap.mappedColumns.add(compositeColumn.toUpperCase(Locale.ENGLISH));

}

}

}

// 添加属性 property 到 mappedProperties 集合中

final String property = resultMapping.getProperty();

if (property != null) {

resultMap.mappedProperties.add(property);

}

// 检测当前 resultMapping 是否包含 CONSTRUCTOR 标志

if (resultMapping.getFlags().contains(ResultFlag.CONSTRUCTOR)) {

// 添加 resultMapping 到 constructorResultMappings 中

resultMap.constructorResultMappings.add(resultMapping);

// 添加属性(constructor 节点的 name 属性)到 constructorArgNames 中

if (resultMapping.getProperty() != null) {

constructorArgNames.add(resultMapping.getProperty());

}

} else {

// 添加 resultMapping 到 propertyResultMappings 中

resultMap.propertyResultMappings.add(resultMapping);

}

if (resultMapping.getFlags().contains(ResultFlag.ID)) {

// 添加 resultMapping 到 idResultMappings 中

resultMap.idResultMappings.add(resultMapping);

}

}

// 如果没有一个列有id标记,则把所有列都当作id列

if (resultMap.idResultMappings.isEmpty()) {

resultMap.idResultMappings.addAll(resultMap.resultMappings);

}

if (!constructorArgNames.isEmpty()) {

// 获取实际的构造方法参数列表(解析@Param注解获取实际配置的形参名(通过参数数量和类型来进行匹配构造器))

final List<String> actualArgNames = argNamesOfMatchingConstructor(constructorArgNames);

if (actualArgNames == null) {

throw new BuilderException("Error in result map '" + resultMap.id

+ "'. Failed to find a constructor in '"

+ resultMap.getType().getName() + "' by arg names " + constructorArgNames

+ ". There might be more info in debug log.");

}

// 对 constructorResultMappings 按照构造方法参数列表的顺序进行排序

Collections.sort(resultMap.constructorResultMappings, new Comparator<ResultMapping>() {

@Override

public int compare(ResultMapping o1, ResultMapping o2) {

int paramIdx1 = actualArgNames.indexOf(o1.getProperty());

int paramIdx2 = actualArgNames.indexOf(o2.getProperty());

return paramIdx1 - paramIdx2;

}

});

}

// 将以下这些集合变为不可修改集合

resultMap.resultMappings = Collections.unmodifiableList(resultMap.resultMappings);

resultMap.idResultMappings = Collections.unmodifiableList(resultMap.idResultMappings);

resultMap.constructorResultMappings = Collections.unmodifiableList(resultMap.constructorResultMappings);

resultMap.propertyResultMappings = Collections.unmodifiableList(resultMap.propertyResultMappings);

resultMap.mappedColumns = Collections.unmodifiableSet(resultMap.mappedColumns);

return resultMap;

}

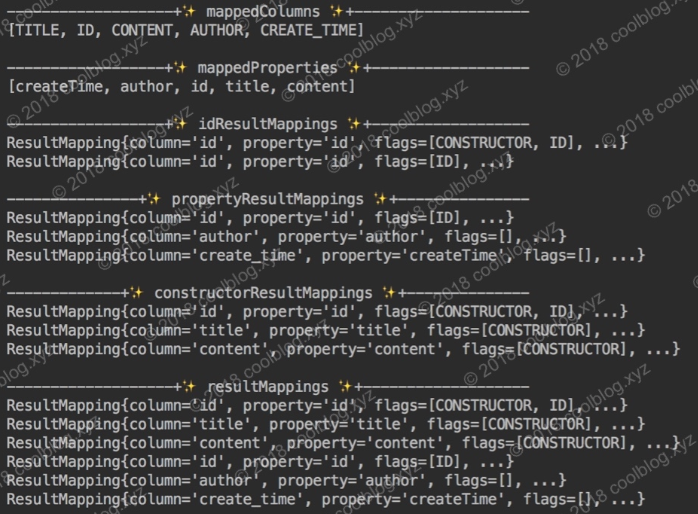

以上代码看起来很复杂,但实际上只是将 ResultMapping 实例及属性分别存储到不同的集合中而已。写点代码测试一下,并把这些集合的内容打印到控制台上,大家直观感受一下。先定义一个映射文件,如下:

<mapper namespace="xyz.coolblog.dao.ArticleDao">

<resultMap id="articleResult" type="xyz.coolblog.model.Article">

<constructor>

<idArg column="id" name="id"/>

<arg column="title" name="title"/>

<arg column="content" name="content"/>

</constructor>

<id property="id" column="id"/>

<result property="author" column="author"/>

<result property="createTime" column="create_time"/>

</resultMap>

</mapper>

测试代码如下:

public class ResultMapTest {

@Test

public void printResultMapInfo() throws Exception {

Configuration configuration = new Configuration();

String resource = "mapper/ArticleMapper.xml";

InputStream inputStream = Resources.getResourceAsStream(resource);

XMLMapperBuilder builder = new XMLMapperBuilder(inputStream, configuration, resource, configuration.getSqlFragments());

builder.parse();

ResultMap resultMap = configuration.getResultMap("articleResult");

System.out.println("\n-------------------+✨ mappedColumns ✨+--------------------");

System.out.println(resultMap.getMappedColumns());

System.out.println("\n------------------+✨ mappedProperties ✨+------------------");

System.out.println(resultMap.getMappedProperties());

System.out.println("\n------------------+✨ idResultMappings ✨+------------------");

resultMap.getIdResultMappings().forEach(rm -> System.out.println(simplify(rm)));

System.out.println("\n---------------+✨ propertyResultMappings ✨+---------------");

resultMap.getPropertyResultMappings().forEach(rm -> System.out.println(simplify(rm)));

System.out.println("\n-------------+✨ constructorResultMappings ✨+--------------");

resultMap.getConstructorResultMappings().forEach(rm -> System.out.println(simplify(rm)));

System.out.println("\n-------------------+✨ resultMappings ✨+-------------------");

resultMap.getResultMappings().forEach(rm -> System.out.println(simplify(rm)));

inputStream.close();

}

/** 简化 ResultMapping 输出结果 */

private String simplify(ResultMapping resultMapping) {

return String.format("ResultMapping{column='%s', property='%s', flags=%s, ...}",

resultMapping.getColumn(), resultMapping.getProperty(), resultMapping.getFlags());

}

}

结果如下:

第五节 解析 sql 节点

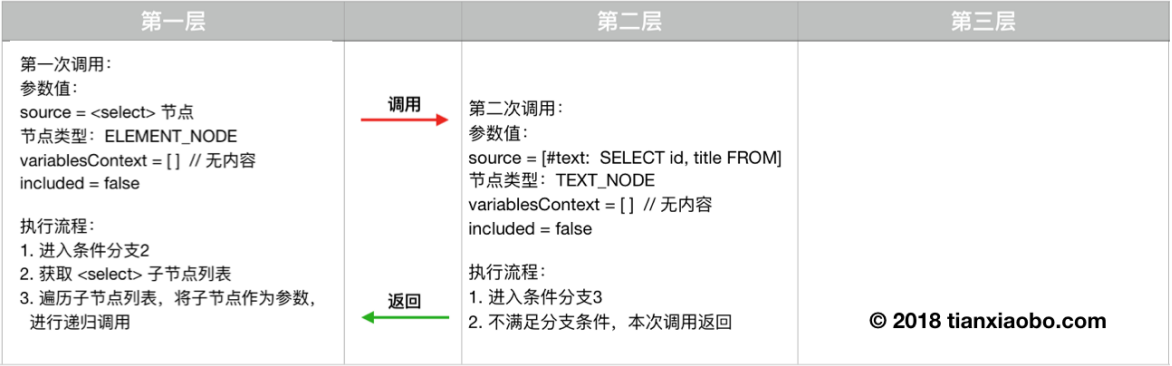

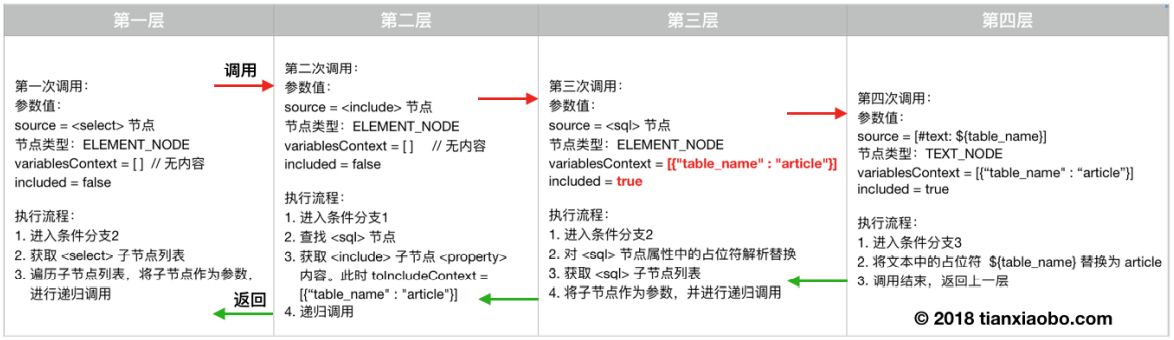

<sql> 节点用来定义一些可重复使用的 SQL 语句片段,如表名,或表的列名等。在映射文件中,可以通过 <include> 节点引用 <sql> 节点定义的内容。下面是 <sql> 节点的使用方式,如下:

<!--定义一个sql节点,id为table,内容为“article”-->

<sql id="table">

article

</sql>

<!--定义一个带占位符的sql节点,占位符可以从全局属性中解析,也可以从include标签的属性解析-->

<sql id="table">

${table_prefix}_article

</sql>

<!--通过include标签引用定义的sql节点-->

<select id="findOne" resultType="Article">

SELECT id, title

FROM <include refid="table"/>

WHERE id = #{id}

</select>

下面分析一下 sql 节点的解析过程,如下:

private void sqlElement(List<XNode> list) throws Exception {

if (configuration.getDatabaseId() != null) {

// 调用 sqlElement 解析 <sql> 节点

sqlElement(list, configuration.getDatabaseId());

}

// 再次调用 sqlElement,不同的是,这次调用,该方法的第二个参数为 null

sqlElement(list, null);

}

这里需注意下 databaseId 属性的特殊处理,后面会多次用到。MyBatis一般采用 两次调用的方式来处理databaseId 问题,第一次带上下文中的数据库厂商调用,第二次使用NULL调用。即优先解析匹配数据库厂商标识的标签,如果不存在匹配的,则解析不带数据库厂商标识的标签。继续往下分析。

private void sqlElement(List<XNode> list, String requiredDatabaseId) throws Exception {

for (XNode context : list) {

// 获取 id 和 databaseId 属性

String databaseId = context.getStringAttribute("databaseId");

String id = context.getStringAttribute("id");

// id = currentNamespace + "." + id

id = builderAssistant.applyCurrentNamespace(id, false);

// 检测当前 databaseId 和 requiredDatabaseId 是否一致

if (databaseIdMatchesCurrent(id, databaseId, requiredDatabaseId)) {

// 将 <id, XNode> 键值对缓存到 sqlFragments 中

sqlFragments.put(id, context);

}

}

}

首先是获取 <sql> 节点的 id 和 databaseId 属性,然后为 id 属性值拼接命名空间。最后,通过检测当前 databaseId 和 requiredDatabaseId 是否一致,来决定保存还是忽略当前的 <sql> 节点。

下面,我们来看一下 databaseId 的匹配逻辑是怎样的。

private boolean databaseIdMatchesCurrent(String id, String databaseId, String requiredDatabaseId) {

if (requiredDatabaseId != null) {

// 当前 databaseId 和目标 databaseId 不一致时,返回 false

if (!requiredDatabaseId.equals(databaseId)) {

return false;

}

} else {

// 如果目标 databaseId 为空,但当前 databaseId 不为空。两者不一致,返回 false

if (databaseId != null) {

return false;

}

/*

* 如果当前 <sql> 节点的 id 与之前的 <sql> 节点重复,且先前节点

* databaseId 不为空。则忽略当前节点,并返回 false

*/

if (this.sqlFragments.containsKey(id)) {

XNode context = this.sqlFragments.get(id);

if (context.getStringAttribute("databaseId") != null) {

return false;

}

}

}

return true;

}

下面总结一下 databaseId 的匹配规则。

- databaseId 与 requiredDatabaseId 不一致,即失配,返回 false

- 当前节点与之前的节点出现 id 重复的情况,若之前的

<sql>节点 databaseId 属性不为空,返回 false。 - 若以上两条规则均匹配失败,此时返回 true

在上面三条匹配规则中,第二条规则稍微难理解一点。这里简单分析一下,考虑下面这种配置。

<!-- databaseId 不为空 -->

<sql id="table" databaseId="mysql">

article

</sql>

<!-- databaseId 为空 -->

<sql id="table">

article

</sql>

在上面配置中,两个 <sql> 节点的 id 属性值相同,databaseId 属性不一致。假设 configuration.databaseId = mysql,第一次调用 sqlElement 方法,第一个 <sql> 节点对应的 XNode 会被放入到 sqlFragments 中。第二次调用 sqlElement 方法时,requiredDatabaseId 参数为空。由于 sqlFragments 中已包含了一个 id 节点,且该节点的 databaseId 不为空,此时匹配逻辑返回 false,第二个节点不会被保存到 sqlFragments。

第六节 解析 statement 节点

Statement节点指 SQL 语句节点,包括用于查询的<select>节点,以及执行更新和其它类型语句<update>、<insert>和<delete>节点,四者配置方式非常相似,因此放在一起进行解析。

private void buildStatementFromContext(List<XNode> list) {

if (configuration.getDatabaseId() != null) {

// 调用重载方法构建 Statement

buildStatementFromContext(list, configuration.getDatabaseId());

}

// 调用重载方法构建 Statement,requiredDatabaseId 参数为空

buildStatementFromContext(list, null);

}

private void buildStatementFromContext(List<XNode> list, String requiredDatabaseId) {

for (XNode context : list) {

// 创建 Statement 建造类

final XMLStatementBuilder statementParser = new XMLStatementBuilder(configuration, builderAssistant, context, requiredDatabaseId);

try {

// 解析 Statement 节点,并将解析结果存储到 configuration 的 mappedStatements 集合中

statementParser.parseStatementNode();

} catch (IncompleteElementException e) {

// 解析失败,将解析器放入 configuration 的 incompleteStatements 集合中

configuration.addIncompleteStatement(statementParser);

}

}

}

上面的解析方法没有什么实质性的解析逻辑,我们继续往下分析。

public void parseStatementNode() {

// 获取 id 和 databaseId 属性

String id = context.getStringAttribute("id");

String databaseId = context.getStringAttribute("databaseId");

// 根据 databaseId 进行检测,检测逻辑和上一节基本一致,这里不再赘述

if (!databaseIdMatchesCurrent(id, databaseId, this.requiredDatabaseId)) {

return;

}

// 获取各种属性

Integer fetchSize = context.getIntAttribute("fetchSize");

Integer timeout = context.getIntAttribute("timeout");

String parameterMap = context.getStringAttribute("parameterMap");

String parameterType = context.getStringAttribute("parameterType");

Class<?> parameterTypeClass = resolveClass(parameterType);