Title:Ship Energy Scheduling with DQN-CE Algorithm Combining Bi-directional LSTM and Attention Mechanism

【Applied Energy】结合双向LSTM和注意力机制的DQN-CE算法船舶能量调度(中科院1区Top,IF 11.2)

具体实现方法可以参考原文:论文地址

欢迎大家引用和交流,具体问题可以给我留言,后面有空也会详细介绍实现过程。

Highlights

(1)建立了AES电力系统智能能量调度环境。

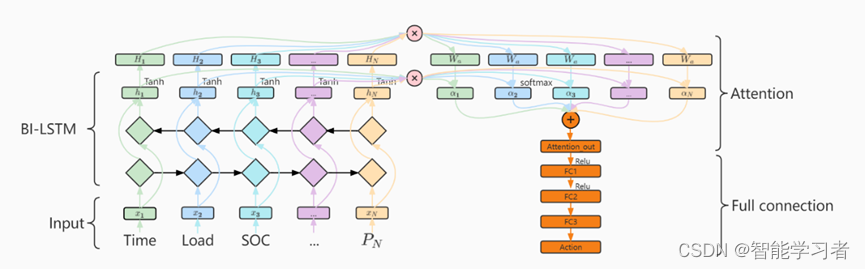

(2)将BI-LSTM与注意力机制相结合,提出了BI-LSTM-Att行动网络。

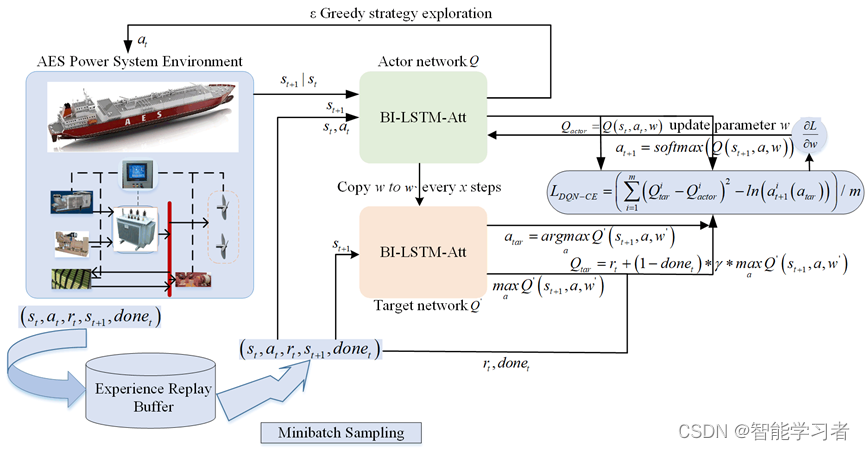

(3)通过对DQN算法进行改进提出了DQN-CE算法。

(4)在全电动渡轮上在多个场景下进行了多个方法的对比实验,从而验证了本文方法的有效性和优越性。

Research gap

(1) 目前大多数基于DRL的能量调度算法基本上都是采用MLP作为动作网络,只对MLP的隐藏层层数、节点数和激活函数等进行调整,暂时未有对动作网络结构的研究探索,而MLP作为动作网络对DRL性能提升是有限的,因此本文提出了新的DRL动作网络。

(2) 在AES能量调度问题中,基于DQN的能量调度算法已有较多的研究和应用,但是DQN算法本身存在Q值估计过高的问题,而一般来说Q值的过高估计会降低算法性能,降低DQN算法Q估计值可提高算法性能。在AES能量调度领域,尚未有发现对DQN算法进行改进的研究,因此本文对DQN损失函数进行了改进。

摘要

基于深度强化学习(DRL)的船舶能量调度是目前研究的重要方向,其中深度Q学习算法(Deep Q-learning,DQN)在能量调度领域已有较多成功运用的案例,本文针对全电力船舶(All-Electric Ships,AES)能量调度中DQN算法使用多层感知机(MLP)作为动作网络性能不足,以及DQN过高估计Q值导致收敛性能降低问题,提出了一个结合双向LSTM和注意力机制(BI-LSTM-Att)的DQN交叉熵(DQN-CE)能量调度算法。首先将BI-LSTM-Att代替MLP作为DQN动作网络,然后在此基础上,提出了一个改进的DRL算法DQN-CE,即在DQN损失函数的基础上,增加了目标网络和动作网络下一时刻预测动作的交叉熵损失。在全电力渡轮上进行了仿真实验,实验结果显示本文提出的能量调度算法相比原始DQN能量调度算法,经济消耗降低了4.11%,对能量存储系统的利用率提高了24.4%,智能体训练探索时间减少了31.3%。最后在新的案例下进一步验证了算法的有效性和优越性。

Abstract

At present, Ship energy scheduling based on deep reinforcement learning (DRL) is an important research direction in which Deep Q learning algorithm(DQN) has been successfully applied in the field of energy scheduling. In terms of the shortcomings of DQN in all electric ships(AES) energy scheduling, such that, the insufficient performance of using multiplayer perceptron(MLP) as action network and the degradation of convergence performance due to over estimation of Q value, in this paper, we propose a DQN cross entropy(DQN-CE) energy scheduling algorithm combing bi-directional LSTM and attention mechanism(BI-LSTM-Att). Instead of using MLP, firstly, we use BI-LSTM-Att as action network of DQN, and then an improved DRL algorithm called DQN-CE is proposed, that is, we add cross-entropy loss of predicted action of the next time for the target network and the action network to DQN. Finally, we conduct simulation experiments on an all-electric ferry, and the experimental results show that the energy scheduling algorithm proposed in this paper reduces the economic consumption by 4.11%, increases the utilization rate of energy storage system by 24.4%, and reduces the exploration time of agent training by 31.3% compared with the original DQN energy scheduling algorithm. Finally, the effectiveness and superiority of the algorithm were further verified in the new case study.

Keywords

Energy scheduling 能量调度

AES 全电力船舶

DQN深度Q网络

MLP多层感知机

BI-LSTM-Att 结合BI-LSTM和注意力机制动作网络

DQN-CE深度Q学习交叉熵算法

Schematics

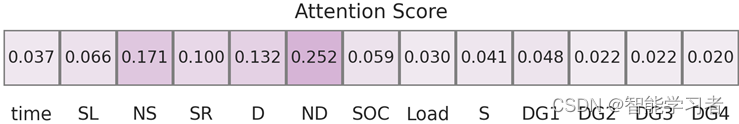

图1 BI-LSTM-Att动作网

图2 带有经验回放和冻结参数的DQN-CE训练流程

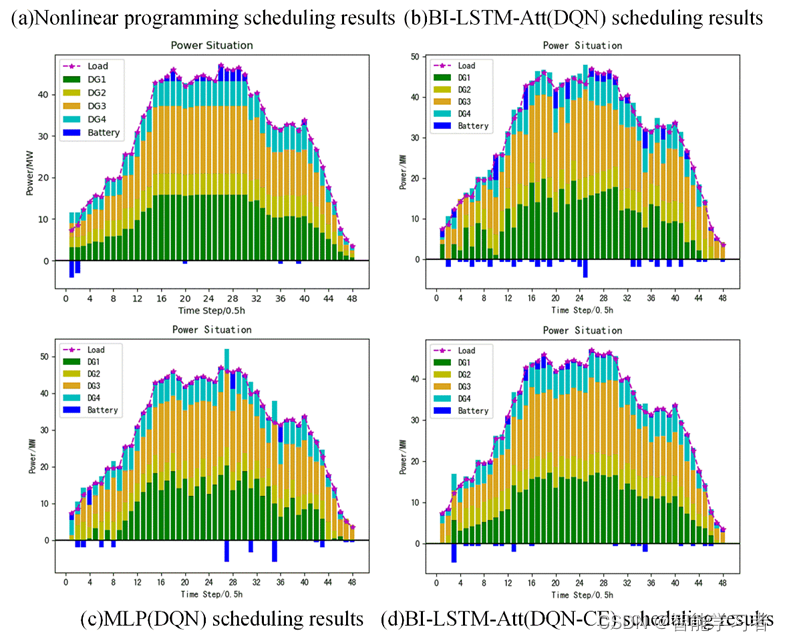

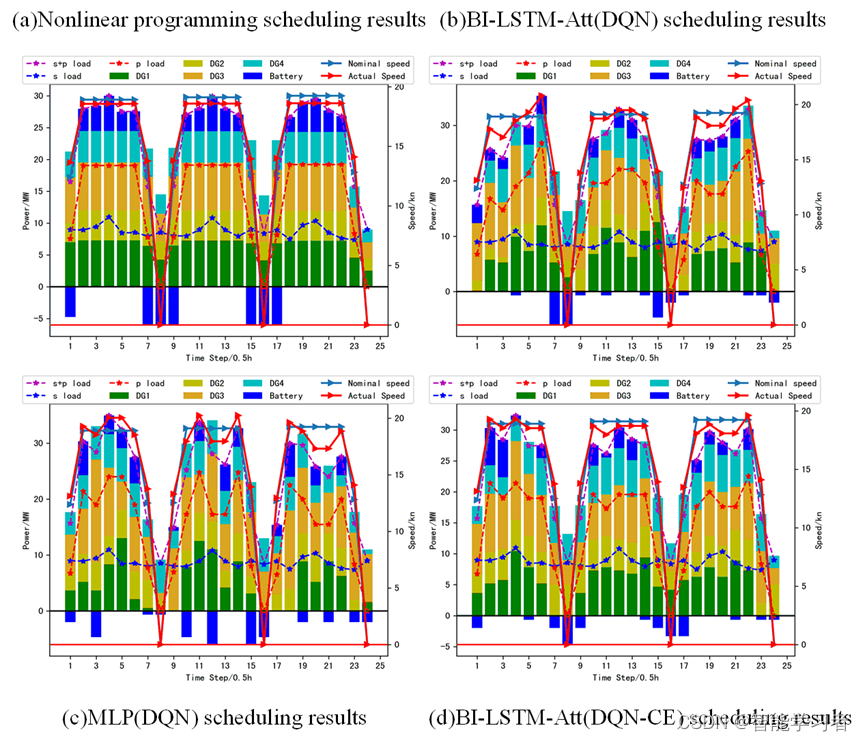

图3 在自由航行场景下的功率调度结果

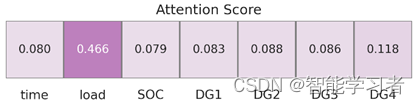

(a)BI-LSTM-Att(DQN)

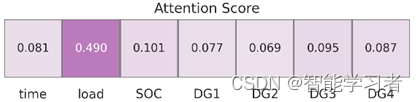

(b)BI-LSTM-Att (DQN-CE)

图4 在自由航行场景下注意力机制可视化结果

图5 在固定航程场景下能量和速度协同调度结果

(a)BI-LSTM-Att(DQN)

(b)BI-LSTM-Att (DQN-CE)

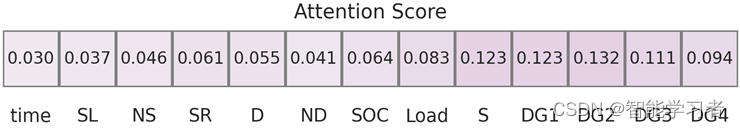

图6在固定航程场景下注意力机制可视化结果

1806

1806

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?