以爬取百度首页为例子

直接上代码

import requests

url="http://www.baidu.com"

html=requests.get(url).text

print(html)

输出结果乱码,可这是为什么呢?很明显是编码问题造成的

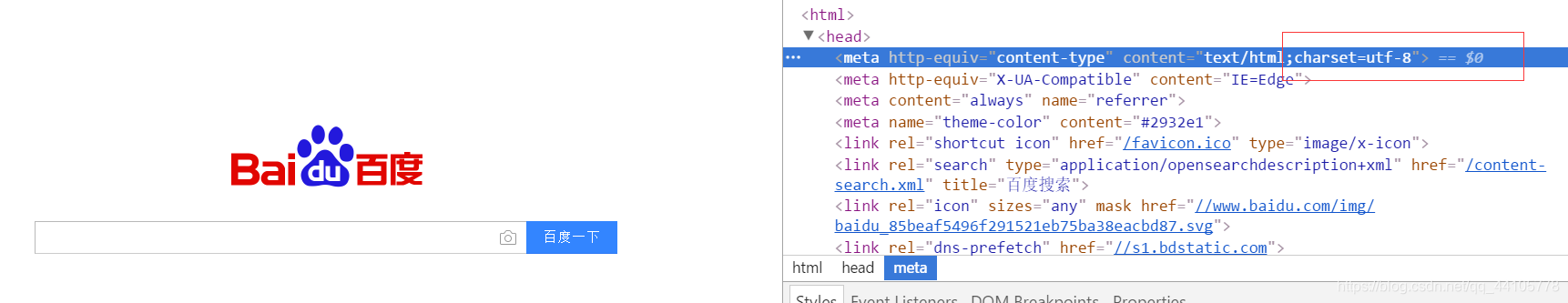

我们去百度看下网页源码,编码为utf-8

然而我们的编译器,采用的也是utf-8,都是utf-8为什么会乱码呢?这时候就想到了,直接输出百度首页的编码方式

import requests

import sys

//输出我们编译器所用的编码

print(sys.getdefaultencoding())

url="http://www.baidu.com"

html=requests.get(url)

//输出百度的编码

print(html.encoding)

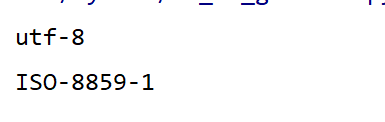

输出结果如下

乖乖,竟然是ISO-8859-1,不是utf-8,可这个是为什么呢,可能是由于网页压缩问题,我也是瞎猜的,哈哈。

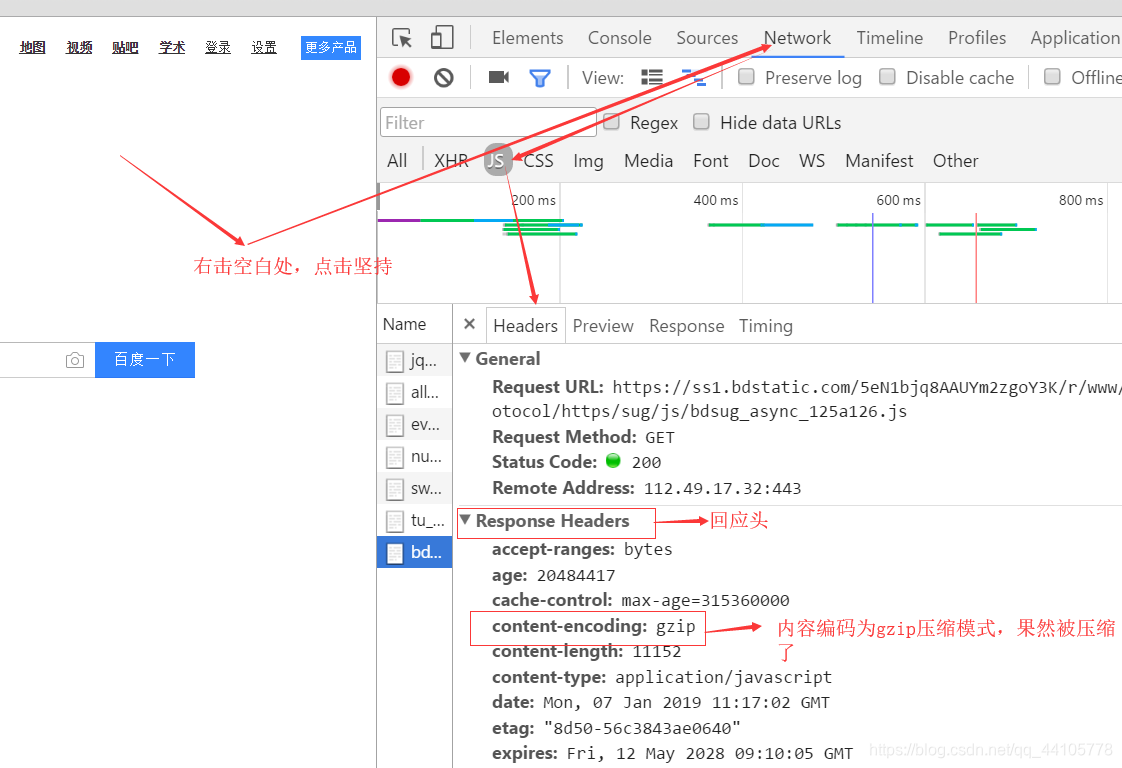

那么我们就来用谷歌浏览器查看下该网页是否被压缩

接下来我们就进行编码转化

import requests

url="http://www.baidu.com"

html=requests.get(url).text

#encode编码,将ISO-8859-1编码成unicode

html=html.encode("ISO-8859-1")

#decode解码,将unicode解码成utf-8

html=html.decode("utf-8")

print(html)

问题解决

当然还有一种简单的方法

encoding是从http中的header中的charset字段中提取的编码方式,若header 中没有charset字段则默认为ISO-8859-1编码模式,则无法解析中文,这是乱码的原因。

apparent_encoding会从网页的内容中分析网页编码的方式,所以apparent_encoding比encoding更加准确。当网页出现乱码时可以把apparent_encoding的编码格式赋值给encoding。

import requests

url = "http://www.baidu.com"

r = requests.get(url)

# 修改为网页的编码方式

r.encoding = r.apparent_encoding

# 输出网页内容

print(r.text)

5230

5230

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?