@R星校长

开发 PySpark 所需准备环境

1) 安装 python 环境

下载安装Anaconda。 详细见文档 “Anaconda安装及使用.docx”。

2) 安装 PyCharm

下载安装 PyCharm。

3) 官网下载 Spark 安装包

由于 PyCharm 开发 spark 需要本地 Spark 环境,所以要在官网中下载 Spark 安装包到本地(这里我们下载 Spark1.6 版本)。

A. 进入 Spark 官网,找到对应的 Spark 版本下载。

B. 将下载好的安装包解压到本地某个路径(路径中不要有空格和中文)

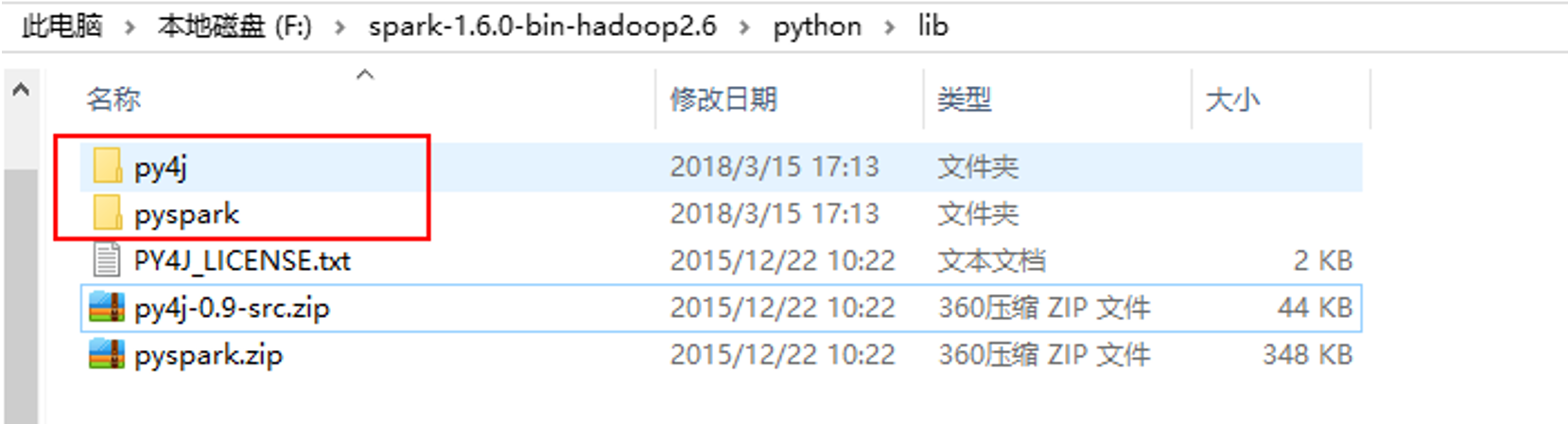

C. 将解压的路径中的…spark….\python\lib下的以下两个压缩包解压

解压后:

注意:

★py4j 是一个用 Python 和 Java 编写的库。通过 Py4J,Python 程序能够动态访问 Java 虚拟机中的 Java 对象,Java 程序也能够回调 Python 对象。

★pyspark 是 Spark 为 Python 开发者提供的 API。

PyCharm 开发 Spark 应用程序

使用 PyCharm 开发 Spark 应用环境需要配置 Python 环境,我们使用的 Spark1.6 版本,Spark2.1 以下版本不支持 python3.6 版本,所以我们使用兼容性比较好的 Python3.5 版本,需要在 PyCharm 中配置。具体如下:

1) 打开 PyCharm 创建新的项目

本文介绍了如何搭建PySpark开发环境,包括安装Anaconda、PyCharm,从官网下载Spark并配置SPARK_HOME。强调了PyCharm中配置Python环境的重要性,特别是针对Spark1.6版本需要使用Python3.5。最后,指出了运行脚本时可能遇到的问题及解决办法,如指定pyspark的Python版本。

本文介绍了如何搭建PySpark开发环境,包括安装Anaconda、PyCharm,从官网下载Spark并配置SPARK_HOME。强调了PyCharm中配置Python环境的重要性,特别是针对Spark1.6版本需要使用Python3.5。最后,指出了运行脚本时可能遇到的问题及解决办法,如指定pyspark的Python版本。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?