概要:

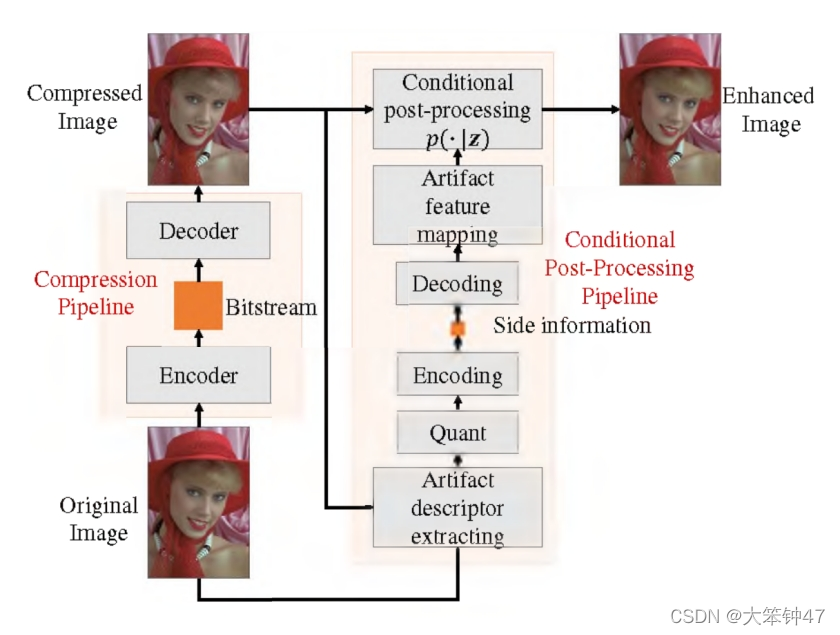

该文提出通过传输side信息来减弱基于神经网络压缩方法的伪影。

6.1 应用场景:

该文的工作是初步的探索端到端学习边信息的压缩,为得到增强的解码信息提供了借鉴。

6.2 关键设计思路:

边信息是由编码器通过分析原始图像和压缩图像之间的差别而获得的伪影描述符。在解码器中,接收到的描述符作为后处理神经网络的附加输入。同时为了降低传输开销,在速率失真约束下,通过端到端学习对整个模型进行了联合优化。

](https://i-blog.csdnimg.cn/blog_migrate/65a0c5f67082be029bebd2b4078a6c88.png)

模型架构

6.2.1 Artifact Decriptor Extraction

下图为所设计的Artifact Descriptor提取神经网络的结构。

原始图像和压缩图像分别经过三个卷积层,提取特征 f o r i f_{ori} fori和 f r e c f_{rec} frec, f o r i f_{ori} fori、 f r e c f_{rec} frec和它们的差异拼接在一起,输入到后续的层中。在最后一步中使用了1x1的卷积和softmax操作来将特征映射到浮点概率向量,称为伪影描述符。我们将伪影描述符的通道维度设置为16。它也有可能取另一种取值。

6.2.2 Quantization

为了量化浮点伪影描述符,同时确保梯度在反向传播过程中能够通过量化层,该文利用了soft-to-hard量化。具体地说,从图像中提取的每个Artifact描述符

x

∈

R

16

x\in R^{16}

x∈R16都需要被量化为16个one-hot向量

C

=

{

c

1

,

c

2

,

.

.

.

,

c

16

}

∈

B

16

C=\{c_1,c_2,...,c_{16}\}\in B^{16}

C={c1,c2,...,c16}∈B16中的一个。在正向传递中,x被量化为最近的one-hot向量。

x

^

=

Q

h

a

r

d

(

x

)

=

a

r

g

min

i

D

K

L

(

x

,

c

i

)

\hat{x}=Q_{hard}(x)=arg \min \limits_{i}D_{KL}(x,c_i)

x^=Qhard(x)=argiminDKL(x,ci)

播在反向传递中,将上述公式近似为软量化,以保证反向传播:

x

^

=

Q

s

o

f

t

(

x

)

=

∑

i

=

1

16

e

c

p

(

−

σ

D

K

L

(

x

,

c

i

)

)

∑

j

=

1

16

e

x

p

(

−

σ

D

K

L

(

x

,

c

j

)

)

c

i

\hat{x}=Q_{soft}(x)=\sum \limits_{i=1}^{16}\frac{ecp(-\sigma D_{KL}(x,c_i))}{\sum_{j=1}^{16}exp(-\sigma D_{KL}(x,c_j))}c_i

x^=Qsoft(x)=i=1∑16∑j=116exp(−σDKL(x,cj))ecp(−σDKL(x,ci))ci

6.2.3 Rate Estimation

采用中上下文模型的思想来准确估计传输侧信息的比特率。

在训练过程中,需要同时考虑侧边信息的比特率和重建信息的质量。与端到端图像压缩类似,设计的训练损失如下:

L

=

D

+

λ

R

L=D+\lambda R

L=D+λR

其中,D是输出和原始图像之间的均方误差(MSE),R估计边信息的比特率。

具体来说,该文使用一个5x5掩蔽卷积层和三个1x1卷积层来实现上下文模型。输出有16个通道,沿通道方向标准化softmax,得到概率向量

p

∈

R

16

p\in R^{16}

p∈R16。比特率可以计算如下:

R

=

∑

x

^

∈

X

l

o

g

2

(

x

^

⋅

p

x

^

)

∣

∣

x

∣

∣

R=\frac{\sum_{\hat{x}\in X}log_2(\hat{x}\cdot p_{\hat{x}})}{||x||}

R=∣∣x∣∣∑x^∈Xlog2(x^⋅px^)

式中,X是一幅图像的所有量化Artifact描述符的集合,

x

^

⋅

p

x

^

\hat{x}\cdot p_{\hat{x}}

x^⋅px^表示向量

x

x

x和

p

x

^

p_{\hat{x}}

px^之间的向量点积,||X||为X的大小。

6.2.4 Artifact Feature Mapping

在重构解码器中的Artifact描述符后,首先通过下图所示的神经网络将这些one-hot向量转换为浮点数向量,其中“2x”和“8x”代表2倍和8倍的上采样。

6.2.5 Conditional Residual Block

我们去掉了EDSR神经网络中的上采样层,并将其作为后处理神经网络的主干。为了区别于它和原网络,我们称之为EDSR-baseline*。对于条件概率模型,Artifact特征在1x1的卷积层后直接乘以残差块的输入特征。

6.3 测试条件:

JPEG

6.4 测试效率

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-onSmMCOv-1648649510002)(file:///C:\Users\LIUJIA~1\AppData\Local\Temp\ksohtml\wpsEDCD.tmp.jpg)]](https://i-blog.csdnimg.cn/blog_migrate/be7e266b8406b4d417cfbc0c0474fc24.png)

DIV2K验证数据集上的RD曲线

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-nOyfeNeL-1648649510003)(file:///C:\Users\LIUJIA~1\AppData\Local\Temp\ksohtml\wpsEDCE.tmp.jpg)]](https://i-blog.csdnimg.cn/blog_migrate/8f760be457fa66fbc9f62ccd1a7bb513.png)

LIVE1验证数据集上的RD曲线

6.5 Reference

Reference:Improving Compression Artifact Reduction via End-to-End Learning of Side Information

1016

1016

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?