1. 把hadoop-2.6.4.tar.gz拖放到/usr/local目录下

2. 使用命令tar -zxvf hadoop-2.6.4.tar.gz解压缩,产生文件夹/usr/local/hadoop-2.6.4

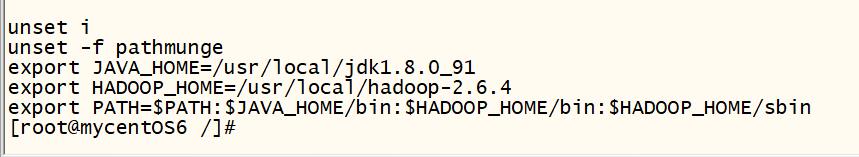

3. 编辑/etc/profile,增加环境变量。记得source /etc/profile

export HADOOP_HOME=/usr/local/hadoop-2.6.4

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

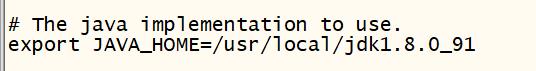

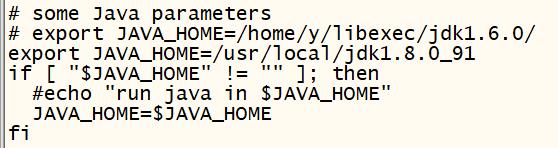

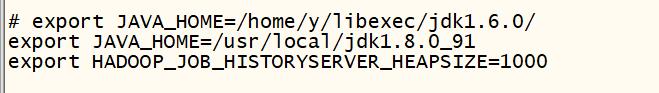

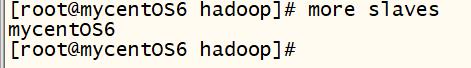

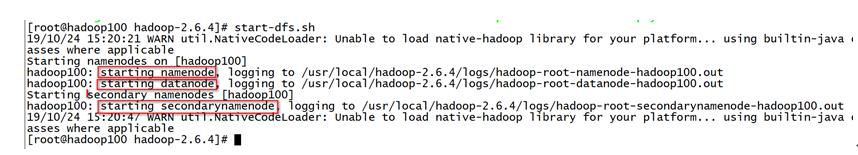

4. 修改/usr/local/hadoop-2.6.4/etc/hadoop目录下的配置文件

<value>hdfs://hadoop100:9000</value>

<value>/usr/local/hadoop-2.6.4/data/tmp</value>

(3) hdfs-site.xml (从节点数量 是指备份数量)

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop100:50090</value>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

<name>yarn.resourcemanager.hostname</name>

(7) mapred-site.xml (mapred-site.xml .template)

<name>mapreduce.framework.name</name>

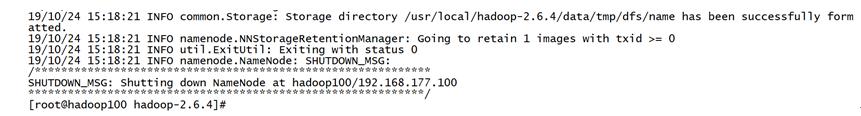

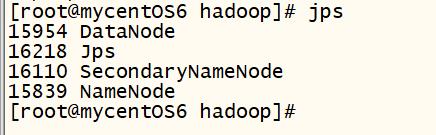

(单点启动节点 :hadoop-daemon.sh start namenode)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?