RNN没有机制去关注某些地方,或者不关注某些地方。

门控神经网络,通过一些gating单元使得我们在构造隐藏状态的时候可以选择重要的,忘记不重要的。同注意力机制。

更新门:发现一个数据比较重要,想要尽量用它去更新隐藏状态。

遗忘门(重置门):发现一个到目前为止不重要的,可能是输入,或者是隐藏状态里的一部分。

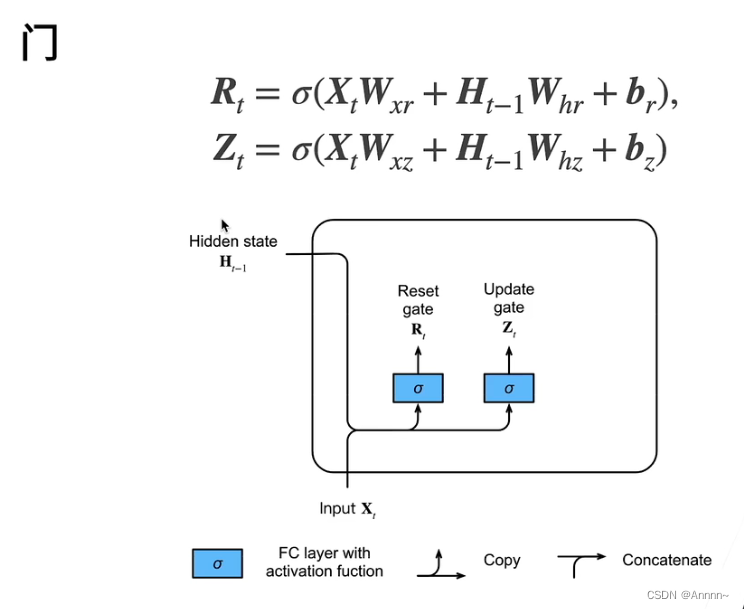

上图表示一个层, 有一个输入:;一个隐藏状态

.

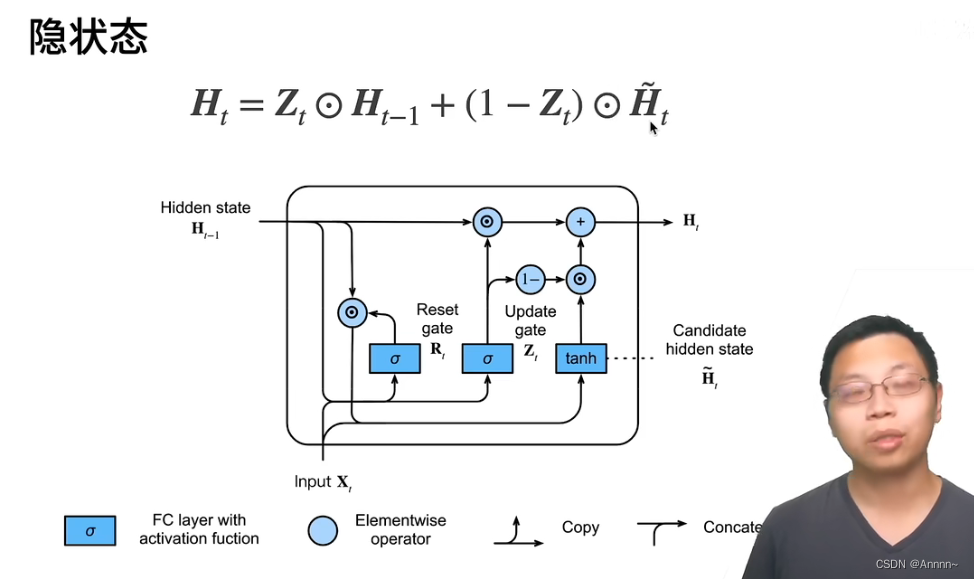

候选隐状态:去掉,隐状态计算方法同RNN。

![]() :按元素乘法的意思。

:按元素乘法的意思。

如果的元素靠近0,

的结果就会靠近0.

的结果就会靠近0.

真正的隐状态是按元素点乘上一次的隐状态+(1-

)点乘候选隐藏状态。

如果=0:基本就回到了RNN的状态。不去看过去的状态,只看现在的状态。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?