数据库设计:

CREATE TABLE t_user(

`id` BIGINT(20) NOT NUll COMMENT '用户ID,手机号码',

`nickname` VARCHAR(255) NOT NULL,

`password` VARCHAR(32) DEFAULT NULL COMMENT 'MD5(MD5(pass明文+固定salt)+salt)',

`slat` VARCHAR(10) DEFAULT NULL,

`head` VARCHAR(128) DEFAULT NULL COMMENT '头像',

`register_date` datetime DEFAULT NULL COMMENT '注册时间',

`last_login_date` datetime DEFAULT NULL COMMENT '最后一次登录时间',

`login_count` int(11) DEFAULT '0' COMMENT '登录次数',

PRIMARY KEY(`id`)

)

上面两次MD5加密,第一次因为用户输入的是明文,在客户端加密;第二次MD5加密是后端接收到第一次加密的密文然后存储到数据库里面进行一次MD5加密。

pom.xml增加md5依赖:

<!--md5依赖-->

<dependency>

<groupId>commons-codec</groupId>

<artifactId>commons-codec</artifactId>

<version>1.15</version>

</dependency>

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-lang3</artifactId>

<version>3.12.0</version>

</dependency>上面md5对后端帮助不大,所以不看了。

逆向工程:使用工具mybatisPlus,快速生成Controller、Service、ServiceImpl、Mapper。

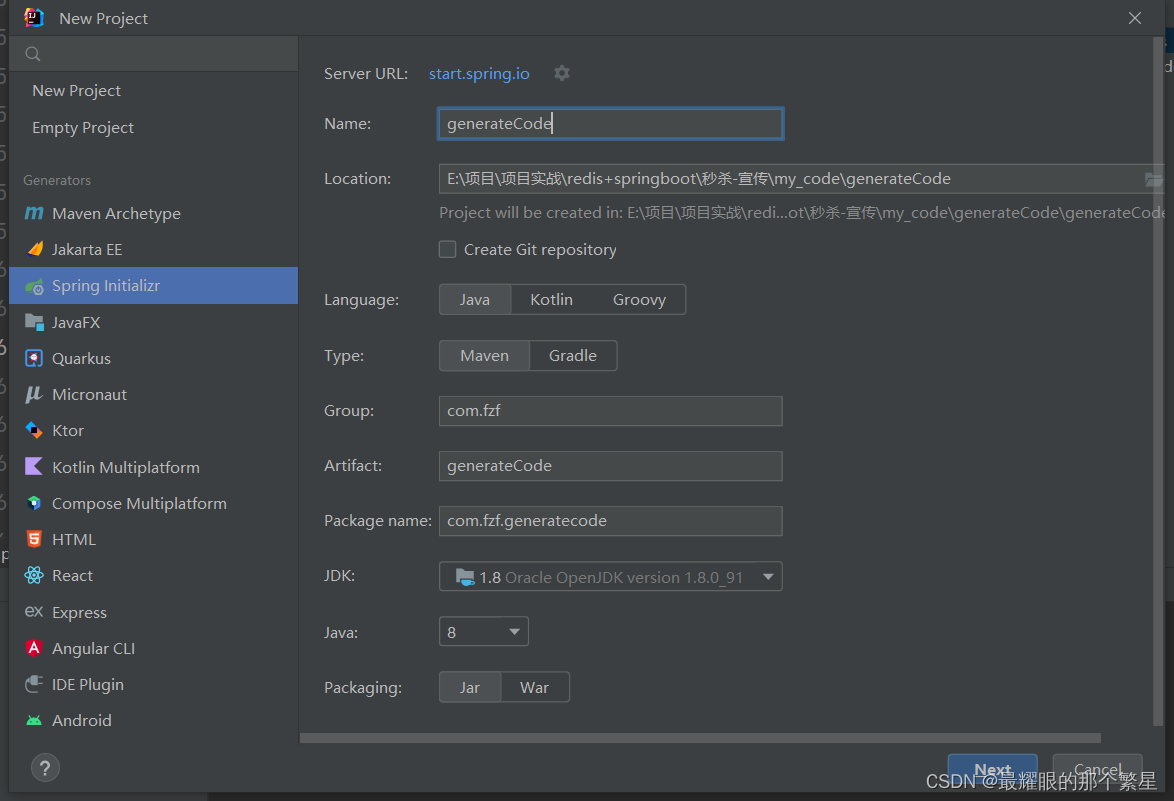

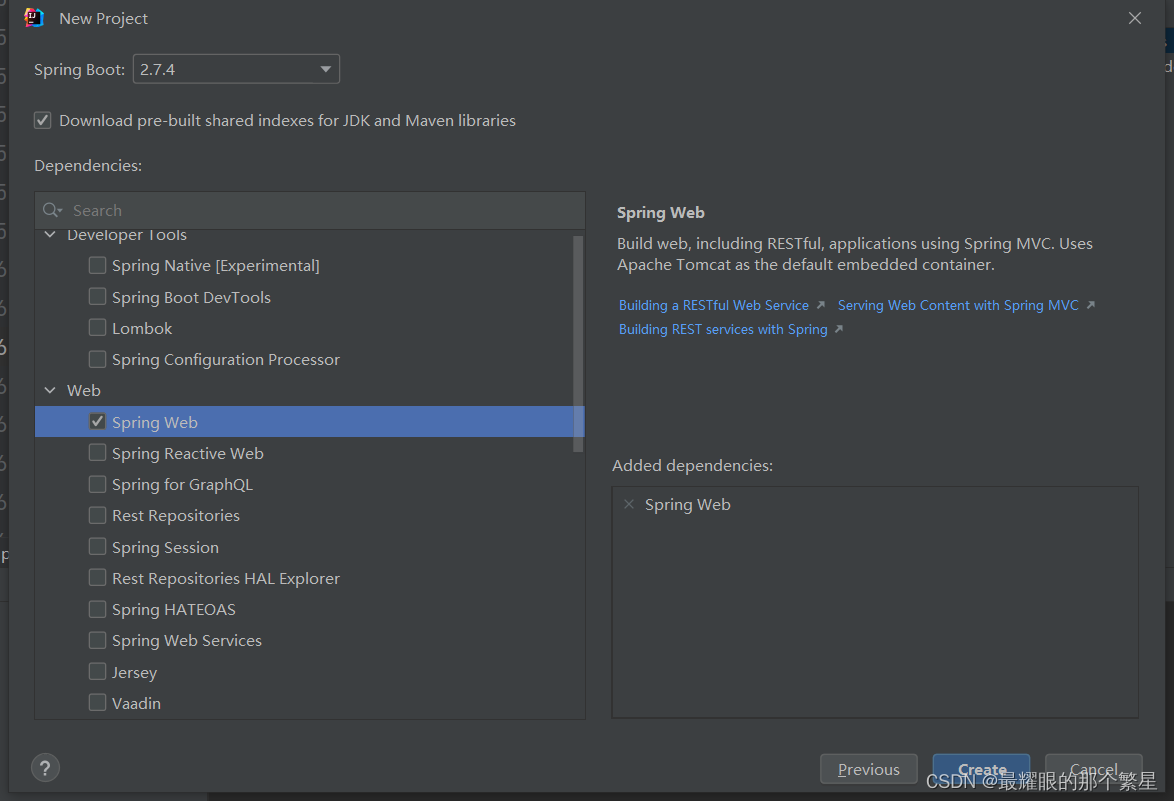

创建工程流程:

工程结构:

package com.fzf.generatecode;

import com.baomidou.mybatisplus.core.exceptions.MybatisPlusException;

import com.baomidou.mybatisplus.core.toolkit.StringPool;

import com.baomidou.mybatisplus.core.toolkit.StringUtils;

import com.baomidou.mybatisplus.generator.AutoGenerator;

import com.baomidou.mybatisplus.generator.InjectionConfig;

import com.baomidou.mybatisplus.generator.config.*;

import com.baomidou.mybatisplus.generator.config.po.TableInfo;

import com.baomidou.mybatisplus.generator.config.rules.DateType;

import com.baomidou.mybatisplus.generator.config.rules.NamingStrategy;

import com.baomidou.mybatisplus.generator.engine.FreemarkerTemplateEngine;

import java.util.*;

/**

* @Author 繁星

* @Date 2022/10/17 15:34

* @Function

*/

// 演示例子,执行 main 方法控制台输入模块表名回车自动生成对应项目目录中

public class CodeGenerator {

/**

* <p>

* 读取控制台内容

* </p>

*/

public static String scanner(String tip) {

Scanner scanner = new Scanner(System.in);

StringBuilder help = new StringBuilder();

help.append("请输入" + tip + ":");

System.out.println(help.toString());

if (scanner.hasNext()) {

String ipt = scanner.next();

if (StringUtils.isNotBlank(ipt)) {

return ipt;

}

}

throw new MybatisPlusException("请输入正确的" + tip + "!");

}

public static void main(String[] args) {

// 代码生成器

AutoGenerator mpg = new AutoGenerator();

// 全局配置

GlobalConfig gc = new GlobalConfig();

String projectPath = System.getProperty("user.dir");

gc.setOutputDir(projectPath + "/src/main/java");

//作者

gc.setAuthor("fzf");

//打开输出目录

gc.setOpen(false);

//xml开启BaseResultMap

gc.setBaseResultMap(true);

//xml开启BaseColumnList

gc.setBaseColumnList(true);

//日期格式,采用Date

gc.setDateType(DateType.ONLY_DATE);

// gc.setSwagger2(true); 实体属性 Swagger2 注解

mpg.setGlobalConfig(gc);

// 数据源配置

DataSourceConfig dsc = new DataSourceConfig();

dsc.setUrl("jdbc:mysql://localhost:3306/seckill?useUnicode=true&characterEncoding=utf8&serverTimezone=Asia/Shanghai");

// dsc.setSchemaName("public");

dsc.setDriverName("com.mysql.cj.jdbc.Driver");

dsc.setUsername("root");

dsc.setPassword("root");

mpg.setDataSource(dsc);

// 包配置

PackageConfig pc = new PackageConfig();

pc.setParent("com.fzf.seckill")

.setEntity("pojo")

.setMapper("mapper")

.setService("service")

.setServiceImpl("service.impl")

.setController("controller");

mpg.setPackageInfo(pc);

// 自定义配置

InjectionConfig cfg = new InjectionConfig() {

@Override

public void initMap() {

// to do nothing

Map<String, Object> map = new HashMap<>();

map.put("date1", "1.0.0");

this.setMap(map);

}

};

// 如果模板引擎是 freemarker

String templatePath = "/templates/mapper.xml.ftl";

// 如果模板引擎是 velocity

// String templatePath = "/templates/mapper.xml.vm";

// 自定义输出配置

List<FileOutConfig> focList = new ArrayList<>();

// 自定义配置会被优先输出

focList.add(new FileOutConfig(templatePath) {

@Override

public String outputFile(TableInfo tableInfo) {

// 自定义输出文件名 , 如果你 Entity 设置了前后缀、此处注意 xml 的名称会跟着发生变化!!

return projectPath + "/src/main/resources/mapper/" + tableInfo.getEntityName() + "Mapper"

+ StringPool.DOT_XML;

}

});

/*

cfg.setFileCreate(new IFileCreate() {

@Override

public boolean isCreate(ConfigBuilder, FileType fileType, String filePath) {

// 判断自定义文件夹是否需要创建

checkDir("调用默认方法创建的目录,自定义目录用");

if (fileType == FileType.MAPPER) {

// 已经生成 mapper 文件判断存在,不想重新生成返回 false

return !new File(filePath).exists();

}

// 允许生成模板文件

return true;

}

});

*/

cfg.setFileOutConfigList(focList);

mpg.setCfg(cfg);

// 配置模板

TemplateConfig templateConfig = new TemplateConfig();

// 配置自定义输出模板

//指定自定义模板路径,注意不要带上.ftl/.vm, 会根据使用的模板引擎自动识别

// templateConfig.setEntity("templates/entity2.java");

// templateConfig.setService();

// templateConfig.setController();

templateConfig.setEntity("templates/entity2.java")

.setMapper("templates/mapper2.java")

.setService("templates/service2.java")

.setServiceImpl("templates/serviceImpl2.java")

.setController("templates/controller2.java");

templateConfig.setXml(null);

mpg.setTemplate(templateConfig);

// 策略配置

StrategyConfig strategy = new StrategyConfig();

//数据库表映射到实体的命名策略

strategy.setNaming(NamingStrategy.underline_to_camel);

//数据库表字段映射到实体的命名策略

strategy.setColumnNaming(NamingStrategy.underline_to_camel);

//lombok模型

strategy.setEntityLombokModel(true);

//生成@RestController控制器

strategy.setRestControllerStyle(true);

strategy.setInclude(scanner("表名,多个英文逗号分割").split(","));

strategy.setControllerMappingHyphenStyle(true);

//表前缀

strategy.setTablePrefix("t_");

mpg.setStrategy(strategy);

mpg.setTemplateEngine(new FreemarkerTemplateEngine());

mpg.execute();

}

}

templates获取:把名字后面加个2就行

下一篇:

1507

1507

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?