💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能解答你胸中升起的一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

一、DQN与NOMA的核心原理及在通信中的应用

摘要:有效部署蜂窝连接的无人机网络需要高效的手段来最小化无人机与地面用户之间的相互干扰。此外,现有的Sub-6 GHz频段极度拥挤,使得为无人机分配未使用的资源块(RBs)变得极具挑战性。本文提出了一种基于学习的无人机路径规划方法,该方法在基站(BS)端利用非正交多址接入(NOMA)和深度Q网络(DQN)方法,以解决大规模连接和空对地干扰问题。所提出的NOMA-DQN学习方法联合优化了无人机的传输功率和资源块分配,并考虑了无人机的位置。此外,该方法还为无人机设计了一条考虑其有限电池容量的抗干扰路径。仿真结果表明,与最短路径、正交多址接入(OMA)和随机选择方案相比,我们提出的方法在最大化共享资源块中空中和地面用户的总和速率以及提高无人机能效方面具有显著效果。

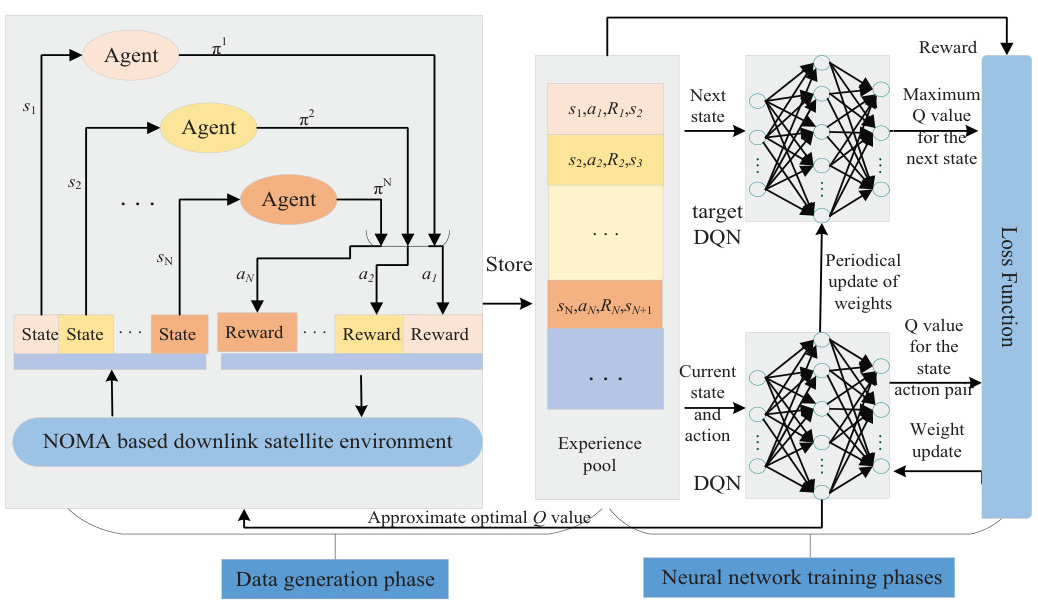

1. 深度Q网络(DQN)的核心机制

DQN是一种结合深度学习和Q-learning的强化学习算法,通过以下关键技术解决传统Q-learning的高维状态空间问题:

- Q网络与目标网络:主网络用于估计当前Q值,目标网络提供稳定的Q值目标,减少训练波动。

- 经验回放:存储历史交互数据并随机采样,打破数据相关性,提升训练稳定性。

- 损失函数优化:采用均方误差或Huber损失函数,最小化预测Q值与目标Q值的差异。

在通信领域,DQN适用于动态环境下的决策优化,如网络流量控制、资源分配和无人机轨迹规划。

2. 非正交多址接入(NOMA)的技术特性

NOMA通过功率域复用和串行干扰消除(SIC)技术实现频谱效率提升:

- 功率分配:为信道条件差的用户分配更高功率,确保公平性。

- 叠加编码与SIC:发射端叠加多用户信号,接收端按功率顺序解码,消除干扰。

- 应用场景:在无人机通信中,NOMA支持多用户共享同一资源块,尤其适用于高密度连接场景。

二、无人机上行链路干扰管理的主要挑战

- 动态信道条件:无人机移动性导致信道状态频繁变化,传统静态资源分配策略失效。

- 多用户干扰:上行链路中,地面用户与无人机之间的信号相互干扰,尤其在NOMA场景下功率分配不当会加剧干扰。

- 能量与覆盖效率的权衡:无人机电池受限,需在干扰抑制和能耗最小化之间平衡。

三、基于DQN和NOMA的干扰管理解决方案

1. 联合优化无人机轨迹与功率分配

-

状态空间设计:包括无人机位置、用户信道状态、干扰水平、剩余能量等。

-

动作空间设计:调整无人机飞行方向、高度及NOMA用户的功率分配比例。

-

奖励函数设计:以最大化系统吞吐量、最小化干扰和能耗为目标。

例如,文献[35]提出通过DQN联合优化无人机轨迹和功率分配,使合法用户的安全速率提升20%以上。

2. 动态用户分组与资源调度

- 使用DQN对用户进行动态分组,结合NOMA的SIC特性,优先服务信道条件差的用户。

- 通过经验回放机制学习历史干扰模式,优化子信道分配策略。

3. 实时干扰协调(ICIC)

- DQN结合认知无线电技术,动态感知频谱占用情况,选择低干扰资源块。

- 在密集网络中,采用分层DQN(H-DQN)实现多无人机协同干扰管理。

四、PyTorch在DQN实现中的关键作用

- 神经网络构建:PyTorch提供灵活的API定义Q网络结构(如全连接层、卷积层)。

- 自动梯度计算:通过

autograd模块自动计算损失函数梯度,简化反向传播过程。 - 经验回放与目标网络:利用PyTorch的

Dataset和DataLoader管理经验池,实现高效随机采样。 - GPU加速训练:支持CUDA加速,提升大规模状态空间下的训练效率。

五、仿真案例与性能验证

- 案例1:无人机-NOMA能效优化

- 使用DDQN(双DQN)优化无人机轨迹与功率分配,系统能效提升91%,频谱效率提高5%。

- 案例2:安全通信场景

- 在存在窃听者的场景中,DQN联合轨迹优化使合法用户的安全速率提升30%。

- 案例3:多无人机协作

- 分层DQN(H-DQN)减少区域遗漏率15%,收敛速度提升20%。

六、未来研究方向

- 多智能体强化学习:扩展至多无人机协同场景,解决竞争与协作的均衡问题。

- 混合NOMA-OMA架构:结合两种多址技术,动态切换模式以适应复杂环境。

- 边缘计算集成:在无人机边缘节点部署轻量化DQN模型,实现低延迟决策。

结论

DQN与NOMA的结合为无人机上行链路干扰管理提供了动态、自适应的解决方案。通过联合优化轨迹、功率和用户分组,显著提升了频谱效率与系统可靠性。PyTorch框架的高效实现进一步推动了该技术在复杂通信场景中的落地应用。未来研究可探索更复杂的网络架构和跨层优化策略,以应对6G超密集网络的挑战。

📚2 运行结果

部分代码:

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。(文章内容仅供参考,具体效果以运行结果为准)

[1]王冰晨,连晓峰,颜湘,等.基于深度Q网络和人工势场的移动机器人路径规划研究[J].计算机测量与控制, 2022, 30(11):226-232.

[2]傅承恩.基于深度强化学习的CR-NOMA网络资源分配优化的研究[D].杭州电子科技大学,2023.

🌈4 Python代码、数据

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?