1. 状态价值函数

V(s),表示在特定状态下,智能体可以获得的长期累积奖励的期望值。它衡量了从当前状态出发,智能体能够获得多大的回报。

根据定义,其公式就是【状态价值函数=回报G的期望】,即:

2. 动作价值函数

Q(s,a),表示在特定状态下,采取特定动作后,智能体可以获得的长期累积奖励的期望值。它衡量了在给定状态下,采取特定动作所能达到的价值。

根据定义,其公式就是【动作价值函数=特定动作产生的奖励R+下一状态的回报G的期望】,由上文我们知道【状态价值函数=回报G的期望】,因此下一状态的汇报G的期望就可以用V(s')表示,s'为s的下一个状态。所以,动作价值函数的公司为【动作价值函数=特定动作产生的奖励R+下一状态的状态价值函数】,即:

3. 两者的关系

状态价值函数 = 动作1的概率 * 动作1的动作价值函数 + 动作2的概率 * 动作2的动作价值函数 + ...... + 动作t的概率 * 动作t的动作价值函数

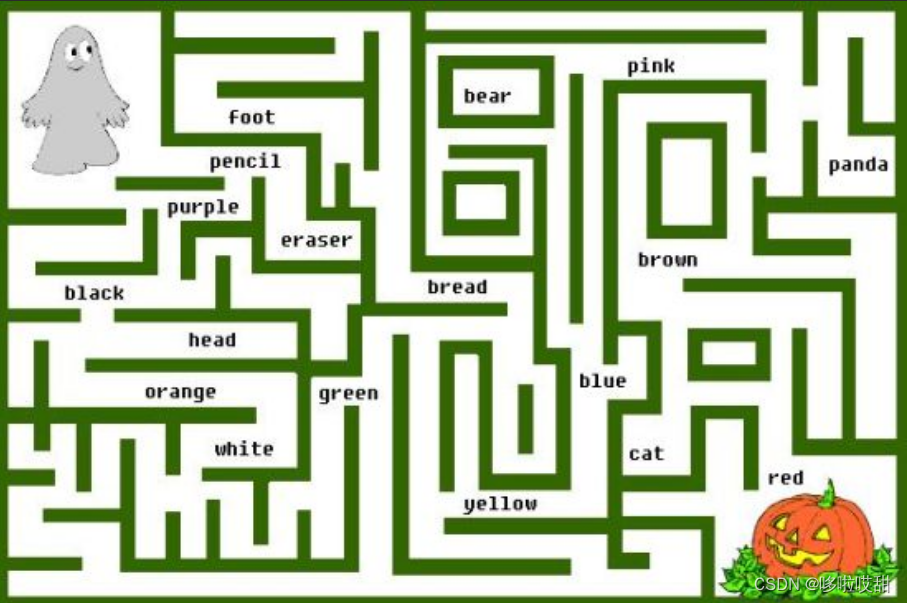

假设在一个迷宫中,智能体需要从起点到达终点,每个格子都有一个即时奖励。智能体可以采取上下左右四个动作中的任意一个,但有些动作可能会导致智能体撞到墙上而无法移动。

在这种情况下,状态价值函数V(s)表示在特定位置(状态)下,智能体可以获得的长期累积奖励的期望值。如果智能体已经走到了一个位置,它可以通过观察周围的格子来预测它将来能够获得的奖励,并据此做出决策。例如,如果智能体在某个位置发现它周围的所有格子都是负奖励,那么它可能会选择朝着终点方向走,因为那个方向上可能会有更高的奖励。

动作价值函数Q(s,a)表示在特定位置(状态)下,采取特定动作后,智能体可以获得的长期累积奖励的期望值。例如,在某个位置上,智能体可以选择采取上下左右四个动作中的任意一个,它可以通过动作价值函数来评估每个动作的价值,从而选择最优的动作。如果采取某个动作后预期能够获得更高的奖励,那么智能体就会选择这个动作。

在这个例子中,状态价值函数和动作价值函数都是用来评估智能体行为的价值。状态价值函数衡量的是每个位置的价值,而动作价值函数则衡量的是每个位置上采取不同动作的价值。通过使用这两个函数,智能体可以确定最优策略,并成功地到达终点。

本文介绍了状态价值函数V(s)和动作价值函数Q(s,a),它们衡量了在给定状态下长期累积奖励的期望。状态价值函数关注位置的整体价值,动作价值函数侧重于特定动作带来的收益。通过这两个函数,智能体能在迷宫环境中制定最优策略以达到目标。

本文介绍了状态价值函数V(s)和动作价值函数Q(s,a),它们衡量了在给定状态下长期累积奖励的期望。状态价值函数关注位置的整体价值,动作价值函数侧重于特定动作带来的收益。通过这两个函数,智能体能在迷宫环境中制定最优策略以达到目标。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?