目录

论文阅读与视频学习

MobileNet V1&V2

传统卷积神经网络:内存需求大、运算量大导致无法在移动设备以及嵌入式设备上运行。

MobileNet网络是google团队在2017年提出的,专注于移动端或者嵌入式设备中的轻量级CNN网络。相比于传统的卷积神经网络,在准确率小幅降低的前提下大大减少了模型参数与运算量。

网络中的亮点:

- Depthwise Convolution(大大减少运算量和参数数量)。

- 增加超参数:控制卷积核卷积个数的超参数α和控制输入图像大小的超参数β,这两个超参数是我们人为自己设定的,并非学习到的。

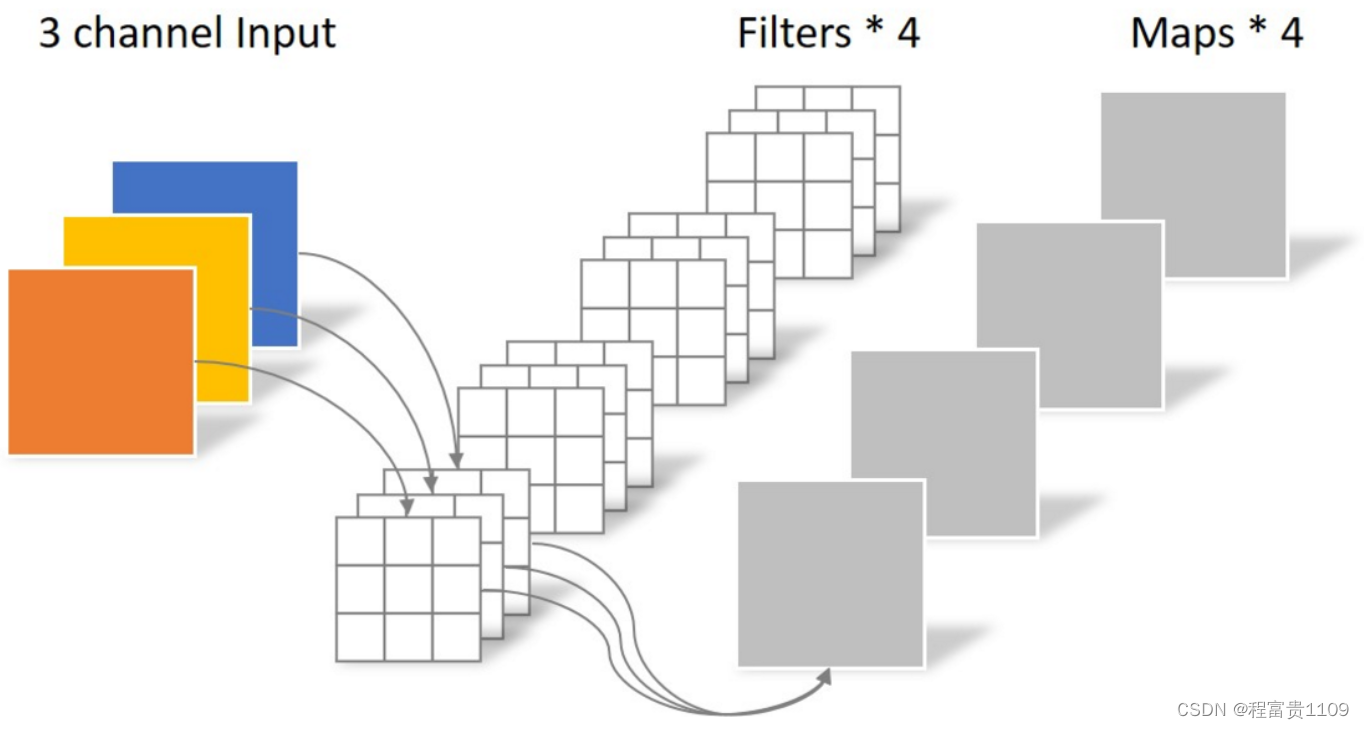

传统卷积:

卷积核channel=输入特征矩阵channel

输出特征矩阵channel=卷积核个数

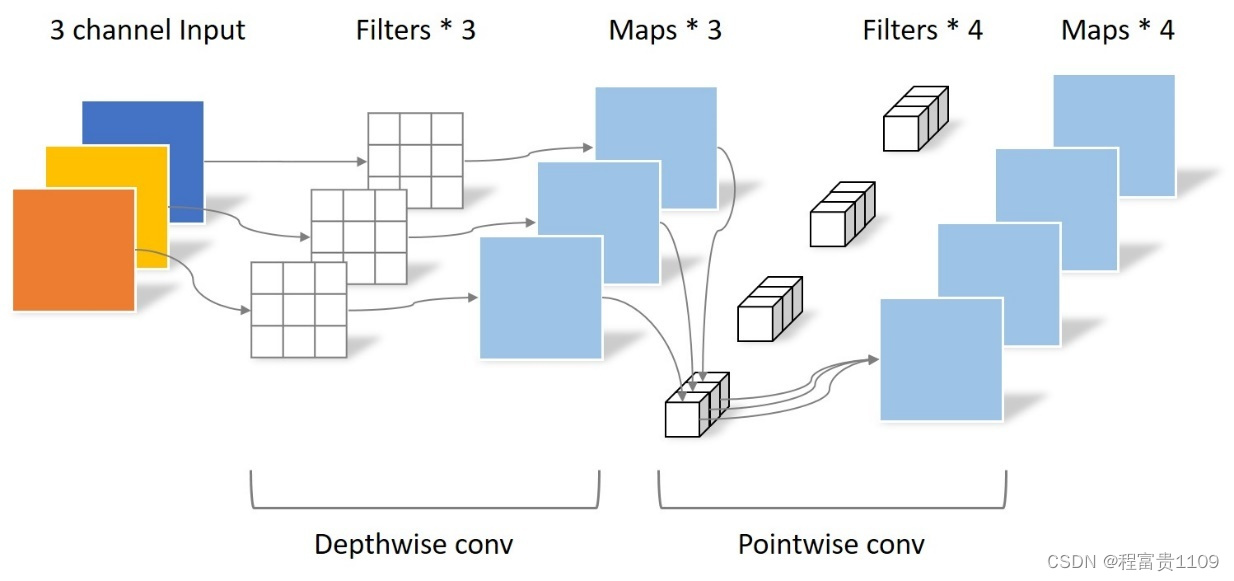

DW卷积:

卷积核channel=1

输入特征矩阵channel=卷积核个数=输出特征矩阵channel

PW卷积:

卷积核大小为1×1

卷积核channel=输入特征矩阵channel

输出特征矩阵channel=卷积核个数

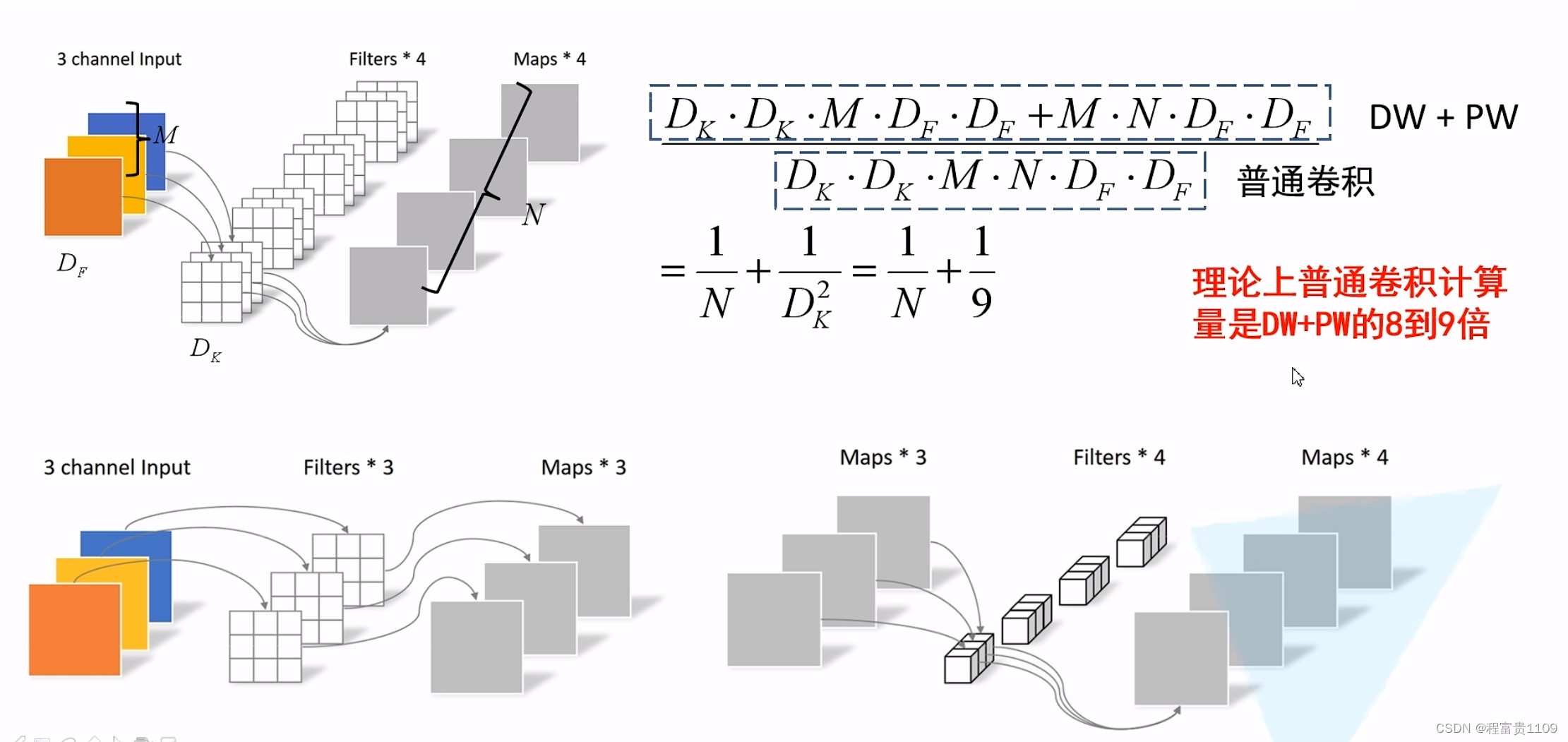

与普通卷积参数量对比:

Depthwise部分的卷积核容易废掉,即卷积核参数大部分为0。

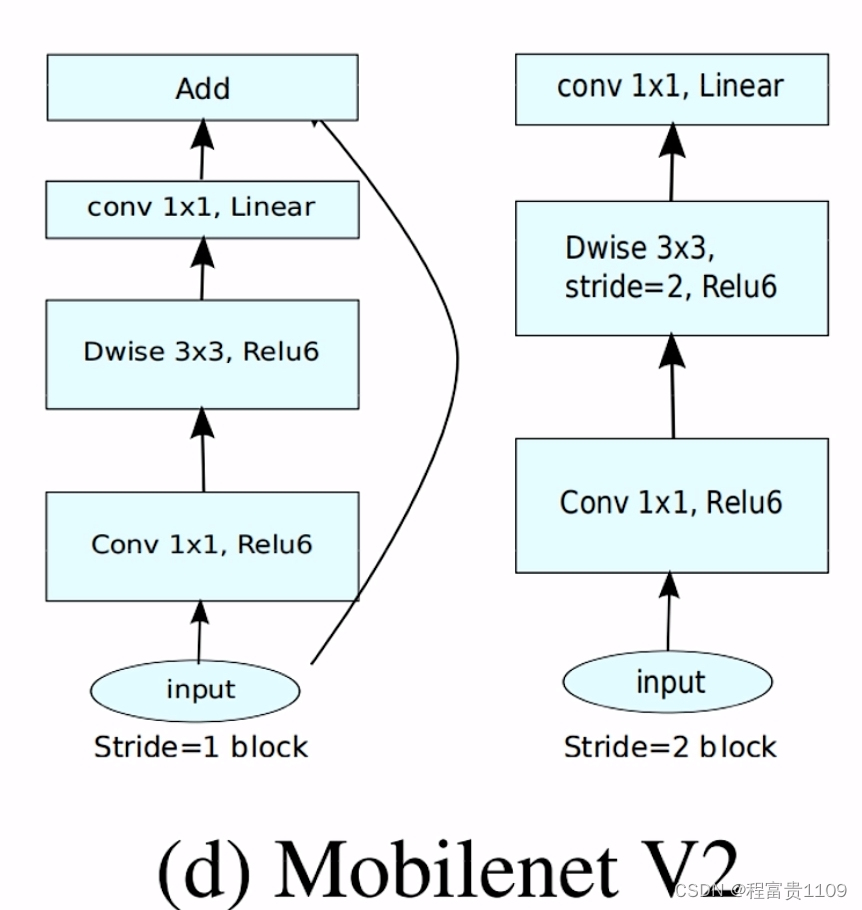

MobileNetV2网络是由google团队在2018年提出的,相比MobileNetV1网络,准确率更高,模型更小。

网络中的亮点:

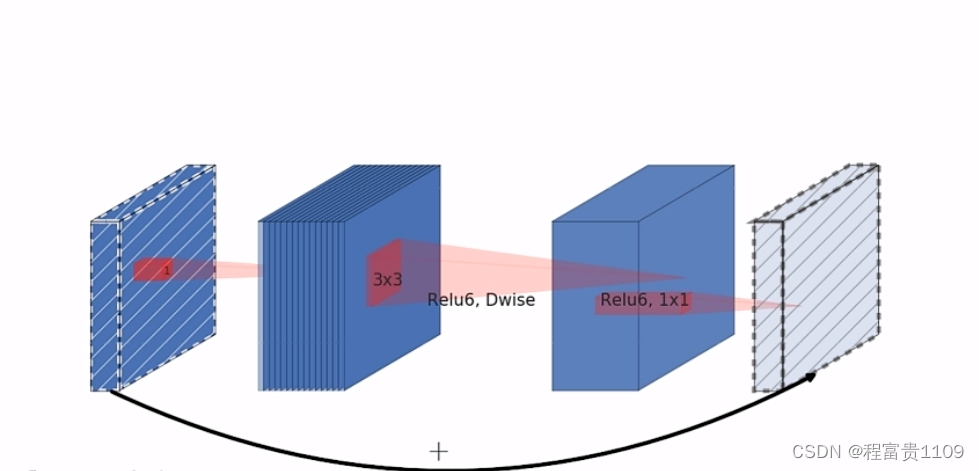

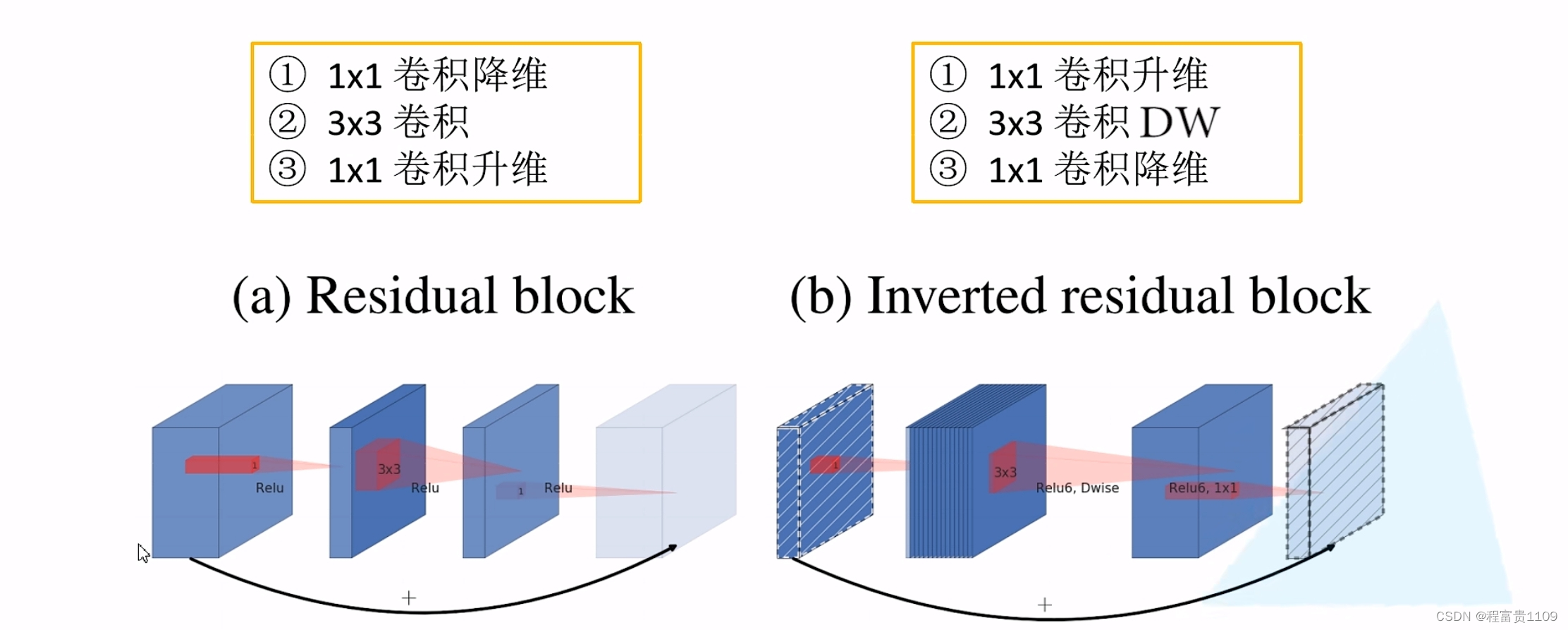

- Inverted Residuals(倒残差结构)

- Linear Bottlenecks

Residual block使用ReLu激活函数,Inverted Residuals block使用ReLu6激活函数。

y=ReLu6(x)=min(max(x,0),6)

Linear Bottlenecks:在倒残差结构最后一个1×1的卷积层,使用了线性的激活函数,因为ReLu激活函数对于低维特征信息造成大量损失,而对高维特征信息损失很小。

当stride=1且输入特征矩阵与输出特征矩阵shape相同时才有shortcut连接。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1057

1057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?