前言

HDFS作为Hadoop的核心组件,其搭建是Hadoop集群能够成功运行的基础,本文就描述了我在搭建HDFS集群时的流程与遇到的问题。

一、HDFS是什么?

HDFS是一个完全分布式文件系统:引入存放文件元数据信息的服务器Namenode和实际存放数据的服务器Datanode,对数据进行分布式储存和读取。

二、搭建流程

1.检查系统

首先我们应该有一个做好免密登录且互相连接的虚拟机流程详见

链接: https://blog.csdn.net/qq_53879605/article/details/126883887?spm=1001.2014.3001.5501

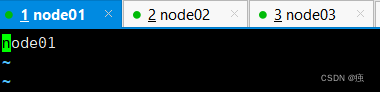

1.1 检查各主机名

vi /etc/hostname

node01的主机名 (node02,node03同样要检查,为简便后文以01,02,03称呼)

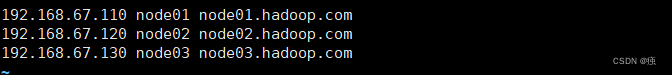

1.2 检查hosts文件

vi /etc /hosts

01,02,03host文件相同

1.3 检查免密登录

ssh node02

用01登录02,03若成功则无误,若不能登录

见链接: https://blog.csdn.net/qq_53879605/article/details/126883887?spm=1001.2014.3001.5501

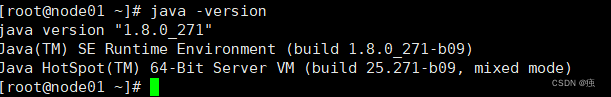

1.4 检查JDK

java -version

02,03都应检查

2. 配置过程

2.1 创建安装目录

cd /opt

mkdir software

cd software/

mkdir hadoop

cd hadoop/

mkdir hdfs

cd hdfs/

mkdir data

mkdir name

mkdir tmp

2.2 上传并解压文件

cd /opt/software/hadoop

yum-y install lrzsz

rz # 上传hadoop-2.9.2.tar.gz

tar -xvzf hadoop-2.9.2.tar.gz

上传Hadoop时只需将hadoop-2.9.2.tar.gz 拖到xshell下即可

文件下载链接: https://pan.baidu.com/s/1kcu2FvwjKTijW-lMd4h6VQ?pwd=yre0

提取码yre0

2.3 配置HADOOP_HOME环境变量

vi /etc/profile

#修改的语句为

export HADOOP_HOME=/opt/software/hadoop/hadoop-2.9.2

export PATH=${

PATH}:${

HADOOP_HOME}/bin:${

HADOOP_HOME}/sbin

刷新环境变量

source /etc/profile

测试Hadoop是否安装

hadoop version

2.4 配置hadoop-env.sh

无需修改配置 只是修改JAVAHOME和HADOOPCONF_DIR的值

cd /opt/software/hadoop/hadoop-2.9.2/etc

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2783

2783

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?