第一章课程大纲:

(本笔记大部分内容来自DataWhale的六月llm打卡课程,并融入了一些个人的理解以及思考)

-

大型语言模型 LLM 理论简介

-

LLM的定义和概念

-

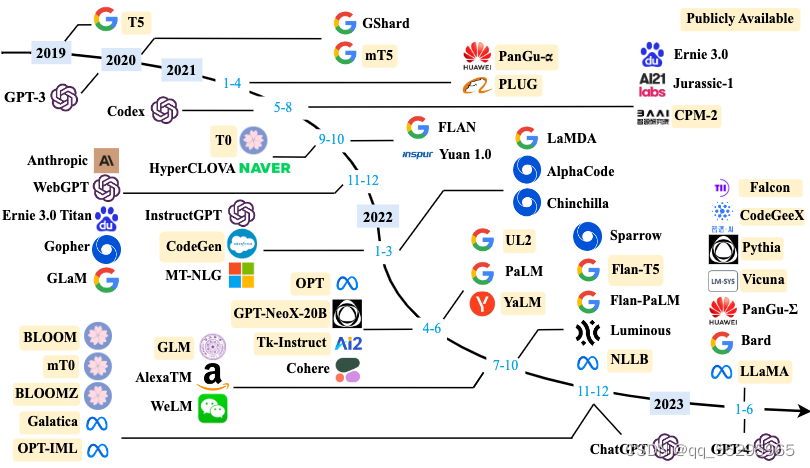

发展历程

-

主要模型(如GPT-3、GPT-4、PaLM等)

-

典型应用场景

-

LLM的能力和特点

-

-

检索增强生成 RAG 简介

-

RAG的概念

-

工作流程

-

优势和应用

-

与微调(Finetune)的比较

-

-

环境配置

-

Python环境安装

-

依赖库安装

-

虚拟环境管理

-

Jupyter Notebook配置

-

常见问题解决

-

1. 大型语言模型 LLM 理论简介

1.1 LLM的定义和概念

大型语言模型(LLM)是人工智能模型,旨在理解和生成人类语言。LLM通常包含数百亿参数,通过在海量文本数据上训练,获取对语言的深层次理解。常见LLM有GPT-3.5、GPT-4、PaLM、Claude、LLaMA、文心一言、讯飞星火、通义千问和ChatGLM等。LLM展现出"涌现能力",即随着模型规模的扩大,处理复杂任务的能力显著提升。

1.2 发展历程

- 20世纪90年代:研究集中在统计学习方法预测词汇。

- 2003年:Bengio首次将深度学习应用于语言模型,提升了模型性能。

- 2018年:Transformer架构崭露头角,通过大量文本数据训练,极大提升了模型在自然语言处理任务上的表现。

- 现今:随着模型规模的扩大,LLM展现出强大的能力,标志着LLM时代的到来。

1.3 主要模型

- GPT系列:包括ChatGPT和GPT-4。ChatGPT因其出色的对话能力受到广泛关注,而GPT-4在处理复杂任务方面表现更强。

- Claude系列:由Anthropic公司开发,最新版本Claude-3性能卓越。

- PaLM/Gemini系列:Google开发的模型,最新版本Gemini增强了多模态支持能力。

- 文心一言:百度开发的中文能力较强的闭源模型。

- 星火大模型:科大讯飞发布,支持多种自然语言处理任务。

- LLaMA系列:Meta开源的基础语言模型,具有高效的数据并行和流水线并行技术。

- 通义千问:阿里巴巴开发的开源模型,适用于多种应用场景。

- GLM系列:清华大学和智谱AI合作研发,展现了强大的多模态处理能力。

- Baichuan系列:百川智能开发的开源模型,具有较强的实用性和商用价值。

该图来源于A Survey of Large Language Models[1]

该图来源于A Survey of Large Language Models[1]

1.4 典型应用场景

LLM在多个领域产生了深远影响:

- 自然语言处理:帮助计算机更好地理解和生成文本,包括写作、问答、翻译等。

- 信息检索:改进搜索引擎,提高信息获取效率。

- 计算机视觉:结合图像和文字,改善多媒体交互。

- 通用人工智能(AGI):作为AGI的早期形式,LLM引发了对未来人工智能发展的思考和探索。

1.5 LLM 的能力

1.5.1涌现能力(emergent abilities)

区分大语言模型(LLM)与以前的预训练语言模型(PLM)最显著的特征之一是它们的 涌现能力 。涌现能力是一种令人惊讶的能力,它在小型模型中不明显,但在大型模型中特别突出。类似物理学中的相变现象,涌现能力就像是模型性能随着规模增大而迅速提升,超过了随机水平,也就是我们常说的量变引起质变。

涌现能力可以与某些复杂任务有关,但我们更关注的是其通用能力。接下来,我们简要介绍三个 LLM 典型的涌现能力:

-

上下文学习:上下文学习能力是由 GPT-3 首次引入的。这种能力允许语言模型在提供自然语言指令或多个任务示例的情况下,通过理解上下文并生成相应输出的方式来执行任务,而无需额外的训练或参数更新。此外,充分训练和算力充足的LLM能够理解语言的深层含义,包括隐喻、讽刺、双关语等,这些通常需要对上下文和文化背景有深入的理解。

-

指令遵循:通过使用自然语言描述的多任务数据进行微调,也就是所谓的

指令微调。LLM 被证明在使用指令形式化描述的未见过的任务上表现良好。这意味着 LLM 能够根据任务指令执行任务,而无需事先见过具体示例,展示了其强大的泛化能力。 -

逐步推理:小型语言模型通常难以解决涉及多个推理步骤的复杂任务,例如数学问题。然而,LLM 通过采用

思维链(CoT, Chain of Thought)推理策略,利用包含中间推理步骤的提示机制来解决这些任务,从而得出最终答案。据推测,这种能力可能是通过对代码的训练获得的。 -

知识整合:LLM能够整合来自不同领域和主题的知识,生成跨学科的见解或解决方案。

-

适应性:LLM能够适应不同的语言风格和用户需求,生成符合特定语境的文本。

-

错误纠正和自我修正:在生成文本的过程中,LLM能够识别并纠正自身的错误,提高输出的准确性。

-

交互式学习能力:通过与用户的交互,LLM可以学习用户的偏好和需求,从而提供更加个性化的服务。

这些涌现能力让 LLM 在处理各种任务时表现出色,使它们成为了解决复杂问题和应用于多领域的强大工具。涌现能力使得LLM在语言处理方面表现出类似人类的能力,但同时也带来了一些挑战,如确保生成内容的准确性、避免偏见和不当内容的产生等。研究者们正在不断探索如何更好地理解和控制这些涌现能力,以提高LLM的性能和应用价值。

1.5.2 作为基座模型支持多元应用的能力

在 2021 年,斯坦福大学等多所高校的研究人员提出了基座模型(foundation model)的概念,清晰了预训练模型的作用。这是一种全新的 AI 技术范式,借助于海量无标注数据的训练,获得可以适用于大量下游任务的大模型(单模态或者多模态)。这样,多个应用可以只依赖于一个或少数几个大模型进行统一建设。目前比较知名的有OpenAI的基于GPT-4和GPT-4o的GPTs商店,和对标OpenAI的基于智谱清言的GLM-4开发的智能体,可以让用户通过预设词和上传文档、调用api等形式,完成一些用户指定的任务。此外,还有通过comfyUI进行ai绘画的工作流等利用绘画模型来进行创作的案例,在此处不做多余赘述。

此外,在中国的LLM土壤里,研发倾向更倾向于LLM在工业、医疗、教育中的落地,例如华为的盘古大模型,上海人工智能实验室的OpenMEDLab浦医、在2024年5月初,教育部公布了一批首批18个“人工智能+教育”应用场景典型案例,其中包括清华大学、北京大学等一系列高校和实验室合作开发的高等教育落地场景。

1.5.3 支持对话作为统一入口的能力

让大语言模型真正火爆的契机,是基于对话聊天的 ChatGPT。业界很早就发现了用户对于对话交互的特殊偏好,陆奇在微软期间,就于 2016 年推进过“对话即平台(conversation as a platform)” 的战略。此外,苹果 Siri 、亚马逊 Echo 等基于语音对话的产品也非常受欢迎,反映出互联网用户对于聊天和对话这种交互模式的偏好。虽然之前的聊天机器人存在各种问题,但大型语言模型的出现再次让聊天机器人这种交互模式可以重新涌现。用户愈发期待像钢铁侠中“贾维斯”一样的人工智能,无所不能、无所不知。这引发我们对于智能体(Agent)类型应用前景的思考,Auto-GPT、微软 Jarvis 等项目已经出现并受到关注,相信未来会涌现出很多类似的以对话形态让助手完成各种具体工作的项目。个人认为LLM+Agent+RPA的应用会有很光明的前景。

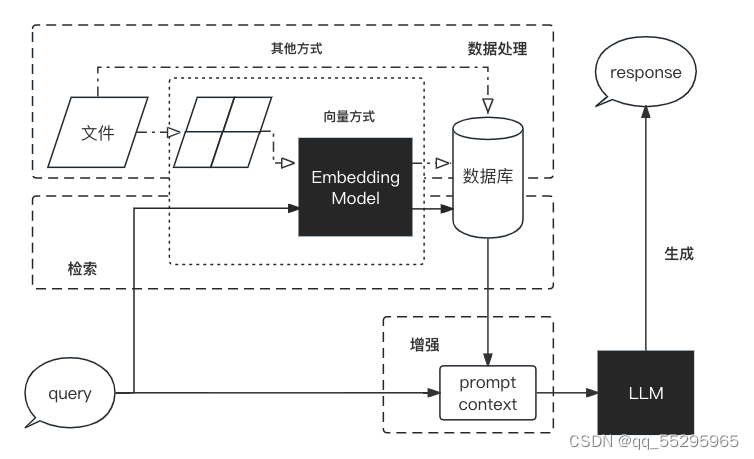

2.检索增强生成 RAG 简介

检索增强生成(RAG, Retrieval-Augmented Generation)。该架构巧妙地整合了从庞大知识库中检索到的相关信息,并以此为基础,指导大型语言模型生成更为精准的答案,从而显著提升了回答的准确性与深度。主要解决了目前大模型存在的①信息偏差、幻觉;②知识滞后性、不专业性,真实性难以确认③应用场景受限④propmt工程不能解决的问题,例如专业应用场景以及高并发场景或防止大模型逆向propmt工程。

2.1 RAG 的工作流程

RAG 是一个完整的系统,其工作流程可以简单地分为数据处理、检索、增强和生成四个阶段:

1.数据处理阶段

i.对原始数据进行清洗和处理。

ii.将处理后的数据转化为检索模型可以使用的格式。

iii.将处理后的数据存储在对应的数据库中。

2.检索阶段

i.将用户的问题输入到检索系统中,从数据库中检索相关信息。

3.增强阶段

i.对检索到的信息进行处理和增强,以便生成模型可以更好地理解和使用。

4.生成阶段

i.将增强后的信息输入到生成模型中,生成模型根据这些信息生成答案。

2.2 RAG VS Finetune

| 特征比较 | RAG | 微调 |

|---|---|---|

| 知识更新 | 直接更新检索知识库,无需重新训练。信息更新成本低,适合动态变化的数据。 | 通常需要重新训练来保持知识和数据的更新。更新成本高,适合静态数据。 |

| 外部知识 | 擅长利用外部资源,特别适合处理文档或其他结构化/非结构化数据库。 | 将外部知识学习到 LLM 内部。 |

| 数据处理 | 对数据的处理和操作要求极低。 | 依赖于构建高质量的数据集,有限的数据集可能无法显著提高性能。 |

| 模型定制 | 侧重于信息检索和融合外部知识,但可能无法充分定制模型行为或写作风格。 | 可以根据特定风格或术语调整 LLM 行为、写作风格或特定领域知识。 |

| 可解释性 | 可以追溯到具体的数据来源,有较好的可解释性和可追踪性。 | 黑盒子,可解释性相对较低。 |

| 计算资源 | 需要额外的资源来支持检索机制和数据库的维护。 | 依赖高质量的训练数据集和微调目标,对计算资源的要求较高。 |

| 推理延迟 | 增加了检索步骤的耗时 | 单纯 LLM 生成的耗时 |

| 降低幻觉 | 通过检索到的真实信息生成回答,降低了产生幻觉的概率。 | 模型学习特定领域的数据有助于减少幻觉,但面对未见过的输入时仍可能出现幻觉。 |

| 伦理隐私 | 检索和使用外部数据可能引发伦理和隐私方面的问题。 | 训练数据中的敏感信息需要妥善处理,以防泄露。 |

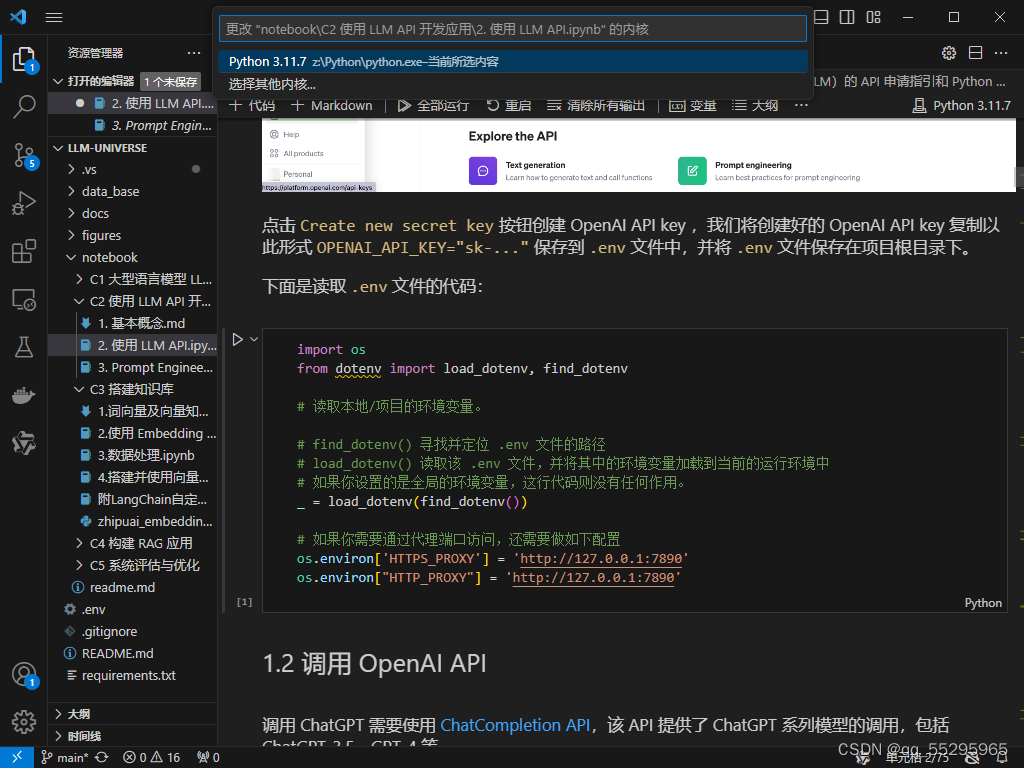

3.环境配置

由于本人之前白嫖过阿里云的服务器,并且在服务器上直接开发,这次采用本地+服务器的形式开发(手动狗头)

这里已经配置好了本地的vscode环境,准备进行下一个course的学习。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?