搭建环境:

centos6.5

vm16

jdk1.8

hadoop 2.6.5

1.先设置静态ip

vi /etc/sysconfig/network-scripts/ifcfg-eth0

DEVICE=eth0

#HWADDR=00:0C:29:42:15:C2

TYPE=Ethernet

ONBOOT=yes

NM_CONTROLLED=yes

BOOTPROTO=static

IPADDR=192.168.90.11

NETMASK=255.255.255.0

GATEWAY=192.168.90.2

DNS1=223.5.5.5

DNS2=114.114.114.114重启服务:service network restart

关闭防火墙:service iptables stop

开机自动关闭防火墙:chkconfig iptables off

为了方便操作,使用xshell连接centos,因为centos里面直接就给我们安装了ssh,所以我们便不需要安装了

2.设置本机中ip与主机名的映射

vi /etc/hosts

192.168.90.111 node01

192.168.90.112 node02

192.168.90.113 node03

192.168.90.114 node04

3.为了方便后面搭建集群,我们现在就把其他机器给弄出来

直接将第一台node01给另外克隆出3台来

(1).克隆完成

(2).修改主机名

vi /etc/sysconfig/network 把HostName改成自己的主机名

(3).设置静态ip

参照1

(4)重启服务后会报如图所示错误

解决办法:rm -rf /etc/udev/rules.d/70-persistent-net.rules

reboot,重启后再service network restart即可

4. 安装jdk1.8

rpm -i jdk-8u181-linux-x64.rpm

*有一些软件只认:/usr/java/default

vi /etc/profile

export JAVA_HOME=/usr/java/default

export PATH=$PATH:$JAVA_HOME/bin

source /etc/profile

5.设置免密登录自己

ssh localhost 1,验证自己还没免密 2,被动生成了 /root/.ssh

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys验证:ssh localhost 发现不用密码登录了

6. 搭建haddop

mkdir /opt/poke

mkdir /opt/poke/bigdata

tar xf hadoop-2.6.5.tar.gz

mv hadoop-2.6.5 /opt/poke/bigdata/

vi /etc/profile

export JAVA_HOME=/usr/java/default

export HADOOP_HOME=/opt/poke/bigdata/hadoop-2.6.5

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile设置hadoop配置

1.因为ssh到了另一台机器的时候,我们不能得到系统的环境变量,比如$JAVA_HOME

所以我们需要再hadoop里面自己配置

vi hadoop-env.sh

export JAVA_HOME=/usr/java/default2.配置NameNode在那台机器运行

vi core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://node01:9000</value>

</property>

3.配置hdfs 副本数为1.。。。

vi hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>#namenode的dir

<property>

<name>dfs.namenode.name.dir</name>

<value>/var/bigdata/hadoop/local/dfs/name</value>

</property>#datanode的dir

<property>

<name>dfs.datanode.data.dir</name>

<value>/var/bigdata/hadoop/local/dfs/data</value>

</property>#secondary的ip地址

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node01:50090</value>

</property>#secondary的dir

<property>

<name>dfs.namenode.checkpoint.dir</name>

<value>/var/bigdata/hadoop/local/dfs/secondary</value>

</property>

4.配置DN这个角色再那里启动

vi slaves

node01

7.初始化启动hadoop

hdfs namenode -format

创建目录

并初始化一个空的fsimagestart-dfs.sh

第一次:datanode和secondary角色会初始化创建自己的数据目录

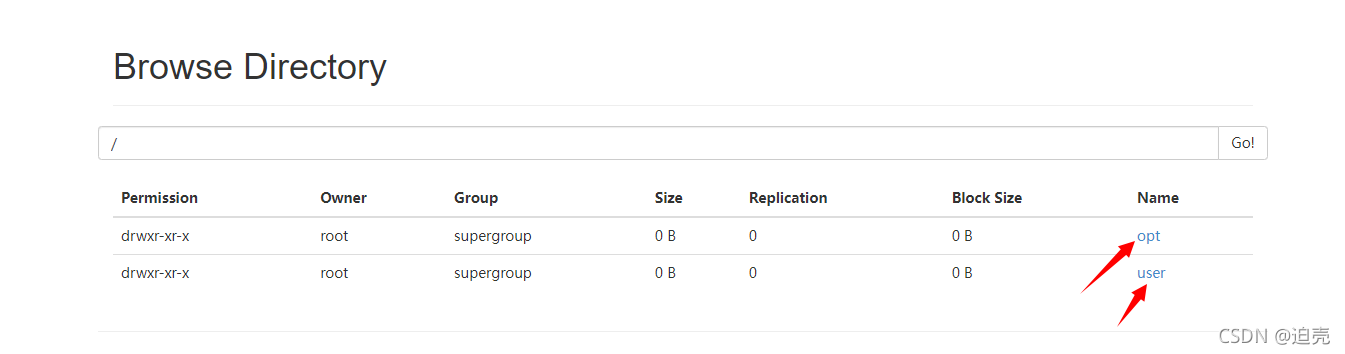

8.访问node01:50070验证结果

如果没有在主机映射的话,可以在windows: C:\Windows\System32\drivers\etc\hosts

192.168.90.111 node01

192.168.90.112 node02

192.168.90.113 node03

192.168.90.114 node04进行映射

测试:

创建opt目录:hdfs dfs -mkdir /opt

创建根目录:hdfs dfs -mkdir -p /user/root

584

584

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?