Uni4D: Unifying Visual Foundation Models for 4D Modeling from a Single Video

问题:

文章

本文提出了一种从随意拍摄视频中理解动态场景的统一方法。

第一遍阅读

Uni4D是一个从野外捕获的单个视频中重建4D场景的新框架且这个框架不需要Uni4D不需要重新训练或微调。

Uni4D也是一个统一视觉基础模型和结构化能量最小化的框架,

名词解释:

一、结构化能量最小化:

“结构化能量最小化”(Structured Energy Minimization)是一种在计算机视觉和图形学中常见的优化方法,用于在复杂的约束条件下找到最优解。以下是对这个概念的详细解释:

1. 能量函数(Energy Function)

在许多优化问题中,能量函数是一个标量函数,用于衡量当前解的质量。能量函数通常由多个部分组成,每个部分对应不同的约束条件。例如:

- 数据项(Data Term) :衡量当前解与观测数据的匹配程度。例如,在图像分割中,数据项可以衡量分割边界与图像边缘的匹配程度。

- 平滑项(Smoothness Term) :用于保证解的平滑性,避免过度波动。例如,在图像分割中,平滑项可以防止分割边界过于复杂。

- 先验项(Prior Term) :引入先验知识,例如运动先验或几何先验,以引导优化过程。

2. 结构化能量最小化

结构化能量最小化的核心思想是通过最小化一个综合的能量函数来找到最优解。这个能量函数不仅考虑数据项,还考虑平滑项和先验项,从而在满足多种约束条件下找到最佳解。具体来说:

- 数据项:确保解与输入数据(如视频帧)的一致性。

- 平滑项:确保解在空间和时间上的平滑性,避免不合理的波动。

- 先验项:引入运动和几何先验,例如物体的运动规律和几何形状,以指导优化过程。

3. 应用示例

在动态四维建模(Dynamic 4D Modeling)中,结构化能量最小化可以用于优化四维表示(如时间序列中的三维形状和运动)。具体步骤如下:

-

初始化:从输入视频中提取初始的四维表示。

-

构建能量函数:

- 数据项:衡量四维表示与视频帧的匹配程度。

- 平滑项:确保四维表示在时间和空间上的平滑性。

- 先验项:引入运动和几何先验,例如物体的运动规律和几何形状。

-

优化:通过最小化能量函数,逐步调整四维表示,使其在满足所有约束条件下达到最优。

4. 优势

结构化能量最小化方法的优势在于:

- 多约束融合:能够同时考虑数据一致性、平滑性和先验知识,从而得到更合理、更稳定的解。

- 灵活性:可以根据具体问题调整能量函数的各个部分,适应不同的应用场景。

- 鲁棒性:通过引入先验知识,可以提高模型对噪声和异常数据的鲁棒性。

5. 总结

结构化能量最小化是一种强大的优化方法,通过综合考虑数据项、平滑项和先验项,能够在复杂的约束条件下找到最优解。在动态四维建模中,这种方法可以有效优化四维表示,使其既符合视觉线索,又遵循运动和几何规律。

第二遍阅读(忽略了实验细节)

相关工作

SfM(运动恢复结构)

- 目标:把几十张旅游照片扔给电脑,让它自动算出你拍照时的位置(比如从哪个角度拍的埃菲尔铁塔),同时把照片里的东西拼成一个3D模型。

- 怎么搞:电脑会找不同照片里相同的点(比如铁塔的塔尖),然后不断调整两个东西——你的拍照位置和这些点的3D坐标,直到这些点在所有照片里的投影位置都对得上(这叫捆调整/光束法平差)。

- 限制:假设你拍的东西都是固定不动的。如果照片里有走动的行人,电脑就懵了:“这人在这张照片里站左边,另一张又跑右边了?我该信哪张?”结果3D模型会出现“重影”或者错位。

SLAM(同步定位与地图构建) :

- 场景:扫地机器人边移动边工作,它要实时知道自己在哪(定位),同时画出房间地图。

- 和SfM的区别:SfM是事后处理照片,SLAM是边拍边算,要求快如闪电。比如扫地机每秒处理30帧画面,否则撞墙上了还没算出来。

- 同样的问题:也依赖“场景静止”的假设。如果家里有跑来跑去的小孩或宠物,扫地机的地图上会出现“幽灵障碍物”(小孩跑过的地方被误认为永久障碍),定位也会漂移。

方法

src="/widgets/Kmind/" data-src="/widgets/Kmind/" data-subtype="widget" border="0" frameborder="no" framespacing="0" allowfullscreen="true" style="width: 1184px; height: 416px;"/>大白话解释:

这段讲的是如何用三个关键步骤,从普通手机拍的视频里**“看”出动态物体的3D形状和运动轨迹**,就像把2D视频变成立体动画模型。整个过程像拼图,需要把不同线索(分割、跟踪、深度)拼起来。

第一步:视频分割——找出哪些东西在动

-

识别物体类别:用RAM模型(类似图像标签器)给视频里的东西贴标签,比如“人”“汽车”“树”。

-

过滤背景:让GPT-4o当“智能筛子”,筛掉“不动的东西”(比如房子、路灯),只留“会动的东西”(比如行人、狗、车)。

-

画框跟踪:

- 用Grounding-SAM(高级PS魔棒工具)在关键帧上精确抠出动态物体。

- 用DEVA(视频跟踪器)盯着这些抠出来的物体,记录它们每帧的位置,得到动态物体随时间移动的轨迹。

作用:相当于在视频里给每个动态物体贴上“追踪器”,知道它们什么时候出现在哪。

第二步:稠密运动追踪——看每个像素点怎么动

-

传统方法问题:以前用光流(类似看像素颜色变化猜移动方向),但遇到大角度转动或物体变形就失效。

-

新方法优势:用Co-TrackerV3(像素级跟踪器)密集跟踪每个像素点的运动路径,即使物体被遮挡也能猜出轨迹。

- 操作:每隔10帧双向跟踪,确保覆盖所有时间段。

- 过滤:结合分割结果,只保留动态物体上的点,得到高密度运动轨迹。

类比:就像在视频画面上撒满荧光粉,每个光点移动都被记录下来,连成运动路径。

第三步:视频深度估计——猜物体离相机多远

- 单目深度问题:只用一部手机拍的视频,很难准确判断物体距离(就像闭一只眼很难接住飞来的球)。

- 解决方案:用UniDepthV2(深度猜猜看模型)估计每帧的粗略深度图和相机参数,作为初始猜测。

作用:虽然不够准,但能告诉系统“人大概离镜头5米,车在10米外”,为后续优化打基础。

为什么这套方法厉害?

-

模块化设计:每个步骤用现成模型(RAM、GPT-4、SAM等)像乐高积木一样拼装,哪个模块升级了直接替换。

-

多线索互补:

- 分割告诉系统“哪里是动态物体”

- 跟踪告诉系统“这些物体怎么动”

- 深度提供“空间位置初始猜测”

-

省时省力:不用训练新模型,一部手机视频就能输出带时间轴的3D模型(比如跳舞的人的骨骼运动+衣服飘动)。

举个实际例子:

拍一段“小孩踢足球”的视频:

- 分割:识别出“小孩”和“足球”是动态物体,过滤掉背景的草坪和球门。

- 跟踪:追踪小孩的四肢关节点和足球表面的每个像素点,记录它们每帧的位置变化。

- 深度:粗略判断小孩离镜头3米,足球飞到了5米外。

- 最终输出:重建出小孩踢球的3D动作模型+足球飞行轨迹,还能反推出拍摄时手机的移动路径。

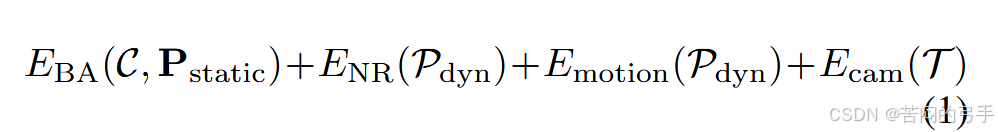

动态4D重建框架的能量公式:

-

设输入动态分割 M = { M t } t = 0 T M = \left\lbrace M_{t}\right\rbrace^{T}_{t=0} M={Mt}t=0T、单目深度 D = { D t } t = 0 T D = \left\lbrace D_{t}\right\rbrace^{T}_{t=0} D={Dt}t=0T 和密集运动轨迹 Z = { Z k } k = 0 K Z = \left\lbrace Z_{k}\right\rbrace^{K}_{k=0} Z={Zk}k=0K 均从输入视频 I = { I t } t = 0 T I = \left\lbrace I_{t}\right\rbrace^{T}_{t=0} I={It}t=0T 中提取。

-

目标:获取相机参数 C(包含位姿 T 和内参 K),以及包含动态和静态部分的 4D点云集合 P={Pstatic,Pdyn}。

- P s t a t i c P_{static} Pstatic:不随时间变化的静态点云

- P d y n = ( P k ∈ R T × 3 ) k P_{dyn}=({P_{k} \in R^{T\times3}})_k Pdyn=(Pk∈RT×3)k:随时间变化的动态点轨迹(每个 P k P_k Pk 是一条动态点的运动路径)

解释

three-stage optimization pipeline:

Stage 1: Camera Initialization.

Stage 2: Bundle Adjustment.

Stage 3: Non-Rigid Bundle Adjustment.

总结

第二遍阅读对uni4D有了一个基本的认识,但其实现方法仍然是一知半解,也就是说我仍然没有明白他的具体方法,这其中有一些基础的问题

zotero笔记

代码阅读

给的图片数据表示一张图片就是视频的一帧

模型的运行顺序

模型的完整使用顺序(pipeline)是一个级联的多阶段流程,将2D视频逐步提升为动态3D场景表示(4D = 3D几何 + 时间维度)。以下是其核心步骤的清晰拆解:

1. 整体流程概述

论文的模型顺序可概括为:

视频输入 → 2D特征提取与跟踪 → 3D几何初始化 → 时空优化 → 4D表示生成与渲染

每个阶段依赖前一阶段的输出,最终实现从单视频到动态3D场景的建模。

2. 详细使用顺序与模块功能

阶段1:视频预处理与特征提取

-

输入视频分割

- 将输入视频分割为连续的帧序列 ( {I_1, I_2, ..., I_T} )。

- 可能进行帧采样(如固定间隔)以平衡计算效率与时序精度。

-

2D特征提取(如ViT或CNN)

- 使用视觉基础模型(如DINOv2、CLIP)提取每帧的全局/局部特征。

- 输出:每帧的2D特征图 ( {F_1, F_2, ..., F_T} )。

-

RAM模型(划分关键词) →GPT-4o(区分静态和动态事务)

阶段2:跨帧点跟踪(CoTracker3)

-

稀疏/密集点跟踪

- CoTracker3 在帧间跟踪特征点(如SuperPoint关键点或均匀采样点),生成轨迹 ( { \mathbf{p}ti }{t=1}T ),其中 ( \mathbf{p}_t^i ) 是第 ( i ) 个点在帧 ( t ) 的2D坐标。

- 解决遮挡和长时一致性(如通过时序Transformer或光流传播)。

阶段3:3D结构初始化

-

动态点云初始化

- 基于多视图几何(如运动恢复结构,SfM)或单目深度估计(如MiDaS),将2D轨迹提升为初始3D点 ( { \mathbf{P}^i } )。

- 可能联合优化相机位姿(若视频来自移动视角)。

阶段4:时空优化与4D建模

-

动态神经辐射场(NeRF)或体素网格

-

将3D点与时间变量 ( t ) 结合,构建4D表示(如DyNeRF、HexPlane)。

-

通过可微渲染(Differentiable Rendering)优化几何与外观:

- 颜色约束:渲染帧与真实帧的像素误差(L1/L2损失)。

- 轨迹约束:渲染的2D投影应与CoTracker3的轨迹对齐。

-

-

正则化与细化

- 添加时空平滑性约束(如光流一致性、形变场正则化)。

- 可能引入物理约束(如刚体运动先验)提升真实性。

阶段5:渲染与应用

-

新视角合成(NVS)与编辑

- 输入任意相机视角和时间 ( t ),渲染高清图像或视频。

- 支持动态场景编辑(如物体移除、运动调整)。

3. 关键模块依赖关系

-

CoTracker3的输入依赖:原始视频帧 + 初始特征(如2D关键点)。

-

4D建模的输入依赖:CoTracker3的轨迹 + 初始3D点云。

-

端到端训练?

- 若论文采用联合优化(如BA + NeRF),则部分阶段(如跟踪与重建)可能交替迭代;

- 若为分阶段独立训练,则顺序严格递进。

4. 与同类工作的差异

Uni4D的核心创新在于统一框架的设计:

- 传统方法:通常分离跟踪、重建、渲染(如COLMAP → NeRF)。

- Uni4D:通过共享基础模型特征(如ViT)和联合目标,实现端到端兼容性。

5. 图示辅助理解

若论文包含流程图(如Figure 2或3),可重点关注:

- 箭头方向:体现模块间的数据流向。

- 损失函数位置:揭示是否有多阶段联合优化(如跟踪误差是否反向传播到特征提取器)。

如需更具体的训练细节或数学形式化描述,可定位论文的 Methodology 章节(通常为第3节)。

623

623

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?