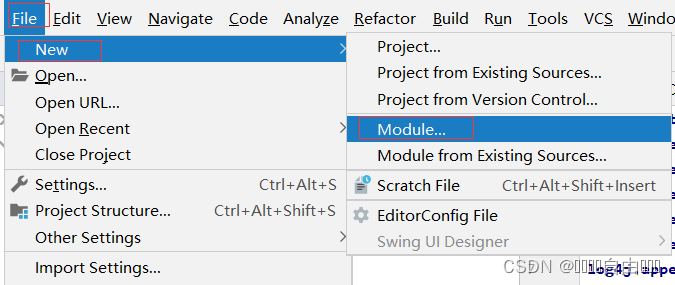

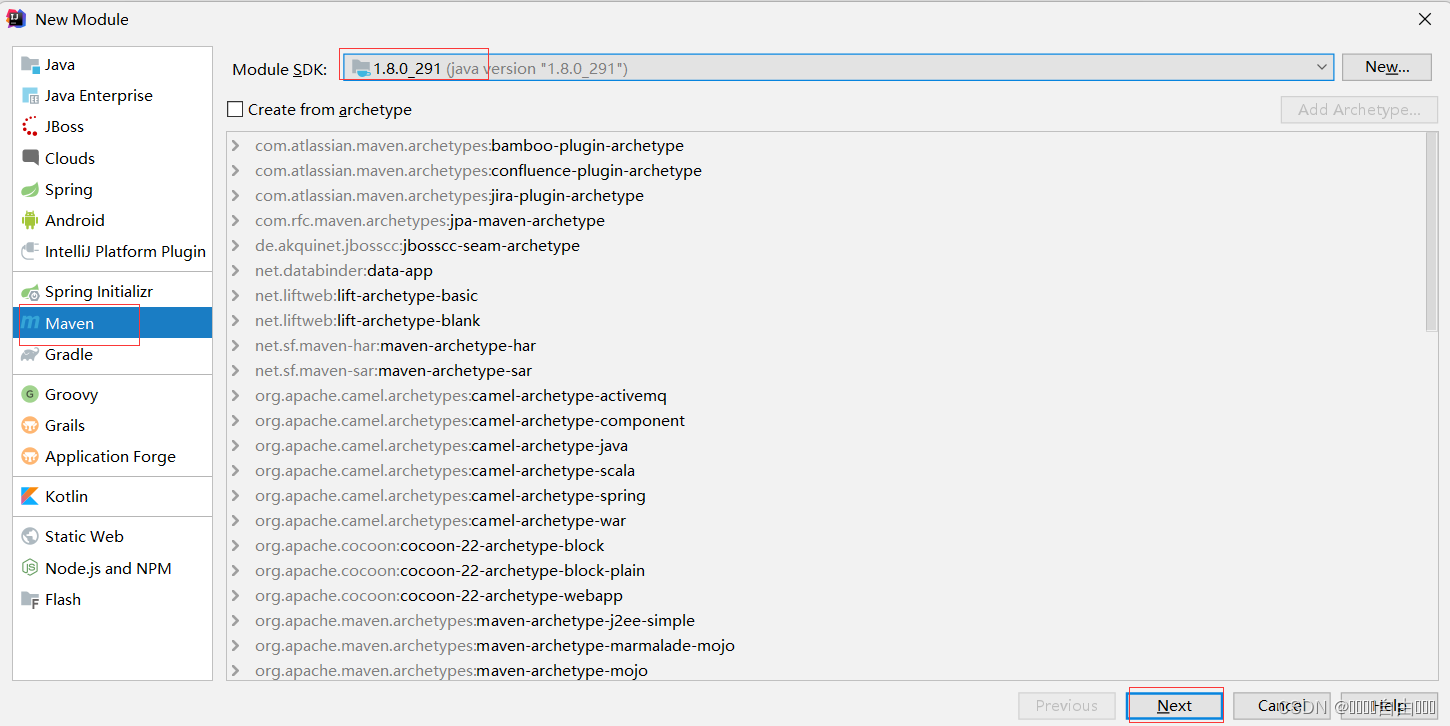

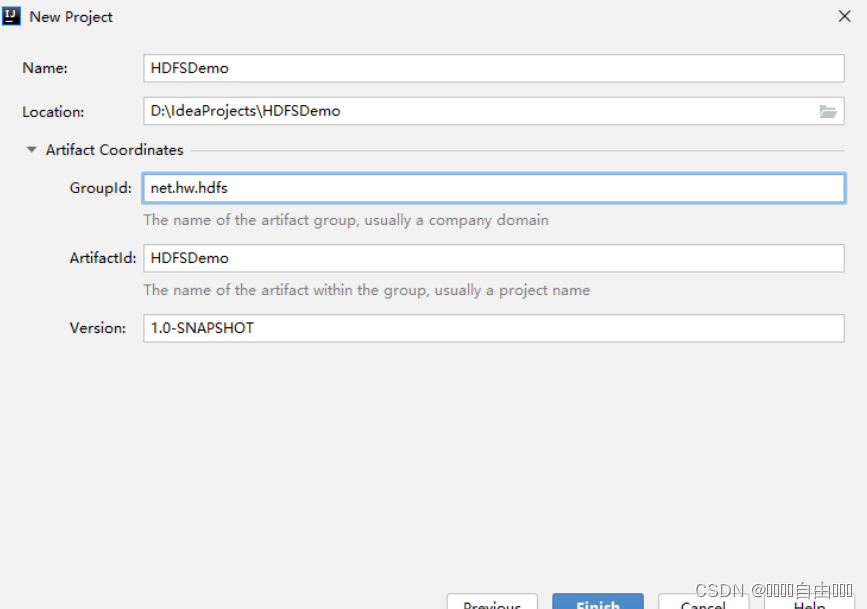

创建Maven项目

单击【Finish】按钮

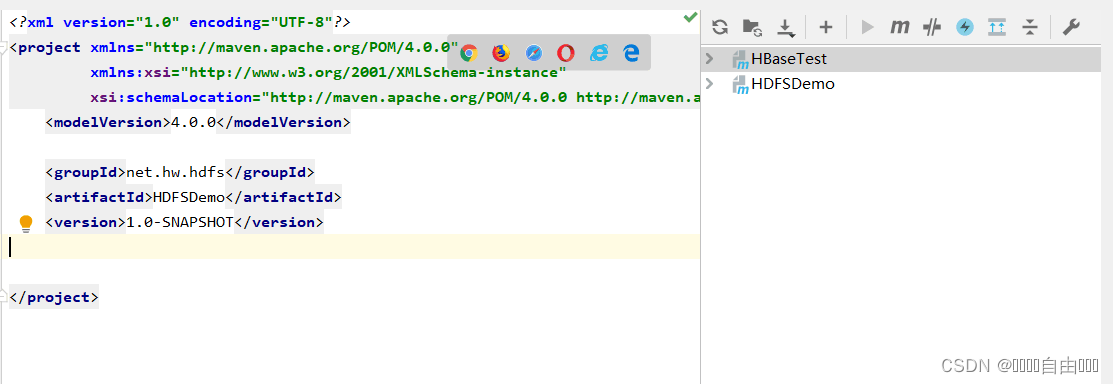

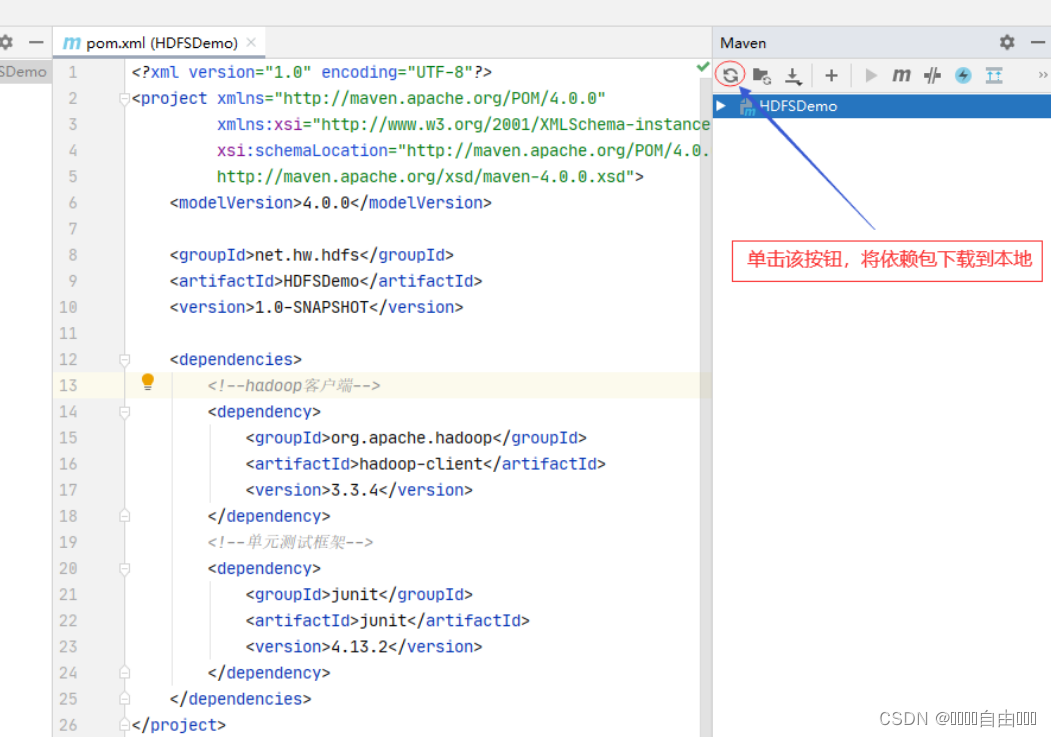

在里面添加两个依赖:

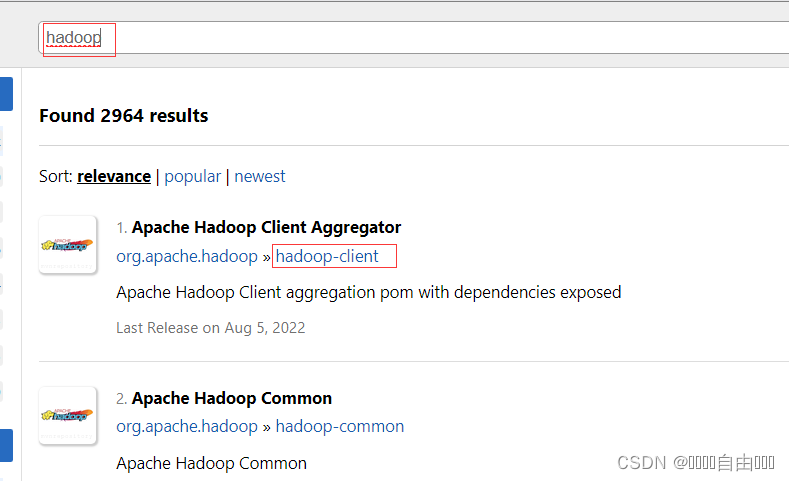

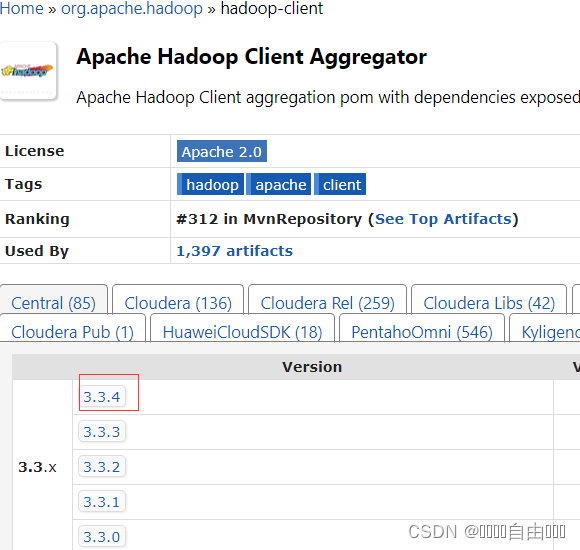

Maven Repository(Maven仓库)- https://mvnrepository.com/

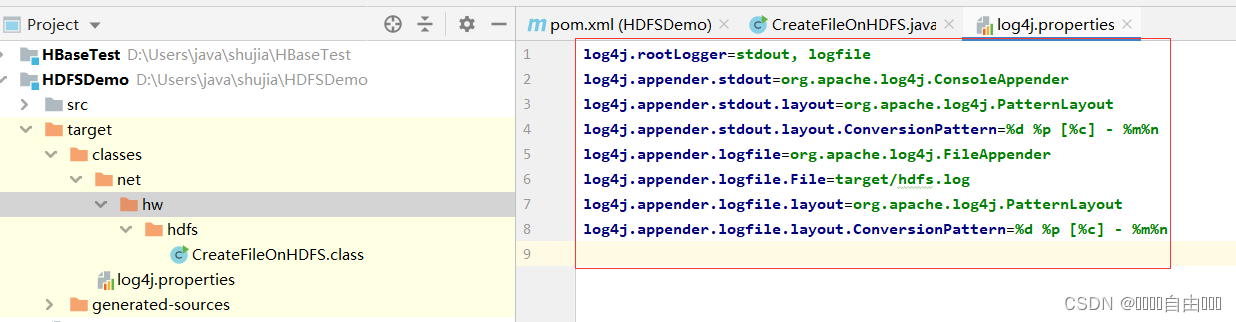

在resources目录里创建log4j.properties文件

log4j.rootLogger=stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/hdfs.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

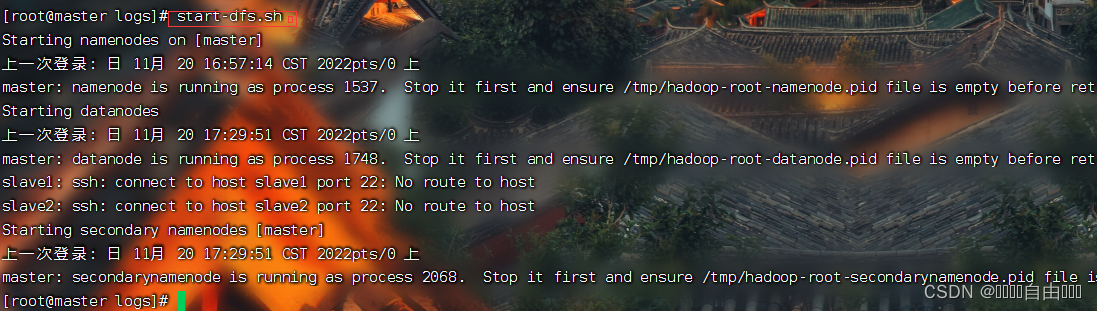

在主节点上执行命令:start-dfs.sh

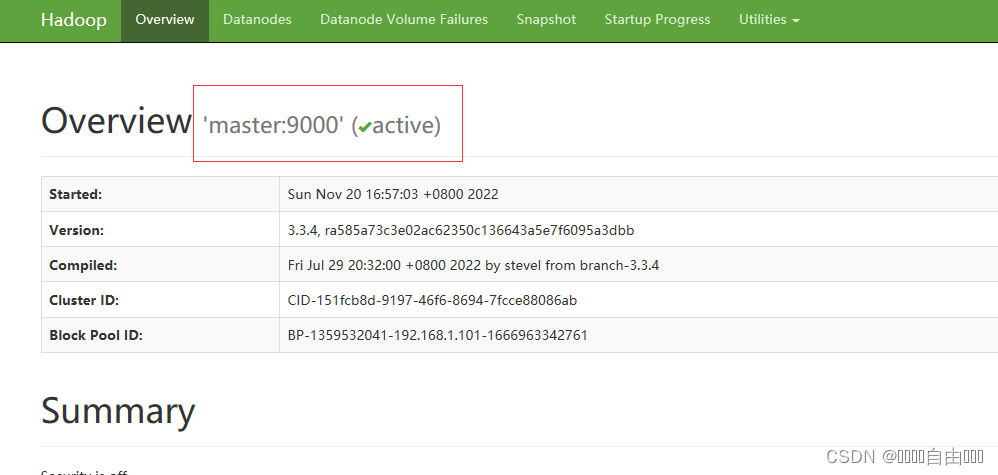

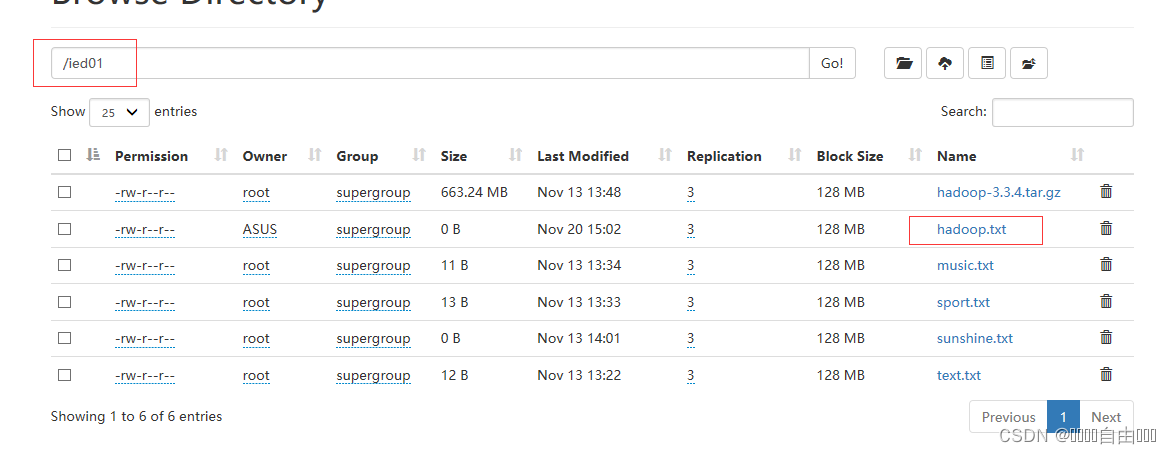

在Hadoop WebUI界面查看

创建

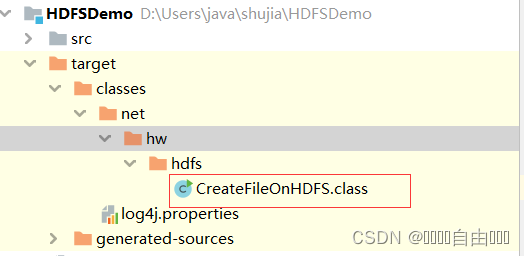

创建net.hw.hdfs包,在包里创建CreateFileOnHDFS类

在HDFS上有/ied01目录,在该目录里创建hadoop.txt文件

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.net.URI;

public class CreateFileOnHDFS {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义统一资源标识符

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象

Path path = new Path(uri + "/ied01/hadoop.txt");

// 创建文件

boolean result = fs.createNewFile(path);

// 判断文件是否创建成功

if (result) {

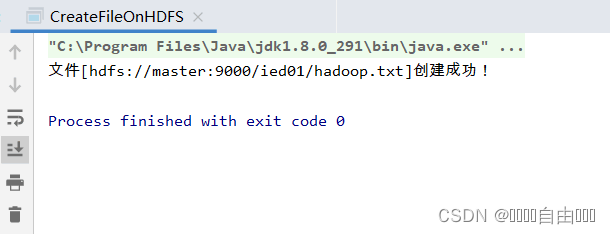

System.out.println("文件[" + path + "]创建成功!");

} else {

System.out.println("文件[" + path + "]创建失败!");

}

}

}

运行程序,查看结果

利用HDFS集群WebUI查看

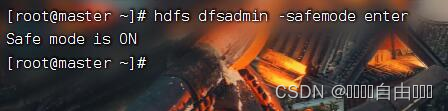

在finalshell中开启安全模式输入:hdfs dfsadmin -safemode enter

在finalshell中删除hadoop.txt文件,输入命令:hdfs dfs -rm /ied01/hadoop.txt

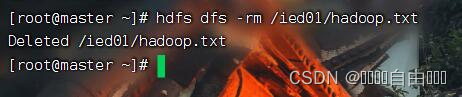

运行Java代码,获得报错,解决办法里面含有,在finalshell中输入:hdfs dfsadmin -safemode leave 关闭安全模式

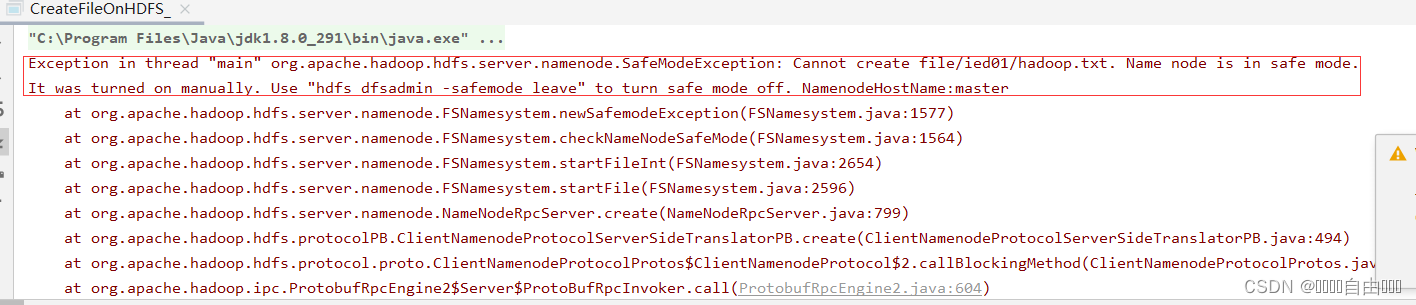

修改代码,抛出异常

public class CreateFileOnHDFS_ {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象

Path path = new Path(uri + "/ied01/hadoop.txt");

//判断路径对象指向的文件是否存在

if (fs.exists(path)){

//提示用户文件已存在

System.out.println("文件["+path+"]已存在");

}else {

// 创建文件

try {

boolean result = fs.createNewFile(path);

// 判断是否创建成功

if (result) {

System.out.println("文件[" + path + "]创建成功!");

} else {

System.out.println("文件[" + path + "]创建失败!");

}

} catch (Exception e) {

System.err.println("异常信息:"+e.getMessage());

}

}

}

}

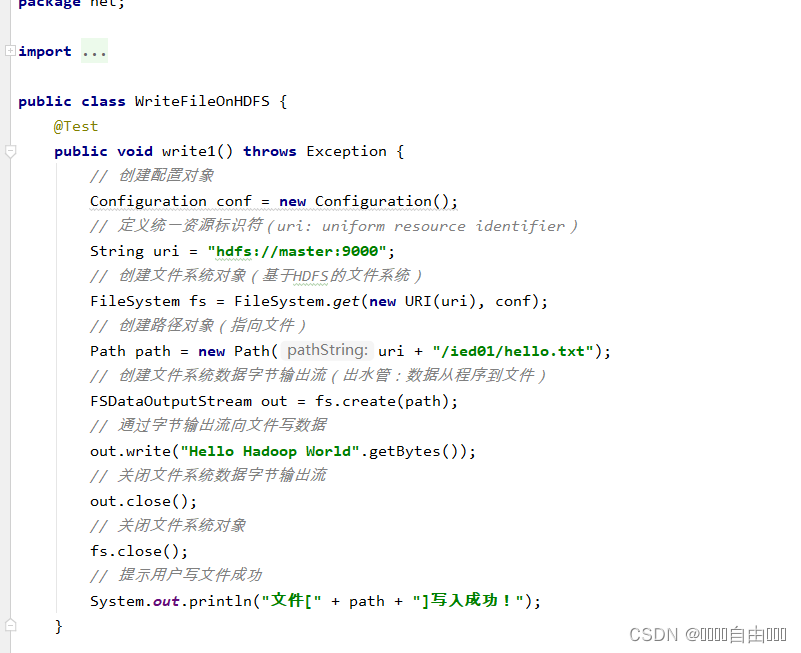

在/ied01目录里创建hello.txt文件,创建write1()方法

package net;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class WriteFileOnHDFS {

@Test

public void write1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/hello.txt");

// 创建文件系统数据字节输出流(出水管:数据从程序到文件)

FSDataOutputStream out = fs.create(path);

// 通过字节输出流向文件写数据

out.write("Hello Hadoop World".getBytes());

// 关闭文件系统数据字节输出流

out.close();

// 关闭文件系统对象

fs.close();

// 提示用户写文件成功

System.out.println("文件[" + path + "]写入成功!");

}

}

2094

2094

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?