目录

Attempting to operate on hdfs namenode as root

Hadoop

Attempting to operate on hdfs namenode as root

HDfs客户端报错

(31条消息) 两种解决ERROR: Attempting to operate on hdfs namenode as root的方法_世幻水的博客-CSDN博客

报错:

jps后没有namenode

解决

删除data logs 重新初始化namenode

Hive

报错

Exception in thread "main" java.lang.NoSuchMethodError: com.google.common.base.Preconditions.checkArgument(ZLjava/lang/String;Ljava/lang/Object;)V

原因

hive和hadoop里的 guava.jar版本不一样

解决

cd /opt/module/hive-3.1.1/lib

ll |gerp guavacd /opt/module/hadoop-3.1.3/share/hadoop/common/lib

ll |grep guava比较两个guava-*-jre.jar的版本

rm guava-低版本的.jar

cp 高版本的 低版本的文件目录加guava-高版本的.jar报错

Caused by:org.apache.hadoop.ipc. RemoteException (org.apache.hadoop.hdfs.server.namenode.SafeModeExcepti

on):Cannot create directory /tmp/hive. Name node is in safe mode

原因

NameNode 处于安全模式 ,对于客户端是only-read。

NameNode启动时,将镜像文件fsimage载入内存,并执行编辑日志edits log中的所有操作,从而建立完整的元数据metadata。

满足最小副本条件(配置项minimal replication condition决定),NameNode 将会在随后(默认30s,配置项dfs.namenode.safemode.extension)自动退出safemode。

NameNode 处于安全模式有两种情况:

1. NameNode启动前30s.

2. 不满足最小副本条件。

参数:

| 属性名称 | 数据类型 | 默认值 | 说明 |

| dfs.namenode.replication.min | int | 1 | 成功执行写操作所需要创建的最小副本数目(也称为最小副本级别) |

| dfs.namenode.safemode.threshold-pct | float | 0.999 | 在namenode退出安全模式之前,系统中满足最小副本级别(dfs.namenode.replication.min定义)的块的比例。将这项值设为0或更小会令namenode无法启动安全模式;设为高于1则永远不会退出安全模式 |

| dfs.namenode.safemode.extension | int | 30000 | 在满足最小副本条件(由dfs.namenode.safemode.threshold-pct定义)之后,namenode还需要处于安全模式的时间(以毫秒为单位)。对于小型集群(几十个节点)来说,这项值可以设为0 |

解决

等待30s后,再启动Hive;

如果不行可以强制退出

# hdfs:可执行命令

# dfsadmin:运行一个dfs admin client

# -safemode:参数,安全模式

# get:参数,是否安全模式(on表示是,off表示否)

# enter:参数,进入安全模式

# leave:参数,离开安全模式

hdfs dfsadmin -safemode get # NameNode是否出于安全模式

hdfs dfsadmin -safemode enter # 进入安全模式

hdfs dfsadmin -safemode leave # 离开安全模式Spark

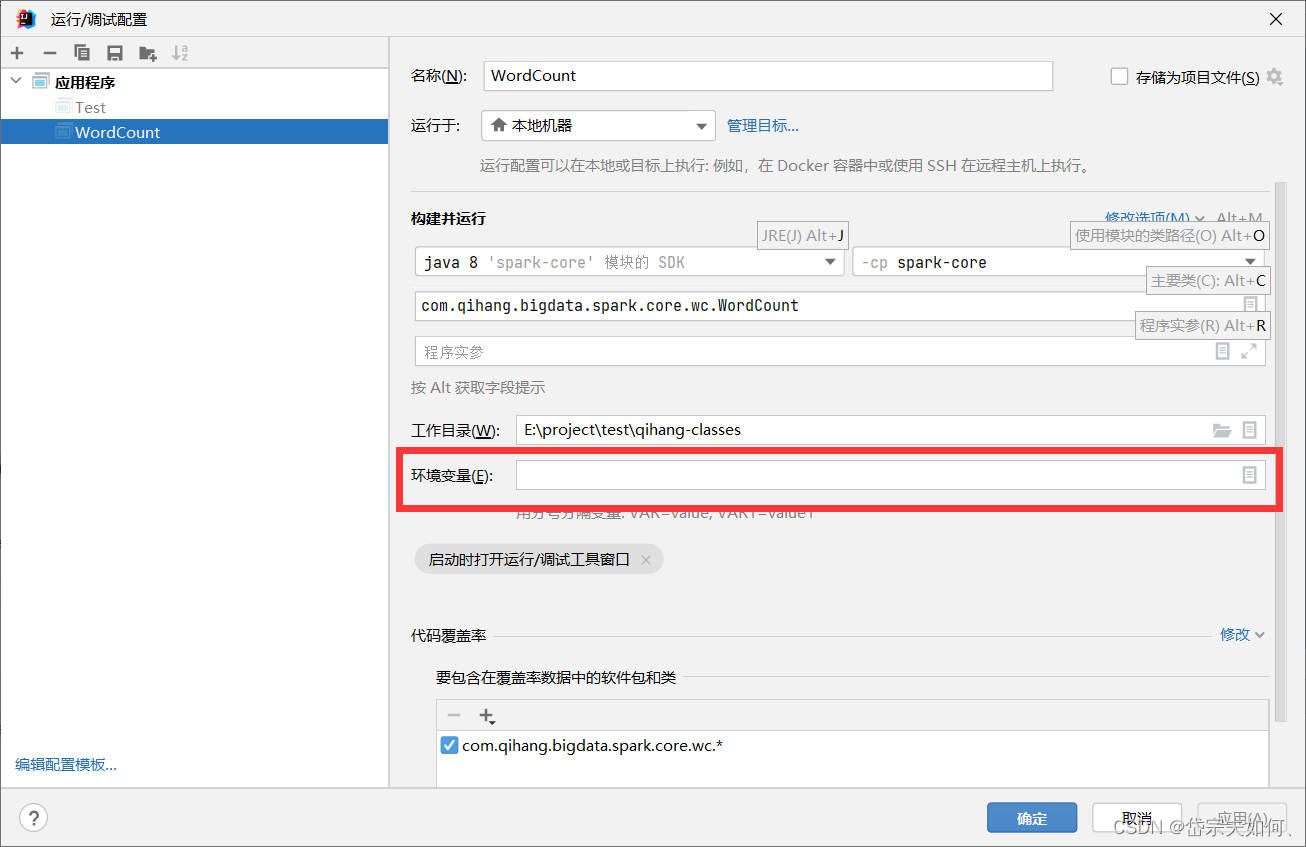

ERROR --[main]org.apache.hadoop.util.Shell(line:303):Failed to locate the winutils binary in the hadoop binary path

java.io.IOException:Could not locate executable null\bin\winutils.exe in the Hadoop binaries

来源:

尚硅谷

文章列举了在操作Hadoop、Hive和Spark时遇到的一些典型错误,如尝试以root用户操作HDFS、Namenode未启动、Guava版本不匹配、NameNode处于安全模式以及Spark找不到winutils.exe。针对这些问题,提供了相应的解决方案,包括删除datalogs重置Namenode、替换Guava库、等待或强制退出安全模式以及配置HADOOP_HOME环境变量。

文章列举了在操作Hadoop、Hive和Spark时遇到的一些典型错误,如尝试以root用户操作HDFS、Namenode未启动、Guava版本不匹配、NameNode处于安全模式以及Spark找不到winutils.exe。针对这些问题,提供了相应的解决方案,包括删除datalogs重置Namenode、替换Guava库、等待或强制退出安全模式以及配置HADOOP_HOME环境变量。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?