文章目录

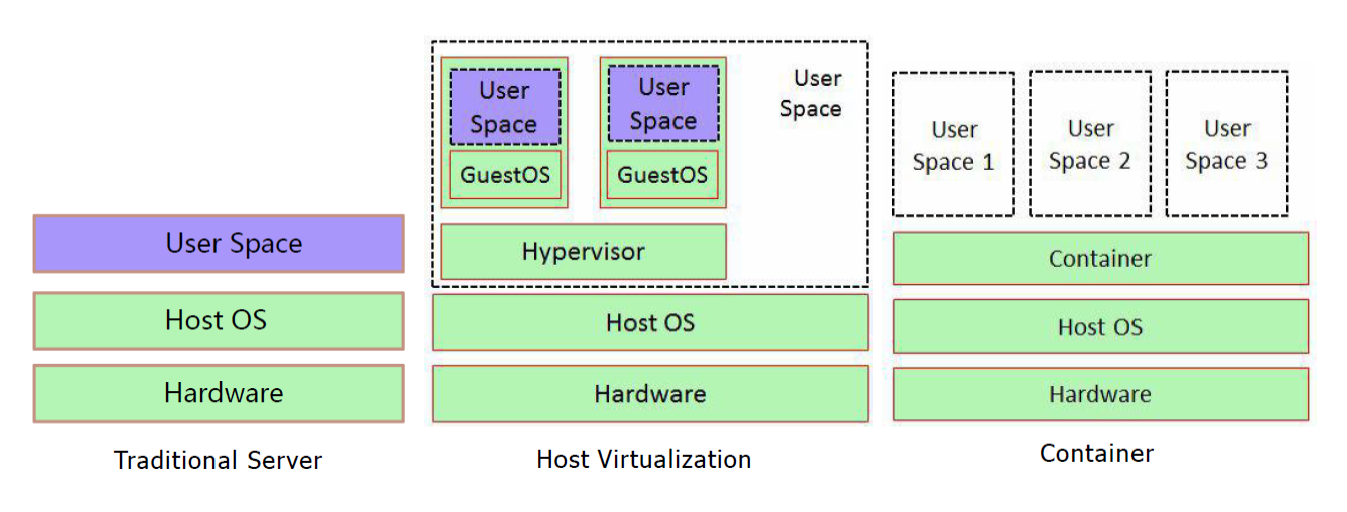

虚拟化

虚拟化:是指通过虚拟化技术将一台计算机虚拟为多台逻辑计算机。

在一台计算机上同时运行多个逻辑计算机,每个逻辑计算机可运行不同的操作系统,并且应用程序都可以在相互独立的空间内运行而互不影响,从而显著提高计算机的工作效率

技术角度分类

完全虚拟化技术:在虚拟机(VM)和硬件之间加了一个软件层Hypervisor(或者叫虚拟机监控器VMM),Hypervisor在中间好比翻译者的角色,工作在硬件层之上,直接可以跟硬件进行交互,应用程序发送指令调用内核,内核通过驱动的方式返回给Hypervisor ,Hypervisor 在把指令翻译给硬件去听,然后在一级级返回给应用程序

Hypervisor 直接运行在物理硬件之上-KVM

Hypervisor 运行在另一个操作系统中 QEMU 和 WINE

半虚拟化技术:在完全虚拟化的基础上对操作系统进行了修改,增加了专门的API,这个API可以将操作系统发出的指令进行优化,使性能大大提高

架构类型分类

寄居架构:在操作系统之上安装和运行虚拟化程序,依赖于主机操作系统对设备的支持和物理资源的管理

优点:简单,便于实现

缺点:安装和运行应用程序依赖于主机操作系统对设备的支持,宿主操作系统崩了该虚拟程序也无法使用无用消耗(windows装上vmware,就算不打开也消耗内存)

举例:GSXServer,VMware Server,Workstation

裸金属架构:直接在硬件上面安装虚拟化软件,再在其上安装操作系统和应用,依赖虚拟层内核和服务器控制台进行管理。

优点:虚拟机不依赖于操作系统,可以支持多种操作系统,多种应用,更加灵活

缺点:虚拟层内核开发难度较大

举例:VMWare ESXI Server

Vmver ESXi

Vmver ESXi是专门构建的裸机hypervisor,ESXi直接安装在物理服务器上,并将其划分为多个逻辑服务器,既虚拟机

router:数据转发,可以 按照请求的类型、地址进行转发,

server根据请求的类型执行主机中,主机会生成一个引擎,生成很多个job,比如执行 docker run 就会生成docker run 的 job,docker执行的每一条命令都可以理解为一个job

容器与虚拟机

容器是一种沙盒(沙箱)技术。沙盒将软件运行于一个受限的系统环境中,控制程序可使用的资源(如文件描述符、内存、磁盘空间等)。顾名思义,沙盒就是能够像一个集装箱一样,把你的应用装起来。这样应用与应用之间就有了边界而不会相互干扰。同时装在沙盒里面的应用,也可以很方便的被搬来搬去,这也是 PaaS 想要的最理想的状态(可移植性,标准化,隔离性)。

容器技术是虚拟化、云计算、大数据之后的一门新兴的并且是炙手可热的新技术, 容器技术提高了硬件资源利用率、 方便了企业的业务快速横向扩容(可以达到秒级快速扩容)、 实现了业务宕机自愈功能(配合K8S可以实现,但OpenStack无此功能),因此未来数年会是一个容器愈发流行的时代 ,这是一个对于 IT 行业来说非常有影响和价值的技术,而对于IT行业的从业者来说, 熟练掌握容器技术无疑是一个很有前景的行业工作机会。

传统虚拟机是虚拟出一个主机硬件,并且运行一个完整的操作系统,然后在这个系统上安装和运行软件。使用虚拟机是为了更好的实现服务运行环境隔离,每个虚拟机都有独立的内核,虚拟化可以实现不同操作系统的虚拟机,但是通常一个虚拟机只运行一个服务,很明显资源利用率比较低且造成不必要的性能损耗,我们创建虚拟机的目的是为了运行应用程序,比如Nginx、PHP、Tomcat等web程序,使用虚拟机无疑带来了一些不必要的资源开销,但是容器技术则基于减少中间运行环节带来较大的性能提升。

容器没有内核,容器启动和运行过程中直接使用了宿主机的内核,通过宿主机内核调用物理硬件。而镜像本身则只提供相应的roots,即系统正常运行所必须的用户空间的文件系统,比如/dev、/proc、/bin、/etc等目录,所以容器当中基本是没有/boot目录的,而/boot当中保存的就是与内核相关的文件和目录。对于宿主机而言,每个容器就是一个单独的进程,数据存储在磁盘中,通过调用内核进行访问。

根据实验,一个运行着CentOS的KVM虚拟机启动后,在不做优化的情况下,虚拟机自己就需要占用 100~200 MB内存(虚拟机一般会有5-20%的损耗)。此外,用户应用运行在虚拟机里面,它对宿主机操作系统的调用就不可避免地要经过虚拟化软件的拦截和处理,这本身又是一层性能损耗,尤其对计算资源、网络和磁盘I/O的损耗非常大。

比如: 一台96G内存的物理服务器,为了运行java程序的虚拟机一般需要分配8G内存/4核的资源,只能运行13台左右虚拟机,但是改为在docker容器上运行Java程序,每个容器只需要分配4G内存即可,同样的物理服务器就可以运行25个左右容器,运行数量相当于提高一倍,可以大幅节省IT支出,通常情况下至少可节约一半以上的物理设备

Docker 和虚拟机、物理主机

容器直接使用了宿主机的内核,而虚拟机运行的是一个完整的操作系统,独立的操作系统,独立的内核。所以容器隔离性没有虚拟机隔离性好啊

容器管理工具

有了 chroot、namespace、cgroups就具备了基础的容器运行环境,但是还需要有相应的容器创建与删除的管理工具、以及怎么样把容器运行起来、容器数据怎么处理、怎么进行启动与关闭等问题需要解决,于是容器管理技术出现了。早期使用 LXC,目前主要是使用docker。

一提到容器,好多人认为docker就是容器,其实docker只是一种容器工具,就好比一提到操作系统,我们能想到windows、linux、macos等。docker镜像运行后也叫做容器,这个容器是镜像运行后的结果。

LXC:Linux Container。可以提供轻量级的虚拟化功能,以便隔离进程和资源,包括一系列容器的管理工具软件。如lxc-create、lxc-start、lxc-attach等,但这技术功能不完善,目前较少使用

Docker:Docker 相当于增强版的LXC,功能更为强大和易用,也是当前最主流的容器前端管理工具

Docker 先启动一个容器也需要一个外部模板,也称为镜像,docke的镜像可以保存在一个公共的地方共享使用,只要把镜像下载下来就可以使用,最主要的是可以在镜像基础之上做自定义配置并且可以再把其提交为一个镜像,一个镜像可以被启动为多个容器。

Docker的镜像是分层的,镜像底层为库文件且只读层即不能写入也不能删除数据,从镜像加载启动为一个容器后会生成一个可写层,其写入的数据会复制到宿主机上对应容器的目录,但是容器内的数据在删除容器后也会被随之删除。

pouch(小袋子):在中国开源年会现场,阿里巴巴正式开源了基于 Apache 2.0 协议的容器技术 Pouch。Pouch 是一款轻量级的容器技术,拥有快速高效、可移植性高、资源占用少等特性,主要帮助阿里更快的做到内部业务的交付,同时提高超大规模下数据中心的物理资源利用率。目前的容器方案大多基于 Linux 内核提供的 cgroup 和 namespace 来实现隔离,然后这样轻量级方案存在的弊端:容器间,容器与宿主间,共享同一个内核。内核实现的隔离资源,维度不足。

面对如此的内核现状,阿里巴巴采取了三个方面的工作来解决容器的安全问题:用户态增强容器的隔离维度,比如网络带宽、磁盘使用量等。给内核提交 patch,修复容器的资源可见性问题,cgroup 方面的 bug。实现基于 Hypervisor 的容器,通过创建新内核来实现容器隔离

Podman:Podman即Pod Manager tool,从名称上可以看出和kubernets的pod的密切联系,不过就其功能来说,简而言之: alias docker = podman,是CentOS 8 新集成的功能,或许不久的未来会代替docker

Podman是一个 为 Kubernetes 而生的开源的容器管理工具,原来是 CRI-O(即容器运行时接口CRI 和开放容器计划OCI) 项目的一部分,后来被分离成一个单独的项目叫 libpod。其可在大多数Linux平台上使用,它是一种无守护程序的容器引擎,用于在Linux系统上开发,管理和运行任何符合Open Container Initiative(OCI)标准的容器和容器镜像。

Podman 提供了一个与Docker兼容的命令行前端,Podman 里面87%的指令都和Docker CLI 相同,因此可以简单地为Docker CLI别名,即“ alias docker = podman”,事实上,podman使用的一些库也是docker的一部分。

容器工具 Docker

Docker是一个基于go语言遵从apache2.0协议开源的LXC的高级容器引擎(底层技术是Linux Container,docker只是管理底层的工具),并通过namespace、cgroup等来提供容器的资源隔离与安全保障等。

Docker 最早采用 LXC 技术 (LXC 是 Linux 原生支持的容器技术,是一种内核虚拟化技术,可以提供轻量级的虚拟化,LXC将Linux进程沙盒化,使进程之间相互隔离 ),可以说docker 就是基于 LXC 发展起来的。在LXC的基础之上,docker提供了一系列更强大的功能。后来Docker 改为自己研发并开源的 runc 技术运行容器,彻底抛弃了LXC。而虚拟化技术 KVM(KernelKernelbasedVirtual Machine Machine) 基于模块实现。

docker容器不能跨主机访问,Docker 相比虚拟机的交付速度更快,资源消耗更低,Docker 采用客户端/服务端架构,使用远程API来

管理和创建容器,其可以轻松的创建一个轻量级的、可移植的、自给自足的容器,docker 的三大理念是build(构建)、ship(运输)、 run(运行),Docker遵从apache 2.0协议,并通过namespace及cgroup等来提供容器的资源隔离与安全保障等,所以Docke容器在运行时不需要类似虚拟机(空运行的虚拟机占用物理机6-8%性能)的额外资源开销,因此可以大幅提高资源利用率,总而言之Docker是一种用了新颖方式实现的轻量级虚拟机.类似于VM但是在原理和应用上和VM的差别还是很大的,并且docker的专业叫法是应用容器(Application Container)。

Docker 是一个可以将应用程序及其依赖打包到几乎可以在任何服务器上运行的容器的工具。将应用运行在容器中,容器在任何操作系统上都是一致的,使其运行环境一次封装,处处运行,解决了代码水土不服,实现了跨平台跨服务器。解决了软件跨环境迁移的问题。

docker的组成

| docker组成 | 说明 |

|---|---|

| docker 主机 | 一个物理机或虚拟机,用来运行docker服务进程和容器 |

| docker 服务端 | docker的守护进程,主要用来运行docker容器 |

| docker 客户端 | 客户端使用docker命令或其它工具调用docker API 对容器进行操作 |

| docker 仓库 | 保存镜像的仓库,类似于git和svn |

| docker 镜像 | 封装好的运行环境,镜像运行之后变成容器 |

| docker 容器 | 镜像运行完成以后得到的正在运行的运行环境 |

docker部署

docker配置阿里云加速器,国内下载国外的镜像有时候会很慢,可以通过加速器达到加速下载镜像的目的

[root@localhost ~]# dockerd --help | grep json

--config-file string Daemon configuration file (default "/etc/docker/daemon.json")

[root@localhost ~]# sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://oinh00fc.mirror.aliyuncs.com"]

}

EOF

#{

# "registry-mirrors": ["https://oinh00fc.mirror.aliyuncs.com"],

# "graph": "/data/docker" #修改存储路径,默认存储/var/lib/docker/

#}

[root@localhost ~]# systemctl daemon-reload

[root@localhost ~]# systemctl enable docker && systemctl restart docker

[root@localhost ~]# docker info

Registry Mirrors:

https://oinh00fc.mirror.aliyuncs.com/

二进制部署:

比如服务器不能访问外网,通过ansible批量部署二进制安装包

下载docker二进制包:https://download.docker.com/linux/static/stable/x86_64/

wget https://download.docker.com/linux/static/stable/x86_64/docker-20.10.17.tgz

tar -zxf docker-20.10.17.tgz

[root@localhost ~]# ls docker

containerd containerd-shim containerd-shim-runc-v2 ctr docker dockerd docker-init docker-proxy runc

[root@localhost ~]# cp docker/* /usr/bin/ #将可执行文件拷贝到/usr/bin

[root@localhost ~]# vim /lib/systemd/system/docker.service

[Unit]

Description=Docker Application Container Engine

Documentation=https://docs.docker.com

After=network-online.target docker.socket firewalld.service containerd.service

Wants=network-online.target

Requires=docker.socket containerd.service

[Service]

Type=notify

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

ExecReload=/bin/kill -s HUP $MAINPID

TimeoutSec=0

RestartSec=2

Restart=always

StartLimitBurst=3

StartLimitInterval=60s

LimitNOFILE=infinity

LimitNPROC=infinity

LimitCORE=infinity

TasksMax=infinity

Delegate=yes

KillMode=process

OOMScoreAdjust=-500

[Install]

WantedBy=multi-user.target

[root@localhost ~]# vim /lib/systemd/system/docker.socket

[Unit]

Description=Docker Socket for the API

[Socket]

ListenStream=/var/run/docker.sock

SocketMode=0660

SocketUser=root

SocketGroup=docker

[Install]

WantedBy=sockets.target

[root@localhost ~]# vim /lib/systemd/system/containerd.service

[Unit]

Description=containerd container runtime

Documentation=https://containerd.io

After=network.target local-fs.target

[Service]

ExecStartPre=-/sbin/modprobe overlay

ExecStart=/usr/bin/containerd

Type=notify

Delegate=yes

KillMode=process

Restart=always

RestartSec=5

LimitNPROC=infinity

LimitCORE=infinity

LimitNOFILE=infinity

TasksMax=infinity

OOMScoreAdjust=-999

[Install]

WantedBy=multi-user.target

dockerd 调用containerd,dockerd启动后会监听containerd sock文件,进行通信

[root@localhost ~]# more /lib/systemd/system/docker.service

[Service]

Type=notify

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

systemctl start containerd

systemctl enable containerd

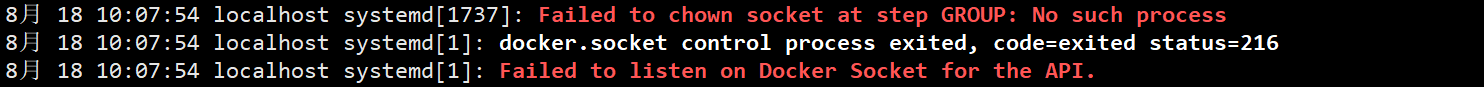

docker启动时如果报了如下错误:

vim /usr/lib/systemd/system/docker.socket

SocketGroup=root #将这里改为root

systemctl list-unit-files | grep docker

systemctl enable docker.service && systemctl enable docker.socket

systemctl daemon-reload

systemctl restart docker

docker框架结构

通过docker version命令发现docker采用客户端跟服务端架构,docker的守护进程运行在服务器上。

[root@localhost ~]# docker version

Client: Docker Engine - Community

Version: 20.10.1

API version: 1.41

Go version: go1.13.15

Git commit: 831ebea

Built: Tue Dec 15 04:37:17 2020

OS/Arch: linux/amd64

Context: default

Experimental: true

Server: Docker Engine - Community

Engine:

Version: 20.10.1

API version: 1.41 (minimum version 1.12)

Go version: go1.13.15

Git commit: f001486

Built: Tue Dec 15 04:35:42 2020

OS/Arch: linux/amd64

Experimental: false

containerd:

Version: 1.4.3

GitCommit: 269548fa27e0089a8b8278fc4fc781d7f65a939b

runc:

Version: 1.0.0-rc92

GitCommit: ff819c7e9184c13b7c2607fe6c30ae19403a7aff

docker-init:

Version: 0.19.0

GitCommit: de40ad0

[root@localhost ~]# docker run -itd --name busybox1 busybox

938056588e34ed79daf894d8f2e8538dc31364f5011627dd7f0d99a47bcf7a8e

[root@localhost ~]# docker run -itd --name busybox2 busybox

8efcfccfc5044b7658057754c44068e8cdde8ec887be4ff95a0050c3aee5a421

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

8efcfccfc504 busybox "sh" 7 seconds ago Up 6 seconds busybox2

938056588e34 busybox "sh" 13 seconds ago Up 12 seconds

[root@localhost ~]# ps -ef | grep containerd

root 4871 1 0 8月12 ? 00:01:36 /usr/bin/containerd

root 5208 1 0 8月12 ? 00:01:35 /usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

root 20401 1 0 18:40 ? 00:00:00 /usr/bin/containerd-shim-runc-v2 -namespace moby -id 938056588e34ed79daf894d8f2e8538dc31364f5011627dd7f0d99a47bcf7a8e -address /run/containerd/containerd.sock

root 20483 1 0 18:41 ? 00:00:00 /usr/bin/containerd-shim-runc-v2 -namespace moby -id 8efcfccfc5044b7658057754c44068e8cdde8ec887be4ff95a0050c3aee5a421 -address /run/containerd/containerd.sock

Docker 采用了 C/S 架构,包括客户端和服务端。Docker 守护进程 (Daemon)作为服务端接受来自客户端的请求,并处理这些请求(创建、运行、分发容器)。

客户端和服务端既可以运行在一个机器上,也可通过 socket 或者 RESTful API 来进行通信。

Docker 守护进程一般在宿主主机后台运行,等待接收来自客户端的消息。

Docker 客户端则为用户提供一系列可执行命令,用户用这些命令实现跟 Docker 守护进程交互。

docker namespace

多个容器运行在一个宿主机上会面临以下问题:

1、怎么样保证每个容器都有不同的文件系统并且能互不影响?

2、一个docker主进程内的各个容器都是其子进程,那么实现同一个主进程下不同类型的子进程?各个进程间通信能相互访问(内存数据)吗?

3、每个容器怎么解决IP及端口分配的问题?

4、多个容器的主机名能一样吗?

5、每个容器都要不要有root用户?怎么解决账户重名问题?

docker 本质就是宿主机的一个进程。

docker使用namespace来隔离不同容器的运行环境(用户、进程、文件系统、ip和端口)。namespace是Linux系统的底层概念,在内核层实现。不同类型的命名空间被部署在核内,各个docker容器运行在同一个docker主进程并且共用同一个宿主机系统内核,各docker容器运行在宿主机的用户空间,每个容器都有类似于虚拟机一样的相互隔离的运行空间,但是容器技术是在一个进程内实现运行指定服务的运行环境,并且还可以保护宿主机内核不受其他进程的干扰和影响。如文件系统空间、网络空间、进程空间等。

Namespace 是 Linux 内核用来隔离内核资源的方式。通过 namespace 可以让一些进程只能看到与自己相关的一部分资源,而另外一些进程也只能看到与它们自己相关的资源,这两拨进程根本就感觉不到对方的存在。具体的实现方式是把一个或多个进程的相关资源指定在同一个 namespace 中。

Linux namespaces 是对全局系统资源的一种封装隔离,使得处于不同 namespace 的进程拥有独立的全局系统资源,改变一个 namespace 中的系统资源只会影响当前 namespace 里的进程,对其他 namespace 中的进程没有影响。

Docker 底层的核心技术包括 Linux 上的命名空间(Namespaces)、控制组(Control groups)、Union 文件系统(Union file systems)和容器格式(Container format)。

我们知道,传统的虚拟机通过在宿主主机中运行 hypervisor 来模拟一整套完整的硬件环境提供给虚拟机的操作系统。虚拟机系统看到的环境是可限制的,也是彼此隔离的。 这种直接的做法实现了对资源最完整的封装,但很多时候往往意味着系统资源的浪费。 例如,以宿主机和虚拟机系统都为 Linux 系统为例,虚拟机中运行的应用其实可以利用宿主机系统中的运行环境。

我们知道,在操作系统中,包括内核、文件系统、网络、PID、UID、IPC、内存、硬盘、CPU 等等,所有的资源都是应用进程直接共享的。 要想实现虚拟化,除了要实现对内存、CPU、网络IO、硬盘IO、存储空间等的限制外,还要实现文件系统、网络、PID、UID、IPC等等的相互隔离。 前者相对容易实现一些,后者则需要宿主机系统的深入支持。

随着 Linux 系统对于命名空间功能的完善实现,程序员已经可以实现上面的所有需求,让某些进程在彼此隔离的命名空间中运行。大家虽然都共用一个内核和某些运行时环境(例如一些系统命令和系统库),但是彼此却看不到,都以为系统中只有自己的存在。这种机制就是容器(Container),利用命名空间来做权限的隔离控制,利用 cgroups 来做资源分配。

| 隔离类型 | 说明 |

|---|---|

| uts | 主机名和域名隔离 |

| ipc | 进程间通信的隔离(信号量、消息队列、共享内存) |

| pid | 进程隔离 |

| net | 网络隔离 |

| mnt | 磁盘挂载点和文件系统的隔离 |

| user | 用户和用户组隔离(3.8以后的内核才支持) |

/proc是一种伪文件系统(也即虚拟文件系统,它只存在内存当中,而不占用外存空间。它以文件系统的方式为访问系统内核数据的操作提供接口),存储的是当前内核运行状态的一系列特殊文件,用户可以通过这些文件查看有关系统硬件及当前正在运行进程的信息,甚至可以通过更改其中某些文件来改变内核的运行。

进程号为目录名

比如启动一个nginx进程,再启动一个apache进程,会发现80端口冲突,解决冲突最好的办法就是隔离。比如新冠最好的解决办法一样,就是隔离。linux中通过 数字编号 将不同的进程进行隔离,相同的编号代表在同一空间。

[root@localhost ~]# ss -lntp | grep http

LISTEN 0 128 [::]:80 [::]:* users:(("httpd",pid=28276,fd=4),("httpd",pid=28275,fd=4),("httpd",pid=28274,fd=4),("httpd",pid=28273,fd=4),("httpd",pid=28268,fd=4),("httpd",pid=28267,fd=4),("httpd",pid=27978,fd=4),("httpd",pid=27977,fd=4),("httpd",pid=27975,fd=4),("httpd",pid=27974,fd=4),("httpd",pid=27973,fd=4))

[root@localhost ~]# ll /proc/27974/ns #ns为namespace缩写

total 0

lrwxrwxrwx 1 root root 0 May 4 15:19 ipc -> ipc:[4026531839] #

lrwxrwxrwx 1 root root 0 May 4 15:19 mnt -> mnt:[4026532151]

lrwxrwxrwx 1 root root 0 May 4 15:19 net -> net:[4026531956]

lrwxrwxrwx 1 root root 0 May 4 15:19 pid -> pid:[4026531836]

lrwxrwxrwx 1 root root 0 May 4 15:19 user -> user:[4026531837]

lrwxrwxrwx 1 root root 0 May 4 15:19 uts -> uts:[4026531838]

[root@localhost ~]# ll /proc/2/ns #随机查看一个pid为2的命名空间

total 0

lrwxrwxrwx 1 root root 0 May 4 15:22 ipc -> ipc:[4026531839] #ipc相同

lrwxrwxrwx 1 root root 0 May 4 15:22 mnt -> mnt:[4026531840] #mnt不相同,代表没有冲突

lrwxrwxrwx 1 root root 0 May 4 15:22 net -> net:[4026531956] #net相同

lrwxrwxrwx 1 root root 0 May 4 15:22 pid -> pid:[4026531836] #pid相同

lrwxrwxrwx 1 root root 0 May 4 15:22 user -> user:[4026531837] #user相同

lrwxrwxrwx 1 root root 0 May 4 15:22 uts -> uts:[4026531838] #uts相同

命名空间后面对应的数字是相等的代表在同一个空间。可以发现ipc、net、pid、user、uts后面的数值是相等的,说明在同一命名空间下

一号进程一定是一个特殊权限的进程,负责开启所有的进程

[root@localhost ~]# ps -ef | head -2

UID PID PPID C STIME TTY TIME CMD

root 1 0 0 Apr17 ? 00:07:39 /usr/lib/systemd/systemd --switched-root --system --deserialize 22

IPC Namespace

进程间通信的隔离:一个容器内的进程间通信,允许一个容器内的不同进程的(内存、缓存等)数据访问,但是不能跨容器访问其他容器的数据。

root@36fc7a3fdb6d:/# ps -ef | grep nginx | grep -v grep #每个容器内都会有一个PID为1的主进程。

root 1 0 0 01:30 pts/0 00:00:00 nginx: master process nginx -g daemon off;

nginx 31 1 0 01:30 pts/0 00:00:00 nginx: worker process

MNT Namespace

mnt技术提供磁盘挂载点和文件系统的隔离能力

每个容器都要有独立的根文件系统有独立的用户空间,以实现在容器里面启动服务并且使用容器的运行环境。即一个宿主机是ubuntu的服务器,可以在里面启动一个centos运行环境的容器,并且在容器里面启动一个Nginx服务,此Nginx运行时使用的运行环境就是centos系统目录的运行环境,但是在容器里面是不能访问宿主机的资源,宿主机使用chroot技术把容器锁定到一个指定的运行目录里面,容器内产生的数据也会存在相应的目录。

[root@localhost ~]# docker pull nginx

[root@localhost ~]# docker pull tomcat

[root@localhost ~]# docker run -it -d --name nginx -p 80:80 nginx

[root@localhost ~]# docker exec -it nginx bash

root@36fc7a3fdb6d:/# cat /etc/issue #debian系统

Debian GNU/Linux 11 \n \l

root@36fc7a3fdb6d:/# apt update

root@36fc7a3fdb6d:/# apt install procps #安装 top 命令

root@36fc7a3fdb6d:/# apt install iputils-ping #安装 ping 命令

root@36fc7a3fdb6d:/# apt install net-tools #安装网络工具

docker run -it -d -p 8080:8080 nginx

docker exec -it 镜像id bash

cd webapps

mkdir test

echo 'hello docker tomcat' > index.html

ll /var/lib/docker/co /

各容器在宿主机对应的路径下

从新进入一个新的容器,发现并没有之前创建的文件,

UTS Namespace

包含了运行内核的名称、版本、底层体系结构类型等信息,用于系统标识,其中包含了hostname和域名domainname,它使得一个容器拥有属于自己hostname标识,这个主机名标识独立于宿主机系统和其上的其他容器。

root@36fc7a3fdb6d:/# cat /etc/hostname #查看容器内主机名

36fc7a3fdb6d

root@36fc7a3fdb6d:/# uname -a #容器里用的是宿主机的内核

Linux 36fc7a3fdb6d 3.10.0-1160.45.1.el7.x86_64 #1 SMP Wed Oct 13 17:20:51 UTC 2021 x86_64 GNU/Linux

[root@localhost ~]# uname -a #宿主机的内核

Linux localhost 3.10.0-1160.45.1.el7.x86_64 #1 SMP Wed Oct 13 17:20:51 UTC 2021 x86_64 x86_64 x86_64 GNU/Linux

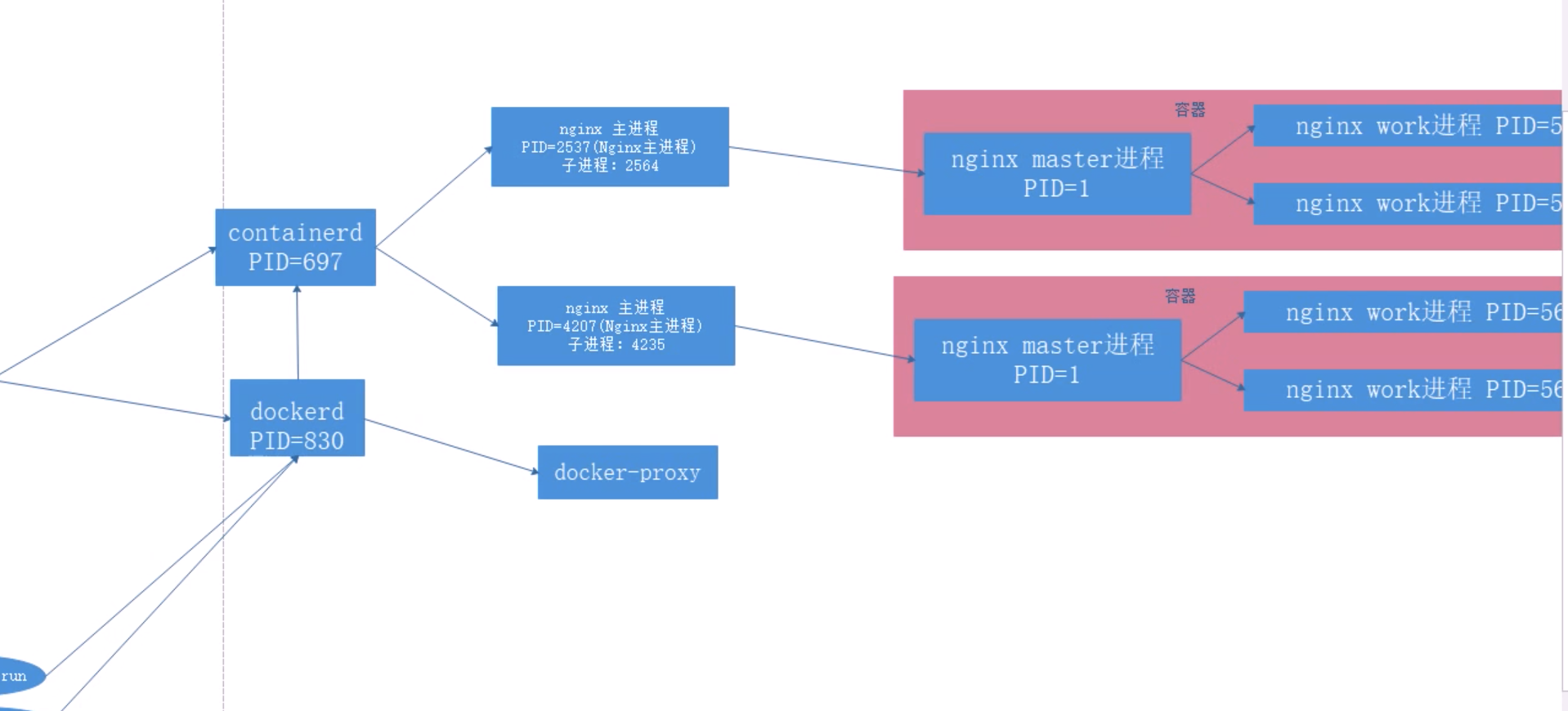

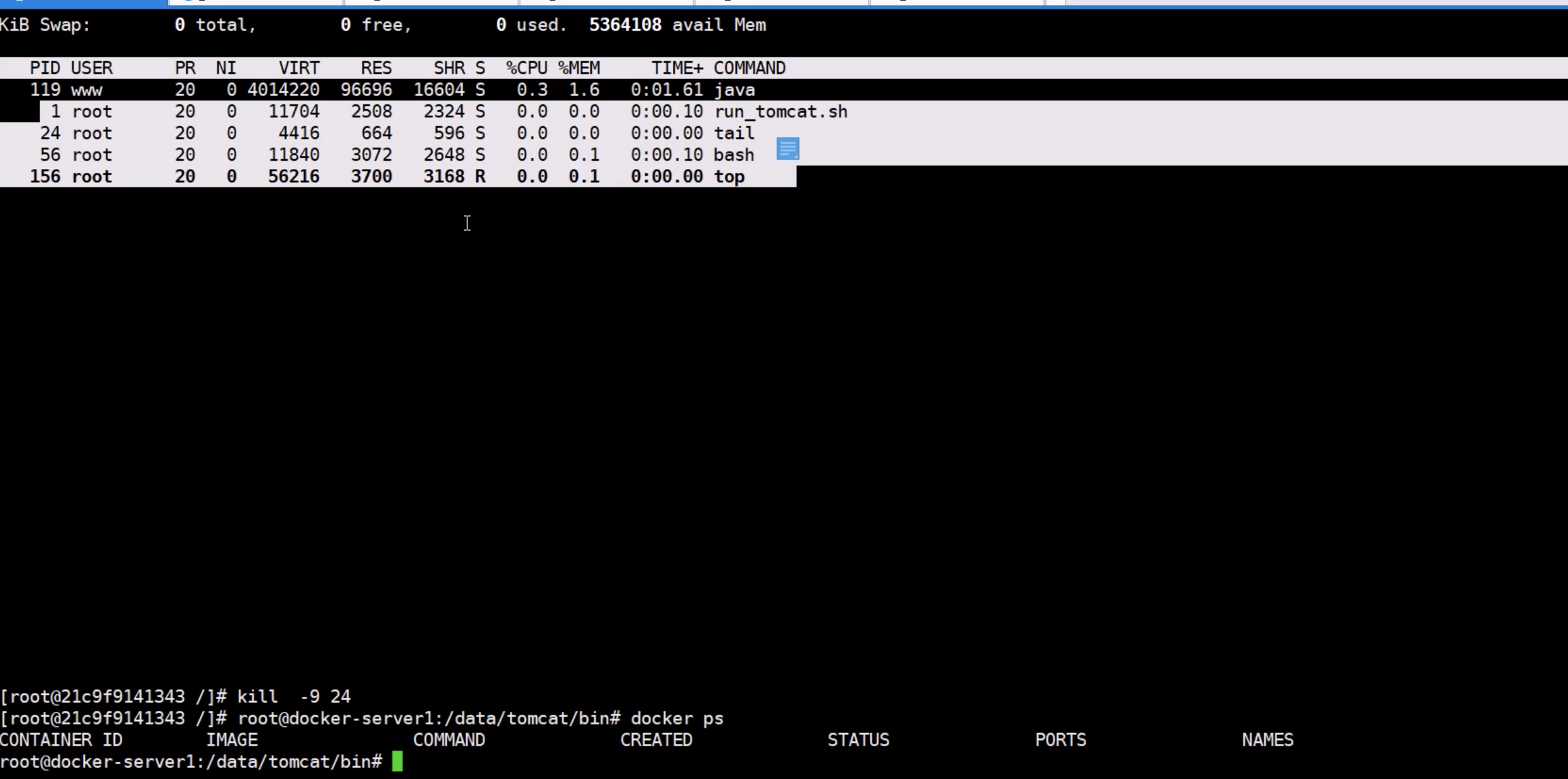

PID Namespace

Linux系统中有一个PID为1的进程(init/systemd)是其他所有进程的父进程,那么在每个容器内也要有一个父进程来管理其下属的子进程,那么多个容器的进程通PID namespace进程隔离(比如PID编号重复、容器内的主进程生成与回收子进程等)。

因为容器内没有内核所以也没有init或systemd,所以需要手动自定义一个进程,pid为1。在容器中第一个被拉起的进程并且是可以长期运行的进程,那么这个进程的pid就为1,作为容器的守护进程(类似于init或systemd)

root@36fc7a3fdb6d:/# ps -ef | grep nginx | grep -v grep #每个容器内都会有一个PID为1的主进程。

root 1 0 0 01:30 pts/0 00:00:00 nginx: master process nginx -g daemon off;

nginx 31 1 0 01:30 pts/0 00:00:00 nginx: worker process

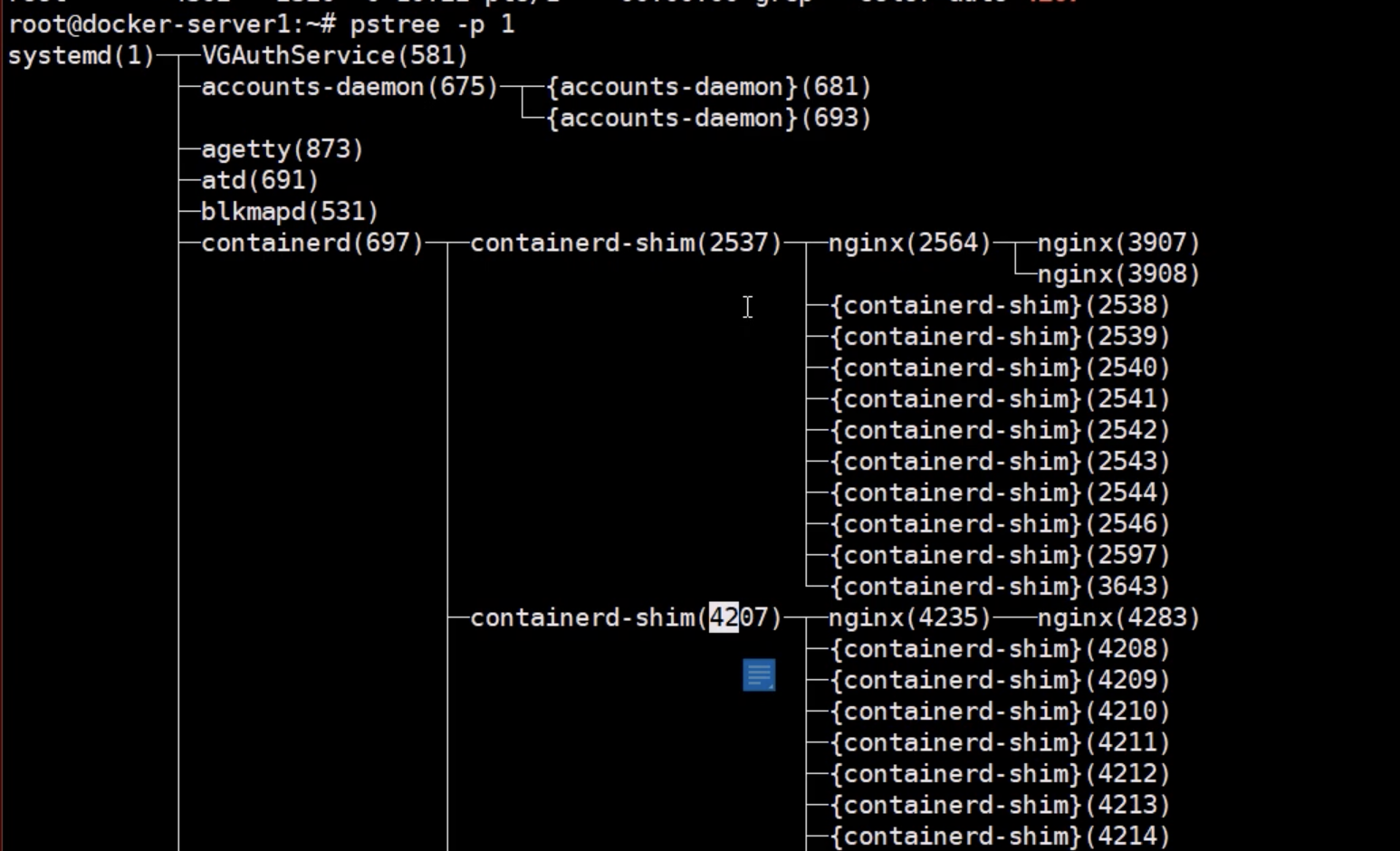

[root@localhost ~]# pstree -p 1

systemd(1)───containerd(9962)───containerd-shim(778)───nginx(797)───nginx(847)

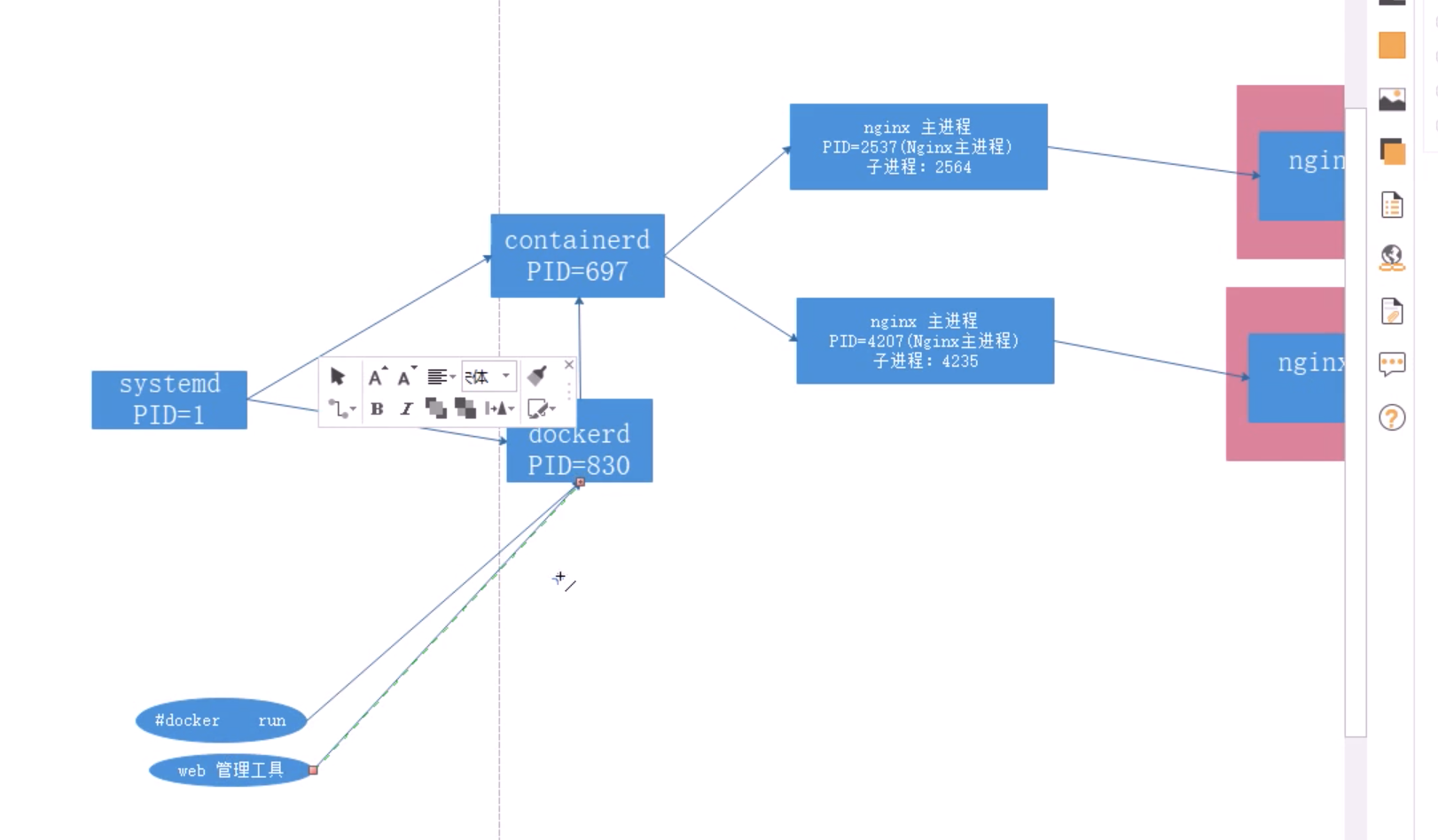

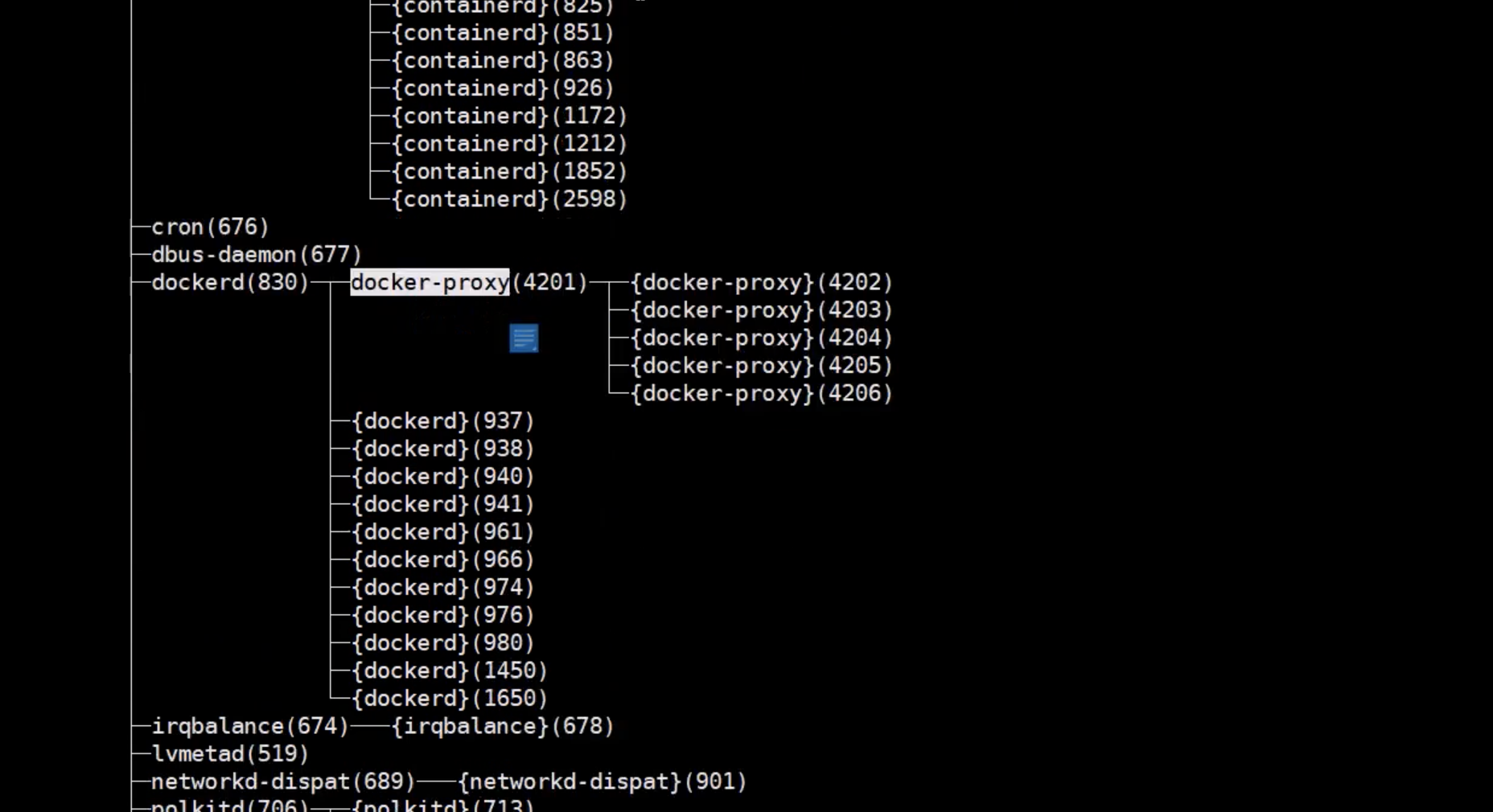

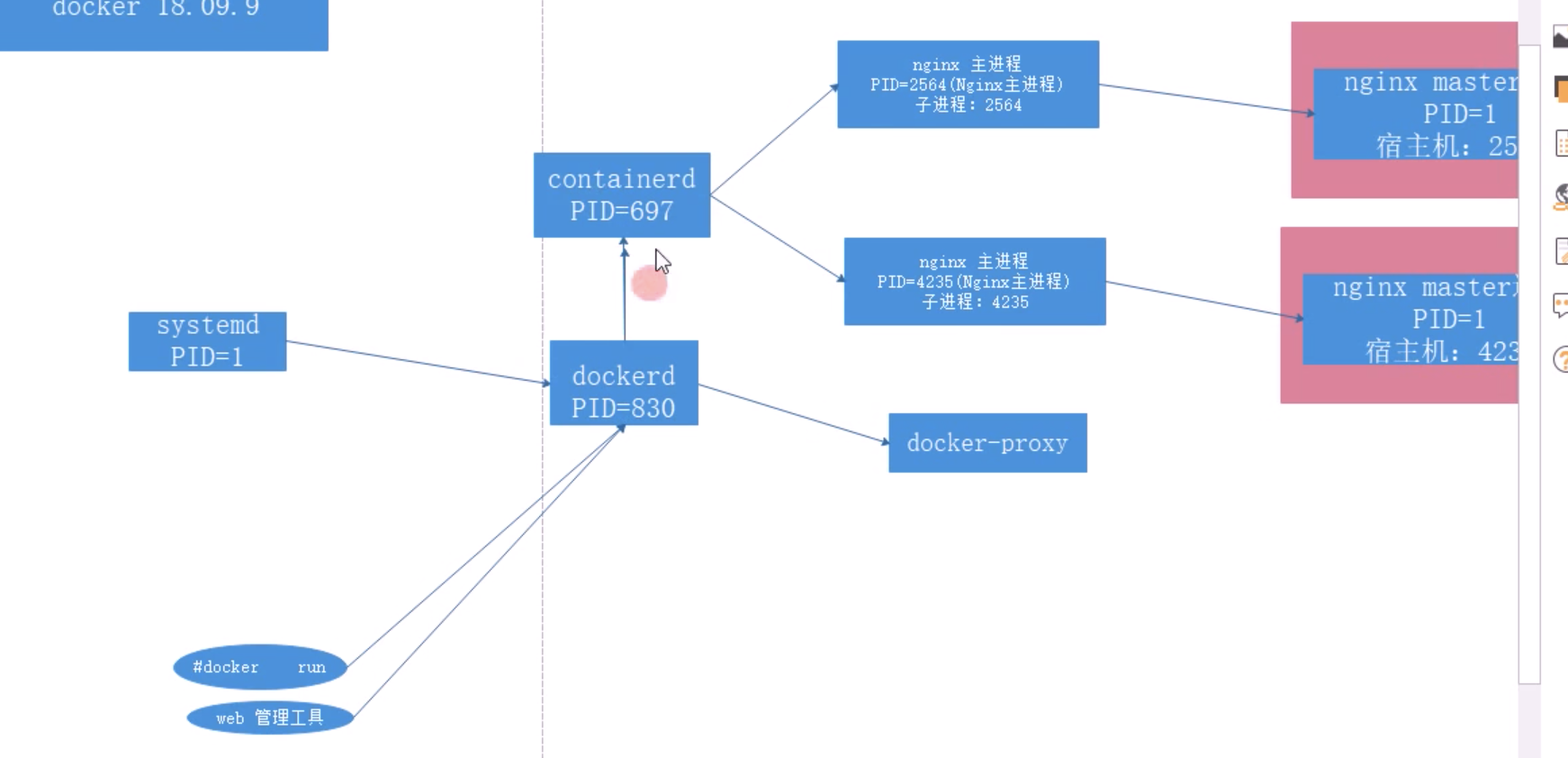

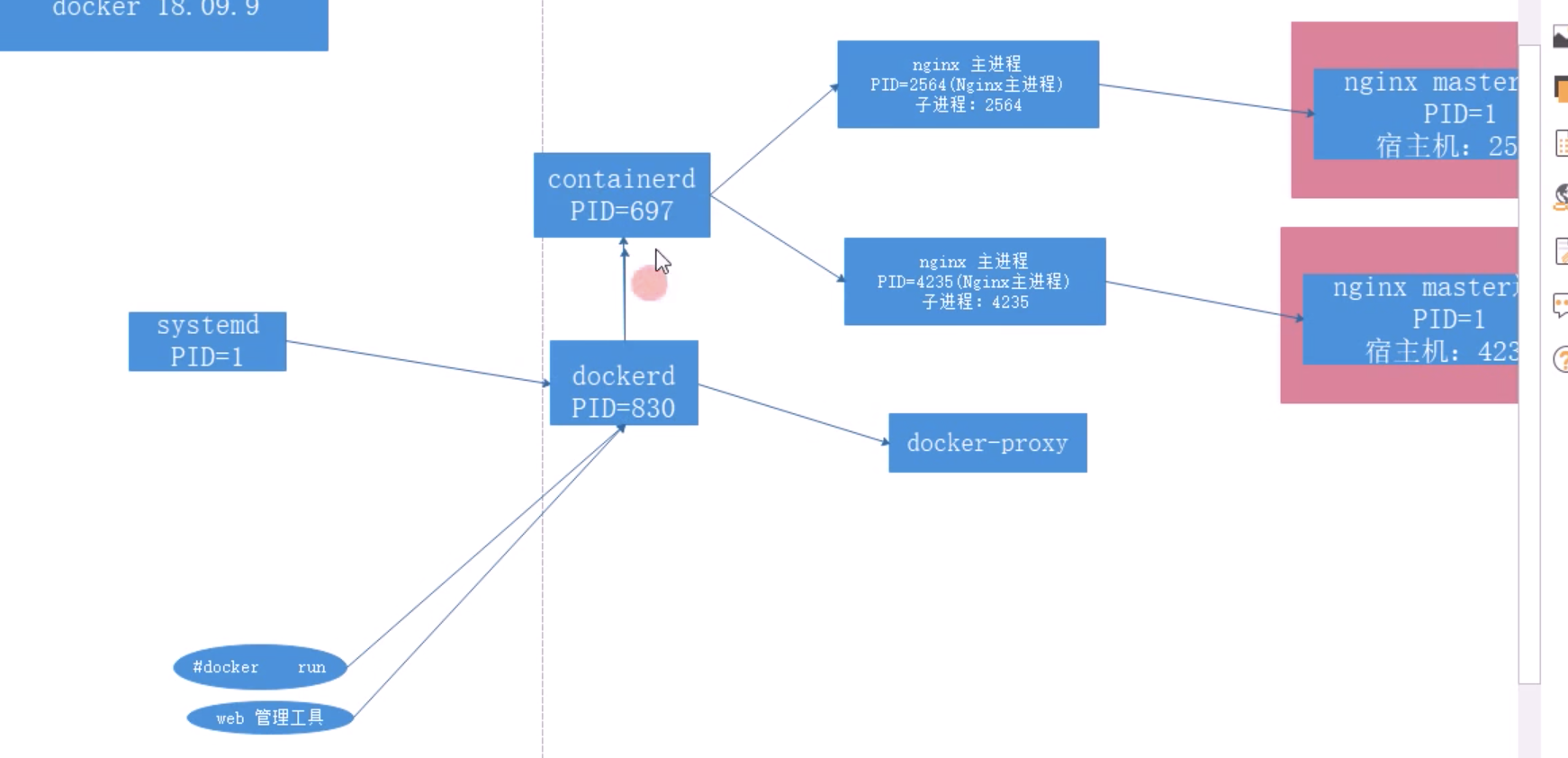

containerd进程

containerd用于启动多个容器

| dockerd | 被client直接访问,其父进程为宿主机的systemd守护进程 |

| docker-proxy | 实现容器通信,其父进程为dockerd |

| containerd | 被dockerd进程调用以实现与runc交互 |

| containerd-shim | 真正运行容器的载体,其父进程为containerd |

[root@localhost ~]# ps -ef |grep containerd

root 2156 1 0 Oct19 ? 00:00:12 /usr/bin/containerd

root 2168 1 0 Oct19 ? 00:00:31 /usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

root 8524 1 0 10:46 ? 00:00:00 /usr/bin/containerd-shim-runc-v2 -namespace moby -id 0ebf9461cd091e29081ead2a06a53c909519da77a839382b0d2625f2aa0e9a81 -address /run/containerd/containerd.sock

[root@localhost ~]# ps -ef | grep docker-proxy

root 8507 2168 0 10:46 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip 0.0.0.0 -host-port 8080 -container-ip 172.18.0.3 -container-port 80

root 8511 2168 0 10:46 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip :: -host-port 8080 -container-ip 172.18.0.3 -container-port 80

root 10743 32656 0 18:52 pts/0 00:00:00 grep --color=auto docker-proxy

root 21915 2168 0 08:34 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip 0.0.0.0 -host-port 80 -container-ip 172.18.0.2 -container-port 80

root 21919 2168 0 08:34 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip :: -host-port 80 -container-ip 172.18.0.2 -container-port 80

[root@localhost ~]# cat /lib/systemd/system/docker.service | grep ExecStart

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

通过docker命令调用 dockerd ,dockerd 通过这个 sock 文件调用 containerd 来创建容器。dockerd还会生成 docker-proxy,docker-proxy调用内核生成IPtables规则,当用户通过ip:port访问服务器会通过内核检查iptables规则进行转发

[root@localhost ~]# iptables -t nat -vnL #访问宿主机80会被iptables转发到容器的80

14 704 DNAT tcp -- !docker0 * 0.0.0.0/0 0.0.0.0/0 tcp dpt:80 to:172.18.0.4:80

[root@localhost ~]# pstree -p 1

systemd(1)──dockerd(9971)──docker-proxy(761)

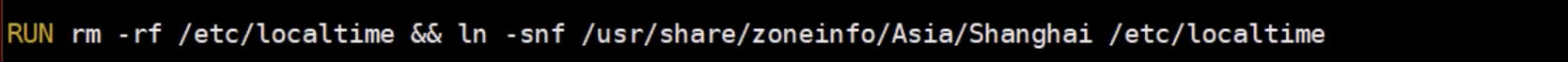

NET Namespace

每一个容器都类似于虚拟机一样有自己的网卡、监听端口、TCP/IP协议栈等,Docker使用network namespace启动一个vethX接口,这样你的容器将拥有它自己的桥接ip地址,通常是docker0,而docker0实质就是Linux的虚拟网桥,网桥是在OSI七层模型的数据链路层的网络设备,通过mac地址对网络进行划分,并且在不同网络直接传递数据。

iptables -t nat -vnl #通过iptables目标地址转换,

容器内执行apt install net-tools

curl ip

没启动以个容器,宿主机就会vethxxxx

USER Namespace

各个容器内可能会出现重名的用户名和用户组名,或重复的用户UID或者GID。User Namespace允许在各个宿主机的各个容器空间内创建相同的用户名以及相同的用户UID和GID。只是会把用户的作用范围限制在每个容器内,即A容器和B容器可以有相同的用户名称和ID的账户,但是此用户的有效范围仅是当前容器内,不能访问另外一个容器内的文件系统,即相互隔离、互补影响、永不相见。

运行两个不同的容器

[root@localhost ~]# docker run -itd --name busybox1 busybox

[root@localhost ~]# docker run -itd --name busybox2 busybox

[root@localhost ~]# docker exec -it busybox1 sh #进入 busybox1 容器

/ # id #每个容器内都有超级管理员root及其它系统账户,并且账户ID和其它容器相同

uid=0(root) gid=0(root) groups=10(wheel)

/ # echo 'hello docker' > hellodocker.txt

/ # cat hellodocker.txt

hello docker

/ # exit

[root@localhost ~]# docker exec -it busybox2 sh

/ # id #每个容器内都有超级管理员root及其它系统账户,并且账户ID和其它容器相同

uid=0(root) gid=0(root) groups=10(wheel)

/ # ls #在 busybox1 容器创建的文件在 busybox2 中无法看到

bin dev etc home proc root sys tmp usr var

/ # exit

[root@localhost ~]# find / -name hellodocker.txt #容器中的数据会保存到宿主机内

/var/lib/docker/overlay2/65ded0a1b6f3195a7aab473505f9edffc318e81712b8d503e3269c709faeb3b8/diff/hellodocker.txt

/var/lib/docker/overlay2/65ded0a1b6f3195a7aab473505f9edffc318e81712b8d503e3269c709faeb3b8/merged/hellodocker.txt

[root@localhost ~]# cat /var/lib/docker/overlay2/65ded0a1b6f3195a7aab473505f9edffc318e81712b8d503e3269c709faeb3b8/diff/hellodocker.txt

hello docker

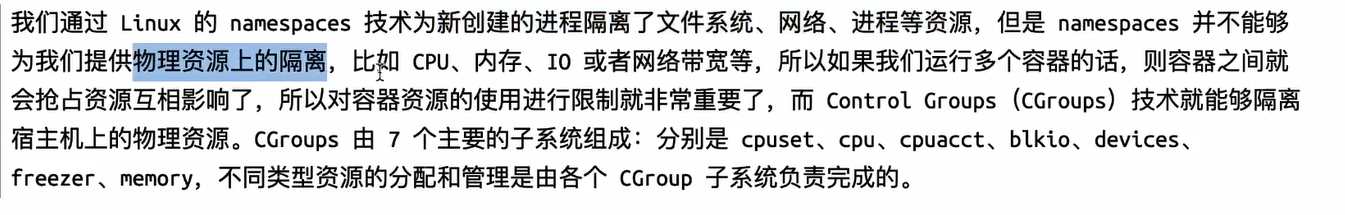

cgroup

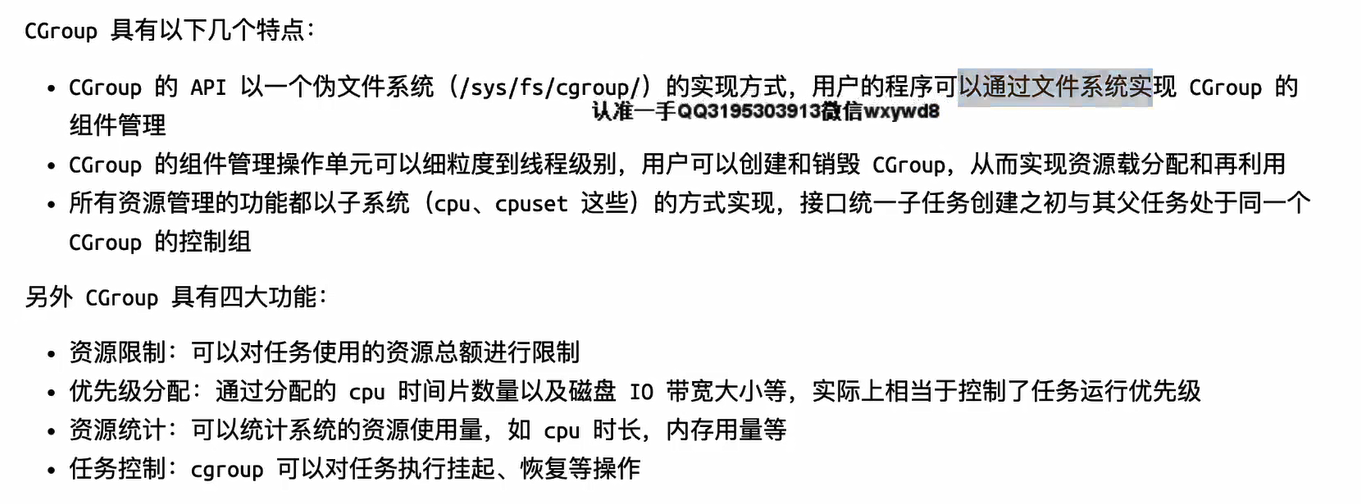

控制组(cgroups)是 Linux 内核的一个特性,主要用来对共享资源进行隔离、限制、审计等。只有能控制分配到容器的资源,才能避免当多个容器同时运行时的对系统资源的竞争。控制组可以提供对容器的内存、CPU、磁盘 IO 等资源的限制和审计管理。

Linux Cgroups的全称是Linux Control Groups,它最主要的作用就是限制一个进程组能够使用的资源上限,包括CPU、内存、磁盘、网络带宽等。此外还能够对进程进行优先级设置,以及将进程挂起和恢复等操作。如果容器不对其做任何资源限制,则宿主机会允许其占用无限大的内存空间,有时候程序会因为代码bug一直申请内存,直到把宿主机内存占完,为了避免此类的问题出现,宿主机有必要对容器进行资源分配限制,比如CPU、内存等。

验证系统 cgroups

Cgroups在内核层默认已经开启,从CentOS 和 Ubuntu 不同版本对比,显然内核较新的支持的功能更多。

#cgroup中内存模块,y代表开启

[root@localhost ~]# cat /boot/config-3.10.0-1160.11.1.el7.x86_64 | grep CGROUP

CONFIG_CGROUPS=y

# CONFIG_CGROUP_DEBUG is not set

CONFIG_CGROUP_FREEZER=y

CONFIG_CGROUP_PIDS=y

CONFIG_CGROUP_DEVICE=y

CONFIG_CGROUP_CPUACCT=y

CONFIG_CGROUP_HUGETLB=y

CONFIG_CGROUP_PERF=y

CONFIG_CGROUP_SCHED=y

CONFIG_BLK_CGROUP=y

# CONFIG_DEBUG_BLK_CGROUP is not set

CONFIG_NETFILTER_XT_MATCH_CGROUP=m

CONFIG_NET_CLS_CGROUP=y

CONFIG_NETPRIO_CGROUP=y

[root@localhost ~]# cat /boot/config-3.10.0-1160.11.1.el7.x86_64 | grep MEM | grep CG

CONFIG_MEMCG=y #限制内存

CONFIG_MEMCG_SWAP=y #限制交换分区

CONFIG_MEMCG_SWAP_ENABLED=y

CONFIG_MEMCG_KMEM=y

cgroups 具体实现

[root@localhost ~]# ll /sys/fs/cgroup/ #查看系统 cgroups

total 0

drwxr-xr-x 5 root root 0 Nov 18 07:52 blkio #块设备IO限制

lrwxrwxrwx 1 root root 11 Nov 18 07:52 cpu -> cpu,cpuacct #使用调度程序为 cgroup 任务提供 cpu 的访问

lrwxrwxrwx 1 root root 11 Nov 18 07:52 cpuacct -> cpu,cpuacct #产生 cgroup 任务的 cpu 资源报告

drwxr-xr-x 6 root root 0 Nov 18 07:52 cpu,cpuacct

drwxr-xr-x 3 root root 0 Nov 18 07:52 cpuset #如果是多核心的cpu,这个子系统会为 cgroup 任务分配单独的cpu和内存

drwxr-xr-x 5 root root 0 Nov 18 07:52 devices #允许或拒绝 cgroup 任务对设备的访问

drwxr-xr-x 3 root root 0 Nov 18 07:52 freezer #暂停和恢复cgroup任务

drwxr-xr-x 3 root root 0 Nov 18 07:52 hugetlb

drwxr-xr-x 6 root root 0 Nov 18 07:52 memory #设置每个 cgroup 的内存限制以及产生内存资源报告

lrwxrwxrwx 1 root root 16 Nov 18 07:52 net_cls -> net_cls,net_prio #标记每个网络包以供 cgroup 方便使用

drwxr-xr-x 3 root root 0 Nov 18 07:52 net_cls,net_prio

lrwxrwxrwx 1 root root 16 Nov 18 07:52 net_prio -> net_cls,net_prio

drwxr-xr-x 3 root root 0 Nov 18 07:52 perf_event #增加了对 cgroup 的监测跟踪的能力,可以监测属于某个特定的 cgroup 的所有线程以及运行在特定CPU上的线程

drwxr-xr-x 5 root root 0 Nov 18 07:52 pids

drwxr-xr-x 5 root root 0 Nov 18 07:52 systemd

容器规范

容器技术除了的docker之外,还有coreOS的rkt、阿里的pouch,为了保证容器生态的标准性和健康可持续发展,Linux基金会、Docker、微软、红帽、谷歌、IBM等公司在2015年6月共同成立了一个叫 open container (OCI)的组织,其目的就是制定开放标准的容器规范,目前OCI一共发布了两个规范:分别是 runtime spec 和 image format spec。不同的容器公司开发的容器只要兼容这两个规范,就可以保证容器的可移植性和相互可操作性。

runtime

runtime 是真正容器运行的地方,因此为了运行不同的容器runtime需要和操作系统内核紧密合作、相互支持,以便为容器提供相应的运行环境。

早期的kubernetes runtime架构,远没这么复杂,kubelet创建容器,直接调用docker daemon,docker daemon自己调用libcontainer就把容器运行起来。国际大厂们认为运行时标准不能被 Docker 一家公司控制,于是就串通搞了开放容器标准 OCI。忽悠Docker 把 libcontainer 封装了一下,变成 runC 捐献出来作为 OCI 的参考实现。

目前主流的三种runtime:

LXC:linux上早期的runtime,Docker早期就是采用lxc作为runtime

runc:目前Docker默认的runtime,runc遵守OCI规范,因此可以兼容LXC

rkt:是Coreos开发的容器runtime,也符合OCI规范,所以使用rktruntime也可以运行Docker容器

查看docker的 runtime

[root@localhost ~]# docker info

Runtimes: io.containerd.runc.v2 io.containerd.runtime.v1.linux runc

Default Runtime: runc

runtime主要定义了以下规范,并以json格式保存在/run/docker/runtime-runc/moby/容器ID/state.json,此文件会根据容器状态实时更新

管理工具连接runtime与用户,为用户提供图形或命令方式操作,然后管理工具将用户操作传递给runtime执行。

Runc的管理工具是docker engine,docker engine包含后台deamon和cli两部分,大家经常提到的Docker就是指的docker engine。

lxc是lxd的管理工具

rkt的管理工具是rkt cli

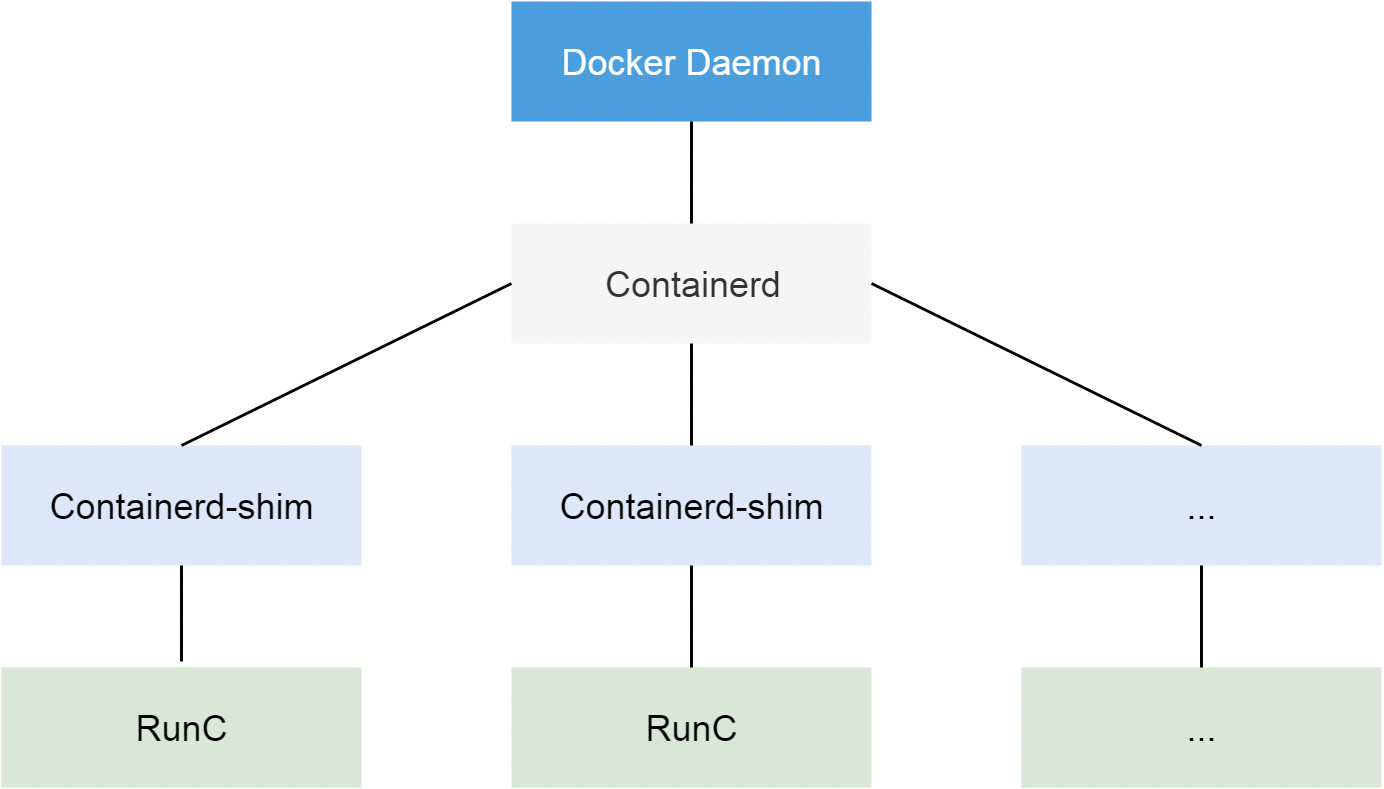

从 Docker 1.11 版本开始,Docker 容器运行就不是简单通过 Docker Daemon 来启动了,而是通过集成 containerd、runc 等多个组件来完成的。虽然 Docker Daemon 守护进程模块在不停的重构,但是基本功能和定位没有太大的变化,一直都是 CS 架构,守护进程负责和 Docker Client 端交互,并管理 Docker 镜像和容器。现在的架构中组件 containerd 就会负责集群节点上容器的生命周期管理,并向上为 Docker Daemon 提供 gRPC 接口。

当我们要创建一个容器的时候,现在 Docker Daemon 并不能直接帮我们创建了,而是请求 containerd 来创建一个容器,containerd 收到请求后,也并不会直接去操作容器,而是创建一个叫做 containerd-shim 的进程,让这个进程去操作容器,我们指定容器进程是需要一个父进程来做状态收集、维持 stdin 等 fd 打开等工作的,假如这个父进程就是 containerd,那如果 containerd 挂掉的话,整个宿主机上所有的容器都得退出了,而引入 containerd-shim 这个垫片就可以来规避这个问题了。

containerd进程

containerd用于启动多个容器

| dockerd | 被client直接访问,其父进程为宿主机的systemd守护进程 |

| docker-proxy | 实现容器通信,其父进程为dockerd |

| containerd | 被dockerd进程调用以实现与runc交互 |

| containerd-shim | 真正运行容器的载体,其父进程为containerd |

[root@localhost ~]# ps -ef |grep containerd

root 2156 1 0 Oct19 ? 00:00:12 /usr/bin/containerd

root 2168 1 0 Oct19 ? 00:00:31 /usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

root 8524 1 0 10:46 ? 00:00:00 /usr/bin/containerd-shim-runc-v2 -namespace moby -id 0ebf9461cd091e29081ead2a06a53c909519da77a839382b0d2625f2aa0e9a81 -address /run/containerd/containerd.sock

[root@localhost ~]# ps -ef | grep docker-proxy

root 8507 2168 0 10:46 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip 0.0.0.0 -host-port 8080 -container-ip 172.18.0.3 -container-port 80

root 8511 2168 0 10:46 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip :: -host-port 8080 -container-ip 172.18.0.3 -container-port 80

root 10743 32656 0 18:52 pts/0 00:00:00 grep --color=auto docker-proxy

root 21915 2168 0 08:34 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip 0.0.0.0 -host-port 80 -container-ip 172.18.0.2 -container-port 80

root 21919 2168 0 08:34 ? 00:00:00 /usr/bin/docker-proxy -proto tcp -host-ip :: -host-port 80 -container-ip 172.18.0.2 -container-port 80

[root@localhost ~]# cat /lib/systemd/system/docker.service | grep ExecStart

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

通过docker命令调用 dockerd ,dockerd 通过这个 sock 文件调用 containerd 来创建容器。dockerd还会生成 docker-proxy,docker-proxy调用内核生成IPtables规则,当用户通过ip:port访问服务器会通过内核检查iptables规则进行转发

| 版本信息 | 存放OCI标准的具体版本号 |

| 容器ID | 通常是一个哈希值,可以在所有 state.json 文件中提取出容器ID对容器进行批量操作(关闭、删除等),此文件在容器启动后会自动生成,容器关闭后会被删除 |

| PID | 在容器中运行的首个进程在宿主机上的进程号,即将宿主机的那个进程设置为容器的守护进程 |

| 容器文件目录 | 存放容器 rootfs 及相应配置的目录,外部程序只需读取 state.json 就可以定位到宿主机上的容器文件目录 |

| 容器创建 | 创建包括文件系统、namespaces、cgroups、用户权限在内的各项内容 |

| 容器启动 | 运行容器启动进程,该文件在/run/containerd/io.containerd.runtime.v1.linux/moby/容器ID/config.jsono |

| 容器生命周期 | 容器进程可以被外部程序关停,runtime规范定义了对容器操作信号的捕获,如果容器正常退出,docker会把当前容器当中的数据全部清理,并做相应资源回收的处理,避免避免出现垃圾资源、僵尸进程 |

containerd 从 Docker Engine 里分离出来,作为一个独立的开源项目,目标是提供一个更加开放、稳定的容器运行基础设施。

containerd 是一个工业级标准的容器运行时,它强调简单性、健壮性和可移植性,containerd 可以负责干下面这些事情:

管理容器的生命周期(从创建容器到销毁容器)

拉取/推送容器镜像

存储管理(管理镜像及容器数据的存储)

调用 runc 运行容器(与 runc 等容器运行时交互)

管理容器网络接口及网络

将容器运行时从 Docker 切换到 containerd

containerd 同样也提供一个对应的 CLI 工具:ctr,不过 ctr 的功能没有 docker 完善,但是关于镜像和容器的基本功能都是有的。直接输入 ctr 命令即可获得所有相关的操作命令使用方式

拉取镜像

拉取镜像可以使用 ctr image pull 来完成,比如拉取 Docker Hub 官方镜像 nginx:alpine,需要注意的是镜像地址需要加上 docker.io Host 地址:

[root@localhost ~]# ctr image pull docker.io/library/nginx:alpine

docker.io/library/nginx:alpine: resolved |++++++++++++++++++++++++++++++++++++++|

index-sha256:082f8c10bd47b6acc8ef15ae61ae45dd8fde0e9f389a8b5cb23c37408642bf5d: done |++++++++++++++++++++++++++++++++++++++|

manifest-sha256:2959a35e1b1e61e2419c01e0e457f75497e02d039360a658b66ff2d4caab19c4: done |++++++++++++++++++++++++++++++++++++++|

layer-sha256:b231d02e51502ce72ff0813057a12b7778148c2e629aa21fe30d1cb1d0d5671b: done |++++++++++++++++++++++++++++++++++++++|

config-sha256:804f9cebfdc58964d6b25527e53802a3527a9ee880e082dc5b19a3d5466c43b7: done |++++++++++++++++++++++++++++++++++++++|

layer-sha256:213ec9aee27d8be045c6a92b7eac22c9a64b44558193775a1a7f626352392b49: done |++++++++++++++++++++++++++++++++++++++|

layer-sha256:2546ae67167b3580b7dcc4a4d56e504594bac17e22e046b2d215fc2d021d6d7e: done |++++++++++++++++++++++++++++++++++++++|

layer-sha256:23b845224e138d383175fc5fb15d93ad0795468b8d6210edf3a50f23ded3ed8b: done |++++++++++++++++++++++++++++++++++++++|

layer-sha256:9bd5732789a330a86ed2257e6bf18928c6ae873107ef0a408f1ad65b42f6d14f: done |++++++++++++++++++++++++++++++++++++++|

layer-sha256:328309e59ded59f3fc9eb5ade5c0135ec9aae5553ab837ed763fc1510799bae8: done |++++++++++++++++++++++++++++++++++++++|

elapsed: 29.7s total: 9.8 Mi (336.2 KiB/s)

unpacking linux/amd64 sha256:082f8c10bd47b6acc8ef15ae61ae45dd8fde0e9f389a8b5cb23c37408642bf5d...

done: 448.216498ms

列出本地镜像

[root@localhost ~]# ctr image ls

REF TYPE DIGEST SIZE PLATFORMS LABELS

docker.io/library/nginx:alpine application/vnd.docker.distribution.manifest.list.v2+json sha256:082f8c10bd47b6acc8ef15ae61ae45dd8fde0e9f389a8b5cb23c37408642bf5d 9.8 MiB linux/386,linux/amd64,linux/arm/v6,linux/arm/v7,linux/arm64/v8,linux/ppc64le,linux/s390x -

[root@localhost ~]# ctr image ls -q #使用 -q(--quiet) 选项可以只打印镜像名称

docker.io/library/nginx:alpine

检测本地镜像

主要查看其中的 STATUS,complete 表示镜像是完整可用的状态。

[root@localhost ~]# ctr image check

REF TYPE DIGEST STATUS SIZE UNPACKED

docker.io/library/nginx:alpine application/vnd.docker.distribution.manifest.list.v2+json sha256:082f8c10bd47b6acc8ef15ae61ae45dd8fde0e9f389a8b5cb23c37408642bf5d complete (7/7) 9.7 MiB/9.7 MiB true

重新给指定的镜像打一个 Tag

[root@localhost ~]# ctr image tag docker.io/library/nginx:alpine harbor.io/test/nginx:alpine

harbor.io/test/nginx:alpine

[root@localhost ~]# ctr image ls -q

docker.io/library/nginx:alpine

harbor.io/test/nginx:alpine

删除镜像,加上 --sync 选项可以同步删除镜像和所有相关的资源。

[root@localhost ~]# ctr image rm harbor.io/test/nginx:alpine

harbor.io/test/nginx:alpine

[root@localhost ~]# ctr image ls -q

docker.io/library/nginx:alpine

容器操作

容器相关操作可以通过 ctr container 获取

创建容器

[root@localhost ~]# ctr container create docker.io/library/nginx:alpine nginx

查看容器

[root@localhost ~]# ctr container ls

CONTAINER IMAGE RUNTIME

nginx docker.io/library/nginx:alpine io.containerd.runc.v2

[root@localhost ~]# ctr container ls -q #-q 选项精简列表内容

nginx

查看容器详细配置

类似于 docker inspect 功能

[root@localhost ~]# ctr container info nginx

{

"ID": "nginx",

"Labels": {

"io.containerd.image.config.stop-signal": "SIGQUIT",

"maintainer": "NGINX Docker Maintainers \u003cdocker-maint@nginx.com\u003e"

},

"Image": "docker.io/library/nginx:alpine",

"Runtime": {

"Name": "io.containerd.runc.v2",

"Options": {

"type_url": "containerd.runc.v1.Options"

}

},

"SnapshotKey": "nginx",

"Snapshotter": "overlayfs",

......

删除容器

[root@localhost ~]# ctr container rm nginx #也可以使用 delete 或者 del 删除容器

[root@localhost ~]# ctr container ls

CONTAINER IMAGE RUNTIME

在这里插入代码片

在这里插入代码片

在这里插入代码片

在这里插入代码片

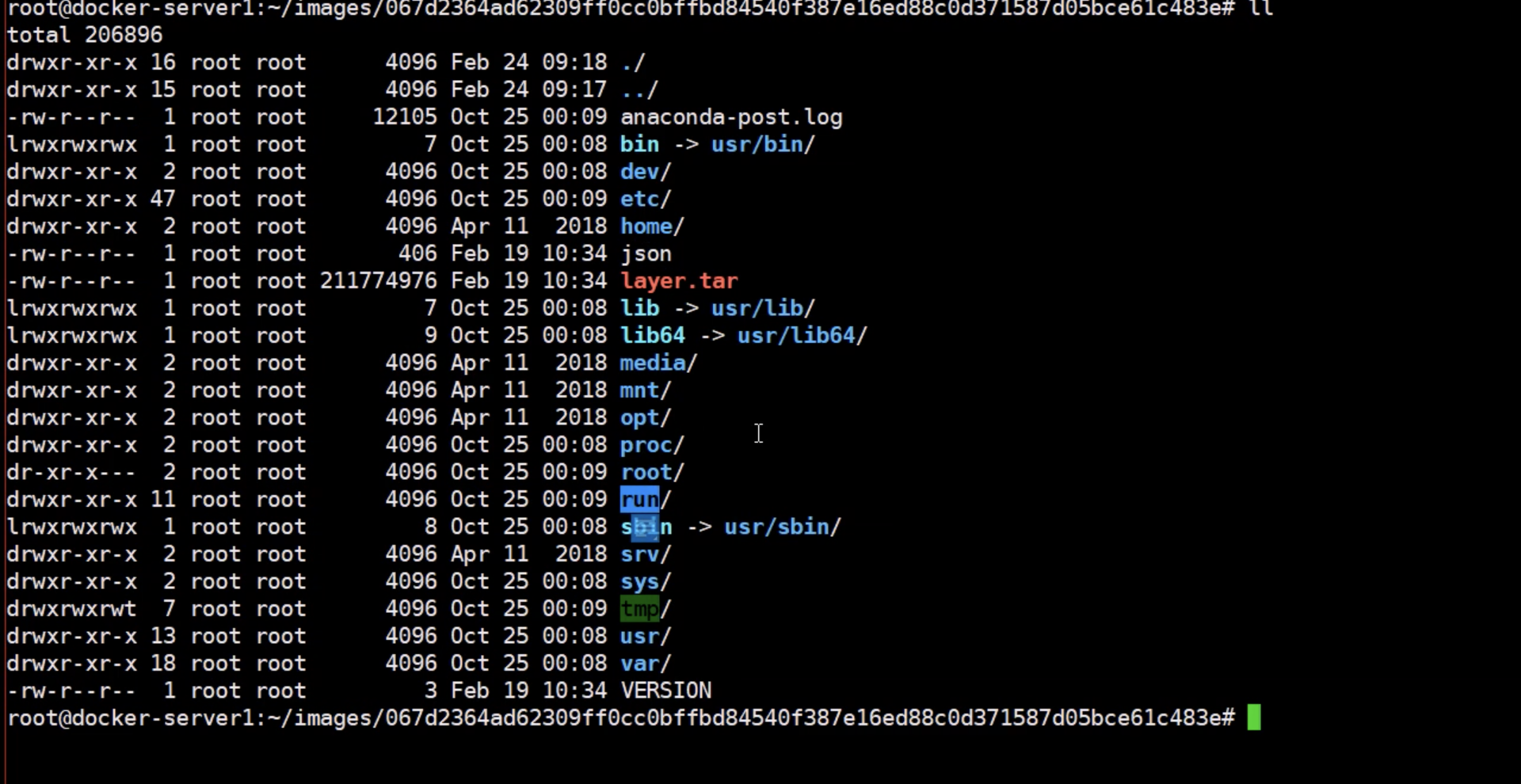

容器镜像

| 文件系统 | 定义以 layer 保存的文件系统,在镜像里面是 layer.tar,每个 layer 保存了和上层之间变化的部分,image format spec定义了 layer 应该保存哪些文件,增加、修改和删除的文件等操作 |

| manifest | 描述有哪些layer、tag标签及config文件名称 |

| config | 以hash命名的json文件,保存了镜像平台、容器运行时需要的一些信息,比如环境变量、工作目录、命令参数等 |

| index | 可选的文件,指向不同平台的 manifest 文件,这个文件能保证一个镜像可以跨平台使用。每个平台拥有不同的 manifest 文件使用 index 作为索引 |

| 父镜像 | 大多数层的元信息结构都包含一个 parent 字段,指向该镜像的父镜像 |

[root@localhost ~]# docker pull nginx

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

nginx latest ea335eea17ab 3 days ago 141MB

[root@localhost ~]# docker save ea335eea17ab > nginx/nginx_image.tgz

[root@localhost ~]# cd nginx/

[root@localhost nginx]# tar xf nginx_image.tgz

[root@localhost nginx]# ls #每一个目录代表每一层,记录着相应的内容。目录以镜像ID命名。

0b559ad9d88e1aaf50f87c77d49d18cebe6da93fe87d13b5c057545a272267d7

38f1bd2b083f130a6d717f1b1b523d2b124a19cb558104107b1854f1aeade840

5e4bc520016371648437e1831bf062a37a085c15f3207bfb7729af21f32a39b2

7725c8ca82f41dbcbeb31aba4a04e45996ad499f198ebced7ab853557ffc232a

8c2a29dfd83cc3420ecb475b76ce332185027edaa919ccf1069e67653b4ff760

a9592c42c1c981c6ddd9d474f64620044e281375a6e1b4ebb1d6713525fff610

ea335eea17ab984571cd4a3bcf90a0413773b559c75ef4cda07d0ce952b00291.json

manifest.json

容器的管理工具

[root@localhost ~]# ps -ef |grep docker

root 2168 1 0 Oct19 ? 00:00:25 /usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

容器定义工具允许用户定义容器的属性和内容,方便容器能够被保存、共享和重建。

| 定义工具 | 说明 |

|---|---|

| docker image | docker容器的模板,runtime根据docker image创建容器 |

| dockerfile | 多个命令的文本文件,通过dockerfile创建出docker image |

| registry | 镜像仓库,用于保存镜像 image registry:docker官方提供的私有仓库部署工具 docker hub:docker官方的公共仓库 harbor:vmware提供的自带web界面自带认证功能的镜像仓库 |

当多个容器在多个主机运行的时候,单独管理容器是相当复杂而且很容易出错,而且也无法实现某一台主机宕机后容器自动迁移到其他主机从而实现高可用的目的,也无法实现动态伸缩的功能,因此需要有一种工具可以实现统一管理、动态伸缩、故障自愈、批量执行等功能。这就是容器编排引擎。

容器编排通常包括容器管理、调度、集群定义和服务发现等功能。

Docker swarm: docker开发的容器编排引擎。

Kubernetes: google领导开发的容器编排引擎,内部项目为Borg,且其同时支持docker和CoreOS

Mesos + Marathon:通用的集群组员调度平台,mesos(资源分配)与marathon(容器编排平台)一起提供容器编排引擎功能。

| 容器网络 | docker自带的网络docker network仅支持管理单机上的容器网络,当多主机运行的时候需要使用第三方开源网络。例如calico、flannel等 |

| 服务发现 | 容器的动态扩容特性决定了容器IP也会随之变化,因此需要有一种机制可以自动识别并将用户请求动态转发到新创建的容器上,kubernetes自带服务发现功能,需要结合kube-dns服务解析内部域名 |

| 容器监控 | 可以通过原生命令docker ps/top/stats 查看容器运行状态,另外也可以使heapster/ Prometheus等第三方监控工具监控容器的运行状态 |

| 数据管理 | 容器的动态迁移会导致其在不同的Host之间迁移,因此如何保证与容器相关的数据也能随之迁移或随时访问,可以使用逻辑卷/存储挂载等方式解决 |

| 日志收集 | docker原生的日志查看工具docker logs,但是容器内部的日志需要通过ELK等专门的日志收集分析和展示工具进行处理 |

docker状态

镜像(image)

镜像是一个只读模板,封装好的运行环境,镜像运行之后变成容器,也就是把镜像加载得到容器,容器就是正在运行的运行环境。比如在docker仓库下载nginx镜像,然后运行nginx镜像,就得到nginx容器

镜像的分层:

| 存储驱动类型 | |

|---|---|

| UnionFS | |

| overlay | 一种UnionFS文件系统,Linux内核3.18后支持 |

| overlay2 | overlay的升级版,目前所有Linux发行版推荐使用的存储类型 |

Docker镜像加载原理:

一个典型的 Linux文件系统由 bootfs 和 rootfs 两部分组成

bootfs(boot file system):用于系统引导的文件系统,主要包含 bootloader 和 kernel,bootloader主要是引导加载 kernel,Linux刚启动时会加载 bootfs 文件系统,在Docker镜像的最底层是bootfs。这一层与我们典型的Linux/Unix系统是一样的,包含boot加载器和内核。当boot加载完成之后整个内核就都在内存中了,此时内存的使用权已由bootfs转交给内核,此时系统也会卸载bootfs。容器启动完成后会被卸载以节省内存资源

rootfs (root file system) :位于bootfs之上,为 Docker 容器的跟文件系统。包含的就是典型 Linux 系统中的 /dev, /proc, /bin, /etc 等标准目录和文件。rootfs就是各种不同的操作系统发行版,比如Ubuntu,Centos等等。

传统模式中,系统启动时,内核挂载 rootfs 时会首先将其挂载为“只读”模式,完整性自检完成后将其挂载为读写模式(先运行bootfs,目的是识别上层文件系统加载内核,然后引入rootfs,rootfs才会有系统内核的一些指令,有了指令才能对操作系统完成质检,质检完后才把它由只读改为读写,只读改为读写后操作系统才能正常工作)

Docker中,rootfs由内核挂载为“只读”模式(rootfs从头到尾都是只读模式),而后通过UFS技术挂载一个“可写”层进行写入操作

平时我们安装进虚拟机的CentOS都是好几个G,为什么docker这里才200M??

对于一个精简的OS,rootfs可以很小,只需要包括最基本的命令、工具和程序库就可以了,因为底层直接用Host的kernel,自己只需要提供 rootfs 就行了。由此可见对于不同的linux发行版, bootfs基本是一致的, rootfs会有差别, 因此不同的发行版可以公用bootfs。

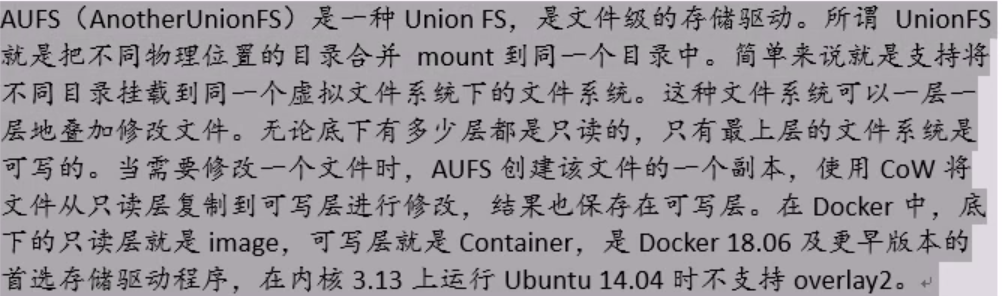

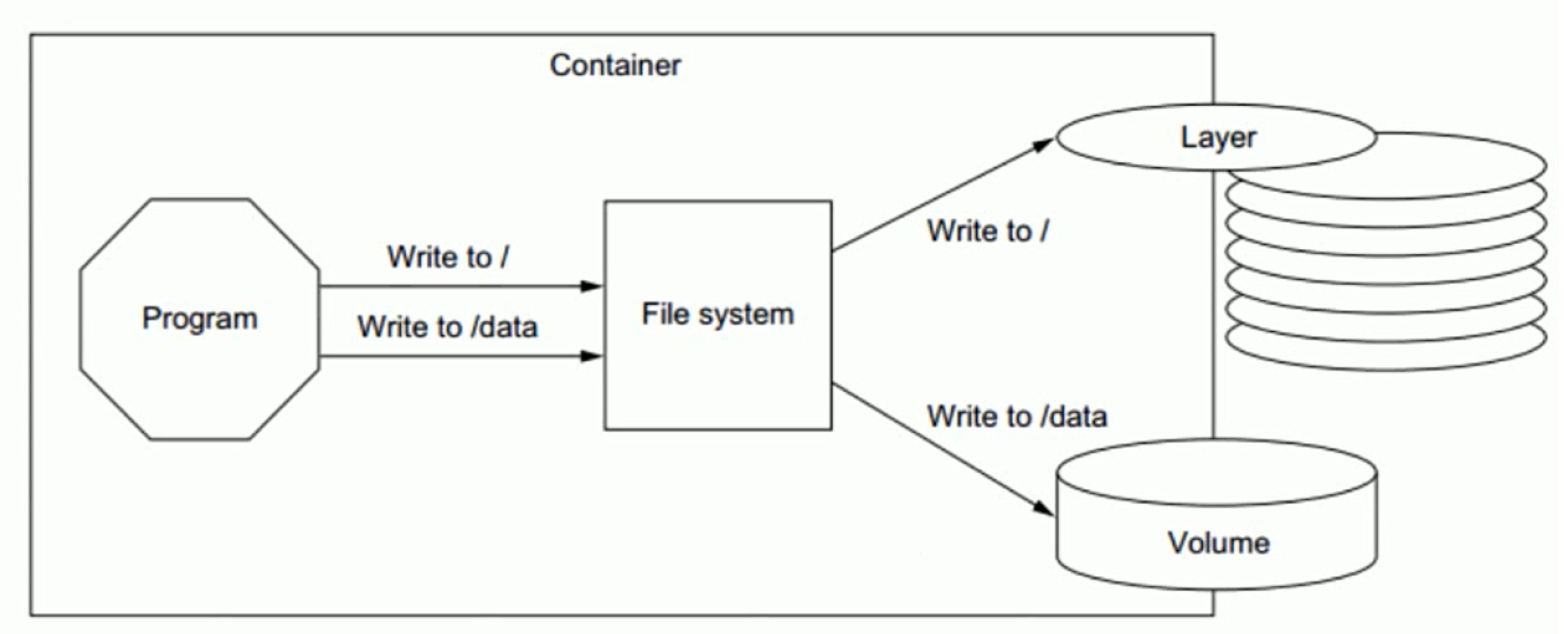

Docker的镜像实际上由一层一层的文件系统组成,通过联合文件系统 ( union filesystem )将各层文件系统叠加在一起,对外表现为一个整体。无论底下有多少层都是只读的,只有最上层(可写层)是文件系统是可写的。当修改一个文件时,AUFS创建该文件的一个副本,使用写时复制将文件从只读层复制到可写层进行修改,结果也保存在可写层。在Docker中底下的只读层就是镜像,可写层就是容器。Docker镜像含有启动容器所需要的文件系统及所需要的内容,因此镜像主要用于创建并启动docker容器。

UnionFS文件系统:一种分层、轻量级并且高性能的文件系统。联合文件系统可以将多个目录挂载到一起从而形成一整个虚拟文件系统,该虚拟文件系统的目录结构就像普通linux的目录结构一样,docker通过这些文件再加上宿主机的内核提供了一个linux的虚拟环境,每一层文件系统我们叫做一层layer,联合文件系统可以对每一层文件系统设置三种权限:只读(readonly)、读写(readwrite)和写出(whiteout-able)。但是docker镜像中每一层文件系统都是只读的,构建镜像的时候从一个最基本的操作系统开始,每个构建的操作都相当于做一层的修改,增加了一层文件系统,一层层往上叠加,上层的修改会覆盖底层该位置的可见性,这也很容易理解,就像上层把底层遮住了一样,当使用镜像的时候,我们只会看到一个完全的整体,不知道里面有几层也不需要知道里面有几层,结构如下:

Docker镜像是分层设计的,由多个只读层(通过联合文件系统)叠加而成,比如下图把三层拼接在一起就是一个完整的镜像。镜像运行后变为容器,启动容器时,Docker会加载只读镜像层并在镜像栈顶部添加一个读写层。用户写入的数据都保存在这一层中。

如果运行中的容器修改了现有的一个已经存在的文件,那么该文件将会从读写层下面的的只读层复制到读写层,然后对可写层文件进行修改,并且修改完的文件会把底层的文件给隐藏。该文件的只读版本仍然存在,只是已经被读写层中该文件的副本所隐藏,此即“写时复制”机制

如果将正在运行中的容器修改生成了新的数据,那么新产生的数据将会被复制到读写层,进行持久化保存,这个读写层也就是容器的工作目录,也为写时复制(COW) 机制。

比如一个文件在0层显示A,在1层显示D

在0层显示A,1层没有修改,2层显示D

写时复制机制可以节约空间,容器关闭重启数据不受影响。但是删除容器,其对应的可写层也会随之而删除,即数据丢失。如果容器需要持久保存数据,可以使用数据卷技术实现

如下图是将对根的数据写入到了容器的可写层,但是把/data 中的数据写入到了一个另外的volume 中用于数据持久化

容器分层

[root@localhost ~]# mkdir /data/a /data/b /data/system

mount -t aufs -o dirs=/data/a:/data/b none /data/system

写在虚拟文件系统的数据会写到真实的目录中去

把相同的目录挂载后,显示的是两个目录共同的结果。A目录挂载到了C上,B目录也挂载了C上,那么在C上可以看到A和B共同的内容

[root@localhost ~]# mount -t aufs -o dirs=/opt/bin/:/opt/sbin none /opt/system

一个典型的Linux文件系统由bootfs和rootfs两部分组成,bootfs(boot filesystem)主要包含bootloader和kernel,bootloader主要用于引导加载kernel,当kernel被加载到内存中后bootfs会被umount掉,rootfs (root file system)包含的就是典型Linux系统中的/dev、/proc、/bin、/etc等标准目录和文件。所以容器起来之后只有rootfs,没有内核。下图就是docker image中最基础的两层结构,不同的linux发行版(如ubuntu和CentOS)在Foots这一层会有所区别。

但是对于docker镜像通常都比较小,docker镜像直接调用宿主机的内核,镜像中只提供rootfs,也就是只包括最基本的命令、工具和程序库。比如alpine镜像在5M左右。

下图就是有两个不同的镜像在一个宿主机内核上实现不同的rootfs

[root@localhost ~]# docker pull alpine

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

alpine latest 14119a10abf4 7 weeks ago 5.6MB

比如5台服务器需要下载同一个镜像,镜像仓库就需要对5台不同的宿主机进行传输

一个容器运行起来之后会将底层的镜像通过aufs联合挂载成为一个虚拟文件系统供容器使用,

官方提供的基础镜像层

在基础镜像安装新的镜像,如图,Apache的父镜像为emacs,emacs的父镜像为Debian

每一行命令代表镜像的一层

FROM scratch

COPY hello/

CMD ["/hello"]

base 镜像:不依赖于其它镜像从scratch开始构建;能给其它镜像作为基础镜像,比如centos、ubuntu

查看镜像的层数

[root@localhost ~]# docker history centos:latest

IMAGE CREATED CREATED BY SIZE COMMENT

5d0da3dc9764 6 weeks ago /bin/sh -c #(nop) CMD ["/bin/bash"] 0B

<missing> 6 weeks ago /bin/sh -c #(nop) LABEL org.label-schema.sc… 0B

<missing> 6 weeks ago /bin/sh -c #(nop) ADD file:805cb5e15fb6e0bb0… 231MB

多个容器共享基础镜像,当某个容器修改了基础镜像中的/etc下的内容那么其它容器是不是也被修改了呢?因为容器在可写层修改,所用镜像层都是只读层,不会被容器修改,所以镜像可以被多个容器共享

数据只能往外读,数据修改后是不能写回去的,保证镜像内的数据是永远不变的,容器层的数据是可变的,

当启动一个容器的时候一个新的可写层(容器层)会被加载到镜像的顶部,容器层之下的都叫做镜像层,所以对容器的增删改查只会发生在容器层内,只有容器层是可写的,容器层下面所有的镜像层都是只读的,读取文件的时候容器会从上到下的各层当中去找这个文件,找到了就读出来。修改文件时是找到数据先读到容器层内,然后在修改数据,不会向镜像再次写入

冷数据放在镜像层,热数据放在容器层

镜像是只读的,启动为容器后,新增一个可写层。dockerfile每一条指令代表其中的一层

容器和镜像之间的主要区别就是容器在镜像顶部由一个可写层,在容器中的所有操作都会存储在这个容器层中,删除容器后,容器层也会被删除,但是镜像不会变化。正因为每个容器都有自己的可写容器层,所有更改都存储在自己的容器层中,所以多个容器之间可以共享同一基础镜像的访问,但仍然具有自己的数据状态。如下图演示了多个容器共享同一镜像的请情况:

镜像启动为容器,镜像层为只读的,新创建一个可写层。存放于宿主机上的一个目录

/var/lib/overlay2/随机id命名的目录/

镜像命令

查询本地镜像 docker images

docker images 可以查看下载至本地的镜像

docker images [选项]

| 选项 | 作用 |

|---|---|

| -a | 列出本地所有的镜像 |

| -q | 只显示镜像id |

| –digests | 显示备注信息 |

| –no-trunc | 显示完整的镜像信息 |

[root@locahost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

hello-world latest bf756fb1ae65 4 months ago 13.3kB

| 选项 | 说明 |

|---|---|

| REPOSITORY | 镜像名所属的仓库名称 |

| TAG | 镜像的标签(版本),默认latest |

| IMAGE ID | 镜像ID |

| CREATED | 镜像创建时间 ,有的镜像显示的是本地创建时间,有的显示的是官方构建时间 |

| SIZE | 镜像大小 |

[root@localhost ~]# docker images alpine #只查看指定REPOSITORY的镜像

REPOSITORY TAG IMAGE ID CREATED SIZE

alpine latest c059bfaa849c 6 months ago 5.59MB

[root@localhost ~]# docker images alpine --no-trunc #显示完整的镜像信息

REPOSITORY TAG IMAGE ID CREATED SIZE

alpine latest sha256:c059bfaa849c4d8e4aecaeb3a10c2d9b3d85f5165c66ad3a4d937758128c4d18 6 months ago 5.59MB

查看指定镜像的详细信息

[root@localhost ~]# docker image inspect alpine

[

{

"Id": "sha256:c059bfaa849c4d8e4aecaeb3a10c2d9b3d85f5165c66ad3a4d937758128c4d18",

"RepoTags": [

"alpine:latest"

],

"RepoDigests": [

"alpine@sha256:21a3deaa0d32a8057914f36584b5288d2e5ecc984380bc0118285c70fa8c9300"

],

"Parent": "",

"Comment": "",

"Created": "2021-11-24T20:19:40.483367546Z",

"Container": "4292e8ed2ef2b6dc4bbaf8e1cda0cb5f95b96adc4aa2da3d15181b54d07a0b34",

"ContainerConfig": {

"Hostname": "4292e8ed2ef2",

"Domainname": "",

"User": "",

"AttachStdin": false,

"AttachStdout": false,

"AttachStderr": false,

"Tty": false,

"OpenStdin": false,

"StdinOnce": false,

"Env": [

"PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin"

],

"Cmd": [

"/bin/sh",

"-c",

"#(nop) ",

"CMD [\"/bin/sh\"]"

],

"Image": "sha256:b747534ae29d08c0c84cc4326caf04e873c6d02bb67cd9c7644be2b4fa8d2f31",

"Volumes": null,

"WorkingDir": "",

"Entrypoint": null,

"OnBuild": null,

"Labels": {}

},

"DockerVersion": "20.10.7",

"Author": "",

"Config": {

"Hostname": "",

"Domainname": "",

"User": "",

"AttachStdin": false,

"AttachStdout": false,

"AttachStderr": false,

"Tty": false,

"OpenStdin": false,

"StdinOnce": false,

"Env": [

"PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin"

],

"Cmd": [

"/bin/sh"

],

"Image": "sha256:b747534ae29d08c0c84cc4326caf04e873c6d02bb67cd9c7644be2b4fa8d2f31",

"Volumes": null,

"WorkingDir": "",

"Entrypoint": null,

"OnBuild": null,

"Labels": null

},

"Architecture": "amd64",

"Os": "linux",

"Size": 5585772,

"VirtualSize": 5585772,

"GraphDriver": {

"Data": {

"MergedDir": "/var/lib/docker/overlay2/f2307eddcd15aac8b272b5119761cfb9e26d6dc0b71349dbcdd94d2cb6ec4898/merged",

"UpperDir": "/var/lib/docker/overlay2/f2307eddcd15aac8b272b5119761cfb9e26d6dc0b71349dbcdd94d2cb6ec4898/diff",

"WorkDir": "/var/lib/docker/overlay2/f2307eddcd15aac8b272b5119761cfb9e26d6dc0b71349dbcdd94d2cb6ec4898/work"

},

"Name": "overlay2"

},

"RootFS": {

"Type": "layers",

"Layers": [

"sha256:8d3ac3489996423f53d6087c81180006263b79f206d3fdec9e66f0e27ceb8759"

]

},

"Metadata": {

"LastTagTime": "0001-01-01T00:00:00Z"

}

}

]

如果仔细观察,会注意到,这里标识的所占用空间和在 Docker Hub 上看到的镜像大小不同。比如,ubuntu:18.04 镜像大小,在这里是 63.3MB,但是在 Docker Hub 显示的却是 25.47 MB。这是因为 Docker Hub 中显示的体积是压缩后的体积。在镜像下载和上传过程中镜像是保持着压缩状态的,因此 Docker Hub 所显示的大小是网络传输中更关心的流量大小。而 docker image ls 显示的是镜像下载到本地后,展开的大小,准确说,是展开后的各层所占空间的总和,因为镜像到本地后,查看空间的时候,更关心的是本地磁盘空间占用的大小。

另外一个需要注意的问题是,docker image ls 列表中的镜像体积总和并非是所有镜像实际硬盘消耗。由于 Docker 镜像是多层存储结构,并且可以继承、复用,因此不同镜像可能会因为使用相同的基础镜像,从而拥有共同的层。由于 Docker 使用 Union FS,相同的层只需要保存一份即可,因此实际镜像硬盘占用空间很可能要比这个列表镜像大小的总和要小的多。

你可以通过 docker system df 命令来便捷的查看镜像、容器、数据卷所占用的空间。

搜索镜像 docker search

从docker仓库中去查询镜像,会列出许多镜像,选择需要下载的。

注意:查询是从docker hup上查询,下载是从自己配的加速地址进行下载,比如配置的是阿里云,则会在阿里云上下载

docker search [选项] 镜像名

| 选项 | 作用 |

|---|---|

| -s 数值 | 会列出超过下载数大于该数值的镜像 |

| –no-trunc | 显示完整的镜像信息 |

[root@localhost ~]# docker search -s 30 tomcat #列出STARS列大于30的镜像

[root@localhost ~]# docker search mysql

NAME DESCRIPTION STARS OFFICIAL AUTOMATED

镜像名 镜像说明 收藏数 是否允许自动开启(run以后不需要采用一些别的命令就让他运行)

在官方的docker仓库中搜索指定名称的docker镜像:http://hub.docker.com

下载镜像 docker pull

从 docker 仓库将镜像下载到本地,命令格式如下:

docker pull 仓库服务器地址:端口/仓库名/镜像名镜像名字:标签

从docker仓库下载镜像文件,如果不写版本默认最新版latest。本机先检索本地目录有无镜像文件,如果本地没有将会去官方仓库下载,下载至本地。镜像下载保存的路径:/var/lib/docker/overlay2/镜像ID

注意:当本地镜像下载的为latest,如果镜像仓库对该镜像进行了版本升级,新的latest镜像是无法下载至本地的。

[root@localhost ~]# docker pull mysql

Using default tag: latest #如果不指定版本默认下载最新版

latest: Pulling from library/mysql

afb6ec6fdc1c: Pull complete #分层下载 docker镜像的核心

0bdc5971ba40: Pull complete

97ae94a2c729: Pull complete

f777521d340e: Pull complete

1393ff7fc871: Pull complete

a499b89994d9: Pull complete

7ebe8eefbafe: Pull complete

597069368ef1: Pull complete

ce39a5501878: Pull complete

7d545bca14bf: Pull complete

211e5bb2ae7b: Pull complete

5914e537c077: Pull complete

Digest: sha256:a31a277d8d39450220c722c1302a345c84206e7fd4cdb619e7face046e89031d #签名(防伪标志)

Status: Downloaded newer image for mysql:latest

docker.io/library/mysql:latest #真实地址,也就是执行 docker pull mysql 等价于 docker pull docker.io/library/mysql:latest

[root@localhost ~]# docker pull mysql:5.7 #指定mysql5.7版本

5.7: Pulling from library/mysql #library:官方镜像仓库名称hub.docker.com默认仓库省略不写

afb6ec6fdc1c: Already exists #已经存在,文件已存在就不会再下载,联合文件系统

0bdc5971ba40: Already exists

97ae94a2c729: Already exists

f777521d340e: Already exists

1393ff7fc871: Already exists

a499b89994d9: Already exists

7ebe8eefbafe: Already exists

4eec965ae405: Pull complete

a531a782d709: Pull complete

270aeddb45e3: Pull complete

b25569b61008: Pull complete

Digest: sha256:d16d9ef7a4ecb29efcd1ba46d5a82bda3c28bd18c0f1e3b86ba54816211e1ac4

Status: Downloaded newer image for mysql:5.7

docker.io/library/mysql:5.7

从下载过程中可以看到我们之前提及的分层存储的概念,镜像是由多层存储所构成。下载也是一层层的去下载,并非单一文件。下载过程中给出了每一层的 ID 的前 12 位。并且下载结束后,给出该镜像完整的 sha256 的摘要,以确保下载一致性。

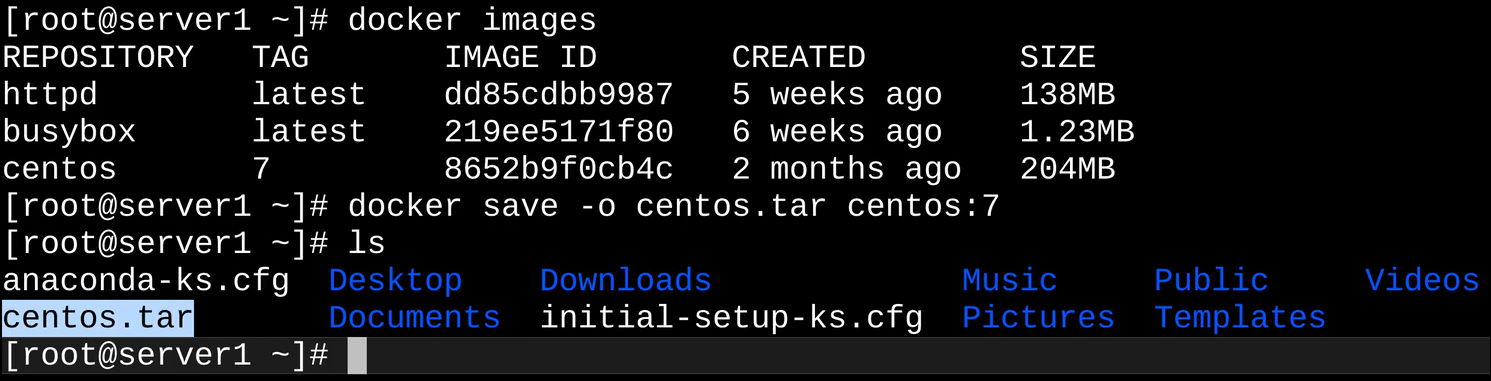

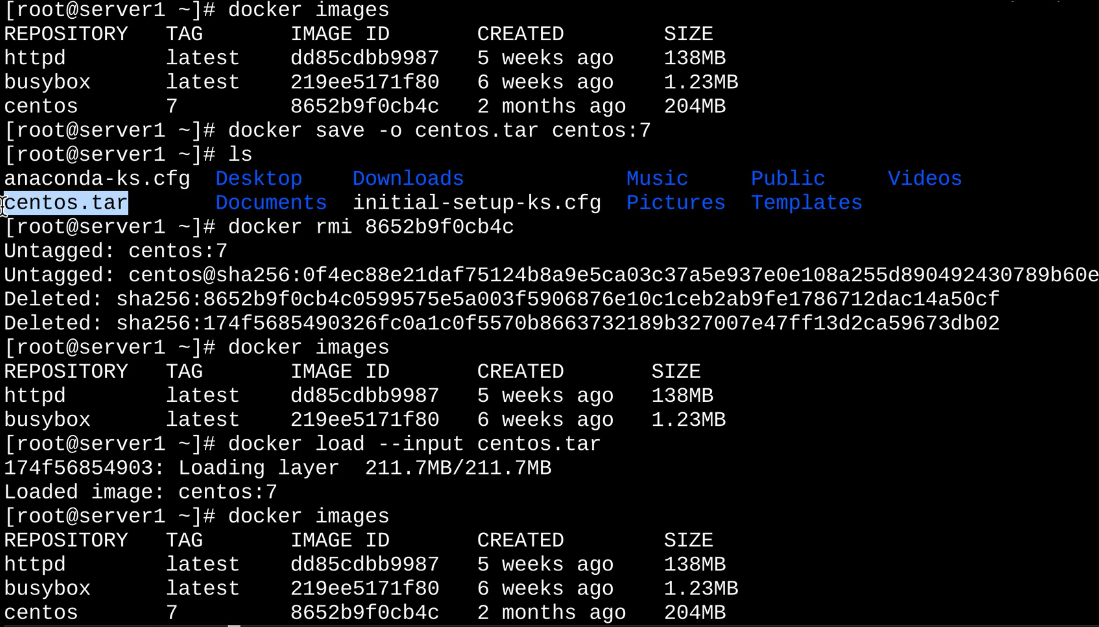

镜像导出 docker sava

利用docker save命令可以将从本地镜像导出为一个打包 tar文件,然后复制到其他服务器进行导入使用

#可以使用 -o 也可以使用 >

[root@localhost ~]# docker save 镜像名:TAG号 -o 保存的路径/压缩文件名

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

centos latest 5d0da3dc9764 4 weeks ago 231MB

[root@localhost ~]# docker save centos > /data/centos_image.tgz

[root@localhost ~]# ll /data/centos_image.tgz

-rw-r--r-- 1 root root 238581248 Oct 20 20:28 /data/centos_image.tgz

镜像导入 docker load

利用docker load命令可以将镜像导出的压缩文件再导入

#可以使用 -i 也可以使用 <

[root@localhost ~]# docker load -i 镜像包名

[root@localhost data]# ls

centos_image.tgz

[root@localhost data]# docker load -i centos_image.tgz

74ddd0ec08fa: Loading layer [==================================================>] 238.6MB/238.6MB

Loaded image: centos:latest

[root@localhost data]# docker images # 发现有了新的镜像

REPOSITORY TAG IMAGE ID CREATED SIZE

centos latest 5d0da3dc9764 5 weeks ago 231MB

删除镜像 docker rmi

docker rmi [选项] 镜像名[:版本] 版本不写默认latest

[root@locahost ~]# docker rmi -f 镜像文件 #不加版本默认为latest

[root@locahost ~]# docker rmi -f 镜像文件1 镜像文件2 … #删除多个镜像

[root@locahost ~]# docker rmi -f `docker images -q` #删除全部镜像

镜像是多层存储结构,因此在删除的时候也是从上层向基础层方向依次进行判断删除。镜像的多层结构让镜像复用变得非常容易,因此很有可能某个其它镜像正依赖于当前镜像的某一层。这种情况,依旧不会触发删除该层的行为。直到没有任何层依赖当前层时,才会真实的删除当前层。这也是为什么有的镜像删除时的层数和自己 docker pull 看到的层数不一样的原因。

容器(Container)

容器是一个镜像的可运行实例,镜像运行后得到的正在运行的运行环境

容器创建时需要指定镜像,每个镜像都由唯一的标示 Image ID ,和容器的 Container ID 一样,默认128位,可以使用前16为缩略形式,也可以使用镜像名与版本号两部分组合唯一标示,如果省略版本号,默认使用最新版本标签(latesr)

容器的本质是进程,但与直接在宿主机执行的进程不同,容器进程运行在属于自己的独立命名空间。因此容器可以拥有自己的文件系统、网络配置、进程空间、用户ID等。容器内的进程运行在隔离的环境中,使用起来就好像在一个独立的宿主系统一样。

容器的创建与管理

1、dockerd通过grpc和containerd模块通信(runc)交换,dockerd和containerd通信的socket文件:/run/containerd/containerd.sock

2、containerd在dockerd启动时被启动,然后containerd启动grpc请求监听,containerd处理grpc请求,根据请求做相应动作。/usr/bin/dockerd -H fd://–containerd/run/containerd/containerd.sock(文件配置路径/lib/systemd/system/docker.service)

3、若是创建容器,containerd拉起一个container-shim容器进程,并进行相应的创建操作。

4、container-shim被拉起后,start/exec/create拉起runc进程,通过exec、control文件和containerd通信,通过父子进程关系和SIGCHLD(信号)监控容器中进程状态。

5、在整个容器生命周期中,containerd通过epoll监控容器文件监控容器事件。

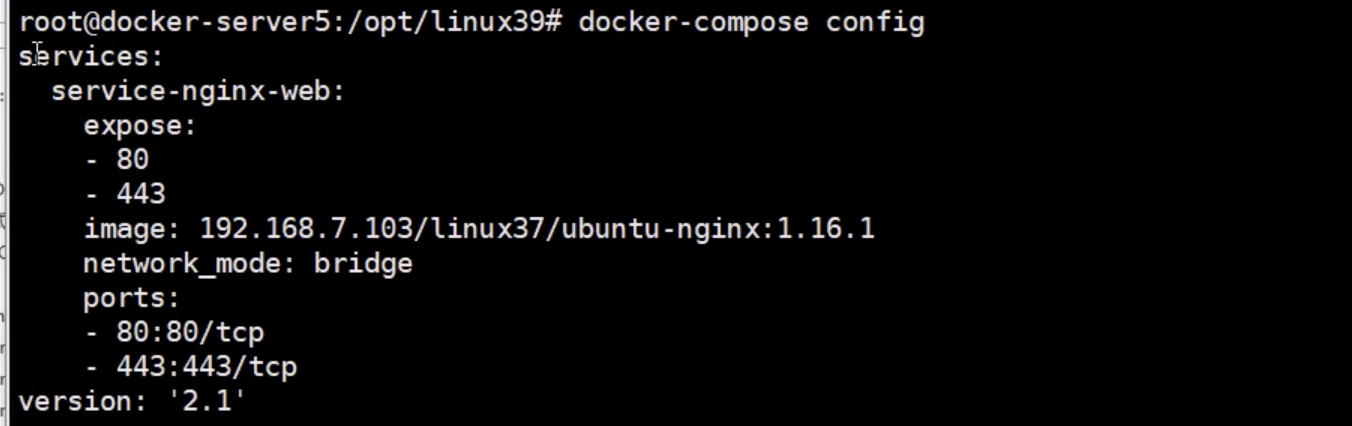

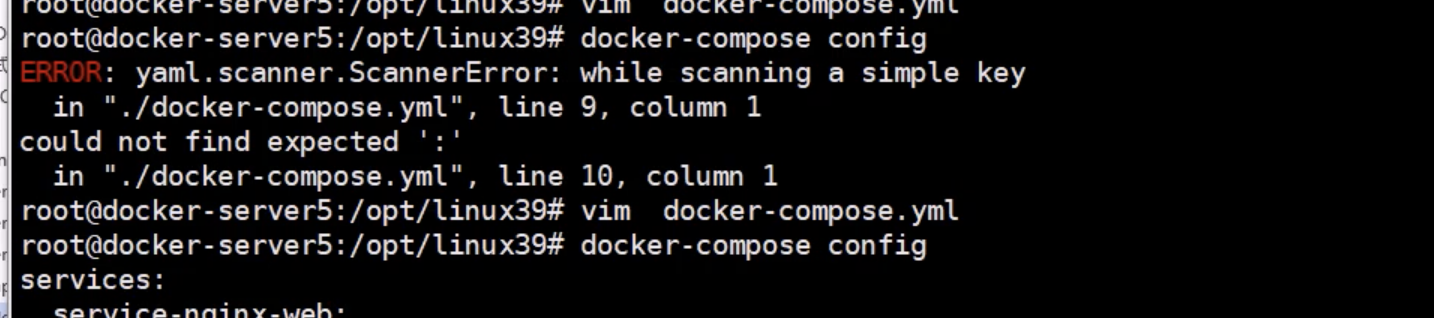

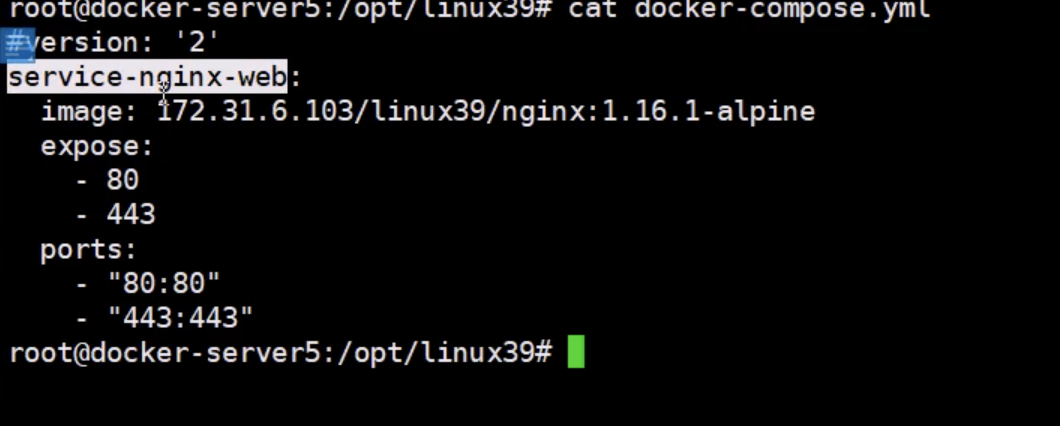

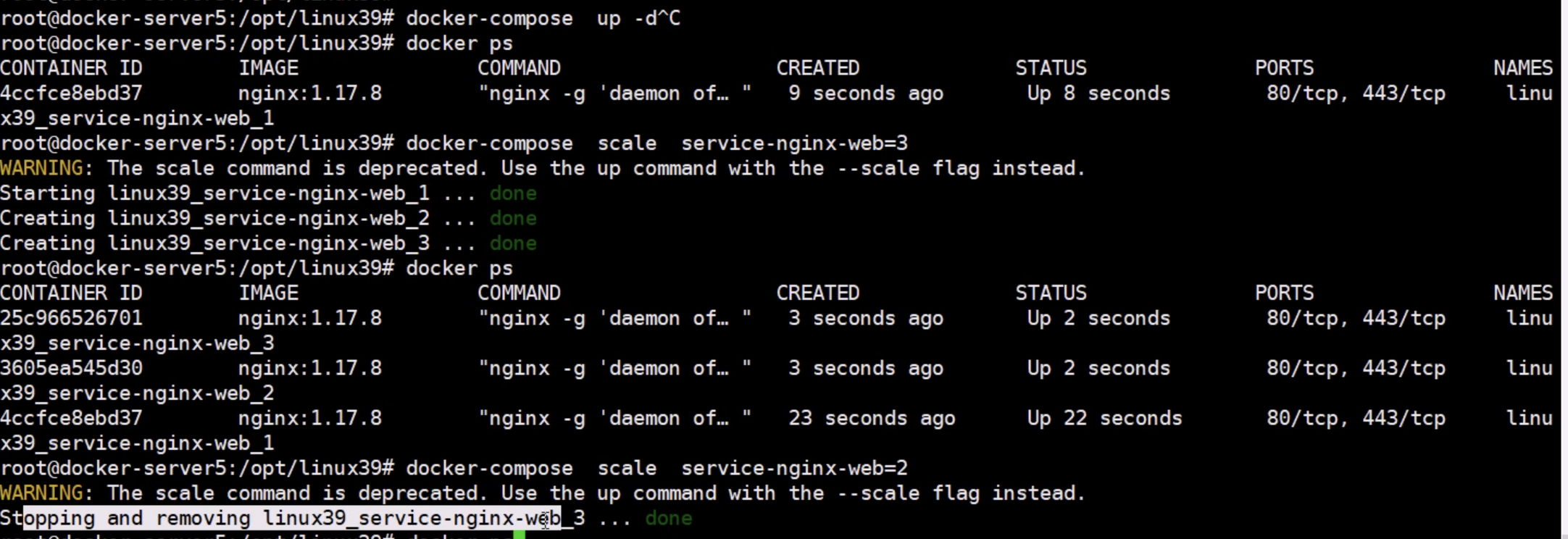

Docker compose

Docker compose:容器编排工具,允许用户在一个模板(YAML格式)中定义一组相关联的容器,会根据-link等参数对启动的优先级进行排序

Docker理念:一个容器一个进程,如果一个服务需要多个进程组成,就需要多个容器组成一个系统,互相分工和配合对外提供完整服务。在启动容器时,同一台主机下如果两个容器之间需要由数据交流,使用-link选项建立两个容器之间的互联,前提是建立是mariadb。

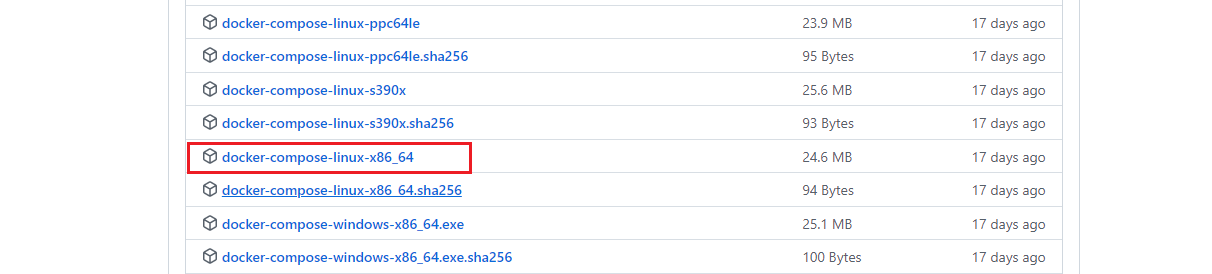

[root@locahost ~]# curl -L https://github.com/docker/compose/releases/download/1.14.0/docker-compose-`uname -s`-`uname -m` > /usr/local/bin/docker-compose

[root@locahost ~]# chmod a+x /usr/local/bin/docker-compose

[root@locahost ~]# docker-compose --version

Docker命令

docker save -o 名 镜像名:tag #将镜像保存至本地

docker load --input 本地镜像名 将本地镜像导入

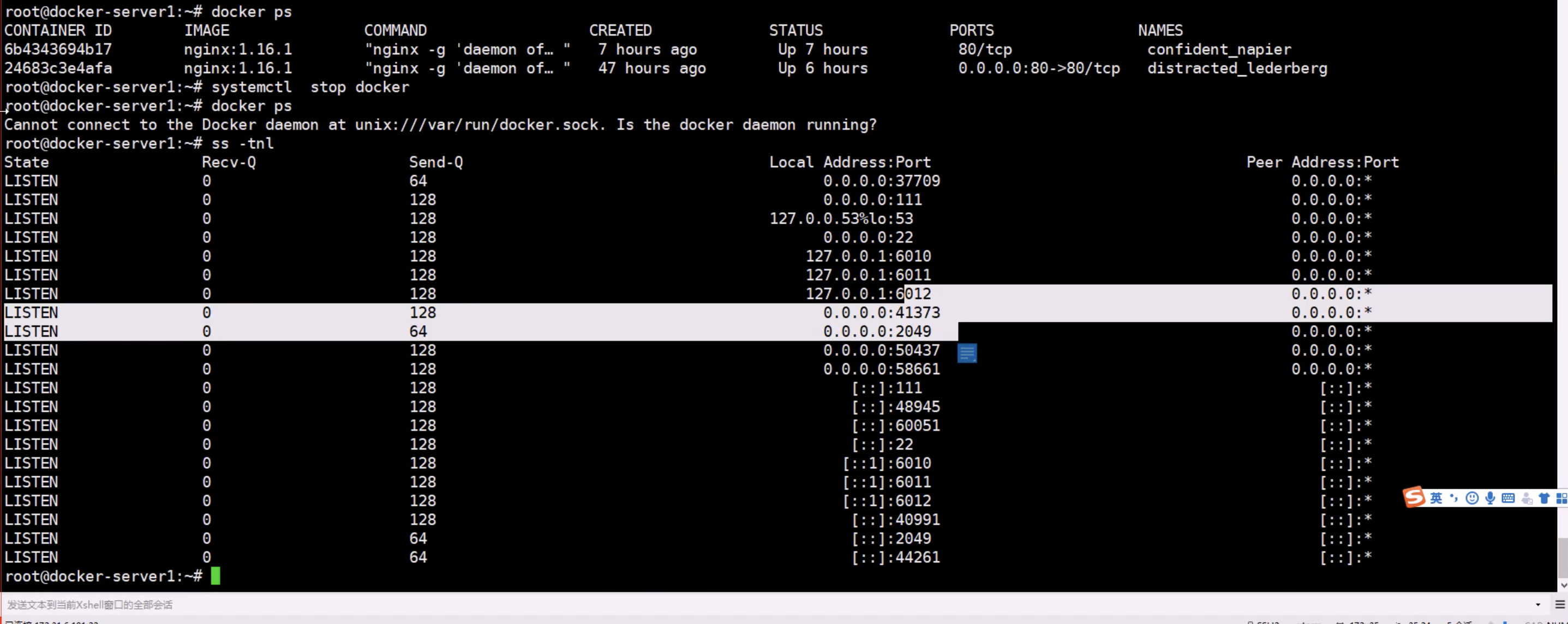

启动docker

[root@localhost ~]# systemctl start docker #启动docker

[root@localhost ~]# systemctl restart docker #重新启动

docker info

[root@localhost ~]# docker info

Containers: 1 #当前主机运行的容器总数

Running: 1 #正在运行的容器数量

Paused: 0 #暂停运行容器的数量

Stopped: 0 #停止运行容器的数量

Images: 2 #当前服务器的镜像数量

Server Version: 1.13.1 #docker服务端版本

Storage Driver: overlay2 #使用的存储引擎/驱动

Backing Filesystem: extfs #后端文件系统,即服务器的磁盘文件系统

Supports d_type: true #是否支持d_type

Native Overlay Diff: true #是否支持差异数据存储

Logging Driver: journald #日志类型

Cgroup Driver: systemd #Cgroups类型

Plugins: #插件

Volume: local #卷

Network: bridge host macvlan null overlay #overlay跨主机通信

Swarm: inactive #是否支持swarm

Runtimes: docker-runc runc #已安装的容器运行时

Default Runtime: docker-runc #默认使用的容器运行时

Init Binary: /usr/libexec/docker/docker-init-current #初始化容器的守护进程,即pid为1的进程

containerd version: (expected: aa8187dbd3b7ad67d8e5e3a15115d3eef43a7ed1) #版本

runc version: 66aedde759f33c190954815fb765eedc1d782dd9 (expected: 9df8b306d01f59d3a8029be411de015b7304dd8f) #版本

init version: fec3683b971d9c3ef73f284f176672c44b448662 (expected: 949e6facb77383876aeff8a6944dde66b3089574) #版本

Security Options: #安全选项 https://docs.docker.com/engine/security/apparmor

apparmor #安全模块 https://docs.docker.com/engine/security/seccomp

seccomp #审计(操作)

WARNING: You're not using the default seccomp profile

Profile: /etc/docker/seccomp.json #默认的配置文件

Kernel Version: 3.10.0-1160.25.1.el7.x86_64 #宿主机的内核版本

Operating System: CentOS Linux 7 (Core) #宿主机操作系统

OSType: linux #宿主机操作系统类型

Architecture: x86_64 #宿主机架构

Number of Docker Hooks: 3 #

CPUs: 2 #宿主机CPU数量

Total Memory: 3.733 GiB #宿主机总内存

Name: localhost #宿主机名

ID: GM2U:CTQB:3BX5:PK22:RPN4:B5AC:RAFX:2RKC:2HAA:K6AF:ZSRX:WI6Z #宿主机ID

Docker Root Dir: /var/lib/docker #宿主机数据保存目录

Debug Mode (client): false #client端是否开启debug

Debug Mode (server): false #server端是否开启debug

Registry: https://index.docker.io/v1/ #镜像仓库

Experimental: false #是否测试版

Insecure Registries: #非安全的镜像仓库

127.0.0.0/8

Live Restore Enabled: false #是否开启活动重启(重启docker-daemon不关闭容器)

Registries: docker.io (secure)

默认是false 发现容器也停止了

容器命令

容器启动/停止

| 启动容器 | docker start 容器id或容器名 |

| 重启容器 | docker restart 容器id或容器名 |

| 停止容器 | docker stop 容器id或容器名 |

| 强制停止容器 | docker kill 容器id或容器名 |

| 挂起容器 | docker pause 容器id或容器名 |

| 解除挂起容器 | docker unpause 容器id或容器名 |

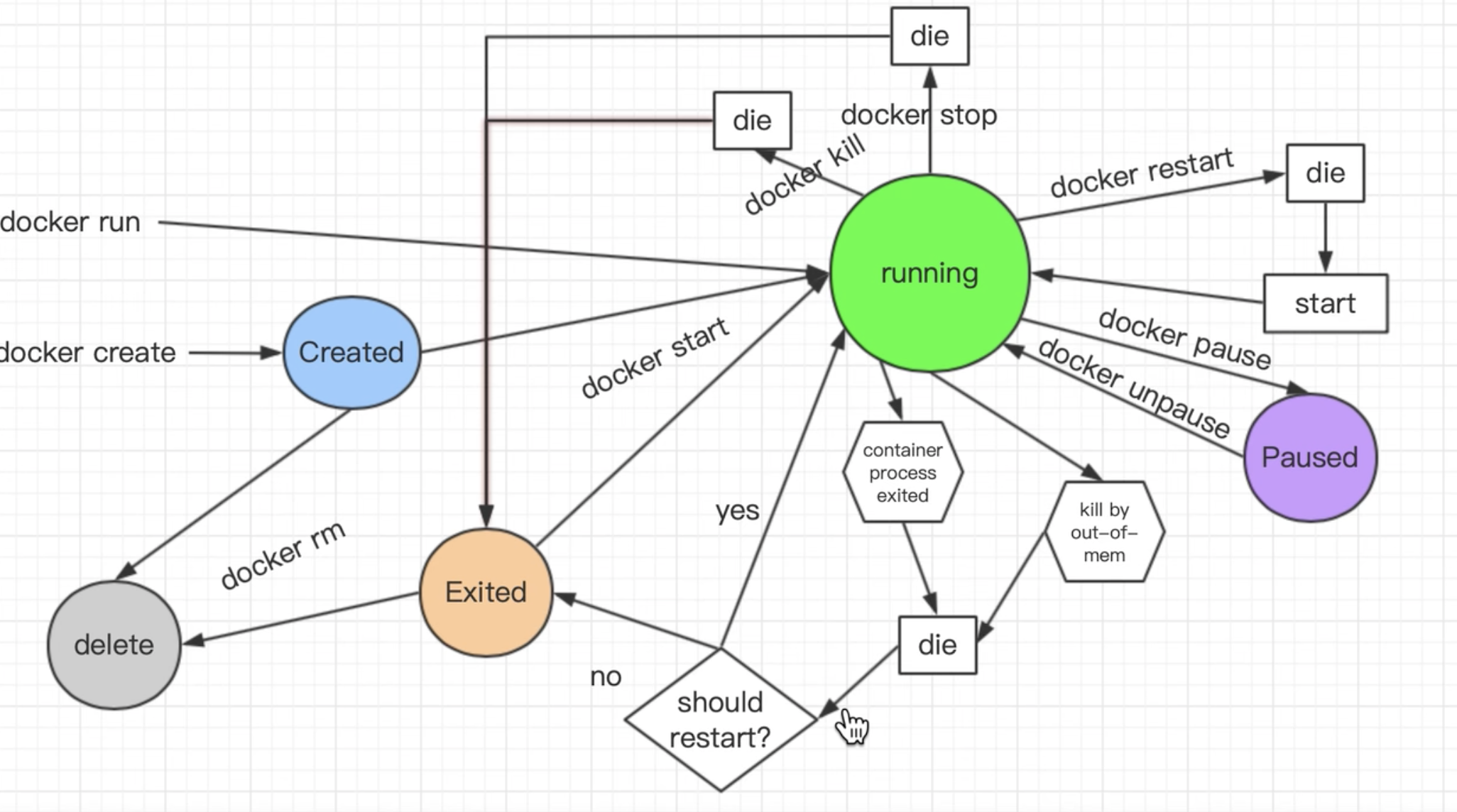

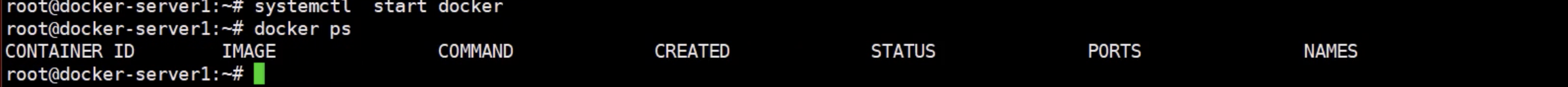

基于镜像创建容器 docker create

docker create 镜像名

[root@localhost ~]# docker create alpine

[root@localhost ~]# docker ps -a #docker ps只能查看到正在运行的容器

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

b11b2b07bc09 alpine "/bin/sh" 40 seconds ago Created nervous_heisenberg

[root@localhost ~]# docker start b11b2b07bc09 #发现该容器的状态是created,需要通过start来将容器启动

b11b2b07bc09

[root@localhost ~]# docker ps -a #状态由 Created 转变为 Exited (0),0代表正常退出。因为这个容器的COMMAND是/bin/sh,

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

b11b2b07bc09 alpine "/bin/sh" 7 minutes ago Exited (0) 5 seconds ago nervous_heisenberg

docker run alpine echo "hello docker"

docker ps -a 发现这个容器的状态也是退出,容器的运行声明周期取决于COMMAND命令,命令运行结束,容器就退出

docker -i 打开交互式终端 -t 伪终端

然后再次执行发现会进入到容器里面运行,

exit,代表退出,发现容器状态依旧为退出状态

如果想要后台运行 -d

docker start 发现容器状态为运行状态

docker stop 关闭容器,stop命令会把容器里面的服务关闭后在关闭容器

docker ps -a 会发现退出状态不为0,

docker start 启动

docker kill 代表强制关闭,

docker pause 将容器挂起,

docker unpause 解除挂起

运行容器 docker run

如果镜像不存在,会自动进行下载

[root@locahost ~]# docker run [选项] 镜像名:版本 [shell命令] [参数]

| 选项 | 说明 |

|---|---|

| -i | 以交互模式运行容器,保持容器持久运行,如果没有客户端连接将会断开 |

| -t | 为容器重新分配一个伪输入终端,进入到容器进行交互 |

| -d | 后台运行容器,并返回容器ID,也即启动守护式容器;使用exec进入容器,exit容器后,容器不关闭 |

| -p | 指定端口映射,格式为:-p 宿主机端口:容器端口 |

| -P | 随机端口映射 |

--name 容器新名字: 为容器指定一个名称;也可写为 —-name=容器新名字

--hostname 主机名: 容器启动时的主机名

--env:环境变量

-v:

--restart=always:容器自动启动

-h 主机名:设置容器主机名,默认主机名是容器id号

--dns xx.xx.xx.xx :设置容器使用的dns服务器

--dns-search:DNS搜索设置

--add-host hostname:IP :注入hostname<>Ip解析

--rm:容器停止后自动删除

Docker启动必须至少有一个工作在前台的守护进程

#使用镜像centos:latest以后台模式启动一个容器

[root@localhost ~]# docker run -d centos

7e8fd11740c6dd453e7fd3ab9b8c31c916b5dd0b1cec2f06934fc97cb088ef02

[root@localhost ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

7e8fd11740c6 centos "/bin/bash" 31 seconds ago Exited (0) 30 seconds ago blissful_galois

问题:然后docker ps -a 进行查看,会发现容器已经退出

很重要的要说明的一点:Docker容器后台运行,就必须有一个前台进程

容器运行的命令如果不是那些一直挂起的命令(比如运行top,tail),就是会自动退出的。

这个是docker的机制问题,比如你的web容器,我们以nginx为例,正常情况下,我们配置启动服务只需要启动响应的service即可。例如

service nginx start

但是,这样做,nginx为后台进程模式运行,就导致docker前台没有运行的应用,

这样的容器后台启动后,会立即自杀因为他觉得他没事可做了.

所以,最佳的解决方案是,将你要运行的程序以前台进程的形式运行

[root@locahost ~]# docker run -it centos

[root@locahost ~]# docker run -it centos /bin/bash

以/bin/bash的形式登录,默认以该形式登录,不写也可以

[root@locahost ~]# docker run -it -p 8080:8080 tomcat

Tomcat默认端口8080

主机端口:外部访问就通过该自己设置的端口访问

容器端口:docker内部8080端口的tomcat

比如网页访问:ip:自己设置的主机端口

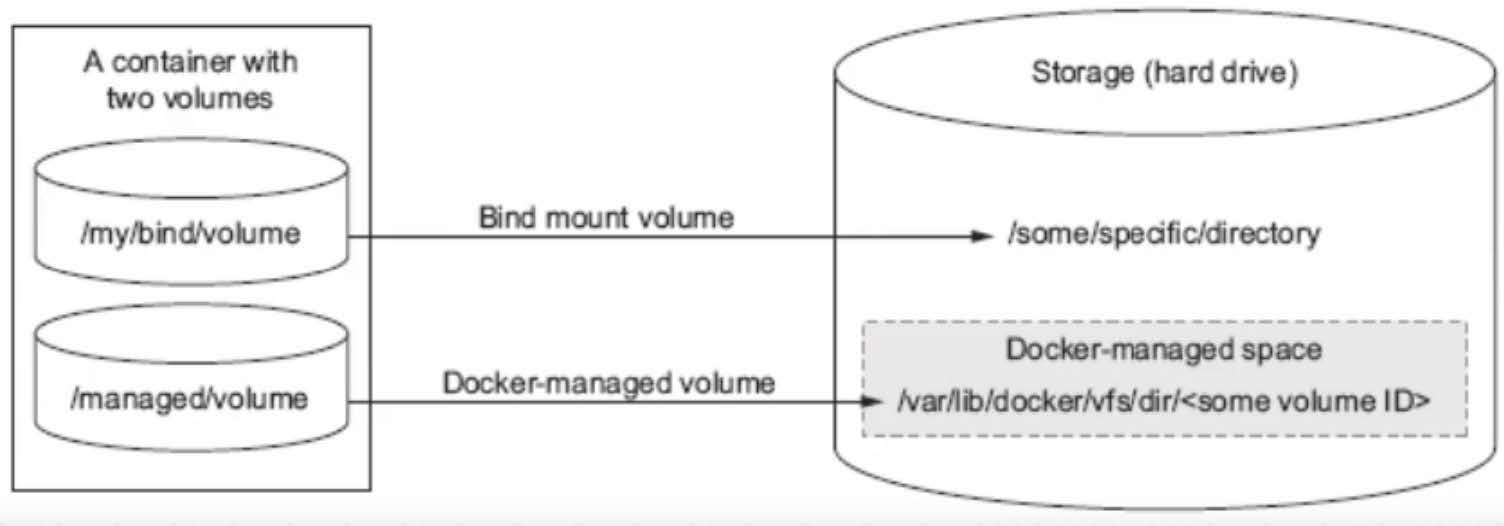

[root@locahost ~]# docker run -it -v 宿主机绝对路径目录:容器内目录 镜像名

使用-v选项,容器持久化自管理目录,如果目录不存在自动创建,两个文件共享资源

如果想要其它容器共享宿主机目录,创建时指定该宿主机目录即可共享该宿主机目录

缺点:换台机器宿主机目录无法使用

[root@localhost ~]# systemctl restart docker #重新启动docker,运行的容器将会停止

[root@locahost ~]# docker run –-name=a –-restart=always -d mysql

[root@localhost ~]# systemctl restart docker #加了该选项后该容器会自动启动

单次运行:

docker run -it --rm nginx #退出后自动删除

指定容器DNS:Dns服务默认采用宿主机的dns地址 一是将dns地址配置在宿主机,二是将参数配置在docker启动脚本里面 -dns-1.1.1.1

[root@localhost ~]# docker run -it -rm --dns 223.6.6.6 centos bashe

[root@localhost ~]# cat /etc/resolv.conf

nameserver 223.6.6.6

在容器里面是默认不能使用systemd作为PID为1的守护进程,因为容器里面没有kernel ,虚拟机有内核

在容器里面必须有一个进程可以一直运行下去,这个进程就会被封装为PID为1的守护进程

可以使用Nginx的master进程,apache的主进程或者shell命令,如tail

#启动的容器在执行完shell命令就退出了,容器的生命周期取决于COMMAND命令,这条命令结束周期就结束。

[root@localhost ~]# docker run centos /bin/echo 'helloworld'

helloworld

[root@localhost ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

d157ef644e61 centos "/bin/echo helloworld" 13 seconds ago Exited (0) 12 seconds ago wonderful_leakey

docker run -it centos bash #会直接进入到容器,并随机生成容器ID和名称

当利用 docker run 来创建容器时,Docker 在后台运行的标准操作包括:

检查本地是否存在指定的镜像,不存在就从 registry 下载

利用镜像创建并启动一个容器

分配一个文件系统,并在只读的镜像层外面挂载一层可读写层

从宿主主机配置的网桥接口中桥接一个虚拟接口到容器中去

从地址池配置一个 ip 地址给容器

执行用户指定的应用程序

执行完毕后容器被终止

指定本地端口映射

#本地端口映射到容器端口

[root@localhost ~]# docker run -d -it --name nginx1 -p 81:80 nginx

e790982371f8050dffbb6efbb3e2c85732660594b45de6645151256a4291c42c

本地ip:本地端口:容器端口

[root@localhost ~]# docker run -d -it --name nginx2 -p 172.17.0.15:82:80 nginx

ab008741e9576426bf786df99c97bf1ea92850a4bbf39319792c913d954f606e

本地ip:本地随机端口:容器端口

[root@localhost ~]# docker run -d -it --name nginx3 -p 172.17.0.15::80 nginx

4d1199c1b549844bc29add5d8ec8322792bbb42f9b8e5a59328a6f35fdca5d25

#默认tcp

[root@localhost ~]# docker run -d -it --name nginx4 -p 84:80/udp nginx

7fea54fcba329621ed7040dfc5355f6df079f117cd08626193660b3c28fd6f77

[root@localhost ~]# docker run -d -it --name nginx5 -p 80:80 -p 443:443 nginx

9880708baa505c605a51abfdb399f3185ecfe5afc6539079ae87b97e50e2ea45

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

9880708baa50 nginx "/docker-entrypoin..." 27 seconds ago Up 25 seconds 0.0.0.0:80->80/tcp, 0.0.0.0:443->443/tcp nginx5

7fea54fcba32 nginx "/docker-entrypoin..." 6 minutes ago Up 6 minutes 80/tcp, 0.0.0.0:84->80/udp nginx4

4d1199c1b549 nginx "/docker-entrypoin..." 10 minutes ago Up 10 minutes 172.17.0.15:32769->80/tcp nginx3

ab008741e957 nginx "/docker-entrypoin..." 12 minutes ago Up 12 minutes 172.17.0.15:82->80/tcp nginx2

e790982371f8 nginx "/docker-entrypoin..." 12 minutes ago Up 12 minutes 0.0.0.0:81->80/tcp nginx1

[root@localhost ~]# iptables -t nat -vnL

Chain PREROUTING (policy ACCEPT 206 packets, 8592 bytes)

pkts bytes target prot opt in out source destination

64366 2428K DOCKER all -- * * 0.0.0.0/0 0.0.0.0/0 ADDRTYPE match dst-type LOCAL

Chain INPUT (policy ACCEPT 206 packets, 8592 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 29210 packets, 1753K bytes)

pkts bytes target prot opt in out source destination

0 0 DOCKER all -- * * 0.0.0.0/0 !127.0.0.0/8 ADDRTYPE match dst-type LOCAL

Chain POSTROUTING (policy ACCEPT 29210 packets, 1753K bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * !docker0 172.18.0.0/16 0.0.0.0/0

0 0 MASQUERADE tcp -- * * 172.18.0.2 172.18.0.2 tcp dpt:80

0 0 MASQUERADE tcp -- * * 172.18.0.3 172.18.0.3 tcp dpt:80

0 0 MASQUERADE tcp -- * * 172.18.0.4 172.18.0.4 tcp dpt:80

0 0 MASQUERADE udp -- * * 172.18.0.5 172.18.0.5 udp dpt:80

0 0 MASQUERADE tcp -- * * 172.18.0.6 172.18.0.6 tcp dpt:443

0 0 MASQUERADE tcp -- * * 172.18.0.6 172.18.0.6 tcp dpt:80

Chain DOCKER (2 references)

pkts bytes target prot opt in out source destination

0 0 RETURN all -- docker0 * 0.0.0.0/0 0.0.0.0/0

0 0 DNAT tcp -- !docker0 * 0.0.0.0/0 0.0.0.0/0 tcp dpt:81 to:172.18.0.2:80

0 0 DNAT tcp -- !docker0 * 0.0.0.0/0 172.17.0.15 tcp dpt:82 to:172.18.0.3:80

0 0 DNAT tcp -- !docker0 * 0.0.0.0/0 172.17.0.15 tcp dpt:32769 to:172.18.0.4:80

0 0 DNAT udp -- !docker0 * 0.0.0.0/0 0.0.0.0/0 udp dpt:84 to:172.18.0.5:80

0 0 DNAT tcp -- !docker0 * 0.0.0.0/0 0.0.0.0/0 tcp dpt:443 to:172.18.0.6:443

0 0 DNAT tcp -- !docker0 * 0.0.0.0/0 0.0.0.0/0 tcp dpt:80 to:172.18.0.6:80

宿主机对应端口被映射到容器端口

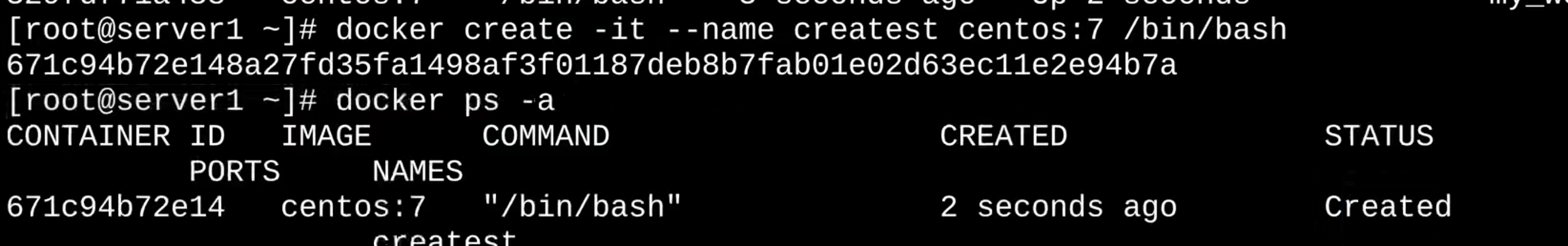

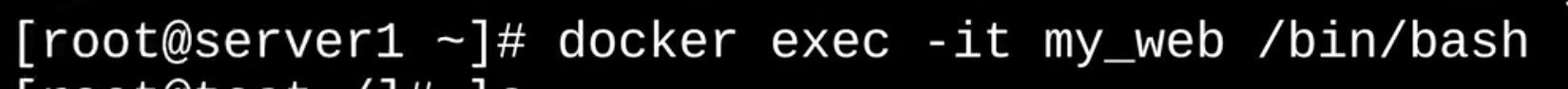

进入容器docker attach

两种退出方式:

exit:容器退出停止

ctrl+p+q:容器不停止退出

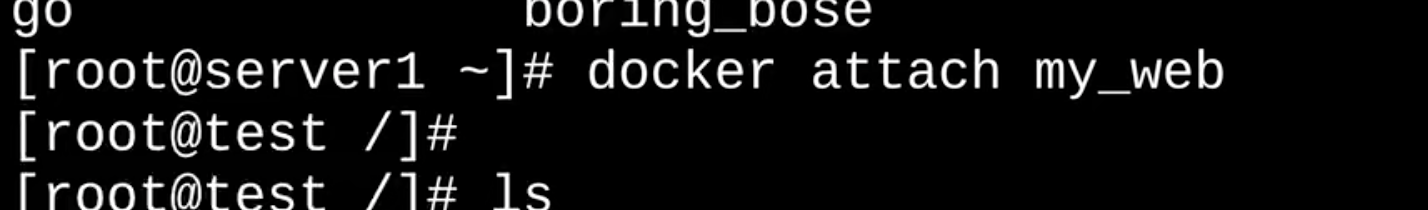

进入容器docker exec

进入正在运行的容器并以命令行交互

[root@locahost ~]# docker exec [选项] 容器名

选项:

-d :分离模式: 在后台运行

-i :即使没有附加也保持STDIN 打开

-t :分配一个伪终端

[root@locahost ~]# docker exec -it 容器名 /bin/bash

进入到容器中,使用docker run -id 创建运行的容器,exit退出容器后,该容器后台还在运行

[root@locahost ~]# docker exec 容器id ls -l /tmp

不进入容器执行该命令(执行的是容器中的内容),得到容器内的结果

[root@localhost ~]# docker exec -it 容器id /bin/bash

[root@localhost ~]# docker attach 容器id /bin/bash

docker exec : 进入容器后开启一个新的终端,可以进行操作,exit后容器还在运行

docker attach :进入容器正在执行的终端,不会启动新的进程

docker atttach 进入容器后执行exit整个容器都会停止,ctrl+p在ctrl+q退出容器,这样容器才不会被关闭

yum provides ip #docker进入容器后可以通过yum命令来查询属于哪个软件包,比如查询ip

当执行docker run 的时候已经启动了一个bash,docker exec 进入容器是因为又开了个bash,而attach 是进入的父shell,所以退出后容器就嘎了

查看容器 docker ps

docker ps [选项]

| 选项 | 说明 |

|---|---|

| -a | 列出当前所有正在运行的容器以及已经关闭的所有容器 |

| -q | 静默模式,只显示容器id |

| -f | |

| -l | 显示最近创建的容器 |

| -n | 显示最近n个创建的容器 |

| –no-trunc | 显示完整id,容器id是容器的唯一标识,完整版是128位,系统只显示16位 |

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

容器id 镜像名 容器创建执行的命令 容器创建时间 运行时间 端口映射 容器名

退出容器

两种退出方式:

exit:容器退出停止

ctrl+p+q:容器不停止退出

在虚拟机里面,我们可以通过重启服务或者重启虚拟机的方式进行配置变更和代码发布,但是,在k8s环境,是禁止通过重启服务或者重启容器来实现配置变更和代码发布的

查看容器信息 docker inspect

docker inspect 容器id

删除容器 docker rm

| 选项 | 说明 |

|---|---|

| -f | 强制删除 |

| -l | 删除指定的link |

| -v | 删除与容器关联的卷,默认也是删除 |

[root@locahost ~]# docker rm -f 容器id # -f选项代表强制删除,即使容器正在运行中,也会被强制删除掉

[root@locahost ~]# docker rm -f `docker ps -a -q` #删除全部容器

[root@locahost ~]# docker rm -fv `docker ps -a -q -f status=exited` #批量删除已退出的容器

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

68baa232d50a centos "/bin/bash" 3 seconds ago Up 3 seconds inspiring_bassi

[root@localhost ~]# docker rm 68baa232d50a #容器正在运行无法删除,需要docker stop 在执行docker rm

Error response from daemon: You cannot remove a running container 68baa232d50a57343b1911c270f7192408f59dfb11bf6049421f2f175f73f1ec. Stop the container before attempting removal or force remove

[root@localhost ~]# docker rm -f 68baa232d50a #强制删除

68baa232d50a

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

查看容器日志docker logs

当容器无法启动

[root@locahost ~]# docker logs [选项] 容器id

| 选项 | 说明 |

|---|---|

| -f | 跟随最新的日志打印(类似于 tail -f) |

| -t | 加入时间戳 |

| –tail 数字 | 显示最后多少条 |

查看容器内运行的进程 docker top

[root@locahost ~]# docker top 容器id

查看容器所占用的系统资源 docker stats

[root@locahost ~]# docker stats 容器id

CONTAINER CPU% MEM USAGE/LIMIT MEM% NET I/O BLOCK I/O PIDS

容器名 cpu使用率 已使用内存大小/总内存大小 内存使用率 网络IO 磁盘IO

从容器内拷贝文件到宿主机上 docker cp

[root@locahost ~]# docker cp 容器id:容器路径文件 要拷贝到的宿主机路径

Docker镜像制作

Docker镜像有没有内核。从镜像大小上面来说,一个比较小的镜像只有十几MB,而内核文件需要一百多兆,因此镜像里面是没有内核的。

镜像在被启动为容器后将直接使用宿主机的内核,而镜像本身则只提供相应的rootfs,即系统正常运行所必须的用户空间的文件系统。比如/dev、/proc、/bin、/etc 等目录,容器当中/boot目录是空的,而/boot当中保存的就是与内核相关的文件和目录。由于容器启动和运行过程中是直接使用了宿主机的内核,不会直接调用物理硬件,所以也不会涉及到硬件驱动,因此也无需容器内拥有自已的内核和驱动。另外有内核的那是虚拟机,如果使用虚拟机技术,对应每个虚拟机都有自已独立的内核。

[root@localhost ~]# uname -r #查看宿主机内核

3.10.0-1160.45.1.el7.x86_64

[root@localhost ~]# docker run -it --rm debian bash

root@4b072acf6539:/# uname -r #查看容器内核,发现与宿主机内核一致

3.10.0-1160.45.1.el7.x86_64

root@4b072acf6539:/# ls /boot

root@4b072acf6539:/# cat /etc/issue

Debian GNU/Linux 11 \n \l

制作镜像方式:

Docker 镜像制作类似于虚拟机的镜像(模版)制作,即按照公司的实际业务需求将需要安装的软件、相关配置等基础环境配置完成,然后将其做成镜像,最后再批量从镜像批量生成容器实例,这样可以极大的简化相同环境的部署工作。

Docker的镜像制作分为手动制作(基于容器)和自动制作(基于DockerFile),企业通常都是基于Dockerfile制作镜像

docker commit #通过修改现有容器,将之手动构建为镜像

docker build #通过Dockerfile文件,批量构建为镜像

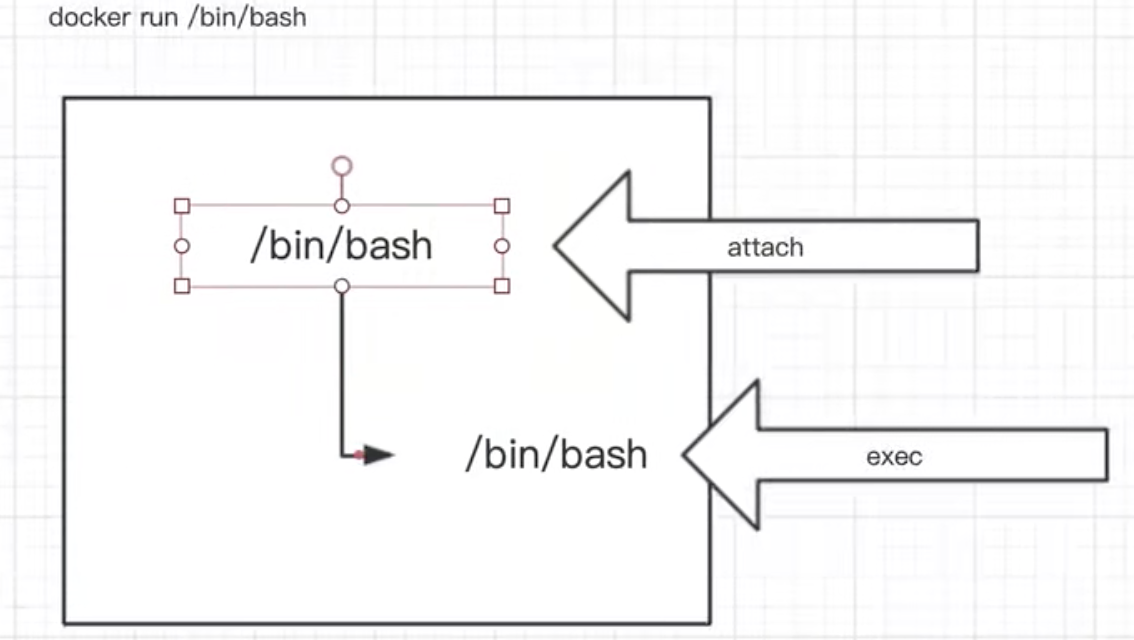

docker 镜像生命周期

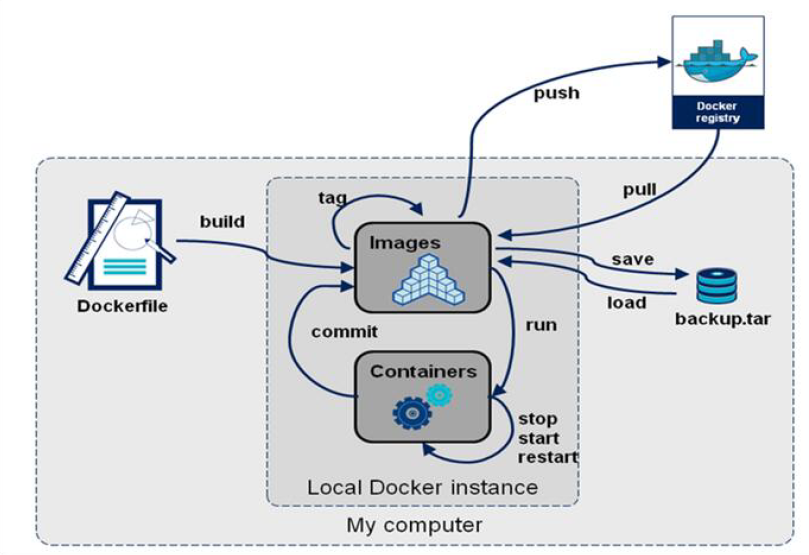

docker commit 手动构建镜像(慎用)

基于容器制作为镜像,制作镜像和 CONTAINER 状态无关,停止状态也可以制作镜像。如果没有指定 [REPOSITORY[:TAG]],那么REPOSITORY和TAG都为。提交的时候标记TAG号:后期可以根据TAG标记创建不同版本的镜像以及创建不同版本的容器

为什么不建议使用 docker commit 手动构建镜像?

当我们运行一个容器的时候(如果不使用卷的话),我们做的任何文件修改都会被记录于容器存储层里。而 Docker 提供了一个 docker commit 命令,可以将容器的存储层保存下来成为镜像。换句话说,就是在原有镜像的基础上,再叠加上容器的存储层,并构成新的镜像。以后我们运行这个新镜像的时候,就会拥有原有容器最后的文件变化。

可以通过 docker history 具体查看镜像内的历史记录,如果比较 nginx:latest 的历史记录,我们会发现新增了我们刚刚提交的这一层。

使用 docker commit 意味着所有对镜像的操作都是黑箱操作,生成的镜像也被称为黑箱镜像,换句话说,就是除了制作镜像的人知道执行过什么命令、怎么生成的镜像,别人根本无从得知。而且,即使是这个制作镜像的人,过一段时间后也无法记清具体的操作。这种黑箱镜像的维护工作是非常痛苦的。镜像所使用的分层存储的概念,除当前层外,之前的每一层都是不会发生改变的,换句话说,任何修改的结果仅仅是在当前层进行标记、添加、修改,而不会改动上一层。如果使用 docker commit 制作镜像,以及后期修改的话,每一次修改都会让镜像更加臃肿一次,所删除的上一层的东西并不会丢失,会一直如影随形的跟着这个镜像,即使根本无法访问到。这会让镜像更加臃肿。

[root@locahost ~]# docker commit [选项] 容器名 新镜像名:版本

选项:

-a "作者信息"

-m "提交的描述信息"

-c "容器运行时执行的命令"

[root@locahost ~]# docker commit -a "qs" -m "描述信息" 容器id 新镜像名:版本

Commit只是把容器当时的状态保存为镜像,当你再次把镜像运行为容器的时候,依然使用的是原来的启动命令(COMMAND)

比如本地有一个centos:v1,再次通过 commit 重新提交,如果之前的名字和版本没有做任何修改,那么就会覆盖之前的镜像,被覆盖的这个镜像的REPOSITORY和TAG就变成了none,这类无标签镜像也被称为 虚悬镜像(dangling image) 。下面通过案例进行演示

[root@localhost ~]# docker run -d busybox

fd489fdceb09d639916bb1071d445fc500710c1123d3d63ec0bac06bc5d8cd36

[root@localhost ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

fd489fdceb09 busybox "sh" 16 seconds ago Exited (0) 14 seconds ago keen_vaughan

[root@localhost ~]# docker commit fd489fdceb09 my_busybox:v1

sha256:27973ab29701e3befda04daf65fe43430e48f4c233857ebceee5e8c4923a6293

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

my_busybox v1 27973ab29701 8 seconds ago 1.24MB

第一次提交的这个镜像原本是有镜像名和标签的,然后我们再次提交。由于新旧镜像同名,旧镜像名称被取消,从而出现仓库名、标签均为 的镜像

[root@localhost ~]# docker commit fd489fdceb09 my_busybox:v1

sha256:bf0effe95ea7f8201b327b3814d224342bb2e419797c9fa76c03cbc40a63c362

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

my_busybox v1 bf0effe95ea7 3 seconds ago 1.24MB

<none> <none> 27973ab29701 About a minute ago 1.24MB

[root@localhost ~]# docker image ls -f dangling=true #该命令用于专门显示虚悬镜像

<none> <none> 27973ab29701 7 minutes ago 1.24MB

一般来说,虚悬镜像已经失去了存在的价值,是可以随意删除的,可以用下面的命令删除。

[root@localhost ~]# docker image prune

基于容器手动制作镜像步骤具体如下:

- 下载一个系统的官方基础镜像,如: CentOS 或 Ubuntu

- 基于基础镜像启动一个容器,并进入到容器

- 在容器里面做配置操作:安装基础命令、配置运行环境、安装服务和配置服务、放业务程序代码

- 提交为一个新镜像 docker commit

- 基于自己的的镜像创建容器并测试访问

基于 busybox 制作 httpd 镜像

[root@localhost ~]# docker pull busybox

[root@localhost ~]# docker run -it --name busybox_http busybox

/ # mkdir -p /data/html

/ # echo "busybox_httpd_test" > /data/html/index.html

/ # exit

#两种不同的格式

[root@localhost ~]# docker commit -a "qianshuai" -c 'CMD /bin/httpd -fv -h /data/html' -c "EXPOSE 80" busybox_http httpd_busybox:v1.0

[root@localhost ~]# docker commit -a "qianshuai" -c 'CMD ["/bin/httpd","-f","-v","-h","/data/html"]' -c "EXPOSE 80" busybox_http httpd_busybox:v2.0

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

httpd_busybox v2.0 dd83963b0ac5 5 seconds ago 1.24MB

httpd_busybox v1.0 42487fc6dc41 32 seconds ago 1.24MB

[root@localhost ~]# docker run -d -P --name httpd_busybox1 httpd_busybox:v1.0

[root@localhost ~]# docker run -d -P --name httpd_busybox2 httpd_busybox:v2.0

[root@localhost ~]# docker port httpd_busybox1

80/tcp -> 0.0.0.0:49153

80/tcp -> :::49153

[root@localhost ~]# docker port httpd_busybox2

80/tcp -> 0.0.0.0:49154

80/tcp -> :::49154

[root@localhost ~]# curl 127.0.0.1:49153

busybox_httpd_test

[root@localhost ~]# curl 127.0.0.1:49154

busybox_httpd_test

[root@localhost ~]# docker inspect -f "{{.Config.Cmd}}" httpd_busybox1

[/bin/sh -c /bin/httpd -fv -h /data/html]

[root@localhost ~]# docker inspect -f "{{.Config.Cmd}}" httpd_busybox2

[/bin/httpd -f -v -h /data/html]

[root@localhost ~]# docker exec -it httpd_busybox1 sh

/ # ps -ef

PID USER TIME COMMAND

1 root 0:00 /bin/httpd -fv -h /data/html

9 root 0:00 sh

15 root 0:00 ps -ef

在原有镜像的基础上,再叠加上容器的存储层,并构成新的镜像

基于Ubuntu的基础镜像手动制作nginx 的镜像

1、启动Ubuntu基础镜像并下载nginx

[root@localhost ~]# docker run -it --name nginx_ubuntu ubuntu bash

root@e18271e73f15:/# apt update

root@e18271e73f15:/# apt -y install nginx

Please select the geographic area in which you live. Subsequent configuration questions will narrow this down by presenting a list of cities,

representing the time zones in which they are located.

1. Africa 3. Antarctica 5. Arctic 7. Atlantic 9. Indian 11. SystemV 13. Etc

2. America 4. Australia 6. Asia 8. Europe 10. Pacific 12. US

Geographic area: 6

Please select the city or region corresponding to your time zone.

70. Shanghai

Time zone: 70 #配置时区,这里选择的是上海

root@e18271e73f15:/# nginx -v

nginx version: nginx/1.18.0 (Ubuntu)

root@e18271e73f15:/# echo Nginx Website in Docker > /var/www/html/index.html

2、提交为镜像

[root@localhost ~]# docker commit -a 'qianshuai' -m 'nginx-ubuntu:v1' nginx_ubuntu nginx_ubuntu:v1

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

nginx_ubuntu v1 1482153603bb 2 hours ago 169MB

3、从制作的新镜像启动容器并测试访问

[root@localhost ~]# docker run -d -p 8000:80 --name nginx-web nginx_ubuntu:v1 nginx -g 'daemon off;'

b9b7bd57a6bdfcea500bacb4d078ff8f3b483a3dad5894412355eb921f5ef097

[root@localhost ~]# curl http://127.0.0.1:8000

Nginx Website in Docker

基于CentOS的基础镜像手动制作 nginx 镜像

yum安装

1、下载基础镜像并初始化系统。基于某个基础镜像之上重新制作,因此需要先有一个基础镜像,本次使用官方提供的centos镜像为基础

[root@localhost ~]# docker pull centos:centos7

[root@localhost ~]# docker run -it centos:centos7 bash

#修改时区

[root@ccc9de7dcde6 /]# rm -f /etc/localtime

[root@ccc9de7dcde6 /]# ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

2、更改yum 源

[root@ccc9de7dcde6 /]# yum -y install wget

[root@ccc9de7dcde6 /]# rm -rf /etc/yum.repos.d/*

[root@ccc9de7dcde6 /]# wget -P /etc/yum.repos.d/ http://mirrors.aliyun.com/repo/Centos-7.repo

[root@ccc9de7dcde6 /]# wget -P /etc/yum.repos.d/ http://mirrors.aliyun.com/repo/epel-7.repo

#清除缓存并重新构建 yum 源

[root@ccc9de7dcde6 /]# yum clean all

[root@ccc9de7dcde6 /]# rm -rf /var/cache/yum

[root@ccc9de7dcde6 /]# yum makecache

3、安装相关软件和工具

#安装常用命令

[root@ccc9de7dcde6 /]# yum -y install vim curl iproute net-tools

#yum安装nginx

[root@ccc9de7dcde6 /]# yum –y install nginx

#清理yum缓存

[root@ccc9de7dcde6 /]# rm -rf /var/cache/yum/*

4、修改服务的配置信息关闭nginx后台运行

[root@ccc9de7dcde6 /]# vim /etc/nginx/nginx.conf #新增daemon off

user nginx;

daemon off; #关闭后台运行

5、自定义web界面

[root@ccc9de7dcde6 /]# rm -f /usr/share/nginx/html/index.html

[root@ccc9de7dcde6 /]# echo "Nginx Page in Docker" > /usr/share/nginx/html/index.html

6、提交为镜像

[root@localhost ~]# docker commit -a "zhangsan" -m "nginx yum v1" -c "EXPOSE 80 443" ccc9de7dcde6 centos7-nginx:v1

sha256:efb4239c46ef8fc86ae64c247fdb7ff41546654a839987b12c4e07fe25d97ba0

7、从制作的镜像启动容器

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

centos7-nginx v1 efb4239c46ef 41 seconds ago 831MB

[root@localhost ~]# docker run -d -p 8000:80 --name my-centos-nginx centos7-nginx:v1 /usr/sbin/nginx

e2db096ecbebce3f285ae389537a65a7d190551cabd4f756f4e309d986d79143

8、访问测试镜像

[root@localhost ~]# curl 127.0.0.1:8000

Nginx Page in Docker

编译安装

1、下载基础镜像并初始化系统。基于某个基础镜像之上重新制作,因此需要先有一个基础镜像,本次使用官方提供的centos镜像为基础

[root@localhost ~]# docker pull centos:centos7

[root@localhost ~]# docker run -it --name centos7_nginx centos:centos7 bash

[root@0ce9420fb0f5 /]# useradd -r -s /sbin/nologin nginx

#修改时区

[root@0ce9420fb0f5 /]# rm -f /etc/localtime

[root@0ce9420fb0f5 /]# ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

2、更改yum 源

[root@0ce9420fb0f5 /]# yum -y install wget

[root@0ce9420fb0f5 /]# rm -rf /etc/yum.repos.d/*

[root@0ce9420fb0f5 /]# wget -P /etc/yum.repos.d/ http://mirrors.aliyun.com/repo/Centos-7.repo

[root@0ce9420fb0f5 /]# wget -P /etc/yum.repos.d/ http://mirrors.aliyun.com/repo/epel-7.repo

#清除缓存并重新构建 yum 源

[root@0ce9420fb0f5 /]# yum clean all

[root@0ce9420fb0f5 /]# rm -rf /var/cache/yum

[root@0ce9420fb0f5 /]# yum makecache

3、安装相关软件和工具

#安装基础包

[root@0ce9420fb0f5 /]# yum -y install gcc gcc-c++ automake pcre pcre-devel zlib zlib-devel openssl openssl-devel

#安装nginx

[root@0ce9420fb0f5 /]# cd /usr/local/src

[root@0ce9420fb0f5 src]# wget http://nginx.org/download/nginx-1.16.1.tar.gz

[root@0ce9420fb0f5 src]# tar xf nginx-1.16.1.tar.gz

[root@0ce9420fb0f5 src]# cd nginx-1.16.1

[root@0ce9420fb0f5 nginx-1.16.1]# ./configure --prefix=/opt/nginx

[root@0ce9420fb0f5 nginx-1.16.1]# make && make install

[root@0ce9420fb0f5 nginx-1.16.1]# rm -rf nginx*

[root@0ce9420fb0f5 nginx-1.16.1]# rm -rf /var/cache/yum/*

4、修改服务的配置信息关闭nginx后台运行

[root@0ce9420fb0f5 ~]# vi /opt/nginx/conf/nginx.conf #新增以下内容

user nginx;

daemon off;

[root@0ce9420fb0f5 ~]# ln -s /opt/nginx/sbin/nginx /usr/sbin/

[root@0ce9420fb0f5 ~]# ll /usr/sbin/nginx

lrwxrwxrwx 1 root root 21 Jun 27 14:13 /usr/sbin/nginx -> /opt/nginx/sbin/nginx

5、自定义web界面

[root@0ce9420fb0f5 ~]# echo "Nginx Page in Docker" > /opt/nginx/html/index.html

6、提交为镜像,不要退出容器,在另一个终端窗口执行以下命令

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

0ce9420fb0f5 centos:centos7 "bash" 17 minutes ago Up 17 minutes centos7_nginx

[root@localhost ~]# docker commit -m "nginx1.6.1" -c "CMD nginx" centos7_nginx centos7-nginx:v1.6.1

7、从制作的镜像启动容器

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

centos7-nginx v1.6.1 0fa45627a65e 23 seconds ago 400MB

#最后面的nginx是运行的命令,即镜像里面要运行一个nginx命令,所以前面软链接到/usr/sbin/nginx,目的为了让系统不需要指定路径就可以执行此命令

[root@localhost ~]# docker run -d -p 8000:80 --name my-centos-nginx centos7-nginx:v1.6.1 nginx

8、访问测试镜像

[root@localhost ~]# curl 127.0.0.1:8000

Nginx Page in Docker

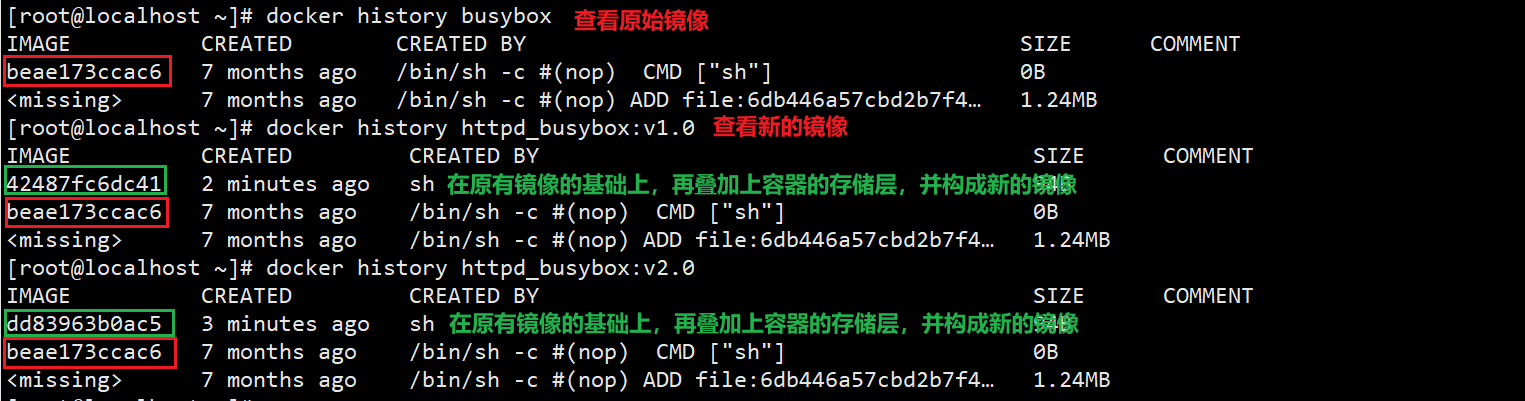

Dockerfile

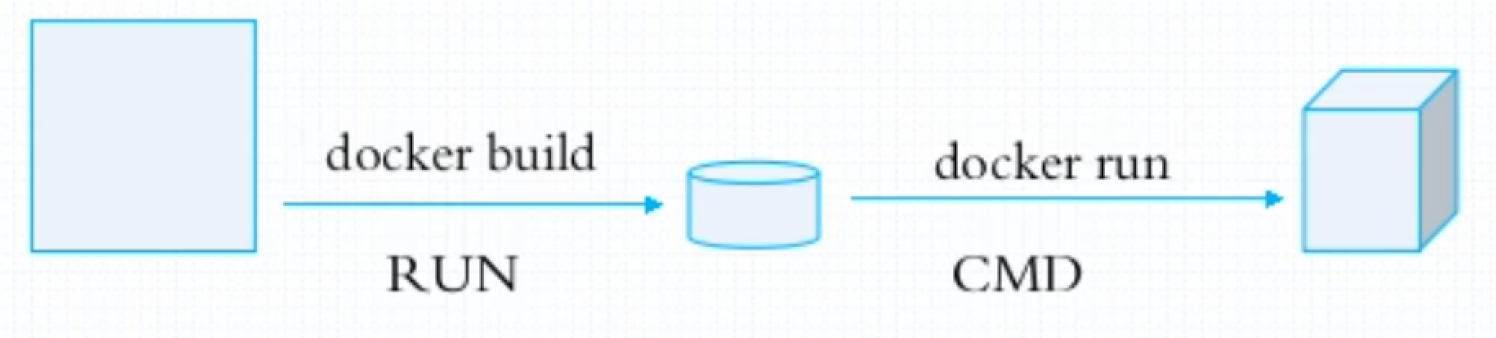

Dockerfile是用来构建docker镜像的构建文件,由一条一条的指令组成,由Docker程序解释执行,脚本中的每条指令对应Linux 下面的每一条命令,Docker程序将这些DockerFile指令再翻译成真正的linux命令,Docker程序读取DockerFile并根据指令生成Docker镜像。相比于手动commit制作镜像的方式,Dockerfile更能直观的展示镜像是怎么产生的。

Dockerfile中每条指令都是独立运行的,每条指令都会创建一个新的镜像层,并对镜像进行提交,最多不超过128层,命令最多128行。比如RUN cd /tmp 对下一条指令不会有任何影响

1、 编写一个dockerfile文件

2、 docker build 构建称为一个镜像

3、 docker run 运行镜像

4、 docker push发布镜像(DockerHub、阿里云仓库)

Dockerfile 镜像制作和使用流程

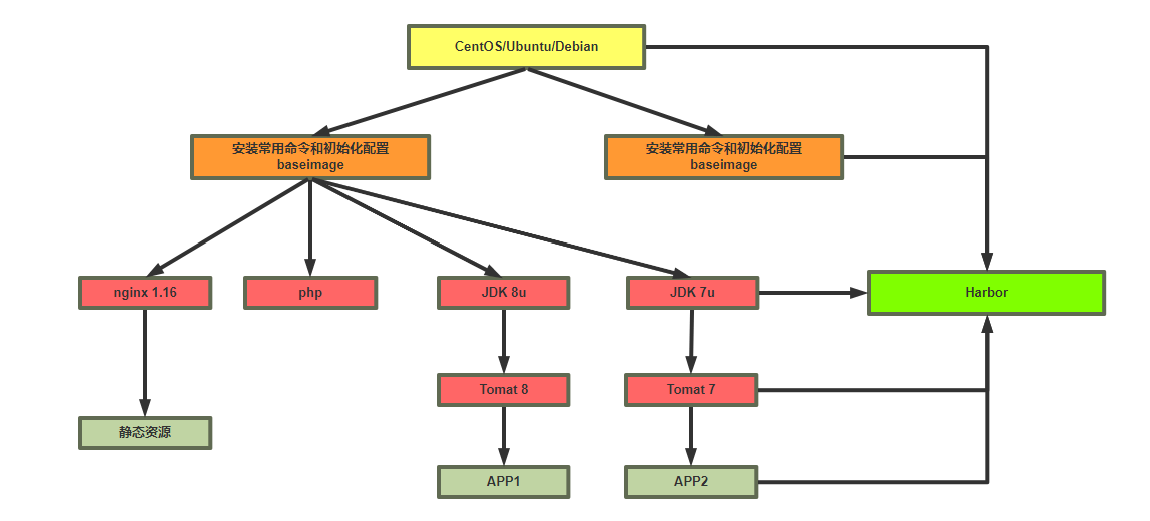

Dockerfile文件的制作镜像的分层结构

dockerfile文件格式

1、每一行以Dockerfile的指令开头,指令不区分大小写,但是惯例使用大写。# 开头作为注释

2、指令按文件的顺序从上至下进行执行,每一行只支持一条指令,每条指令可以携带多个参数

3、每个指令的执行会生成一个新的镜像层,为了减少分层和镜像大小,尽可能将多条指令合并成一条指令

4、制作镜像一般可能需要反复多次,每次执行dockfile都按顺序执行,从头开始,已经执行过的指令已经缓存,不需要再执行,如果后续有一行新的指令没执行过,其往后的指令将会重新执行,所以为加速镜像制作,将最常变化的内容放下dockerfile的文件的后面

FROM 指定基础镜像

指定基础镜像,Dockerfile 中 FROM 是必备的指令,并且必须是第一条指令。后续的指令都依赖于该指令指定的image。FROM指令指定的基础image可以是官方远程仓库中的,也可以位于本地仓库,该指令在dockerfile中只能有一个

base镜像:基础的镜像,不需要依赖其它镜像来构建;其它镜像以之为基础进行扩展的镜像,比如debian、centos

FROM [--platform=<platform>] <image>[:<tag>] [AS <name>]

--platform 指定镜像的平台,比如: linux/amd64, linux/arm64, or windows/amd64

tag 和 digest是可选项,如果不指定,默认为latest

除了选择现有镜像为基础镜像外,Docker 还存在一个特殊的镜像,名为 scratch。这个镜像是虚拟的概念,并不实际存在,该镜像是一个空的镜像,可以用于构建busybox等超小镜像,可以说是真正的从零开始构建属于自己的镜像。该镜像在构建基础镜像(例如debian和busybox)或超最小镜像(仅包含一个二进制文件及其所需内容,例如:hello-world)的上下文中最有用。

FROM scratch

...

LABEL 指定镜像元数据

LABEL可以指定镜像元数据,如镜像作者等。一个镜像可以有多个label,还可以写在一行中,即多标签写法,可以减少镜像的的大小

LABEL <key>=<value> <key>=<value> <key>=<value> ...

LABEL version="1.0"

LABEL name="test"

LABEL version="1.0" name="test"

docker inspect 命令可以查看LABEL信息

[root@localhost ~]# docker inspect centos:7

...

"Labels": {

"org.label-schema.build-date": "20201113",

"org.label-schema.license": "GPLv2",

"org.label-schema.name": "CentOS Base Image",

"org.label-schema.schema-version": "1.0",

"org.label-schema.vendor": "CentOS",

"org.opencontainers.image.created": "2020-11-13 00:00:00+00:00",

"org.opencontainers.image.licenses": "GPL-2.0-only",

"org.opencontainers.image.title": "CentOS Base Image",

"org.opencontainers.image.vendor": "CentOS"

}

...

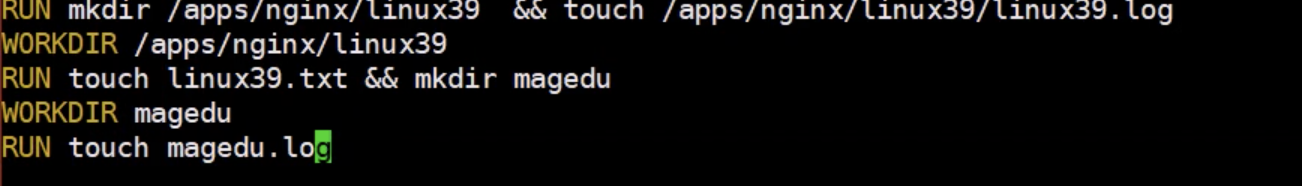

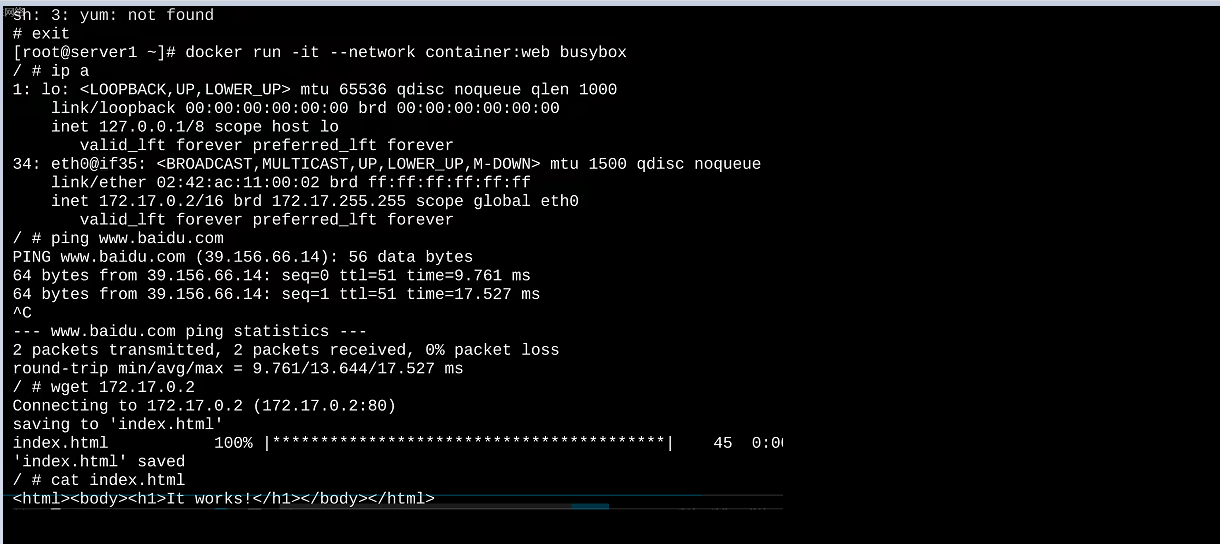

RUN 执行 shell命令

RUN 指令用来在构建镜像阶段需要执行 FROM 指定镜像所支持的Shell命令,RUN可以运行任何被基础 image 支持的命令。由于命令行的强大能力,RUN 指令在定制镜像时是最常用的指令之一。其格式有两种:

shell 格式:相当于 /bin/sh -c <命令> 此种形式支持环境变量

RUN <命令>

RUN echo '<h1>Hello, Docker!</h1>' > /usr/share/nginx/html/index.html

shell格式中,通常是一个shell命令,且以"/bin/sh -c”来运行它,这意味着此进程在容器中的PID不为1,不能接收Unix信号,因此,当使用docker stop 命令停止容器时,此进程接收不到SIGTERM信号

exec 格式:此种形式不支持环境变量,注意:是双引号,不能是单引号

RUN ["可执行文件", "参数1", "参数2"],这更像是函数调用中的格式。

#exec格式可以指定其它shell

RUN ["/bin/bash","-c","echo hello wang"]

exec格式中的参数是一个JSON格式的数组,其中为要运行的命令,后面的为传递给命令的选项或参数;然而,此种格式指定的命令不会以"/bin/sh -c"来发起,因此常见的shell操作如变量替换以及通配符(?,*等)替换将不会进行;不过,如果要运行的命令依赖于此shell特性的话,可以将其替换为类似下面的格式。

RUN ["/bin/bash", "-c", "<executable>", "<param1>"]

RUN 可以写多个,每一个RUN指令都会建立一个镜像层,所以尽可能合并成一条指令,比如将多个shell命令通过 && 连接一起成为在一条指令。

多个前后RUN 命令独立无关和shell命令不同,file.txt并不存放在opt路径下

[root@localhost ~]# vim dockerfile

FROM alpine

RUN cd /opt

RUN echo "hello docker" > file.txt

[root@localhost ~]# docker build .

[root@localhost dockerfile]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

<none> <none> fa7006bf3f78 3 hours ago 5.59MB

[root@localhost ~]# docker run -it --rm fa7006bf3f78 /bin/sh -c "ls /opt"

[root@localhost ~]# docker run -it --rm fa7006bf3f78 /bin/sh -c "cat /file.txt"

hello docker

CMD 容器启动时执行的命令

Docker 不是虚拟机,容器就是进程。既然是进程,那么在启动容器的时候,需要指定所运行的程序及参数。CMD 指令就是用于指定默认的容器主进程启动执行的命令。该命令可以是执行自定义脚本,也可以是执行系统命令。该指令只能在文件中存在一次,如果有多个,则只执行最后一条。

如果docker run没有指定任何的执行命令,或者dockerfile里面也没有ENTRYPOINT,那么开启容器时就会使用执行CMD指定的默认的命令。如果用户启动容器时用 docker run xxx 指定运行的命令,则会覆盖 CMD 指定的命令。比如,ubuntu 镜像默认的 CMD 是 /bin/bash,如果我们直接 docker run -it ubuntu 的话,会直接进入 bash。我们也可以在运行时指定运行别的命令,如 docker run -it ubuntu cat /etc/os-release。这就是用 cat /etc/os-release 命令替换了默认的 /bin/bash 命令了,输出了系统版本信息。

一个容器中需要持续运行的进程一般只有一个,CMD 用来指定启动容器时默认执行的一个命令,且其运行结束后容器也会停止,所以一般CMD指定的命令为持续运行且为前台命令

Docker 不是虚拟机,容器中的应用都应该以前台执行,而不是像虚拟机、物理机里面那样,用 systemd 去启动后台服务,容器内没有后台服务的概念。一些初学者将 CMD 写为:CMD service nginx start 然后发现容器执行后就立即退出了。甚至在容器内去使用 systemctl 命令结果却发现根本执行不了。这就是因为没有搞明白前台、后台的概念,没有区分容器和虚拟机的差异,依旧在以传统虚拟机的角度去理解容器。对于容器而言,其启动程序就是容器应用进程,容器就是为了主进程而存在的,主进程退出,容器就失去了存在的意义,从而退出,其它辅助进程不是它需要关心的东西。

CMD service nginx start 会被理解为 CMD [ “sh”, “-c”, “service nginx start”],因此主进程实际上是 sh。那么当 service nginx start 命令结束后,sh 也就结束了,sh 作为主进程退出了,自然就会令容器退出。正确的做法是直接执行 nginx 可执行文件,并且要求以前台形式运行。比如:CMD [“nginx”, “-g”, “daemon off;”]

docker 不是在宿主机上虚拟出一套硬件并运行完整的操作系统,然后再在其上运行所需的应用进程,而是直接在 docker 容器里面的进程直接运行在宿主的内核中,docker 会做文件系统、网络以及进程隔离等,容器不用进行硬件和内核的虚拟。对于 docker 容器而言,其启动程序就是容器的应用进程,容器就是为了主进程而存在的,主进程退出,容器就失去了存在的意义,其它辅助进程不是它需要关心的东西。

# exec 格式:使用 exec 执行,推荐方式,第一个参数必须是命令的全路径,此种形式不支持环境变量

CMD ["可执行文件", "参数1", "参数2"...]

# shell 格式:在 /bin/sh 中执行,提供给需要交互的应用;此种形式支持环境变量

CMD command param1 param2

# 参数列表格式:提供给 ENTRYPOINT 命令的默认参数

CMD ["参数1", "参数2"...]

在指令格式上,一般推荐使用 exec 格式,这类格式在解析时会被解析为 JSON 数组,因此一定要使用双引号 ",而不要使用单引号。

如果使用 shell 格式的话,实际的命令会被包装为 sh -c 的参数的形式进行执行。比如:CMD echo $HOME 在实际执行中,会将其变更为:CMD [ “sh”, “-c”, “echo $HOME” ] 这就是为什么我们可以使用环境变量的原因,因为这些环境变量会被 shell 进行解析处理。

FROM ubuntu:18.04

RUN apt-get update

&& apt-get install -y curl

&& rm -rf /var/lib/apt/lists/*

CMD [ “curl”, “-s”, “http://myip.ipip.net” ]

在镜像名后面的是 command,运行时会替换 CMD 的默认值。

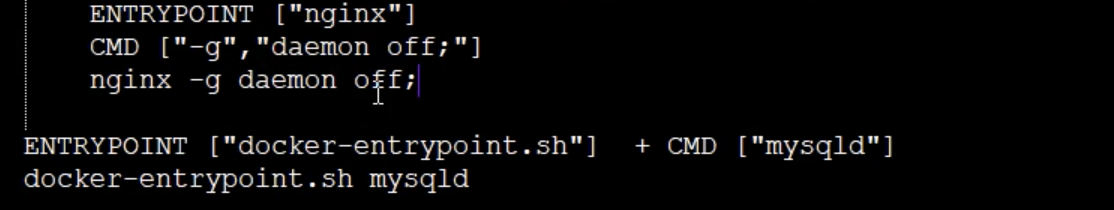

ENTRYPOINT 容器启动时执行的命令

容器启动时默认运行的命令,功能类似于CMD,ENTRYPOINT 在运行时也可以替代,不过比 CMD 要略显繁琐,需要通过 docker run 的参数 --entrypoint 来指定。

# 使用 exec 执行

ENTRYPOINT ["executable", "param1", "param2"]

# shell中执行

ENTRYPOINT command param1 param2

该指令的使用分为两种情况,一种是独自使用,另一种和CMD指令配合使用。

当独自使用时,如果你还使用了CMD命令且CMD是一个完整的可执行的命令,那么CMD指令和ENTRYPOINT会互相覆盖只有最后一个CMD或者ENTRYPOINT有效

CMD指令将不会被执行,只有ENTRYPOINT指令被执行

CMD echo “Hello, World!”

ENTRYPOINT ls -l

另一种用法和CMD指令配合使用来指定ENTRYPOINT的默认参数,这时CMD指令不是一个完整的可执行命令,仅仅是参数部分;ENTRYPOINT指令只能使用JSON方式指定执行命令,而不能指定参数

两种命令都会被执行

CMD ["-l"]

ENTRYPOINT ["/usr/bin/ls"]

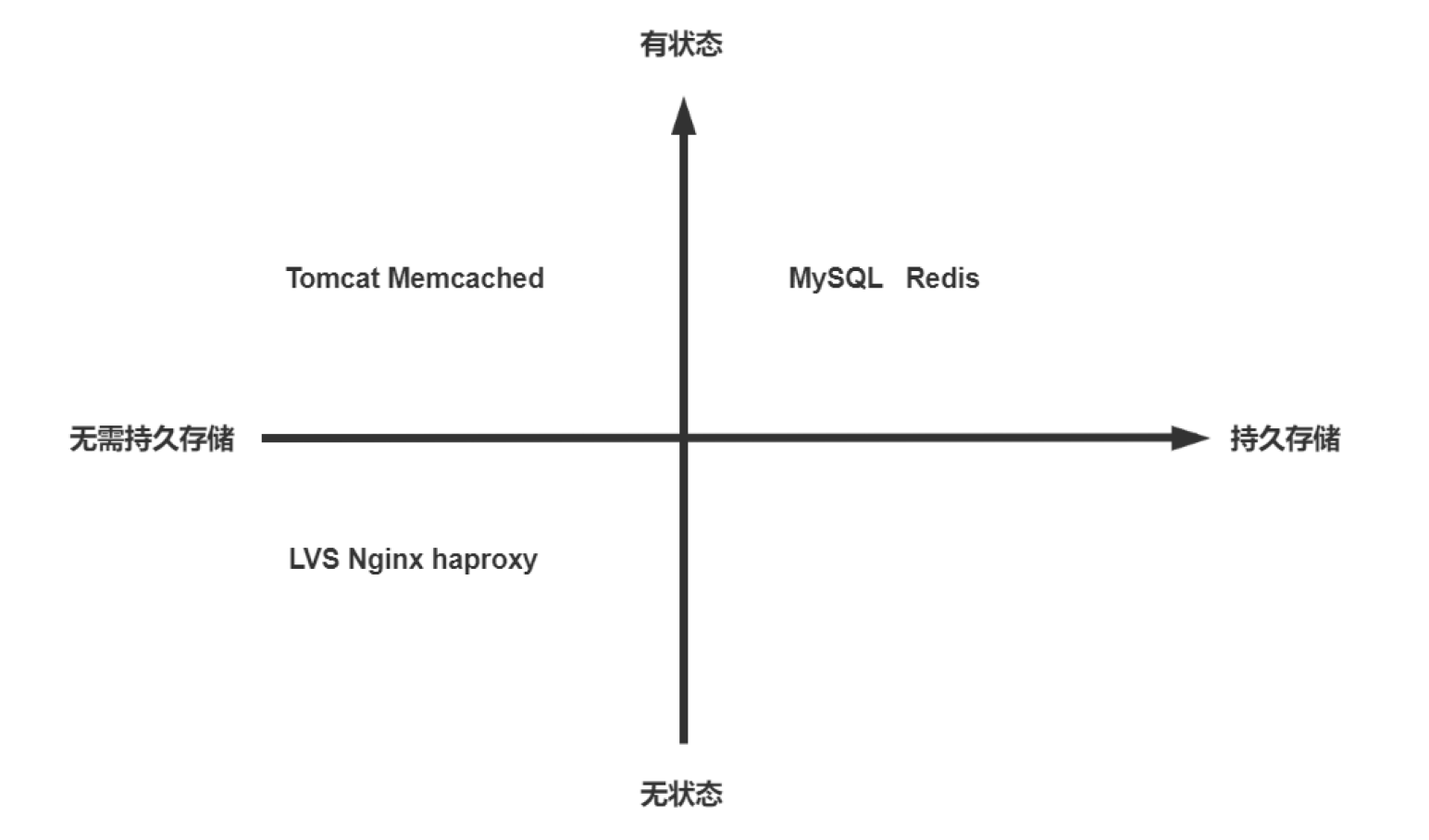

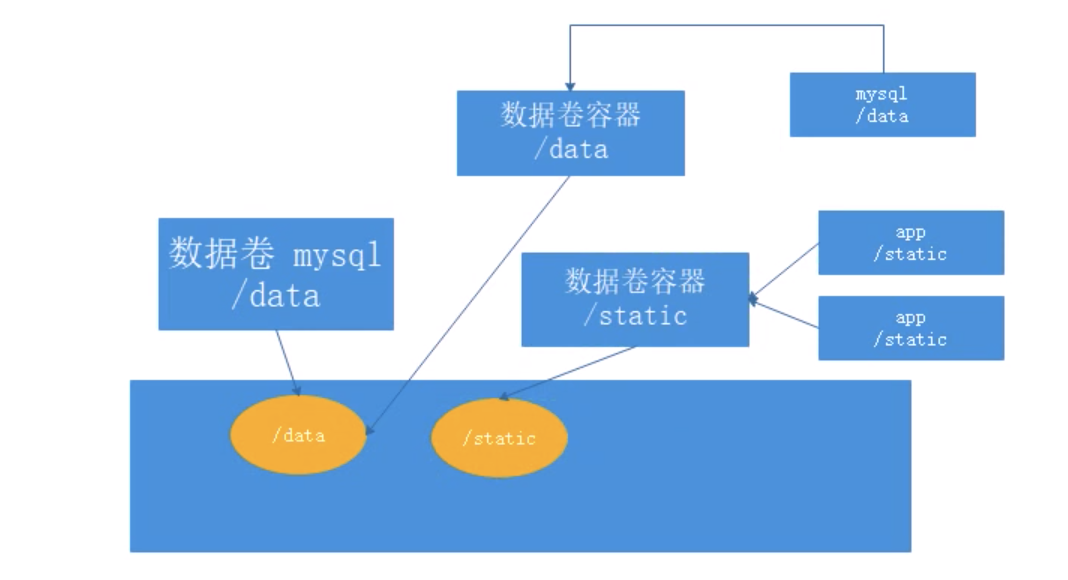

如果docker run 命令有参数,那么参数全部都会作为ENTRYPOINT的参数。ENTRYPOINT 不能被 docker run 提供的参数覆盖,而是追加。