权 斌

中国联通粤港澳大湾区创新研究院,广州 510627

当前,部署deepseek已成为政务、事业单位、企业等各领域提升效率的首选。但是部署完成之后,如何将通用模型有效转化为各领域专属的垂直模型,成为关键议题。2025年2-3月,笔者拜访调研了政数局、检察院、公安局、海关、教育局、研究所、地铁、制药企业、电商服务企业等30余个单位,发现如何使用好deepseek,已成为困扰通用大模型商用落地的重要命题。

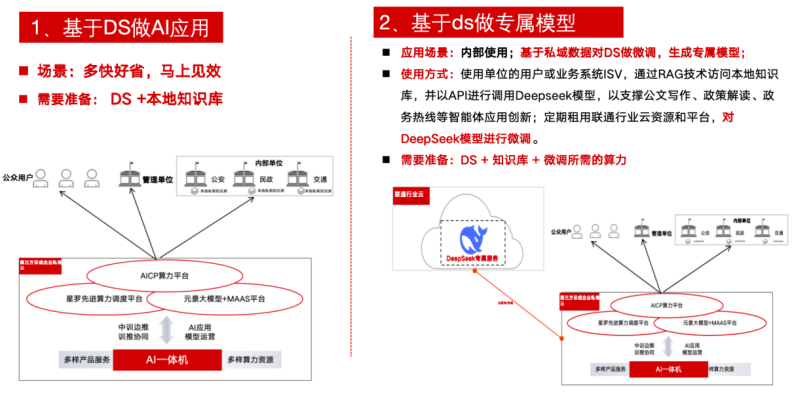

经过实践研究发现,当前阶段部署DeepSeek后主要可以做两方面事情:第一、基于通用模型做行业垂直模型或者特定场景的专属模型;第二、通过通用模型直接做AI应用。

本文主要探究基于通用模型做行业垂直模型或专属模型的最优路径。以下从现有方式、优劣分析、最优路径三个方面展开论述。

- 基于通用模型对垂直模型的迁移方式

笔者基于实践经验,对现有的基于通用模型做垂直模型的现有方式做了总结(表1)。

| 方式 | 技术实现 | 能耗成本 | 适合场景 |

| 提示工程 | 不改变通用模型参数,通过设计和制作提示词从而有效指导模型按照你所需要的思维方向来思考和生产内容 | 最低,仅需推理算力 | 构建AI应用 |

| 检索增强 生成 | 不改变通用模型参数,将外部知识库、资料包与模型连接,让模型能从外部检索数据(特别是某个领域的专业知识),以增强模型对某个领域问题的专业度 | 较低,增加约30%检索能耗 | |

| 参数高调 微调 | 改变最少量的参数对模型进行微调 | 中等,训练能耗约为全微调的15-20% | 构建行业 垂直模型 |

| 全参数微调 | 通过改变全部参数对模型进行微调 | 较高,相当于原模型训练成本的50-70% | 构建复杂的行业模型 |

| 从头预训练 | 构建你自己的模型 | 最高,需数百张GPU卡数月训练 |

表1:垂直领域迁移方式

1.1 提示工程(Prompt Engineering)

指通过设计精准的提示词引导模型输出,特点是零参数调整,仅改变输入指令;实践示例:用特定句式要求模型以法律文书格式输出。这是使用大模型的最便捷方式。

1.2 检索增强生成(RAG)

指通过外接知识库实时检索增强上下文。特点是模型参数不变,增加动态数据接入。实践示例:客服系统对接产品数据库回答用户咨询。

1.3参数高效微调(PEFT)

选择性调整部分网络参数,通常仅调整1-5%参数量。实践示例:适配医疗术语的临床报告生成模型。

参数高效微调通过冻结主干+轻量适配,可解决大模型微调的资源瓶颈问题,已成为工业界微调百亿级参数模型的标配技术。实践中需根据任务需求、硬件条件和性能要求,灵活选择适配方法。

1.4 全参数微调(Full Fine-tuning)

即全面更新模型所有权重,因此需要完整的训练基础设施,消耗算力量大。实践示例:金融风控领域的定制化风险评估模型。

全参数微调是最大化利用预训练模型能力的有效方法,但需权衡计算成本与收益。实践中可根据任务需求和数据规模,灵活选择全参数微调、部分微调或高效微调技术。

1.5 预训练(Pretraining)

指的是从零开始训练新模型。需大规模算力和数据。实践示例:从0开始训练行业专用基础大模型。

1.6 最优解思考

基于不同企业需求场景,我们探索最优实践路径:

针对初创企业,建议优先采用提示工程+RAG组合来做��垂直模型或AI应用,是快速验证商业应用方向的最佳选择。

针对行业解决方案商,推荐PEFT+领域知识库方案,从而平衡模型适配度与实施成本比如当前在医疗、法律等专业领域适用。

针对领军企业,如构建复杂场景AI需求可采用全微调,可能需准备至少5000+高质量标注数据,比如智能制造中的故障诊断系统。

针对具有独特数据资产的行业巨头,或者需构建竞争壁垒的核心业务的企业,可采用预训练路径构建行业或垂直模型,如头部金融机构的量化模型。

笔者预估:当前阶段,约80%的行业场景可通过提示工程和RAG满足,剩余20%复杂需求再考虑微调方案。综合企业的数据储备、算力预算、需求复杂度三要素,在效果与成本间寻求最优解,笔者认为参数高效微调(PEFT)是现阶段的最优路径。

- 参数高效微调的最优路径探究

当前,参数高效微调(PEFT)的实践路径主要包括直接微调通用模型和基于通用模型构建特定任务子模型。

直接微调通过在通用模型基础上,用行业数据进行二次训练,提升模型在该领域的表现。构建子模型则是在通用模型框架内,针对特定任务设计专用模块,实现更精细化的应用。

两种方式各有优劣,直接微调简单高效,但泛化能力有限;子模型设计复杂,但能更好地满足特定需求。

实践中,结合两者优势,可采用“分层微调+模块化设计”策略,先对通用模型进行初步微调,再针对细分任务设计模块,既保留了泛化性,又提升了针对性。通过多轮迭代优化,逐步逼近最优解,实现垂直模型的高效构建。

在最优路径探索中,还需关注数据质量和模型迭代频率。高质量的行业数据是模型精准度的基石,而频繁的迭代则能快速响应需求变化。

结合“东数西算”战略,利用云边端协同,提升数据处理和模型训练效率,进一步加速垂直模型的优化与应用。通过这种策略,不仅能在各领域实现深度智能化,还能推动我国人工智能产业的整体进步。

参数高效微调(PEFT)大致步骤可以分为:

(1)确定垂直领域的具体需求:明确目标任务(如分类、问答、生成)、数据类型(文本、图像、语音)、性能指标等。

(2)选择基础模型:根据任务和资源选择合适的通用模型和版本。

(3)数据收集与预处理/准备知识库:收集垂直领域的专业数据,确保数据的质量和多样性。进行数据清洗、标注和预处理,以提高数据的质量和可用性。并将数据向量化处理形成知识库。

(4)模型微调:使用垂直领域数据对基础模型进行微调,调整超参数以优化性能,使其更好地适应特定领域的需求。

(5)算法与技术优化:结合领域特点,选择合适的算法和技术进行优化,如混合专家(MoE)架构、低精度训练等。使用强化学习、监督微调等技术进一步提升模型的性能。

(6)效果验证/模型评估:使用领域特定的测试集评估模型性能并对微调效果进行测试和对齐,确保达到预期效果。

(7)部署与优化:对模型进行优化以提高推理速度,然后部署到生产环境。持续监控模型表现,收集新数据进行迭代训练。

图1:参数高效微调(PEFT)示意

微调效果 = 0.6*(知识库质量) + 0.3*(训练策略) + 0.1*(基础模型)。其中:知识库质量 = log(有效token数) * 信息密度系数。

实际案例显示:当知识库达到5万高质量文档(约1亿token),经过3轮微调迭代后,模型在特定领域的表现可超越通用模型3-5倍。

但需注意:单纯投喂数据无法突破基础模型架构限制,复杂推理任务仍需定制模型结构。

作者简介

权斌,硕士研究生学历,大数据工程师职称。具有信息安全工程师、数据治理工程师、阿里云工程师、数字化转型规划师(高级)等证书,港科大(广州)前沿科技与工程管理高级研修班学员。现就职于中国联通粤港澳大湾区创新研究院,负责生态合作。主要研究方向:人工智能、大模型。获得人工智能类发明专利1项。获得省级课题基金1项。

欢迎智算类、人工智能类业务合作和咨询。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?