参考文献:机器学习与数据挖掘参考文献

分类决策树模型是一种描述对实例进行分类的树形结构。决策树由结点和有向边组成。结点有两种类型:内部结点和叶结点。内部结点表示一个特征或属性,叶结点表示一个类。

决策树学习通常包括3个步骤:特征选择、决策树的生成和决策树的修剪。决策树学习用损失函数表示这一目标。决策树学习的损失函数通常是正则化的极大似然函数。决策树学习的策略是以损失函数为目标函数的最小化。

当损失函数确定以后,学习问题就变为在损失函数意义下选择最优决策树的问题。因为从所有可能的决策树中选取最优决策树是NP完全问题,所以现实中决策树学习算法通常采用启发式方法,近似求解这一最优化问题。这样得到的决策树是次最优的。

决策树的生成对应于模型的局部选择,决策树的剪枝对应于模型的全局选择。决策树的生成只考虑局部最优,相对地,决策树的剪枝则考虑全局最优。

通常决策树特征选择的准则有三种:信息增益(ID3)、信息增益比(C4.5)和基尼指数(CART)。

ID3算法

信息增益算法:

输入:训练数据集D和特征A;

输出:特征A对训练数据集D的信息增益g(D,A)。

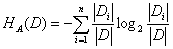

(1)计算数据集D的经验熵H(D)

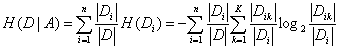

(2)计算特征A对数据集D的经验条件熵H(D|A)

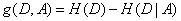

(3)计算信息增益

C4.5算法

以信息增益作为划分训练数据集的特征,存在偏向于选择取值较多的特征的问题,使用信息增益比可以对这一问题进行校正。

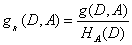

特征A对训练数据集D的信息增益比gR(D,A)定义为其信息增益g(D,A)与训练数据集D关于特征A的值的熵HA(D)之比,即

其中,

ID3和C4.5的生成算法如下:

输入:训练数据集D,特征集A,阈值ε;

输出:决策树T。

(1)如果D中所有实例属于同一类Ck,则置T为单结点树,并将Ck作为该结点的类,返回T;

(2)如果A=∅,则置T为单结点树,并将D中实例数最大的类Ck作为该结点的类,返回T;

(3)否则,计算A中各特征对D的信息增益(ID3)或信息增益比(C4.5),选择信息增益或信息增益比最大的特征Ag;

(4)如果Ag的信息增益或信息增益比小于阈值ε,则置T为单结点树,并将D中实例数最大的类Ck作为该结点的类,返回T;

(5)否则,对Ag的每一种可能ai,依Ag=ai将D分割为若干非空子集Di,将Di中实例数最大的类作为标记,构建子结点,由结点及其子结点构成树T,返回T;

(6)对结点i,以Di为训练集,以A-{Ag}为特征集,递归地调用步(1)~步(5),得到子树Ti,返回T。

2957

2957

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?