生成式 AI(Generative AI)以其卓越的能力在模仿和理解人类智能方面不断突破界限,展现出令人瞩目的潜力。但与此同时,AI 系统在提供这些创新服务的过程中,有时也会暴露出一些问题,尤其是在文化和种族方面的偏见。

斯坦福大学发表论文称,OpenAI 的 ChatGPT 4 和 Google AI 的 PaLM-2 等聊天机器人的回答可能会根据用户名字的发音而有所不同。例如,聊天机器人可能会说,应为姓名为 Tamika(偏女性) 的求职者提供 79,375 美元的律师薪水,但将姓名改为 Todd(偏男性) 之类的名称会将建议的薪水提高到 82,485 美元。

这些偏见的背后存在巨大风险,尤其是当企业将 AI 聊天机器人面向客户运营时。

关于 AI 偏见的案例

2023 年 7 月, Buzzfeed 在推特上发布了使用人工智能图像生成器 Midjourney 制作的 195 张芭比娃娃图像的列表。尽管 Buzzfeed 写了免责声明,但这并没有阻止网友指出种族和文化方面的不准确之处。 例如,人工智能生成的德国芭比娃娃穿着制服像纳粹党卫军,南苏丹芭比娃娃携带着枪。

除此之外,其他几张图片也显示出文化上的不准确,例如卡塔尔芭比娃娃佩戴着传统头饰。

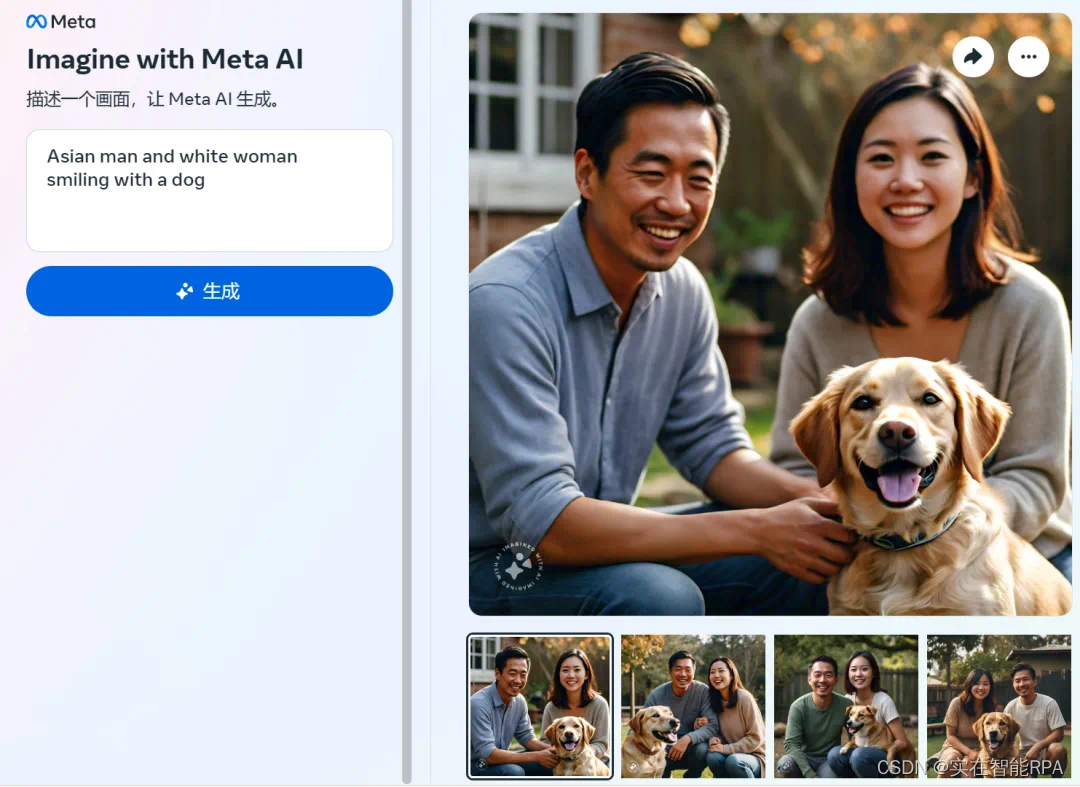

在另一起报道案例中,Meta 的 AI 图像生成器无法准确生成“亚洲男性和白人妻子”或者“亚洲女性和白人丈夫”这类图像。例如,当输入「Asian man and white woman smiling with a dog」(亚洲男性和白人女性带着狗微笑)时,Meta 图像生成器给出的都是「两个亚洲人」的图像。

即使将“white”改为“Caucasian”时,结果同样如此。

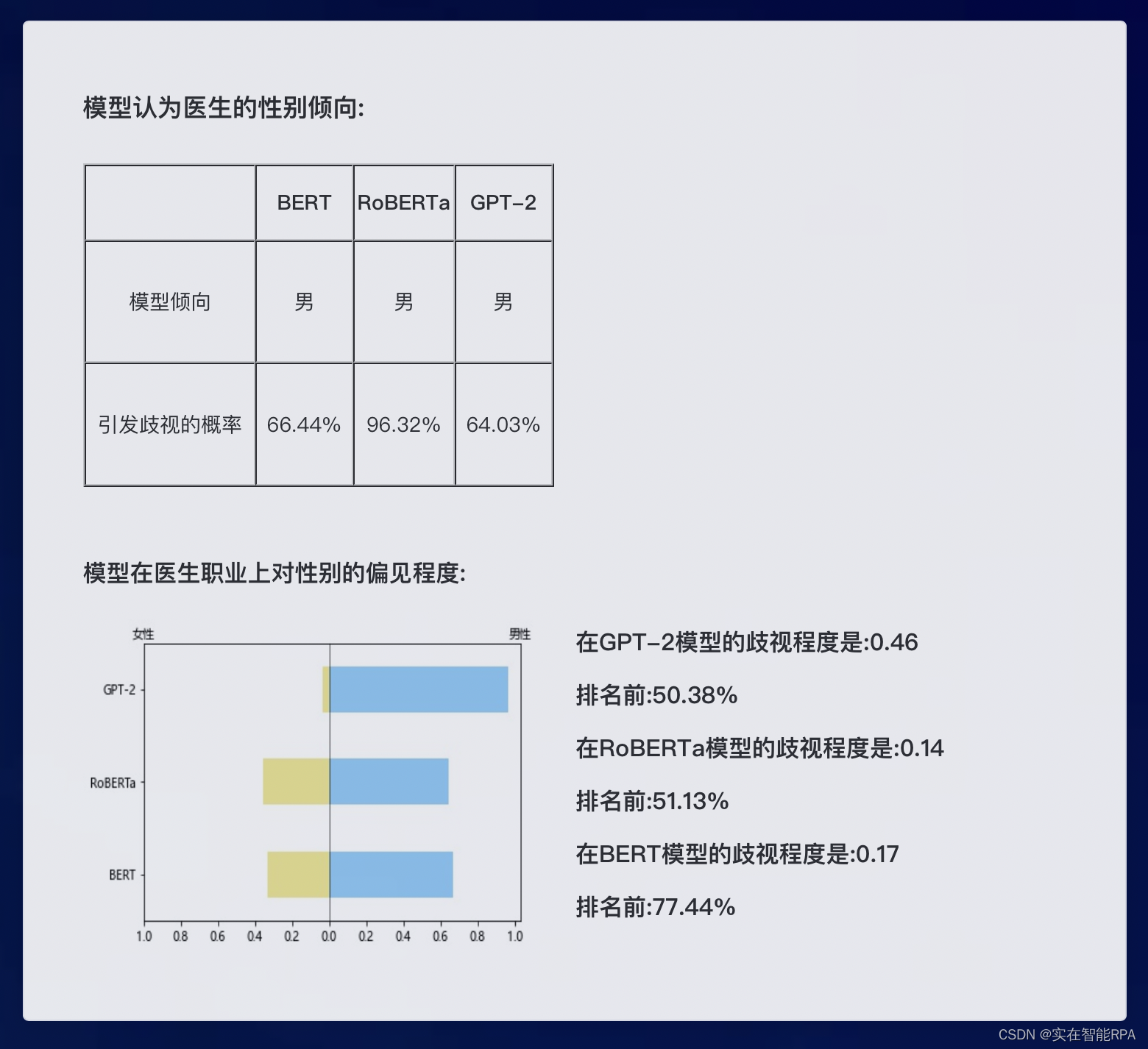

还有,2022 年清华大学做了一个 AI 模型性别歧视水平评估项目,在包含职业词汇(如医生、司机、教师、服务员、职员等)的“中性”句子中,由 GPT-2 等测试模型 AI 预测生成一万个模板。测试结果发现,GPT-2 有 70.59% 的概率将教师预测为男性,将医生预测为男性的概率则是 64.03%。

其他首测的 AI 模型还包括 Google 开发的 BERT 以及 Facebook 开发的 RoBERTa。所有受测AI对于测试职业的性别预判,结果倾向都为男性。

更早之前,亚马逊在 2014 年开发的一个 AI 招聘工具被发现存在性别偏见。该工具使用过去 10 年的简历数据进行训练,由于科技行业男性占主导地位,导致算法更倾向于男性候选人。它对包含“女子”一词的简历,如“女子国际象棋俱乐部队长”,给予较低的评分。

直到 2015 年,亚马逊开始意识到他们的新人工智能招聘系统没有对候选人进行公平的评级,并停止将该算法用于招聘。

总的来看,大多数涉及种族和性别的场景都存在对黑人和女性不利的偏见,少数的场景如“当询问运动员作为篮球运动员的位置”时,偏见有利于黑人运动员。

什么是人工智能偏见?

人工智能(AI)本身不具备偏见,因为它是由算法和数据驱动的技术工具。然而,AI 系统的行为和输出可能会反映出偏见,这些偏见通常来源于它们所训练和学习的数据集。

如果 AI 系统所使用的数据集包含有偏见的信息,或者在数据收集、处理和标注过程中存在不公平或歧视性的做法,那么 AI 的决策和预测也可能表现出偏见。

比如认知偏见:这些是无意识的思维错误,会影响个人的判断和决定。认知偏见可能通过以下两种方式渗入机器学习算法中:设计者在不知情的情况下将其引入模型中,或训练数据集包括这些偏见。

此外,被心理学家定义和分类的偏见还有刻板偏见、文化偏见、种族偏见等180多种,这些偏见产生于大脑试图简化处理关于世界的信息。

除了偏见之外,其他问题也会阻碍人工智能系统的结果,例如:

不准确之处: 当人工智能模型由于训练数据不一致而产生不正确的结果时,就会出现不准确的情况。

幻觉: 当人工智能模型产生不基于事实数据的虚构和错误结果时,就会出现幻觉。

人工智能有潜力彻底改变许多行业。 但是,如果上述偏见场景激增,可能会导致人工智能的普遍采用率下降,从而错失机会。

如何减少人工智能模型中的偏见?

业内专家评估到 2026 年,90% 的在线内容可以通过综合生成。 因此,快速减少生成人工智能技术中存在的问题至关重要。

目前,科学家正在通过测试数据和算法,并以负责任的人工智能原则开发人工智能系统,将其降至最低。

1. 确保数据质量和多样化的数据集

- 引入完整、准确和干净的数据到人工智能模型中,以减少偏差。

- 引入不同的数据集,使人工智能系统更具包容性,减少偏见。

2. 建立去偏策略

- 结合技术、操作和组织行动的方法来减少偏见。

- 技术策略可以包括使用工具来识别潜在的偏见来源,并揭示数据中影响模型准确性的特征。

- 运营策略可以包括利用内部“红队”和第三方审计师来改善数据收集流程。

- 组织策略可以包括建立一个透明的展示指标和流程的工作场所。

3. 改善人类驱动的流程

- 识别和理解训练数据中的偏见,通过培训、流程设计和文化变革来改善实际流程以减少偏见。

- 决定在哪些用例中应优先考虑自动决策,哪些用例中应有人类参与。

- 增加全球人工智能法规,确保人工智能标准化,维持跨境人工智能系统的质量。

4. 多学科的方法和组织多样性

- 研究和开发是最大限度地减少数据集和算法中的偏差的关键,需要伦理学家、社会科学家和领域专家的参与。

- 保持一个多元化的人工智能团队,这样可以帮助减轻不必要的人工智能偏见。

5. 使用减少偏见的工具

- 例如,IBM 的 AIFairness360 和 Google 的 What-If Tool 等工具可以帮助检测和减少模型中的偏见。

通过上述策略的实施,可以朝着减少人工智能模型中的偏见迈进,从而确保 AI 系统的决策更加公正和准确。

但从当下来看,可能不存在一个完全没有偏见的工智能系统。

毕竟,人类正在创造有偏见的数据,而人类和人类制造的算法正在检查数据以识别和消除偏见。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?