首先下载Spark并解压缩到/apphome目录,/apphome/spark-1.6.1-bin-hadoop2.6

进入到这个目录后执行如下命令:bin/spark-shell

Spark 启动成功。

来实现第一个例子:

在spark shell 中依次输入如下命令:

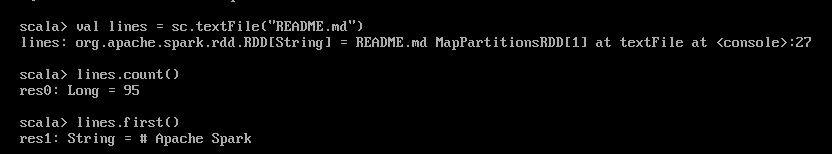

val lines = sc.textFile("README.md")

lines.count()

lines.first()需要说明的是每输入一行,回车后,都会有对应的日志出现。README.md是在/apphome/spark-1.6.1-bin-hadoop2.6 目录下面的。

截图如下:

第一行是加载README.md文件到spark中。

第二行是统计README.md文件的行数。

第三行是返回README.md文件的第一行。

到此,入门实例结束。很简单吧~

850

850

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?