TEngine是由OPEN AI LAB开发的一款轻量级模块化的高性能神经网络推理引擎,专门针对Arm嵌入式设备优化,提供超过所有已知开源框架的无与伦比的性能,并且无需依赖第三方库,可跨平台使用支持Android,Liunx。

OPEN AI LAB是Arm发起的,旨在推动Arm嵌入式智能机器的产业发展,为智能机器应用场景构建嵌入式SoC基础计算框架,推动芯片、硬件、算法软件整个产业链的深度协作,实现有计算的地方就有人工智能。

TEngine介绍

TEngine支持各类常见卷积神经网络,包括SqueezeNet,MobileNet,AlexNet,ResNet等,支持层融合、8位量化等优化策略。并且通过调用针对不同CPU微构架优化的HCL库,将Arm CPU的性能充分挖掘出来。例如在RK3399平台Cortex-A72单线程运行移动端常用的MobileNet一次只需要111ms,比NCNN快50%以上1。TEngine目前已经适配Cortex-A7/A17,Cortex-A53/A72/A73,后续还将适配Arm最新构架CPU Cortex-A55/A75,并且支持8位点积指令和半精度浮点指令,大幅度提升推理性能。

除了对单核性能的挖掘,TEngine在多线程加速上也针对Arm SoC系统构架做了专门的优化,并且通过优化调度,双线程加速比达到170%,四线程加速比达到270%。

为了满足嵌入式应用场景对低功耗、小内存的需求,TEngine在内存也做了深度优化,轻松运行极度消耗内存的VGG16网络,并且通过增加缓存利用率减少不必要的内存访问,从而降低功耗。

TEngine开放生态

TEngine平台不仅性能指标非常优秀,而且使用非常方便。TEngine可以以wrapper的形式支持Caffe API,原本基于caffe开发的应用只需要简单的重新编译就能在TEngine上二次部署,后续TEngine还将支持Tensorflow API。

作为一款开放计算平台,TEngine的扩展能力非常强,除了支持自带的HCL库以外,还支持业界常见的Openblas, Arm Compute Library库。客户还可以很容易拓展自己的算子库,给用户自由的选择。除此之外,TEngine还能适配芯片上GPU等各类硬件资源甚至是DLA硬件加速器。只需要简单的在TEngine上注册设备并挂载上驱动,就能充分利用芯片上的硬件资源提升计算能力。

TEngine PK ncnn

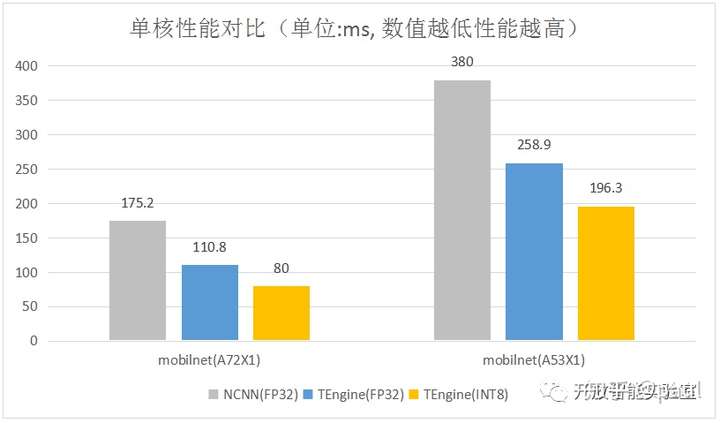

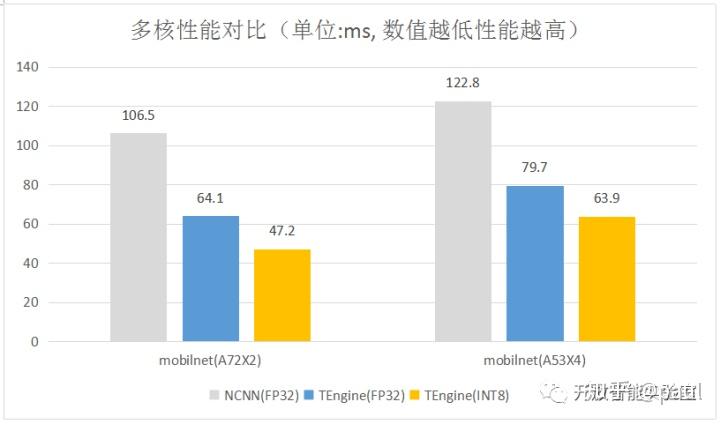

TEngine提供开源版本仅支持Arm v8构架,32位浮点计算和部分功能,链接为https://github.com/OAID/TEngine。如下是基于RK3399对比测试 ncnn 和 TEngine的性能图表。ncnn为2018年6月16日版本。

结论:在单核单线程测试mobilnet,

TEngine的性能是NCNN的2.19~1.93倍。

结论:在多核多线程测试mobilnet,

TEngine的性能是NCNN的2.26~1.92倍。

http://weixin.qq.com/r/6SqRiRvEekYFrV-q93-7 (二维码自动识别)

OPEN AI LAB 由Arm发起,核心团队来自Arm, Broadcom, Intel等公司。旨在推动Arm嵌入式智能机器的产业发展,为智能机器应用场景构建嵌入式SoC基础计算框架,并整合应用场景服务接口。致力于推动芯片、硬件、算法软件整个产业链的深度协作,一起实现万物智能。

908

908

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?