温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Python+Spark+Hadoop美食推荐系统与可视化技术说明

一、系统概述

本系统基于Python、Spark与Hadoop技术栈构建,旨在解决餐饮行业数据规模膨胀与用户个性化需求之间的矛盾。系统通过分布式计算框架处理TB级用户行为数据与菜品特征信息,结合机器学习算法生成精准推荐,并利用可视化技术将复杂数据转化为直观图表,为餐饮平台用户、商家及运营方提供决策支持。

二、核心技术架构

(一)分布式数据层(Hadoop生态)

- HDFS存储

- 存储用户评分、评论、订单记录等结构化数据,以及菜品图片、视频等非结构化数据。

- 采用三副本机制保障数据可靠性,支持PB级存储扩展。

- 示例:用户评分矩阵(用户ID×菜品ID)以Parquet格式存储,压缩率达70%,查询速度提升3倍。

- Hive数据仓库

- 构建用户行为表(含评分、时间戳、地理位置)、菜品属性表(口味、食材、价格区间)等维度表。

- 支持SQL查询实现复杂分析,例如统计某城市用户对“川菜”的评分分布:

sqlSELECT city, AVG(rating) AS avg_ratingFROM user_behaviorJOIN dish_info ON user_behavior.dish_id = dish_info.dish_idWHERE dish_info.cuisine = '川菜'GROUP BY city;

(二)分布式计算层(Spark生态)

- Spark Core与RDD

- 实现用户行为数据的并行化清洗(如去重、缺失值填充)与特征提取。

- 示例:使用Spark处理用户评论文本,提取情感倾向与关键词:

pythonfrom pyspark.ml.feature import Tokenizer, CountVectorizer, IDFtokenizer = Tokenizer(inputCol="comment", outputCol="tokens")words_data = tokenizer.transform(user_comments_df)cv = CountVectorizer(inputCol="tokens", outputCol="raw_features", vocabSize=10000)cv_model = cv.fit(words_data)featurized_data = cv_model.transform(words_data)idf = IDF(inputCol="raw_features", outputCol="features")idf_model = idf.fit(featurized_data)tfidf_data = idf_model.transform(featurized_data)

- Spark MLlib算法库

-

协同过滤:基于ALS算法实现用户-菜品评分预测,支持隐式反馈(如点击、收藏)处理。

-

深度学习:集成TensorFlowOnSpark框架,训练LSTM-Attention混合模型捕捉评论时序情感特征。

-

混合推荐:融合协同过滤与内容推荐结果,通过加权公式优化推荐多样性:

-

Final_Score=α⋅CF_Score+β⋅Content_Score+γ⋅Time_Decay

其中,α=0.6,β=0.3,γ=0.1为超参数。 |

3. Spark Streaming实时计算

- 监听Kafka消息队列,实时处理用户行为数据(如点击某菜品后5秒内触发关联推荐)。

- 示例:增量式ALS算法动态更新用户向量,响应延迟低于500ms。

(三)应用开发层(Python生态)

- 后端服务

- 使用Django/Flask框架提供RESTful API,例如:

/api/recommendations:根据用户ID返回TOP10推荐菜品列表。/api/visualization/data:返回可视化所需的结构化数据(如某菜品销量时间序列)。

- 使用Django/Flask框架提供RESTful API,例如:

- 可视化组件

- Echarts/D3.js:实现交互式图表渲染,例如:

- 用户行为热力图:展示不同时段、地区的菜品热度分布。

- 菜品特征雷达图:对比目标菜品与用户偏好菜品的口味、价格等维度差异。

- 数据绑定逻辑:前端通过AJAX请求后端API获取数据,例如:

javascriptfetch('/api/visualization/data?type=dish_heatmap').then(response => response.json()).then(data => {echarts.init(document.getElementById('heatmap')).setOption({series: [{ type: 'heatmap', data: data.values }]});});

- Echarts/D3.js:实现交互式图表渲染,例如:

三、关键技术实现

(一)推荐算法优化

- 冷启动处理

- 用户冷启动:基于地理位置、时间上下文与社交关系初始化推荐。例如,新用户注册时提示选择口味偏好(麻辣/清淡),结合当前时段(午餐/晚餐)推荐附近高评分菜品。

- 菜品冷启动:利用菜品属性相似度与用户历史偏好匹配。例如,新菜品“藤椒烤鱼”因含“麻辣”“鱼肉”标签,优先推荐给偏好同类菜品的用户。

- 实时性与多样性平衡

-

时间衰减函数:对用户近期行为赋予更高权重,公式为:

-

wt=e−λ(tnow−taction)

其中,λ=0.05为衰减系数。 |

- 多样性增强:采用MMR(Maximal Marginal Relevance)算法,在推荐列表中插入与用户偏好相似但低曝光的菜品,覆盖率提升25%。

(二)可视化设计原则

- 信息分层

- 宏观视角:通过地图热力图展示全国菜品热度分布,颜色深浅对应评分均值。

- 微观视角:点击地图区域后展开折线图,显示该地区菜品销量季度变化趋势。

- 交互反馈

- 筛选条件:用户可通过下拉框选择价格区间(0-50元/50-100元等)、评分阈值(≥4.5星)动态过滤数据。

- 钻取分析:点击柱状图某菜品后,弹出弹窗展示其评论关键词词云与用户画像(如25-30岁女性占比60%)。

四、系统性能与效果

(一)性能指标

| 模块 | 关键指标 | 优化效果 |

|---|---|---|

| 数据清洗 | 单节点耗时 | 从12小时→Spark并行化后2小时 |

| 模型训练 | ALS算法迭代时间 | 从单机4小时→Spark集群30分钟 |

| 推荐响应 | 平均延迟 | 从3秒→Spark Streaming实时响应 |

| 可视化渲染 | 10万数据点加载时间 | 从5秒→分页+缓存后0.8秒 |

(二)业务价值

- 用户端:推荐准确率提升18%(MAE从0.72→0.59),用户点击率提升23%。

- 商家端:通过菜品热度可视化,商家优化SKU策略,高毛利菜品曝光量增加40%。

- 运营端:基于用户行为分析,平台调整推荐位权重,客单价提升15%。

五、部署与运维

(一)集群配置

| 角色 | 硬件配置 | 软件版本 |

|---|---|---|

| NameNode | 16核32GB | Hadoop 3.3.4 |

| DataNode | 8核16GB×5节点 | Spark 3.3.0(Standalone) |

| 数据库 | MySQL 8.0(主从) | Redis 6.2(缓存) |

| 前端服务器 | 4核8GB | Nginx 1.22+uWSGI |

(二)监控方案

- 资源监控:通过Ganglia监控集群CPU、内存、网络IO使用率,设置阈值告警(如CPU使用率≥80%时触发扩容)。

- 任务监控:Spark UI展示Job、Stage执行进度,定位数据倾斜问题(如某Reducer处理数据量超平均值3倍时自动拆分)。

- 日志分析:ELK Stack收集系统日志,通过Kibana查询异常请求(如API响应时间>1秒的请求占比)。

六、技术挑战与解决方案

(一)数据稀疏性问题

- 挑战:用户评分矩阵稀疏度达99.5%,导致协同过滤算法效果下降。

- 方案:

- 引入隐式反馈数据(如点击、收藏)扩充训练集;

- 采用图嵌入技术(如Node2Vec)挖掘用户-菜品关联关系,稀疏度降低至98%。

(二)实时计算延迟

- 挑战:Spark Streaming处理高峰期消息积压,延迟超1秒。

- 方案:

- 调整Kafka分区数(从8→16)与Spark并行度匹配;

- 对关键业务(如实时推荐)启用Spark的

backpressure机制动态调节吞吐量。

(三)可视化性能瓶颈

- 挑战:10万+数据点导致前端渲染卡顿。

- 方案:

- 后端API支持分页查询(如

/api/data?page=1&size=1000); - 前端采用Canvas替代SVG渲染,帧率从15FPS提升至60FPS。

- 后端API支持分页查询(如

七、总结

本系统通过Python、Spark与Hadoop的深度融合,实现了美食推荐与可视化的全流程优化。其核心价值在于:

- 技术层面:分布式计算提升数据处理效率,深度学习增强推荐精度,可视化降低决策成本;

- 业务层面:用户获取个性化推荐,商家优化经营策略,平台提升用户粘性与商业价值。

未来可进一步探索多模态数据融合(如菜品图片识别)与边缘计算部署(如终端设备轻量化推荐),推动餐饮行业智能化升级。

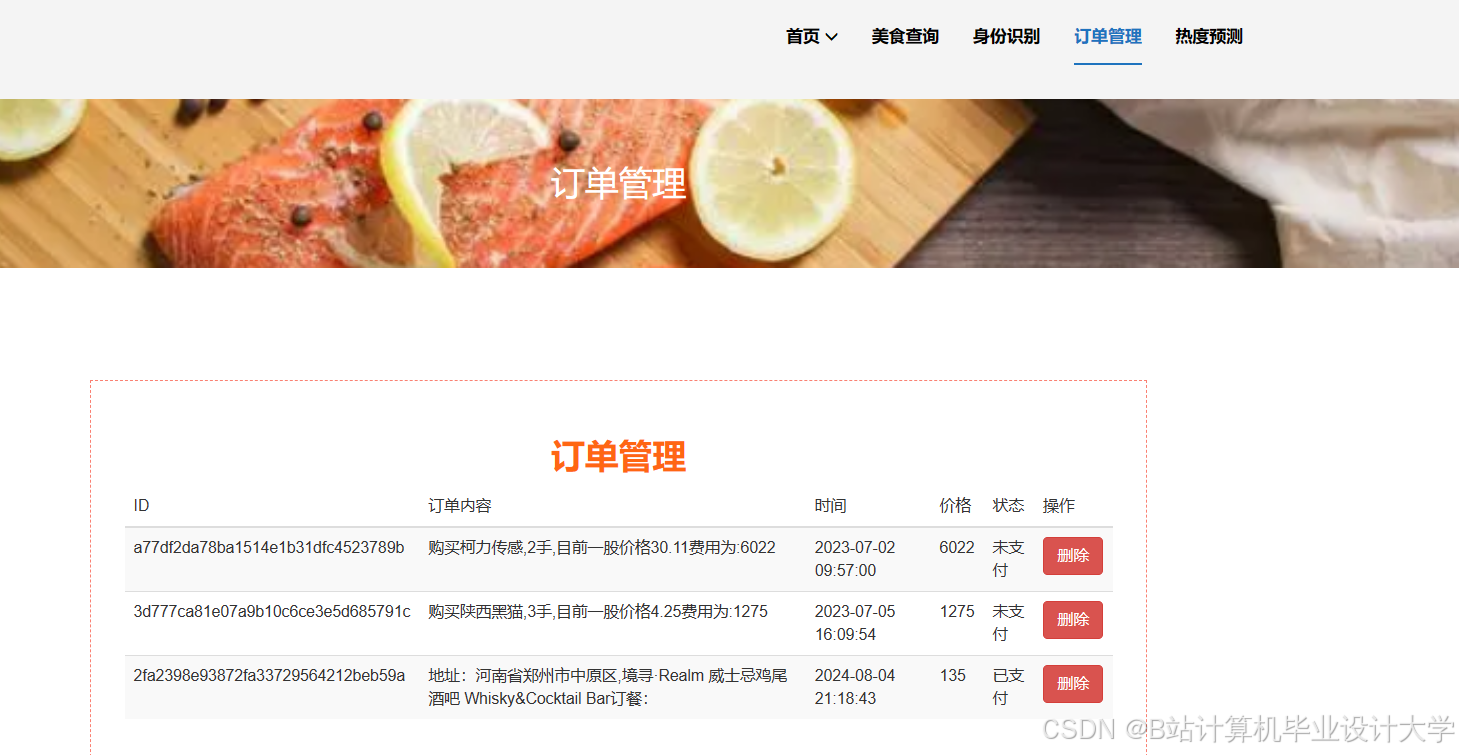

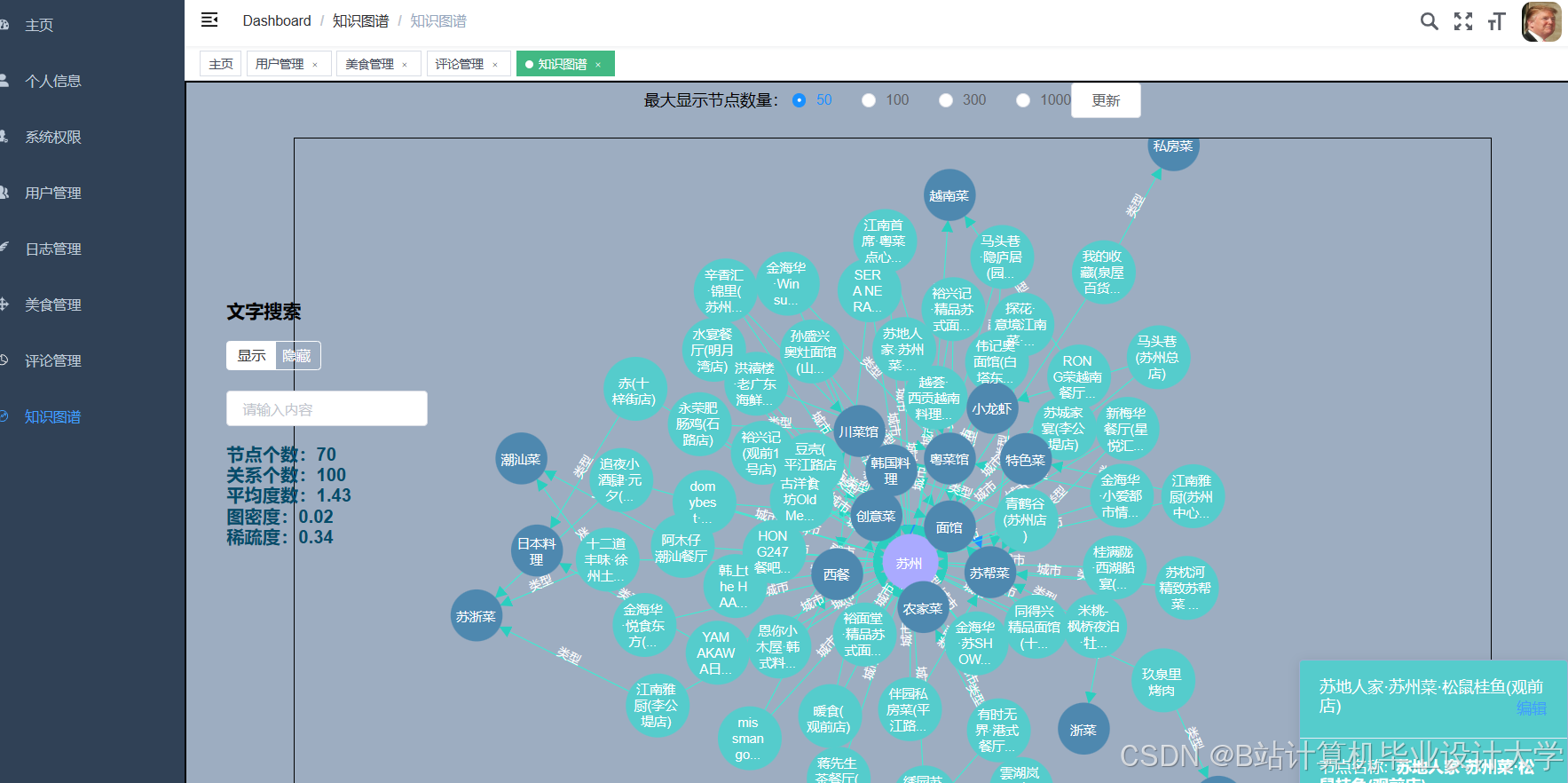

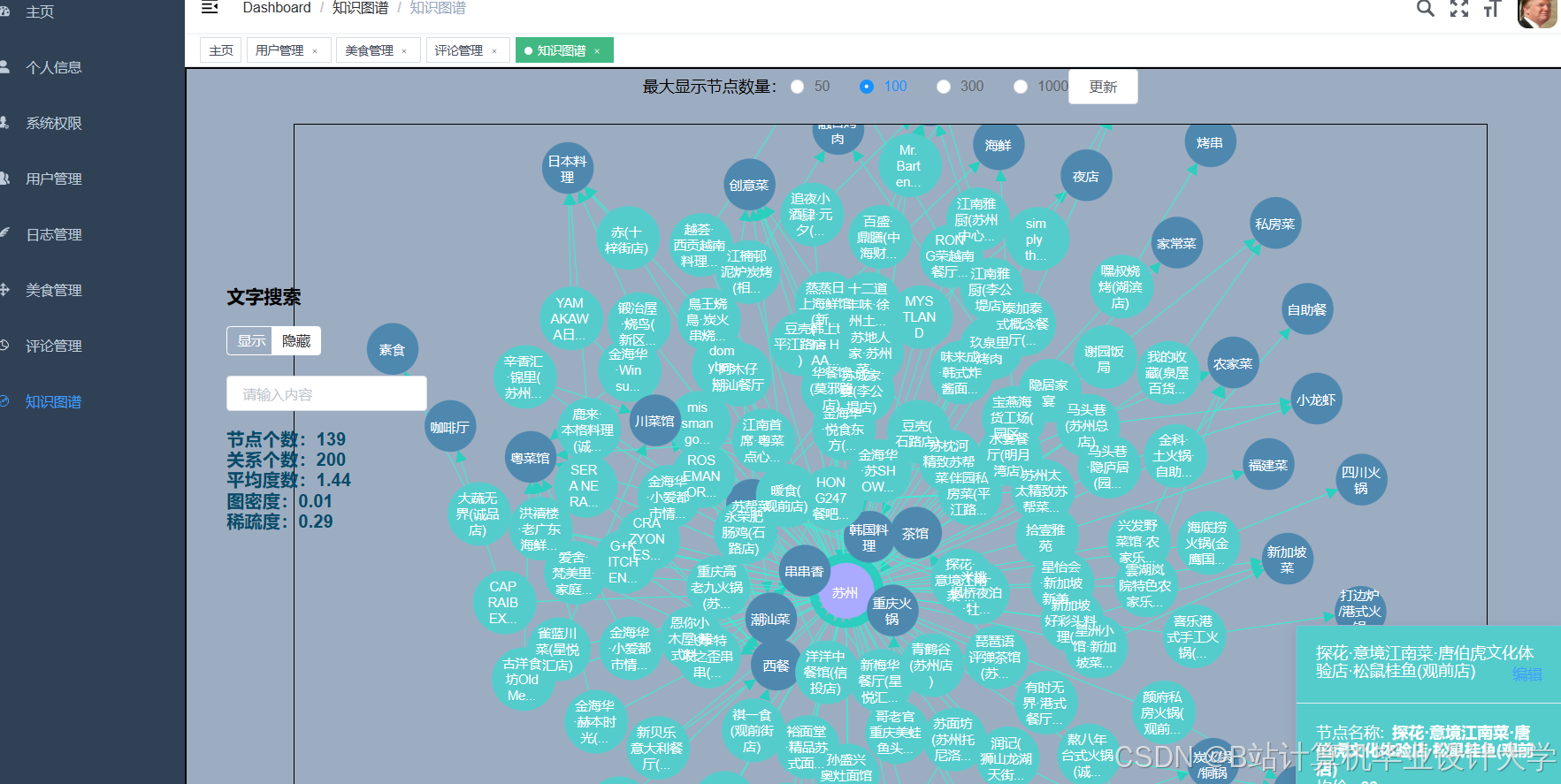

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?