一、到底什么是shuffle(洗牌)

需要Shuffle的关键性原因是某种具有共同特征的数据需要最终汇聚到一个计算节点上进行计算。shuffle会将中间结果存储在本地,然后下个stage需要数据再去向这个节点要数据(此时如果是不同节点会涉及到网络传输)。

二、Shuffle可能面临的问题?运行task的时候才会产生shuffle(shuffle已经融化在spark的算子中了)

1.数据量非常大;(几千台机器进行shuffle,网络传输比较大)

2.数据如何分类,即如何Partition:hash,sort,钨丝计算(tungsten);

3.负载均衡(数据倾斜);(不同方式进行shuffle)

4.网络传输效率,需要在压缩和解压缩(CPU)之间做出权衡,序列化和反序列化也是要考虑的问题;

说明:具体的task进行计算的时候尽一切最大可能使得数据具备process locality的特性(内存中计算);退而求其次是增加数据分片,减少每个task处理的数据量(任务批次会多,即使任务更多,排队也会快)。

读磁盘比读内存风险大,内存中直接算可能比从磁盘读中间结果要快,不持久化中间结果,数据丢失,重新计算数据依赖的RDD,一个Stage内部,鼓励这么做,但如果产生shuffle,网络通信,需要持久化,容错角度,shuffle容错需要持久化,需要父stage所有算完,才能进行下一步,如果出错,需要重新计算父stage,代价比较大,所以Stage计算,遇见shuffle,一定要持久化,local filesystem,techoyon中,

三、 Hash shuffle

1.key不能是array

2.hash shuffle不需要排序,此时从理论上讲就节省了hadoop mapreduce中进行shuffle需要排序时候的时间浪费,因为实际环境有大量的不需要排序的shuffle类型;

思考:不需要排序的hash shuffle是否一定比需要排序的sorted shuffle速度更快?

不一定!如果数据规模比较小的情况下,hash shuffle会比sorted shuffle速度快(很多)!但是如果数据量大(hash shuffle适合椎小规模的数据,因为spark之前版本使用hash shuffle的,后来出现sorted shuffle,适合处理大规模数据,hash处理不了,hash方式:key,句柄,小文件,磁盘、内存会成瓶颈),此时sorted shuffle(节省内存,节省磁盘访问,利于更大规模的数据)一般都会比hash shuffle快(很多)。

3.每个ShuffleMapTask会根据key的hash值计算出当前的key需要写入的partition,然后把决定后的结果写入单独的文件,此时会导致每个task会产生R(Reducer的个数,指下一个stage的并行度)个文件,如果当前的stage中有M个shufflemaptask,则会M*R个文件!!!

上个Stage的信息会注册给driver,下个Stage会从driver中(通过网络)读取数据,但是注意:shuffle操作绝大多数情况下都要通过网络,如果mapper和reducer在同一台机器上,此时只需要读取本地磁盘即可。

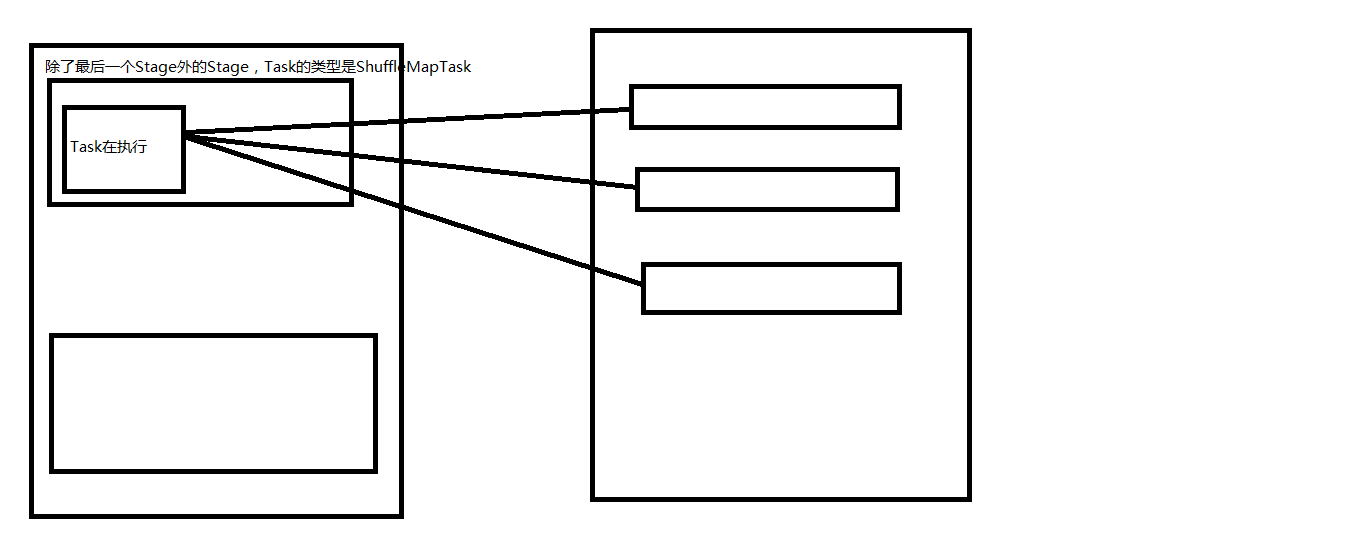

除了最后一个Stage外的Stage,Task的类型是ShuffleMapTask

Task在执行过程中,假设下一个Stage有三个并行,如果有两个shufflemaptask,就会产生六个文件,但是数量越大,就越大

读数据需要文件句柄读数据

Hash shuffle的两大死穴:第一:shuffle前会产生海量的小文件于硬盘之上,此时会产生大量耗时低效IO操作;第二:内存不够用!!!由于内存中需要保存海量的文件操作句柄和临时缓存信息,如果数据处理规模比较庞大的话,内存不可承受,出现oom等问题。

三:Sorted Shuffle:

为了改善上述问题(同时打开过多文件导致writer handler内存使用过大以及产生过度文件),spark后来推出了Consalidate机制,来把小文件合并,此时shuffle文件产生的数量为cores*R,对于shufflemaptask的数量明显多于同时可用的并行cores的数量的情况下,shuffle产生的文件会大幅度减少,会极大降低oom的可能;

为此spark推出shuffle pluggable开发框架,方便系统升级的时候定制shuffle功能模块,也方便第三方系统改造人员根据实际业务场景来开放具体最佳的shuffle模块;核心接口shuffleManager,具体默认实现有HashShuffleManager, SortedShuffleManager等,Spark 1.6.0中具体的配置如下:

val shortShuffleMgrNames = Map(

“hash”-> “org.apache.spark.shuffle.hash.HashShuffleManager”,

“sort”-> “org.apache.spark.shuffle.sort.SortShuffleManager”,

“tungsten-sort”-> “org.apache.spark.shuffle.sort.SortShuffleManager”)

默认是sort

首先shuffle map不会,所有结果写到一个文件中,还有索引,避免产生大量文件,磁盘文件变小,索引,节省内存,减少gc分享频率,减少同时写多个文件给系统带来的压力,归并排序

288

288

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?